21 minute read

Дизайнерская уборка

from ITExpert07_2020

text: Андрей Виноградов

Eufy RoboVac G10 Hybrid (Т2150) 16 990 рублей

Advertisement

Возможность одновременной сухой и влажной уборки Высокая мощность всасывания Привлекательный внешний вид Пылесборник можно мыть водой Поддержка Алисы от «Яндекса» и помощника Google Качественная локализация Одноступенчатый фильтр

Встречают, как известно, по одежке, и в этом смысле робот-пылесос Eufy RoboVac G10 настоящий франт: оригинальный орнамент под прозрачным покрытием черного корпуса производит впечатление, что перед тобой эдакий миниатюрный рояль.

Комплект поставки не просто полный: помимо специальной щетки для чистки самого робота, в него входят запасной фильтр, салфетки для влажной уборки и даже несколько нейлоновых стяжек, чтобы аккуратно скрутить провод блока питания базовой станции. А вот пульта ДУ нет, в его роли предполагается использовать смартфон или «умную» колонку. Разработчики Eufy RoboVac G10 предпочли использовать систему без основной вращающейся щетки, зато дополнительно на нижней части корпуса установлены резиновые направляющие, помогающие собирать частицы мусора в сторону всасывающего отверстия. Разумеется, боковые щетки-усики тоже никто не отменял. При первом же включении приятный женский голос на русском языке информирует вас обо всех действиях и возникающих ошибках. К сборке и качеству изготовления придраться невозможно — все сделано на высшем уровне. Модуль пылесборника емкостью 450 мл можно мыть под водой — он удобно раскрывается и с чисткой проблем нет. Бумажный фильтр эффективно справляется со своими обязанностями, но стоит помнить, что перед следующим использованием его следует тщательно просушить после мойки. На мой взгляд, системе фильтрации не помешал бы дополнительный сетчатый фильтр, захватывающий основную массу пыли, а бумажный служил бы для самых мелких частиц. Впрочем, что касается качества сухой уборки, претензий никаких. Сила всасывания 2000 Па — весомый аргумент в пользу RoboVac G1 0. А для влажной уборки требуется установить специальный модуль, предварительно залив в него воду с моющим средством или без оного. Таким образом, процедура будет полноценной: сначала пыль и мусор собирает всасывающий модуль, а дальше влажная салфетка очищает пол от налипшей грязи. Кстати, приложение EufyHome — одно из лучших среди тех, что я видел: современный дизайн, качественная локализация. Единственное, что требуется учесть для сопряжения RoboVac G10, это переключиться на WiFi-сеть диапазона 2,4 ГГц, так как модуля 5 ГГц в пылесосе нет. Ну а дальше запускайте своего помощника из любой точки мира — настраивайте расписание уборки, выбирайте режим и т. д. Уровень шума RoboVac G10 весьма умеренный, учитывая высокую мощность всасывания. Впрочем, если хочется, чтобы робот урчал потише, можно выбрать режим «Стандартный», а не «Макс.». Процесс уборки порадовал: робот корректно обходит препятствия, при этом строя карту, благодаря чему неплохо справляется с обработкой комнат площадью более 30 м². Единственное замечание — может пропустить небольшую зону в углу, но это происходит из-за крайне бережного алгоритма движения — пылесос старается не касаться мебели и стен. Подводя итог знакомства с Eufy RoboVac G10, скажу, что это один из лучших представителей роботов‑пылесосов без турбощетки. Во‑первых, классно выглядит, во‑вторых, удобно управляется, и главное — качественно убирает.

Песочница для ЦОДа

Если вы руководитель, ответственный за ИТ на предприятии или в компании, поставляющей услуги, и вам предстоит обеспечивать работу 100 новых сотрудников в течение следующих пяти лет, какие темпы роста возможностей и производительности вы внесете в планы и как реализуете этот проект на базе вашей инфраструктуры?

text: Райнер В. Кезе, старший менеджер по развитию бизнеса, подразделение устройств хранения данных, Toshiba Electronics Europe GmbH О твет на эти вопросы не найти путем простого математического расчета. Кроме того, планы, безусловно, потребуют корректиров ки в процессе реализации. Тем не менее для приблизительной оценки верхней и нижней планки расходов нужны лишь несколько исходных цифр и каль кулятор. К тому же, вероятно, вы уже наметили поставщиков, к которым обратитесь для реализации своего проекта. А что, если вас попросят разрабо тать концепцию хранения данных для новой услуги, предлагаемой произво дителем автомобилей? Предположим, эта компания планирует запустить ав топилот с подключением к облаку. Имеется приблизительная оценка количества проданных автомобилей в год и объема данных, однако нижняя и верхняя планки ожидаемого спро са заметно различаются, что потребует разработки целого ряда подходов к организации ЦОДов — ведь произ водитель рассчитывает на коммерческую выгоду и не захочет закупать избыточные мощности.

Что же произойдет, когда вам потре буется протестировать свои приблизительные расчеты на практике? Можете ли вы в любой момент выделить стойку, серверы, жесткие диски и сете

вой канал, чтобы сравнить цифры с реальностью? Скорее всего, нет.

Конечно, решений для облачного хранения данных в наши дни не пред лагает только ленивый, но они подходят не для всякого проекта, а при серьез ных масштабах еще и довольно дорого обходятся. Если же предполагается об рабатывать конфиденциальные данные или планируются особые подходы к ре ализации проекта, то имеет смысл хранить такие данные в физически защищенном месте, однако такой вариант требует площадей, подключения к сети и большого количества «железа», а это тоже серьезные затраты.

И все же решение есть — это револю ционный подход к проверке идей и внедрению инновационных услуг. Компания Global Data Centers EMEA, подразделе ние концерна NTT Ltd., располагает мощностями Technology Experience Labs, которые обеспечивают площади, энерго питание и защиту, а также возможность реализации инновационных решений с использованием прогрессивных техно логий облачного и локального хранения данных. Это позволяет менеджерам цен тров обработки данных и поставщикам услуг быстро и без лишних расходов вне дрять новые решения для тестирования частных или гибридных облаков, а также исследовать распределенные архитек туры и оценивать их влияние на эффективность ИТ-услуг. Проект поддерживается сообществом энтузиастов, регулярно проводятся вебинары, учебные лагеря, встречи и хакатоны.

Гл авн ая п лощ а д к а н а ход и т с я во Франкфурте (Frankfurt 1, Герма ния), доступно 65 000 м² площадей для серверов в здании, специально спро ектированном как дата-центр. Энергоснабжение обеспечивается двумя подстанциями, запитанными от разных сетей. Кроме того, установлены два отдельных источника бесперебойного питания (ИБП) и имеется резервная система электропитания от дизельно го генератора. Физическая безопасность и контроль доступа обеспечивают защиту систем от широкого спектра потенциальных атак, а также ведут ся круглосуточный мониторинг и резервирование. Интернет-подключение со скоростью до 10 Гбит/с обеспечи вают более чем 350 провайдеров. Этот кампус также связан оптоволо конным соединением с центром обработки данных NTT в Рюссельхайме

(Frankfurt 3), что позволяет внедрять распределенные решения.

На сегодняшний день уже протести ровано множество решений — среди них гибридные облака, хранилища дан ных, Big Data, DevOps, App Management и даже High Performance и Cognitive Computing. Проводятся также иссле дования «железных» решений, например испытания жидкостного охлаждения с рекуперацией тепла.

Однако вернемся к приведенным примерам. В подобных случаях мно гие менеджеры ИТ-компаний, центров обработки данных и организаций — по ставщиков услуг стремятся к вертикальному масштабированию имеющихся систем и для увеличения производи тельности и емкости устанавливают дополнительное оборудование и диски. Если для вас это подходящий вариант, то у NTT есть среда, в которой можно дать оценку такому подходу. Для его демонстрации был построен высоко производительный сервер хранения данных, удовлетворяющий критери ям по надежности и производительности, который можно использовать для различных iSCSI-задач объемом от 10 до 40 Тбайт.

Данная система, смонтированная в 2017 году, использует серверы серии Supermicro X10 в формате 2U с двумя процессорами Intel Xeon и 128 Гбайт оперативной памяти. В ее состав вхо дят контроллер Microsemi ASR8885, сетевые карты со скоростью 10 Гбит/с и шасси JBOD с двойным расширени ем и верхней загрузкой на 60 мест от Celestica. Для хранения данных ис пользуются 3,5‑дюймовые жесткие диски корпоративного класса Toshiba MG04SCA40EA емкостью 4 Тбайт с ин терфейсом SAS 12 Гбит/с и скоростью вращения 7200 об/мин.

Решение построено на программ ном обеспечении для хранения данных Open-E JovianDSS на базе Linux с ис пользованием файловой системы ZFS, подходящей для организации хране ния данных по протоколам iSCSI, Fiber Channel (FC), NFS и SMB (CIFS). Благо даря Linux-основе оно отличается высокой аппаратной совместимостью и хорошо подходит для виртуализированных сред хранения данных, обеспечивая высокую целостность и надежную защи ту с помощью контрольных сумм и самовосстановления данных и метаданных для обнаружения и исправления ошибок, а также может быть сконфигу рировано как часть кластера системы active/active с двойным контроллером.

Итоговое решение представляет со бой СХД сдоступной пользователям емкостью 108 Тбайт и коэффициентом эффективности Zpool 50% при использовании двустороннего зеркального резервиро вания. Zpool разбит на 30 пар дисков с контролем четности, что обеспечива ет 240 Тбайт необработанной емкости (фактически 120 Тбайт). Итоговая полез ная емкость хранилища — 108 Тбайт, причем скорость чтения Zpool в 12,9 раза выше, чем для одного диска, а записи — в 8,5 раза. За исключением единствен ного запланированного отключения для обновления программного обеспечения, система работает без простоев и сбоев дисков с августа 2017 года.

Наряду с зеркальными группами поддерживаются двойные и тройные группы четности. Тройная четность рекомендуется для дисков большой емкости — 10 Тбайт и выше, при та ком уровне допустимы сбои в работе трех дисков в каждой группе данных. Кроме того, Open-E JovianDSS поддер живает саморезервирование хранилища с возможностью версионирования вплоть до раза в минуту. Функция резервного копирования автомати чески создает ротируемые в обозначенных рамках моментальные снимки тома в соответствии с заданными пользователем планами периодично сти, асинхронно реплицируя дельты снимков в локальное или удаленное хранилище.

Приложение, отвечающее за резерв ное копирование, очень легкое и может оставаться запущенным постоянно без значительного влияния на производи тельность системы. Его можно использовать для регулярных задач по резервному копированию и восстановлению или для мгновенного аварийного вос становления.

Описываемый кластер служит дока зательством масштабируемости СХД, а также виртуальной инфраструктурой хранения данных Technology Experience Lab для всех испытателей новых ре шений, что позволяет ему ежедневно подтверждать свои функциональные и эксплуатационные преимущества в реальных условиях.

Кроме того, кластер имеет потенци ал для дальнейшего масштабирования по мере роста потребностей в хране нии данных, для чего потребуется лишь добавить жестких дисков в корпусах JBOD. Верхний предел такого масшта бирования определяется свободным местом в стойках, доступностью при помощи кабелей SAS, количеством пор тов SAS на контроллере (контроллерах) и вычислительной мощностью управля ющего сервера. Масштабирование данного кластера JovianDSS в Technology Experience Lab возможно до объема в несколько петабайт, однако в связи с указанными ограничениями это, ско рее всего, его предел.

Если объемы вашего потенциально го роста и границы пользовательской базы не определены, как в примере с автомобильной компанией, то вам нужен другой вариант — хранилище, ко торое расширяется по мере необходимости и фактически не имеет верхнего предела возможностей. Речь о горизон тальном масштабировании, известном также как Scale-out.

СХД Scale-out основаны на сетевых связях, что позволяет по мере необходи мости добавлять к существующим кла-

стерам новые узлы практически без ограничений. Каждый кластер состоит из нескольких серверов, дисков и сете вого оборудования, при этом узлы кластера соединяются высокоскоростной сетью или кросс-платой. Благодаря та кому подходу нет необходимости в закупке оборудования «на вырост», так как емкость и производительность можно расширять, когда это становится необ ходимым. Всё решение по хранению данных выглядит для пользователей как единое целое и может управляться через единый интерфейс, даже если части его аппаратной составляющей разбросаны по разным городам или континентам.

Чтобы гарантировать работу такого набора «железа» как единого хранили ща, а также обеспечить расширяемость, отказоустойчивость и надежность, необ ходимо подобрать соответствующее программное обеспечение. Решение отNTT идеально подходит для тестирования комбинаций аппаратного и ПО и изуче ния их совместимости. С его помощью можно определить, какой вариант наи лучшим образом подойдет для ваших нужд — например, для выполнения ча стичного или полного восстановления системы после ransomware-атаки в об становке, приближенной к реальной.

В одной из таких систем использу ется PetaSAN — масштабируемая сеть хранения данных (SAN), построенная на Ceph. Последняя представляет со бой ведущую платформу хранения данных с открытым исходным кодом, цель которой — обеспечение хранения дан ных на объектном, блочном и файловом уровне с помощью распределенного вычислительного кластера. Кроме того, она поддерживает масштабируемость хранилища и реплицирует данные, обе спечивая их отказоустойчивость, самовосстановление и самоуправление. Одна из возможных проблем заключа ется в том, что для ее настройки и обслуживания требуется администратор со знанием Linux. Для ее решения и был запущен open-source-проект PetaSAN. Он упаковывает всю мощь и сложность Ceph в одноэкранный интерфейс управ ления, сохраняя возможность доступа

к всемогущей командной строке Linux, когда это необходимо. Цель — предо ставление высокодоступных кластерных iSCSI-дисков, каждый из которых сопоставлен со всеми физическими дисками в системе. Это означает, что, например, в кластерной гипервизорной среде могут поддерживаться одновре менные транзакции нескольких виртуальных машин (ВМ) без заметного влияния на производительность.

Платформа построена с исполь зованием аппаратного обеспечения от Starline Computer GmbH, состояще го из RAID-карт Areca в режиме passthru в сочетании с 10‑гигабитными Ethernet-контроллерами Cavium с уда ленным прямым доступом к памяти (RDMA). Внедрение PetaSAN позволяет получить высокодоступные кластерные диски iSCSI объемом 220 Тбайт на вы сокопроизводительных HDD Toshiba корпоративного класса емкостью 10 Тбайт. Полученные таким образом диски с ре жимом многопутевого подключения могут быть идентифицированы по виртуальным IP-адресам и обеспечены быстрым вводом/выводом с резервированием каналов.

Добавлю: эта система предоставляет ресурсы виртуального хранилища для Technology Experience Labs, особенно полезные для проверки концепций, тре бующих масштабируемости.

Разумеется, вы можете отказаться от эксплуатации и обслуживания аппа ратных решений для хранения данных, или же при реализации может потребо ваться сочетание собственных аппаратных и облачных ресурсов. В таких ситуациях можно рассмотреть возможность использования службы Amazon Simple Storage Service (S3). Благодаря Starline, в этой тестовой платформе имеется инте грированный шлюз S3, доступный через командную строку. В будущем он дол жен получить интерфейс для настройки.

Определение оптимального подхода к организации центра обработки дан ных — непростая задача. Требования к производительности и пропускной способности постоянно растут, но объ емы этого роста сложно запланировать заранее. Здесь приходят на помощь решения, подобные описанному нами варианту. NTT предлагает профессионально организованное физическое пространство с поддержкой от сообще ства — это позволяет проводить эксперименты с использованием значимых систем. К тому же с его помощью мож но в некритических для систем условиях оценить и измерить реальные решения повседневных задач.

Как создать эффективный ЦОД?

text: Райнер В. Кезе, старший менеджер по развитию бизнеса, подразделение устройств хранения данных, Toshiba Electronics Europe GmbH

Количество информации в мире, хранимой удаленно, постоянно увеличивается. Поэтому все боль шую важность приобретает разработка систем, способных справиться с таким потоком данных. Основные критерии оценки таких систем: • Стоимость: учитывая невероятные объемы информации, главным кри терием становится соотношение стоимости к емкости (цена за 1 Тбайт). • Габариты: место в серверных ЦОДах.

Для его минимизации применяются диски наибольшей емкости, установ ленные в компактные 19‑дюймовые стойки. • Рассеивание мощности: накопители в ЦОДах и облачных системах хране ния данных работают в режиме 24/7, соответственно рассеивание мощ ности напрямую влияет на показатель совокупной стоимости эксплуатации. Помимо этого, каждый ватт, потребляемый в СХД, должен ком пенсироваться системой охлаждения ЦОДа, что также увеличивает затраты на электроэнергию. • Производительность: никто не хочет ожидать доступа к своим данным до бесконечности, поэтому от СХД в ЦОДе требуется определенный уро вень производительности. Под резервное копирование данных также отводится достаточно ограниченное время, поэтому пропускная способ ность системы должна позволять записать все данные в этот промежуток. А в случае непредвиденного сбоя данные из резервной копии необхо димо восстановить в кратчайшие сроки, чтобы минимизировать простой в бизнес-процессах клиента.

В этом исследовании основное вни мание уделялось оптимизации затрат и рассеиваемой мощности при мини мизации габаритов системы хранения данных. Оптимизация ее производитель ности не была его целью, но контрольные значения в этой категории также изме рялись. Если клиента интересует именно производительность, рекомендуется применять другие решения, например твердотельные накопители. При этом сто ит учесть, что соотношение их стоимости кемкости во много раз превышает пока затели систем на базе жестких дисков.

Архитектура СХД : выбор жестких дисков

Жесткие диски предлагают самое низкое соотношение стоимости к ем

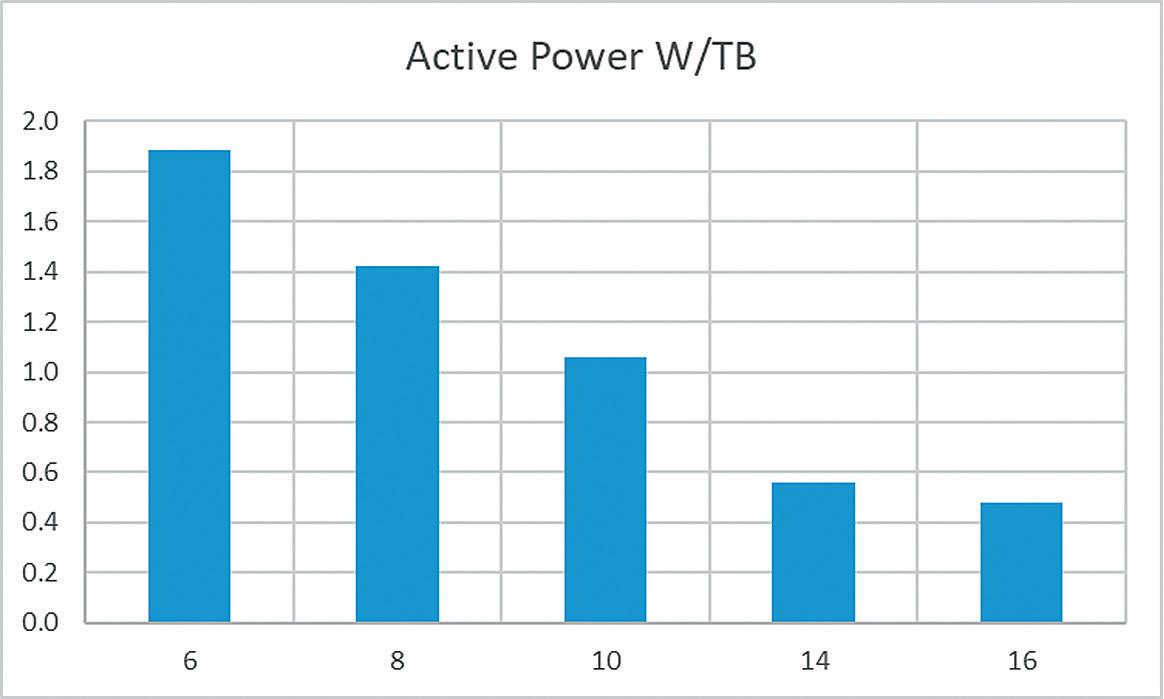

кости в расчете на один юнит в системе хранения данных ЦОДа, поэтому именно они были выбраны для дальней шего исследования. Стоимость 1 Тбайта в современных моделях емкостью 12, 14 ли 16 Тбайт примерно одинако ва, поэтому выбор максимально емкого жесткого диска на это соотношение особо не влияет. Однако при примене нии накопителей емкостью 16 Тбайт понадобится меньше устройств, чтобы выйти на запланированный объем СХД. И это напрямую влияет на следующий критерий оценки: меньшее количество жестких дисков занимает меньше ме ста в стойке и рассеивание мощности в расчете на единицу емкости также оказывается в этом случае значитель но меньше (см. таблицу 1).

Как видно из данных выше, для снижения рассеивания мощности и уменьшения габаритов системы ре комендуется применять жесткие диски максимально доступной емкости, в дан ном случае — 16 Тбайт.

Жесткие диски производства Toshiba указанной емкости доступны в линей ке MG08 и выпускаются в версиях с интерфейсами SAS либо SATA. SAS-версия

имеет два канала с пропускной способ ностью 12 Гб/с, что позволяет исполь зовать эти накопители в системах, для которых важнейшими параметрами являются производительность и макси мальная доступность. За счет этого повышается уровень рассеивания мощности, так как SAS-жесткие диски потребляют примерно на 1-2 Вт больше, чем вер сия SATA. Учитывая, что целью исследования была оптимизация рассеивания мощности, для него была выбрана вер сия MG08ACA16TE с интерфейсом SATA.

Ниже приведены показатели рассе ивания мощности этой модели под различной нагрузкой: Чтение случайных блоков размером 4 Кбайт, QD=16: 8,60 Вт Запись случайных блоков размером 4 Кбайт, QD=16: 5,83 Вт Последовательное чтение: 7,50 Вт Последовательная запись: 6,83 Вт Ожидание: 4,00 Вт Максимальная нагрузка при запуске за 500 мс: 16,85 Вт

Модели на 45–100 жестких дисков высотой 4 юнита лучше всего подхо дят для накопителей корпоративного уровня формфактора 3,5 дюйма (так называемые жесткие диски Nearline). На рынке доступны версии серверно го типа или JBOD с одним либо двумя SAS-экспандерами.

Для данного проекта была выбра на стандартная дисковая полка AIC на 60 накопителей, которую можно уста новить в любую 1000‑мм стойку благодаря компактной конструкции. Стоит отметить, что модели на большее коли чество жестких дисков длиннее, поэтому 1000‑мм стойка окажется для них недостаточно глубокой. Этот вариант JBOD-полки подходит для исследова ния, так как упрощает измерение рассеивания мощности жестких дисков и подключение к системе за счет зад ней платы и экспандера. Модель с одним SAS-экспандером была выбрана потому, что это позволяет снизить стои

Таблица 1. Рассеивание мощности и емкость жестких дисков корпоративного уровня (источник: данные и руководства Toshiba, параметры брались для чтения/записи случайных блоков размером 64 Кбайт с QD=1 для 1 накопителя)

Год

2013 2015 2017 2018 2019

Модель

MG04ACA MG05ACA MG06ACA MG07ACA MG08ACA

Емкость (Тбайт)

6 8 10 14 16

Энергопотребление в активном режиме (Вт)

11,3 11,4 10,6 7,8 7,7

Соотношение Вт/Тб в активном режиме

1,9 1,4 1,1 0,6 0,5

мость и рассеивание мощности. Также в выбранных накопителях SATA в любом случае есть только один канал для пере дачи данных. Наименование модели — AIC-J4060–02 (JBOD, высота 4 юнита, 60 отсеков для жестких дисков, версия 02 = 1 SAS-экспандер).

Общая емкость такой JBOD-дисковой полки на 60 накопителей (при полной загрузке жесткими дисками емкостью 16 Тбайт) достигает 960 Тбайт, то есть обеспечивает почти петабайт дисково го пространства. Полка подключается к адаптеру системной шины или кон троллеру RAID-массива сервера при помощи одного кабеля mini-SAS-HD.

Параметры системы

Энергопотребление полностью загруженной JBOD-полки на 60 жестких дисков измерялось при помощи терми налов (клемм) резервных БП с напряжением 220 В. Все измерения велись при температуре окружающей среды 24 °C.

Сперва рассеивание мощности включенной JBOD-стойки было изме рено без установленных жестких дисков: JBOD (включена), без накопителей, SAS-подключение — 80 Вт

Следующий этап — установка в JBOD одного жесткого диска и снятие пока заний при различной рабочей нагрузке, включая последовательную запись (нагрузка, характерная для архивации данных, видеозаписи и создания ре зервных копий) и чтение (нагрузка, аналогичная восстановлению резервных копий данных и стримингу медиафай лов) блоков размером 64 Кбайт. Также были получены контрольные значения энергопотребления при чтении/записи случайных блоков размером 4 Кбайт,

Рисунок 2. Жесткий диск Toshiba из линейки MG08 емкостью 16 Тбайт

которые соответствуют работе с «горячими» файлами в базах данных, но эта информация не относилась к цели ис следования, так как обычно системы с одним или более жесткими дисками для подобных операциях не применя ются. Во всех случаях измерялось как рассеивание мощности, так и показа тели производительности (IOPS для чтения/записи случайных блоков и Мб/с для последовательных операций).

В дополнение кэтим пограничным слу чаям рабочих нагрузок было проведено тестирование в условиях, максимально приближенных к реальным. В его ходе производились чтение и запись блоков различных размеров, выбранных слу чайным образом: 20% блоков размером 4 Кбайт, 50% блоков размером 64 Кбайт, 20% блоков размером 256 Кбайт и 10% блоков размером 2 Мбайт. Чтобы добить ся максимально возможной производительности, для всех синтетических нагрузок использовалась глубина очереди (QD), равная 16. Помимо этих тестов, оце нивалось рассеивание мощности при стандартном копировании файлов в ОС Windows.

Нагрузка

Последовательная запись блоков размером 64 Кбайт Последовательное чтение блоков размером 64 Кбайт Запись случайных блоков размером 4 Кбайт Чтение случайных блоков размером 4 Кбайт Смешанная нагрузка чтение/запись Копирование файлов в ОС Windows

Энергопотребление, Вт

85 86 83,6 84 84,2 85

IOPS

- 350 420 200

Пропускная способность 270 Мб/с 270 Мб/с

- 70 Мб/с 110 Мб/с

Нагрузка

Последовательная запись блоков размером 64 Кбайт Последовательное чтение блоков размером 64 Кбайт Запись случайных блоков размером 4 Кбайт Чтение случайных блоков размером 4 Кбайт Смешанная нагрузка чтение/запись

Энергопотребление, Вт

445 500 445 470 475

IOPS

- 23000 7600 1800

Пропускная способность

1900 Мб/с 2100 Мб/с

- 550 Мб/с

Полученные значения для одного жесткого диска (за вычетом 80 Вт, ко торые потребляет JBOD-полка без накопителей) оказались ниже, чем в спецификациях. В отличие от спецификаций жесткого диска показатели при после довательных операциях выше, чем при случайном чтении/записи. Это связано с более высоким энергопотреблением SAS-расширителя в JBOD при увеличе нии пропускной способности в операциях последовательного чтения/записи.

После подключения 60 16‑терабайт ных накопителей к JBOD-полке было измерено максимальное рассеивание мощности при запуске системы, а так же энергопотребление в режиме ожидания без операций чтения/записи:

JBOD с накопителями, макс. показа тель при загрузке за 500 мс: 720 Вт

JBOD в режиме ожидания: 420 Вт

Максимальная потребляемая мощ ность при запуске JBOD ниже расчетного значения (80 Вт+60×16,85 Вт = 1100 Вт), поскольку жесткие диски за пускаются с задержкой по времени. Значение для JBOD в режиме ожида ния выше расчетного (80 Вт+60×4 Вт = 320 Вт), так как контроллер время от времени обращается к жестким дис кам даже в этом режиме. 60 жестких дисков в режиме JBOD, параллельная нагрузка

На следующем этапе все 60 накопителей в режиме JBOD получали прямые параллельные запросы от ОС. Синтети ческие нагрузки в данном случае позволили снова измерить рассеивание мощности системы и ее производитель ность (для справки).

Потребляемая мощность во время всех рабочих нагрузок не превышала 500 Вт.

Локальный RAID-массив

На этой стадии 60 жестких дисков были объединены в один виртуальный на копитель при помощи RAID-контроллера в режиме RAID10 с пятью подмассивами. Из получившихся в результате 480 Тбайт свободного пространства в Windows Server 2016 было сформировано два ло гических диска емкостью по 240 Тбайт.

Программно-определяемая система хранения данных

И на последнем этапе все 60 жестких дисков были объединены в программно-определяемую систему хранения данных с файловой системой ZFS под управлением ПО JovianDSS, разра ботанного компанией Open-E.

Резервирование и надежность хранения данных обеспечивались при помощи их зеркалирования, для чего использовалось пять подмассивов жестких дисков, твердотельный накопи тель корпоративного уровня емкостью 800 Гбайт для кэширования операций чтения и аналогичный накопитель для буферизированной записи в лог. Пул на копителей был доступен серверу через протокол iSCSI, при этом система была разбита на логические диски емкостью 240 Тбайт. Тестирование логических дисков в RAID-массиве включало в себя стандартные рабочие нагрузки (чте ние/запись случайных блоков, последовательные чтение и запись, смешанные нагрузки и копирование данных в ОС Windows). Производительность логиче ских дисков в ZFS при использовании протокола iSCSI в первую очередь за висит от пропускной способности сети и от конфигурации твердотельных нако пителей. Поэтому значения синтетических рабочих нагрузок в данном случае указаны только для справки.

Заключение

Система хранения данных в ЦОДе общей емкостью 1 петабайт в современ

Рисунок 4. ПО JovianDSS от Open-E

ных условиях может состоять из 16‑терабайтных жестких дисков, установленных в JBOD-полку высотой 4 юнита, и по тре блять менее 500 Вт. Реальный показатель ее энергопотребления колеблется между 420 Вт (режим ожидания, без операций чтения/записи) и 480 Вт (по стоянное чтение/запись блоков данных различного размера).

В системах хранения данных стан дартной конфигурации, то есть при зеркалировании и работе в режимах RAID, максимальный доступный объем сво бодного места при полной загрузке полки из 6016‑терабайтных жестких дисков

Нагрузка

Последовательная запись блоков размером 64 Кбайт Последовательное чтение блоков размером 64 Кбайт Запись случайных блоков размером 4 Кбайт Чтение случайных блоков размером 4 Кбайт Смешанная нагрузка чтение/запись Копирование файлов в ОС Windows

Энергопотребление, Вт

425 460 445 480 465 430

IOPS

- 9800 12 000 2700

Пропускная способность

3900 Мб/с 6200 Мб/с

- 790 Мб/с 320 Мб/с

Нагрузка

Режим ожидания (фоновые задачи ZFS активны) Последовательная запись блоков размером 64 Кбайт Последовательное чтение блоков размером 64 Кбайт Запись случайных блоков размером 4 Кбайт Чтение случайных блоков размером 4 Кбайт Смешанная нагрузка чтение/запись Копирование файлов в ОС Windows

Энергопотребление, Вт

430 445 440 470 455 480 450

IOPS

- (2700) (7000) 1100

Пропускная способность

- (250 Мб/с) (550 Мб/с)

- 330 Мб/с 230 Мб/с

колеблется от 480 Тбайт (RAID10/чере дование четности с зеркалированием) до 800 Тбайт (RAID60/двойное чередо вание четности). Общее энергопотребление системы в этом случае достигает примерно 1 Вт на каждый терабайт емкости при зеркалировании и снижа ется до 0,5 Вт на терабайт в режимах RAID с чередованием четности.

Прогнозы на будущее

По оценкам Toshiba Electronics Europe, в 2019 году было отгружено корпоративных (Nearline) жестких дис ков общей емкостью около 500 экзабайт (500 000 Пб). При условии, что емкость каждого диска была равна 16 Тб и все они были установлены в JBOD-полки на 60 устройств, общее постоянное энергопотребление этих систем составило бы 225 МВт (что примерно равно количеству электри чества, вырабатываемого угольной ТЭС средней мощности). Но большая часть этих жестких дисков имела мень шую емкость, поэтому стоит предположить, что их энергопотребление было выше. Учитывая, что в будущем объ емы данных в мире могут только расти, снижение затрат электроэнергии на их хранение будет приобретать все большую важность. Поэтому для всей отрасли в целом и для компании Toshiba в частности одной из главных целей должны стать разработка и про изводство жестких дисков со все большей емкостью и минимизация рассеивания их мощности.