Okiemużytkownika Cyfryzacja PKP Intercity

cyberbezpieczeństwo: cyberbezpiec

Okiemużytkownika Cyfryzacja PKP Intercity

cyberbezpieczeństwo: cyberbezpiec

dobre, bo polskie dobre, bo

Gospodarka o obiegu zamkniętym Polski rynek smart home

Bezpieczna infrastruktura krytyczna

Chcesz być na bieżąco z tym co najważniejsze w branży IT w Polsce i nie tylko?

Możesz dostawać trzy razy w tygodniu newsletter CRN, z którego szybko dowiesz się o ważnych wydarzeniach i nowościach z ostatnich 48 godzin.

n wejścia na rynek, n fuzje i przejęcia, n kluczowe newsy z branży, n zmiany personalne, n skróty najważniejszych raportów

Masz konto na CRN.pl?

– to wszystko trafi do Ciebie mejlem, w każdy poniedziałek, środę i piątek.

Włącz wysyłkę newslettera CRN na stronie CRN.pl/prenumerata (wymagane wcześniejsze zalogowanie na CRN.pl/logowanie).

Nie masz jeszcze konta na CRN.pl?

Załóż je na stronie CRN.pl/rejestracja

Najpierw klient, potem inwestor

Klienci powinni być na szczycie

Klienci powinni na szczycie hierarchii, również dla startupów również dla startupów.

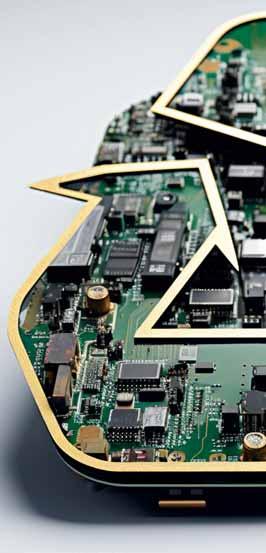

Niebezpieczne połączenie

Infrastruktura krytyczna to często połączenie IT

i OT. Oba środowiska często powstawały w różnym czasie, więc są to zwykle dwa odmienne światy.

10 Schneider Electric w Paryżu AI wyzwaniem i szansą dla centrów danych

11 Po partnersku naRising Stars Spotkanie partnerów Dagma Bezpieczeństwo IT

12 Startupy SI opływają w pieniądze, choć nie mają klientów Amerykańskie fundusze VC pompują mnóstwo pieniędzy w startupy utożsamiane ze sztuczną inteligencją

13 Szczypta dziegciu w beczce w prognozami finansowymi Felieton Larry’ego Walsha

14 Okrągy Stół CRN Polska Cyberbezpieczeństwo: dobre, bo polskie

21 Najpierw klient, potem inwestor Felieton Szymona Janiaka

22 Programy partnerskie W pogoni za innowacjami

24 Samsung Memory: stabilność lepsza od pośpiechu Rozmowa z Maciejem Kamińskim, dyrektorem dywizji Samsung Memory w Polsce i regionie CEE

25 Senetic: platforma zakupowa dla partnerów Prostota składania zamówień, dostępność towaru i szybkie dostawy (advertorial Senetic)

26 Niebezpieczne połączenie Infrastruktura krytyczna to często połączenie IT i OT. Trzeba wiedzieć do jakiego stopnia procedury i narzędzia są wspólne dla obu tych środowisk

30 Fudo Enterprise Intelligent PAM Na czas kryzysu (advertorial Fudo)

31 Trustwave i SpiderLabs Kompleksowa ochrona infrastruktury krytycznej (advertorial Trustwave)

32 BlackBerry AtHoc Kryzys pod kontrolą (advertorial BlackBerry AtHoc)

34 PowerWalker EVS 5kVA

Zasilacz nowej generacji (advertorial Impakt, PowerWalker)

36 PAM ułatwia zapewnienie zgodności z NIS2

Operatorzy infrastruktury krytycznej będą zmuszeni do skrupulatnej weryfikacji obowiązujących u nich reguł polityki bezpieczeństwa (advertorial Wallix)

Obieg zamknięty, czy błędne koło? O obiegu O zamkniętym w gospodarce w gospodarce dużo rozmawia się dużo rozmawia również w branży również w branży nowych technologii technologii.

37 Cyberzagrożenia wreszcie na Twoim radarze SOCRadar, amerykański dostawca platformy do analizy cyfrowych zagrożeń, zadebiutował na polskim rynku (advertorial iIT Distribution, SOCRadar)

38 EVER: gwarancja zasilania i eksperckiego wsparcia Współpraca z poznańskim producentem jest nieoceniona zwłaszcza przy dostarczaniu zaawansowanych rozwiązań (advertorial EVER)

39 NIS2 szansą dla integratorów i ich klientów

Dyrektywa NIS2 to nie tylko szereg obowiązków, ale też szansa na poprawę cyfrowej ochrony w firmach i instytucjach (advertorial ESET, DAGMA Bezpieczeństwo IT)

40 Polski smart home Nadrabiamy dystans do świata

43 Magiczna moc „zjeb..., przepraszam”

Felieton Rafała Agnieszczaka

44 Zamknięty obieg, czy błędne koło?

Gospodarka o obiegu zamkniętym stała się jednym z wiodących tematów biznesowych

Felieton Marcina Babiaka

Felieton Wojciecha Urbanka 5/2024

47 Jaką wartość mają przegrane deale?

48 Sztuczna inteligencja najlepszym przyjacielem danych

Ze zgromadzonych danych trzeba wyciągnąć określoną wartość

50 Rekrutacja: „nie”, które brzmi jak „tak”

Rozmowa z Julią Awerianową, Senior IT Recruitment Consultantem w Yard Corporate

52 Egzaminy IIBA: życiowe podejście do testów

Felieton Hanny Gruzdowskiej

54 Analityku, witaj w erze post-agile!

Felieton Pawła Cyzmana

55 Lepszy raj

Felieton Arnolda Adamczyka

Porażki są przereklamowane

Felieton Piotra Karwatki

56 Kto mieczem wojuje, od miecza ginie

Felieton Kyle’a Alspacha

58 Pociąg do informatyki

Rozmowa z Tomaszem Gontarzem, do kwietnia 2024 wiceprezesem zarządu

PKP Intercity

64 Sukces nie ma wieku

Felieton Wacława Iszkowskiego

66 Przełącznik w mózgu

Wpierwszym kwartale 2024 trzynaście spośród osiemnastu największych firm technologicznych na świecie zanotowało wzrost przychodów (rok do roku). Bank rozbiła Nvidia, uzyskując trzycyfrowy wynik (+265 proc.), podczas gdy pozostali rośli w jedno- lub dwucyfrowym tempie. Korki od szampana wystrzeliły także między innymi w gabinetach szefów AWS-u, Microsoftu, Broadcomu i Salesforce’a. Nie mogą natomiast pierwszych trzech miesięcy tego roku zaliczyć do udanych takie koncerny, jak: Apple, Cisco, Dell, HP oraz HPE.

Ważnym sygnałem jest uśredniony wynik całej osiemnastki, którą Canalys określił swego czasu mianem Tech Titans, tworząc indeks o takiej właśnie nazwie, który pełni rolę barometru mierzącego aktualną kondycję amerykańskiej, a w dużym stopniu również globalnej branży IT.

I tak, w pierwszym kwartale br., Tech Titans Index wzrósł pod względem przychodów o 8,6 proc., co stanowi kontynuację korzystnego trendu, bo w ostatnich czterech kwartałach odsetek ten też był dodatni, wynosząc 3,6 proc. Wygląda więc na to, że po kilku chudych kwartałach z lat 2022–23, nadeszła trwała poprawa koniunktury, choć – jak już wspomniałem – nie dotyczy to wszystkich tuzów sektora IT.

Analitycy podkreślają, że cierpią głównie dostawcy pecetów (chociaż akurat Lenovo zaliczyło dodatni wynik, w przeciwieństwie do Della i HP), co ma jednak niebawem ulec zmianie, gdyż nadchodzi wielka wymiana sprzętu kupowanego na pniu w czasie niedawnych lockdownów. Proces ten ma być napędzany sztuczną inteligencją, choć w tym przypadku resellerzy zwracają uwagę na brak spójnego przekazu marketingowego na temat namacalnych korzyści dla użytkowników – pod tym względem producenci wciąż mają niełatwą lekcję do odrobienia. Tym bardziej, że w przekazach medialnych coraz częściej pisze się o AI w kontekście wysokiego zużycia energii, co stoi w sprzeczności z lansowanymi bardzo mocno w Unii Europejskiej tzw. celami klimatycznymi

(swoją drogą, pod tym względem pod górkę wizerunkowo mogą mieć niebawem także dostawcy infrastruktury centrów danych, choć na tym etapie to jedynie luźne przypuszczenie).

Co ważne, w pierwszym kwartale 2024 łączny wzrost dochodu netto technologicznych tytanów był dwucyfrowy, przebijając poziom 40 proc., a łączna kapitalizacja największych koncernów skoczyła o blisko połowę (49,2 proc.). Zatem również pod względem tych dwóch wskaźników mamy do czynienia z kontynuacją korzystnego trendu, począwszy od drugiego kwartału ubiegłego roku. To wszystko stanowi dość solidną podstawę, aby zaryzykować prognozę, że druga połowa tego roku zaskoczy nas pozytywnie, podobnie jak rok 2025. Niestety, ani w Europie, ani na polskim rynku sytuacja tak różowa nie jest: według Contextu wartość sprzedaży w europejskiej dystrybucji spadła w pierwszym kwartale rok do roku o około 6 proc., a w Polsce o 4 proc. Niemniej, brytyjscy analitycy przewidują, że jesteśmy tuż przed okresem wzrostu sprzedaży także w naszej części świata. Oby!

Tomasz Gołębiowski Redaktor naczelny

MIESIĘCZNIK CRN POLSKA www.CRN.pl

Rok 27, numer 5 (499), 22 maja 2024 PL ISSN 2080-8607

REDAKCJA

Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa redakcja@crn.pl

Tomasz Gołębiowski tg (redaktor naczelny) tel. 608 425 699 tomasz.golebiowski@crn.pl

Wojciech Urbanek wu (zastępca red. naczelnego) tel. 691 672 065 wojciech.urbanek@crn.pl

Karolina Marszałek km (sekretarz redakcji) karolina.marszalek@crn.pl

Andrzej Gontarz ag andrzej.gontarz@crn.pl

Krzysztof Jakubik kj krzysztof.jakubik@crn.pl

Krzysztof Pasławski kp krzysztof.paslawski@crn.pl

Tomasz Janoś tj tomasz.janos@crn.pl

FELIETONY

Arnold Adamczyk, Rafał Agnieszczak, Marcin Babiak, Paweł Cyzman, Hanna Gruzdowska, Wacław Iszkowski, Szymon Janiak, Piotr Karwatka, Wojciech Urbanek, Larry Walsh,

GRAFIKA, LAYOUT, KOORDYNACJA PRODUKCJI: Tomasz Baziuk

FOTOGRAFIE

Theta Art Studio Tomasz Pisiński, PhotobyMysluk.pl, Adrian Stykowski, Piotr Syndoman, archiwum

PRENUMERATA prenumerata@crn.pl

REKLAMA I PROJEKTY SPECJALNE Agata Myśluk tel. 694 455 426 agata.mysluk@crn.pl Jacek Goszczycki tel. 601 935 513 jacek.goszczycki@crn.pl

WYDAWCA

Peristeri Sp. z o.o. Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa

Reklamy są przyjmowane w siedzibie wydawnictwa. Za treść ogłoszeń redakcja nie ponosi odpowiedzialności. © 2024 Peristeri Sp. z o.o. Wszelkie prawa zastrzeżone.

DM BOŚ podniósł cenę docelową akcji AB z 83,50 zł do 96,60 zł i podtrzymał rekomendację „kupuj”. „Oczekujemy, że wyniki spółki w kolejnych kwartałach będą napędzane m.in realizacją przetargów publicznych, środkami z Europejskiego Planu Odbudowy czy oczekiwanym ożywieniem wydatków konsumenckich” – stwierdzono w raporcie. Analitycy spodziewają się wzrostu zysku na akcję AB za II kw. finansowy 2023/24 (I kw. 2024 r.) o 5 proc. rok do roku. Wynik na plusie oznaczałby kontynuację trendu z I kw. finansowego 2023/24 (IV kw. 2023 r.), gdy zysk netto grupy poprawił się o 5 proc. r/r, do kwoty 71,5 mln zł, przy przychodach na poziomie ponad 5 mld zł.

Zespół z Polski i Finlandii znalazł się na podium Locked Shields 2024. To największe na świecie ćwiczenia z cyberobrony, organizowane przez NATO Cooperative Cyber Defence Centre of Excellence (CCDCOE). Zorganizowano je w Tallinie (Estonia). Wzięło w nich udział około 4 tys. ekspertów z ponad 40 krajów, w tym specjaliści z Wojskowej Akademii Technicznej w Warszawie. W tegorocznej edycji Polskę i Finlandię po raz pierwszy reprezentował jeden zespół, dowodzony przez oficera Dowództwa Komponentu Wojsk Obrony Cyberprzestrzeni. Do polskiej części ekipy weszli przedstawiciele sił zbrojnych, CSIRT poziomu krajowego, służb, przemysłu i uczelni.

Państwowa Wytwórnia Papierów Wartościowych wdraża system ERP od SAP-a. W tym celu podpisała umowę z warszawską firmą KBJ. Jej przedmiotem jest projekt wdrożenia systemu SAP S/4 HANA wraz z obsługą gwarancyjną i pracami dodatkowymi. Wartość kontraktu przekracza 20 mln zł netto. Przewidywany czas zakończenia realizacji projektu wdrożenia to 1 stycznia 2026 r. KBJ należy do największych firm wdrożeniowych na polskim rynku. W 2023 r. miała ponad 80 mln zł przychodów i 3 mln zł zysku netto.

Maxcom zwiększył w 2023 r. sprzedaż o 5 proc. rok do roku, odnotowując najwyższe w historii przychody o wartości 134,4 mln zł. Polski producent i dystrybutor urządzeń mobilnych wypracował 2,9 mln zł zysku operacyjnego wobec straty na poziomie minus 1,2 mln zł przed rokiem. Zysk netto sięgnął natomiast sumy 422 tys. zł wobec 4,4 mln zł na minusie w 2022 r. Na wzrost zainteresowania produktami Maxcomu miało wpłynąć rozszerzenie asortymentu o urządzenia marki własnej i innych dostawców, rozwój e-commerce i wzmocnienie pozycji za granicą. Producent rozbudował ofertę smartwatchy i urządzeń z kategorii elektromobilności, rozszerzając ponadto sprzedaż hurtową komponentów do instalacji fotowoltaicznych.

Grupa kapitałowa Sygnity według wstępnych, szacunkowych danych uzyskała w I kw. 2024 r. około 62 mln zł przychodów, a więc 18 proc. więcej niż rok wcześniej (52,3 mln zł). Z kolei zysk poprawił się o 40 proc., do około 8 mln zł (z 4,9 mln zł przed rokiem). Dane uwzględniają wyniki finansowe spółek przejętych przez Sygnity w tym roku, tj. Edrana Baltic z Wilna oraz Sagra Technology ze Szczecina.

„1miliardeurozainwestowanew opensourcedajedo PKBdodatkowe95miliardów”– Dariusz Świąder, prezes Linux Polska.

UOKiK postawił zarzuty Jura Poland (wyłączny importer ekspresów do kawy marki Jura) i osobie zarządzającej w spółce, która odpowiadała za politykę dystrybucyjną. Postępowanie prowadzone jest również przeciwko sprzedawcom ekspresów Jura: Euro-net, Media Saturn Holding, Media Saturn Online i Terg, czyli właścicielom sklepów RTV Euro AGD, Media Markt i Media Expert. Za udział w porozumieniu ograniczającym konkurencję grozi im kara 10 proc. obrotu, a menedżerom 2 mln zł. Jak utrzymuje UOKiK podczas przeszukania w siedzibach kilku spółek znaleziono dowody wskazujące, że Jura Poland mogła zawrzeć porozumienie ograniczające konkurencję z autoryzowanymi dystrybutorami swoich produktów.

sąd skazał na 13 lat i 7 miesięcy więzienia Jarosława W., obywatela Ukrainy oskarżonego o udział w głośnych atakach wykorzystujących luki w oprogramowaniu Kaseya w 2021 r. Ofiarami miało paść ponad 1 tys. firm. W ocenie śledczych ma on na koncie więcej podobnych przestępstw. Usłyszał wyrok za udział w ponad 2,5 tys. ataków z wykorzystaniem ransomware na całym świecie. Jarosław W., który przyznał się do winy, nie dość, że pójdzie za kraty, to jeszcze ma zapłacić 16 mln dol. odszkodowania.

Władze USA ogłosiły nowy, obszerny pakiet sankcji gospodarczych. Wśród prawie 300 celów jest embargo nałożone na dziesiątki podmiotów, które zdaniem amerykańskiego rządu umożliwiły Rosji zdobycie „desperacko potrzebnej technologii” i sprzętu z zagranicy. Przykładowo, rosyjską gospodarkę wojenną miała wspierać słowacka spółka Carovilli Trading, która – jak twierdzi Departament Skarbu – kupuje sprzęt komputerowy i oprogramowanie, a następnie odsprzedaje je spółkom w Rosji.

do wycieku danych pacjentów All-Med Centrum Medyczne w Łodzi. Placówka otrzymała zgłoszenie w tej sprawie od Medily, dostawcy oprogramowania medycznego, który poinformował, że rekordy zostały skradzione w wyniku ataku hakerskiego. Łupem przestępców mogły paść takie informacje jak: imię i nazwisko pacjenta, PESEL, data urodzenia, dane adresowe, numer telefonu, dane o stanie zdrowia. Według All-Medu incydent dotyczył danych z okresu do końca 2019 r.

venture capital w Polsce w I kw. 2024 r. wyniosła 173 mln zł. To spadek o 61 proc. wobec I kw. 2023 r. – wynika z raportu PFR Ventures i Inovo VC. Znacznie skurczyła się przy tym liczba spółek, które pozyskały finansowanie – ze 128 przed rokiem do 30, którym środki przyznało 35 funduszy. „Mimo spadków, dostępność środków VC jest diametralnie lepsza niż przed 2019 rokiem. Zakładamy, że sytuacja poprawi się w drugiej połowie roku, po uruchomieniu nowych funduszy z programu FENG ” – prognozuje Aleksander Mokrzycki, wiceprezes PFR Ventures. Planowane inwestycje w ramach FENG to ponad 3,1 mld zł. Na tę kwotę składają się środki PFR Ventures oraz od inwestorów prywatnych.

„PolskastałasięwiodącymdostawcąterminaliStarlinkdla Ukrainy”– Mykhailo Fedorov, minister transformacji cyfrowej Ukrainy.

„WybraliśmyCEOz silnymi umiejętnościamisprzedażowymii przywódczymi” – Gustavo Möller-Hergt o swoim następcy w Also.

W dniu 14 października 2025 r. Microsoft zakończy wsparcie dla Windows 10. Po tej dacie będzie ono płatne. Jak poinformował koncern, w pierwszym roku ma kosztować 61 dol. (około 240 zł) za jedno urządzenie. W kolejnych latach stawka będzie rosła dwukrotnie (czyli 122 dol. oraz 244 dol. za 1 PC). W tej cenie koncern oferuje klientom komercyjnym rozszerzone aktualizacje bezpieczeństwa (ESU). Firmy korzystające z rozwiązania Microsoftu do zarządzania aktualizacjami w chmurze (Intune lub Windows Autopatch) mogą uzyskać 25 proc. zniżki na licencjonowanie ESU (czyli 45 dol. w pierwszym roku). Gigant łagodniej potraktował podmioty edukacyjne, gdzie stawki za ESU zaczynają się od 1 dol. w pierwszym roku (w kolejnych 2 dol. i 4 dol.). Patrząc na aktualne dane wygląda na to, że zanosi się na wymianę sprzętu i zakupy na dużą skalę. Z danych Statcounter wynika, że w Polsce w marcu 2024 r. z Windows 10 działało 72,09 proc. komputerów, które mają zainstalowany system Microsoftu, a z Windows 11 25,09 proc.

Ailleron zawarł porozumienie z Pekao SA w sprawie uregulowania stosunków z bankiem po wypowiedzeniu przez spółkę umowy z 2018 r. Dotyczyła ona wdrożenia, uruchomienia, utrzymania i rozwoju internetowej platformy bankowości transakcyjnej dla firm. Ailleron w ub.r. zarzucił Pekao naruszenie warunków kontraktu, domagając się zapłaty około 44,2 mln zł. W minionym miesiącu strony porozumiały się, że rozwiążą spór w sposób polubowny. Wartość brutto porozumienia według krakowskiej spółki wynosi około 9,6 mln zł, na co składa się wynagrodzenie od banku za wykonane prace, prawa autorskie i inne.

MCI nabyło 65 proc. akcji poznańskiej spółki Profitroom, dostawcy rozwiązań do zautomatyzowanej obsługi rezerwacji hotelowych, zarządzania kanałami sprzedaży, relacjami z klientem i obsługi płatności. Wycena spółki wyniosła 290 mln zł, a sprzedającymi są jej założyciele i poznańska spółka cyber_Folks (do ub.r. pod nazwą R22). Profitroom w ciągu 5 lat czterokrotnie zwiększył swoje przychody. W 2022 r. wyniosły 52 mln zł przy zysku netto na poziomie 5,3 mln zł. Spółka zatrudnia blisko 300 osób i działa w niemal 50 krajach.

n Fikcyjne faktury na tusze i tonery

CBA zatrzymało w woj. śląskim i małopolskim cztery osoby w związku z wystawianiem i przyjmowaniem nierzetelnych faktur. Śledztwo ma dotyczyć „wielu spółek” i obejmuje lata 2013–2016. Jedną z nich jest spółka z o.o., która w 2015 r. uzyskała prawie 10 mln zł nienależnych zwrotów VAT-u. Przedmiotem fikcyjnego obrotu były głównie tusze i tonery, a także akcesoria i urządzenia do druku 3D. Ponadto w śledztwie pojawia się wątek wyłudzeń leasingowych oraz oszustw na bazie funduszy unijnych. Według CBA szkody skarbu państwa z tego tytułu wyniosły około 16 mln zł. W sprawę jest zamieszanych w sumie 28 podejrzanych.

Action podpisał list intencyjny dotyczący sprzedaży nieruchomości w Zamieniu przy ul. Arakowej. Chodzi o działkę o powierzchni 4,96 tys. mkw. Proponowana cena to 5,32 mln zł (powiększona o VAT). List intencyjny, nie stanowiąc oferty ani zobowiązania do zawarcia umowy, może być podstawą do uzgodnienia ostatecznych warunków transakcji. Środki ze sprzedaży zarząd chce przeznaczyć na rozwój spółki i grupy, w tym na planowane przejęcia. Nieruchomość nie była wykorzystywana gospodarczo. W opinii zarządu jej zbycie nie wpłynie negatywnie na działalność operacyjną.

Zaległości finansowe firm IT w Polsce wynoszą w sumie 264 mln zł – wynika z danych Krajowego Rejestru Długów. To oznacza, że zadłużenie branży wzrosło w ciągu 2 lat o jedną trzecią. Problemy z płatnościami ma blisko 7 tys. podmiotów, a średnie zadłużenie na jedną firmę wynosi 38 tys. zł (rekordzista z Poznania ma 8,4 mln zł długu). Największe kwoty firmy IT mają do oddania instytucjom finansowym. Co ciekawe, jeszcze więcej, bo prawie 400 mln zł, przedsiębiorcy z branży IT muszą odzyskać od swoich klientów, którzy nie płacą na czas. Nierzetelni kontrahenci działają głównie w sektorze handlowym.

Salony Cortland zaczną funkcjonować pod szyldem iSpot. Sieć obejmie w sumie 48 sklepów. Natomiast sklep internetowy Cortland.pl będzie nadal funkcjonować niezależnie – poinformował iSpot. W kwietniu 2023 r. iSpot Poland kupił 100 proc. udziałów w Cortland Apple Premium Reseller (cena transakcji nie została ujawniona). Jednym z pierwszych kroków w ramach łączenia obu organizacji było utworzenie w br. wspólnego zespołu, obsługującego klientów B2B. W dniu 19 kwietnia br. został uzgodniony plan połączenia obu spółek. Przewiduje on, że cały majątek Cortlandu zostanie przeniesiony na iSpota. Wartość księgową majątku przejmowanej poznańskiej spółki (wartość aktywów netto) na dzień 31 marca 2024 r. określono na blisko 29 mln zł.

Cisco sfinalizowało przejęcie Isovalent, dostawcy oprogramowania sieciowego open source, służącego do cyberochrony i zapewniania obserwowalności infrastruktury cloud-native. Nowy nabytek, z siedzibą w Dolinie Krzemowej i oddziałem w Szwajcarii, działa od 2007 r. Warunki finansowe transakcji nie zostały ujawnione, ale według nieoficjalnych doniesień cena wyniosła 650 mln dol. Technologie Isovalent mają stać się kamieniem węgielnym strategii platformy bezpieczeństwa Cisco Security Cloud.

Salesforce zrezygnował z planu zakupu Informatica. Według nieoficjalnych informacji w kwietniu br. zakończono negocjacje, które nie doprowadziły do porozumienia. Wartość ewentualnego przejęcia szacowano na około 11 mld dol. Informatica, która jest dostawcą usług do zarządzania danymi, działa od 1993 r. i jest kontrolowana obecnie przez private equity Permira oraz kanadyjską firmę inwestycyjną CPPIB. Ostatni duży zakup Salesforce’a – największy w historii firmy – miał miejsce w 2021 r., gdy dostawca CRM przejął Slacka za 28 mld dol.

Centrum Obsługi Administracji Rządowej ruszyło na wielomilionowe zakupy sprzętu i oprogramowania, w tym dla ministerstw i urzędów centralnych. W przetargu na dostawę drukarek, urządzeń MFP, skanerów i drukarek etykiet z budżetem 11,5 mln zł brutto (umowa ramowa) oferty złożyli: konsorcjum Copy.net.pl i Canona, Galaxy Systemy Informatyczne, Intaris oraz Suntar. Otwarto także oferty w postępowaniu na zakup oprogramowania ponad 20 dostawców (16,8 mln zł). W przetargu na świadczenie usług telefonii ruchomej wraz z dostawą telefonów komórkowych, modemów i kart SIM (65,5 mln zł) rywalizują Orange Polska i T-Mobile Polska. Z kolei w postępowaniu na zakup komputerów stacjonarnych, przenośnych, AiO, monitorów i tabletów (63,3 mln zł) oferty złożyli: Galaxy Systemy Informatyczne, Suntar, Immitis oraz konsorcja: Grupa E i FHU Horyzont Krzysztof Lech, NTT System z NTT Technology i Intaris, MDP Polska ITS i MBA System, Intaris i NTT Technology. Z wybranymi podmiotami zostaną zawarte umowy ramowe.

Piotr Podlawski objął stanowisko Head of Microsoft Cloud Services w Hostersi. W śląskiej spółce będzie odpowiadać za ofertę rozwiązań chmurowych Microsoftu i usług utrzymaniowych cloud. Poprzednie 4 lata (2019 – 2024) spędził w Beyond.pl, awansując na stanowisko Global Cloud Services Director. Wcześniej przez blisko 10 lat był związany z Integrit, jako wiceprezes i COO. Doświadczenie zdobywał także na stanowiskach kierowniczych w Incomie, GNT Poland (Also) i JTT Computer. W branży IT działa już od ponad 30 lat.

Mariusz Stusiński został prezesem Atende (zastępując w tej roli Marcina Petrykowskiego), zaś Jacek Szczepański objął funkcję wiceprezesa. Nowy prezes do zarządu wszedł w 2021 r., a z Grupą Atende jest związany od 13 lat. W tym czasie był wiceprezesem spółek zależnych Atende Software oraz Atende Industries. W branży IT działa od ponad 20 lat, pracując wcześniej w strukturach sprzedaży Orange i Nortela. Z kolei Jacek Szczepański w Atende pracuje od 2016 r. W styczniu br. został dyrektorem pionu cyberbezpieczeństwa, jednocześnie pełniąc rolę dyrektora Programu PGE. Jest menedżerem z ponad 25-letnim doświadczeniem, w tym jako dyrektor konsultingu usług technologicznych w HPE i członek zarządu SAP Polska.

Nazariy Kurochko, założyciel GigaCloud, objął teraz stanowisko CEO. W nowej roli zamierza przyspieszyć rozwój firmy na polskim rynku i w całej UE – w zakresie rozwiązań chmury publicznej i chronionej zarządzanej chmury prywatnej. Nazariy Kurochko ma prawie 20 lat doświadczenia w IT i ochronie danych. Od 2006 r. założył cztery duże firmy, w tym centrum danych, operatora telekomunikacyjnego i firmę zajmującą się cyberbezpieczeństwem. GigaCloud to dostawca usług chmurowych, który działa od 2016 r.

Tomasz Starzec, od blisko 10 lat związany z Amazon Web Services w Polsce jako Account Manager, w marcu br. opuścił firmę. Z kolei w czerwcu br. kończy studia podyplomowe z coachingu na Akademii Leona Koźmińskiego w Warszawie i zostanie dyplomowanym coachem. Kolejnym krokiem będzie akredytacja EMCC (European Mentoring & Coaching Council). Obecnie Tomasz Starzec już świadczy takie usługi, skupiając się na coachingu biznesowym. Menedżer ma blisko 30-letnie doświadczenie w branży w rolach kierowniczych i był pierwszą osobą zatrudnioną w AWS Polska. Wcześniej pracował jako dyrektor sprzedaży na Polskę w kanadyjskiej firmie Avigilon (2012 – 2014) oraz dyrektor sprzedaży na rynkach CEE w Anixterze (2008 – 2012). Ponad 12 lat był związany z APC Poland, w tym przez 8 lat jako Country Manager. Karierę zaczynał w JTT Computer.

Z początkiem kwietnia br. Piotr Baca został awansowany na stanowisko dyrektora regionu Brother Central and Eastern Europe. W nowej roli jest odpowiedzialny za realizację strategii biznesowej firmy i rozwój kanału partnerskiego. Będzie także współpracował z Marketing Managerem w zakresie działań marketingowych w regionie CEE. Piotr Baca pracuje w strukturach Brothera już prawie 20 lat, a przez ostatnie ponad 15 lat piastował stanowisko Country Managera w Brother Polska (nadal je pełni). Od października 2023 r. koordynował działania firmy na Ukrainie. Na początku swojej kariery w Brotherze pełnił funkcję Regional Sales Representative w Brother International Austria.

n Paweł

Działalność w Polsce rozpoczął iIT Distribution – VAD z siedzibą na Ukrainie, który specjalizuje się w rozwiązaniach z zakresu bezpieczeństwa informacji i cyberbezpieczeństwa. Ma w ofercie takich dostawców jak CrowdStrike, GTB Technologies, SOCRadar, Infinidat, Fastly, Terrazone czy Threema. Dostarcza rozwiązania wyłącznie poprzez sieć partnerską, a strategicznym celem iITD Polska jest zapewnienie partnerom zaawansowanego wsparcia sprzedażowego i technicznego na każdym etapie projektu. Polskim oddziałem iITD, jako General Country Manager, zarządza Mateusz Wepa, który pierwsze szlify w branży zdobywał od 2012 r. w Dagmie. Przez ostatnie 10 lat w Senetic rozwijał kanał sprzedaży w Wielkiej Brytanii i zarządzał działem handlowym w Polsce.

Paweł Meserszmit objął stanowisko Distribution Managera na region Europy Środkowo-Wschodniej w Vertiv Poland. Będzie odpowiadał za budowę i rozwój kanału partnerskiego oraz dystrybucyjnego, korzystając z wieloletniego doświadczenia we współpracy z dystrybutorami i resellerami. Wcześniej, przez ponad 7 lat rozwijał kanał sprzedaży rozwiązań audio i wideokonferencyjnych w Polycomie, działając na obszarze Europy Wschodniej. Bezpośrednio przed przejściem do Vertiva przez 2 lata współpracował z dystrybutorami rozwiązań cyberbezpieczeństwa w Acronisie.

Dwóch

W Warszawie powstała AI Chamber, której założycielem jest Tomasz Snażyk, prezes Fundacji Startup Poland (od 2020 r.). Głównym celem nowej Izby branżowej jest propagowanie odpowiedzialnego rozwoju sztucznej inteligencji w Europie ŚrodkowoWschodniej poprzez badania rynku, pomoc we wdrażaniu rozwiązań AI w różnych obszarach gospodarki, jak też budowanie platformy dla ekspertów do dialogu i dzielenia się doświadczeniami. AI Chamber zrzesza startupy, przedsiębiorstwa i organizacje pozarządowe działające w Polsce, a docelowo w regionie CEE.

Na początku kwietnia br. do Nanovo dołączyli: Józef Skóra, jako Chief Growth Officer oraz Dominic Brynolf – w roli Chief Growth Officer Global. Ich zadaniem jest wsparcie warszawskiej firmy w przyspieszeniu jej ekspansji międzynarodowej. Józef Skóra jest menedżerem z ponad 15-letnim doświadczeniem w obszarach sprzedaży i rozwoju biznesu, które zdobywał w korporacjach konsultingowych (EY, Deloitte) i firmach IT. Ostatnio był członkiem zarządu Yieldbird (2022 – 2024). Z kolei Dominic Brynolf jest ekspertem z ponad 20-letniem doświadczeniem menedżerskim w handlu detalicznym. Poprzednio był wiceprezesem Trigo (od 2023 r.) i starszym dyrektorem Bolta w Wielkiej Brytanii i Europie (od 2022 r.).

Piotr Nowok, dotychczasowy Business Manager Display, Gadgets & New Business w polskim oddziale Acera, objął nowo utworzoną funkcję kierowniczą Deputy Commercial Head. Tym samym będzie podejmował decyzje w zakresie rozwoju firmy w sektorze komercyjnym i edukacyjnym. Piotr Nowok jest związany z Acer Polska od ponad 10 lat. Wcześniej pracował w tej firmie na stanowiskach

Product Manager

Peripherals i Key

Account Manager.

Mariusz Madejczyk został zastępcą szefa NASK i dyrektorem ds. nowych technologii dla polityk publicznych. Ostatnio kierował Biurem Informatyki i Systemów Teleinformatycznych Podlaskiego Urzędu Wojewódzkiego w Białymstoku. Z administracją rządową jest związany od 1998 r. W latach 2018–2022 był dyrektorem oddziału

NASK w Białymstoku, a od 2016 do 2019 r. pełnomocnikiem ministra cyfryzacji ds. współpracy z administracją rządową i samorządową RP. Ponadto jest pomysłodawcą i współtwórcą Strategii Informatyzacji Państwa.

W obliczu rozwoju sztucznej inteligencji i rosnącego zapotrzebowania

na moc pilną potrzebą stała się poprawa efektywności centrów danych

– podkreślano podczas Innovation Summit Paris 2024.

W2030 r. powstanie dwa razy więcej nowych centrów danych (licząc w MW) niż w roku bieżącym, przy rocznym wzroście na poziomie 12 proc. Specjaliści Schneider Electric prognozują, że w tym okresie globalna konsumpcja energii w segmencie data center zwiększy się z obecnych 1,4 proc. do 2,2 proc. Co ważne, w przypadku rozwiązań wykorzystujących AI, w najbliższych latach przewidywany jest 2–3 razy szybszy wzrost niż na całym rynku data center. W 2023 r. obciążenia związane z AI pochłonęły 8 proc. z 56 GW całkowitej mocy (4,3 GW), podczas gdy w 2028 r. odsetek ten ma sięgać od 15 do nawet 20 proc. z 90 GW (13,5 – 18 GW) – szacują eksperci Schneidera. Tym samym wykorzystywanie możliwości, jakie daje AI, stanowi wyzwanie dla wszystkich graczy w segmencie DC. Zwłaszcza w takich kwestiach, jak pojemność (potrzeba odpowiedniej mocy), przestrzeń (a konkretnie jej brak), koszty (rosnące) i projektowanie (rosnąca skala działania hiperskalerów).

Skalowalne data center

Z powyższych powodów sprawdzianem możliwości dostawców centrów danych

będzie skalowalne centrum danych. W tym kontekście należy zwrócić uwagę na różnicę pomiędzy DC dla dużych modeli językowych (LLM) a tradycyjnym DC, którą jest zapotrzebowanie na niższe opóźnienia, co prowadzi do potrzeby przetwarzania na brzegu. O ile w 2023 r. centralnie przetwarzano 95 proc. obciążeń AI, zaś na brzegu jedynie 5 proc., to w 2028 r. proporcje te mają wynosić 50/50.

– Największym wyzwaniem związanym ze sztuczną inteligencją jest dostępność mocy – podkreślał Marc Garner, wiceprezes Secure Power Division Europe w Schneider Electric.

Sztuczna inteligencja ma również kluczowe znaczenie dla efektywności energetycznej centrów danych. Chodzi o to, że analiza danych pozwala podejmować lepsze i zautomatyzowane decyzje. Tym samym, jak można usłyszeć od przedstawicieli francuskiego producenta: „AI jest z jednej strony wyzwaniem, ale też rozwiązaniem, które poprawia efektywność energetyczną”.

W ocenie Schneidera do zrównoważonego rozwoju centrów danych w ramach obsługi AI potrzebne są trzy czynniki: energia, wyszkoleni specjaliści i właściwe partnerstwa. Producent poinformował, że współpracuje już w tym obszarze z Nvidią, Equinix’em, Digital Realty oraz firmą Aeven. Przykładowo, Schneider Electric i Nvidia wspólnie tworzą pierwszy kompleksowy projekt referencyjny dla publicznie dostępnych na rynku klastrów AI. Nowa architektura jest przeznaczona zarówno dla

istniejących centrów danych, jak i nowych obiektów projektowanych pod obciążenia związane ze sztuczną inteligencją.

– Potrzebujemy efektywności, a AI pomoże nam w jej osiągnięciu. Przy czym naszym celem jest dekarbonizacja – mówił Peter Herweck, CEO Schneider Electric.

Towarzyszy temu kształcenie talentów, co jest kluczowe dla dalszego rozwoju i utrzymywania centrów danych. W ciągu trzech najbliższych lat ma powstać 175 tys. miejsc pracy w tym właśnie segmencie rynku.

Podczas Innovation Summit Paris 2024 omawiano spodziewane efekty współpracy pomiędzy Schneider Electric a Digital Realty – funduszem inwestującym w nowoczesne centra danych. Oba podmioty realizują w ten sposób inicjatywę dotyczącą gospodarki o obiegu zamkniętym w jednym z paryskich centrów danych. Projekt ma na celu przedłużenie i utrzymanie żywotności systemów o znaczeniu krytycznym. Przykładem jest pierwszy w branży program regeneracji akumulatorów, którego celem jest wydłużenie cyklu życia akumulatorów UPS VRLA (pilotaż zapowiedziano na 2025 r.).

Wykorzystując wyposażenie od Schneidera, Digital Realty zakłada, że w ciągu 3–5 lat obniży poziom węgla zawartego w infrastrukturze nisko- i średnio napięciowej oraz trójfazowych UPS-ach o 50–70 proc., przy jednoczesnym przedłużeniu cyklu życia sprzętu.

Fabrice Coquio, dyrektor zarządzający

Digital Realty we Francji, ocenia, że do nowych regulacji środowiskowych trudno będzie dostosować się zwłaszcza firmowym centrom danych, które mają wiele lat. – Trzeba będzie zamknąć stare data center i przejść na nowsze. To jest dobre dla planety i dla nas oraz dla Schneidera – podsumowuje Fabrice Coquio. n

Nowe produkty w portfolio oraz te, które już zyskały renomę, a ponadto model MSP, certyfikowane szkolenia, audyty i narzędzia dla partnerów. Wszystko to w ciągu dwudziestu jeden godzin, podczas IV edycji Rising Stars of Cybersecurity.

n Karolina MarszałekWydarzenie kierowane do partnerów biznesowych DAGMA Bezpieczeństwo IT odbyło się w pierwszych dniach kwietnia w Bronisławowie. Oprócz firm współpracujących już z katowicką spółką, przybyło wiele nowych. – To dowód, że nasza sieć partnerska rozwija się bardzo dynamicznie. Rozmowy zainspirowały nas do nowych pomysłów i wspólnych projektów, także pomiędzy partnerami. Blisko sto osób omawiało wiele różnych tematów – tłumaczy Stanisław Horak, dyrektor handlowy w DAGMA Bezpieczeństwo IT. Bogaty program obejmował szkolenia dotyczące rozwiązań Barracuda Networks, ESET, Holm Security, Safetica, Sekoia i Stormshield. Podczas panelu otwierającego „Jak Partner z Partnerem”, uczestnicy zapoznali się z narzędziami wspomagającymi sprzedaż produktów z dziedziny cyberbezpieczeństwa, które oferuje dystrybutor. – Na konkretnych przykładach zilustrowaliśmy, w jaki sposób możemy skutecznie prowadzić klientów przez proces wyboru, wykorzystując nasze rozwiązania i wsparcie – mówi Jarosław Cichecki, Senior Channel Manager w DAGMIE. Najbliższe miesiące będą w tym zakresie kluczowe.

– Przegląd narzędzi, produktów i usług w kontekście implementacji dyrektywy NIS2 w Polsce pokazał nam kolejne pola do współ pracy z partnerami – dodaje Paweł Przybylski, Channel Manager w DAGMIE.

Klaudia Michalak, specjalistka ds. sprzedaży w Penta potwierdza, że event pozwala wprowadzić nowych partnerów we współpracę z DAGMĄ, a w przypadku wieloletnich – podnieść ją na wyższy poziom. – To czas na nawiązanie nowych relacji i umocnienie dotychczasowych, poznanie nowych produktów i rozszerzenie portfolio usług stosownie do trendów na rynku cyberbezpieczeństwa – mówi Klaudia Michalak. Przedstawicielka Penty deklaruje wdrożenie trzech nowych rozwiązań z portfolio dystrybutora, aby podnieść poziom bezpieczeństwa w firmach jej klientów. Stały dostęp do inżynierów rozwiązań oraz Product Managerów, który zapewnia spółka, pozwoli na sprawną realizację tych planów.

Temat MSP (zawsze) na czasie

Tradycyjnie już zachęcano partnerów do współpracy w modelu Managed Service Provider. Z rozmów z przedstawicielami DAGMY wynika, że widzą oni skokowy

wzrost sprzedaży rozwiązań z zakresu cyberbezpieczeństwa, oferowanych w formie usługi abonamentowej. Partnerów i klientów przekonuje do niej choćby elastyczność, która pozwala zmieniać z dnia na dzień liczbę chronionych stanowisk.

n Katarzyna Kocela, członek zarządu, ITBiotic

Wydarzenie Rising Stars to dla mnie świetny sposób na pozyskanie cennych kontaktów biznesowych oraz źródło inspiracji dotyczące najnowszych trendów i technologii stosowanych w branży cyberbezpieczeństwa. Panele produktowe pozwalają poszerzyć horyzonty i spojrzeć na temat bezpieczeństwa kompleksowo. Zainteresowało mnie rozwiązanie Safetica, co wynika z rosnącego znaczenia ochrony danych przy jednoczesnym nasileniu liczby cyberataków i przepisów o ochronie danych osobowych.

n Małgorzata Kuliberda, specjalista ds. administracyjno-handlowych IT, SQD Alliance

Udział w konferencji Rising Stars był dla mnie ważny i inspirujący. Doceniam zwłaszcza możliwość wyboru zakresu interesujących mnie szkoleń, a także osobisty kontakt z Product Managerami, z którymi mogłam wymienić się ciekawymi doświadczeniami oraz dobrymi praktykami. Co ważne, nie zabrakło dobrej zabawy i poczucia humoru!

– Partnerzy powtarzają, że model abonamentowy usprawnił im pracę administracyjną ze względu na to, że mogą samodzielnie generować licencje za pomocą jednej konsoli. Jednocześnie płatności miesięczne za abonament są stałym dochodem, uzyskiwanym w sposób pasywny – mówi Andrzej Wściubiak, Channel Manager w DAGMA Bezpieczeństwo IT. Dodaje również, że klienci chwalą model abonamentowy za to, że nie muszą ponosić dużego jednorazowego kosztu oraz unikają ryzyka związanego z niewykorzystanymi licencjami. To, rzecz jasna, tylko niektóre z zalet „abonamentów”. Model MSP funkcjonuje już w pełni w przypadku marek ESET oraz Acronis. Można się spodziewać, że do tych dwóch producentów wkrótce dołączą następni. n Łukasz Staszak, członek zarządu, firma Informatyk Rising Stars to doskonała okazja do wymiany doświadczeń oraz skonfrontowania potrzeb z realiami rynkowymi. Jestem pod wrażeniem zaprezentowanych rozwiązań, a zwłaszcza możliwości sprzedaży w modelu MSP. To przyszłość dla branży IT oraz naszych klientów. Model ten umożliwia elastyczne dostosowanie się do potrzeb każdej firmy, bez względu na skalę działalności. Daje nam to szerokie możliwości stosowania rozwiązań cyberbezpieczeństwa z najwyższej półki w połączeniu z niesamowicie prostym, szybkim i niegenerującym wysokich kosztów wdrożeniem.

Amerykańskie fundusze venture capital pompują mnóstwo pieniędzy w startupy utożsamiane ze sztuczną inteligencją (SI). Nie przeszkadza im w tym fakt, że młode firmy często nie generują żadnych przychodów, a czasami w ogóle nie mają czego pokazać.

n WojciechThe Wall Street Journal opisuje interesujący przypadek firmy Imbue, której siedziba mieści się w sercu San Francisco, a jej pracownicy dumnie noszą bluzy z pomarańczowym logo firmy. Jak na razie inwestorzy obdarzyli ten startup kwotą 210 mln dol. Szefowie Imbue w każdy piątek organizują dla całego zespołu imprezę Feelings Friday, której celem jest budowanie zaufania i bliskich więzi. Ze strony internetowej dowiadujemy się, że kalifornijski startup opracowuje systemy sztucznej inteligencji, które mogą rozumować i kodować, a tym samym nasycać komputery inteligencją i ludzkim wartościami. Jednak, choć od założenia firmy upłynęły już dwa lata, to wciąż nie posiada klientów, a nawet produktu. Tymczasem, choć ostatnie lata przyniosły znaczny spadek inwestycji w startupy, to ostatnie sukcesy giełdowe Nvidii i Microsoftu sprawiły, że inwestorzy bardzo łaskawym okiem patrzą na przedsięwzięcia związane ze sztuczną inteligencją. Według firmy badawczej

CB Insights w 2023 r. inwestorzy przelali 21,8 mld dol. na konta startupów pracujących nad projektami SI, co oznacza pięciokrotny wzrost w porównaniu z 2022 r. Średnia wielkość rundy dla tych transakcji wynosiła 51 mln dol., zaś średnia dla branży nowych technologii to wówczas „marne” 8 mln dol. – Wszyscy wierzą w to, że sztuczna inteligencja jest przyszłością, więc zobaczymy

niezwykłą liczbę inwestycji w projekty z nią związane. Przynajmniej do czasu, aż ktoś nie udowodni, że jest inaczej. Problem polega na tym, że nie wiemy, jak te modele biznesowe będą wyglądać na dużą skalę. Każdy może mieć swoją teorię na ten temat, ale to tylko domysły – wyznaje Alex Clayton, partner generalny Meritechu w rozmowie z The Wall Street Journal.

Inwestycje poszły za daleko.

Obawy przed rosnącymi wycenami startupów w Dolinie Krzemowej nie są niczym nowym. Natomiast tym, co niepokoi ekspertów, jest wypisywanie czeków dla „młodych przedsiębiorczych”, aby mogli ruszyć z miejsc. Nawet w szczytowych okresach boomu na startupy tak wysokie finansowanie było zarezerwowane dla tych firm, które przygotowują się do agresywnego wzrostu. Wspomniany wcześniej Imbue wyceniono na ponad miliard dolarów, a jego założyciele otrzymali fundusze między innymi od Nvidii i Erica Schmidta, byłego dyrektora generalnego Google. Kanjun Qiu, dyrektor generalna Imbue, zaczarowała inwestorów wizją tworzenia inteligentnych komputerów, które mogłyby dać ludziom „wolność, godność i zdolność robienia rzeczy, które kochamy”. Rzecznik prasowy startupu tłumaczy, że decyzja o tym, aby nie skomercjalizować jego działalności, była celowa. Dzięki temu firma może skoncentrować się wyłącznie na badaniach.

Inwestorzy venture capital liczą, że niektóre ze startupów powtórzą sukces Open

AI. Jednakże jak do tej pory nie widać zbyt wielu kandydatów, a wspomniany przypadek Imbue nie jest odosobniony. Otóż nie mniej ciekawa jest historia Inflection AI. Ten startup powołany do życia przez Reida Hoffmana, założyciela LinkedIn i wspierany między innymi przez Billa Gatesa, zebrał 1,5 mld dol. (!) na opracowanie modeli językowych dla chat bota o nazwie Pi. Jego rolą jest… emocjonalne wsparcie użytkowników. Trudno się dziwić, że firma nie potrafiła znaleźć perspektywicznego modelu biznesowego, który umożliwiłby wygenerowanie zysku ze sprzedaży. W rezultacie Mustafa Suleyman, dyrektor generalny Inflection AI, a także większość pracowników przeniosła się do Microsoftu. Wprawdzie startup ma nowego szefa i poszukuje strategii sprzedaży swojego oprogramowania chętnym przedsiębiorstwom, aczkolwiek wydaje się to być karkołomne zadanie.

Według wyliczeń Sequoia Capital, jednego z najbardziej uznanych funduszy venture capital, branża wydała około 50 mld na najnowocześniejsze chipy Nvidii przeznaczone do szkolenia modeli językowych. Natomiast startupy opracowujące narzędzia generatywnej sztucznej inteligencji wygenerowały przychody o wysokości 3 mld dol.

– Kwota potrzebna, aby zbudować te produkty, znacznie przekroczyła sumę środków, które do tej pory zostały na to wydane. W związku z tym mamy kilka prawdziwych problemów do rozwiązania… – podsumowuje Sonya Huang, partner w Sequoia Capital. n

Chociaż analitycy jednogłośnie wieszczą

wzrost sprzedaży na szeroko rozumianym rynku IT, to ich prognozy należy traktować nie dosłownie, a co najwyżej „kierunkowo”.

Wśród obserwatorów rynku IT panuje zgoda co do tego, że jest on nie tylko zdrowy, ale wciąż rośnie, a wzrost ten nabiera tempa. Przy czym analitycy IDC są dość konserwatywni, przewidując zwiększenie wydatków na rozwiązania IT w tempie od 4,2 do 4,5 procenta. Z kolei Canalys umieścił ten wskaźnik na poziomie 6,2 procenta, zaś Gartner prognozuje, że wydatki sięgną 6,8 procenta. Jednocześnie eksperci spodziewają się, że spadną one w 2025 r. o 8 do 9 procent.

Na razie niektóre segmenty technologiczne rozwijają się we wręcz fantastycznym tempie. Nowo powstała kategoria sztucznej inteligencji ma wzrosnąć w tym roku o około 55 procent. Przetwarzanie w chmurze – usługi infrastrukturalne i platformowe – wzrośnie o około 22 procent. Wyposażenie centrów danych natomiast, czyli serwery, pamięć masowa i przełączniki, wzrośnie o 11 procent. To naprawdę niezłe liczby… A jednak rynek nie jest zdrowy.

i zyski będą w tym roku wyższe niż w poprzednim.

Osłabienie zaufania do sytuacji rynkowej wynika w dużej mierze z negatywnych nastrojów dotyczących trendów makroekonomicznych, na które partnerzy nie mają wpływu. Analizując prognozy wzrostu wydatków na IT, musimy mieć, siłą rzeczy, na uwadze trendy makroekonomiczne. IDC twierdzi, że nawet jeśli PKB przestanie się zwiększać, wydatki na IT nadal wzrosną o około 3 procent, ponieważ firmy będą musiały zrównoważyć rosnące koszty i niższe przychody poprzez automatyzację. Inwestorzy, dostawcy i partnerzy opierają się na tych prognozach przy planowaniu strategicznym i podejmowaniu rozsądnych decyzji biznesowych.

Druga połowa roku przyniesie znaczną poprawę.

Niemcy, Japonia, Wielka Brytania i znaczna część Europy Wschodniej znajdują się w recesji. Francja, Włochy i Hiszpania balansują na krawędzi recesji. Z kolei Chiny, które doświadczają załamania swojej gospodarki, zalewają światowe rynki tanimi towarami, aby wesprzeć słabnące sektory nieruchomości oraz usług finansowych.

Co ważne, społeczność partnerów w kanale sprzedaży IT wcale nie patrzy optymistycznie na 2024 rok. Według prognozy Channelnomics „2024 Channel Forecast” poziom samopoczucia partnerów spada drugi rok z rzędu, mimo że zdecydowana większość resellerów, integratorów i dostawców usług wierzy, że ich przychody

Jednak te liczby stale się zmieniają. Na przykład rok 2022 Gartner rozpoczął solidną prognozą wzrostu na poziomie 5,3 procenta. Następnie co kwartał obniżał perspektywę o pełny punkt procentowy. Pod koniec czwartego kwartału Gartner sprowadził prognozę do poziomu 0,8 procenta. A jak było w kolejnym roku? Otóż w lipcu 2023 analitycy Gartnera opublikowali aktualizację swojej prognozy na rok ubiegły twierdząc, że wydatki na IT wzrosną wówczas o 4,3 procenta. W październiku 2022 r. prognoza wynosiła 5,1 procenta, a w grudniu została zrewidowana do 2,5 procenta. W kwietniu 2023 roku ponownie ją podniesiono (do 5,5 procenta). I wreszcie, na koniec ubiegłego roku Gartner zamknął „okienko przewidywań” na wyniku 3,3 procenta.

Gartner to niejedyna firma analityczna, która w krótkim czasie wprowadza znaczące zmiany w swoich prognozach

wzrostu. Co nie jest w sumie niczym niestosownym, bo nie ma nic dziwnego w tym, że sytuacja rynkowa może się dramatycznie zmieniać z kwartału na kwartał. Z tego powodu Channelnomics nie prognozuje skali wydatków na IT. Zostawiamy to firmom zawodowo zajmującym się analityką rynkową. Zamiast tego, sporządzamy ogólne prognozy w oparciu o panujące trendy. A zatem nasza generalna prognoza pozostaje taka sama: pierwsza połowa 2024 roku będzie przypominać warunki i wyniki z roku ubiegłego, zaś druga połowa przyniesie znaczną poprawę. Spodziewamy się także silnego i wysokiego wzrostu wydatków na IT w 2025 roku i (potencjalnie) w roku 2026, na co wpływ będą miały inwestycje w sztuczną inteligencję, usługi zarządzania danymi i modernizacja infrastruktury.

Larry Walsh

CEO oraz Chief Analyst w Channelnomics, firmie analitycznej specjalizującej się w kanałach sprzedaży i doradztwie dla producentów, dystrybutorów i integratorów IT. Autor jest również prowadzącym podcast „Changing Channels” i producentem podcastu „In the Margins”. Kontakt: lmwalsh@channelnomics.com.

Globalny rynek dostawców cyberbezpieczeństwa jest mocno rozdrobniony. Działa na nim ponad 3 tysiące producentów, ale w zasadzie brakuje dominującego lidera. Jak wygląda to w Polsce: czy można u nas doszukać się analogii z rynkiem światowym?

Łukasz Gawron

W Polsce jest podobnie. Powiedziałbym nawet, że nasz rynek jest jeszcze bardziej rozproszony. W poszczególnych segmentach sektora cybersecurity występuje dużo różnych rozwiązań. Są to zarówno produkty bardzo popularne, jak firewalle czy rozwiązania do monitorowania sieci, ale też rozwiązania niszowe związane z bezpieczeństwem OT. Nie ma przy tym dominującego gracza, który kontrolowałby dużą część rynku. Uważam, że wciąż jesteśmy przed etapem integracji i odnoszę wrażenie, że trend postępującej fragmentaryzacji będzie się przez jakiś czas utrzymywał, chociażby ze względu na wciąż powstające kolejne startupy.

Grzegorz Świrkowski

my się na produktach dostosowanych do specyficznego klienta. To oznacza, że dobieramy rozwiązania cyberbezpieczeństwa, które spełniają lokalne potrzeby i uwzględniają wymagania polskiego rynku. Niejednokrotnie są to zatem popularne produkty, w rodzaju oprogramowania służącego do ochrony urządzeń sieciowych. Są to raczej bardziej innowatorskie, zaawansowane rozwiązania, z którymi z powodzeniem wychodzimy zagranicę, gdzie są entuzjastycznie przyjmowane.

Artur Bicki

Pewne rzeczy nas w określonym stopniu blokują. Choćby prawo zamówień publicznych, gdzie kluczowym kryterium jest cena – Mateusz Kopacz

W Polsce obserwujemy inne standardy niż światowe. Po pierwsze, skupia-

W mojej ocenie Polska ma charakter rynku mieszanego. Z jednej strony mamy centra kompetencyjne dużych korporacji, a z drugiej coś, co można określić mianem ruchu polskiego, dobrego inżyniera, trochę z naturą partyzancką. Taki inżynier bardzo chętnie tworzy produkty, szuka rozwiązań, ale za to z dużo mniejszym entuzjazmem podchodzi do produktów zamkniętych, charakteryzujących się mocno sprecyzowaną „mapą drogową”. Lokalni producenci adresują

produkty dla rodzimych klientów, których notabene lepiej rozumieją, a jednocześnie idą z nimi dalej, wychodząc z ofertą poza kraj. Tak, jak Polska geograficznie zawsze łączyła Zachód ze Wschodem, tak też jest w przypadku produktów cybersecurity.

Paweł Rybczyk

Jeśli oceniać polski rynek pod kątem działających na nim producentów, to z jednej strony mamy do czynienia z dużymi graczami z Izraela czy Stanów Zjednoczonych, a z drugiej z firmami, które koncentrują się na rozwiązywaniu jakiegoś konkretnego problemu. Tak właśnie jest w naszym przypadku – skupiamy się na określonym obszarze bezpieczeństwa, gdzie chcemy być ekspertem, a nie producentem pokrywającym szeroki wachlarz różnorodnych zagadnień. Osobną kwestię stanowi kanał partnerski, gdzie zachodzi pewna ewolucja. Wprawdzie nie jest to takie przyśpieszenie, jakie ma miejsce na zachodzie Europy, ale widać, że polscy partnerzy znacznie więcej inwestują w sprzedaż usług niż samych produktów. Dostarczenie usługi niesie ze sobą dodatkową wartość, a partner musi się wykazać odpowiednią wiedzą i doświadczeniem, aby poradzić sobie z problemem klienta.

Mateusz Kopacz

Polski rynek czerpie pełnymi garściami z dobrodziejstw tego wszystkiego, co jest dostępne na całym świecie, co ma swoje dobre i gorsze strony. Na przykład Asseco już od dwóch dekad stosuje w swoim oprogramowaniu najtańszego na rynku antywirusa od czeskiego dostawcy. Niestety, nie odpowiada on na aktualne polimorficzne, ewoluujące w trakcie ataku, zagrożenia. Jednak z drugiej strony nie mamy się czego wstydzić, ponieważ w Polsce ma miejsce wiele dużych komercyjnych wdrożeń w bankach czy w obszarze infrastruktury krytycznej. Rzeczywiście można się pokusić o tezę, że jesteśmy takim mostem łączącym Wschód z Zachodem. Warto jednak zauważyć, że pewne rzeczy nas w pewnym stopniu blokują. Na przykład prawo zamówień publicznych, gdzie kluczowym kryterium jest cena, która może wpłynąć na jakość rozwiązań. Nie wykorzystujemy też aspektów patriotyzmu gospodarczego. Często marzeniem wielu „bezpieczników” jest znane rozwiązanie ze Stanów Zjednoczonych, cztery do pięciu razy droższe od podstawowych produktów. Niemniej taka hybryda dwóch różnych światów sprawia, że napastnicy

Artur Bicki

Łukasz Gawron

CEO, CyberMadeInPoland

natrafiają na trudne do przejścia pole minowe i nie wiedzą, co ich spotka na jego końcu.

Polscy dostawcy systemów bezpieczeństwa nie mają łatwo, bo z jednej strony muszą rywalizować z wielkimi koncernami światowymi, zaś z drugiej z nieco mniejszymi producentami z Europy Środkowo-Wschodniej, jak chociażby ESET czy Bitdefender. Jakie argumenty, poza ceną, mogą przekonać polskiego klienta, aby zainwestował w rodzime produkty?

Paweł Rybczyk

Mateusz Kopacz

CEO, Energy Logserver Officer,

Co do ESET-a, to wszedł on na polski rynek bardzo dawno, kiedy były inne uwarunkowania. Myślę, że obecnie nie dałoby się powtórzyć tego sukcesu. Przez pewien czas pracowałem dla polskiego dystrybutora ESET-a i trzeba przyznać, że to rozwiązanie ma kilka poważnych zalet. Natomiast, jeśli chodzi o polskich dostawców, ich atutem jest lokalność produktu, co ma znaczenie zarówno z punktu widzenia użytkowników końcowych, jak i partnerów. Klienci mają dostęp do działu rozwoju danego producenta, wpływ na funkcje i sposób, w jaki ten produkt ma działać w określonym środowisku. Poza responsywnością i podejściem do klienta, dużym

Paweł Rybczyk

CEO, Labyrinth Security Solutions Grzegorz Świrkowski

CEO, Net Complex

Prowadzący:

Chief Information Security Officer, Alma Wojciech Urbanek

zastępca redaktora naczelnego, CRN Polska

walorem rodzimych dostawców jest wsparcie techniczne, które często kuleje w przypadku globalnych vendorów, szukających sposobów na obniżenie kosztów. Wśród polskich producentów, którzy tworzą rozwiązania cyberbezpieczeństwa, nie mamy firmy o skali Palo Alto Networks czy Checkpointa, z tak szerokim wachlarzem produktów. Jesteśmy za to wyspecjalizowani w pewnych obszarach, gdzie trzeba się przebić i pokazać nasze wyróżniki na tle globalnych marek. To najtrudniejsze zadanie, bowiem żadna z polskich firm nie ma budżetu, który pozwalałby występować w roli głównego sponsora najważniejszych konferencji i tym samym budować świadomość marki.

Łukasz Gawron

niedawno wyceniono na miliard dolarów! Tymczasem rynek litewski w porównaniu do naszego jest niewielki, co nie przeszkodziło tej firmie w osiągnięciu sporego sukcesu.

Artur Bicki

Nasze położenie w Europie

sprawia, że patrzymy na firmy z zachodniej części kontynentu jako konkurentów, których chcemy prześcignąć

– Artur Bicki

Za to pod względem jakości nasze produkty są w stanie konkurować z zagranicznymi. A nie bez znaczenia jest fakt, że czasami są po prostu tańsze. W końcu cena odgrywa wciąż istotną rolę, chociażby przy przetargach, co jest o tyle istotne, że polskie startupy mogą zaoferować taką samą wysoką jakość za niszą cenę. Lokalność też jest poważnym atutem, ponieważ tutejsza firma podlega polskiemu prawu, przetwarzając dane zgodnie z polskimi regulacjami. Natomiast prawda jest taka, że jeśli mówimy o rozwoju i o tym, żeby stać się firmą na poziomie przywoływanego wcześniej ESET-a, trzeba od początku myśleć globalnie. Dobrym przykładem jest nie polski, ale litewski startup Nord Security, którego wartość

Jedną z naszych polskich cech jest rynkowa agresywność, co ma podłoże historyczne. Nasze położenie w Europie sprawia, że patrzymy na firmy z zachodniej części kontynentu jako konkurentów, których chcemy prześcignąć. W tym przypadku ta nasza agresywność jest atutem. Dostrzegam ją też w moim zespole, gdzie przejawia się w chęci wykorzystania każdej okazji w postaci otwarcia nowego rynku czy szansy na sprzedaż produktu. Nie obserwuję takiego podejścia w firmach z Europy Zachodniej czy USA. Nasz klient jest inny niż ten „zachodni”, bowiem chce rozwiązywać konkretne problemy. Niemniej trzeba uważać, aby nadmiernie nie spersonalizować produktów. Poza tym w lokalnej społeczności ważne są też nazwiska, czego nie ma na globalnym rynku. Dziś część naszych wdrożeń firmujemy właśnie naszymi nazwiskami i jest to dla zamawiającego duży komfort, związany z ogromnym zaufaniem do tego, co robimy.

Mateusz Kopacz

Pierwszą i podstawową cechą jest wrażliwość cenowa, dostosowana do lokalnego rynku. Drugą są kompetencje naszych specjalistów i nie powinniśmy mieć tutaj żadnych kompleksów.

Doskonale pamiętam, jak polski badacz Adam Ziaja wygrał batalię słowną z szefem bezpieczeństwa Splunka. Z kolei Wojciech Reguła regularnie znajduje błędy w iOS-ie i jest jedną z kilkunastu osób, które otrzymują do testowania iPhone’a na długo przed oficjalną premierą. O umiejętnościach naszych specjalistów świadczy też rozwój technologiczny sektora bankowego, a przede wszystkim stosowane w tej branży zabezpieczenia. Często są to „pola minowe”, stanowiące zaporę nie do przejścia dla hakerów. Co istotne, Polacy podchodzą nieufnie do dostarczanych informacji, śledzą dokładnie dokumentację, jak też chętnie dyskutują na tematy techniczne, podsuwając przy okazji lepsze rozwiązania. Regularnie obserwuję, że nasi inżynierowne przedkładają swoim amerykańskim czy izraelskim kolegom propozycje usprawnień, które są wdrażane w życie.

Grzegorz Świrkowski

Bardzo ważna jest elastyczność, o której wspominali moi przedmówcy. Klienci coraz bardziej przywiązują wagę do tego czynnika. Jako lokalna firma potrafimy szybko zająć się problemem, rozkładając go na drobne części i błyskawicznie rozwiązując. Polskie firmy często wybierają rodzimych dostawców systemów cyberbezpieczeństwa właśnie ze względu na możliwość spersonalizowania produktu. To pozwala na bardziej indywidualne podejście do klienta aniżeli w przypadku realizacji kontraktu przez globalnego dostawcę, gdzie klient jest traktowany jako kolejny numer. Współpraca z lokalnym dostawcą bazuje na relacjach międzyludzkich i konkretnych osobach. To zupełnie inny poziom sprzedaży.

Paweł Rybczyk

Nie zgadzam się z moimi przedmówcami tylko w jednej kwestii, a mianowicie pieniędzy. Nie chciałbym, aby nasz przekaz był taki, że polskie firmy są zwinne i elastyczne, bo potrafią dostosować cenę do wymagań klienta. Rynek w ciągu ostatnich lat się zmienił. Polskie firmy stać, żeby zainwestować w bezpieczeństwo. Wzrosły też ich oczekiwania co do jakości produktu. No, może pomijając sektor publiczny, gdzie liczy się przede wszystkim cena.

Wspominacie panowie, że mamy świetnych specjalistów ds. cyberbezpieczeństwa. Od czasu wybuchu wojny na Ukrainie liczba cyberataków wymierzonych w polskie firmy oraz instytucje znacznie wzrosła. Czy zmagania na cyberfroncie nas wzmacniają i stajemy się coraz silniejsi, a może przeciwnie, nadmiar pracy wywołuje stres i prowadzi do błędów? Paweł Rybczyk

Na pewno na tym zyskujemy. To jest tak jak z armią, która musi być w ciągłym ruchu. Jeżeli pole walki leży obok nas bądź bezpośrednio nas dotyczy, powinniśmy to wykorzystać. Zresztą robimy to i postrzegam takie działania jako krok w kierunku ogromnego rozwoju. Oczywiście nikt nie cieszy się z wojny, aczkolwiek zauważam, że zmieniła ona postrzeganie bezpieczeństwa u partnerów i użytkowników. Po pierwsze zaczyna się o nim mówić coraz więcej, a po drugie, pojawia się myślenie strategiczne. To krok we właściwym kierunku, ponieważ klient płaci w takim przypadku mniej niż w przypadku nieprzemyślanych zakupów, robionych bez odpowiedniego przygotowania.

Artur Bicki

Co do stresu, to jest on nieodłącznym składnikiem naszej pracy. Narzędzia

cyberbezpieczeństwa są bronią, ponieważ jest to jest obszar inwestowania strategicznego. Bardzo się cieszę, że również na szczeblu państwowym organizacje odpowiedzialne za nasze bezpieczeństwo szukają specjalistów w Polsce i nie sięgają w pierwszym ruchu po dużych graczy z giełdy amerykańskiej. To oznacza, że idziemy dobrą drogą.

Łukasz Gawron

Branża musiała się dostosować do panującej sytuacji geopolitycznej, ponieważ będąc na froncie cyfrowym musimy być bezpieczni. Choć skala ataków jest duża, to jak do tej pory nie zdarzył się jakiś poważny incydent. To pokazuje, że faktycznie ten system działa. Może nie do końca nadążają za tym regulacje, ale to już jest temat na osobną debatę. Obecne wydarzenia musimy wykorzystać do rozwoju naszego rynku. W rozmowach z partnerami bądź klientami biznesowymi powinniśmy im opowiadać o świetnych specjalistach, którzy zmagają się na cyberfroncie z wyrafinowanymi zagrożeniami. Takie osoby mogą otwierać własne firmy, budować markę i napędzać innowacje. Z bardzo podobną sytuacją mieliśmy do czynienia w Izraelu. W tym kraju mocno rozwinięto ekosystem bezpieczeństwa i dziś nie brakuje tam graczy globalnych. Tego nie da się w naszym kraju zrobić jeden do jednego, jednakże warto wykorzystać ten obecny, doskonały moment. Wydaje mi się, że taka szansa już się nie powtórzy.

Grzegorz Świrkowski

Cieszą mnie zmiany, których inicjatorem jest strona rządowa. Przez ostatnie lata państwo przeznaczyło mnóstwo środków na dotacje, które pozwoliły lepiej zabezpieczyć branże wcześniej bardzo zaniedbane pod względem bezpieczeństwa IT. To ważne dla stabilności i ochrony danych w tych sektorach, co ma istotne znaczenie zarówno dla gospodarki, jak również bezpieczeństwa narodowego.

Bardzo cenię biznesy, gdzie założenia początkowe są konsekwentnie rozwijane. To niemal zawsze przekłada się na sukces

– Grzegorz Świrkowski

Duże znaczenie mają też regulacje NIS2, DORA czy nowy projekt ustawy o ochronie sygnalistów. Ustalenie spójnych standardów i procedur pomaga w lepszym zarządzaniu ryzykiem cybernetycznym oraz w szybszym reagowaniu na zagrożenia. Dodatkowo, wojna na Ukrainie napędza rynek cyberbezpieczeństwa. Niebawem też pojawią się pieniądze z KPO przeznaczone na cyfryzację. Liczę, że redystrybucja środków będzie sprzyjać rozwojowi innowacyjności i konkurencyjności polskich firm na arenie międzynarodowej.

Mateusz Kopacz

Czasami trafiam na osoby decyzyjne, które mają do wszystkiego autorskie podejście i dotyczy to również cyberbezpieczeństwa. Wówczas pytam je, czy pamiętają, że nasz kraj od 1999 roku należy do NATO. Po czym przypominam, że dobrą praktyką tego sojuszu jest przeznaczanie 2 procent budżetu na obronę, a następnie proszę o spotkanie z dyrektorem IT, aby sprawdzić, jak wygląda ten bilans

w jego organizacji. Ten obrazowy argument dobrze przemawia do moich rozmówców. W każdym razie na pewno znajdujemy się w dobrym momencie. Być może trochę brakuje nam modeli bezpieczeństwa dla małych i średnich przedsiębiorstw oraz instytucji. Przydałoby się opracowanie z myślą o nich architektury referencyjnej. Uczestnicy dzisiejszej debaty mają ambicje, żeby zdobywać świat. Ich aspiracje są jak najbardziej uzasadnione. Energy Logserver rozwija bardzo ciekawe rozwiązanie w obszarze korelacji danych, zaś Labirynth zastawia pułapki na hakerów. Wyobraźcie sobie czasem Miszę, który przez kilka godzin penetruje sieć i w końcu trafia na emulator np. Windowsa 7. Ostatecznie dostaje to, czym my chcieliśmy go nakarmić, a nie dostaje tego, po co przyszedł. Ważny polski akcent w tej wojnie to adopcja kluczy Yubico dla naszych struktur rządowych, ale również wysyłka dla OUK, operatora usługi kluczowej na Ukrainie, gdzie jedna z pierwszych partii służyła do zabezpieczenia infrastruktury krytycznej. Po dwóch latach możemy przyznać, że cyberataki ze strony rosyjskiej nie zdezorganizowały w znaczący sposób życia Ukraińców, a jedynie przyczyniły się do chwilowych niedogodności. Dobrze pokazuje to przykład telekomów. Wprawdzie jeden z nich znacząco ucierpiał, ale trzy pozostałe przejęły na siebie cały ruch. Trochę działa to na zasadzie: robimy swoje

i nie zatrzymujemy się, jedziemy dalej. To tak, jak uśmiechnąć się pod nosem do kogoś, kto na ciebie krzyczy. „Keep Moving Forward”!

Artur Bicki

Nie można siedzieć

z założonymi rękami

i utyskiwać nad tym, że mamy problem z zatrudnieniem specjalistów

– Łukasz Gawron

Ja patrzę na związaną z cyberbezpieczeństwem historię Izraela po to, żeby napisać własną, lepszą. Sytuacja w Rosji otworzyła nam dostęp do Kazachstanu, Uzbekistanu czy Azerbejdżanu. Okazuje się, że model sprzedaży licencji wieczystej, od którego odchodzą amerykańscy dostawcy, staje się naszym wyróżnikiem. To kraje, które czują z nami bliskość słowiańską, co bardzo ułatwia współpracę. Zresztą mogą liczyć na nasze solidne wsparcie. Przykładowo, Energy Logserver zapewnia tłumaczenie na język kazachski. Chciałbym zobaczyć, który producent zza oceanu podjąłby w ogóle taki temat… Paweł Rybczyk Dużo mówimy o Izraelu czy Stanach Zjednoczonych, a można do tej dwójki dołączyć również Francję. Nie kwestionuję tego, że mamy bardzo dobrych inżynierów, ale to nie wystarczy, aby osiągnąć międzynarodowy sukces. Mam dobre porównanie, jak to działa we Francji. Tam państwo wspiera swój biznes na poziomie każdej ambasady. Niestety my tego nie robimy, a w związku z tym nie mamy wsparcia ze strony rządu. Zdecydowanie nie chciałbym wchodzić w politykę, aczkolwiek podczas takiej debaty trzeba zaznaczyć, że mamy bardzo dużo do zrobienia w tym aspekcie.

Mateusz Kopacz

No właśnie, technologia się zgadza, ale nie zgadza się ekosystem. Amerykanie, kiedy wymieniają ekipę dyplomatyczną w Warszawie, sprawdzają jakie ich firmy mają w Polsce główne siedziby, szkolą się, dysponują specjalnymi materiałami, a także wydzielonym miejscem w placówce, gdzie chwalą się swoimi technologiami. My tego nie mamy. W idealnym świecie w każdej ambasadzie i konsulacie naszego kraju powinien być przynajmniej jeden kącik, gdzie można promować rodzimą technologię. Nasze środowisko powinno zwrócić uwagę na ekosystem, głęboko się nad tym zastanowić, zwłaszcza w kontekście globalnych regulacji i zagrożeń, ale to już temat na osobną debatę.

Łukasz Gawron

Muszę wystąpić tutaj w roli adwokata diabła. Ambasady, odziały ekonomiczne i zagraniczne biura handlowe zaczynają działać bardzo sprawnie. Co prawda, pojawiają się pewne problemy. Przykładowo, w biurze handlowym pracuje osoba, która w poniedziałki zajmuje się eksportem ryb, w środę jest specjalistą od biotechnologii, a w czwartek od cyberbezpieczeństwa. Z kolei we Francji są specjalnie wydzielone osoby do zajmowania się cyberbezpieczeństwem, a ich zadaniem jest nawiązywanie relacji wyłącznie w tym obszarze. Uważam, że tą drogą musimy pójść, jeżeli zamierzamy działać globalnie.

Wsparcie ze strony państwa to jedno, ale młode firmy z Izraela czy Stanów Zjednoczonych mogą również liczyć na ogromne zastrzyki finansowe ze strony funduszy venture capital. W Polsce o takich środkach można jedynie pomarzyć. To istotne

o tyle, że to właśnie startupy najczęściej tworzą innowacyjne produkty. Czy polskie firmy nie są z tego tytułu w jakiś sposób „pokrzywdzone”?

Mateusz Kopacz

Ekosystem, o którym tutaj tyle rozmawiamy, przekłada się też na część komercyjną. Polski produkt do zarządzania dostępem uprzywilejowanym, który spisuje się świetnie, niekoniecznie poradzi sobie za granicą, bo o to zadbają chociażby konkurenci z Izraela. Działa to w ten sposób, że ktoś wcześniej sformułował odpowiedni zapis w umowie i ze względu na swoją siłę był w stanie go przeforsować, a teraz go egzekwuje. Podobnie jest z dostępem do kapitału. Czasami transfery finansowe pochodzą od dużych graczy, dla których mniejsza firma stanowi na tyle poważną konkurencję, że dysponują kapitałem, aby na wczesnym etapie ją kupić i zamknąć.

Artur Bicki

Nie ukrywam, że mam trochę problem z określeniem, czym jest startup. Swoją działalność otworzyliśmy kilka lat temu, w związku z tym według obowiązującej definicji już nie jesteśmy startupem. Jednak niezależnie od nazewnictwa osiągnęliśmy sukces i rozwijamy się w szybkim tempie. Dostaliśmy bilet zaufania od jednego z banków, który zwrócił się do nas o rozwiązanie pewnego problemu. Nie chodziło o inwestycję w przysłowiowego Mercedesa, lecz poskładanie komponentów przez odważny zespół, gotowy podjąć rękawicę. Powołanie spółki nastąpiło po realizacji udanego projektu. Pewna doza zaufania z rynku komercyjnego, a co za tym idzie fundament finansowy, pozwoliły nam pójść dalej. To pokazuje, że promowanie startupów to nie zawsze jedyna

droga do sukcesu. My potrzebujemy przede wszystkim zaufania ze strony klientów do naszych kompetencji. Przestałem też odpowiadać na propozycję zakupu Energy Logserver od różnych inwestorów bądź koncernów. Jesteśmy łakomym kąskiem dla dużych graczy, bo mały zespół można stosunkowo łatwo kupić, a my na etatach zatrudniamy jedynie 12 osób, choć współpracujemy również z zagranicznymi programistami. W każdym razie decydenci z administracji państwowej powinni otwierać przed nami różne możliwości, chociażby na zasadach „wilczego biletu”, jak ma to miejsce w różnych wydarzeniach sportowych. Paweł Rybczyk Zgadzam się z tym, że mamy świetnych inżynierów i innych specjalistów, aczkolwiek zacznijmy mówić też szeroko o tym, że mamy świetne produkty. Zróbmy coś, zanim klient zacznie oglądać kombajny zagranicznych firm. Niech najpierw sprawdzi, czy nie mają ich w swoim portfolio polskie firmy. Dajmy sobie szansę. Warto, aby każdy z polskich producentów, wygrywając duży projekt, mówił o tym głośno, używając tego jako koła zamachowego do skalowania biznesu. Trzeba jak najwięcej działań promocyjnych, żeby wykreować modę na polskie produkty. Jestem wdzięczny naszym partnerom, którzy pozytywnie reagują na nasze rozwiązanie, włączając go do swojego portfolio w postaci produktu bądź usługi.

Łukasz Gawron

Mamy świetnych inżynierów i innych specjalistów, aczkolwiek zacznijmy mówić też szeroko o tym, że mamy świetne produkty – Paweł Rybczyk

Bardzo chciałbym, żeby każdy startup powstawał tak, jak to było w przypadku Energy Logserver. To znaczy pojawiła się konkretna potrzeba, a następnie jej realizacja. Nie ma znaczenia czy zespół tworzą ludzie pracujący od dwóch dekad w banku jako specjaliści ds. cyberbezpieczeństwa, bądź dopiero ukończyli studia. Ważne, że mają pomysł i pragną go rozwijać. Zastanówmy się przy tym, czy jako ekosystem dysponujemy narzędziami, które pomogą im ten pomysł wdrożyć w życie. Do tego trzeba mieć dostęp do kapitału i do wiedzy, akcelerator, inkubator, dobrze współpracować z uczelniami, zbudować kanały partnerskie, dział marketingu i strategię wyjścia na rynki zagraniczne. Do tego wszystkiego potrzebne jest wsparcie, którego w Polsce brakuje. Nie mniej ważna jest mentalność szefów departamentów IT wielkich korporacji. A więc na ile są otwarci na nowe rozwiązania, zwłaszcza kiedy używają od kilkunastu lat produktów tego samego vendora. Czasami decydują się na proof of concept produktu opracowanego przez startup. Takie rzeczy się dzieją i w ten sposób napędza się rynek nowych technologii. Cyberbezpieczeństwo nie jest tutaj żadnym wyjątkiem, tylko w Polsce brakuje całego łańcucha – od narodzin pomysłu do komercjalizacji i odniesienia sukcesu globalnego. Grzegorz Świrkowski Polskie firmy mogą być w pewnym stopniu „pokrzywdzone” z uwagi na

brak dostępu do tak dużych środków. Należy jednak pamiętać, że nie tylko kapitał decyduje o sukcesie startupu, a w Polsce istnieją inne formy finansowania i wsparcia dla młodych firm. Tak naprawdę zdobycie środków finansowych nie stanowi problemu, a mówimy czasem o milionach złotych dla trzyosobowej działalności. To w zupełności wystarczy, aby wystartować z nowym projektem. Bardzo cenię biznesy, gdzie założenia początkowe są konsekwentnie rozwijane. Współpracuję z takimi firmami i widzę, że niemal zawsze przekłada się to na sukces. Być może warto w tym kontekście pomyśleć o monitoringu biznesowym dla startupów.

Jedną z największych bolączek nie tylko polskiego rynku cyberbezpieczeństwa jest deficyt specjalistów. Globalizacja i wzrost popularności zdalnego modelu sprawiają, że Polak z Warszawy może dalej mieszkać w swoim mieście, a dostawać przelewy z San Francisco. W jaki sposób staracie się pozyskać tych pracowników, a następnie sprawić, żeby na dłużej się z wami związali ?

Grzegorz Świrkowski

Nie ukrywam, że mam z tym kłopot. Ciągła rotacja pracowników wynika głównie z deficytu specjalistów na rynku. Dotyczy to nie tylko inżynierów, ale również specjalistów certyfikowanych w konkretnych obszarach: od sieci, obsługi SIEM-ów itp. Niestety, siłą rzeczy są oni wchłaniani zarówno przez duże polskie firmy, jak i zagraniczne korporacje. Postępuję aktywnie wobec tego wyzwania, inwestując w szkolenia pracowników, aby stale rozwijali swoje umiejętności. Ze względu na warunki rynkowe i ekonomiczne nie możemy konkurować z zagranicznymi płacami, dlatego stawiam na możliwości roz-

woju zawodowego i specjalizowania się w różnych branżach w kontekście cyberbezpieczeństwa, takich jak bankowa, medyczna czy produkcyjna. Uważam, że różnorodność i możliwości rozwoju zawodowego są kluczowe, aby zatrzymać pracowników u nas.

Artur Bicki

Kiedy rozmawiam z kandydatami do pracy staram się w nich rozpalić pasję, choć pieniądze też zawsze muszą się zgadzać. Nie mam większych problemów z zatrudnieniem, ponieważ potrafię przekonać, że praca u nas jest szalenie ciekawa. Na przykład pytam pracownika: w jakim kraju chciałby sprzedawać produkty? Tymczasem żadna z międzynarodowych spółek nie zadaje takich pytań swoim pracownikom, lecz oddelegowuje ich na określony kierunek. Nasze podejście to szansa dla młodego, ambitnego zespołu.

Mateusz Kopacz Znowu zawodzi ekosystem. Szkoły nie wychodzą z inicjatywą współpracy i wysyłania klas technicznych do laboratoriów, a byłaby to doskonała szansa, żeby wyłowić talenty. Tak naprawdę jedynie wojsko dostrzega lukę kompetencyjną w tym obszarze i podejmuje działania. Co nie zmienia faktu, iż nie wygląda na solidnie zbudowany budynek, lecz fuszerkę, gdzie woda podchodzi nam do piwnicy. Problem z dostępem do specjalistów ds. cyberbezpieczeństwa jest zjawiskiem globalnym. Akurat w moim przypadku mam ten komfort, że mogę napisać ogłoszenie o pracę i czekać na oferty. Kiedy potrzebuję specjalistów do projektu, to po prostu korzystam z giełdy z dostępem do ekspertów. Biznes robi się z ludźmi i ta edukacja musi być

wielopoziomowa. Powinniśmy współpracować z dziećmi w szkołach czy z seniorami, ale również włączać do dialogu działy HR.

Łukasz Gawron

Chciałbym zwrócić uwagę na dwie kwestie. Zgadzam się z Mateuszem Kopaczem, że powinniśmy działać proaktywnie. Nie można siedzieć z założonymi rękami i utyskiwać nad tym, że mamy problem z zatrudnieniem specjalistów. Niewiele uczelni zdaje sobie sprawę z tego, jakie są realne potrzeby przedsiębiorców w zakresie zatrudniania tej grupy specjalistów na zmieniającym się rynku pracy. To bardzo istotny czynnik, bowiem nasza branża cechuje się niezwykłą dynamiką. Dlatego potrzebny jest dialog biznesu nie tylko z uczelniami wyższymi, ale musimy schodzić poziom niżej – do liceum i technikum. Należy odpowiedzieć na pytania – jakie cyberzagrożenia obecnie występują na rynku, jakie są najważniejsze trendy, jakich specjalistów poszukują firmy? Natomiast druga sprawa to jest kwestia wynagrodzeń specjalistów. Oczywiście, nie możemy konkurować ze Szwajcarią czy Stanami Zjednoczonymi, ale to nie będzie trwało wiecznie. W pewnym momencie wynagrodzenia się wyrównają, chociażby ze względu na wzrost gospodarki, podnoszącą się jakość usług, a także samych specjalistów. Nie demonizujmy, nie będziemy na szarym końcu pod względem wynagrodzeń. Moim zdaniem za parę lat przyjadą do nas również specjaliści z Zachodu i będą pracować za przyzwoite pieniądze.

Rozmawiał Wojciech Urbanek

N a j p i e r w k l i e n t ,

Startupy zbierają pieniądze. Firmy je zarabiają. Im szybciej startup zrozumie, że jest firmą, tym lepiej dla niego.

Ten wniosek nasunął mi się ostatnio, w wyniku pracy ze spółkami z mojego portfela i jako efekt konsultacji dla dziesiątek niezależnych startupów. Wiele z tych rozmów poświęconych było właśnie pozyskiwaniu kapitału. Co powinniśmy teraz zrobić? Do kogo iść po pieniądze? Co zmienić w decku? Był w tym zaszyty pewien automatyzm – mam startup, idę po rundę do VC. Pierwszą, drugą, trzecią – to już bez znaczenia. To, co te rozmowy łączyło to fakt, że founderzy poświęcali większość swojego czasu na pogoń za inwestorami. A że droga do tego celu jest długa, kręta i wycieńczająca – to sprzedaż spadała na drugi albo nawet trzeci plan.

Co więcej, kiedy zadaję pytanie, po co im właściwie te pieniądze, spotykam się z dość schematycznymi odpowiedziami: na rozwój, na funkcjonowanie, na produkt. Rzadko kto ma precyzyjnie opracowany plan dotyczący tego, jak zamienić pozyskany kapitał w szybszy wzrost spółki. W efekcie jest on traktowany jak tlen niezbędny do funkcjonowania, a nie jak „nitro”, które powinno „dopalić” całość, pozwalając wskoczyć na wyższy bieg.

dojrzałości. Wiedzą, że mitycznym jednorożcem już nie będą, ale są w stanie zbudować świetnie prosperującą i rentowną firmę. To jest ich ścieżka rozwoju na najbliższe lata. Być może uda im się w przyszłości sprzedać firmę, ale nawet jeśli tego nie zrobią, to generowane zyski pozwolą im żyć na wysokim poziomie. Paradoksalnie wielu wychodzi na tym lepiej niż na symbiozie z funduszami.

Nie zbieraj. Zarabiaj…

Pamiętam, jak stawiając lata temu pierwsze kroki w VC, pewien founder powiedział mi: „Przepraszam Szymon, ale odwołuję nasze spotkanie. Trafiło mi się super ważne spotkanie z klientem, które może mieć dla spółki duże znaczenie”. W pierwszej chwili odebrałem to jako zwykły brak szacunku. Może nawet jako pewien rodzaj „gry w niedostępność”. Trochę czasu zajęło mi zrozumienie, że to jest jedyna słuszna postawa. Klienci powinni być na szczycie hierarchii. My inwestorzy powinniśmy mieć względem nich drugorzędny charakter. Firma z klientami zawsze sobie poradzi. Spółka z samymi inwestorami już nieco gorzej. Zamiast nieustannie próbować zbierać pieniądze, lepiej po prostu je zarabiać.

Founderzy, którzy na pierwszym miejscu stawiają sprzedaż, rzadko zmieniają priorytety. Po pierwsze wiedzą, że jeśli będzie im to szło naprawdę dobrze, to inwestorzy zawsze się znajdą – prędzej czy później. Takie spółki nie potrzebują ich do przeżycia i w efekcie zarząd zastanowi się kilka razy, czy taki ruch naprawdę ma sens. Osobiście mam dużo szacunku do founderów, którzy na pewnym etapie świadomie schodzą ze ścieżki VC. To wymaga pewnej

Szymon Janiak

Autor jest współtwórcą i partnerem zarządzającym funduszu venture capital Czysta3.vc

Klienci powinni być na szczycie hierarchii.

Programy partnerskie muszą być dostosowane do zmian zachodzących na rynku, a wbrew pozorom, nie jest to łatwe zadanie.

W tym kontekście dywizja Samsung Memory w Polsce i regionie CEE przedkłada stabilność programu partnerskiego ponad częste zmiany. Nie oznacza to jednak, że program partnerski pozostaje niezmienny. Przykładowo, w ubiegłym roku Samsung Memory wprowadził do oferty dwie serie dysków wewnętrznych Data Center SSD i, aby otworzyć się na współpracę z firmami integratorskimi działającymi w tym segmencie rynku, producent musiał wyjść z ciekawą propozycją, co wymagało wprowadzenia nowych zapisów do programu.

wiat nowych technologii mknie do przodu w szaleńczym wprost tempie. Taki stan rzeczy nie pozostaje bez wpływu na sposób, w jaki sprzedawane są produkty oraz usługi, a co za tym idzie, na relacje zachodzące w kanale partnerskim. W związku z tym producenci mają twardy orzech do zgryzienia, bowiem muszą pogodzić stabilność programu z wprowadzaniem na rynek innowacyjnych rozwiązań i nowych modeli sprzedaży. Jak w takiej sytuacji zachować

odpowiedni balans? Co zrobić, aby nie wylać dziecka z kąpielą? Producenci na różne sposoby starają się rozwiązać te dylematy. – Wiadomo, że stabilność zwiększa przewidywalność działania. Niemniej, na tak szybko zmieniającym się rynku, w dobie przyśpieszenia implementacji nowych technologii, należy szczególnie dbać o to, aby program partnerski był dopasowany do zachodzących zmian – mówi Rafał Szarzyński, dyrektor sprzedaży w Sharp Electronics CEE.

Zwolennikiem stabilnej współpracy jest również Robert Gawroński, SMB Channel Manager w TP-Linku, zwracając przy tym uwagę na poszanowanie czasu partnerów. Jego zdaniem zbyt częste zmiany w zapisach czy też progach rabatowych absorbują uwagę i energię resellerów, którzy, zamiast poświęcić czas na sprzedaż rozwiązań, spędzają długie godziny na studiowaniu programów.