Okiem użytkownika

Cyfryzacja

Województwa

Mazowieckiego

Optymalizacja bez kompromisów

Andrzej

Przybyło

ESG jako wyzwanie i szansa

Prawo i zarządzanie

Sygnaliści pod ochroną

Janis Varufakis

Okiem użytkownika

Cyfryzacja

Województwa

Mazowieckiego

Optymalizacja bez kompromisów

Andrzej

Przybyło

ESG jako wyzwanie i szansa

Prawo i zarządzanie

Sygnaliści pod ochroną

Janis Varufakis

Jak technofeudalizm zniszczył kapitalizm

„Polski sektor technologiczny nie wykorzystuje w pełni swojego potencjału” –Michał Piątkowski, CEO MOTIFE.

Systemy drukujące i zarządzanie dokumentamiIT w handlu Migracja do centrum danych

jeśli pracujesz w firmie z branży IT, możesz bezpłatnie zaprenumerować magazyn CRN Polska?

Załóż konto na stronie

crn.pl/rejestracja

Najlepiej poinformowany magazyn w branży IT!

dla resellerów, VAR-ów i integratorów

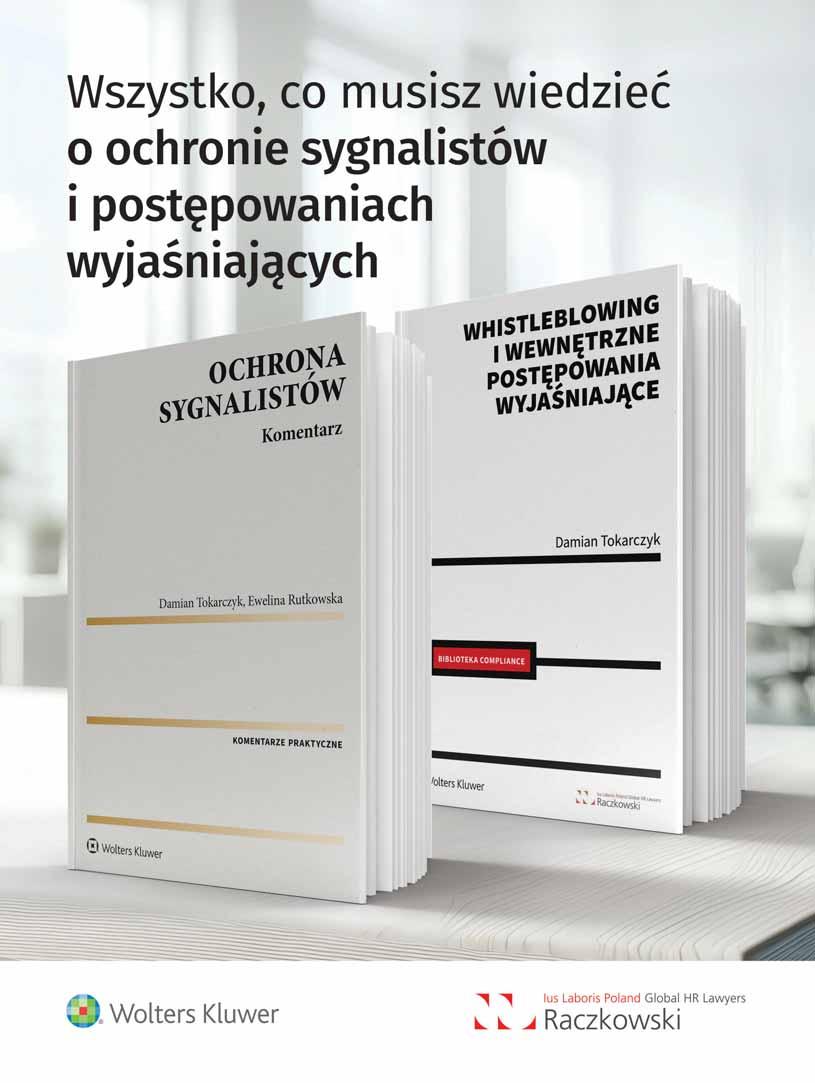

Sygnaliści: nowe przepisy polskiego prawa Już niebawem wejdzie w życie w życie większość przepisów ustawy o ochronie ustawy o ochronie sygnalistów sygnalistów.

Usługi i ekologia zmieniają rynek druku W segmencie druku na znaczeniu zyskuje oferta kompleksowych usług zarządzanych. pytają też o urządzenia refabrykowane.

9 HP wywinduje Ingram Micro

Rozmowa z Bogdanem Wiśniewskim, Business Unit Managerem w Ingram Micro

10 OpenAI czuje na plecach oddech rywali

11

Zbliża się kolejna tura finansowania OpenAI

Nowoczesna firma to zrównoważona firma

Innowacyjne komputery i monitory biurowe MSI

12 Czas na debatę o polskim IT

Rozmowa z Michałem Piątkowskim, CEO Motife

16 Cyberbezpieczeństwo 2.0 w jednostkach samorządowych

Samorządy mają trudności, aby nadążać za zmianami zachodzącymi w świecie cyberbezpieczeństwa (Exclusive Networks)

18 ESG: jak wykorzystać szansę i uniknąć zagrożeń

Rozmowa z Andrzejem Przybyło, prezesem Grupy AB

20 Hiperskaler: wróg czy przyjaciel?

Liczba największych dostawców usług chmurowych rośnie w dość szybkim tempie

23 Dlaczego wciąż nie wszyscy opuszczają chmurę?

GigaCloud we współpracy z partnerami zapewnia klientom rozwiązania chmurowe, oferując niezawodne środowisko przechowywania i ochrony danych

24 Boat.Alert, czyli druga para oczu Czym Boat.Alert różni się od typowych aplikacji bezpieczeństwa (Boat.Systems)

25 Usługi i ekologia zmieniają rynek druku

W segmencie druku na znaczeniu zyskuje oferta kompleksowych usług zarządzanych

28 Druk jako usługa: jak MPS rewolucjonizuje pracę biura

Rozmowa z Pawłem Lechickim, MPS Coordinatorem w polskim oddziale Brothera

30 Sprzedaż laserowych MFP mocno w górę Dane IDC Polska dotyczące polskiego rynku

31 FIS-KOMP na rynku druku: z usługą do klienta Warszawska firma rozwija usługowy model działalności w oparciu o drukarki Canon

32 Zarządzanie dokumentami nie musi być uciążliwe

Rozmowa z Adamem Wolfem, Technical Sales Specialist w polskim oddziale Epsona

34 IT w handlu

Sklepy stacjonarne się nie poddają

37 Od lady aż po tablety

Wszystko dla handlu detalicznego (Zebra, Jarltech)

38 Nowa jakość dla edukacji i biznesu

Dotykowe monitory interaktywne stanowią jeden z filarów oferty produktowej firmy ViewSonic

39 Ankieta CRN.pl Nie taki ład, jak go malują?

Technofeudalizm: chmurowi dziedzice i cyfrowi chłopi Recenzja książki Janisa Warufakisa „Technofeudalism: What Killed Capitalism”

40 Systemy AI wiedzą, ale nie rozumieją Rozmowa z Lucy Szaszkiewicz, CEO 1Strike.io

42 Startupy optymalizują dane i procesory Oszczędności w erze procesorów graficznych i dużych zbiorów danych nabierają dodatkowego znaczenia

44 Fuzje i przejęcia: CloudFerro z zastrzykiem gotówki W pierwszym kwartale tego roku na polskim rynku M&A miało miejsce 95 transakcji

45 Startup to nie bajka Felieton Szymona Janiaka

46 How to Startup Wieści z sektora startupów

48 13 kroków... ...aby z szefa kanału sprzedaży zmienić się w szefa ekosystemu

52 Sygnaliści: nowe przepisy polskiego prawa Polska to ostatni kraj, który przyjął przepisy wdrażające dyrektywę o sygnalistach

54 AI Act: „sztuczne” prawo? Kontraktowanie rozwiązań AI rodzi ryzyko naruszenia praw autorskich i danych osobowych

56 Technofeudalizm: chmurowi dziedzice i cyfrowi chłopi Recenzja książki Janisa Warufakisa „Technofeudalism: What Killed Capitalism”

58 Puls branży IT

Istotne trendy produktowe, technologiczne, biznesowe, w oparciu o dane pochodzące z renomowanych agencji analitycznych, organizacji branżowych i globalnych mediów, dotyczące głównie Europy i Polski

60 Cyfrowe Mazowsze

Rozmowa z Marcinem Pawlakiem, dyrektorem Departamentu Cyfryzacji, Geodezji i Kartografii Urzędu Marszałkowskiego Województwa Mazowieckiego

62 LinkedIn Park Sprawdzamy, o czym branża IT (i nie tylko) dyskutuje na największym portalu społecznościowym

64 Porachunki z bankami Felieton Wacława Iszkowskiego

66 Spokojnie, to tylko kłamstwo Felieton Wojciecha Urbanka

Otym, że nadgorliwość jest gorsza od faszyzmu, wiedziałem od wczesnego dzieciństwa, bo tak się mawiało u mnie w domu. O czym sobie przypominam za każdym razem, gdy nasi politycy biorą się za wdrażanie unijnych dyrektyw. Od razu wiadomo, że ich polska wersja będzie przegadana, zagmatwana i wymagająca.

Najnowszy przykład? Nowe Prawo komunikacji elektronicznej na bazie Europejskiego Kodeksu Łączności Elektronicznej. Według sześciu organizacji branżowych „ustawa, której branża oczekuje od 4 lat, mija się z obecnymi realiami rynkowymi i bez uzasadnionego powodu wychodzi poza zakres wdrażanej dyrektywy EKŁE. Dodatkowo, skrócony nieoczekiwanie do 3 miesięcy okres vacatio legis na wdrożenie tak rozległych zmian uznać należy za nieracjonalnie krótki. Przedsiębiorcy nie powinni ponosić kosztów opóźnień legislacyjnych i wcześniejszych zaniechań”. Branża apeluje o szybki powrót do prac gwarantujących racjonalne rozwiązania, licząc na pilne rozpoczęcie rozmów ze stroną rządową i regulatorami. Po szczegóły zapraszam do sierpniowego numeru CRN Polska, gdzie opublikowaliśmy pełną treść rozpaczliwego, a jednocześnie niezwykle charakterystycznego apelu ze strony przedsiębiorców do ustawodawców.

Niestety, nie jestem w tej sprawie optymistą, bo lata mijają, a diagnoza prof. Legutki, zgodnie z którą mamy w Polsce do czynienia z „modernizacją przez kserokopiarkę”, jest wciąż aktualna. Co wynika częściowo z faktu, że po 1989 roku dla większości z nas „wszelka >>zachodniość<< z miejsca stała się fajna i godna naśladowania” (to z kolei cytat z książki „My, fajnopolacy” Piotra Stankiewicza). Efekt jest taki, że zamiast filtrować unijne propozycje przez sito pytań o to, co leży w polskim interesie, a co się u nas nie sprawdzi, implementujemy zachodnie pomysły nawet, gdy nie do końca rozumiemy ani ich celów, ani skutków. Przy czym uprzejmie

zakładam, że robimy to z niewiedzy i nieudolności, a nie celowo.

Tymczasem kolejne dyrektywy same w sobie zaczynają podcinać unijną gałąź, na której wszyscy siedzimy. A jako że jesteśmy świeżo po XXIII Forum Ekonomicznym w Karpaczu, oddam głos Zygmuntowi Berdychowskiemu, organizatorowi tego wydarzenia: „Już jesteśmy świadkami exodusu różnych firm przemysłowych, które uciekają z Unii Europejskiej, dlatego że tu jest droga energia, że trzeba raportować ESG, że trzeba spełniać wiele dodatkowych warunków – i to się najzwyczajniej w świecie nie opłaca”.

Najwyższy czas na Okrągły Stół Gospodarczy, przy którym zasiądą politycy, przedsiębiorcy i organizacje konsumenckie. Przy czym nie upieram się, żeby był poprzedzony rozmowami w Magdalence…

Tomasz Gołębiowski Redaktor naczelny

MIESIĘCZNIK CRN POLSKA www.CRN.pl

Rok 27, numer 9 (502), 18 września 2024 PL ISSN 2080-8607

REDAKCJA

Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa redakcja@crn.pl

Tomasz Gołębiowski tg (redaktor naczelny) tel. 608 425 699 tomasz.golebiowski@crn.pl

Wojciech Urbanek wu (zastępca red. naczelnego) tel. 691 672 065 wojciech.urbanek@crn.pl

Karolina Marszałek km (sekretarz redakcji) karolina.marszalek@crn.pl

Andrzej Gontarz ag andrzej.gontarz@crn.pl

Krzysztof Jakubik kj krzysztof.jakubik@crn.pl

Krzysztof Pasławski kp krzysztof.paslawski@crn.pl

Tomasz Janoś tj tomasz.janos@crn.pl

FELIETONY

Wacław Iszkowski, Szymon Janiak, Wojciech Urbanek,

GRAFIKA, LAYOUT, KOORDYNACJA PRODUKCJI: Tomasz Baziuk

FOTOGRAFIE

Theta Art Studio Tomasz Pisiński, PhotobyMysluk.pl, Adrian Stykowski, Piotr Syndoman, archiwum PRENUMERATA prenumerata@crn.pl

REKLAMA I PROJEKTY SPECJALNE Agata Myśluk tel. 694 455 426 agata.mysluk@crn.pl

Jacek Goszczycki tel. 601 935 513 jacek.goszczycki@crn.pl

WYDAWCA Peristeri Sp. z o.o. Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa

Reklamy są przyjmowane w siedzibie wydawnictwa. Za treść ogłoszeń redakcja nie ponosi odpowiedzialności. © 2024 Peristeri Sp. z o.o. Wszelkie prawa zastrzeżone.

Warsaw Equity Group zainwestuje ponad 20 mln zł (z możliwością rozszerzenia do ponad 30 mln zł) w Xopero Software. Transakcja ma przyspieszyć globalną ekspansję gorzowskiej firmy, rozwój produktów i powiększenie zespołu, co z kolei w ocenie WEG przełoży się na wielokrotny wzrost sprzedaży i przychodów spółki w perspektywie kilku lat. Do transakcji dołączyli Maciej Zawadziński, przedsiębiorca i współzałożyciel funduszu Hard2beat oraz Paweł Maj, inwestor VC w spółki cybersecurity.

Dell w II kw. roku finansowego 2025 zwiększył przychody o 9 proc., do 25 mld dol. Zysk operacyjny poprawił się natomiast o 15 proc. (1,3 mld dol.), a zysk netto o 85 proc. (841 mln dol.). Tak duży wzrost to w dużej mierze efekt rekordowej sprzedaży produktów infrastrukturalnych. Sprzedaż serwerów zoptymalizowanych pod kątem sztucznej inteligencji zwiększyła się o 23 proc. wobec I kw. finansowego, do wartości 3,2 mld dol., co stanowi około połowy z 6 mld dol. dla serwerów AI sprzedanych w ciągu ostatnich czterech kwartałów.

Sprzedaż w sieciach franczyzowych Grupy AB wzrosła w II kw. 2024 r. o 18,9 proc. rok do roku. Podana dynamika dotyczy Polski, Czech i Słowacji. Na polskim rynku chodzi o Alsen, Kakto i Wyspę Szkrabów (zabawki dla dzieci), na czeskim o Digimax, Comfor, Premio, Play i Triline, a na słowackim o Comfor i Play. Na sprzedaży w sieciach franczyzowych korzystają producenci, Grupa AB, jak i partnerzy (strategia triple-win).

Comarch w II kw. 2024 r. zwiększył przychody zarówno ze sprzedaży krajowej, jak i z eksportu. W kraju w II kw. 2024 r. sprzedaż grupy poprawiła się o 12,5 proc., osiągając poziom 205,8 mln zł. Sprzedaż zagraniczna stanowiła większość, bo blisko 54 proc. przychodów grupy. Z tym, że znaczny wpływ na wyższe obroty z eksportu w II kwartale 2024 r. miały różnice kursowe, związane z umocnieniem się złotego wobec walut obcych. Ten czynnik zwiększył przychody ze sprzedaży w minionym kwartale o 1,9 mln zł (podczas gdy w II kw. 2023 r. różnice kursowe zmniejszyły obrót w złotówkach o ponad 19 mln zł).

Nvidia, w II kw. roku finansowego 2025 (zakończonym 28 lipca br.), zanotowała przychody o wartości 30,04 mld dol., co oznacza wzrost o ponad 122 proc. rok do roku. Sprzedaż pociągnął biznes centrów danych, gdzie przychody wyniosły 26,3 mld dol. (+154 proc. r/r).

Zysk netto producenta poprawił się w omawianym okresie do poziomu 16,6 mld dol., czyli o 168 proc. Mimo że wyniki Nvidii, na które czekało całe Wall Street, generalnie przekroczyły oczekiwania inwestorów, cena akcji spółki spadła w handlu posesyjnym o prawie 7 proc., do 116,95 dol. Tym samym wartość kapitalizacji spółki zmniejszyła się o około 200 mln dol. Nadal jednak kwota jest imponująca i wynosi 2,9 biliona dol.

„Tounikalnaofertawśród dystrybutorów.Tenkoncept sięsprawdza”– Andrzej Przybyło o sieciach franczyzowych Grupy AB.

Niemal 9 na 10 firm na świecie doświadczyło w ub.r. co najmniej jednego incydentu naruszenia bezpieczeństwa w środowisku Kubernetes – wynika z raportu Red Hata. W przypadku 67 proc. organizacji obawy związane z ochroną kontenerów spowodowały wydłużenie procesu wdrażania aplikacji. Nie dziwi więc, że wiele przedsiębiorstw nadal ostrożnie podchodzi do tego rozwiązania. W 44 proc. firm korzystających z Kubernetes problemy wynikające z poważnych luk w zabezpieczeniach zostały wykryte na etapie budowy i wdrażania narzędzi IT.

Placówki edukacyjne wciąż zbyt często padają ofiarami cyberataków. W 2023 r. 63 proc. szkół podstawowych oraz 66 proc. uczelni wyższych na świecie padło ofiarą ataków ransomware – wynika z danych Sophosa. To mniejszy odsetek niż w 2022 r. (odpowiednio 80 i 79 proc.). Jednak wydatki związane z odzyskiwaniem danych poszybowały w górę. Średni koszt dla placówek niższego szczebla edukacji zwiększył się ponad dwukrotnie, osiągając kwotę 3,76 mln dol., podczas gdy na uczelniach wyższych nastąpił niemal czterokrotny wzrost, do kwoty 4,02 mln dol. Aż 95 proc. placówek edukacyjnych, które doświadczyły ataku, zgłosiło próby naruszenia bezpieczeństwa ich kopii zapasowych przez cyberprzestępców. Niestety, ponad 70 proc. tych prób zakończyło się sukcesem.

Intel analizuje opcje strategiczne w celu rozwiązania problemu słabnącego biznesu. W grę wchodzi m.in. podział firmy lub sprzedaż części biznesu – informuje CNBC. Według Bloomberga rozważane możliwości obejmują fuzje i przejęcia albo zbycie lub podział działu foundry, który produkuje czipy dla klientów zewnętrznych. Przypuszcza się, że Intel wstrzyma niektóre plany ekspansji przed ewentualnym oddzieleniem tego biznesu. Koncern zatrudnił Morgan Stanley i innych doradców, aby przedstawili opcje dyrektorom Intela w tej sprawie we wrześniu br.

Policja zatrzymała w Elblągu cztery osoby zamieszane w wyłudzanie pieniędzy w zamian za usuwanie negatywnych komentarzy w sieci. Dotyczyły one trzech kancelarii adwokackich. Śledczy zarzucają zatrzymanym przestępstwa prania pieniędzy, oszustwa i usiłowania wymuszenia rozbójniczego. Główny podejrzany na 3 miesiące trafił do aresztu. Podczas przeszukań zabezpieczono nośniki danych w postaci telefonów, kart bankomatowych i umów bankowych.

CBA zatrzymało kolejną osobę w związku ze śledztwem dotyczącym ustawiania przetargów na usługi i sprzęt informatyczny w Zachodniopomorskim Zarządzie Dróg Wojewódzkich w Koszalinie. Doszło do kolejnych akcji w tej sprawie po tym, jak w czerwcu br. zatrzymano cztery osoby, w tym jednego przedsiębiorcę. Kolejna zatrzymana to urzędniczka z urzędu miejskiego w Pabianicach. W Prokuraturze Regionalnej w Szczecinie przedstawiono jej zarzut niedopełnienia obowiązków i przekroczenia uprawnień w celu osiągnięcia korzyści majątkowej i zmowy przetargowej. Prokurator zastosował wobec zatrzymanej zabezpieczenie majątkowe w kwocie 20 tys. zł, a także poręczenie majątkowe w wysokości 30 tys. zł.

„Popytznacznieprzewyższa podaż”– Colette Kress, dyrektor finansowa Nvidii, na temat procesorów Blackwell.

„BarierywdrażaniaAI nadużąskalębędą maleć”– Ritu Jyoti, dyrektor generalna ds. AI w IDC.

AB sprzeda magazyn przy ul. Kościerzyńskiej we Wrocławiu, gdzie znajdowała się kiedyś siedziba firmy. Zawarto już umowę przedwstępną z nabywcą, w której ustalono, że do spółki z tytułu transakcji wpłynie 35 mln zł netto. Po finalizacji transakcji dystrybutor jeszcze przez 3 lata będzie mógł wynajmować powierzchnię w zbywanym obiekcie. Obecny, centralny magazyn AB, który jest 2,5-krotnie większy od właśnie sprzedawanego, został wybudowany w 2016 r. w Magnicach koło Wrocławia. Koszt inwestycji, obejmującej też nową siedzibę główną Grupy AB, wyniósł wówczas 129 mln zł.

Część programistów straci prawo do ulgi IP Box – wynika z projektu ustawy, nad którym pracuje Ministerstwo Finansów. Resort chce wprowadzić wymóg zatrudnienia dla osób chcących skorzystać z ulgi. Prawdopodobnie oznacza to, że programiści na B2B stracą do niej prawo, jeżeli nie zatrudniają pracowników. Ponadto podstawa obliczenia daniny solidarnościowej (4 proc. od dochodu ponad 1 mln zł) ma objąć dochody opodatkowane IP Box. Zmiana jest częścią większego pakietu modyfikacji w PIT i CIT, które mają uszczelnić system podatkowy. W przypadku IP Box może w praktyce oznaczać, że małe i jednoosobowe firmy pożegnają się z ulgą, a duże przedsiębiorstwa już niekoniecznie.

Centrum Informatyki Resortu Finansów prowadzi przetarg na dostawę produktów Red Hata. Przedmiotem zamówienia jest zawarcie umowy ramowej na dostawę oprogramowania wraz z licencjami w modelu subskrypcyjnym, przy czym dopuszczony jest równoważny software. W odpowiedzi wpłynęło osiem ofert, które złożyli: DahliaMatic, konsorcjum Comarchu i Engave, Decsoft, Simplicity, Symmetry, konsorcjum Linux Polska i 4Towers, Eskom IT i Comtegra. Zamawiający deklaruje, że zawrze umowę ramową na trzy lata z maksymalnie pięcioma wykonawcami. Kryteria oceny to: upust dla produktów głównych dostawcy, których listę zawiera dokumentacja przetargowa (85) oraz upust dla produktów innych niż główne (15).

n Groźny haker wpadł w Polsce

Polska cyberpolicja we współpracy z FBI zatrzymała mężczyznę, poszukiwanego przez Interpol za cyberprzestępstwa. Wpadł przy próbie przekroczenia granicy polsko–białoruskiej. Podejrzanym jest 38-letni obywatel Białorusi i Ukrainy, Maksym S., pseudonim „J.P. Morgan”, „xxx” i „lansky”. Według służb kierował włamaniami komputerowymi i oszustwami bankowymi na międzynarodową skalę. Maksym S., który został przewieziony do USA, jest tam oskarżony o przestępstwa związane z przesyłaniem złośliwego oprogramowania i oszustw internetowych dotykających „komputery milionów ofiar” w okresie od października 2013 r. do marca 2022 r. Zarzuty dotyczą ponadto stworzenia ransomware’u pod nazwą Ransom Cartel.

Passus zdecydował się na zbycie spółki zależnej Sycope, która dostarcza własne oprogramowanie do zabezpieczania sieci. Zostanie przejęta w transakcji wartej 9 mln zł przez Tadeusza Dudka (dotychczasowy prezes Passus SA) i Łukasza Bieńkę (członek zarządu). Obaj w związku z tym odeszli z zarządu Passus SA. Ponadto Sycope zostanie dokapitalizowane z funduszu private equity. Transakcja stanowi finansową ulgę dla grupy, gdyż inwestycje w Sycope mocno obciążały budżet warszawskiego integratora, pochłaniając w sumie kilkanaście milionów złotych (spółka została zarejestrowana w 2022 r.). Uwolnione więc zostały spore środki na jej dalszy rozwój.

n Ingram Micro Polska strategicznym partnerem

Ingram Micro Polska ogłosiło nawiązanie strategicznej współpracy z HP Inc. Partnerstwo ma na celu wprowadzenie na polski rynek szerokiej gamy produktów i usług amerykańskiej marki. Współpraca z HP umożliwi Ingram Micro Polska rozszerzenie oferty o zaawansowane technologie, takie jak najnowsze komputery i urządzenia peryferyjne. Klienci Ingram Micro Polska będą mogli korzystać z rozwiązań producenta wspieranych przez sieć dystrybucji i profesjonalne wsparcie techniczne. Tym samym partnerstwo łączy szeroką ofertę HP z doświadczeniem i siecią dystrybucyjną Ingram Micro Polska. Obie firmy są przekonane, że ich współpraca przyczyni się do jeszcze lepszego zaspokojenia potrzeb klientów i wzmocnienia ich pozycji na rynku.

n AMD kupi dostawcę serwerów AI

AMD za 4,9 mld dol. przejmie ZT Systems, dostawcę serwerów i specjalistę od przetwarzania w chmurze. Firma z siedzibą w stanie New Jersey działa od blisko 30 lat i generuje około 10 mld dol. przychodów rocznie. Zatrudnia około 2,5 tys. pracowników. Finalizacja transakcji jest spodziewana do końca 2025 r. Po niej ZT Systems dołączy do grupy AMD Data Center Solutions. Według AMD wiedza i doświadczenie ZT Systems w projektowaniu i optymalizacji rozwiązań przetwarzania w chmurze pomoże klientom chmurowym i korporacyjnym przyspieszyć implementację infrastruktury AI opartej na AMD, w tym systemów wdrażanych na dużą skalę.

n Cisco zwolni 5 tysięcy osób

W sierpniu br. rodzina Filipiaków, wraz z funduszem CVC Capital Partners Fund IX i Anną Prokop, ogłosili wezwanie na akcje Comarchu. Oferują 315,40 zł za sztukę. Chcą w ten sposób przejąć 5,266 mln papierów wartościowych spółki. Ich łączna cena sięga tym samym 1,66 mld zł. Zapisy chętnych na sprzedaż papierów potrwają do 21 października br. Wezwanie dotyczy akcji reprezentujących 34,81 proc. głosów w spółce. Wzywający, działający w porozumieniu, posiadają już łącznie 65,19 proc. głosów. Celem transakcji jest osiągnięcie przez nich 100 proc. udziałów i wycofanie spółki z giełdy. Krakowski koncern informatyczny zamierza skoncentrować się na rozwoju na rynkach zagranicznych, w czym mają wspomóc go inwestorzy.

Intel analizuje opcje strategiczne, w celu rozwiązania problemu słabnącego biznesu. W grę wchodzi m.in. podział firmy lub sprzedaż jej części – informuje CNBC. Według Bloomberga rozważane możliwości obejmują fuzje i przejęcia albo zbycie lub podział działu foundry, który produkuje czipy dla klientów zewnętrznych. Koncern zatrudnił konsultantów z Morgan Stanley i innych doradców, aby przedstawili opcje dyrektorom Intela w tej sprawie jeszcze we wrześniu br. Przypomnijmy, że na początku sierpnia br. Intel ogłosił plan ograniczenia kosztów. Obejmuje redukcję zespołu o 15 proc. (ponad 15 tys. osób), jak też cięcie innych wydatków operacyjnych oraz kapitałowych. W efekcie koszty mają spaść w przyszłym roku o 10 mld dol.

Koncern zamierza ograniczyć globalne zatrudnienie o 7 proc. Oznacza to, że z firmą pożegna się około 5 tys. osób. Koszt redukcji oszacowano na blisko 1 mld dol., z czego 700 – 800 mln zostanie wydanych w I kw. finansowym 2025 (tj. od 28 lipca br.), głównie na odprawy i inne świadczenia. Cięcia mają być związane z koncentracją firmy na szybko rosnących obszarach, takich jak cyberbezpieczeństwo i sztuczna inteligencja. Cisco twierdzi, że zamówienia AI przekroczyły już 1 mld dol. i przewiduje kolejny 1 mld w tym roku finansowym.

Nowe Prawo Komunikacji Elektronicznej wejdzie w życie w listopadzie br. Pomimo protestów ze strony branży, regulacje przeszły przez cały proces legislacyjny. Jak przekonuje Ministerstwo Cyfryzacji, ustawa przynosi szereg korzyści, takich jak wzmocnienie ochrony konsumentów i poprawę jakości usług telekomunikacyjnych. Tymczasem w ocenie organizacji reprezentujących sektor telekomunikacyjny PKE mija się z realiami rynkowymi, a jego nieprecyzyjne zapisy mogą zniszczyć polskich przedsiębiorców. Obowiązki, jakie przepisy nakładają na firmy z branży teleinformatycznej, wymagają wielomilionowych nakładów finansowych i długiego czasu na ich wdrożenie – alarmowały wcześniej izby branżowe. Jak widać, bezskutecznie.

Claudia Nieuwland została Chief Operating Officerem w Britenet, a jej doświadczenie ma posłużyć do rozwoju biznesu polskiej firmy w Europie. Britenet, z centralą w Warszawie, specjalizuje się w rozwoju oprogramowania i na obecnym etapie działalności chce zwiększyć swoje udziały w zagranicznych rynkach. Claudia Nieuwland ma ponad 25 lat doświadczenia w rozwijaniu firm na różnych rynkach, w tym w Belgii, Luksemburgu, Francji, Wielkiej Brytanii i Szwajcarii. Zarządzała zmianami organizacyjnymi, wdrażaniem nowych rozwiązań operacyjnych, jak też kierowała strategiami marketingowymi i sprzedażowymi. Wcześniej pracowała dla takich firm jak Solumob, SD Worx i Attentia.

n Awans Jakuba Kozaka

Jakub Kozak objął stanowisko Area Sales Director ECE w Genetecu. Będzie odpowiedzialny za opracowanie i realizację strategii regionalnej i nadzór nad sprzedażą w 14 krajach. Do tej pory pełnił funkcję Regional Sales Managera. Z kanadyjską firmą jest związany od 5 lat. Ma ponad 20 lat doświadczenia w branży. W minionych latach pracował w Axis Communications (2014 – 2018), zarządzając sprzedażą i relacjami biznesowymi w regionie, a wcześniej był Country Managerem Nedapa w Polsce (2011 – 2014).

Rubrik powołał Agnieszkę Jabłońską na stanowisko Channel Sales Directora na Polskę, kraje bałtyckie, Czechy i Słowację. Będzie odpowiadać za rozwijanie strategicznych partnerstw kanałowych amerykańskiego dostawcy rozwiązań do zarządzania i ochrony danych, jak też prowadzenie inicjatyw sprzedażowych i zwiększanie zaangażowania klientów w regionie. Agnieszka Jabłońska ma 25-letnie doświadczenie w branży IT. Zanim dołączyła do Rubrika, pracowała w Cisco Systems jako Channel Account Manager, Distribution Manager, Sales Leader for Small & Medium-sized Enterprises i Channel Manager.

Do zespołu Esri Polska dołączyła Monika Kleinrok-Brzozowska, obejmując stanowisko dyrektora ds. finansów i administracji. Będzie odpowiedzialna za zarządzanie finansami firmy, która jest wyłącznym przedstawicielem Esri Inc., dostawcy oprogramowania systemów informacji geograficznej (GIS). Monika KleinrokBrzozowska ma 15-letnie doświadczenie w obszarze finansów, księgowości i controllingu. Uprzednio pełniła funkcję menedżera ds. finansów farm wiatrowych Grupy Innogy w Polsce, jak też pracowała w polskich spółkach technologicznych, takich jak Packhelp i BaseLinker.

Bartosz Dzirba objął stanowisko prezesa Passusa. Z firmą jest związany od 15 lat. Dotychczas pełnił funkcję wiceprezesa. Zmiana nastąpiła w związku z realizacją umowy inwestycyjnej, w ramach której dotychczasowy prezes Passusa, Tadeusz Dudek, jak i członek zarządu Łukasz Bieniek przejmują spółkę zależną Sycope w ramach transakcji o wartości ponad 9 mln zł. Obaj złożyli w związku z tym rezygnacje ze swoich funkcji w zarządzie Passus SA.

Robert Pusz został dyrektorem sprzedaży Newline Interactive na region EMEA, zastępując na tym stanowisku Marka Harrisa. Do jego obowiązków należy teraz nadzorowanie sprzedaży w regionie. Robert Pusz dołączył do Newline Interactive w 2015 r. jako Sales Manager na Europę Wschodnią. Odegrał kluczową rolę w budowaniu pozycji amerykańskiej marki w Europie i we wzroście sprzedaży w naszym kraju. Na początku 2024 r. awansował na stanowisko Senior Managera. Przed przejściem do Newline Robert Pusz doświadczenie zdobywał w ViDiS-ie i Acco Brands. W branży IT działa od ponad dwóch dekad.

Na ile podpisanie umowy dystrybucyjnej z HP wzmacnia ofertę Ingram Micro?

W naszej ofercie bardzo brakowało produktów marki HP. Pozyskanie kontraktu z HP Inc. zwiększy jej konkurencyjność. Liczymy, iż w ciągu kolejnych 12 miesięcy staniemy się kluczowym dystrybutorem na rynku IT. Od ogłoszenia poszerzenia oferty o HP Inc., wielu resellerów zwraca się do nas z prośbą o ofertę na rozwiązania tego producenta, co daje nam pewność, iż ten kontrakt to doskonały ruch wzmacniający naszą pozycję na rynku.

Nowy dystrybutor to szansa dla partnerów na lepsze warunki handlowe?

Resellerzy maksymalizując zyski, starają się dzielić zamówienia w taki sposób, aby w pełni wykorzystywać limity kredytowe u poszczególnych dystrybutorów. To bardzo korzystne zarówno z punktu widzenia resellera, jak i dystrybutora. Nowy dystrybutor HP to wielka szansa na zwiększenie zarówno obrotów, jak i zysków naszych partnerów.

Na które modele komputerów stawia HP?

HP wspiera rozwój rynku SMB, są to klienci wymagający i wyedukowani. Aby sprostać oczekiwaniom, HP stawia na modele ProBook oraz Elitebook – wzmocniona obudowa oraz gwarancja NBD on site sprosta najwyższym oczekiwaniom. Widzimy też duże zainteresowanie modelami stacji roboczych z serii Z, zarówno mobilnych jak i stacjonarnych. Dzięki unikalnym rozwiązaniom HP oraz szerokiej gamie produktów, partnerzy mogą liczyć na do-

„Kiedy informacja poszła w świat, zaczęło się do nas odzywać wielu partnerów, w tym również tych, którzy

wcześniej nie byli zbyt aktywni” – mówi Bogdan

Wiśniewski, Business Unit Manager HP w Ingram Micro.

skonały dobór rozwiązania do potrzeb swoich klientów.

Czy mniejsze zainteresowanie desktopami oznacza słabszą sprzedaż monitorów HP?

Absolutnie nie. Aktualnie wiele osób pracuje w trybie hybrydowym, potrzebuje więc dodatkowych ekranów zarówno w domu, jak i biurze. Zwiększony obszar roboczy pozwala na wydajniejszą oraz łatwiejszą pracę w wielu sektorach rynku. Jestem przekonany, że nadal duża część pracowników będzie korzystać z więcej niż jednego monitora. W związku z tym, ten rynek ma wciąż duży potencjał. Natomiast z naszego punktu widzenia bardzo ważne jest to, że HP jest jednym z pierwszoplanowych graczy w tym segmencie rynku.

Dwa lata temu HP przejęło Poly, producenta sprzętu audio i wideo do biur. W czasie pandemii tej klasy produkty sprzedawały się niemal na pniu. Ale czy popyt na nie, wraz z powrotem pracowników do biur, nieco nie wygasł? Większość firm pracuje w modelu pracy hybrydowej. W związku z tym zgłasza zapotrzebowanie na wysokiej klasy sprzęt do wideokonferencji. Poza tym firmy ograniczają liczbę wyjazdów na rzecz konferencji online. Portfolio HP Poly obejmuje szeroki zakres rozwiązań począwszy od wysokiej klasy słuchawek, czy personalnych kamer, poprzez soundbary czy profesjonalny sprzęt do prowadzenia telekonferencji. Rozmówcy po obu stronach kamery słyszą każde słowo i skupiają się na komunikacji dzięki zaawansowanym automatycznym systemom kadrowania grupy oraz śledzeniu osoby mówiącej.

Możliwości tych produktów są naprawdę imponujące. Za ich pomocą można prowadzić interaktywne wirtualne spotkania. I to w taki sposób, że nikt nie będzie miał prawa się podczas nich nudzić.

HP jest także liderem na rynku urządzeń drukujących. Niestety jest to segment, który najlepsze lata ma już za sobą. Jakie znaczenie dla Ingram Micro ma wprowadzenie do oferty tej grupy produktów?

Informacje o śmierci druku są przedwczesne. W biurach wciąż drukuje się i skanuje bardzo dużo dokumentów. Do tego potrzebny jest profesjonalny sprzęt. Nawet, jeśli firma podejmie decyzję o przejściu z dokumentów papierowych na cyfrowe, to i tak jeszcze przez pewien czas będzie potrzebować urządzenia MFP. Poza tym taki proces nie będzie przebiegać równolegle, niektóre organizacje zrobią to szybciej, inne później.

Rozwiązania dostępne w Ingram Micro oferują także inni dystrybutorzy. Dlaczego resellerzy powinni wybrać właśnie Ingram?

Ingram to nie tylko doskonała dostępność szerokiej gamy produktów. Naszym atutem jest szybkość działania, jak też responsywność na potrzeby resellera. Oferujemy wiele usług (w tym finansowanie i magazynowanie), pozwalających sprostać najbardziej wymagającym projektom. Dzięki temu możemy pochwalić się dwucyfrowymi wzrostami sprzedaży. Olbrzymia liczba partnerów docenia nasze zaangażowanie, a dzięki kontraktowi z HP liczymy, że w przeciągu kilkunastu miesięcy będziemy dla wielu z nich pierwszym wyborem.

Zbliża się kolejna runda finansowania OpenAI. Pieniądze są potrzebne, aby budować nowe, lepsze modele sztucznej inteligencji, a tym samym odeprzeć ofensywę konkurentów.

n Wojciech Urbanek

Nowa runda finansowania będzie największym zastrzykiem kapitału zewnętrznego dla OpenAI od stycznia 2023 r., kiedy to Microsoft zainwestował w kultowy już startup 10 mld dol. Jak do tej pory gigant z Redmond zasilił Open AI kwotą 13 mld dol. i posiada w nim 49 proc. udziałów. Wszystko wskazuje na to, że Microsoft przystąpi do zbliżającej się, kolejnej rundy finansowania OpenAI. W grupie inwestorów znajdą się również fundusz Thrive Capital, a także Apple oraz Nvidia. Na szczególną uwagę zasługują dwie ostatnie firmy. Nvidia uaktywniła się jako inwestor dwa lata temu, zasilając zastrzykiem finansowym Inflection AI oraz Databricks, a także mniejsze startupy związane z opracowywaniem nowych leków przy wykorzystaniu sztucznej inteligencji oraz zajmujące się robotyką. Craig Federighi, szef oprogramowania Apple, przyznał na czerwcowej konferencji dla developerów, że koncern korzysta z ChatGPT, ponieważ zaczął testowanie generatywnej sztucznej inteligencji w jej najlepszym wydaniu. W tym kontekście informacja o inwestycji w OpenAI pokazuje, że Apple nie ogranicza się wyłącznie do kurtuazji. Warto jednak w tym miejscu, dodać, że podczas wspomnianego wyżej samego wydarzenia, koncern z Cupertino napomknął o możliwości bliskiej współpracy z Google Gemini. Apple prowadziło również rozmowy z Meta, Anthropic oraz Perplexity.

Na ten moment OpenAI odczuwa presję ze strony konkurentów, a dopływ dużych środków finansowych mógłby pozwolić słynnemu startupowi zachować nad nimi przewagę. Do tego potrzebne jest stworzenie jeszcze lepszego modelu sztucznej inteligencji niż GPT-4. Taki skok technologiczny wymaga inwestycji w drogie superkomputery, naszpikowane procesorami graficznymi. OpenAI na opracowanie GPT-4 przeznaczył ponad 100 mln dol. Kolejny pochłonie prawdopodobnie jeszcze większą sumę.

ło przy tym na ChatGPT, dostępny za pośrednictwem Microsoft Azure. Wprawdzie na przestrzeni ostatnich 12 miesięcy cena usługi gwałtownie spadła, ale pomimo tego firma postanowiła opracować oprogramowanie ułatwiające korzystanie z różnych modeli sztucznej inteligencji w ramach całego systemu. To ilustruje wyzwania, z jakimi wkrótce musi zmierzyć się OpenAI.

Open source: za i przeciw

Model otwarty wydaje się wyjątkowo kuszący.

Jednak konkurencja nie śpi. Google oferuje swój własny produkt, a ponadto wraz z Amazonem włożył 6 mld dol. w Anthropic, konkurenta założonego przez byłych dyrektorów OpenAI. Natomiast Meta opracowała autorski model sztucznej inteligencji Llama, wydawany bezpłatnie oraz zintegrowany między innymi z Facebookiem oraz Instagramem. W bieżącym roku model był pobrany niemal 350 milionów razy. Julien Launay, założyciel startupu Adaptive ML, uważa, iż w przypadku wielu codziennych zastosowań lepiej sprawdzają się mniejsze, otwarte modele AI. Takie firmy jak: DoorDash, Shopify, Goldman Sachs czy Zoom, używają ich do obsługi klienta.

The Wall Street Journal opisuje interesujący przypadek Procore Technologies, dostawcy platformy do zarządzania skomplikowanymi projektami budowlanymi. Na początku roku firma ta po raz pierwszy wprowadziła funkcje wykorzystujące duże modele językowe. Procore postawi-

Mark Zuckerberg uważa, że podejście typu open source pozwoli większej liczbie ludzi na całym świecie czerpać korzyści ze sztucznej inteligencji. Można się tutaj doszukać analogii z systemem operacyjnym Android, który jest dostępny bezpłatnie dla każdego producenta smartfonów. To kontrastuje ze strategią Microsoftu, który pobiera od vendorów opłaty licencyjne za zainstalowanie oprogramowania Windows na ich komputerach. Natomiast Apple nie zezwala innym producentom korzystać ze swoich systemów operacyjnych.

Zwolennicy systemów zamkniętych wychodzą z założenia, że dysponują zasobami i odpowiednimi mechanizmami kontrolnymi, aby zapobiec niewłaściwemu wykorzystaniu SI. Ich zdaniem koncepcja open source może sprawić, że sytuacja wymknie się spod kontroli i grożą nam obrazki znane z „Terminatora” Jamesa Camerona.

Promotorzy open source’a przekonują, że ich systemy podlegają publicznej kontroli. W związku z tym łatwiej jest wykrywać problemy i radzić sobie z niezamierzonymi szkodami ze strony ich systemów, co byłoby trudne w rozwiązaniach zamkniętych. Jak na razie trudno ocenić kto zwycięży, aczkolwiek model otwarty wydaje się wyjątkowo kuszący, zwłaszcza dla użytkowników indywidualnych czy MŚP.

Rosnąca świadomość konsumencka i inne uwarunkowania gospodarcze sprawiają, że zrównoważony rozwój firmy przestaje być wyborem i staje się wymogiem, bez którego trudno myśleć o długoterminowym sukcesie na bardzo konkurencyjnym rynku.

Zrównoważony rozwój przedsiębiorstwa to nie tylko długoterminowa strategia umożliwiająca realizowanie planów i osiąganie zysków, ale i system wartości uwzględniający wrażliwość społeczną, dobrostan pracowników i dbałość o środowisko naturalne, coraz mocniej obciążone działalnością człowieka.

Harmonizacja tych elementów to zadanie wymagające, ale opłacalne, bo przynoszące realne korzyści w postaci oszczędności finansowych, nowych klientów czy wzmocnienia wizerunku firmy. A jednym ze sposobów osiągnięcia tego celu jest integracja nowoczesnych technologii, tworzonych z myślą o wydajności, komforcie użytkowania i ochronie środowiska naturalnego, jak innowacyjne komputery i monitory biurowe MSI.

– Naszym obowiązkiem jest promowanie zrównoważonego rozwoju i jesteśmy dumni z tego, że możemy zaoferować naszym klientom szereg produktów przyjaznych dla środowiska. W ten sposób przyczyniamy się do ochrony naszej planety – podkreśla Wojciech Jara, Business Development Manager NEE Region w polskim oddziale MSI.

Jednym z takich produktów MSI jest Cubi N ADL-002EU, komputer wyróżniający się atrakcyjną minimalistyczną stylistyką oraz kompaktowymi wymiarami. Jego niewielka obudowa o pojemności zaledwie 0,66 litra pozwala na instalację w dowolnym miejscu – za sprawą wsparcia dla standardu monta-

żowego VESA również na uchwycie lub za monitorem – oszczędzając mnóstwo miejsca na biurku i poprawiając ergonomię oraz estetykę stanowiska pracy.

Niewielkie gabaryty nie przeszkodziły jednak w wyposażeniu urządzenia w nowoczesne procesory Intel Core z rodziny Alder Lake, słynące z energooszczędnej hybrydowej architektury. W połączeniu z pamięcią

RAM DDR4 (do 16 GB) oraz nowoczesnym dyskiem SSD typu M.2 PCIe NVMe i możliwością rozbudowy o dodatkowy nośnik

SATA 2,5” gwarantują one wysoką wydajność podczas wykonywania codziennych obowiązków.

Nie bez znaczenia dla otoczenia firmowego są także moduł dTPM zapewniający szyfrowanie sprzętowe wrażliwych danych oraz bogaty zestaw złączy, pozwalający obsłużyć nawet trzy monitory o rozdzielczości 4K UHD, na który składają się m.in. HDMI, DisplayPort i USB-C (z Thunderbolt 4 i Power Delivery 65 W). Zgodnie z polityką wspierania zrównoważonego rozwoju MSI, możliwe jest również wyrobienie certyfikatu środowiskowego EPEAT Silver.

Monitor do nowoczesnego biura

Cubi N ADL-002EU znakomicie spisuje się w zestawie z 24-calowym bezramkowym monitorem PRO MP245V, wyposażonym w matrycę o wysokim kontraście 4000:1, rozdzielczości Full HD i częstotliwości odświeżania aż 100 Hz, który ostrością i płynno-

ścią deklasuje typowe wyświetlacze biurowe o częstotliwości 60 Hz.

Nie daje im również szans w zakresie ochrony wzroku, bo w ramach pakietu MSI Eye Care użytkownik może liczyć na technologie ograniczające emisję światła niebieskiego, przeciwdziałające migotaniu obrazu, antyodblaskową powłokę ekranu czy certyfikat TUV potwierdzający możliwość dłuższej pracy bez męczenia oczu. Producent przewidział nawet funkcje Eye-Q Check, za pomocą których można przeprowadzić korektę postawy czy wyświetlić siatkę Amslera umożliwiającą ocenę czynności centralnej części siatkówki. MSI PRO MP245V to jednak nie tylko atrakcyjna stylistyka, najwyższa jakość obrazu i ergonomia użytkowania, ale i dbałość o środowisko. Monitor został wyposażony w tryb oszczędzania energii i może się pochwalić prestiżowym certyfikatem Energy Star 8.0.

MSI Cubi N ADL-002EU i PRO MP245V objęte są 2-letnią gwarancją D2D dla biznesu z możliwością rozszerzenia na indywidualnych warunkach. Zapraszamy do sprawdzenia warunków handlowych u przedstawiciela MSI.

Kontakt do przedstawiciela MSI: Wojciech Jara, Business Development Manager NEE Region, MSI Polska tel. 519 513 912 wojciechjara@msi.com

„Przewagą polskich spółek IT może być dużo

większa otwartość na dawanie autonomii w podejmowaniu decyzji zatrudnionym w Polsce specjalistom. Dotyczy to również strategicznych kwestii technicznych czy biznesowych w procesie tworzenia oprogramowania” – mówi Michał

Piątkowski, CEO, MOTIFE.

To głównie dzięki międzynarodowym firmom nastąpił bardzo duży wzrost kompetencji polskich specjalistów.

Na początek porozmawiajmy o danych, jakie zebraliście na potrzeby niedawno opublikowanego raportu „Kraków IT Market Report 2024”. Z jednej strony cieszy, że lokalny rynek stale się rozwija, ale może nieco martwić stosunkowo niski odsetek polskich rm IT. Czy to jest realny problem? Michał Piątkowski Takie są fakty. W samym Krakowie działa w sumie kilkaset firm IT, zatrudniających około 60 tysięcy osób, z czego połowa pracuje w dużych oddziałach międzynarodowych firm. Biorąc pod uwagę, że w Krakowie funkcjonują też mniejsze zagraniczne oddziały, a więc liczące poniżej 500 zatrudnionych, szacujemy, że jedynie około 20 procent specjalistów IT w naszym mieście pracuje w polskich spółkach. I choć chciałoby się, aby przewagę miały rodzime podmioty, to warto podkreślić, że przez kilka minionych dekad to głównie dzięki międzynarodowym firmom nastąpił bardzo duży wzrost kompetencji wśród polskich specjalistów. Dodatkowo mieliśmy przez ten czas i wciąż mamy do czynienia ze znaczącym napływem ka-

pitału zagranicznego, korzystnie wpływając na inwestycje i konsumpcję.

Co należałoby zrobić, żeby sytuacja zmieniła się na korzyść polskich podmiotów?

Warto o tym dyskutować, bo przecież to, co wytwarzamy na rzecz międzynarodowych firm, stanowi ich własność intelektualną, z czego czerpią szereg korzyści biznesowych. A zatem polscy specjaliści zwiększają wartość firm zagranicznych, co w dłuższej perspektywie nie wzmacnia naszej gospodarki względem innych rynków. Sprawa ta ma jeszcze taki aspekt, że polskie państwo przez lata łożyło na edukację specjalistów, którzy pracują teraz w międzynarodowych strukturach. A jeśli nawet niektórzy z nich w polskich firmach, to często świadczących usługi programistyczne podmiotom spoza kraju. I kółko się zamyka…

Wracając do waszego raportu: jak prezentuje się Kraków, jako hub innowacyjności, w porównaniu z innymi dużymi miastami?

Kraków jest bardzo mocnym ośrodkiem, a jednocześnie ma swoją specyfikę. O ile w Warszawie korporacje chętnie lokują, poza zespołami programistów, swoje centrale oraz działy sprzedaży i marketingu, o tyle Kraków uznawany jest za świetną lokalizację dla centrów rozwoju oprogramowania, gdzie prym wiedzie kadra techniczna. Podobnie wygląda to w przypadku Wrocławia, Poznania i Gdańska. Z tą jednak różnicą, że Kraków jest mocno zdominowany przez firmy amerykańskie, podczas gdy we Wrocławiu i Poznaniu dominują raczej podmioty z regionu DACH, a Gdańsk jest chętniej wybierany do prowadzenia biznesu przez skandynawskie spółki technologiczne. Patrząc zaś z perspektywy technologicznej, w Krakowie dotychczas działało stosunkowo niewiele firm specjalizujących się w rozwiązaniach opartych na oprogramowaniu typu embedded. Z tym, że to się powoli zmienia, czego przejawem jest decyzja Volvo o otwarciu tutaj centrum badawczo-rozwojowego.

W minionych kilkunastu miesiącach w Krakowie zaczęło działać ponad 20 nowych zagranicznych firm IT, w tym pięć z nich to unicorny. Trzeba przyznać, że to bardzo dobry wynik, jednak chciałoby się zapytać: kiedy doczekamy się krakowskiego unicorna? Na razie wciąż czekamy na oficjalnego polskiego unicorna, który mam nadzieję w końcu się objawi, a na Kraków też przyjdzie czas. Moim zdaniem przeszkodą wcale nie są kompetencje technologiczne specjalistów, ale umiejętności biznesowe. To znaczy proszę mnie źle nie zrozumieć – polscy przedsiębiorcy potrafią tworzyć znakomite firmy, takie jak InPost czy Comarch, które podbijają obce rynki. Natomiast wciąż brakuje nam powszechnej wiedzy i rozmachu, niezbędnych do tego, aby działać globalnie. Częściowo tłumaczy to fakt, że skoro Stany Zjednoczone są epicentrum świata technologii (wciąż), a Europa jest położona na jego peryferiach, to tym samym Polska stanowi peryferie peryferiów… Dlatego zbudowanie globalnej firmy jest u nas dużo trudniejsze niż w USA i wymaga ogromnej wprost determinacji kluczowych osób w firmie. Zwłaszcza że o specjalistów na lokalnym rynku musimy konkurować z międzynarodowymi korporacjami. Poza tym łatwiej osiągnąć globalny sukces w segmencie rozwiązań B2B niż w sektorze B2C. W tym pierwszym przypadku, żeby zaistnieć na obcych rynkach, potrzebne są znacznie mniejsze nakłady marketingowe. A polskie firmy, które odnoszą sukcesy specjalizują się raczej w produktach dla rynku B2C – jak InPost, DocPlanner czy Booksy – gdzie jednak światowa konkurencja jest wyjątkowo silna, więc szczególnie trudno jest się przebić.

Łatwiej osiągnąć

globalny sukces w segmencie rozwiązań B2B niż w sektorze B2C.

biorstw w branży nowoczesnych technologii znajduje się w głowach prezesów firm działających w tej branży. Mam przekonanie, że wśród nich nie brakuje takich, którzy mają ambicje i możliwości działania na rzecz rozwoju całej polskiej branży technologicznej. Ciekawym pomysłem wydaje się stworzenie przez nich platformy współpracy, która zaplanuje, zainicjuje i będzie wspierać niezbędne dla branży działania. Warto na pewnym etapie włączyć do tych prac inne grupy: administrację rządową, przedstawicieli uczelni, przedstawicieli dużych spółek państwowych czy środowisk startupowych. Zwłaszcza, że tych zewnętrznych czynników, które sprawiają, że polski sektor IT nie wykorzystuje w pełni swojego potencjału, jest bardzo dużo i są bardzo różne. Dopiero ich właściwa identyfikacja, a następnie systematyczne rozwiązywanie kolejnych problemów, doprowadzi nas do celu. Możemy przy tym brać przykład z innych państw, które odniosły niewątpliwy sukces, w tym Izraela, ale nie tylko, bo również Wielkiej Brytanii czy Francji.

Mam obawy, że wielu polskich prezesów, którzy odnieśli sukces, będzie jednak chciało – zamiast swoje firmy dalej rozwijać – sprzedać je większym podmiotom, wybierając „karierę” rentiera.

Co należałoby zrobić, żeby wesprzeć rozwój polskiego sektora technologicznego? Czy to rola polityków? Częściowo pewnie tak, ale problem jest znacznie bardziej złożony. Praktyczna wiedza na temat budowania przedsię-

A czym się tu martwić? Ja akurat uważam, że to wcale nie jest niepożądane zjawisko. W USA jest powszechnie przyjęte, że firma technologiczna przechodzi przez różne fazy – od powstania aż do exitu. To właśnie dzięki udanym exitom do kluczowych osób w firmach trafiają pokaźne środki, z których część jest inwestowana w kolejne spółki. W efekcie rynek startupów rozwija się przez pączkowanie, co korzystnie wpływa na innowacyjność na danym rynku. W Polsce zaś zbyt często traktuje się swoje firmy jak własne „dzieci”, z którymi chce się pozostać do końca życia. Być może brakuje nam jeszcze kultury exitu, przez co dobrych polskich startupów, z doświadczoną kadrą founderów, jest mniej niż

mogłoby być. Niewykluczone, że tak będzie w przyszłości.

Za to wciąż przybywa zagranicznych marek. Z waszego raportu wynika, że w latach 2012–2023 średnio każdego roku rozpoczynało działalność w Krakowie dziesięciu zagranicznych graczy IT. W jaki sposób miasto pozyskuje nowych inwestorów?

Jednym z wielu czynników jest duża otwartość lokalnego samorządu, który zawsze deklaruje gotowość do rozmów i współpracy z inwestorami. Z drugiej strony lokalne organizacje, w tym zrzeszenia pracodawców, takie jak Aspire, ABSL, American Chamber of Commerce, jak też poszczególne firmy, są znakomitymi ambasadorami Krakowa. Ogromne znaczenie ma w tym przypadku międzynarodowy marketing szeptany.

A jakie znaczenie ma Krakowski Park Technologiczny, który pełni rolę administratora specjalnej strefy ekonomicznej?

Krakowski Park Technologiczny jest ważną instytucją lokalnego ekosystemu. Co do specjalnej strefy ekonomicznej, nie jestem przekonany czy zagraniczne firmy technologiczne powinny liczyć na znaczące ulgi podatkowe. Tym bardziej, że model biznesowy zagranicznych korporacji, który skutkuje niskim lokalnym zyskiem, a więc i niskimi kwotami podatków, sprawia, że tego rodzaju benefity mają dla inwestorów często marginalne znaczenie przy podejmowaniu decyzji o otwarciu oddziału w Polsce. Faktycznych powodów jest dużo więcej, w tym wysoko wykwalifikowana kadra za konkurencyjne stawki, a dodatkowo gwarantująca bliskość kulturową.

To rzeczywiście aż tak ważny czynnik?

coś będzie gotowe za tydzień, to taka deklaracja może mieć inne znaczenie niż kiedy to samo powie specjalista z innego kręgu kulturowego. Jest bardzo ważne, żeby obie strony wiedziały czego wzajemnie mogą się po sobie spodziewać i od siebie nawzajem oczekiwać.

Z waszych danych wynika, że w Krakowie rośnie zatrudnienie na stanowiskach wymagających specjalizacji, w tym data engineers, data scientists czy cloud engineers… Jest to trend obecny globalnie w całej branży IT. Można by powiedzieć, że jeśli ktoś chce mieć bardzo dobrą perspektywę rozwoju w sektorze IT, powinien specjalizować się w tych właśnie obszarach. Dotyczy to oczywiście nie tylko pojedynczych osób, ale też całych przedsiębiorstw.

A zatem jesteśmy bez szans?

Kraków uznawany jest za świetną lokalizację dla centrów rozwoju oprogramowania.

Jak najbardziej, bliskość kulturowa, a także zrozumienie międzykulturowe to jedne z kluczowych aspektów warunkujących dobrą współpracę i wzajemne porozumienie. Ujmę to tak, przykładowo, kiedy polski specjalista powie, że

Tytuł jednego z rozdziałów wspomnianego raportu brzmi: „How to employ IT talent in Poland?”. Spróbujmy odpowiedzieć na to pytanie. No cóż, z punktu widzenia polskich pracodawców w branży, firmy te muszą podjąć wysiłek i zaproponować swoim specjalistom podobny poziom wynagrodzeń i benefitów, jak zachodnie korporacje. Niestety, nie pomaga im w tym wciąż pokutujące przekonanie, czasem zresztą nie bez racji, że zagraniczne firmy charakteryzują się wyższą kulturą organizacyjną. A dodatkowo zapewniają dostęp do międzynarodowego środowiska, a nierzadko też podróży do różnych krajów, a więc zdobywania doświadczeń zawodowych poza Polską. Lokalne firmy, które ograniczają się do działania na polskim rynku z definicji nie są w stanie tego zaoferować. Warto jednak przy tym dodać, że inaczej wyglądają starania o świetnego specjalistę z doświadczeniem międzynarodowym, a inaczej próba pozyskania programisty bez dobrej znajomości języka angielskiego. W tym drugim przypadku polskiej firmie będzie mimo wszystko łatwiej.

Na szczęście nie. Przewagą polskich spółek IT może być dużo większa otwartość na dawanie autonomii w podejmowaniu decyzji zatrudnionym w Polsce specjalistom. Dotyczy to również strategicznych kwestii technicznych czy biznesowych w procesie tworzenia oprogramowania. Firmy zagraniczne zwykle nie dają tak dużej, a często wręcz żadnej swobody decyzyjnej swoim polskim pracownikom. Niemniej w pewnym momencie nastąpił taki dość ścisły podział na osoby pracujące w zagranicznych firmach i specjalistów, którzy pracują w firmach polskich. I przepływ pomiędzy tymi dwoma grupami jest stosunkowo niewielki. To wynika z jednej strony z bariery językowej, a z drugiej pojawiającego się u niektórych specjalistów przekonania, że przejście z korporacji do polskiej firmy to jakby transfer z ekstraklasy do niższej ligi.

Jednym ze szczególnie interesujących rozdziałów raportu jest ten dotyczący „neurodiversity in IT”. Z jakim potencjałem mamy tu do czynienia i jak można go uwolnić?

Przede wszystkim warto zapoznać się z tym tematem, a więc zdobyć wiedzę na temat rodzajów neuroróżnorodności. Posiadając już tę wiedzę, będzie można zastosować ją w praktyce. I niekoniecznie chodzi tu o cele biznesowe, ale o zmniejszanie wykluczenia społecznego w miejscach pracy. Przykładowo, należy w procesie rekrutacji wziąć pod uwagę, że nie każda osoba będzie odpowiadała zgodnie z przyjętym przez nas szablonem, co wcale nie znaczy, że jest niekompetentna. Nie brakuje świetnych fachowców, którzy mają bardzo konkretne potrzeby związane z miejscem pracy, przykładowo związane z hałaśliwym otoczeniem lub zbyt jasnym światłem. To oczywiście tylko pojedyncze przykłady, których jest znacznie więcej. Jeśli zatem postawimy tezę, że firma na zwiększonej różnorodności zawsze korzysta, to zatrudnianie osób z różnymi cechami w kontekście neuroróżnorodności ma również biznesowy sens. Na rynku są

profesjonalne firmy, którzy pomagają przedsiębiorcom w tym zakresie – jedną z nich prezentujemy w raporcie „Kraków IT Market Report 2024”.

Czy zagrożeniem dla dalszego rozwoju polskiego rynku IT jest demografia?

w niewystarczającym stopniu reguluje działania dużych firm technologicznych.

W długiej perspektywie z całą pewnością tak, ale to zagadnienie jest dużo bardziej złożone niż wynikałoby z alarmistycznych przekazów medialnych. Jak na razie w branży IT mamy do czynienia z dużym napływem chętnych. Wystarczy spojrzeć na rosnący odsetek studentów informatyki w stosunku do studentów wszystkich pozostałych kierunków. Obecnie przekroczył on już poziom 10 procent, bo coraz więcej osób chce pracować w sektorze IT ze względu na dobre płace i pewność zatrudnienia. W sumie zatem słaba demografia jest tymczasowo równoważona rosnącym zainteresowaniem branżą technologiczną. Docelowo jednak nie unikniemy konieczności opracowania mechanizmu ściągania do Polski specjalistów z zagranicy, w tym także na etapie edukacji. Osoby te po ukończeniu studiów w Polsce zostałyby tutaj podejmując pracę, najlepiej w polskiej firmie IT.

W ubiegłym roku wziął Pan udział, jako prelegent, w Krakowskim Salonie Ekonomicznym NBP. Tematem przewodnim była „wolność” jako składowa sukcesu gospodarczego. Czy w obecnej, przeregulowanej unijnej gospodarce, możemy jeszcze mówić o „wolności”?

Osobiście jestem zdania, że w niektórych aspektach jest niedostatecznie regulowana.

Słucham?

Sądzę, że Unia Europejska w niewystarczającym stopniu reguluje działania dużych firm technologicznych, przede wszystkim z grupy określanej niegdyś jako GAFAM. Przykładowo, Meta nie ponosi praktycznie żadnej odpo-

wiedzialności za to, jaką rolę odgrywa w procesach związanych z manipulowaniem opinią publiczną. Jednocześnie lokalne rządy w poszczególnych krajach europejskich nie mają wpływu na sposób funkcjonowania największych platform social mediowych czy wyszukiwarki Google. A to powinno podlegać skutecznym regulacjom. Z drugiej strony pozostaje otwartym pytanie, czy Unia dostatecznie wspiera europejskie podmioty w globalnej grze konkurencyjnej w sektorze technologicznym. Mam przekonanie, że to wsparcie nie jest wystarczające.

Wróćmy na koniec do Krakowa jako lokalnego hubu innowacyjności. Jaki powinien być za dziesięć lat, żeby można było uznać jego rozwój za duży sukces?

Chciałbym, żebyśmy za te symboliczne 10, może 15 lat mieli w Krakowie sto polskich firm technologicznych, specjalizujących się w tworzeniu własnego oprogramowania – platform czy aplikacji, a więc nie świadczących jedynie usług zewnętrznym zleceniodawcom. Takich, które działają na poziomie globalnym, a przynajmniej regionalnym, zatrudniając co najmniej 100 osób. Żeby jednak do tego doszło, potrzeba spełnienia szeregu czynników prawnych, gospodarczych, edukacyjnych, politycznych, jak też współpracy pomiędzy całymi sektorami gospodarki i poszczególnymi podmiotami. W tym przypadku nie ma łatwych i prostych rozwiązań.

Rozmawiał Tomasz Gołębiowski

CYBERBEZPIECZEŃSTWO W INSTYTUCJACH SAMORZĄDOWYCH

Samorządy mają trudności, aby nadążać za zmianami zachodzącymi w świecie cyberbezpieczeństwa. Na szczęście istnieją sposoby na poradzenie sobie przynajmniej z częścią przeszkód na drodze do innowacji.

Polskie samorządy przygotowują się, aby odeprzeć nasilającą się ofensywę hakerów, również tych ze Wschodu. Nie tak dawno Krzysztof Gawkowski, wicepremier i minister cyfryzacji, stwierdził, że mamy zimną wojnę w cyberprzestrzeni. Napastnicy, wśród których dużą aktywnością wykazują się groźne grupy APT, coraz częściej atakują Polskę. Ich działania są wymierzone nie tylko w świat biznesu, ale również w instytucje państwowe.

Nie bez przyczyny rząd chce dać jednostkom samorządowym do ręki narzędzia nowej generacji, umożliwiającą skuteczną walkę z grupami cyberprzestępczymi. W tym celu uruchomiono w ubiegłym roku rządowy program „Cyberbezpieczny Samorząd”, realizowany w partnerstwie z Państwowym Instytutem Badawczym

NASK. Na jednostki samorządu terytorialnego czeka 1,5 mld zł, z czego 1,2 mld zł na infrastrukturę sprzętową i oprogramowanie oraz wdrożenia, a 183 mln zł na opracowanie procedur, certyfikację, audyty i wdrażanie systemu zarządzania bezpieczeństwem informacji. Z kolei 105 mln zł ma być przeznaczone na szkolenie pracowników. Środki należy wykorzystać do końca czerwca 2026 r. W związku z tym decydenci mają dość dużo czasu, aby spokojnie przemyśleć ich alokację.

Małe gminy powinny tworzyć centra usług wspólnych.

Jedną z podstawowych czynności, poprzedzających wybór systemu bezpieczeństwa IT, jest zdefiniowanie zagrożeń. Nieraz słyszy się, że gangi ransomware, które sieją spustoszenie wśród użytkow-

Jerzy Trzepla, dyrektor działu produktów bezpieczeństwa w Exclusive Networks

ników biznesowych, nie wykazują większego zainteresowania samorządami. Po części jest to prawda, aczkolwiek działania cyberprzestępców nie ograniczają się wyłącznie do jednego rodzaju ataków. Poza tym samorządy wkroczyły w erę cyfrową, przy czym proces digitalizacji przebiega w różnym tempie. Inne wymagania w tym zakresie ma mała gmina wiejska, a inne duże miasto wojewódzkie. Co nie zmienia faktu, że jedni i drudzy muszą wdrażać systemy chroniące sieć, urządzenia końcowe czy dane.

– Wraz z nadejściem cyfryzacji zaczęły obowiązywać nowe zasady. Wszelkie przestoje infrastruktury IT, wywołane przez awarie lub cyberataki, nabrały większego znaczenia. O ile jeszcze kilka lat temu nie były one zbyt dokuczliwe, o tyle w obecnych czasach to norma. Ponadto na urzędniczych serwerach znajduje się wiele danych osobowych, łakomy kąsek dla hakerów – tłumaczy Jerzy Trzepla, dyrektor działu produktów bezpieczeństwa w Exclusive Networks.

Rzecz jasna, jednostki samorządów terytorialnych posiadają już rozwiązania chroniące ich infrastrukturę przed hakerami. Trudno byłoby znaleźć tego rodzaju instytucję bez narzędzi do backupu i odzyskiwania danych czy podstawowego oprogramowania antywirusowego. To jednak zaledwie podstawa dobrej

ochrony. Obecnie konieczne jest myślenie o „cyberbezpieczeństwie 2.0”. Zwłaszcza że dyrektywa NIS 2 dotyczy wszystkich podmiotów administracji publicznej, nie tylko tych prowadzących działalność w dziedzinach bezpieczeństwa narodowego, bezpieczeństwa publicznego, obronności lub egzekwowania prawa. Nakłada ona na jednostki samorządowe szereg ważnych wymagań dotyczących cyberbezpieczeństwa, takich jak zarządzanie ryzykiem, zgłaszanie poważnych incydentów związanych z cyberbezpieczeństwem czy audyty środowiska informatycznego.

Jednym z największych wyzwań na rynku cyberbezpieczeństwa jest brak wykwalifi kowanych fachowców. Z problemem tym borykają się nawet duże przedsiębiorstwa. W przypadku samorządów sytuacja jest wyjątkowa trudna, ze względu na mało konkurencyjne stawki płacowe. To szczególnie poważna przeszkoda podczas korzystania z zaawansowanych systemów, takich jak EDR, XDR czy SIEM. Te rozwiązania do identyfikacji zagrożeń mają zastosowanie między innymi w SOC-ach (Security Operations Center).

Zdaniem Jerzego Trzepli samorządy stoją przed wyborem jednej z dwóch dróg. Jedną z nich jest korzystanie z usług zarządzanych. W praktyce oznacza to wdrożenie rozwiązania Security Operations Center, zbierającego informacje z różnych systemów zabezpieczających i na tej podstawie wykrywającego incydenty. Niestety, to jest coś, co przerasta możliwości jednostki samorządu terytorialnego. Tym bardziej, że system musi działać w trybie 24/7, a do jego obsługi potrzeba co najmniej czterech osób. Dlatego w tym przypadku jedynym wyjściem

może być podpisanie umowy z operatorem bądź firmą zewnętrzną specjalizującą się w tego rodzaju usługach. Jednak w przypadku mniejszych gmin będzie to inwestycja nieadekwatna do realnych potrzeb.

Niemniej, istnieje również druga droga, polegająca na zrzeszaniu się kilku gmin, które tworzą centrum usług wspólnych. Co istotne, można w ten sposób świadczyć usługi na rzecz zarówno jednostek samorządu terytorialnego, jak i podległych im jednostek.

– Myślę, że jest to absolutnie do zrobienia. Właśnie w tę stronę powinny podążać zwłaszcza mniejsze gminy, które chcą zapewnić sobie bezpieczeństwo – podkreśla Jerzy Trzepla.

Samorządy na ogół nie mają kłopotów z doborem rozwiązań do ochrony sieci. Na rynku dostępna jest szeroka gama produktów, dopasowanych do różnego rodzaju potrzeb. W przypadku zamówień publicznych kluczową rolę odgrywa cena. Poza nią liczy się też powszechność zastosowania.

Samorządy w Polsce stoją przed wyborem jednej z dwóch

– Ta grupa klientów nie wybiera efemerycznych produktów. Duże znaczenie ma dla nich fakt, że kolega z sąsiedniego urzędu posiada takie samo rozwiązanie, ponieważ łatwiej wymieniać się informacjami na temat działania sprzętu czy oprogramowania. Kolejnym ważnym czynnikiem jest przyjazny interfejs użytkownika, a co za tym idzie, łatwość obsługi systemu – mówi Jerzy Trzepla. Jednostki samorządu terytorialnego wybierają zarówno urządzenia UTM, jak i firewalle. Oba produkty coraz bardziej się do siebie upodobniają, a o ich wyborze decydują przyzwyczajenia użytkowników oraz działania marketingowe producentów.

– Jeśli dokładnie przyjrzymy się funkcjom UTM-a oraz firewalla, okazuje się, że są do siebie bardzo zbliżone. Można powiedzieć, że 80 procent rozwiązań spełnia 80 procent wymagań 80 procentów klientów. Podobnie jest ze skutecznością wykrywania zagrożeń. Testy niezależnych instytucji badawczych pokazują, że różnice w wykrywalności wynoszą około 2 procent. Z punktu widzenia użytkownika końcowego nie ma to tak naprawdę znaczenia – dodaje Jerzy Trzepla. Rewolucji nie należy się spodziewać w segmencie produktów do ochrony danych. Jednostki samorządów terytorialnych stawiają na rozwiązania tradycyjne, a jedyne co się zmienia to ciągły przyrost danych. Urzędy zazwyczaj przechowują kopie zapasowe na serwerach NAS oraz bibliotekach taśmowych. Wiele wskazuje na to, że taśmy jeszcze dość długo pozostaną w urzędach ze względu na to, iż jest to najtańszy nośnik, a także stanowi solidne zabezpieczenie przed atakami ransomware. Dlatego bardzo ważne jest, aby systemy pamięci masowych, które pracują w jednostkach samorządowych, potrafiły je obsługiwać.

Warto na koniec podkreślić, że urzędy bardzo ostrożnie podchodzą do backupu online, preferując rozwiązania lokalne. Dzieje się tak z dwóch powodów: chęci posiadania produktów na własność, a także ewentualnych trudności związanych z odzyskiwaniem danych z chmury publicznej.

„Raportowanie ESG jest rewolucją w sprawozdawczości. Jak pokazuje doświadczenie, wprowadzane zmiany wymagają czasu, w trakcie którego wykształcą się dobre praktyki i standardy tworzenia i publikacji raportów ESG, w tym również samego procesu audytu” – mówi Andrzej Przybyło, prezes Grupy AB.

W mojej ocenie zbyt mało, w kontekście ESG, mówi się o idei circular economy. Czy ma ona szansę przebić się realnie do branżowego „mainstreamu”, biorąc pod uwagę, że producenci żyją ze sprzedaży nowych modeli, a nie odświeżania starych? Jakie modele finansowe mogą w tym przypadku pomóc w popularyzacji tego modelu biznesowego?

Andrzej Przybyło Idea gospodarki obiegu zamkniętego jest słuszna i już teraz na rynku są widoczne oferty produktów refabrykowanych, które na dobre wpisały się w obszar poszukiwań konsumentów. Zapewne w zakresie zainteresowania większości vendorów znajdują się rozwiązania, które pozwolą pogodzić te dwie, na pierwszy rzut oka rozbieżne, koncepcje strumieni przychodów, czyli rozwoju w oparciu o nowe produkty i realizacji biznesu w modelu circular economy. Niektórzy producenci już posiadają w ofercie portfolio z obiegu wtórnego. Przeważnie dotyczy to serii produktów biznesowych, które wykazują się najwyższą trwałością i na które jest

najwyższy popyt na rynku produktów, które nie są nowe.

Warto także dodać, że circular economy to nie tylko wtórny obieg i remarketing produktów. Producenci mocno angażują się w zmiany w projektowaniu urządzeń, aby zwiększyć ich naprawialność, zmniejszyć koszty naprawy i wydłużyć okres, w którym użytkowanie jest zasadne funkcjonalnie i ekonomicznie. Ekoprojektowanie, zwiększenie dostępności fizycznej i cenowej części zamiennych, uproszczenie i co za tym idzie, zmniejszenie kosztów serwisu, może bardziej wpłynąć na rynek circular economy niż same procesy związane z remarketingiem.

Circular economy to nie tylko wtórny obieg i remarketing produktów.

Jak widzicie rozwój, także w powyższym kontekście, modelu device-as-a-service?

W AB dostrzegamy, że ze względu na coraz szybsze zmiany technologiczne, rozwój AI i rozwiązań chmurowych, docelowo to właśnie używanie zamiast posiadania okazuje się często dużo bardziej zasadne. Dzieje się tak między innymi ze względu na potrzebę posiadania dostępu do urządzenia spełnia-

jącego aktualne wymagania technologiczne, a model DaaS umożliwia większą elastyczność w tym zakresie niż klasyczny leasing lub posiadanie z amortyzacją. Dlatego cały czas rozwijamy ofertę DaaS i wprowadzamy nowe rozwiązania w tym zakresie, tak aby zainteresowanie tego typu usługą stało się znaczącym trendem, co prognozują analitycy rynkowi. Oczywiście model DaaS, właściwie zaimplementowany, jak najbardziej wpisuje się również w założenia gospodarki o obiegu zamkniętym. Dzięki temu, że cały czas nabywamy doświadczenie w tym zakresie, widzimy, że zbudowanie odpowiedniej skali biznesu DaaS w sposób rentowny wiąże się z wieloma wyzwaniami, do których należy określenie wartości rezydualnej urządzenia w bardzo szybko zmieniającym się świecie, co obarczone jest ryzykiem. Co za tym idzie, trudno skonstruować ofertę w taki sposób, aby była konkurencyjna w stosunku do ofert samego finansowania, jak chociażby leasing. Zwiększanie elastyczności w zakresie umownego okresu użytkowania, bardziej liberalne podejście do rozumienia akceptowalnych śladów użytkowania, oferowanie ubezpieczeń i serwisu na wypadek uszkodzeń, zwiększa

grono potencjalnych klientów, ale zwiększa też ponoszone przez klientów koszty.

Wydaje się, że warto dokładnie przyjrzeć się regulacjom ESG w kontekście dystrybucji oraz kanału sprzedaży IT. Innymi słowy: stanowią zagrożenie czy szansę? Jeśli to pierwsze, to jak temu zaradzić, a jeśli to drugie, to jak ją wykorzystać?

Jak to z regulacjami bywa – stanowią jednocześnie szansę i zagrożenie dla rozwoju firmy, w zależności od jakości implementacji po stronie firm, jak i regulatora. Szansą jest budowanie zaufania klientów i partnerów biznesowych. Większa dostępność danych ESG może być wykorzystana do rozbudowy metodologii scoringów ESG i szerszego ich wykorzystania do ustalania kosztów i możliwości finansowania. Lepszy scoring ESG to także sygnał dla inwestorów o zmniejszonym ryzyku zaangażowania kapitałowego w dane przedsiębiorstwo, mniejszym ryzyku reputacyjnym i regulacyjnym. Przedsiębiorstwa mogą wykorzystać swoje projekty dekarbonizacyjne i zaangażowanie w ESG jako element marketingu i brandingu, promując swoje produkty i usługi jako bardziej zrównoważone.

Oczywiście stopień złożoności i czasochłonności raportowania może generować dodatkowe koszty związane z zaangażowaniem pracowników oraz koszty usług doradczych. Przekrój raportowania będzie oznaczać potencjalną konieczność posiadania narzędzi IT służących do zbierania danych, przygotowania do raportowania. Wyzwaniem jest również raportowanie śladu węglowego we wszystkich kategoriach zakresu trzeciego. Niewątpliwie ten obszar raportowania wymagać będzie współpracy stron zaangażowanych w proces wdrażania regulacji oraz jednostek zobowiązanych do okresowej publikacji raportów ESG, aby wartość informacyjna danych była jak najwyższa. Reasumując, raportowanie stanie się szansą, jeśli podejdziemy do niego z zaangażowaniem i z celem wykorzystania w doskonaleniu procesów biznesowych. Zagrożenia wynikające z regulacji zmitygujemy, zabezpieczając odpowiednie zasoby finansowe i osobowe na realizację obowiązku raportowego i projektów biznesowych realizujących cele i zadania ESG. Tak czy inaczej, raportowanie ESG jest rewolucją w sprawozdawczości. Jak pokazu-

je doświadczenie, wprowadzane zmiany wymagają czasu, w trakcie którego wykształcą się dobre praktyki i standardy tworzenia i publikacji raportów ESG, w tym również samego procesu audytu.

Pomówmy o rynku: poprzedni rok i pierwsza połowa tego rozczarowała – zwłaszcza w Polsce, która wcześniej była liderem i jasno świeciła na mapie Europy. Jakie są wasze oczekiwania na drugą – kalendarzową – połowę 2024? Mocno stąpamy po ziemi, lecz nie odbiegamy w naszych oczekiwaniach od większości analityków, którzy prognozują pozytywne odbicie na rynku w drugiej połowie tego roku. Jeśli chodzi o bazę do tych przewidywań, to podzieliłbym ją zasadniczo na dwa obszary – pierwszy jest związany z ogólnymi impulsami ekonomicznymi, regulacyjnymi i inwestycyjnymi, które nadchodzą w naszym kierunku. Do takich niewątpliwie należą fundusze z Krajowego Planu Odbudowy, które już w formie konkretnych i realnych programów powinny w trzecim i czwartym kwartale zacząć napływać na rynek, a w których znaczącym priorytetem jest akceleracja cyfrowej transformacji naszej gospodarki. W obszarze bezpieczeństwa IT mamy z kolei do czynienia z wymaganiami nałożonymi w dyrektywie NIS 2, która ma na celu poprawę odporności systemów IT na wszelkie zagrożenia, które szczególnie w obecnych niespokojnych czasach znacząco rosną. Liczymy również na kontynuację dużych programów publicznych wspierających informatyzację w edukacji, badaniach naukowych czy służbie zdrowia.

A ten drugi obszar?

ment związany z nowoczesną komunikacją bezprzewodową – sieci 5G, a także wchodzący na rynek nowy standard sieci bezprzewodowych WIFI 7. Przyspieszenie w rewolucji cyfrowej przynosi także trend związany z ograniczaniem negatywnego oddziaływania branży IT na środowisko naturalne, który wymusza budowę urządzeń bardziej efektywnych energetycznie czy złożonych z odzyskiwanych surowców. Dlatego z optymizmem patrzymy na nadchodzące okresy, w tym już na drugą połowę tego roku.

Zbudowanie odpowiedniej skali biznesu

DaaS w sposób rentowny wiąże się z wieloma wyzwaniami.

Nawiązując do wspomnianej już kwestii AI: jakie jest podejście AB do sztucznej inteligencji: czy waszym zdaniem to wciąż buzzword czy już „drugi cloud”, który dopiero się rozpędza? Można z całą pewnością stwierdzić, że AI jest traktowana jako „drugi cloud”, który dopiero nabiera tempa, a nawet więcej – ma potencjał stać się jednym z głównych kierunków rozwoju technologicznego i gospodarczego w Europie. A zmiany wywołane rozwojem AI dla Grupy AB mają zdecydowanie pozytywny kontekst. W obszarze zapotrzebowania na wyspecjalizowany i zoptymalizowany pod kątem użycia sztucznej inteligencji sprzęt, upowszechnianie się tej technologii powinno przynieść znaczące wzrosty popytu zarówno w segmencie klientów klasy enterprise, jak i w segmencie konsumenckim. Wśród rozwiązań enterprise już teraz uwidacznia się to, jak będzie rosła rola rozwiązań HPC (high-performance computing – red.) niezbędnych do przetwarzania złożonych algorytmów AI oraz masywnych zestawów danych wymaganych do trenowania sztucznej inteligencji.

Drugim obszarem czynników stymulujących wzrosty powinien być z kolei obszar technologii, gdzie również mamy wiele dynamicznie rosnących kategorii na czele ze sztuczną inteligencją wymagającą dużej i specjalizowanej mocy obliczeniowej. I tutaj dotykamy sektora data center, lecz również rozwiązań konsumenckich i biznesowych, takich jak szeroko już promowane AI-PC. Na pewno dynamicznie nadal będzie rozwijał się seg-

O tym, że podchodzimy do AI bardzo poważnie, niech świadczą również nasze działania wewnętrzne, bo AI chcemy w jeszcze większym stopniu wykorzystać przy optymalizacji operacji wewnątrz organizacji, a co za tym idzie przygotować jeszcze lepszą ofertę związaną z łańcuchem dostaw, logistyką, obsługą klienta i analizą danych.

Rozmawiał Tomasz Gołębiowski

Chociaż działania największych dostawców usług chmurowych budzą mieszane uczucia, to liczba ich klientów rośnie w dość szybkim tempie.

n Wojciech Urbanek

Termin hiperskaler po raz pierwszy pojawił się w latach 90. podczas boomu dotcomów. W tym czasie odnosił się on do centrów danych, których architektura musiała się skalować, aby spełniać rosnące wymagania systemów IT. Potem na dłuższy czas termin ten został zapomniany, ale w ostatnich latach wrócił ze zdwojoną siłą. Obecnie pojęcie to odnosi się do największych dostawców usług chmurowych: AWS-u, Microsoftu, Google’a, a czasami również IBM-u czy Alibaby.

Pierwsza trójka wymienionych graczy praktycznie na nowo zdefi niowała internet, a rosnąca konsumpcja usług chmurowych sprawiła, że centra danych zaczęły rozrastać się do monstrualnych wręcz rozmiarów. Współcześni hiperskalerzy mają zdolności obsługi niewyobrażalnych wręcz ilości danych, mocy obliczeniowych oraz zasobów sieciowych, dążąc do dalszego, szybkiego rozszerzania infrastruktury, aby zaspokoić rosnący popyt. Według analityków International Date Council hiperskalowalne centrum danych powinno składać się z co najmniej 5 tys.

serwerów i zajmować powierzchnię nie mniejszą niż 920 metrów kwadratowych. Wprawdzie nie ma prostych wytycznych dotyczących zużycia energii, aczkolwiek praktyka dowodzi, że większość hiperskalowych centrów danych zużywa od 100 megawatów (MW) do 300 MW. Analitycy Synergy Research Group szacują, że obecnie na całym świecie działa ponad tysiąc takich obiektów.

Na dłuższy czas termin „hiperskaler” został zapomniany. Teraz wrócił ze zdwojoną siłą.

Stworzenie hiperskalowalnego centrum danych od podstaw to przedsięwzięcie poważne, wymagające nie tylko głębokiej kieszeni i znacznego wysiłku. Na liście wytycznych można znaleźć wiele ciekawych pozycji, takich jak wymagania wobec używanego sprzętu przeciwpożarowego i radzenia sobie z obsługą ogromnych obciążeń elektrycznych. Do potrzeb wliczyć należy parking przeznaczony nie tylko do obsługi samochodów używanych przez operatorów centrów danych, ale również dla wszelkich pojazdów ratunkowych. Do tego dochodzą jeszcze kosztowne umowy, które trzeba podpisać z lokalnymi rządami oraz społecznościami.

Według badania przeprowadzonego przez Synergy Research Group hiperskalowe centra danych mają już 37 proc. udziału w całym rynku pod względem pojemności, co bardzo dobrze ilustruje wpływ przetwarzania w chmurze na inwestycje w infrastrukturę. Kolejne 23 proc. należy do dużych operatorów oferujących kolokację, a pozostałe 40 proc. do lokalnych centrów danych. Warto odnotować, że te ostatnie miały pięć lat temu znacznie większy udział w rynku (sięgał wówczas blisko 60 proc.). Na razie nic nie wskazuje na to, że obecny trend zostanie zatrzymany. Lawinowy przyrost danych, ostatnio głównie napędzany przez boom na sztuczną inteligencję, napędza inwestycje hiperkalerów w centra danych. Analitycy Gartnera wierzą, że w tym roku „hiperskalerzy i inni dostawcy usług będą stanowić 76 proc. jednostek serwerów AI”.

Wystarczy wspomnieć, że AWS w tym roku wyłożył 10 mld dol. na budowę dwóch kompleksów centrów danych w Mississippi. Poza tym rozrastają się istniejące centra danych AWS-u wraz z planami utworzenia 12 kolejnych stref dostępności i czterech kolejnych regionów tego dostawcy w Niemczech, Malezji, Nowej Zelandii i Tajlandii. Z kolei Microsoft

zobowiązał się zainwestować 3,2 mld euro (3,4 mld dol.) w podwojenie swojej infrastruktury sztucznej inteligencji i wydajności przetwarzania w chmurze w Niemczech. Ta ekspansja skoncentruje się na istniejącym regionie chmur we Frankfurcie i nowo planowanej infrastrukturze w Nadrenii Północnej Westfalii.

Mniejsze serwerownie w odwrocie

Synergy Research Group przewiduje, że w ciągu najbliższych pięciu lat udział hiperskalerów w pojemności wszystkich centrów danych przekroczy 50 proc., podczas gdy udział lokalnych obiektów skurczy się do mniej niż 30 proc., zaś reszta ma należeć dla kolokacji. To pokazuje, że mniejsze serwerownie nie znikną, natomiast ich znaczenie będzie powoli spadać. Niewiele za to zmieni się w zakresie kolokacji, w przypadku której analitycy spodziewają się stabilnego udziału w rynku, bez wyraźnych wzrostów, ale również spadków. Rozwój wypadków w segmencie centrów danych ma znaczący wpływ na rynek serwerów oraz pamięci masowych. Kilka lat temu po konsolidacji w segmencie serwerów i pamięci masowych martwiono się, że pozostało na nim jedynie pięciu sprzedawców. Obecnie pół żartem, pół serio mawia się, że będą oni dostarczać produkty tylko do pięciu nabywców. Wprawdzie

Najwięcej emocji wzbudzają koszty.

Mikołaj Wiśniak, wiceprezes, IT Solution Factor

ten żart nie oddaje do końca realnego stanu, ale też tak bardzo od niego nie odbiega. Według IDC w 2023 r. wszyscy dostawcy usług zakupili serwery i pamięci masowe o łącznej wartości 94,5 mld dol., co dało im 56,4 proc. udział w tym rynku. Natomiast według prognoz IDC na koniec 2028 r. wydatki na ten cel osiągną poziom 188,5 mld dol., dając tej prestiżowej grupie udziały na poziomie 69,7 proc. Natomiast przedsiębiorstwa, rządy oraz instytucje akademickie wydały w 2023 r. 73,1 mld dol. (43,6 proc.). Ich wydatki na ten sprzęt będą rosnąć i w 2028 r. mają wynieść 82 mld dol. (30,3 proc.).

Ucieczka z chmury

Oferta hiperskalerów zawierająca bardzo szeroką gamę usług chmurowych, począwszy od mocy obliczeniowej, poprzez bazy danych, narzędzia analityczne, aplikacje biurowe, aż po powierzchnie do przechowywania danych, znajduje wielu zwolenników. Powszechnie znane są też zalety usług chmurowych, takie jak niemal nieograniczona skalowalność w górę i w dół czy brak ponoszenia przez klienta kosztów początkowych. Jednak w tym monolicie pojawiają się też rysy. Wiązanie się z jednym dostawcą może ograniczyć zdolność firmy do innowacji i rozwoju. Poza tym hiperskalerzy często dostarczają standardowe rozwiązania, które trudno dopasować do specyficznych wymagań pojedynczych firm. Przy czym najwięcej

Alternatywą dla usług chmurowych jest kolokacja. W tym przypadku klient jest właścicielem sprzętu, co oznacza, że może zapewnić sobie kompatybilność oprogramowania i infrastruktury, jak też pełną kontrolę fizyczną i logiczną dostępu do tych rozwiązań – nie ma tu zewnętrznych dostawców. Innym aspektem jest na pewno cena, ponieważ przy kolokacji płacimy za zewnętrzną serwerownię, zaś usługami uruchomienia, skalowania czy utrzymania zajmujemy się we własnym zakresie. Pomimo rosnących presji płacowych, cała część związana z kosztami OPEX leży po stronie klienta. Hiperskalerzy w ramach jednej ceny dostarczają wszystko, więc w przypadku takich rozwiązań wskaźnik TCO jest stosunkowo bardziej korzystny dla użytkownika. Ważna jest też możliwość połączenia między ośrodkami, bo decydując się na kolokację możemy zamówić specjalnie przeznaczony do tego światłowód.

emocji wzbudzają koszty. Hiperskalerzy pobierają dodatkowe opłaty za różnego rodzaju dodatkowe usługi, które po zsumowaniu mogą przyprawić o zawrót głowy dyrektorów finansowych, zwłaszcza w mniejszych i średnich fi rmach, które mają wysokie wymagania w zakresie mocy obliczeniowej bądź przestrzeni dyskowej.

Trzy lata temu szerokim echem odbił się artykuł dwóch ekspertów Andreessen Horowitz. Sarah Wang i Martin Casado w publikacji „The Cost of Cloud, a Trillion Dollar Paradox” pokazali na konkretnych przypadkach, że chmura publiczna może być pułapką. W tym kontekście chyba najgłośniejszy jest przykład Dropboxa, który dość długo był uzależniony od Amazon Web Services. W 2016 r. przedsiębiorstwo podjęło decyzję o wybudowaniu własnej infrastruktury, a głównym powodem rozstania z gigantem był model wysokich cen bazujących na zużyciu za godzinę. Akhila Gupta, wiceprezes ds. inżynierii infrastruktury Dropbox, oszacował, że ten

ruch pozwolił mu zaoszczędzić niemal 75 mln dol. w ciągu dwóch lat.