Rozwiązania IT

ISSN 1640-9183 Czerwiec 2023 WYDANIE SPECJALNE DLA MIKROFIRM ORAZ MŚP LAT VADEMECUM

CRN Polska

od 25 lat wspiera rozwój

kanału sprzedaży i całego

Vademecum

VAR-ów i integratorów

od 10 lat szerzy wiedzę na temat zaawansowanych produktów i usług IT!

n jedyny opiniotwórczy miesięcznik dla polskiego kanału sprzedaży IT

n najchętniej odwiedzany portal dla resellerów, VAR-ów i integratorów IT

n najwięcej bezpośrednich relacji z wydarzeń branżowych w Polsce i zagranicą

najbardziej kompleksowe źródło informacji o technologiach

n najszerszy przegląd marek dostępnych na polskim rynku

n czołowa platforma wypowiedzi dla ekspertów i menadżerów

IT n BIZNES n TRENDY n TECHNOLOGIE

wszystkim, którzy towarzyszą nam w rozwoju polskiego rynku IT!

Dziękujemy

LAT CRN POLSKA LAT VADEMECUM

Cyfrowy obieg wielu szans i możliwości Zarządzanie przetwarzaniem dokumentów to dzisiaj rozległy obszar funkcjonowania wielu różnych działań, procesów, narzędzi i rozwiązań.

Sieci: szybkie, bezpieczne i zawsze dostępne Postępująca cyfryzacja sprawia, że rosną wymagania wobec firmowych sieci.

Chmura sprzyja integratorom Korzystanie z wielochmurowych i hybrydowych środowisk rodzi wiele wyzwań i problemów, z którymi muszą sobie poradzić ich użytkownicy.

Hakerzy kontra MŚP: długi i nierówny bój Mniejsze firmy, tak samo jak korporacje, są coraz bardziej nękane przez hakerów.

2/2023 22

3 VADEMECUM CRN czerwiec 2023

Z... 6 INFRASTRUKTURA SIECIOWA 10 13 14 15 PRZETWARZANIE I PRZECHOWYWANIE DANYCH 16 19 20 21 DRUKOWANIE, SKANOWANIE 22 26 28 ZASILANIE AWARYJNE 30 35 OCHRONA SYSTEMÓW INFORMATYCZNYCH 36 40

PRYWATNE, PUBLICZNE, HYBRYDOWE 42 46 42 36

ROZMOWA

CHMURY

10

LAT VADEMECUM

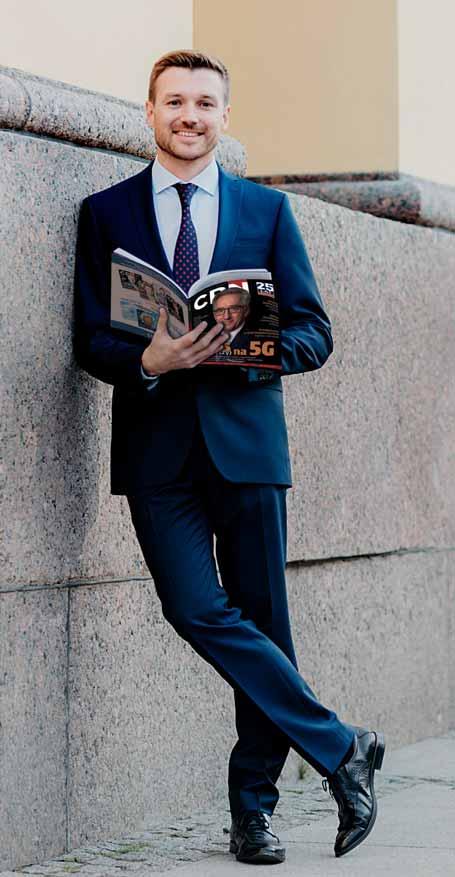

Mamy 10 lat!

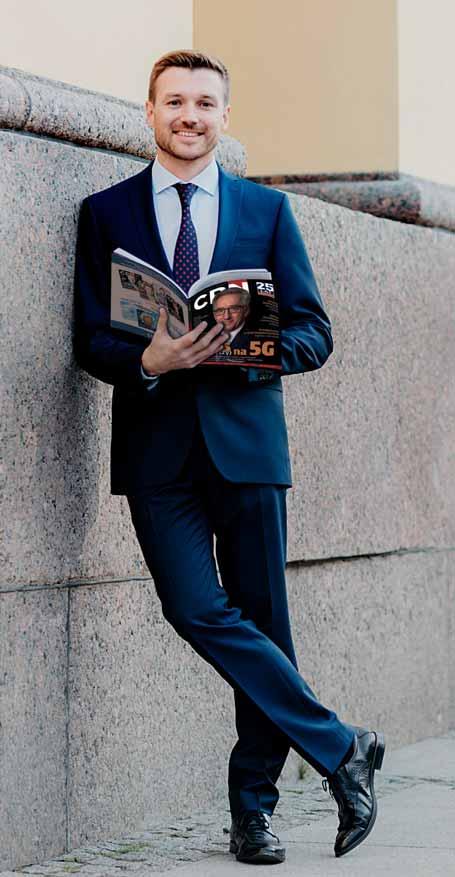

Pierwsze wydanie „Vademecum VAR-ów i integratorów” ukazało się w maju 2013 r. Pół roku wcześniej spotkaliśmy się z Tomkiem Gołębiowskim, redaktorem naczelnym CRN Polska oraz Jackiem Goszczyckim, który dziś jest prezesem zarządu naszego wydawnictwa. Dyskutowaliśmy o formule pisma i zakładaliśmy, że będzie to coś w rodzaju eksperymentu i za sukces uznamy wydanie dwóch lub trzech numerów. Były to bowiem czasy, gdy papierowe pisma padały jak muchy, a tu nagle ktoś wpada na pomysł… założenia nowego. Perspektywa utrzymania się takiego pisma na rynku przez dekadę wydawała się nam wtedy niewyobrażalna. Działy marketingu wszystkich liczących się dostawców rozwiązań IT miały wówczas na tapecie tylko jedno słowo: chmura. Hasło to jednak budziło mieszane uczucia. Resellerzy brutalnie doświadczali spłaszczania kanału dystrybucyjnego i otwartym tekstem wyrażali obawy o swoje istnienie już w nieodległej przyszłości. Użytkownicy zaś uczyli się szacować korzyści płynące z nowego modelu przetwarzania danych, bo wydawało się (i jest tak do dziś), że wśród nich aspekt finansowy wcale nie jest dominujący. W takich realiach, gdy istniało realne ryzyko zniknięcia grupy docelowej, do której chcieliśmy kierować nasz kwartalnik, trudno było zakładać długofalowe powodzenie tego projektu.

Jednak sukces komercyjny, jak i pozytywne opinie Czytelników (potwierdzone w badaniach focusowych), przerosły nasze oczekiwania. W artykułach sponsorowanych, przy których naszym priorytetem jest, aby niosły ze sobą jak największą wartość merytoryczną, przez tych 10 lat reprezentowanych było ponad 300 marek producentów, dystrybutorów i usługodawców. Swojego głosu w postaci wypowiedzi i udzielonych wywiadów użyczali globalni prezesi i wiceprezesi firm, przedstawiciele polskich oddziałów, jak też resellerzy i integratorzy. Ciekawostka: w jednym z wydań Vademecum wypowiadała się pewna pani, która kilkanaście

miesięcy później trafiła na okładkę… polskiej edycji Playboya! Zainteresowanych poznaniem jej personaliów odsyłam do lektury archiwalnych numerów.

Tematów też nam nie brakowało. Gdy zaczynaliśmy, wciąż trwał proces informatyzacji placówek z wielu branż, z naciskiem na sektor publiczny i ochronę zdrowia. Później przyszło RODO, a następnie koronawirus, który zrobił więcej dla cyfrowej transformacji na świecie niż wszystkie wspomniane już działy marketingu największych dostawców IT razem wzięte. Ostatni rok to agresja Rosji na Ukrainę i związane z tym perturbacje na rynku. Na to wszystko, przynajmniej przez ostatnich 5 lat, nakłada się sztuczna inteligencja. A chmura? No cóż, dojrzała, stając się nośnikiem wielu narzędzi informatycznych.

Na koniec chciałbym złożyć trochę podziękowań. Jackowi Goszczyckiemu i Tomkowi Gołębiowskiemu, że uwierzyli w mój pomysł na magazyn o charakterze edukacyjnym i nieustannie wspierali przy jego realizacji. Autorom artykułów – Andrzejowi Gontarzowi, Tomkowi Janosiowi i Wojtkowi Urbankowi – za trud odkrywania tajników i zakamarków rynku oraz przedstawianie ich Czytelnikom. Karolinie Marszałek (sekretarz redakcji) i Tomkowi Baziukowi (DTP) za cierpliwość i dbałość o to, że Vademecum wygląda jak produkt klasy premium. Agacie Myśluk, że wspólnie z Jackiem Goszczyckim dba o ciągłość naszych przychodów i komercyjny sukces.

Słowa uznania chciałbym też złożyć na ręce osób, które w międzyczasie wybrały inną ścieżkę kariery zawodowej. Dorocie Smusz, która przez 7 lat pełniła rolę sekretarza redakcji, Anecie Mikulskiej, która od początku dbała o nienaganny wygląd magazynu, a wreszcie współpracującym wcześniej z nami autorom: Rafałowi Janusowi, Darkowi Hałasowi oraz Tomkowi Kozłowskiemu. Ukłony!

KRZYSZTOF JAKUBIK

EDYTORIAL

4 VADEMECUM CRN czerwiec 2023

Fot. Adrian Stykowski

To miał być eksperyment.

Słyszałeś?

Co miesiąc na kanale CRN Polska (YouTube) nowa audycja Tech Trendy Biznes!

i słuchaj audycji Tech Trendy Biznes na YouTube, Spotify i Apple Podcasts!

IT n BIZNES n TRENDY n TECHNOLOGIE

Subskrybuj

CRN Analitycy rynku IT od kilku lat podkreślają, że wymagania małych i dużych klientów, dotyczące nabywanych przez nich rozwiązań, zbliżają się do siebie. W jakim zakresie widać zbieżność tych oczekiwań?

JIA-YU LIU Małe i średnie firmy mają różne rodzaje cyfrowej tożsamości i inne priorytety niż duże przedsiębiorstwa. Dla MŚP, w związku z tym, że często mają ograniczone zasoby IT i budżetowe, najważniejsze są te rozwiązania, które są łatwe we wdrożeniu, integracji z posiadaną infrastrukturą, zarządzaniu oraz użyciu, a także przystępne cenowo i otwarte. Ale jednocześnie takie, które przyniosą firmie wartość niemalże od razu po wyjęciu z pudełka. Natomiast klienci korporacyjni zazwyczaj wymagają usług bardziej złożonych i dostosowanych do ich potrzeb, a więc o dużej mocy obliczeniowej i większej skalowalności. Tak czy inaczej, dla wszystkich najważniejszym kryterium stała się niezawodność rozwiązań IT, po-

AI zdominuje branżę IT…

ale jeszcze nie teraz

„Dzięki sztucznej inteligencji można zaobserwować nieoczywiste trendy, przeanalizować olbrzymie zbiory informacji i spróbować wyciągnąć z nich wnioski. Jednak podejmowanie eksperckiej decyzji nadal powinno leżeć w gestii człowieka”

– Jia-Yu Liu, wiceprezes i dyrektor działu backupu w Synology.

nieważ przyczynia się do zapewnienia ciągłości biznesowej i minimalizuje ryzyko przestoju. Coraz bardziej, także przez mniejszych klientów, doceniane są również funkcje łączenia systemów w klastry wysokiej dostępności.

W przypadku mniejszych rozwiązań kwestia wysokiej dostępności stanowi ciekawe zagadnienie. U największych dostawców takie systemy kosztują fortunę. Tymczasem tacy dostawcy serwerów NAS jak Synology czy konkurencja oferują je za ułamek ceny. Jak to możliwe? W tym kontekście warto zwrócić uwagę na kilka aspektów. Przede wszystkim inna jest grupa docelowa. Duzi dostawcy obsługują największych klientów, my zaś skupiamy się na małych i śred-

nich firmach. U tych dużych klientów minuta przestoju oznacza straty idące w tysiące dolarów, dlatego przeznaczone dla nich, łączone w klastry rozwiązania IT, są tworzone tak, aby gwarantować wysoką dostępność na poziomie rzędu 99,999 proc. czasu pracy, co oznacza ryzyko przestoju przez kilka minut w skali roku. W przypadku naszych klientów takich oczekiwań nie ma. Bez problemu akceptują oni fakt, że zagwarantujemy dostępność klastra na poziomie, powiedzmy, 95 proc., ale za cenę niższą o kilka rzędów wielkości.

Kilka lat temu

podjęliśmy decyzję, że z chmurą nie należy walczyć, ale

raczej potraktować

ją jako szansę.

Z czego wynika tak wysoka cena u dużych dostawców?

Z większych kosztów produkcji, ale też ogromnego wysiłku wkładanego w przetestowanie całego środowiska, przyznanie odpowiednich

6 VADEMECUM CRN czerwiec 2023

certyfikatów dostawcom poszczególnych komponentów, jak nośniki czy karty sieciowe, a następnie objęcie całości wsparciem technicznym. To zresztą wprowadza sporo ograniczeń co do późniejszej rozbudowy. Nasza filozofia jest inna, klient ma znacznie większą elastyczność i łatwość samodzielnego doboru komponentów środowiska czy nośników do serwera NAS, ale to w dużym stopniu zdejmuje z nas odpowiedzialność za stuprocentowe zagwarantowanie kompatybilności. Klienci jednak decydują się na to ze względu na wspomniane już aspekty finansowe. Doceniają też łatwość i intuicyjność obsługi takich rozwiązań, o której trudno mówić w przypadku większych dostawców.

Przy takiej strategii tworzenia jak najprostszych produktów istnieje jednak ryzyko, że klienci rzadziej będą korzystali z usług partnerów…

Tak naprawdę obserwujemy odwrotną sytuację. Mimo wszystko, potrzeba pew-

nego doświadczenia w wyborze właściwego produktu, który będzie odpowiadał zarówno obecnym, jak i przyszłym potrzebom klientów. Następnie trzeba ich przekonać, aby jako nośników nie używali dowolnych, niepotrzebnych dysków, które administrator znajdzie w szufladzie, ale kupili specjalne nośniki przeznaczone do macierzy dyskowych, przystosowane do ciągłej pracy. Potem przychodzi moment na uruchamianie poszczególnych usług i integracja z już funkcjonującymi systemami w przedsiębiorstwie – w tym zakresie także przydatne jest doradztwo partnerów, którzy z pewnością mają większe doświadczenie w projektowaniu systemów backupu czy zabezpieczaniu środowisk. Finalnie, mogą oni sprawować nadzór nad wdrożonym urządzeniem – albo na stałe, albo w zastępstwie administratora IT, gdy ten na przykład pójdzie na urlop lub zachoruje. Podsumowując, na całym świecie widzimy coraz większe zaangażowanie fi rm partnerskich

jako zaufanych doradców w cały proces sprzedaży, wdrażania i obsługi naszych produktów.

Jeśli chodzi o kwestie dotyczące wsparcia, coraz więcej firm chwali się wbudowanymi w sprzęt IT zautomatyzowanymi mechanizmami bazującymi na sztucznej inteligencji. Czy i w jaki sposób mogą one sprawdzić się także w rozwiązaniach dla małych i średnich przedsiębiorstw?

Sztuczna inteligencja i uczenie maszynowe to modny temat, do czego niewątpliwie przyczynił się sukces usługi ChatGPT, bo dzięki niej wiele osób samodzielnie mogło się przekonać o sile tej technologii. Ale też każdy z nas, kto próbował bawić się tym narzędziem, zauważył, że jego precyzja działania i poprawność generowanych odpowiedzi nadal budzi wątpliwości. Jest ono przydatne w celu uzyskania inspiracji, pewnych innych niż oczywiste punktów widzenia na dane zagadnie-

Fot. archiwum

7 VADEMECUM CRN czerwiec 2023

nie… Niemniej wyniki jego pracy nie powinny być traktowane jako „gotowiec”. To samo dotyczy zastosowania sztucznej inteligencji w rozwiązaniach IT. Dzięki niej można zaobserwować nieoczywiste trendy, przeanalizować olbrzymie zbiory informacji i spróbować wyciągnąć z nich wnioski. Ale podejmowanie eksperckiej decyzji nadal powinno leżeć w gestii człowieka, chociaż oczywiście to może ulec zmianie w przyszłości.

Ale czy korzystacie we własnych produktach z mechanizmów sztucznej inteligencji?

Tak, wykorzystujemy głębokie uczenie w naszych narzędziach do monitoringu wideo, aby poprawić dokładność rozpoznawania wzorców, na przykład osób czy pojazdów, szczególnie w trudnych warunkach oświetleniowych. W tej dziedzinie sztuczna inteligencja sprawdza się bardzo dobrze, mimo że nie jest jeszcze w stu procentach dokładna, ale i tak robi to lepiej niż każdy człowiek. Oczywiście będziemy śledzić rozwój dojrzałości tych mechanizmów i analizować możliwość zastosowania ich w innych obszarach, chociażby dotyczących zarządzania danymi czy procesem backupu. Najważniejsze jest jednak to, aby przyniosły one konkretną korzyść użytkownikowi, a nie stały się kolejną modną aplikacją, bowiem ich obsługa kosztuje olbrzymią ilość mocy obliczeniowej.

Sztuczna inteligencja

trafiła pod strzechy dzięki chmurze, której zasoby obliczeniowe i przestrzeń dyskowa były jednak przez pewien czas wskazywane jako konkurencja dla serwerów NAS i innych rozwiązań dla małych i średnich firm. Synology i inni producenci postanowili jednak stworzyć pewien ekosystem i dzięki niemu korzystać z dobrodziejstw chmury. Jakie jest obecnie wasze podejście do tego zagadnienia?

walczyć, ale raczej potraktować ją jako szansę i skorzystać z oferowanych przez ten model możliwości. Stworzyliśmy wręcz kilka natywnych usług chmurowych, które mogą być powiązanie z naszymi rozwiązaniami wdrażanymi w siedzibie firmy, ale nie muszą. W ten sposób powstało funkcjonalne rozszerzenie możliwości systemu backupu oraz przywracania środowisk do pracy po awarii, działające jako hybryda pomiędzy chmurą i serwerami naszej produkcji. Tworzenie takich ekosystemów połączonych ze sobą rozwiązań jest moim zdaniem nieuniknione, bo oczekują tego klienci – w ten sposób uzyskują dodatkową wartość ze swojej inwestycji. Wystarczy spojrzeć, jakie korzyści z takiego modelu czerpią Apple, Microsoft czy Google. Skupienie się na pojedynczym produkcie niemal natychmiast przyczynia się do konkurowania na cenę, a nie oferowane klientowi wartości.

Nad czym zatem obecnie pracujecie w ramach budowania ekosystemu swoich produktów?

Oczywiście dostrzegamy zainteresowanie tymi produktami i – tu być może zaskoczę czytelników – nasz system operacyjny DSM też jest dostępny w modelu open source, jeśli ktoś jest zainteresowany, aby w ten sposób poznać jego funkcjonalność. Zawsze jednak podkreślamy, że to nie jest metoda na zapewnienie w firmie wysokiej dostępności danych i niezawodności całego rozwiązania, ponieważ tego typu oprogramowanie nie jest wspierane w takiej skali jak komercyjne produkty. Niemniej, jesteśmy zadowoleni, że wzbudza ono zainteresowanie – korzystający z takiego rozwiązania administrator, gdy nabierze odpowiedniego doświadczenia, lepiej zrozumie wartość dla klienta płynącą z naszych produktów i całego ekosystemu.

Jak ta sprawa wygląda pod kątem bezpieczeństwa? Już od kilku lat serwery NAS znajdują się pod ciągłym ostrzałem ataków ransomware…

W ramach programu bug

Stawiamy na szeroko pojętą skalowalność rozwiązań pamięci masowych, jak też rozszerzenie systemów backupu i uczynienie ich jeszcze bardziej profesjonalnymi – w tym celu opracowywany jest zupełnie nowy system operacyjny dla naszych urządzeń. Jego zadaniem będzie stworzenie scentralizowanego, łatwego w użyciu systemu tworzenia kopii zapasowych, którego końcówki można wdrożyć w wielu lokalizacjach, elastycznego pod kątem wydajności i różnego typu wymagań instalacyjnych.

bounty regularnie zapraszamy do współpracy etycznych

hakerów i zewnętrznych

badaczy zagrożeń.

Rzeczywiście, już kilka lat temu podjęliśmy decyzję, że z chmurą nie należy

Jako konkurencja dla serwerów NAS – obok chmury – czasami przez przyszłych użytkowników wybierane są darmowe, bazujące na otwartym źródle systemy instalowane na uniwersalnych mikroserwerach. Czy obecność tego typu produktów stanowi jakieś zagrożenie dla waszej sprzedaży?

Dla nas bezpieczeństwo jest absolutnie priorytetowe. Mamy specjalny zespół odpowiedzialny za wykrywanie ewentualnych zagrożeń, analizowanie ich i reagowanie, gdy zajdzie taka potrzeba. W ramach programu bug bounty regularnie zapraszamy do współpracy także etycznych hakerów i zewnętrznych badaczy zagrożeń. Nasz zespół zobowiązał się do wydawania poprawek dla krytycznych, wykrytych przez nas błędów w ciągu 60 dni, natomiast jeśli pojawiło się zagrożenie zero-day – wówczas w ciągu jednego dnia. Natomiast w przypadku innych projektów open source sprawa jest dyskusyjna. Z jednej strony panuje powszechna opinia, że otwartość kodu powoduje, iż społeczność dokonuje jego ciągłej analizy, także pod kątem bezpieczeństwa. Niestety, takiej analizy dokonują też cyberprzestępcy i tu rodzi się pytanie kto dysponuje większą siłą. W naszym przypadku jest gwarancja, że dysponujemy przeciwwagą dla hakerów w odpowiednim i skutecznym stopniu.

A jak wygląda proces zabezpieczania aplikacji firm trzecich, które można zainstalować w waszych serwerach?

W tej kwestii mamy dwie silne reguły. Po pierwsze, zastrzegamy sobie prawo do

NA TEMAT

8 VADEMECUM CRN czerwiec 2023

bardzo rygorystycznego weryfikowania działania tych aplikacji pod względem bezpieczeństwa. Zdarzało nam się odmawiać, gdy mieliśmy chociażby minimalne podejrzenia. Po drugie zaś, wymuszamy, aby aplikacje te działały z uprawnieniami normalnego użytkownika, a nie administratora. To w dużym stopniu eliminuje ryzyko, że właśnie poprzez taką aplikację cyberprzestępca przeniknie do danych użytkownika.

WHO odwołało właśnie stan zagrożenia pandemią – jaki wpływ na wasze działania odcisnęły te ostatnie trzy lata?

JIA-YU LIU

jest doświadczonym profesjonalistą w dziedzinie informatyki, posiadającym tytuł magistra w tej dziedzinie. W Synology pracuje od 15 lat. W swojej karierze pełnił funkcje kierownicze w różnych obszarach, związanych z aplikacjami mobilnymi, rozwiązaniami do tworzenia kopii zapasowych i synchronizacji plików dla serwerów NAS oraz usługami chmurowymi Synology C2.

Pozytywne aspekty były takie, że wzrosło zainteresowanie naszymi rozwiązaniami. W ciągu ostatnich dwóch lat, jak też w pierwszym kwartale tego roku, osiągnęliśmy rekordowe wzrosty przychodów. Zwiększone zapotrzebowanie widzieliśmy ze strony wszystkich klientów, interesowali się przede wszystkim modelami na 4 i 8 dysków, a także sprzętem do montażu w szafach rack. Powszechne stało się wykonywanie backupu z komputerów zdalnych pracowników. Transformacja cyfrowa, zarówno w zakresie rozwiązań on premise, jak też chmury, zdecydowanie przyspieszyła na całym świecie i to jest dobra wiadomość dla rynku, także dla kanału partnerskiego.

Czy zaobserwowaliście też jakieś niekorzystne zjawiska?

Niestety tak. O jednym już rozmawialiśmy – to bardzo wyraźnie zauważalny wzrost liczby ataków ransomware, które zagrażają zarówno samym serwerom NAS, jak też komputerom użytkowników, z których dane backupowane są na te serwery NAS. To jest obecnie największe wyzwanie, dlatego zintensyfikowaliśmy działania w obszarze usprawnienia procesów wykonywania backupu. W czasie pandemii oczywiście odnotowaliśmy również niedobór chipów, który między innymi spowodował opóźnienie premiery nowych modeli. Przez pewien czas były też problemy związane z wysyłką produktów,

ale obecnie zostały już rozwiązane. Generalnie ratuje nas to, że wszystkie nasze produkty są rozwijane i produkowane w jednym kraju – na Tajwanie. Na szczęście pandemia nie doświadczyła nas zbytnio, dlatego udało się zachować wewnętrzną integralność firmy.

Podsumowując, jak sytuacja związana z rynkiem rozwiązań IT dla małych i średnich firm będzie wyglądała w przyszłości? Kiedyś prognozowano, że rewolucją na miarę pojawienia się internetu będzie chmura. Ale tak się nie stało, chmura po prostu okazała się jednym z przydatnych narzędzi. Czy teraz za takiego „konia pociągowego” będzie można uznać sztuczną inteligencję, czy też na horyzoncie widać jakąś inną technologię?

Zdecydowanie najwięcej uwagi w najbliższych latach będzie przyciągała sztuczna inteligencja – nie tylko ze względu na oferowane możliwości, ale też aspekty prawne, bo pojawiło się już wiele wątpliwości dotyczących etycznych kwestii jej zastosowania. Natomiast co do dalszego horyzontu czasowego, to trudno jest prze-

widywać, ale nie spodziewam się rewolucji. Zresztą przywoływany już ChatGPT też stanowi rewolucję tylko w kwestii przyjmowania zapytań od użytkowników i udzielania odpowiedzi, a działający „pod spodem” mechanizm już był znany od pewnego czasu. Myślę, że ta ewolucja będzie ściśle powiązana z kwestiami, które będą przynosić dodatkową wartość klientom, ponieważ na wymyślanie niesłużących nikomu rozwiązań szkoda obecnie czasu. Z pewnością rozwijana będzie chmura, ale ten rozwój też będzie następował przez pryzmat korzyści klientów. W przypadku naszych rozwiązań największy potencjał chmury widzę w kwestii backupu danych, ich długotrwałej archiwizacji oraz przygotowywania środowisk na sytuacje awaryjne. We wszystkich pozostałych scenariuszach klienci nadal potrzebują szybszego niż oferuje chmura dostępu do danych. Natomiast wśród potencjalnych wyzwań można wciąż wymienić ryzyko niedoboru komponentów, ale doświadczeni ostatnimi zakłóceniami jesteśmy na to coraz lepiej przygotowani.

Rozmawiał Krzysztof Jakubik

9 VADEMECUM CRN czerwiec 2023

Klienci, także ci mniejsi, coraz bardziej doceniają funkcje

łączenia rozwiązań w klastry wysokiej dostępności.

Sieci:

szybkie, bezpieczne i zawsze dostępne

Postępująca cyfryzacja sprawia, że rosną wymagania wobec firmowych sieci, które muszą być szybsze i bardziej niezawodne, a jednocześnie jak najłatwiejsze w konfiguracji i obsłudze.

Rynek ma bogatą ofertę rozwiązań

sieciowych, które mogą nie tylko korporacjom, ale także małym i średnim firmom pomóc zmierzyć się z wyzwaniami wydajnościowymi i operacyjnymi. W tym drugim przypadku problemem dla firmy dysponującej skromnym personelem technicznym jest chociażby instalacja albo wymiana urządzeń sieciowych, takich jak przełączniki czy punkty dostępowe. Często administratorzy muszą poświęcić zbyt dużo czasu, aby skonfigurować kolejne dodawane urządzenia. Naprzeciw wychodzą im producenci oferujący narzędzia, które ułatwiają instalowanie i konfigurowanie całego sprzętu, a także zarządzanie nim – niezależnie od tego czy są to punkty dostępowe, przełączniki sieciowe, bądź bramy dostępowe.

Właśnie z trendu upraszczania wynika to, że głównym nurtem w obszarze zarządzania siecią stały się od jakiegoś czasu rozwiązania bazujące na chmurze. Zyskują one na popularności, ponieważ firmy każdej wielkości starają się konsolidować swoje narzędzia, by zwiększyć wydajność operacyjną i obniżyć koszty. Analitycy przewidują, że nawet połowa wszystkich nowych wdrożeń sieciowych będzie wykorzystywać zarządzanie w chmurze.

Zdalnie i automatycznie

Oferowane przez coraz większą liczbę dostawców zarządzanie siecią w chmurze umożliwia, po pierwsze, daleko idącą automatyzację jej wdrażania (tzw. zero-touch provisioning). Schemat jest zwykle taki sam: trzeba zeskanować kod QR na urządzeniach sieciowych, a następnie wysłać je do klienta (albo też udać się do niego, by samemu przeprowadzić instalację na miejscu). Po rozpakowaniu i podłączeniu sprzętu do internetu wystarczy zalogować się do aplikacji na smartfonie albo otworzyć panel zarządzania w przeglądarce internetowej, a instalowane urządzenia zostaną automatycznie wykryte i zarejestrowane w sieci. W sumie więc zainstalowanie sprzętu w sieci i połączenie go z innymi komponentami zajmuje już nie godziny, a niewiele minut. Znika też wiele innych niedogodności tradycyjnego wdrażania, związanych chociażby z koniecznością odwiedzin danej lokalizacji.

Po drugie, chmurowy portal nie tylko ułatwia uruchomienie sieci w danej lokalizacji, ale także jej utrzymanie i rozwój, które również można przeprowadzać zdalnie w prosty i szybki sposób. Działania takie będą obejmować ciągłe monitorowanie, rozwiązywanie problemów, aktualizacje firmware’u, dodawanie nowych użytkow-

ników i urządzeń. To także stanowi wielką oszczędność czasu i pracy dla administratora, zwłaszcza gdy w pojedynkę musi nadzorować wiele instalacji.

W przypadku małych firm, które nie posiadają własnego personelu technicznego, integratorzy mogą w imieniu swoich klientów zdalnie opiekować się dziesiątkami takich sieci, a nawet stać się ich wirtualnymi działami IT lub sieciowymi. Dzięki chmurowym narzędziom mogą zwiększać swój zasięg działania, wykorzystując przy tym nowe modele biznesowe, takie jak roczne lub miesięczne subskrypcje liczone na użytkownika lub urządzenie.

Integratorzy mają dziś do wyboru znacznie więcej rozwiązań sieciowych, pochodzących od wyraźnie większej grupy dostawców. Ta zwiększona konkurencja na rynku wpływa na marże, więc muszą oni rozważnie wybierać partnerów. A czym kierują się klienci przy wyborze dostawcy sprzętu sieciowego? W jakiej kolejności ustawiają priorytety? Jak ważne są dostępność sprzętu, koszty (zakupu i użytkowania), możliwości techniczne, poziom serwisu i warunki gwarancji, doświadczenie na rynku (liczba wdrożonych projektów itp.)?

Fot. Adobe Stock

n Tomasz Janoś

INFRASTRUKTURA SIECIOWA

10 VADEMECUM CRN czerwiec 2023

– W przypadku klientów instytucjonalnych, kupujących w ramach zamówień publicznych, oczywiście cena stanowi główne kryterium wyboru oferty, ale nie oznacza to, że kwestie techniczne nie są istotne. Warunki dla urządzeń sieciowych zapisane są już w SIWZ, OPZ czy w samym zapytaniu ofertowym – mówi Robert Gawroński, SMB Channel Manager w TP-Linku.

Niemal równie istotne jest przyzwyczajenie do jednego albo 2–3 dostawców rozwiązań sieciowych. W przypadku niewielkich modernizacji albo zakupów zmierzających do rozbudowy sieci lepiej jest – z uwagi na łatwość późniejszego zarządzania – ograniczyć się do mniejszej liczby producentów. Ważne jest także to, że w razie wystąpienia problemu jest on zgłaszany do jednego producenta, a nie kilku różnych. W opinii klientów instytucjonalnych infrastruktura sieciowa musi także cechować się dużą niezawodnością działania oraz wsparciem ze strony producenta.

– Podobnie zresztą jak w przypadku klientów biznesowych, wiele zależy od wielkości i typu projektu. Klient instytucjonalny, taki jak placówka edukacyjna, w której sieć będzie wykorzystywana przez kadrę nauczycielską do prowadzenia zajęć, a przez uczniów do bezpiecznego surfowania w in-

ternecie, będzie miał mniejsze wymagania niż sieć w szpitalu czy ministerstwie – tłumaczy Robert Gawroński.

W przypadku klientów biznesowych, przy mniejszych projektach sieciowych, realizowanych dla małych i średnich przedsiębiorstw, priorytetem są możliwości techniczne rozwiązania w stosunku do jego ceny. Wartość dodaną stanowi wydłużona gwarancja.

– W tej grupie klientów istotną kwestią jest również sposób zakupu. To, czy decydują się na kupno samodzielnie z kanału resellerskiego, czy też korzystają z usług integratora lub firmy obsługującej IT. W tym drugim przypadku to integrator zapewnia w dużej mierze właściwy poziom serwisu i obsługi zgłoszeń technicznych czy gwarancyjnych – twierdzi przedstawiciel TP-Linka.

Przy dużych projektach znacznie większy nacisk kładzie się na doświadczenie dostawcy na rynku, liczbę i typ zrealizowanych projektów (najlepiej wpisujących się w obszar działania klienta), jak również obsługę serwisową i gwarancyjną, pozwalającą na jak najszybszą reakcję w przypadku wystąpienia awarii.

Po kablu i bezprzewodowo Rozwiązania sieciowe dla MŚP są dzisiaj znacznie wydajniejsze niż jeszcze dekadę temu i widać to zwłaszcza w przypadku sieci bezprzewodowych. Jednak także we wdrożeniach przewodowych segment MŚP poczynił znaczne postępy, ponieważ już od dłuższego czasu chętnie sięga po przełączniki 10 GbE. Kiedyś dostępne wyłącznie dla dużych korporacji, dzisiaj są oferowane w takiej cenie, że mogą być

Zdaniem integratora

brane pod uwagę także przez małe firmy. Umożliwiają one modernizację szkieletu ich sieci do standardu 10 GbE, zapewniając bardzo szybkie połączenia przez porty miedziane i światłowodowe. Przełączniki sieciowe są wyposażone także w wydajniejsze porty PoE, które w infrastrukturze kablowej dostarczającej dane zapewniają więcej mocy elektrycznej. Bardzo to ułatwia instalowanie nowych punktów dostępowych sieci Wi-Fi, monitoringu wideo, telefonii IP itp.

Dostęp bezprzewodowy już dawno stał się dla użytkowników urządzeń mobilnych artykułem pierwszej potrzeby. Spodziewają się go w restauracjach i hotelach, instytucjach publicznych, szkołach, a nawet w środkach transportu publicznego. Wiele firm, podążając za oczekiwaniami swoich pracowników, częściej modernizuje swoje sieci Wi-Fi. A potrzeba bezprzewodowej komunikacji nie omija żadnej branży. W szpitalach WLAN łączy najróżniejsze urządzenia klienckie pacjentów i personelu oraz sprzęt medyczny. W handlu natomiast usprawnia i automatyzuje sprzedaż oraz przyciąga klientów. Hotele, jeśli nie chcą szybko pozbyć się gości, muszą im zapewnić dostęp do internetu na odpowiednim poziomie.

Znaczenie Wi-Fi wyraźnie wzrosło także w zastosowaniach niezwiązanych z obsługą użytkowników w biurach czy hotelach. Bezprzewodowa sieć o odpowiednich parametrach staje się kluczowym elementem automatyzacji procesów w logistyce, handlu czy produkcji. W nowoczesnym magazynie infrastruktura bezprzewodowa musi zapewnić ciągłą

n Paweł Zwierzyński, Network&Security Team Leader, Vernity Źle zaprojektowana sieć bezprzewodowa będzie miała fatalny wpływ na działanie aplikacji biznesowych. Szczególnie wymagające projekty to wdrożenia w obiektach magazynowych, które – w zależności od wysokości i długości regałów oraz miejsca montażu punktów dostępowych – mogą potrzebować bardzo różnych anten. Przykładowo, częstym błędem przy projektowaniu sieci bezprzewodowej w magazynie, gdzie występują długie alejki pomiędzy regałami, jest zastosowanie punktów dostępowych z antenami dookólnymi. Z uwagi na charakter propagacji sygnału z anten dookólnych przy wyższym poziomie zatowarowania magazynu będą występować problemy z siecią Wi-Fi. I chociaż przy małym zatowarowaniu magazynu pokrycie zasięgiem Wi-Fi będzie prawidłowe, to znacznie wzrosną interferencje CCI, co również będzie miało negatywny wpływ na działanie sieci.

11 VADEMECUM CRN czerwiec 2023

obsługę będącego stale w ruchu komputera zamontowanego na wózku widłowym lub znajdującego się w ręku magazyniera. Gdy przemieszczające się urządzenie znajduje się w zasięgu kolejnych AP sieć Wi-Fi dba o to, by nie doszło do zerwania połączenia i utraty otwartej sesji systemu klasy ERP lub innej aplikacji.

Zaspokojenie wszystkich potrzeb klientów związanych z siecią bezprzewodową nie jest prostą sprawą. Integratorzy muszą nie tylko rozumieć wymogi biznesowe, ale posiadać wiedzę dotyczącą sieci bezprzewodowych w zakresie skalowalności, kontroli dostępu, projektowania z uwzględnieniem zasięgu i pokrycia, pojemności i bezpieczeństwa.

Chociaż mogłoby się komuś wydawać, że aby stworzyć bezproblemowo działającą sieć Wi-Fi wystarczy wiedzieć ilu użytkowników i urządzeń ma ona obsługiwać, taka informacja stanowi dopiero początek procesu projektowania.

To, jak ma wyglądać sieć bezprzewodowa, będzie zależeć od rodzaju środowiska (biuro, magazyn, otwarta przestrzeń, konstrukcja obiektu itp.), a także wykorzystywanych urządzeń końcowych. Kolejna kwestia to rodzaj aplikacji, które ma obsłużyć sieć Wi-Fi, jak też lokalne możliwości montażu punktów dostępowych i panujące u użytkownika warunki (skrajne temperatury, wysokie zapylenie/wilgotność).

– Każda z tych kwestii wymaga w podejściu projektowym uwzględniania specyficz-

Rozwój sieci Wi-Fi

nych dla niej uwarunkowań. Przykładowo, w biurze będziemy mieć do czynienia z raczej statycznymi klientami bezprzewodowymi, ale podłączeni do Wi-Fi użytkownicy i urządzenia będą potrzebować większej przepustowości. Inaczej jest w magazynie, gdzie urządzenia często są przenoszone i przez to wymagają bezproblemowego przełączania pomiędzy punktami dostępowymi (roaming), ale za to nie potrzebują dużych przepustowości – tłumaczy Paweł Zwierzyński, Network&Security Team Leader w Vernity.

Rozmaite czynniki będą wpływać na dobór odpowiednich punktów dostępowych (czyli anten wbudowanych oraz zewnętrznych), a także samych anten (dookólnych, kierunkowych, o różnym zysku energetycznym itp.). Zastane warunki decydować będą o liczbie punktów dostępowych i kontrolerów, a także kanałach radiowych, na jakich będą nadawać oraz mocach sygnału.

klienckich, tworzenie stref z przywilejami itp.

Przez dekady sieci i cyberbezpieczeństwo rozwijały się równolegle, mając swój udział w innowacjach i przełomach w IT. Dziś zgrabnie łączy je SASE (Secure Access Service Edge), obiecując bezpieczny i wydajny dostęp z dowolnego miejsca.

Sieci oraz cyberbezpieczeństwo

Wszystko to powoduje, że oferowanie sieci bezprzewodowych to nie tylko sprzedaż punktów dostępowych, ale wiele dodatkowych usług. Gdy WLAN staje się podstawową metodą dostępu do sieci, partnerzy mogą zarabiać na planowaniu sieci, ich wdrażaniu, konfigurowaniu i bieżącym utrzymaniu. Szansą na dodatkowe dochody jest zabezpieczanie komunikacji bezprzewodowej oraz zarządzanie – zapewnienie dostępu dla gości, automatycznego konfigurowania sieci i urządzeń

Ewolucja standardów

Przejście na pracę zdalną w czasie pandemii przyspieszyło rozwój oferty SASE, czyli „bezpiecznego dostępu do usług brzegowych”. Od tego czasu wciąż rośnie zainteresowanie uzyskaniem bezpiecznego zdalnego dostępu do aplikacji, bez względu na to skąd są uruchamiane i gdzie znajduje się użytkownik. Towarzyszy temu rosnąca liczba dostawców oferujących SASE na rynku, a więc i możliwości ich partnerów w docieraniu do klientów.

Takie architektury, jak SASE, stanowią odpowiedź na zmianę paradygmatu dostępu do sieci i aplikacji. Czasy, gdy niemal cała komunikacja między pracownikiem a aplikacją odbywała się w wewnętrznej sieci firmy, można z całą pewnością uznać za minione. Stąd wynikła potrzeba rozwiązań, które w erze pracy hybrydowej i powszechnego wykorzystania usług SaaS z chmury zaoferują najwydajniejszy, a zarazem najbezpieczniejszy dostęp. n

12 VADEMECUM CRN czerwiec 2023

Wi-Fi 4 modulacja 64 QAM dwa zakresy (dual band)

Wi-Fi 5 modulacja 256 QAM szyfrowanie WPA2

Wi-Fi 5 (Wave 2) downlink MU-MIMO (4x4)

Wi-Fi 7 modulacja 4k QAM kanały 320 MHz funkcje Multi-Link

Wi-Fi 6 modulacja 1024 QAM downlink MU-MIMO (8x8) ortogonalne przełączanie sygnału (OFDMA)

Wi-Fi 6E zakres częstotliwości 6 GHz więcej kanałów 160 MHz

Wi-Fi 6E (Wave 2) uplink MU-MIMO

Ewolucja spektrum radiowego 2,4 GHz 5 GHz 6 GHz

źródło: Qualcomm INFRASTRUKTURA SIECIOWA

rozwijały się równolegle, a dziś łączy je SASE.

ER7212PC: wielofunkcyjny gigabitowy router VPN

TP-Link ER7212PC to rozwiązanie typu all-in-one: router VPN z wbudowanym 8-portowym przełącznikiem PoE+ i kontrolerem sprzętowym Omada SDN. Sprzęt pozwala na znaczną redukcję liczby urządzeń niezbędnych do stworzenia profesjonalnej sieci, bez konieczności rezygnowania z wymaganej funkcjonalności.

Urządzenie ER7212PC przeznaczone jest do pracy w sieciach domowych i małych fi rmach. To zintegrowane rozwiązanie może zastąpić router, sprzętowy kontroler sieciowy oraz przełącznik PoE. Wyposażone w osiem gigabitowych portów zapewnia zasilanie w standardzie PoE+ 802.3at/af (110 W całkowitej mocy) dla takich urządzeń PoE jak bezprzewodowe punkty dostępowe, kamery sieciowe czy telefony IP, co pozwala obniżyć koszty infrastruktury w małych przedsiębiorstwach.

Dla użytkowników dostępne są także maksymalnie cztery gigabitowe porty WAN (jeden RJ45 WAN, jeden RJ45 WAN/ LAN i dwa WAN/LAN z wkładkami SFP), co umożliwia podłączenie internetu od aż czterech dostawców, a przez to zapewnienie ciągłości działania firmy w razie awarii łącza. Zaimplementowana funkcja równoważenia pasma multi-WAN rozdziela strumienie danych zgodnie z przepustowością każdego portu WAN, aby zwiększyć stopień wykorzystania wieloliniowego połączenia szerokopasmowego.

Wysoka wydajność transferu danych na 12 gigabitowych portach zapewniona jest dzięki zastosowaniu dwurdzenio-

wego procesora z zegarem 1,2 GHz oraz 1 GB pamięci RAM. Niewielka, kompaktowa obudowa umożliwia montaż w wielu miejscach. Urządzenie pozbawione jest wentylatora, co pozwala na bezgłośne odprowadzanie ciepła.

Wbudowany klient i serwer VPN (L2TP, PPTP, IPsec, OpenVPN) umożliwia dostęp do zasobów firmowych osobom pracującym zdalnie. Instalacja i konfiguracja VPN IPsec odbywa się w sposób zautomatyzowany. Obsługa wirtualnych sieci VLAN oraz wielu identyfikatorów SSID ułatwia fragmentaryzację sieci istotnie zwiększając jej bezpieczeństwo. Zapewniono wiele możliwości autoryzacji użytkowników poprzez portal, Facebook, SMS czy vouchery.

Urządzenie ER7212PC umożliwia zarządzanie punktami dostępowymi z serii Omada firmy TP-Link. Producent rekomenduje skorzystanie ze sprzętu zgodnego ze standardem Wi-Fi 6 (802.11ax), takiego jak modele AX1800 o maksymalnej przepustowości 1,8 Gb/s, zasilanych przez PoE. Urządzenia EAP610 i EAP620 HD, oferowane w kompaktowej i dyskretnej obudowie o średnicy 16 cm i grubości 3,3 cm,

przeznaczone są do montażu na suficie bądź ścianie.

EAP610-Outdoor to wersja punktów dostępowych z obudową odporną na warunki atmosferyczne (IP67), przeznaczona do instalacji na zewnątrz budynków. Z kolei EAP615-Wall to model do montażu naściennego, w puszce elektrycznej o średnicy 86 mm. Urządzenie wyposażone jest w 4 porty sieciowe – jeden uplink oraz 3 downlink (z których jeden ma możliwość zasilania podłączonego urządzenia za pomocą PoE 802.3af/at).

Urządzenie ER7212PC ma wbudowany zintegrowany kontroler sprzętowy Omada SDN. Umożliwia on zbiorcze, scentralizowane zarządzanie podłączonym sprzętem (maksymalnie dziesięcioma punktami dostępowymi, dwoma przełącznikami i routerem) oraz aktualizowanie go, bez konieczności indywidualnego i skomplikowanego konfigurowania.

Dodatkowo, poprzez bezpłatną chmurę producenta Omada Cloud można zapewnić zdalną kontrolę podłączonego sprzętu poprzez przeglądarkę lub z urządzenia mobilnego, monitorowanie sieci i sprawdzanie jej stanu w czasie rzeczywistym. Rozwiązanie to sprawdza się szczególnie w hotelarstwie, edukacji, sprzedaży detalicznej, biurach oraz placówkach z wielu innych branż.

Omada w automatyczny sposób analizuje potencjalne problemy i prezentuje sugestie dotyczące optymalizacji sieci, a tym samym zwiększenia jej wydajności. Pomaga też lokalizować źródła zakłóceń i przeciwdziałać im poprzez automatyczne dostosowywanie ustawień kanału i mocy transmisji pobliskich punktów dostępowych połączonych z tą samą siecią.

Dystrybutorami TP-Link w Polsce są: AB, Also, Exclusive Networks i NTT System.

Dodatkowe informacje: Robert Gawroński, SMB Channel Manager, TP-Link robert.gawronski@tp-link.com

13 VADEMECUM CRN czerwiec 2023

Cudy

polski rynek

W tym roku Cudy – producent wysokiej jakości urządzeń

sieciowych – wprowadził na rynek bogatą ofertę przełączników oraz rozwiązań bezprzewodowych.

Inicjatywa powstania Cudy wyszła od profesjonalistów w dziedzinie sieci. Trzech założycieli firmy, każdy z ponad 10-letnim doświadczeniem, wywodzi się od czołowego dostawcy sprzętu sieciowego. Mając wizję tworzenia bardziej zróżnicowanych produktów, pozwalających na lepsze zaspokojenie potrzeb rynku, opuścili poprzedniego pracodawcę i pod koniec 2018 r. założyli firmę Cudy oraz zapewnili jej najwyższej klasy zespół badawczo-rozwojowy.

Dzięki zgromadzonemu doświadczeniu zespół R&D z powodzeniem zbudował wysoce zintegrowany łańcuch produkcyjny, który umożliwia zachowanie delikatnej równowagi między jakością urządzeń a kontrolą kosztów. Własna fabryka umożliwia rygorystyczne testowanie procesu montażu elektroniki i gotowych produktów, co ułatwia utrzymanie wskaźnika zwrotów (RMA) poniżej 1 proc.

– Nasza strategia rozwoju, skoncentrowana na kliencie, pozwoliła nam szybko reagować na potrzeby rynku. Po czterech latach działania oferujemy produkty w głównych kategoriach sieciowych, a wkrótce rozszerzymy portfolio także na obszary IoT i bezpieczeństwa – mówi

Zdzisław Kaczyk, Head of Sales – Eastern Europe w Cudy.

Dodaje, że na polskim rynku zauważa duże zainteresowanie systemami Mesh, które charakteryzują się lepszą stabilnością, optymalnym zasięgiem Wi-Fi oraz są łatwe w konfiguracji i zarządzaniu.

– W przypadku Cudy są one wstępnie skonfigurowane przed wysyłką do klienta, dzięki czemu może on zaoszczędzić czas i wysiłek podczas ich instalacji – podkreśla Zdzisław Kaczyk.

Zgodne z najnowszymi standardami

Na polski rynek trafiła zróżnicowana gama produktów Cudy, obejmująca przełączniki sieciowe, rozwiązania bezprzewodowe i routery (w tym 4G i 5G). Zostały one zaprojektowane w taki sposób, aby w maksymalnym stopniu zwiększać komfort pracy użytkowników. Dla przykładu, w modemach 5G zastosowana jest już najnowsza wersja tego standardu – 3GPP Release 16. Dzięki niej udostępniono takie funkcje jak eURLLC i mTRP, które poprawiają niezawodność łącza, zmniejszają opóźnienia i pozwalają na większe wykorzystanie pasma komórkowego. W ten sposób sieci mobilne mogą stać się silną alternatywą dla stacjonarnych światłowodowych łączy szerokopa-

smowych, dając użytkownikom większy wybór w zakresie dostępu do internetu. Specjaliści Cudy zapewnili także płynny zasięg w sieciach bezprzewodowych dzięki technologii Mesh. Pozwala ona na połączenie wielu węzłów Wi-Fi w jeden system, co zapobiega zrywaniu połączenia, gdy użytkownicy przemieszczają się z jednego obszaru do drugiego. Mechanizm ten jest szczególnie przydatny w dużych przestrzeniach, takich jak centra handlowe, hotele i węzły komunikacyjne, a także w średnich i dużych gospodarstwach domowych.

Dzięki koncentracji producenta na najnowszych technologiach, rozwiązania Cudy spełniają wymagania konsumentów i firm na całym świecie – zyskały szerokie uznanie użytkowników w ponad 60 krajach. Model LT18 jest najpopularniejszym routerem 4G Cat. 18 w Stanach Zjednoczonych, podczas gdy LT400 znajduje się w pierwszej piątce najlepiej sprzedających się routerów na włoskim Amazonie. Flagowy router 5G NR AX3000 Wi-Fi Router P5 firmy Cudy jest jednym z pierwszych routerów obsługujących najnowszy standard 5G Release 16.

Oficjalnym dystrybutorem produktów Cudy w Polsce jest AB.

Dodatkowe informacje: Zdzisław Kaczyk, Head of Sales – Eastern Europe, Cudy zdzislaw.kaczyk@cudy.com

14 VADEMECUM CRN czerwiec 2023

szturmuje

INFRASTRUKTURA SIECIOWA

Zdzisław Kaczyk, Head of Sales – Easter Europe, Cudy

Netgear:

obraz i dźwięk obraz i w profesjonalnej sieci w sieci

Przełączniki Netgear AV M4250

są przeznaczone do przesyłania sygnału audio-wideo w sieci wykorzystującej do komunikacji

protokół IP. Wbudowane w nie oprogramowanie jest zgodne z wymaganiami transmisji danych wykorzystywanymi w branży multimedialnej.

Rozwiązania z rodziny M4250 zostały zbudowane od podstaw dla rozwijającego się rynku transmisji danych AV over IP. Podczas ich projektowania Netgear połączył wiedzę profesjonalistów z branży audio-wideo z wieloletnim własnym doświadczeniem zdobytym przy rozwijaniu zarządzalnych przełączników z rodzin M4300 i M4500. W portfolio producenta dostępnych jest wiele modeli prze-

Podstawowa specyfikacja modeli GSM4210PD

oraz GSM4210PX

n 8 portów 1GbE RJ45, z PoE+ o łącznej mocy 110 W (PD) lub 220 W (PX)

n 1 port 1GbE RJ45 bez PoE+ oraz 1 port 1GbE SFP (tylko PD)

n 2 porty 10GbE SFP+ (tylko PD)

n łączna przepustowość 10 portów: 20 Gb/s (PD) lub 56 Gb/s (PX)

n port zarządzania 1GbE out-of-band (OOB)

n port konsoli USB-C oraz pamięci masowej USB-A

n obudowa nabiurkowa do zastosowania w salach konferencyjnych lub w mobilnych studiach (dostępne uszy do montażu w szafie rack)

łączników M4250, oferujących od 10 do 48 portów i różniących się wydajnością oraz mocą zapewnianą podłączanym urządzeniom za pomocą standardu Power over Ethernet.

Dla małych i średnich firm, które chcą odpowiednio wyposażyć swoje sale konferencyjne czy korzystać z niewielkich systemów nagłośnieniowych, polecane są 8-portowe biurkowe modele M4250–9G1F-PoE+ (nazwa kodowa GSM4210PD) oraz M4250––8G2XF-PoE+ (GSM4210PX), różniące się całkowitą przepustowością, łączną mocą PoE oraz dostępnością portów z wkładkami SFP (szczegóły w ramce obok).

Przełączniki z rodziny M4250 są przystosowane do obsługi standardowych sygnałów audio i wideo. Urządzenia te dostarczane są wraz z fabrycznie skonfigurowanymi profilami AV na określonych portach. Dla sygnału audio dostępne są profile Dante, Q-SYS i AES67, a także wymagający sprzedawanej oddzielnie licencji profil Audio Video Bridging (AVB), który najczęściej używany jest wówczas, gdy wymagane jest bardzo niskie opóźnienie (np. podczas występów na żywo, gdy synchronizacja ruchu warg ma kluczowe znaczenie). Dla transmisji danych wideo M4250 oferuje profile dla NVX, AMX, Q-SYS, NDI, Dante itp., a także profile mieszane audio/wideo/ sterowania. Gdy użytkownik ma bardziej specyficzne wymagania, interfejs przełącznika umożliwia personalizację profili.

Dodatkowo, funkcja AV Line (znana także jako Auto-LAG i Auto-Trunk) zapewnia automatyczną i dynamiczną konfigurację wielu połączonych ze sobą przełączników M4250. Jeśli w sieci będzie pracowa-

ła większa liczba przełączników, funkcja Netgear IGMP Plus zapewnia automatyzowany proces konfiguracji ich współpracy lub połącznia z przełącznikami z rodziny M4300 i M4500.

Wszystkie modele przełączników M4250 można zainstalować w szafie rack, montując je w sposób standardowy lub z portami wyprowadzonymi z tyłu urządzenia. Zarządzanie odbywa się zgodnie z branżowymi standardami, a więc poprzez łatwy w obsłudze interfejs graficzny, za pomocą standardowego wiersza poleceń, a także protokołów SNMP, sFlow i RSPAN. Możliwe jest także skorzystanie z usługi Netgear NMS300 zapewniającej scentralizowane aktualizacje firmware’u oraz zbiorcze zarządzanie i wprowadzanie zmian konfiguracyjnych.

Urządzenia z rodziny Netgear M4250 są objęte dożywotnią ograniczoną gwarancją Netgear ProSAFE, uwzględniającą wymianę sprzętu następnego dnia roboczego. Producent zapewnia także 90 dni wsparcia technicznego przez telefon oraz e-mail, a także dożywotnie wsparcie techniczne za pośrednictwem czatu online.

Autoryzowanymi dystrybutorami Netgear w Polsce są: AB, Action, Also i Exclusive Networks.

Dodatkowe informacje: Paweł Kozłowski, VAR Account Manager, Netgear pkozlowski@netgear.com

15 VADEMECUM CRN czerwiec 2023

w cieniu oprogramowania Sprzęt kwitnie

Dominacja usług chmurowych oraz oprogramowania sprawiły, że mniej mówi się o rozwiązaniach sprzętowych. Nie oznacza to jednak, że tracą one na znaczeniu.

Według najnowszej prognozy Gartnera (z kwietnia 2023 r.) globalne wydatki na IT wyniosą w tym roku 4,6 bln dol., co oznacza wzrost o 5,5 proc. w porównaniu z 2022 r. Bardzo dobre perspektywy rysują się przed dostawcami oprogramowania. Analitycy przewidują, że w 2023 roku ten segment rynku osiągnie wartość 891 mld dol., co oznacza wzrost o 12 proc. w ujęciu rok do roku. Jak na tym tle przedstawia się sprzęt?

Wyjątkowo niekorzystnie prezentuje się kategoria określana w zestawieniach Gartnera jako urządzenia (komputery PC, tablety oraz smartfony). Analitycy prognozują, że tegoroczne globalne przychody ze sprzedaży tej grupy produktów osiągną poziom 684 mld dol. – o 4,6 proc. mniej niż rok wcześniej. Jednak w tabelach Gartnera figuruje też pozycja systemy dla centrów danych, obejmująca między innymi serwery i macierze dyskowe. Ogółem w tym roku ten segment rynku ma wygenerować obroty o łącznej wartości 224 mld dol., a zatem o 3,7 proc. więcej niż w 2022 r.

Powyższe dane nie pozostawiają złudzeń, iż sprzęt wciąż odgrywa niepoślednią rolę w branży IT. Zresztą jego znaczenie szczególnie uwydatniła pandemia. Poza tym na rynku serwerów, komputerów czy systemów NAS aż roi się od technicznych nowinek. Urządzenia wyposażone w najnowsze procesory, karty sieciowe, kontrolery pamięci masowych czy akceleratory pozwalają śrubować kolejne rekordy wydajności, zaś dyski umożliwiają przechowywanie i przetwarzanie coraz większych ilości danych. Zdaniem Gala Naora, CEO i założyciela StorOne

VADEMECUM CRN czerwiec 2023

(wcześniej był twórcą macierzy Storwize), sprzęt rozwija się w bardzo dynamicznym tempie, co potwierdzają parametry najnowszych nośników danych czy przepustowości sieci. Natomiast wąskim gardłem w centrach danych jest oprogramowanie, które nie potrafi zapanować nad rozrastającymi się infrastrukturalnymi silosami.

Chyba tylko nieoprawni optymiści sądzili, że hossa na rynku komputerów PC trwać będzie w nieskończoność. Cud się nie zdarzył i pierwszy kwartał bieżącego roku przyniósł dwucyfrowe spadki. Według danych Canalysa globalna sprzedaż komputerów skurczyła się o 33 proc. w ujęciu rocznym do około 54 mln sztuk, podczas gdy IDC odnotowało spadek o 29 proc., do około 57 mln sztuk. To wynik gorszy niż przychody uzyskane przed pandemią w latach 2014–2019.

Sprawiła ona między innymi, że przedsiębiorcy zaczęli bardziej inwestować w sprzęt z najwyższej półki, na czym dużo zyskał Apple. W 2022 r. udział tej marki w globalnej sprzedaży komputerów wynosił 10 proc., zaś średni roczny udział z wcześniejszych pięciu lat to około 7 proc. Jednak w ostatnich miesiącach firmy nie są już tak hojne. Znamienny jest fragment listu dyrektora finansowego Google Alphabet dotyczącego wydatków na sprzęt IT dla pracowników tej firmy w 2023 r.

– Obecnie urządzenia mają znacznie dłuższą żywotność oraz większą wydajność i niezawodność, dlatego wprowadziliśmy zmiany w tym, co jest dostępne i jak często jest wymieniane – oznajmił Ruth Porat.

Skoro taki komunikat płynie z ust dyrektora finansowego jednego z najbogatszych koncernów na świecie, trudno się dziwić, że małe czy średnie przedsiębiorstwa również zaciskają pasa. Co ciekawe, Apple, będące beneficjentem boomu na komputery w czasie pandemii, w pierwszym kwartale bieżącego roku straciło najwięcej – liczba komputerów z systemem macOS dostarczonych na rynek zmniejszyła się o 46 proc.

Jak będzie wyglądać ponowne ożywienie i kiedy ono nastąpi? Średnia roczna sprzedaż przed pandemią wynosiła około 265 mln sztuk. IDC prognozuje, że w 2027 r. światowy rynek wchłonie około 300 mln komputerów. Analitycy wierzą zwłaszcza w siłę nabywczą klientów biznesowych, którzy zaczną wymieniać urządzenia zakupione w czasie pandemii. Jak wynika z badania przeprowadzonego przez Della oraz ICAN Institute, 84 proc. badanych przedsiębiorstw wskazało na trudności podczas pracy zdalnej, a jedną z największych przeszkód jest zbyt mały ekran laptopa. W tym samym badaniu 69 proc. kierowników oraz 61 proc. specjalistów wskazało potrzebę wymiany sprzętu, w tym monitorów.

– Jednym z impulsów ożywiających rynek komputerów mogą być zmiany w przepisach prawa nakładające na pracodawcę obowiązek wyposażania pracowników w narzędzia umożliwiające stworzenie ergonomicznego miejsca pracy w domu. W związku z tym spodziewamy się zwiększenia zapotrzebowania na monitory, stacje dokujące, zestawy słuchawkowe i inne peryferia – mówi Sebastian

Urbanek Fot. Adobe Stock

n Wojciech

PRZETWARZANIE I PRZECHOWYWANIE DANYCH

16

Antkiewicz, Products & Solutions Senior Manager w Dell Technologies.

Ożywienie na rynku komputerów PC powinny przynieść innowacje techniczne – nowe procesory, karty graficzne, dyski. Najbardziej interesująco przedstawia się sytuacja wśród producentów procesorów. Digitimes Research prognozuje, że w tym roku udział Intela w segmencie chipów dla laptopów skurczy się do historycznego minimum, czyli 65 proc, na czym zyskają układy AMD oraz w nieco mniejszym stopniu ARM. W kwietniu swój debiut miał Ryzen 7 7800X 3D, a pierwsze testy pokazują, że jest on wydajniejszy od swojego poprzednika (Ryzen 7 5800X 3D) o około 20–30 proc.

– Procesor zwiększył wydajność, a do tego dochodzi przystępna cena, która w dniu premiery była praktycznie taka sama jak w przypadku premiery 5800X 3D. Dlatego uważam, że właśnie Ryzen 7 7800X 3D powinien wnieść ożywienie na rynek komputerów – uważa Mateusz Świętek, Product Manager AMD w AB.

Przy czym nie jest tak, że wrocławski dystrybutor stawia wyłącznie na jednostki AMD. Specjaliści z tej firmy pokładają duże nadzieje w trzynastej generacji procesorów Intela i wskazują na dwóch faworytów: Intel

Core i5-i3500 dla użytkowników niskobudżetowych oraz bardziej wydajną jednostkę Intel Core i5–13600K.

Jak na razie małe i średnie firmy najczęściej kupują notebooki z procesorem Intel Core i5–12500, z ekranem o przekątnej 15,6 cala, 8 lub 16 GB pamięci RAM oraz nośnikiem SSD o pojemności 256 GB lub 512 GB. Klienci biznesowi wciąż zaopatrują się w komputery stacjonarne, które trafiają

zazwyczaj do sklepów, hal produkcyjnych bądź stanowisk pracy wymagających komputera o odpowiedniej konfiguracji (m.in. pod kątem wymogów wydajnościowych). Natomiast modele All-In-One można spotkać na recepcjach, w salach konferencyjnych czy miejscach, gdzie brakuje przestrzeni na tradycyjne komputery stacjonarne.

– Rokrocznie obserwujemy wzrosty sprzedaży urządzeń All-In-One o około 30 proc. Tego typu komputery coraz chętniej są wykorzystywane w punktach sprzedażowych. Klienci coraz częściej wybierają większe matryce o przekątnej 24–27 cali, chociaż rok temu królowały rozwiązania 21,5 cala – mówi Bogdan Wiśniewski, Commercial Team Leader w Asusie.

Serwery: rywalizacja gigantów

da broni, a jego odpowiedzią na nową linię chipów konkurenta jest czwarta generacja procesorów Xeon. Z pewnością wiele firm zainwestuje w serwery z najnowszymi układami AMD lub Intela, aby zaspokoić rosnące potrzeby w zakresie obliczeń.

Rywalizacja

Intel oraz AMD mocno rywalizują ze sobą nie tylko na rynku komputerów, ale również serwerów. Chociaż firma kierowana przez Pata Gelsingera wciąż jest górą, jej przewaga powoli topnieje. Na koniec ubiegłego roku przychody Intela ze sprzedaży procesorów dla centrów danych skurczyły się o 16 proc., a udział w rynku spadł z 81 do 71 proc. Natomiast AMD znajduje się na fali wznoszącej – firma odnotowała wzrost przychodów o 62 proc, osiągając 20 proc. udziału w rynku serwerów.

Niewykluczone, że nowa rodzina procesorów AMD EPYC Genoa czwartej generacji pozwoli tej marce jeszcze bardziej skrócić dystans do lidera. Jednak Intel nie skła-

Oczywiście specjaliści tworzą zestawienia porównujące najnowsze chipy AMD i Intela. Wynika z nich, że AMD EPYC Genoa ma kilka atutów w porównaniu z największym konkurentem, takie jak liczba rdzeni na gniazdo, lepsza przepustowość pamięci, mniejsze zużycie energii i więcej linii PCIe. Natomiast Intel Xeon przewyższa rywala pod względem wydajności pojedynczego rdzenia, lepszej obsługi wirtualizacji i szerszych możliwości w zakresie obsługi oprogramowania. Liczy się też renoma marki, która w świecie IT wciąż wiele znaczy.

– Patrząc na rynek z punktu widzenia procesorów, AMD w ostatnich latach odniosło ogromny sukces. Intel czwartą generacją Xeonów chce odzyskać kawałek utraconego rynku, co moim zdaniem wcale nie będzie takie łatwe. Nie zapominajmy jednak, że na rynku są jeszcze obecne procesory ARM, stanowiące konkurencję dla obu wymienionych marek – mówi Mirosław Chełmecki, Data Center & Cloud Department Director w Exclusive Networks.

Według IDC w 2022 r. globalne przychody ze sprzedaży serwerów wyniosły 122,7 mld dol. Natomiast w bieżącym roku ma to być 131,2 mld dol. (w tym 109,6 mld dol. ze sprzedaży jednostek x86). Czynniki

17 VADEMECUM CRN czerwiec 2023

będzie toczyć się na kilku frontach.

napędzające popyt to modernizacja istniejącej infrastruktury i przechodzenie na model chmury hybrydowej. Mirosław Chełmecki doszukuje się przy tym pozytywów w sytuacji politycznej, gdyż w trudnych czasach trzeba zapewnić cyfrowe bezpieczeństwo obywatelom. Tymczasem bez modernizacji lub wymiany starych serwerów jest to niemożliwe. Niepośledni wpływ na decyzje zakupowe mają również inflacja, w tym wzrost cen energii.

– Klienci poszukują rozwiązań efektywnych kosztowo, lecz nie chodzi wyłącznie o cenę zakupu, ale także o późniejsze koszty użytkowania związane z zarządzaniem, wsparciem, poborem energii elektrycznej w odniesieniu do wydajności, czy serwisem. Dodatkowym czynnikiem branym pod uwagę jest sposób dostarczania infrastruktury – mówi Paweł Wójcik, HV and Compute & Data Services Lead w HPE.

Z całą pewnością serwery oferowane w modelu usługowym przez HPE, Della czy Cisco, to szansa dla małych i średnich firm, których często nie stać na zakup innowacyjnych rozwiązań w tradycyjnym modelu.

Osobną kwestią jest rosnąca popularność systemów hiperkonwergentnych (HCI), w których kluczową rolę spełniają serwery zastępujące macierze SAN. Tego typu rozwiązania cieszą się rosnącą popularnością wśród małych i średnich firm ze względu na łatwość wdrożenia i konfiguracji. Zresztą na globalnym rynku działają anonimowi w Polsce producenci (Scale Computing, StorMagic) opracowujący systemy HCI specjalnie na potrzeby MŚP. Obie firmy twierdzą, że

Zdaniem integratora

przetwarzanie na brzegu sieci, a w związku z tym potrzeba umieszczenia aplikacji oraz infrastruktury blisko miejsca wytwarzania i konsumowania danych, będzie w najbliższych latach stymulować popyt na ich rozwiązania.

NAS ewoluuje

Serwery NAS od lat cieszą się nieustającą popularnością wśród małych i średnich przedsiębiorstw. W Polsce najszybciej znikają z magazynów produkty Synology oraz QNAP. Wymieniona dwójka zdominowała rynek odbiorców MŚP i, co za tym idzie, kreuje na nim najważniejsze trendy. Preferencje użytkowników zmieniają się wraz z przyrostem danych, a także spadającymi cenami nośników. Jeszcze do niedawna dyski SSD wydawały się być w serwerach NAS przysłowiowym wodotryskiem. Jednak od niedawna nawet urządzenia dla mniejszych firm mają porty M.2. Szybkie nośniki mogą być wykorzystane jako pamięć cache lub przestrzeń na dane. Najczęściej taką wersję wybierają firmy pracujące z nieskompresowanymi plikami audio-wideo bądź korzystające z wirtualizacji.

MŚP mają też coraz większe wymagania wobec stosowanej w NAS-ach pamięci RAM. Minimum w przypadku najmniejszych klientów biznesowych wynosi 4 GB, zaś większe firmy potrzebują przynajmniej 32 GB. Jednak bywają także klienci MŚP inwestujący w serwery z zainstalowanymi 128 GB pamięci RAM.

n Jacek Marynowski, prezes, Storage IT

Wśród procesorów instalowanych w urządzeniach NAS przeważają

konstrukcje w architekturze x86 z procesorami AMD Ryzen oraz Intel Xeon. Szczególnie AMD Ryzen w ostatnich miesiącach osiągnął całkiem

istotny udział w rynku NAS-ów. Jeśli chodzi o ilości pamięci RAM, tu nie dostrzegam zmian – nadal przeważają konstrukcje z 4 i 8 GB pamięci. Jednak należy tu wyraźnie zaznaczyć, że w przypadku serwerów NAS procesor czy pamięć RAM nie są aż tak kluczowe w wielu wdrożeniach, jak chociażby wydajność sieci. Dlatego coraz częściej mamy do czynienia ze zmianą przepustowości kart sieciowych LAN. W tym segmencie coraz bardziej popularne są prędkości 10, czy też 2,5 GbE. Zatem dobry system dla średniej firmy, to pojemna jednostka z dużą przepustowością sieci LAN. W segmencie, w którym najlepiej się poruszamy, technologia scale-out dopiero „bada” teren. Do tej pory raczej mieliśmy do czynienia z potrzebami zaspokajanymi przez rozwiązania typu scale-up, czyli możliwość zwiększania pojemności w ramach pojedynczego węzła.

Łukasz Milic, Business Development Representative w QNAP, tłumaczy, że wszystko zależy od systemu operacyjnego obsługującego konkretny model. Jeśli zapewnia on deduplikację i kompresję online, wówczas znacznie rośnie zapotrzebowanie na pamięć RAM. Kolejnym bardzo ważnym czynnikiem przy wyborze serwera NAS jest jego pojemność. Mniejsi przedsiębiorcy wybierają urządzenia z przynajmniej dwoma dyskami, zaś średnie firmy decydują się na rozwiązania o większej pojemności (8–12 dysków) i procesorach średniej klasy, na przykład AMD Ryzen Embedded bądź niższe modele CPU Intel Xeon (2–4 rdzenie). Jeśli chodzi o przepustowość sieci, zwykle wystarcza 10 GbE lub nawet mniej. QNAP oferuje klientom rozwiązania 25 GbE, ale średnie przedsiębiorstwa jak na razie nie wykazują zainteresowania tą opcją.

W segmencie rozwiązań NAS bardzo dużo mówi się o systemach klasy scale-out. Według Piotra Drąga, Storage Category & Data Services Business Development Managera w HPE, jest to najszybciej rosnący rynek w obszarze magazynowania zasobów cyfrowych. To wynika z kierunku rozwoju technologii, gdzie większość danych jest przechowywana i przetwarzana w formie nieustrukturyzowanej. NAS typu scale-out pozwala przechowywać petabajty danych. Jak łatwo się domyślić, nie są to jak na razie produkty adresowane dla MŚP, ale biorąc pod uwagę tempo przyrostu danych, już niebawem może się to zmienić. Niestety, systemy scale-out są drogie i często wymagają zmian w infrastrukturze oraz dużej wiedzy niezbędnej do prawidłowego wdrożenia.

Na inny trend, który niedługo może zawitać do Polski zwraca uwagę Oded Nagel, CEO CTERA Networks. Kilka lat temu klienci pytali przede wszystkim o wydajność wyrażaną w liczbie operacji wejścia-wyjścia na sekundę (IOPS), kopie zapasowe, kompresję czy deduplikację, natomiast ostatnimi czasy pojawiają się zupełnie nowe kwestie, takie jak zgodność z regulacjami i mobilność danych, dostęp do nich z dowolnego miejsca, odporność na cyberataki czy DataOps. To oznacza, że rywalizacja w tym segmencie rynku będzie trwała na kilku frontach. n

18 VADEMECUM CRN czerwiec 2023

PRZETWARZANIE I PRZECHOWYWANIE DANYCH

Wpływ na decyzje zakupowe ma inflacja, w tym ceny energii.

Zwiększona ochrona

z Acronis Cyber Protect Cloud

Przywracanie urządzeń klienckich do pracy po awarii lub udanym ataku cyberprzestępców to długotrwałe, a przy tym stresujące wyzwanie. Dzięki chmurowym usługom Acronis można je zautomatyzować i odzyskać dostęp do danych w zaledwie kilka minut.

Użytkownikom usługi Acronis Cyber Protect Cloud można zaproponować dodanie do niej modułu Advanced Disaster Recovery. To jedyne rozwiązanie dla usługodawców, które łączy cyberbezpieczeństwo, ochronę danych przed utratą i zarządzanie nimi. Taka różnorodność połączonych ze sobą funkcji oraz automatyzacja wspierana mechanizmami sztucznej inteligencji pozwala na wyeliminowanie złożoności w obsłudze rozwiązania zabezpieczającego, a dzięki temu lepszą ochronę klientów przy utrzymaniu niskich kosztów – wszystko to zaś przekłada się na zwiększenie przewagi konkurencyjnej.

Moduł Advanced Disaster Recovery umożliwia wykonywanie kopii systemów operacyjnych Windows i Linux, aplikacji oraz plików użytkowników (trafiają do repozytorium Acronis Cloud). W przypadku awarii dysku w komputerze, poważnego błędu oprogramowania lub powodzenia ataku cyberprzestępców (np. zaszyfrowania danych przez ransomware), dowolna kopia może być uruchomiona w postaci wirtualnej maszyny bezpośrednio w chmurze Acronis lub na wskazanym przez administratora serwerze. Identyczny mechanizm jest dostępny dla środowisk wirtualnych, obsługiwanych przez wszystkie popularne hypervisory.

Takie podejście daje użytkownikowi możliwość niemalże natychmiastowego kontynuowania pracy, a administratorowi dodatkowy czas na bezstresowe przywrócenie serwera do działania – na podobnym lub innym sprzęcie. Procedura odzyskiwania może być zautomatyzowana dzięki runbookom - zestawom instrukcji określających sposób urucha-

miania środowiska produkcyjnego klienta w chmurze.

W celu uzyskania większej kontroli nad konfiguracjami sieciowymi i dzierżawami adresów IP, administratorzy mogą uruchomić własną usługę DHCP na serwerze odzyskiwania, aby była ona aktywna podczas rozległej awarii lub procedur testowania sytuacji awaryjnych. Zadbano też o to, aby klienci mogli uruchamiać również aplikacje, w których licencja jest powiązana z adresem karty sieciowej MAC.

Skonstruowana przez Acronis procedura zabezpieczania i odzyskiwania danych umożliwiła skrócenie czasów RPO i RTO do poziomu poniżej 15 minut. Elastyczne zasady odnośnie częstotliwości tworzenia kopii zapasowych pozwalają na osiągnięcie lepszych wskaźników RPO, a także umożliwiają przywrócenie systemów i danych do dowolnego możliwego do odzyskania punktu w przeszłości, a nie do ostatniego.

Rozwiązanie Advanced Disaster Recovery jest bardzo proste w obsłudze. Poradzą sobie z nim wszyscy informatycy, którzy mieli wcześniej do czynienia z platformą Acronis Cloud. Dzięki temu nie muszą uczyć się zarządzania kolejnym narzędziem. Usługodawcy natomiast zyskują możliwość prostego rozszerzenia swojego portfolio o dodatkowe funkcje, zapewniające cyfrowe bezpieczeństwo i wysoką dostępność środowiska IT klientów. Subskrypcyjny model pozwala im natomiast uzyskiwać systematyczne, comiesięczne przychody.

Autoryzowanymi dystrybutorami oprogramowania Acronis w Polsce są: Also, APN Promise, Clico, Dagma, Ingram Micro oraz Systemy Informatyczne ITXON.

Główne funkcje

Acronis Cyber Protect Cloud to…

n …tworzenie kopii zapasowych obrazów systemów operacyjnych, aplikacji i plików,

n …natychmiastowe odzyskiwanie danych (funkcja Instant Restore) w lokalnej infrastrukturze, n …testowe przełączanie awaryjne (test failover),

n …połączenie VPN z usługami chmurowymi.

n …produkcyjne i testowe przełączanie awaryjne do chmury Acronis Cloud,

n …opcję wdrożenia bez konieczności korzystania z VPN-u,

n …wsparcie dla wielooddziałowego tunelowania IPsec VPN, zestawianie tuneli VPN warstwy drugiej pomiędzy oddziałami,

n …wiele szablonów dokumentów runbook,

n …obsługę niestandardowej konfiguracji serwerów DNS,

n …odzyskiwanie awaryjne serwerów DHCP,

n …przełączanie awaryjne do punktu odzyskiwania niezarażonego złośliwym kodem.

Dodatkowe informacje: Dariusz Mumot, Senior Solutions Engineer, Acronis dariusz.mumot@acronis.com

19 VADEMECUM CRN czerwiec 2023

Moduł Advanced Disaster Recovery zapewnia…

Exea Data Center:

przewidywalność

i korzystna lokalizacja

Exea Data Center – całkowicie polski dostawca usług w sektorze centrów danych – deklaruje, że wyeliminował wszystkie możliwe czynniki, które przekładają się na ryzyko otrzymania przez polskich klientów zaskakująco wysokich rachunków za usługi chmurowe.

Wy kupując usługi chmurowe w modelu postpaid u ich globalnych dostawców klient praktycznie nigdy nie jest w stanie oszacować wysokości faktury, którą otrzyma i która zostanie automatycznie opłacona z podłączonej do konta karty kredytowej. Wiele składników rozliczenia jest bezpośrednio uzależnionych od różnych czynników, wśród których najbardziej nieprzewidywalnym jest ilość generowanego w ramach usługi transferu danych. Ten zaś jest bezpośrednio uzależniony od liczby osób odwiedzających witrynę internetową, zapytań do bazy danych czy odtworzeń materiałów multimedialnych. Naliczenie dodatkowych opłat bardzo często jest skutkiem użycia jakiejś dodatkowej funkcji.

Oczywiście dostępne są kalkulatory, które pomagają zasymulować wysokość comiesięcznych rachunków. Jednak z praktycznego doświadczenia wynika, że są one relatywnie wiarygodne tylko do pewnej

liczby użytkowników danej usługi. Poza tym, często nawet handlowcy zatrudniani przez takiego usługodawcę nie są w stanie ich prawidłowo obsługiwać, co prowadzi do obserwowanych później rozbieżności pomiędzy obietnicami a kwotą na fakturze.

Kolejnym problemem jest zmuszanie klientów do korzystania z danych usług w takim stopniu, jakiego nie potrzebują. Przykładem jest tu moc obliczeniowa serwerów wirtualnych, którą można zamawiać tylko w pakietach kilku procesorów (nie ma możliwości zamówienia pojedynczego procesora). Zdarza się też, że wymuszona jest opłata za cały miesiąc za usługę, z której zazwyczaj korzysta się przez jeden lub kilka dni (np. kreator migracji).

W przypadku usług chmurowych oferowanych przez Exea Data Center jedną z ważniejszych różnic na korzyść klienta, a zarazem drastycznie wpływającą na finalny rachunek, jest brak opłaty za zużyty transfer danych – niezależnie od jego wielkości jest on uwzględniony ryczałtowo w koszcie usługi. Exea samodzielnie realizuje też proces migracji danych ze środowiska u obecnego dostawcy klienta do własnego. Oprócz przewidywalności kosztów ważna jest łatwa dostępność inżynierów działu wsparcia, którzy świadczą indywidualną pomoc klientom, niezależnie od skali ich działalności.

Wysokość podstawowych opłat za usługi Exea Cloud jest uzależniona od wielkości uruchomionego wirtualnego środowiska dla klienta, na które składa się: liczba procesorów (można zamówić ich dowolną liczbę, nie trzeba ich kupować w zestawach), ilość pamięci RAM czy też przestrzeni na dyskach HDD/SSD/NVMe. Opcjonalnie można dokupić usługę backupu oraz ewentualne licencje na dodatkowe oprogramowanie typu

SQL (Windows Server i Linux są uwzględnione w cenie). Tak oferowane środowisko umożliwia klientowi samodzielne uruchamianie maszyn wirtualnych w dowolnej ilości. Ewentualny szybki wzrost biznesu klienta, a w związku z tym zwiększona intensywność wykorzystania wykupionych przez niego usług chmurowych, nie jest bezpośrednio związany ze wzrostem opłat. Może jedynie okazać się, że konieczne będzie zwiększenie tylko wybranych parametrów w środowisku wirtualnym, zamiast niepotrzebnie zamawiać dodatkowo zbędne zasoby.

W przypadku globalnych dostawców jest jeszcze jeden ważny czynnik, którego nie można pominąć, a więc fizyczna lokalizacja przechowywanych danych. Nawet jeśli użytkownik może wybrać, aby to była Polska (co czasem wiąże się z koniecznością uiszczenia dodatkowej opłaty), nie ma praktycznie żadnej możliwości zweryfikowania, czy dane te nie trafiły za granicę, chociażby w ramach realizacji procedur disaster recovery lub podczas wykonywania backupu. Tymczasem dla wybranych branż (m.in. finansowej czy medycznej) istnieją regulacje prawne precyzyjnie określające zasady przetwarzania lub nawet przechowywania danych poza granicami Polski. W przypadku Exea Data Center problem ten nie istnieje, jako że jej wszystkie centra danych znajdują się w Polsce, działając w klastrze Toruń-Warszawa.

Dodatkowe informacje: Dawid Goljat, Project Manager, Exea Data Center dawid.goljat@exea.pl

20 VADEMECUM CRN czerwiec 2023

PRZETWARZANIE I PRZECHOWYWANIE DANYCH

Magdalena Mike, prezes zarządu, Exea Data Center

Nowe funkcje bezpieczeństwa w Synology DSM 7.2

Firma Synology publicznie udostępniła kolejną wersję systemu operacyjnego dla swoich serwerów NAS – DiskStation Manager 7.2. Wśród wielu nowych funkcji na uwagę zasługują te dotyczące ochrony plików, szybkiego szyfrowania woluminów z danymi oraz bardziej restrykcyjnych reguł kontroli dostępu do zasobów.

Jedną z najważniejszych funkcji dotyczących bezpieczeństwa w DSM 7.2 jest możliwość tworzenia folderów współużytkowanych WriteOnce, których zawartość (przez określony czas lub na stałe) jest zablokowana przed modyfikacją lub usunięciem. W ten sposób zapewniana jest dodatkowa ochrona przed zaszyfrowaniem plików przez ransomware lub sabotażem dokonanym przez niezadowolonego albo właśnie zwolnionego pracownika.

Dodatkowo, aby zapewnić jeszcze lepszą ochronę przed wyciekiem danych spowodowanym fizyczną kradzieżą serwera lub zainstalowanych w nim dysków, wprowadzono funkcję pełnego szyfrowania woluminów. Wcześniej możliwe było już szyfrowanie folderów współużytkowanych, co także chroniło dane przed kradzieżą. Teraz dodatkowo zabezpieczone są na przykład dane aplikacji przechowywanych na wolumenach, czy też całe jednostki LUN. Zapewniono również większą wydajność tego procesu. Zapis sekwencyjny przy włączonej funkcji szyfrowania całych woluminów odbywa się do 48 proc. szybciej niż ma to miejsce w przypadku szyfrowania pojedynczych folderów współużytkowanych.

W DSM 7.2 usprawniono również proces wykonywania kopii zapasowych. W aplikacji Snapshot Replication pojawiła się funkcja tworzenia kopii migawkowych z zablokowanym wprowadzaniem zmian, co zapewnia ochronę danych na przykład przed zaszyfrowaniem przez ransomware, również w przypadku wycieku poświadczeń administratora.

Uwierzytelnianie

W ramach zwiększania poziomu bezpieczeństwa w nowej wersji DSM rozszerzony został zakres funkcji automatycznego blokowania. Teraz analizuje ona próby logowania także za pomocą protokołu SMB (Server Message Block), przez co zmniejsza szanse powodzenia ataków typu brute-force za pomocą niewystarczająco silnych danych uwierzytelniających użytkownika. Natomiast serwery w świadczonej przez Synology usłudze QuickConnect obecnie globalnie blokują adresy IP po kilku nieudanych próbach uwierzytelniania.

Ponieważ administratorzy urządzeń z systemem DSM często nie korzystają z uwierzytelniania dwuskładnikowego (2FA), aby zwiększyć poziom bezpieczeństwa wprowadzono funkcję adaptacyjnego uwierzytelniania wieloskładnikowego (Adaptive Multi-Factor Authentication, AMFA). Wymusza ona skorzystanie z dodatkowego elementu uwierzytelniania (aplikacja mobilna Secure SignIn, autoryzacja w aplikacji mobilnej DS fi nder, link w wiadomości e-mail) podczas logowania się do konta administratora, gdy proces ten zostanie zainicjowany z niezaufanego połączenia zewnętrznego lub nierozpoznanego urządzenia.

Ochrona danych użytkowników od zawsze jest priorytetem dla Synology. Serwery NAS tego producenta mogą funkcjonować jako profesjonalne repozytorium kopii zapasowych, a proces

ten może być zarządzany za pomocą bezpłatnego oprogramowania Synology Active Backup for Business, stworzonego specjalnie dla małych i średnich przedsiębiorstw do przeprowadzania backupu z komputerów PC, serwerów fizycznych i maszyn wirtualnych według zdefiniowanego harmonogramu lub zdarzeń.

Ciekawym rozwiązaniem jest także Synology Drive – jest to uruchamiana na serwerze NAS bezpłatna usługa zapewniająca bezproblemowy dostęp do plików, ich niezawodną synchronizację i ochronę danych za pomocą kopii zapasowych oraz funkcje pracy zespołowej (edycja dokumentów, arkuszy kalkulacyjnych i slajdów w usłudze Synology Offi ce, kompatybilnej z Microsoft Offi ce). Plikami można zarządzać z telefonów i komputerów – zapewnione jest wsparcie dla systemów Windows, Linux Ubuntu, macOS, iOS i Android.

W ramach Synology Drive możliwe jest uruchomienie synchronizacji pomiędzy wieloma komputerami a serwerem Synology NAS (na którym pracuje usługa Synology Drive), aby ułatwić współpracę na zawsze aktualnych plikach. Dostępna jest też funkcja przechowywania do 32 historycznych wersji plików, co zapewnia dostęp do nich np. w przypadku udanego ataku ransomware.

Dodatkowe informacje: Przemysław Biel, Senior Key Account Manager Poland, Synology pbiel@synology.com

21 VADEMECUM CRN czerwiec 2023

C y f r o w y o b i e g Cyfrowy obieg

wielu szans i możliwości

Zarządzanie przetwarzaniem dokumentów to dzisiaj rozległy obszar funkcjonowania wielu różnych działań, procesów, narzędzi i rozwiązań. Dlatego z łatwością można znaleźć w nim miejsce dla integratorskiego biznesu.

Mimo rosnącego zastosowania cyfrowych rozwiązań w obsłudze procesów biznesowych i administracyjnych, dokumenty papierowe wciąż zajmują znaczące miejsce w funkcjonowaniu wielu firm i instytucji. I nie zanosi się na to, by w najbliższej przyszłości papier mógł zostać całkowicie wyeliminowany z obiegu, zarówno w sferze gospodarczej, jak i w sektorze publicznym. To w dużej mierze rzutuje na sposób podejścia do wprowadzania systemów elektronicznego obiegu dokumentów.

Przyczyn takiego stanu rzeczy jest kilka. Z przygotowanego przez Quocirca raportu „Scanning as an enabler for digital transformation” wynika, że przy kontynuowaniu przez firmę prowadzenia procesów bazujących na dokumentacji papierowej w grę wchodzą obecnie kwestie bezpieczeństwa, ale też przyzwyczajenia pracowników czy klientów. Najwięcej, czyli 39 proc. respondentów badania, na wynikach którego opiera się wspomniany raport, wskazuje jednak na powody związane z koniecznością dostosowania się do wymogów prawa.

Sprostanie

n Andrzej Gontarz ustawodawczych, które mają zachęcić przedsiębiorców oraz urzędników do posługiwania się dokumentacją cyfrową (bądź ułatwić im jej stosowanie w codziennej działalności). W wielu przypadkach forma cyfrowa jest nawet obligatoryjna.

Przykładowo, w postępowaniach o zamówienia publiczne w Polsce oferty o wartości równej lub wyższej niż progi unijne muszą mieć charakter pliku cyfrowego podpisanego elektronicznym podpisem kwalifikowanym. Również przedsiębiorca rozliczający składki za więcej niż 5 osób ma obowiązek składać dokumenty do ZUS-u w formie elektronicznej (mniejsi przedsiębiorcy również mają możliwość skorzystania z tej metody, ale decyzja o jej wyborze leży po ich stronie.) Podobnie jest w przypadku obowiązku składania przez firmy sprawozdań finansowych – one również muszą mieć charakter cyfrowy i być opatrzone podpisem kwalifikowanym.

wymogom wielu różnych regulacji to spore wyzwanie.

Z drugiej jednak strony trzeba też zwrócić uwagę na to, że zarówno w Polsce, jak i w innych krajach europejskich podejmowanych jest szereg inicjatyw

W wielu innych dziedzinach i obszarach aktywności gospodarczej korzystanie z elektronicznego podpisu kwalifikowanego stało się codziennością ze względu na wygodę jego stosowania. W myśl obecnie obowiązującego prawa, dokument cyfrowy jest tożsamy z dokumentem papierowym. Sygnowany elektronicznym podpisem kwalifikowanym został zrównany w skutkach z dokumentem opatrzonym tradycyjną parafą w formie pisemnej.

Na dodatek, w określonych przepisami sytuacjach skuteczną prawnie moc sprawczą może mieć również profil zaufany. Co więcej, jak podkreśla w artykule „Paperless – potencjał i korzyści wykorzystania”

Grzegorz Łaptaś, partner PwC Polska, prawo w coraz szerszym stopniu wspiera budowanie procesów biznesowych bazujących na bezpiecznej komunikacji online, a dokumentami stają się również wiadomości e-mail, SMS, nagrania audio lub wideo.

Do upowszechnienia cyfrowej formy uwierzytelniania dokumentów przyczyniły się w niemałym stopniu niedawne lockdowny. W warunkach pracy zdalnej metoda elektroniczna bywała niejednokrotnie jedyną drogą szybkiego, skutecznego potwierdzenia zawarcia umowy czy realizacji transakcji. Tak samo, jak wprowadzenie elektronicznego obiegu dokumentów dawało w okresie pandemicznym największą szansę zachowania ciągłości działania i zapewniało możliwość sprawnego funkcjonowania rozproszonego zespołu.

Doświadczenia nabyte przez firmy w tych warunkach stworzyły znaczący potencjał rynkowy do wykorzystania teraz i w przyszłości. Również przez integratorów, którzy w latach 2020–2021 zauważyli zdecydowany wzrost zainteresowania wdrożeniami systemów zarządzania obiegiem dokumentów. Teraz przyszła pora na ich dalsze rozwijanie i udoskona-

DRUKOWANIE, SKANOWANIE I ZARZĄDZANIE DOKUMENTAMI

22 VADEMECUM CRN czerwiec 2023

lanie oraz dostosowanie do warunków zyskującego na popularności modelu pracy hybrydowej.