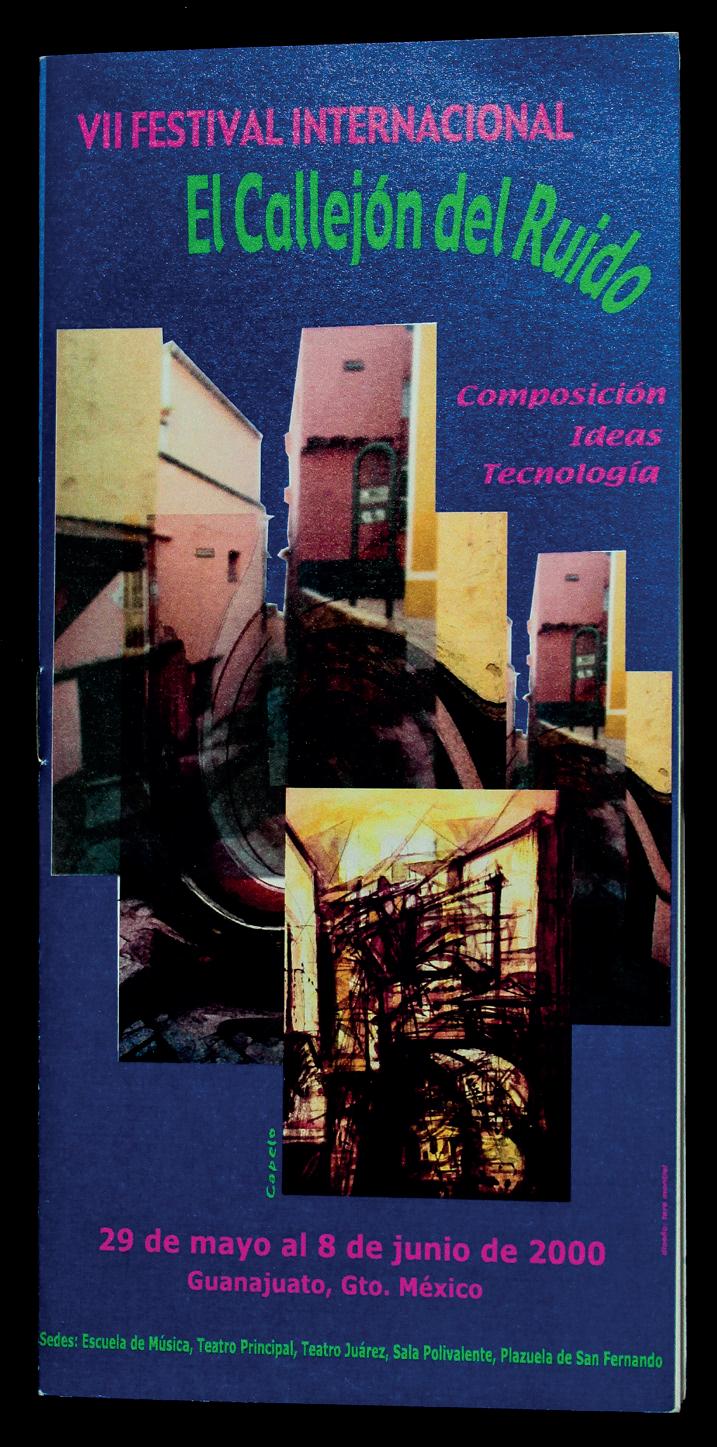

el callejón del ruido

Creación, ideas y TEcnología Resonancias e impacto (1994-2019)

el callejón del ruido

Creación, ideas y TEcnología Resonancias e impacto (1994-2019)

Roberto morales Manzanares Cynthia p. Villagómez oviedo editores

universidad de guanajuato campus guanajuato 2022

UNIVERSIDAD DE GUANAJUATO

Dr. Luis Felipe Guerrero Agripino RECTOR GENERAL

Dra. Teresita de Jesús Rendón Huerta Barrera RECTORA DEL CAMPUS GUANAJUATO

Dra. Claudia Gutiérrez Padilla SECRETARIA ACADÉMICA

Mtro. Gabriel Alejandro Andreu de Riquer COORDINADOR GENERAL DE DESARROLLO ACADÉMICO

Mtra. Rocío Ávalos Gómez COORDINADORA GENERAL DE APOYO ADMINISTRATIVO

Manuel Rocha Iturbide Roberto Cabezas Hernández Edmar Olivares Soria COMITÉ EDITORIAL

Roberto Morales Manzanares Cynthia P. Villagómez Oviedo EDITORES

Callejón del Ruido. Creación, ideas y tecnología, resonancias e impacto (1994-2019) Primera edición, 2022. De esta edición D. R. © Universidad de Guanajuato Lascuráin de Retana 5, zona centro. Guanajuato, Gto. 36000. Campus Guanajuato. Fraccionamiento 1 s/n. Col. El Establo. Guanajuato, Gto.

D. R. © Ediciones de las Sibilas Francisco Contreras 114, Loma Verde León, Gto., CP 37295

Diseño de portada: Cynthia P. Villagómez Oviedo Imagen en portada: Roberto Morales Manzanares Diseño gráfico y corrección de estilo de textos en español Juan José De Giovannini

Esta publicación fue realizada con apoyo del Campus Guanajuato de la Universidad de Guanajuato.

Impreso y hecho en México Printed and Made in Mexico

ISBN: 978-607-99379-9-7

Prohibida la reproducción total o parcial por cualquier medio sin la autorización por escrito del editor.

Los editores desean agradecer a los autores de esta edición. A todos los y las artistas participantes en las diversas ediciones de Callejón del Ruido. Gracias especiales a la Dra. Teresita de Jesús Rendón Huerta Barrera, por darnos la encomienda de realizar la presente edición. Asimismo, expresamos nuestro agradeciemien to al Comité Editorial: Manuel Rocha Iturbide, Edmar Olivares Soria y Roberto Cabezas Hernández.

15

Prólogo

SECCIÓN I

Historia y testimonios

reflexiones y memorias 1994-2019 Roberto Morales Manzanares

Palabras a mano libre Antonio Russek

ColaboraCiones Profundas en berkeley, California, Con el dr. roberto morales Adrian Freed reflexiones sobre el iniCio de un viaje musiCal Víctor Manuel Rivas Dávalos

liber amiCorum [libro de amigos] Luc Houtkamp

mi relaCión Con el festival internaCional el Callejón del ruido Emmanuel Ontiveros

SECCIÓN II

Arte sonoro y electrónico arritmia, el naCimiento de una máquina biomeCániCa Peter Bosch y Simone Simons la vibraCión y la resonanCia en la músiCa eleCtroaCústiCa y el arte sonoro Manuel Rocha Iturbide traslaCiones y resonanCias en “la voz oCulta de los objetos ” Fernando Vigueras ater vulture. videomaPPing / instalaCión Karina Álvarez Castillo

ProCesos de CreaCión e induCCión de emoCiones en el arte eleCtróniCo y el arte sonoro relaCionados Cynthia P. Villagómez Oviedo

Diseño de instrumentos y composición algorítmica

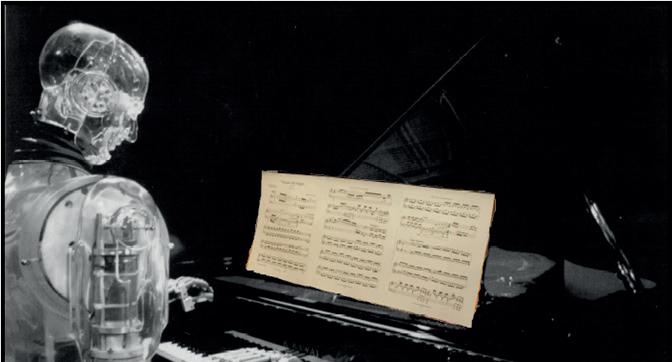

don CuCo el guaPo: un robot Pianista en el Callejón del ruido Alejandro Pedroza Meléndez

la músiCa es teCnología Cort Lippe

ComPosiCión algorítmiCa mediante modelos de reCurrenCia ProbabilístiCa Roger B. Dannenberg

algoritmos genétiCos Para la generaCión de datos simbóliCos y su imPlementaCión en max for live Francisco Colasanto y Jorge Rodrigo Sigal Sefchovich

CooPeraCión humano-máquina Para la CreaCión teCnológiCa Roberto Cabezas Hernández

siCib: sistema interaCtivo de ComPosiCion e imProvisaCion musiCal Para bailarines Roberto Morales Manzanares y Eduardo Morales Manzanares

aPliCaCiones aCtuales de redes neuronales y músiCa Edmar Olivares Soria

Creación, análisis y teoría

ComPosiCión algorítmiCa, ilustrada Por mi ProPia obra: una revisión del Periodo 1971-2021 Clarence Barlow

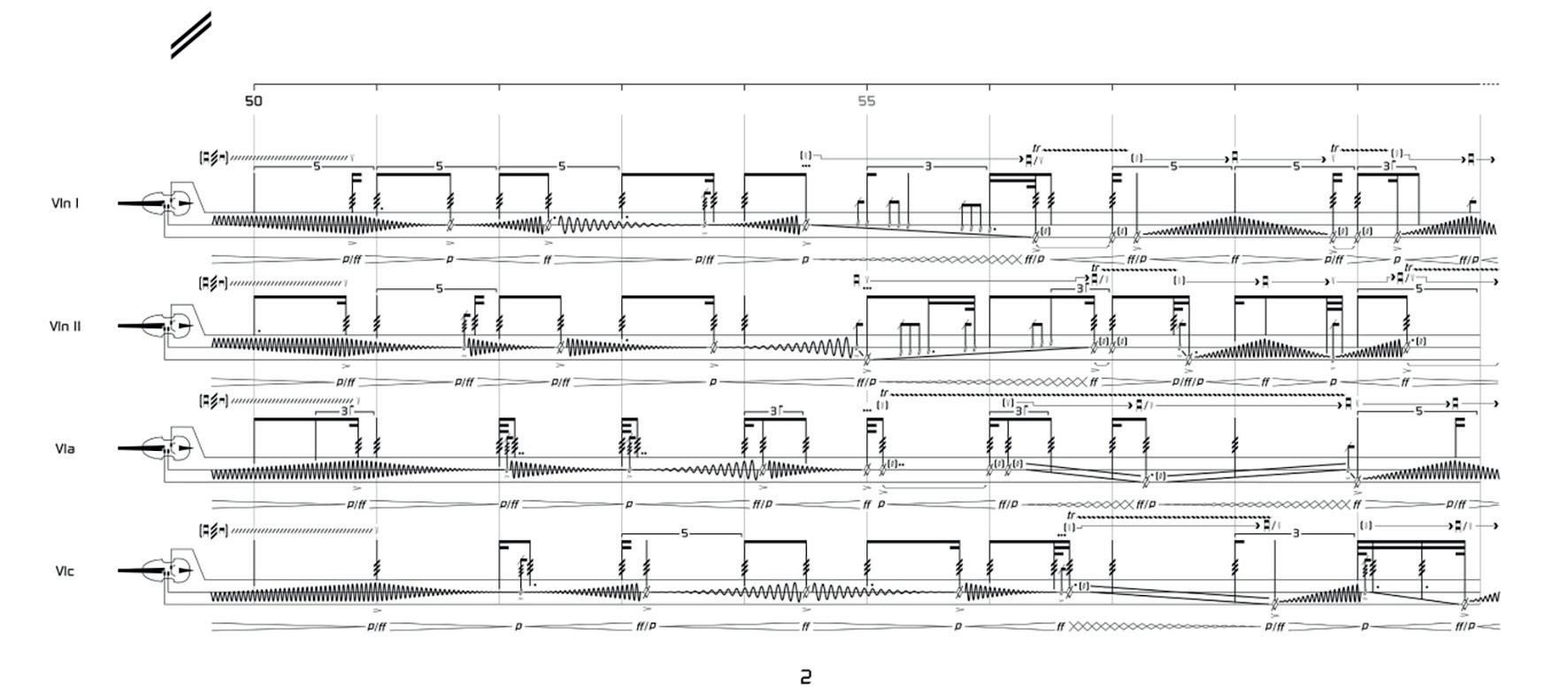

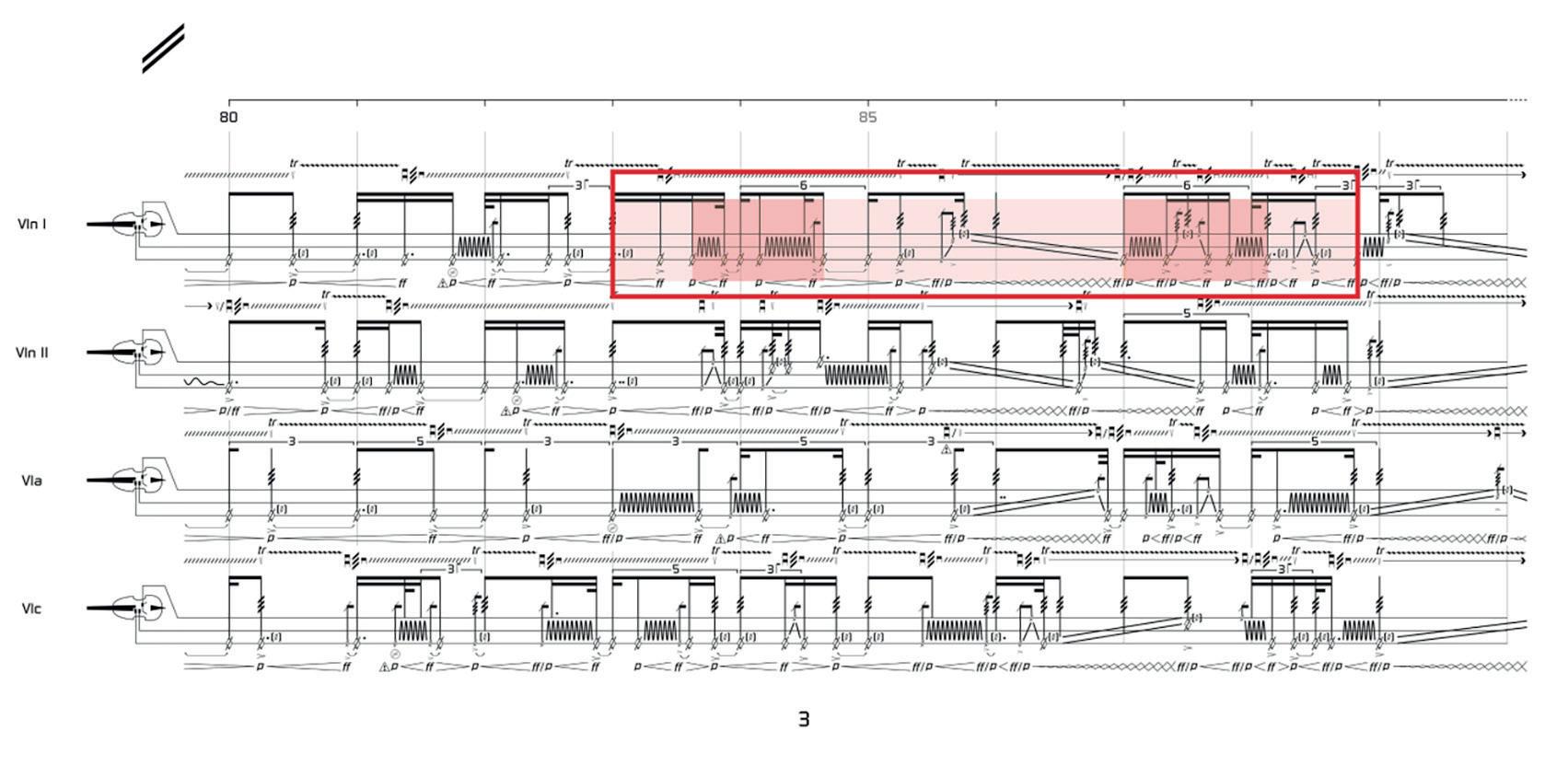

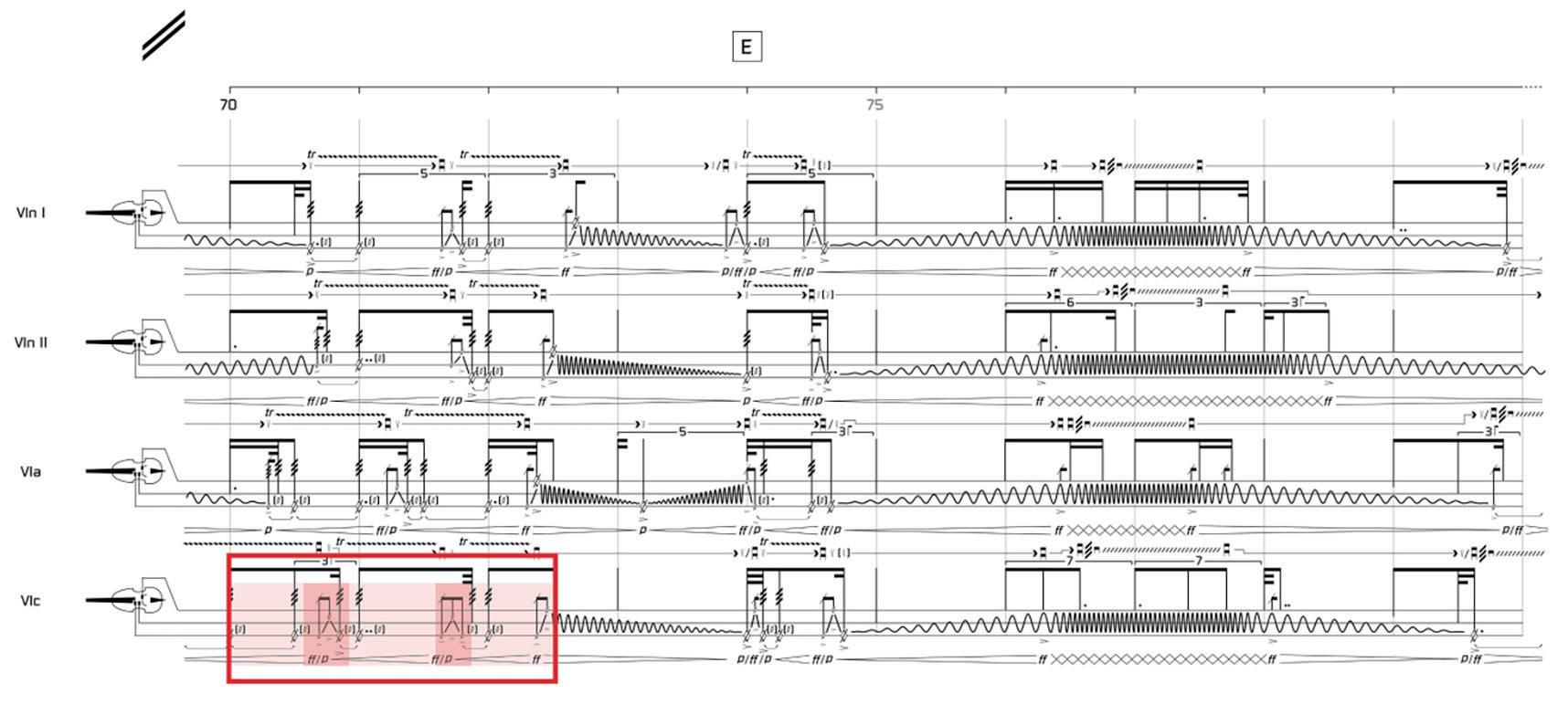

sendas entre teCnología digital y esCritura instrumental y voCal: de eua’on (1980), voz digitalizada, a eua’on’ome (1995), orquesta. Julio Estrada Velasco difusión de obras estereofóniCas Trevor Wishart fire at ChurCh Miller Puckette entre lo analógiCo y lo digital Miguel Ángel Reyna Martínez disCissum: sonoridades de segundo orden en la notaCión de músiCa instrumental Mauricio Rodríguez re-ComPoniendo la radio mexiCana Leigh Landy ePílogo anexos gráfiCos aCerCa de los autores el Callejón del ruido. Creation, ideas and teChnology resonanCes and imPaCt (1994-2019)

Alo largo de los siglos, el arte ha sido una de las manifestaciones huma nas más nobles, porque muestra las preocupaciones ontológicas más genuinas. Es precisamente en el arte, que el ser humano se ha expresado con aquellos recursos que han sido característicos de su época, siempre a través de diversas tecnologías. Desde la curiosidad de Leonardo Da Vinci, cuya exploración con nuevos recursos y medios favoreció la evolución de otras áreas del conocimiento humano, hasta nuestros días con la experimentación que llevan a cabo cientos de artistas electrónicos por todo el orbe; como en el caso que nos ocupa en el presente libro conmemorativo del festival El Callejón del Ruido en sus ediciones de 1994 a 2019, donde primó la ex perimentación sonora, la exploración del sonido con recursos tecnológicos, como también el rescate de música que forma parte de nuestro folclor, atípi ca combinación que cobra sentido cuando estas formas de expresión se unen para formar nuevos paisajes sonoros.

Por lo anterior, con seguridad se puede afirmar que El Callejón del Ruido es parte de un largo ejercicio de libertad artística y de un entorno provisto por la Universidad de Guanajuato, bajo el auspicio también de diversas instituciones. Un marco contextual onírico no libre de vicisitudes, si se tiene en cuenta que nuevas formas de interpretación de un campo determinado generarán un cisma que, no obstante, a la postre se pueda contribuir a la evolución del mismo campo, en este caso, del arte sonoro y su cruce transdisciplinar con otras áreas.

Es así que, El Callejón del Ruido fue un refugio para la libertad creado ra de decenas de músicos y artistas visuales que se presentaron durante el festival. Por lo que, con esta publicación se conmemoran catorce festivales realizados del año 1994 al año 2019, así como el enfoque transdisciplinar del mismo, donde se establecieron diálogos entre la música y otras disci plinas, tales como, las matemáticas —como primer acercamiento—, los ambientes de programación, la ingeniería electrónica, la física y las artes visuales, entre otras.

Se celebra también la incidencia positiva del Callejón del Ruido en la comunidad estudiantil, ya que a partir de él estudiantes de la Universidad de Guanajuato iniciaron una amplia producción de arte con el uso de tec nología; es el caso de Marcela Armas, Gilberto Esparza, Iván Puig y Karina Álvarez, actualmente reconocidos artistas contemporáneos mexicanos. El festival contribuyó también, a la formación de estudiantes en la creación musical con el uso de tecnología; algunos de los más destacados exponentes son, Mauricio Valdés San Emeterio, Marcos Bringas, Héctor Carranco, Em manuel Ontiveros, Víctor Rivas y Paul León Morales, hoy en día abocados a la experimentación sonora.

El Callejón del Ruido contribuyó también a la actualización de diversos programas educativos, no solo en la Universidad de Guanajuato, en donde se innovó en el pe de la Licenciatura en Música con cuatro niveles de la asigna tura de Laboratorio de Informática Musical, así como con las asignaturas de Composición Algorítmica y Acústica. Por otra parte, a raíz de las activida des realizadas en el festival, se implementaron las materias de Procesamiento de Sonido en Tiempo Real, así como la materia de Composición Algorít mica en el Posgrado en Música y Tecnología de la Universidad Nacional Autónoma de México (unam); de dicho posgrado, dos tesis desarrolladas en estos campos de conocimiento estuvieron nominadas a la prestigiosa Meda lla Alfonso Caso. Cabe mencionar que los autores de ambas tesis, a saber, Roberto Cabezas Hernández y Edmar Olivares Soria, son autores de dos capítulos en la presente edición.

En las siguientes páginas el lector encontrará textos de algunas de las figuras más destacadas del escenario del arte sonoro internacional y nacional actual, quienes nos comparten sus experiencias dentro de El Callejón del Ruido, así como sus procesos y prácticas artísticas, lo cual será oro moli

do para los nóveles estudiantes ávidos de conocimiento en torno de nuevas tendencias dentro del arte sonoro y electrónico, así como para todo aquel interesado en el arte, el sonido y sus procesos de creación.

Sea pues que el propósito del presente libro de El Callejón del Ruido. Creación, ideas y tecnología. Resonancias e impacto (1994-2019) se re frende como un referente de la historia del arte sonoro contemporáneo, así como un instrumento de apoyo pedagógico, empero y sobre todo, como tes timonio de todos aquellos que dirigieron devotamente, apoyaron de manera irrestricta, organizaron y participaron de manera entusiasta en el festival, evento excepcional donde se abrió una gran ventana a la experimentación y exploración artística, ventana que auguramos y esperamos permanezca abierta para las generaciones de artistas sonoros por venir.

Guanajuato, Gto., agosto de 2022

Roberto Morales Manzanares Cynthia P. Villagómez Oviedo Editores

El Callejón del Ruido nace en 1994 en una cena en casa del Dr. José Ángel Canavatti. En ese momento, él era di rector del cimat. Hablamos de música, de matemáticas y de las posibles con vergencias y divergencias entre ambas disciplinas. Convenimos que sería una buena idea realizar un festival-congreso para fomentar el diálogo entre la música y las matemáticas, así como su vínculo con otras áreas del conocimiento. Los que conocimos a José Ángel sabemos de su intempestivo carácter, en ese mo mento (9:00 pm aproximadamente) lla mó por teléfono el entonces Rector de la Universidad de Guanajuato, Lic. Juan Carlos Romero Hicks, para agendar una cita al día siguiente.

El Rector de nuestra universidad se entusiasmó de inmediato con la idea y arrancamos el proyecto. El cimat se encargaría de ofrecer sus espacios para conferencias, hospedaje y la alimenta ción de los invitados. La Universidad de Guanajuato por su parte, pondría todos los espacios disponibles para la realiza ción y difusión del evento.

Una vez concretados estos apoyos (¡en 2 días!) viajé a cdmx (antes Distrito Fe

deral) hacia la Coordinación Nacional de Música y Ópera y a lo que fue la ahora extinta oficina de Descentralización, ac tualmente Secretaría de Cultura.

En la Coordinación Nacional de Música y Ópera estaba como director el Mtro. Manuel De Elías. Como ante cedente, cabe señalar que el Mtro. De Elías creó el festival La Computadora y la Música, y nos invitó al Mtro. Fran cisco Núñez y a mí para participar en su realización en 1991.

Conociendo De Elías mi desempeño como organizador, le propuse el pro yecto de El Callejón del Ruido y dados los apoyos estatales y la dimensión del mismo, accedió a apoyarlo con el mon to económico que se usó para el festival La Computadora y la Música, aunado a la participación de los solistas y grupos artísticos que pertenecen a la Coordina ción Nacional de Música y Ópera. Esto dio como resultado la realización de un convenio anual con la Universidad de Guanajuato y la Coordinación, que es tuvo vigente hasta el 2004.

Por otro lado, en la oficina de Des centralización estaba como coordinador del programa el escritor y poeta Eduar do Langagne con quien colaboré en el Centro para el Estudio del Folclor

el Callejón del Ruido

Latinoamericano (Cefol) años atrás. Descentralización en ese entonces pro porcionaba recursos a los institutos es tatales de cultura, por lo que el proyec to fue muy bien recibido y también se comprometió a proporcionar un recurso económico anual vía el Instituto Estatal de la Cultura de Guanajuato para el pro yecto El Callejón del Ruido.

El apoyo de estas cuatro institucio nes (la Universidad de Guanajuato, el cimat, la Coordinación Nacional de Música y Ópera del inba y el Instituto Estatal de la Cultura de Guanajuato, vía Descentralización) me permitió gestio nar otras fuentes de apoyo y colabora ción para el festival: la Fundación Gau demus, Centro Multimedia y la Escuela Superior de Música, ambas del Centro Nacional de las Artes, así como univer sidades de Estados Unidos y Canadá.

El festival funcionó siempre con la colaboración de maestros y artistas tanto de la Universidad de Guanajuato como de universidades nacionales y extranje ras. La rotación anual entre los grupos de colaboradores tales como: curadores, compositores, artistas visuales y grupos artísticos, fue clave para mantener al fes tival fresco y con una visión actualizada del arte contemporáneo en cada edición.

Sí quisiera destacar aquí el entusias mo y apoyo del entonces director de Mú sica Armando López Valdivia, el papel absolutamente determinante del Mtro. Héctor Quintanar, ya que con su iniciati va de incluir a la Orquesta Sinfónica de la Universidad de Guanajuato en el Festival El Callejón del Ruido como parte de sus actividades sustantivas fue fundamental y por supuesto, la voluntad del Mtro. José Luis Castillo para respetar el acuerdo y no escatimar en la programación de obras contemporáneas para orquesta en las fe chas del festival.

Cabe mencionar que El Callejón del Ruido fue el primer festival en México que incorporó arte electrónico y el pri mero a escala mundial en realizar un con curso de composición algorítmica (esto fue en la segunda edición, en 1995, y en donde el ganador fue Cort Lippe).

En el 2001 realicé la edición número 8 y, terminando el festival, me fui a rea lizar mi doctorado a la Universidad de California, en Berkeley, Estados Unidos. Entre el 2002 y el 2004 el Mtro. Héc tor Quintanar siguió con el Festival Ca llejón del Ruido con tres ediciones, pero por desgracia ya no se pudo realizar en el 2005 y se perdieron todos los apoyos conseguidos desde 1994.

Eso creó un problema para poder re tomar el festival al momento de mi rein corporación a la Universidad de Guana juato en el 2006. Las instituciones que antiguamente daban su respaldo, ya se encontraban con otros intereses y polí ticas de apoyo cultural, incluida la Uni versidad de Guanajuato.

En el 2009 pude reanudar el festival por medio de la División de Arquitec tura Arte y Diseño (daad) del Campus Guanajuato. Por desgracia solo pudimos mantenerlo por ese año dados los re cortes presupuestales y el poco tiempo para reanudar apoyos locales, a pesar de haber tenido la colaboración de las Uni versidades de Stanford, uc San Diego de Estados Unidos y York de Inglaterra.

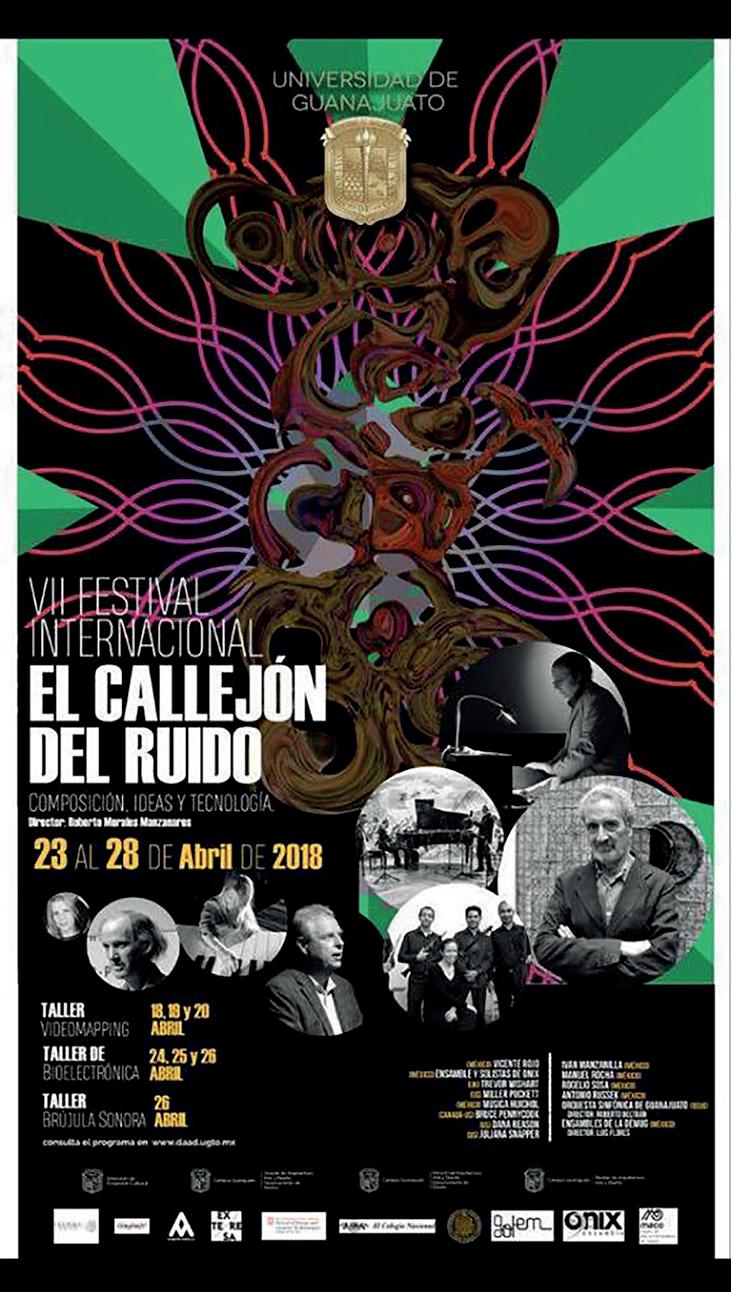

En el 2018 lo retomé de nuevo para las ediciones 2018 y 2019, con un gran apoyo por parte de Rectoría de Campus Guanajuato, la daad y Extensión Cultu ral. Pienso que pudimos haber crecido más ya que en la edición del 2019 tu vimos también apoyo por parte de los programas de coinversiones del Fonca.

En el 2019 propuse institucionalizar el festival para garantizar su continuidad

y afianzar un presupuesto institucional de acuerdo con los estatutos que men ciono más adelante.

El Callejón del Ruido nunca fue un fes tival de música contemporánea, en rea lidad tampoco obedecía a las caracterís ticas de un congreso. Era un festival en donde se programaba música contempo ránea pero también música tradicional de los pueblos originarios de México, arte electrónico, se exponían artículos y seminarios de música y matemáticas, sistemas de cómputo orientados a la mú sica y al arte en general, instalaciones, danza, artes visuales, fotografía y cocina. Mantuvimos siempre de manera sosteni da foros y mesas redondas de creación, fenómenos multidisciplinarios y estrate gias en gestión cultural.

El Callejón era un festival para la co munidad universitaria y el mundo. En este festival germinaron muchas ideas para la creación de obras, proyectos y el desarrollo de lo que es hoy la oferta de programas orientados a la música: Pd, Maxmsp, Nyquist, Audacity, SuperCo llider (la sección de Pbind, Pdefs, etc), Open Sound Control (osc), sicib y Es camol, por dar ejemplos tangibles.

Fue un festival con características únicas y escasas vistas en otros festivales o congresos.

Callejón era una fiesta de ideas e ini ciativas con un formato académico que a veces aparentaba ser irreverente ante los estereotipos convencionales. Siempre con propuestas de cara al futuro, como queda demostrado en su programación, e impacto en otras partes del mundo.

Tal vez el hecho de no estar cien por ciento orientado a la música contempo ránea o académica tipo siglo xix y xx,

y tener una orientación transdisciplinar causaba más ruido que su nombre para algunas personas.

Es claro e inevitable que el futuro está en formar cuadros con equipos multi disciplinarios, que la música puede estar sorprendentemente relacionada con más disciplinas y que éstas a su vez enrique cen y retroalimentan de manera crucial el quehacer musical contemporáneo. Convivir con cosmovisiones y estéticas diversas que demanda la composición en tiempo real (e. g. improvisación) con o sin tecnología, nos nutren de nuevas ideas y técnicas virtuosas novedosas, dignas de tomarse en cuenta para la renovación de planes de estudio tanto en interpretación como en creación musical y visual.

La música es universal y demostrarlo era algo fundamental para la formación de alumnos. Siempre fue para mí muy importante fomentar y mantener un diá logo estrecho entre alumnos, artistas e inventores de otros países.

Programar a grupos de música y danza de los pueblos originarios de Mé xico (huaves, camperos de Valles, jarana mixe, canto cardenche, etc.) lo consideré indispensable para que los alumnos tam bién cobraran conciencia de la riqueza con la que cuenta este país al respecto. Cabe mencionar que oficialmente exis ten 68 lenguas indígenas, cada una con su cosmovisión y enfoque artístico.

Otro aspecto importante que busca ba con El Callejón del Ruido fue mos trarle al alumno la posibilidad de situar se también en campos emergentes del conocimiento con enfoques multidisci plinarios y ampliar su espectro profesio nal en áreas alternativas, una vez egre sados de la Universidad de Guanajuato.

historia y testimonios

sección

el Callejón del Ruido

2. memorias el Callejón del ruido 1994- 2019

A continuación, enumero lo que con sidero son los estatutos y que fueron la columna vertebral del festival para su realización en los años 1994-2001, 2009 y 2018-2019.

El Callejón del Ruido. Creación, Ideas y Tecnología Guanajuato, Gto.

La Universidad de Guanajuato, a través de la Rectoría del Campus Guanajuato, la Dirección de Extensión Cultural, la División de Arquitectura Arte y Diseño (daad), el Departamento de Música de la Universidad de Guanajuato y el Labo ratorio de Informática Musical (lim) se comprometen a producir anualmente el Festival Internacional de Música y Arte Contemporáneo El Callejón del Ruido. Creación, Ideas y Tecnología, que se lle vará a cabo en la ciudad de Guanajuato como sede principal.

Los objetivos y compromisos del fes tival para con la comunidad universitaria, el estado de Guanajuato y el país son:

1. Presentar un mosaico actual y con temporáneo de las diversas tendencias teóricas y artísticas de la composición contemporánea y arte interactivo tanto de nuestro país como del resto del mundo.

2. Contar con la participación de per sonalidades destacadas en el mundo del arte Estas incluyen la creación musical contemporánea, tanto en el campo de la música acústica, como en el de la música por computadora y medios electrónicos, arte electrónico, escultura, pintura, fo tografía, danza e instalaciones.

3. Actualizar y estimular al medio artístico y científico del país en la crea

ción de obras artísticas e investigación, enfatizando de manera inmediata la par ticipación del personal académico de nuestra Universidad.

4. Académicamente, estas activida des deben complementar las asignatu ras teóricas y creativas, incluidas en las áreas de: composición, pedagogía mu sical, musicología, instrumentista, dan za, arquitectura, diseño, matemáticas e ingenierías que actualmente ofrece el Campus Guanajuato de la Universidad de Guanajuato; ya que las ponencias, los talleres y seminarios deben repre sentar el trabajo más avanzado de los investigadores y creadores más reco nocidos a nivel mundial, en los campos mencionados.

5. Es obligatorio incluir en la pro gramación a artistas de comunidades indígenas dada su diversidad y cosmo visión del mundo tan necesarias para el enriquecimiento y formación de nuestra comunidad universitaria

6. Culturalmente es primordial man tenerse como un referente en expresión musical y artística multidisciplinaria que aúnan el arte, las matemáticas, la ciencia y la tecnología, en nuestro país

7. El festival consistirá en uno o dos conciertos diarios, seminarios, ponen cias, clases magistrales y talleres acerca de tópicos relacionados con el queha cer del artista contemporáneo, entre los cuales destacan:

a) Composición con modelos algo rítmicos b) Tecnología en la música y mode los interactivos c) Composición y análisis de obras d) Diseño de instrumentos por com putadora e)Técnicas instrumentales contem poráneas f) Realidad virtual

i)

j) Performance

k) Danza

l) Exposiciones museográficas

8. Los conciertos abarcarán obras para solistas, ensambles de cámara y or questa sinfónica.

9. Con respecto a la danza, perfor mance, videomapping, instalaciones, etc., estos se presentarán en diversos recintos Universitarios y del Estado de Guanajua to, como museos, salas de exposiciones y locaciones al aire libre.

Como se puede observar, en estos objetivos se integran de manera natu ral las estrategias y metas planteadas en lo académico por el plan de desa rrollo institucional de agosto 2016, que comprende las funciones de do cencia, investigación, vinculación y extensión

Si observamos el enfoque de este artícu lo, solo menciona a las personas que fue

ron fundamentales para su nacimiento y continuidad.

Destaco en los lineamientos lo que considero representa ser un artista com pleto y legítimamente contemporáneo.

Compartir mi visión académica y ar tística deja en claro mi pasión hacia lo sonoro y tomo prestado de la ciencia el cuestionar siempre el absolutismo que ha representado la cultura occidental como único camino hacia la creación contemporánea y la ciencia.

Finalmente, mi mayor satisfacción fue ron el impacto causado y la resonancia que tuvo el festival para el mundo, la comuni dad universitaria y el público en general.

Con esta memoria quiero agradecer a todos los participantes de este sueño y los invito a ver los anexos que cuentan parte de la historia de quienes me ayuda ron a realizar este gran proyecto.

El diálogo, el respeto a la diversi dad artística-académica y la constante actualización del conocimiento serán siempre la fortaleza para ser mejores ar tistas y académicos.

Tengo la esperanza y casi la certeza de que nuestra institución hará eco de este proyecto.

historia y testimonios

sección

Con algunas excepciones, fui invitado re gular del Festival Internacional de Mú sica y Arte Contemporáneo El Callejón del Ruido. Soy testigo de su desarrollo desde la primera edición y compartí muy de cerca las complejidades de su realiza ción. Tuve el privilegio de estrenar obras participando en una gran cantidad de conciertos, conferencias, conversatorios y exposiciones, así como otras actividades del festival, pero no quiero, ni considero relevante, hacer un recuento puntual de todas ellas; esto no pretende ser una pu blicación académica así que me ahorro la lista con nombres, fechas y detalles.

Lo que dejo aquí son algunas pala bras escritas a mano libre para señalar y reconocer al amigo y colega Roberto Morales quien ha sido creador, director y principal gestor de El Callejón del Ruido, reconociendo también la labor de muchos otros colaboradores e insti tuciones involucradas en esta larga tra yectoria del festival.

Aprecio las buenas experiencias re unidas durante mis estancias en Gua najuato, lo nutritivo que resultaron las sesiones de trabajo, los ensayos, las po nencias de los colegas, la oportunidad de escuchar obras nuevas en concierto, conocer el trabajo de otros composito res, intérpretes, investigadores, artistas plásticos, fotógrafos, etc., que estuvie

ron presentes en las diferentes emisio nes... cómo olvidar a Donald Buchla, diseñador de los icónicos sintetizadores que llevan su nombre o a Miller Puck ette autor de max y Pure Data, software utilizado mundialmente. El nivel de los eventos en general se mantuvo alto, por igual, la convivencia con los participan tes durante las comidas; mención espe cial merecen las largas reuniones noc turnas en casa de Roberto, beneficiadas con bastante mezcal, poniéndonos al tanto de nuestras vidas.

Cuando inició lo del festival ya nos conocíamos bien, cabalgamos juntos en anteriores proyectos, asistí a su boda, nuestras familias crecieron juntas; con Vicente Rojo Cama, amigo y aliado, configuramos un trío de electrónica “en vivo”, ofreciendo conciertos con cier ta frecuencia. Creo que fue alrededor de 1980 cuando nos encontramos, en tonces él componía la música para una obra de teatro, Rey Lear, dirigida por Salvador Garcini.

Roberto dejó la carrera en la Escue la Superior de Música del inba, pero siempre inquieto aprendió a tocar varios instrumentos con una destreza inusual para la improvisación. Fue invitado al conjunto jarocho del Negro Ojeda to cando el arpa, flautas y otras monerías; con su hermano Rodrigo, bajista, poe

el Callejón del Ruido

ta y luego consejero electoral forma el grupo Alacrán del Cántaro, interesante fusión “etnocontempofreejazzista” re velando mejor sus abstracciones sonoras que inevitablemente desembarcaron en este asunto de la música “electroasústi ca”, como suele decir.

Memorables sesiones en mi estudio de la Condesa, ensayos en casa de su fa milia en Guayacahuala, Morelos, rodea da de bosque, con su sintetizador arp 2600 y yo con mi modular ensamblado con partes Serge, preparando una pieza que me comisionó el primer Festival del Centro Histórico.

Durante la gestión de Francisco Núñez al frente de la Escuela Supe rior de Música, termina su licenciatu ra y desempeña un papel directivo en la creación del Laboratorio de Música Electrónica, cuando se adquieren los primeros equipos se organizan cursos y se inicia una tendencia pionera en el uso de la informática musical. Ahí empieza el desarrollo de sus primeros autómatas. Se incorpora como docente a la Uni versidad de Guanajuato, introducien do un nuevo programa de estudios que pronto se cristaliza en un laboratorio de informática y electrónica en la Escuela de Música... ¡Jesús mil veces! La empre sa no estuvo excenta de dificultades, sin embargo, varios de los exalumnos de Roberto son ahora exponentes desta cados y en su momento fueron colabo radores incondicionales en la operación del festival El Callejón del Ruido. Viaja a California para estudios de postgrado estableciendo amistad y vínculos acadé micos con personajes que serían luego convocados al emergente festival, ase gurando su perfil internacional. Es justo

afirmar que las alianzas privadas y públi cas necesarias para su realización fueron producto de una estrategia delicada y constante con los patrocinadores, tam poco fueron pocas las dificultades para mantenerlas activas.

Mente ágil, humor agudo, dinámico y extrovertido, Roberto cuenta en su catálogo con obra para orquesta y otras dotaciones instrumentales, pero nunca declinó su pasión por el uso de la tec nología en su práctica diaria, diseñando y construyendo dispositivos de control para sus procesos interactivos. Se con virtió en un experto programador en plataformas de síntesis y procesamiento de sonido con sus propios códigos como para otras aplicaciones (SperCollider, max, Pure Data, etc.), asistiendo a sim posios y festivales internacionales. Es catedrático y sinodal del área de post grado en Música y Tecnología de la Fa cultad de Música de la unam, beneficia rio del Sistema Nacional de Creadores de Arte.

Es obvio que el presente testimonio está focalizado, es parcial, está matiza do por los afectos, por las experiencias compartidas, la amistad, la música y el amor al cable. También es probable que no cumpla con el formato apropiado y que los acontecimientos aquí citados no sucedieron en el orden expuesto, tam poco pretende ser una semblanza por que es amplia la cantidad y diversidad de las acciones realizadas por Roberto, pero El Callejón del Ruido ¡es una de las mejores!

Felicidad a todos los involucrados en esta memoria.

Cuernavaca, Morelos, 2022

Mucho antes de que los términos “pro vocaciones” e “innovación disruptiva” se hicieran populares, Roberto Morales empleó de forma productiva estas estra tegias en sus colaboraciones con noso tros en California en el Centro de Nue vas Tecnologías de la Música y el Audio (cnmat). Muchas de nuestras contribu ciones más significativas y reconocidas surgieron de nuestras respuestas a sus ambiciones y nos beneficiamos enorme mente al ver que estas contribuciones se pusieron en práctica en conciertos y simposios memorables. El valor de in tegrar a los colaboradores extranjeros en una comunidad de investigación es considerable. Pero algo en lo que quie ro centrarme y que está infravalorado y subestimado es lo que llamaré “valida ción externa”.

Está comprobado que las nuevas ideas, y sobre todo la nueva música, a menudo tienen dificultades para pros perar más allá de un círculo local, y a menudo son personas ajenas las que ca talizan su eventual crecimiento. Ejem plos musicales bien conocidos son el jazz, el blues, el r&b, el reggae y el hi phop, todos ellos validados y revigori

zados en algunas partes de Europa. Con la intensa atención que se presta actual mente al aprendizaje automático y la ia para las aplicaciones musicales, puede sorprender que a finales de los años setenta había pocas exploraciones de este tipo en Estados Unidos. Las apli caciones musicales no cobraron fuerza hasta que instituciones europeas como el ircam respaldaron y difundieron la ia del mit y el aprendizaje automático de los cibernautas británicos. Los pri meros experimentos en el ircam con el jazz, sobre lo que ahora llamamos “transferencia de estilo”, llevados a cabo por David Wessel, eran promete dores, pero estaban limitados por estar en gran medida fuera del tiempo real. La experimentación en profundidad de los sistemas de improvisación en tiem po real acababa de empezar cuando se dispuso de máquinas lo suficientemen te pequeñas y asequibles como para producir resultados satisfactorios. Los intentos de David Wessel de centrar el ircam en sistemas de control de ml en tiempo real se vieron frustrados en gran medida por su enfoque en el dsp lineal, inadecuado para el aprendizaje auto

el Callejón del Ruido

mático y la ia. Esto era algo que David Wessel y yo queríamos abordar cuando iniciamos el programa de investigación en el cnmat. Uno de los sistemas y do cumentos que nos inspiró y que supuso un apoyo temprano a nuestras ambicio nes fue el sicib de 1997, de Roberto Morales y su hermano Eduardo. Ahora es el aniversario 25 de ese trabajo, uno de los sistemas más sólidos para la im provisación en vivo que evolucionó a partir de las exploraciones de autómatas que Roberto comenzó en 1992.

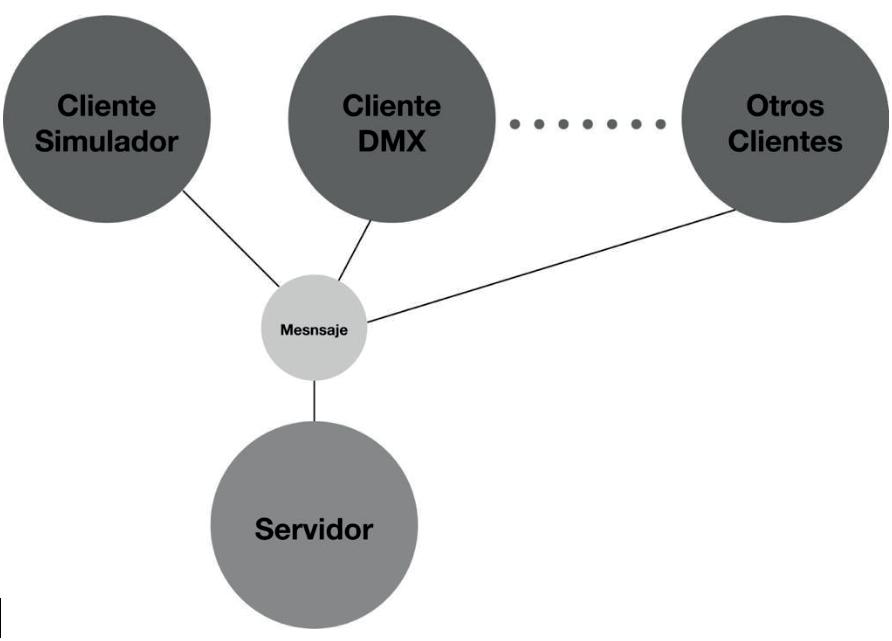

Conocí a Roberto en persona du rante su visita, en los primeros días del cnmat, en 1995 y nos pusimos a tra bajar en la configuración de nuestra infraestructura informática local para apoyar su trabajo. Esto implicaba com binar la única máquina que teníamos a mano que podía ejecutar Prolog (una estación de trabajo Sun) con la síntesis de sonido controlada por midi, media da por un Apple Macintosh. Aunque ya había trabajado en protocolos para este tipo de comunicaciones, ésta fue mi pri mera exploración de las comunicacio nes robustas en tiempo real utilizando Ethernet, algo que ya había sugerido en el ircam, que rechazó Ethernet en favor de una red de cable coaxial de fabrica ción propia. Elaboramos un protocolo sencillo que fue el precursor del trabajo posterior con Matt Wright y otros en lo que se convirtió en la codificación Open Sound Control (osc), la codificación re comendada de facto para la música en red y los controladores e instrumentos musicales digitales. Este protocolo cata lizó los primeros e influyentes grupos de interpretación en red, como The Hub.

El trabajo de aprendizaje automático influyó en muchos colegas del cnmat, incluido Georg Hajdu, que desarro lló Quintet.net. Nos alegramos mucho

cuando Roberto Morales regresó al cn mat para realizar sus estudios de doc torado. Sus compromisos con otros es tudiantes continuaron, como en 2003, cuando colaboró con Ali Momeni en un álbum de grabaciones. En 2005 retomamos otra vertiente de su traba jo, importante e influyente desde hace tiempo: la reintegración del movimiento y la música a través de la tecnología. La separación de la música, la danza y los rituales tradicionales en favor de formas concertantes estrechas y abstractas es una tendencia histórica clave de la músi ca artística y la danza contemporáneas (y no solo para la música occidental).

Roberto ya había trabajado en pie zas intermedias acoplando sistemas de medición inercial a los bailarines, así que, aprovechando la reciente miniatu rización de los sensores clave de la uc Berkeley (tecnología mems), construí un sistema de sensores ligero para acoplarlo a su flauta. Esto proporcionó dimensio nes adicionales de control mientras Ro berto actuaba y desarrolló sistemas de aprendizaje automático para utilizar flu jos integrados de información gestual y sonora. Con estos experimentos descu brimos que los acelerómetros son bue nos micrófonos de baja frecuencia, por lo que el filtrado de su salida producía un flujo de datos que marcaba los gestos de pulsación en el cuerpo de la flauta in dependientemente de los sonidos de la misma. Los primeros experimentos de Roberto con el sistema le llevaron a em plear el sensor como algo que se puede acoplar dinámicamente a los instrumen tos (mediante velcro) mientras se mueve entre sus instrumentos principales en la interpretación de una pieza.

Combinando este sistema con la sín tesis y el procesamiento de imágenes en tiempo real y fuera de línea, creó e in

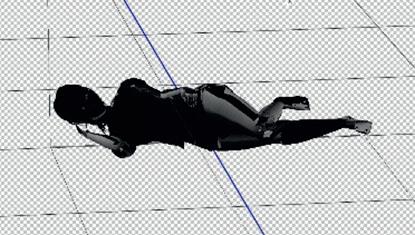

terpretó Cenzontle, una pieza que ganó un premio en Bourges en 2005 y que representa una de las primeras piezas in termedias en vivo del cnmat, un ejemplo estimulante y evocador para futuras inves tigaciones, composiciones e interpreta ciones. Presenté un análisis musicológico visual de esta pieza en una conferencia en Montreal. La integración de la detección inercial en sus actuaciones ha evoluciona do considerablemente y ha sido reconoci da con regularidad en conferencias y even tos internacionales como la conferencia nime, donde vi una actuación memorable en la que se emplearon sensores inalámbri cos Wiimote, por ejemplo.

Estos experimentos han influido en muchas actividades relacionadas en el cnmat, donde se han empleado regu larmente dispositivos como teléfonos móviles que incluyen sensores inercia les. Otro proyecto notable de 2005 en Berkeley consistió en la composición y síntesis con datos de Space Weather proporcionados por la nasa. Roberto fue uno de los primeros en adoptar el sistema SuperCollider y recordaba re gularmente a nuestra comunidad que había herramientas fuera del espacio MaxMSP que debían explorarse.

Cerraré este necesariamente breve recorrido por las ricas colaboraciones que disfrutamos en Berkeley con un punto de conexión personal especial. Desde que escuché las grabaciones de Son Jarocho de la arpista La Negra Graciana (que se hizo famosa en una edición discográfica de un concierto grabado en París), he sentido curiosidad por la vivacidad rítmica y la compleji dad de esta música. Hace veinte años el Son Jarocho apenas era conocido o estaba representado en el área de la ba hía de San Francisco, por lo que fue una deliciosa sorpresa descubrir que Rober

to no solo conocía la música sino que la tocaba muy bien, en arpa, jarana y per cusión. Se convirtió en un guía inestima ble mientras yo reunía grabaciones, es tudios accesibles limitados y una jarana para aprender los rudimentos. Mi viaje personal hacia la tradición y las perso nalidades también tuvo una profunda influencia en mi comprensión del ritmo y en la necesidad de elevar el listón para modelar los aspectos rítmicos de la mú sica, muy por encima de los conocidos enfoques lingüísticos estructuralistas o cognitivistas.

El son jarocho en su contexto tradi cional (el fandango) encarna la polimetría, el groove, el swing, la danza, el contraste rítmico, los cambios de compás y la tex tura de la interpretación (especialmente los rasgueos y paradas de la jarana). En el programa de investigación del cnmat he mos avanzado en el modelado y la com prensión de algunos de estos aspectos de la música, sobre todo con el doctorado de Vijay Iyer y el trabajo del Dr. Rober to Morales. Aunque gran parte del tono y el timbre está bastante bien modelado matemáticamente y en simulaciones por ordenador, todavía queda mucho por ha cer en lo que respecta al ritmo. Gran par te de mis progresos en este campo solo han sido posibles gracias a las ideas de las exploraciones e investigaciones cataliza das por Roberto, y este trabajo, al igual que nuestras otras colaboraciones, sigue dando frutos e impulsando nuestras cu riosidades y descubrimientos.

cnmat. (2005). Calendar Past Events. https://cnmat.org/Calendar/Past_ Events_2005.html cnmat. (2002). Calendar Past Events. https://cnmat.org/Calendar/Past_ Events_2002.html

historia y testimonios

sección

el Callejón del Ruido

cnmat. (25 de junio 2009). Mineral de Cata, Roberto Morales-Manzanares. https://cnmat.berkeley.edu/con tent/mineral-de-cata-roberto-mo rales-manzanares cnmat. (10 de noviembre 2005). Paral lel Worlds in Music. https://cn mat.berkeley.edu/content/paral lel-worlds-music

Morales, Roberto, Eduardo F. Morales y David Wessel. (s.f.). Combining Au dio and Gestures for a Real-Time Improviser. Stanford University. https://opensoundcontrol.stanford. edu/files/icmc05fin.pdf

Morales, R., E. Morales y L. E. Sucar. (2000). Integrating Bayesian Net

works with Logic Programs for Music. International Comput er Music Asociation(2000), s/p. https://quod.lib.umich.edu/i/icmc/ bbp2372.2000.195/1/--integrat ing-bayesian-networks-with-lo gic-programs-for-music?view=im age#end-of-header

Peticolas, Laura, Roberto Morales Man zanares, David Bithell, Nahide Craig, Janet Luhmann, Suart Bale. (2005). Space Weather Sonification for Sci entists, Educators and Musicians. American Geophysical Union, Spring Meeting.

Fue en agosto de 1995 cuando por primera vez asistí a un concierto de El Callejón del Ruido. Fui porque estaba anunciado en las mamparas de la Es cuela de Música que recién empezaba su ciclo escolar y yo acababa de lle gar a vivir a la ciudad de Guanajuato y también comenzaban mis estudios en dicha escuela; quise asistir como una forma de integrarme al plantel y sus actividades.

Esperaba que se tratara de un con cierto de música clásica o académica, de autores estilo Mozart, Beethoven, Bach, etc. En esa época mi relación con la música se basaba en lo más po pular, rock, pop, lo que se promovía en la televisión y radio comerciales, así que esperaba que este concierto fuera mi introducción al mundo de la música seria o académica, como dije anteriormente, y que de esta manera comenzara mi educación y formación cultural de una manera seria.

La cita fue en el Teatro Principal de la Universidad de Guanajuato, que se ubica en el centro de la ciudad. Dieron tercera llamada y se abre el telón. Apa recen en escena un piano, en seguida aparece el pianista y el público aplaude. Todo parecía “normal”, digámoslo así,

estaba presenciando el inicio de un con cierto de música “clásica”.

Grande fue mi sorpresa cuando el pianista comenzó a tocar. Empezó con unos acordes y melodías que, para mi oído sonaban, muy extrañas, como de safinadas, como sin sentido. Conforme avanzaba el concierto, la música se po nía más intensa. En cada obra que toca ba el artista, sonaban ritmos muy raros, irregulares, los acordes y melodías cada vez más complejas, hasta que de pron to, el pianista en vez de tocar las teclas, comenzó a tocar las cuerdas y demás maquinaria del cuerpo del piano, es de cir, se levantó del banco donde estaba sentado y se recargó hacia adelante de manera que sus manos manipulaban el arpa y las clavijas; en otro momento se desplazó hacia un lado del piano para tener un mejor alcance en la caja del instrumento.

En otra pieza, el pianista de plano ya no tocaba las teclas, sino literalmente las golpeaba, con la mano abierta y también con el puño. En ese momento el con cierto ya era una locura para mí porque el pianista se daba de sentones en el te clado, además de tocar timbres o dispo sitivos sonoros que estaban pegados al cuerpo del piano.

el Callejón del Ruido

Este concierto marcó en mi vida un antes y un después en la manera de abor dar la música. Se trataba del pianista ale mán Moritz Eggert.

A partir de este evento, comencé un viaje musical y de aprendizaje intenso, al ser espectador de piezas musicales que solo en El Callejón del Ruido, or ganizado y curado por el Dr. Roberto Morales, se podía presenciar; junto con el Laboratorio de Informática Musical, también dirigido por el Dr. Morales fue el combo sónico que me fue formando en mi carrera como artista sonoro, al estar en contacto con artistas y su obra

de la talla de Cort Lippe, Mari Kimu ra, George E. Lewis, Zack Settel, Ake Parmerud, Manuel Rocha, Antonio Russek, y muchos más.

Es admirable que festivales como El Callejón del Ruido e instituciones como el Laboratorio de Informática Musical hayan sobrevivido en una so ciedad tan conservadora como la gua najuatense y que a pesar del rechazo y críticas de mala fe, provenientes tanto de la comunidad artística como de la académica, se hayan podido mante ner de pie demostrando que la música siempre salva.

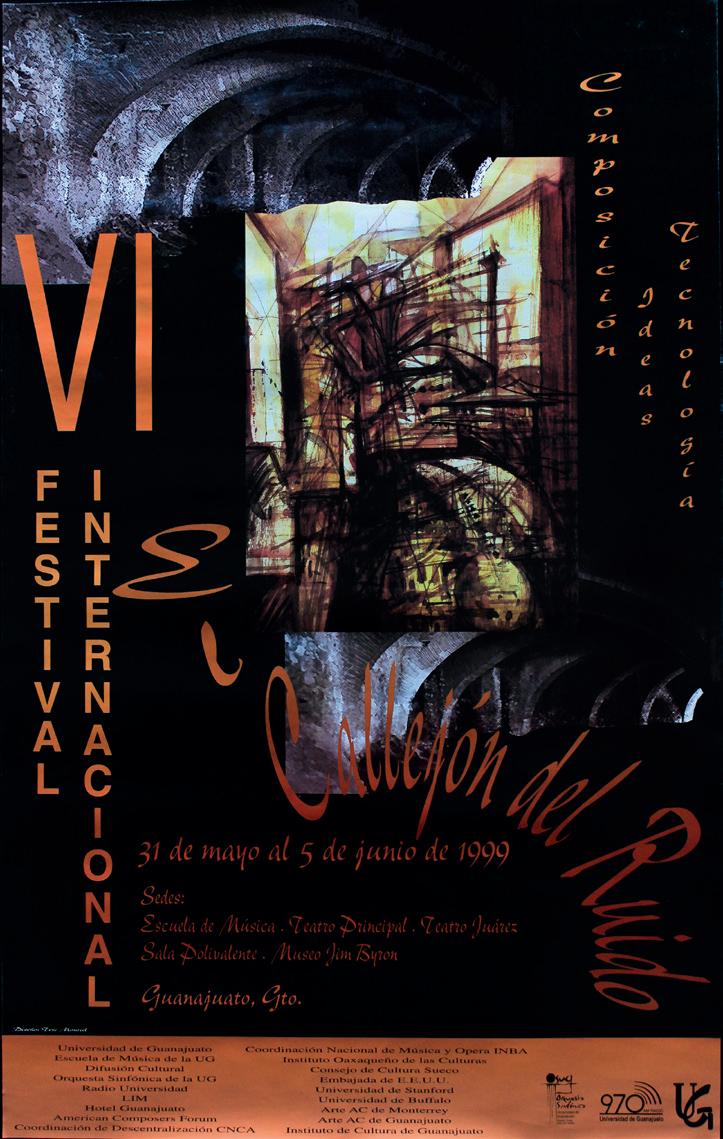

Recuerdos de principios de junio de 1996.

De camino a México. Me invitaron a un festival, llamado El Callejón del Ruido. La información que recibí fue muy breve, ya que fue una invitación de última hora. Me reservaron un vuelo al aeropuerto de Ciudad de México y me dieron la instrucción de que debía ir a la oficina de otra compañía aérea y recoger un boleto para dirigirme en un vuelo a otra ciudad. En el segundo boleto figu raba León como destino final, así que supuse que el festival sería allí.

Después de un largo día, por fin lle gué al destino. En la sala de llegadas miré a mi alrededor para ver a alguien con un cartel con mi nombre, el proce dimiento habitual cuando nos recogen a los músicos en un aeropuerto, ¡pero no había ningún cartel ni nadie buscándo me! Todas las demás personas salieron de la terminal, que volvió a estar vacía, excepto unos cuantos chicos jóvenes y tímidos. Al cabo de un rato, uno de ellos se acercó a mí y me dijo mi nombre. Pa recía que estaban allí para recogerme. Ninguno de ellos hablaba inglés, pero parecían muy contentos de haberme en

contrado. Me sonrieron durante todo el trayecto en coche, que terminó en Gua najuato. Ese parecía ser el destino final. En el hotel, pronto me dormí, agotado por el largo viaje.

A la mañana siguiente, me recogie ron y me llevaron a la universidad. Me recibió Roberto Morales, que era el organizador del festival El Callejón del Ruido. Una persona alta y muy cálida, y pronto comprendí que tenía un conoci miento increíble de la música contem poránea. Unas horas más tarde, conocí a las otras personas que actuaban en El Callejón del Ruido. Algunos viejos ami gos, como George E. Lewis, Clarence Barlow y el oboísta mexicano Roberto Kolb, a quien conocía de cuando estu diaba en el Real Conservatorio de La Haya; pero también hice rápidamente otros nuevos amigos, como Cort Lippe y Zack Settel. Roberto parecía haber in vitado a la crème de la crème del mundo de la música electrónica.

Fue una semana preciosa, con mu chas experiencias nuevas, llena de en cuentros, conciertos y talleres. Tam bién hubo grandes cenas, recuerdo una estupenda en casa de Roberto, la primera vez que comí un pollo con mole, el famoso pollo mexicano en

salsa de chocolate; pero la experiencia más grande fue un concierto en solita rio que di en San Francisco del Rin cón, un sombrío pueblo de la provin cia; esta vez estaba un poco nervioso, ya que estaba lejos del mundo seguro de la burbuja académica amante de la vanguardia en Guanajuato. Cuan do miré al público a través del telón, vi que la sala estaba llena de familias mexicanas, y me pregunté cómo res ponderían a mi música. Pero desde la primera nota que toqué, se concentra ron completamente en mi música y se podía haber escuchado el ruido de una aguja al caer. Un aplauso ovacionado sonó cuando terminé.

Después de la actuación hubo un debate con el público. El Gobernador del Estado subió al escenario, me abra zó y dijo al público que yo les había abierto los oídos. Luego, un hombre del público me pidió que le tocara una escala para saber si yo era un músico de verdad. Más tarde supe que era pro fesor de música en la escuela de músi

ca local. Le dije que podía, pero que no lo haría, porque no tenía nada que probar. El público se rio y le abucheó, diciéndole que debía dejar de hacer sus estúpidos comentarios. En el camino de regreso a Guanajuato, en la parte tra sera del coche, me sentí casi mareado por todas las grandes palabras que se habían dicho. Y esa noche, me dormí más feliz que nunca.

Desgraciadamente, Roberto y yo, después de esto, solo nos hemos visto un puñado de veces. Volví a Guanajua to y al festival en 2000, con Ensemble loos, y nos encontramos una vez más en La Haya, cuando ambos actuamos en el mismo festival; sigo agradecido por la experiencia que me diste de tocar en El Callejón del Ruido.

Te deseo que lo pases muy bien des pués de tu jubilación y espero que ten gas más tiempo para dedicarte a tu pro pia música.

12 de junio de 2022 Birgu, Malta

Mi acercamiento con el Festival Inter nacional El Callejón de Ruido ocurrió en el año 2000, un año antes de llegar a estudiar a la escuela de música de la Universidad de Guanajuato. Tuve la oportunidad de venir a la ciudad de Guanajuato en fechas en las que se rea lizaba el festival y asistí a un par de con ciertos, aunque ya sabía de su existencia antes de asistir por primera ya que tenía amigos que eran estudiantes de música y me contaban del mismo.

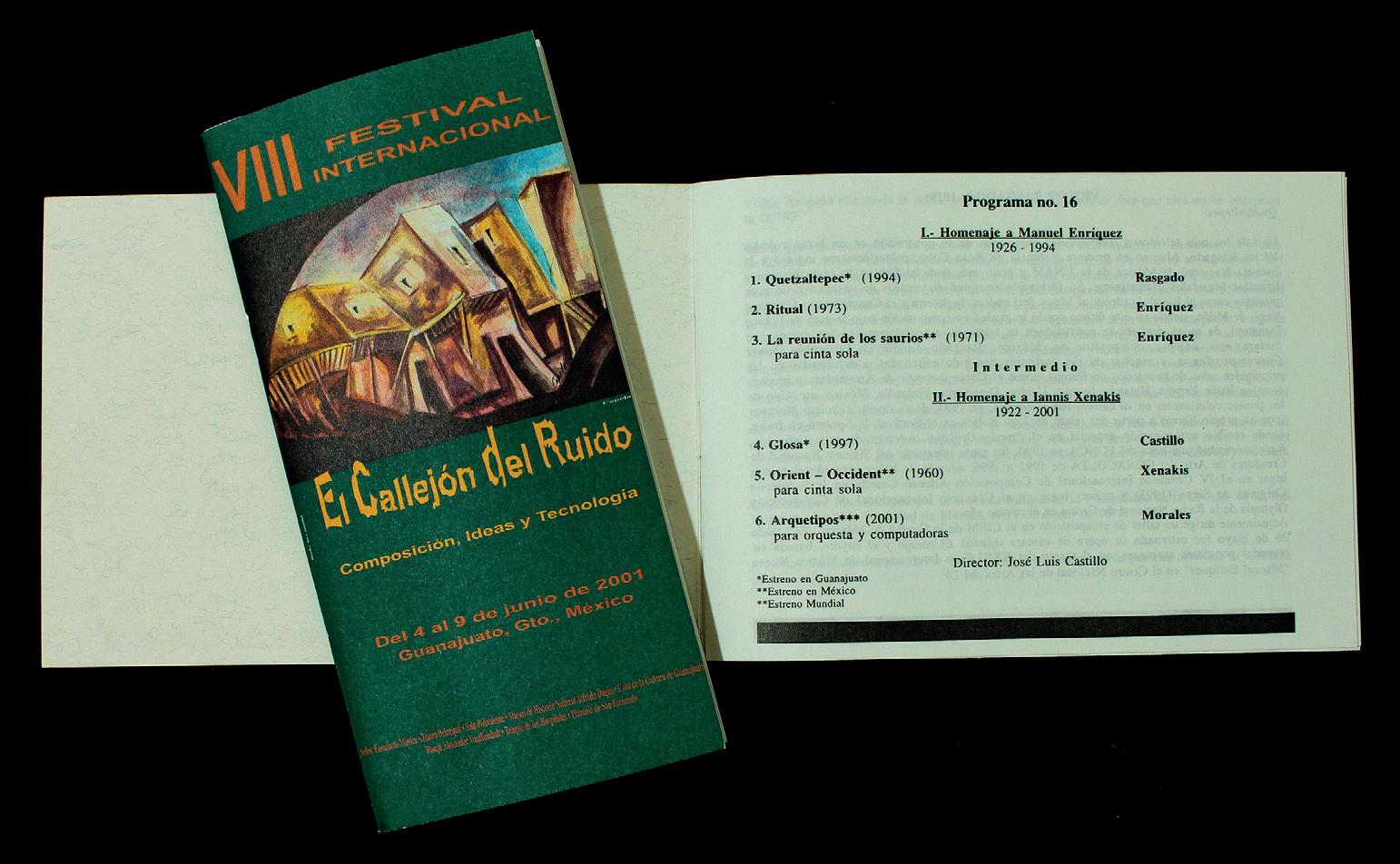

Cuando ingresé como estudiante de música en la Universidad de Guanajuato tuve la oportunidad, en mi primer año, de asistir al total de los conciertos; era su octava edición en el año 2001 y se realizó del 4 al 9 de junio. En ese mo mento el festival era dirigido por Ro berto Morales Manzanares y los conte nidos del festival estaban enfocados en la composición contemporánea y el uso de la tecnología.

Una parte que me sorprendió fue que dentro de la programación del festival había presencia tanto de compositores y artistas internacionales, como nacio nales y locales, y dentro de estos últi

mos había maestros y estudiantes de la Escuela de Música, cosa que me parecía muy enriquecedora debido a que, si eras estudiante, había la oportunidad de co nocer de cerca a los otros participantes que generalmente eran artistas mucho más experimentados, cosa que nutre cualquier artista en formación.

Cuando Roberto Morales dejó Gua najuato para ir a estudiar un doctorado en Estados Unidos, El Callejón del Rui do quedó bajo la dirección de Héctor Quintanar durante las siguientes edicio nes (IX, X y XI), en las cuales me integré al equipo de la organización del festival, por invitación de Quintanar. Lamenta blemente no hubo más ediciones en años posteriores.

El festival resurgió hasta que regresó Roberto Morales a Guanajuato y reali zó la edición de El Callejón del Ruido Fénix (no recuerdo si fue el año 2010) pero fue una edición aislada ya que por motivos de recursos no fue posible te ner continuidad. No fue sino hasta el año 2018 que el Callejón tuvo su tercer aire y en esta edición por invitación de Roberto, también tuve la oportunidad

el Callejón del Ruido

de participar en la organización y como artista, con el ensamble rorschach_3.0, grupo de música experimental confir mado por Benjamín Sánchez Lengeling, Paúl León Morales y yo.

En la última edición en la cual par ticipé tanto como parte del comité or ganizador y como compositor fue en el año 2019.

El tener este acercamiento con El Callejón del Ruido fue de mucho aprendizaje y posteriormente me dio la pauta para trabajar en otros festi vales como es el caso del Ciclo de Música Contemporánea del Festival Internacional Cervantino, al que pude integrarme debido a que su organiza dor, Ramón Montes de Oca, me vio

trabajando en el Callejón y me invito a ser parte de su equipo en el fic , donde laboré por 15 años.

Debido a que El Callejón del Ruido tuvo algunos años de ausencia, decidi mos emprender, en el 2014, la creación del Festival Ex_nihilo en colaboración con mis colegas Paúl León Morales, Jo sué Zamora y Ricardo Durán Barney.

Considero importante hacer men ción aquí del Cervantino y del festival Ex_nihilo ya que de alguna manera fue en El Callejón del Ruido en donde tuve mi primer acercamiento a la gestión, or ganización, planeación y ejecución de un festival de música y en donde apren dí a realizar el trabajo que un festival de esta índole requiere para su realización.

En este artículo describimos un pro ceso de exploraciones con aparatos in dustriales en un contexto artístico. Una práctica que se encuentra en todas las “máquinas musicales” que hemos cons truido desde 1990. Después de utilizar motores eléctricos durante más de dos décadas, comenzamos a examinar una fuente de vibración diferente en un ta ller auspiciado por naisa (New Ad ventures in Sound Art), como parte del Sound Travels Festival of Sound Art, realizado en Toronto en el año 2015. La combinación de una gran variedad de objetos y la creatividad de los parti cipantes nos ayudó a considerar futuras exploraciones de las posibilidades artís ticas de los pequeños vibradores rotati vos neumáticos diseñados originalmente para aplicaciones industriales. Último Esfuerzo Rural III-V (2017) ha sido la primera serie de trabajos en la que con tinuamos los descubrimientos realizados en el taller de 2015. Resultó que el he cho de no fijar en absoluto un vibrador al objeto en el que se coloca le permite desplazarse dentro de su mismo obje to, impulsado por su propia vibración, creando diferentes timbres y volúme

nes sonoros. Con el proyecto Arritmia (una colaboración con Sergey Kostyrko, 2019) los vibradores neumáticos adqui rieron una importancia creciente. Hasta ahora los habíamos utilizado sobre todo en estructuras temporales con dura ciones relativamente largas. Los breves tiempos de disparo utilizados en Arrit mia dieron lugar a un lenguaje sonoro completamente diferente de carácter más percusivo y, al mismo tiempo, or gánico; la combinación única de sonidos de aire que recuerdan a la respiración y el sonido meramente industrial de una bola metálica giratoria encajaba per fectamente en el puente que queríamos construir entre los fenómenos biológicos y la mecánica.

En muchas de nuestras “máquinas mu sicales”, la vibración y la resonancia son las nociones centrales que conducen a la complejidad del comportamiento y del resultado sonoro que hemos buscado durante muchos años. Nuestra fuente de vibración favorita es un motor eléctrico oscilante diseñado para fines industriales. Este tipo de motor es extremadamente fiable; sus frecuencias de oscilación pue

el Callejón del Ruido

den controlarse con precisión y se fijan fácilmente a un objeto. La forma en que incorporamos estos motores a nuestras construcciones no difiere mucho de la práctica industrial. Sin embargo, nues tro enfoque y objetivos son muy dife rentes; en la industria, estos motores son puramente funcionales, repetitivos y se utilizan para mover materiales en una dirección determinada, por ejemplo, pol vos, granos o, en las industrias mineras, incluso trozos de roca. En nuestro caso, el objetivo es mucho más abstracto; tal vez se resuma mejor como la creación de un sistema complejo que pueda ser apre ciado como arte. Al principio de nuestra carrera, en algún momento de la década de 1990, encontramos otra fuente de vi bración industrial en una feria industrial de los Países Bajos que nos llamó la aten ción: un pequeño vibrador neumático ro tativo. Estos vibradores consisten en una bola metálica que gira en una carcasa cir cular con una entrada y una salida de aire, donde la bola empieza a girar cuando se insufla aire comprimido en la entrada.

FiguRa 1. Vibrador neumáti co rotativo, OLI S10. Véase https://www.olivibra.com/ products/s-rotary-pneuma tic-vibrators-ball/

Conservamos un vibrador neumáti co durante años sin hacer mucho con él. Teníamos claro que sus propiedades di ferían mucho de las de nuestros vibrado res eléctricos. Estos actúan a frecuencias inferiores a la gama de audio y con una energía tal que son capaces de poner en movimiento construcciones pesadas como el que se aprecia en la obra Kracht gever (1994-98). El vibrador neumático oscila a una frecuencia mucho más alta (alrededor de 500 Hz) y con una fuerza relativamente pequeña; por estas razo nes no ofrece ningún resultado artístico satisfactorio cuando se utiliza del mismo modo que nuestros motores eléctricos. Si se fija de forma estática con bridas y tuercas, como se utiliza en la industria, se oirá su propia frecuencia de rota ción, pero las frecuencias de resonancia del cuerpo al que está unido se amor tiguarán más que se amplificarán. Tras varios ensayos infructuosos, el vibrador neumático quedó en el olvido hasta que fuimos invitados a impartir un taller en el Sound Travels Festival of Sound Art,

naisa Space, Toronto, 2015. Ahí reto mamos las pruebas del dispositivo neu mático y finalmente descubrimos otras formas mucho más inspiradoras de dar un uso nuevo y poco convencional a este aparato industrial. En este artícu lo relataremos los desarrollos posterio res, hasta la realización de nuestra obra Arritmia (2019), una colaboración con Sergey Kostyrko, físico y artista sonoro ruso afincado en San Petersburgo (véase: https://soundcloud.com/sergey-kostyr ko y https://vimeo.com/kostyrko).

taller de vibraCión y resonanCia en naisa (2015)

En 2015 nos invitaron a mostrar la obra Mirlitones (2012-13) en el Sound Travels Festival of Sound Art de To ronto (Bosch y Simons 2016) y a im partir un taller como parte de la serie Sound Travels Soundhackers Intensi ve.1 El simple hecho de que nuestros Mirlitones utilicen aire comprimido fue la principal motivación para sacar un vibrador neumático de la estantería y empezar a experimentar de nuevo. Toda la infraestructura de un compre sor, tubos de aire, válvulas y una inter faz estaría presente en Toronto, por lo que solo tendríamos que pedir a naisa que recogiera objetos metálicos para el taller, y traer unos cuantos vibradores. Ya habíamos llegado a la conclusión, en nuestro estudio, acerca de que la com binación de un objeto metálico con un vibrador que no está unido de forma rígida, sino con cierto juego entre el vibrador y el cuerpo resonante, podría producir una amplia escala de sonidos dentro de la gama del orden, el caos y el medio; nuestra área favorita. En el taller todo confluyó, la combinación de una gran variedad de objetos y la creativi

dad de los participantes dio lugar a una nueva serie de trabajos y nos ayudó a considerar futuras exploraciones de las posibilidades artísticas de un vibrador semifijo.

último esfuerzo rural iii-v(2017) Último Esfuerzo Rural III-V (2017) ha sido la primera serie de trabajos en los que hemos utilizado los descubri mientos realizados en el taller de 2015 con otra sencilla pero sustancial mejo ra. Resultó que no fijar el vibrador en absoluto producía excitaciones aún más interesantes. Para aumentar la movilidad del vibrador fijamos uno o dos pequeños muelles en los agujeros destinados a una fijación rígida. Como resultado, el vibra dor es capaz de excitar diferentes reso nancias del objeto en el que se mueve.

Conceptualmente, Último Esfuerzo Rural III-V es el tercer proyecto de una serie de obras inspiradas en la zona en la que vivimos, en el interior rural de Valencia, España. “No nos referimos al mito romántico de la vida rural, sino a algo así como una mente rural: el indivi duo que busca soluciones sencillas, pero creativas y lúdicas, a los problemas que se dan en el mundo que le rodea; un es tado de ánimo que está desapareciendo en nuestro mundo globalizado”.2

Durante muchos años hemos esta do coleccionando objetos antiguos de nuestra zona. Los objetos de Último Es fuerzo Rural III incluyen grandes sar tenes para hervir cebollas y embudos de hojalata, utilizados ya en la producción de embutidos, y aguamaniles para me dir diferentes cantidades de aceite de oliva. Una vez puestos en resonancia, nuestros objetos recuperan su valor ol vidado produciendo sonidos misteriosos e hipnóticos: un proceso por el que la

sección Ii / arte sonoro y electrónico

energía potencial de objetos antes signi ficativos, pero ahora muertos, se trans forma en una experiencia espiritual, al estimular sus frecuencias resonantes de una manera inusualmente impredecible y vívida. Los oyentes pueden elegir su propia perspectiva en el entorno sono ro creado por la instalación moviéndose por debajo de los objetos. También en el interior de los objetos se produce un comportamiento imprevisible: normal

mente este tipo de vibradores se montan firmemente con pernos, mientras que nosotros fijamos uno o dos muelles me tálicos debajo de cada uno. Esto permi te que los vibradores se muevan dentro de su objeto, impulsados por su propia vibración, creando diferentes timbres y volúmenes sonoros.

Último Esfuerzo Rural III se estre nó en la Feria de Arte justMAD, Ma drid, dentro de la exposición “EX4”, en febrero de 2017. En septiembre de 2017 realizamos una nueva versión in situ para el DA Fest en la Academia Nacional de Arte, Sofía, Bulgaria. Para este evento los objetos que utilizamos fueron suministrados por Venelin Shu relov, el director artístico del festival, todos procedentes de su abuelo de Jas na Poljana, un pueblo del sureste de Bulgaria. Fue notable que los objetos tuvieran mucho en común con los de nuestro propio pueblo en España, a

FiguRa 4. Último Esfuerzo Rural IV, DA Fest, Academia Nacional de Arte, Sofía, Bulgaria, 2017. Video en https://youtu.be/tEgNHLCPkOY

unos 3,000 km de distancia, y aún más satisfactorio que su sonido resultara aún más convincente, extrarreforzado por la impresionante reverberación del espacio expositivo. último intento minero (2019)

La idea de realizar una obra in situ con vibradores neumáticos como excitado res se continuó examinando con el pro yecto Último Intento Minero, encargado por el festival El Callejón del Ruido, Guanajuato, 2019. La idea inicial era utilizar objetos de la industria minera ya que Guanajuato es una ciudad con una historia muy larga de la explotación mi nera de oro y plata. Una vez allí, revisa mos nuestros planes y buscamos objetos sonoros en un “tiradero” o “basurero”, una gran sugerencia del director del fes tival, Roberto Morales. El resultado fue la incorporación de una gran variedad de objetos cotidianos a la obra, como una gran sartén para hervir tamales, una carretilla, una silla, un buzón y otros re cipientes.

Estos objetos no solo eran más varia dos sino también más grandes que los uti lizados anteriormente en la serie Último Esfuerzo Rural, y sobre todo producían sonidos extremadamente potentes. arritmia (Con sergey kostyrko, 2019)

Peter Bosch y Sergey Kostyrko se cono cieron por primera vez en el Seminario de Arte y Ciencia 9 Evenings Revisited, Kun-stKraftWerk, Leipzig, Alemania, 2016, organizado por Artsci Nexus. En este evento impartieron juntos un taller para niños refugiados de 5 a 10 años.

Desde entonces, las ideas para un proyecto común, impulsado por datos científicos, se habían discutido por co rreo electrónico, y cristalizaron en Arrit mia, estrenada en “Finding Affinities”, una exposición organizada por la Global Young Academy como parte de su décima reunión anual en el Kunstmuseum Mo ritzburg, Halle (Saale), Alemania, 2019 (véase: https://globalyoungacademy.net/ wp-content/uploads/2018/12/Pro gramme-AGM19-Guest.pdf).

arte sonoro y electrónico

sección

En las últimas décadas la investiga ción científica ha hecho grandes progre sos en la visualización de los procesos biológicos a nivel celular y subcelular. Las imágenes de video creadas en el Ins tituto de Citología de San Petersburgo por el Dr. Danila Bobkov y sus colegas constituyen el punto de partida de este proyecto. Su investigación utiliza la mi croscopía confocal de barrido láser para investigar el comportamiento de corazo nes de rata vivos aislados. Sus investiga

FiguRa 6. Último Intento Minero en la inauguración. El Callejón del Ruido, Guanajuato, 2019. Video en https://www. boschsimons.com/ ultimo-intento-mine ro-2019/?lang=es

FiguRa 5. En el tiradero, Guanajuato, 2019.

ciones se centran en el comportamiento arrítmico de los corazones de rata: cómo surge y cómo es posible prevenirlo. Sus investigaciones han demostrado que los factores químicos hacen que las células individuales latan con frecuencias arrít micas. El ruido de estas células arrít micas puede aumentar hasta afectar la frecuencia fundamental, provocando un latido irregular.3 4

Nuestro principal interés radica en convertir el comportamiento de un sis

tema biológico en patrones de sonido. Medimos el desplazamiento relativo en tre fotogramas de los videos de micros copía proporcionados. Los cambios en la dirección del movimiento se transforman en energía (aire) entregada a un vibrador neumático. Aplicamos un enfoque algo rítmico para gestionar las secuencias de video, reorganizando el material fílmico de forma aleatoria en películas collage

Cada vibrador está acoplado indivi dualmente a un “canal de video” espe cífico. Los diferentes comportamientos temporales de estos videos dan lugar a estructuras polirrítmicas únicas produ cidas por los vibradores. Cada canal de video se crea en tiempo real y se proyec ta en su propia pantalla.

Era un paso lógico probar cómo re accionarían nuestros vibradores neumá ticos ante los disparos derivados de las imágenes de video. Resultó que la com binación única de sonidos de aire que recuerdan a la respiración y el sonido meramente industrial de una bola metá lica giratoria encajaba perfectamente en el puente que queríamos construir entre los fenómenos biológicos y la mecánica. Hasta ahora habíamos utilizado los vi bradores sobre todo en estructuras tem porales con duraciones relativamente largas. Ahora, con estos disparos cortos, acabamos con un lenguaje sonoro com

pletamente diferente, de carácter más percusivo y, al mismo tiempo, orgánico.

En el diseño de las partes visibles de la instalación seleccionamos cuidadosa mente los componentes: vibradores de un diseño más bien prosaico e industrial; se colocaron en una variedad vívida y poé tica de jaulas que originalmente alberga ban animales vivos. Un contraste que in vita al espectador a reflexionar sobre los aspectos éticos del uso de animales en la investigación médica. Un objeto mecáni co normalmente sin vida se convierte en una especie de reliquia de lo que una vez fue una criatura viva, como los corazones de rata aislados en el entorno del labora torio, creando una metáfora audiovisual de una máquina biomecánica.

Sergey Kostyrko desarrolló la apli cación para el proyecto utilizando el lenguaje de programación Python. La aplicación analiza las imágenes de video en tiempo real, detecta los latidos de las células y activa los vibradores industria les. Para rastrear el latido de las células se utiliza un algoritmo de correlación de fase de la biblioteca OpenCV, que per mite medir el movimiento en un video. https://opencv.org/5

Cada uno de los cuatro microorde nadores Raspberry Pi 3 reproducen su propia secuencia de video, seleccionada arbitrariamente de una matriz compues

arte sonoro y electrónico

sección

FiguRa 7. Células del corazón. Imagen microscópica de Da nila Bobkov.

el Callejón del Ruido

FiguRa 8. Arrythmia, “Finding Affinities”, Kunstmuseum Moritzburg, Halle (Saale), Alemania, 2019. Video en https://youtu.be/nzo6xo3I_WQ

ta por entre 8 y 9 piezas. Cada uno ana liza el movimiento en el video y envía disparos a uno de los cuatro vibradores industriales según la pulsación detecta da también en un video. notas

1 Peter Bosch y Simone Simons. (2016). Mirlitones, a Fragile and Complex Sonorous System, eContact! 18.2, Canadian Electroa coustic Community. https://www.boschsi mons.com/mirlitones-2012-2013/?lang=es 2 (2005). “Our Music Machines”. Organised Sound 10/2, 103-110.

3 I. V. Kubasov, A. Stepanov, D. Bo bkov, P. B. Radwanski, M. A. Terpi lowski, M. Dobretsov y S. Gyorke. (Fe bruary 2018). Sub-cellular Electrical

Heterogeneity Revealed by Loose Patch Recording Reflects Differential Locali zation of Sarcolemmal Ion Channels in Intact Rat Hearts. Frontiers in Physio logy, 9, 61. https://www.researchgate. net/publication/323144504_Subcellu lar_Electrical_Heterogeneity_Revealed_ by_Loose_Patch_Recording_Reflects_ Differential_Localization_of_Sarcolem mal_Ion_Channels_in_Intact_Rat_Hearts

4 Gary Tse. (2016). “Mechanisms of Car diac Arrhythmias”. Journal of Arrhythmia 32, 75–81. https://www.researchgate.net/ publication/288003095_Mechanisms_of_ Cardiac_Arrhy hmias

5 Miloslav Druckmuller. (2009). Phase Co rrelation Method for the Alignment of To tal Solar Eclipse Images. The Astrophysical Journal, 706, 1605-1608.

Bosch & Simons. (1994-98). Krachtgever [Archivo de video]. https://www.boschsi mons.com/krachtgever/?lang=es Bosch & Simons. (2012-13). Mirlitones [Archivo de video]. https://www.bosch simons.com/mirlitones-2012-2013/?lan g=es

Bosch & Simons. (2017). Último Esfuerzo Rural III-V. [Archivo de video]. https:// www.boschsimons.com/ultimo-esfuer zo-rural-iii-2017/?lang=es

Bosch & Simons. (2019). Arritmia. [Ar chivo de video]. https://www.boschsimons. com/arrhythmia-2019/?lang=es Bosch & Simons. (2019). Último Intento Minero. [Archivo de video]. https://www. boschsimons.com/ultimo-intento-mine ro-2019/?lang=es

Este artículo se adaptó de un texto escrito para eContact!, Montreal. Agradecemos a Sergey Kostyrko, nuesto coautor en Arrit mia y a Ben Toth por revisar nuestro inglés.

sección Ii / arte sonoro y electrónico

En este ensayo hago una reflexión artísti ca acerca del fenómeno de la resonancia en la música y en el arte sonoro a partir de sus efectos físico acústicos en instru mentos musicales u otros cuerpos sóli dos, así como de las distintas técnicas de la música electroacústica, e incluso desde un nivel poético metafórico y conceptual, desdoblado tanto en la música electroa cústica como en la escultura y en la ins talación sonora. Esta reflexión está basada en las distintas técnicas o procedimientos creativos aplicadas/os en distintas obras electroacústicas y de arte sonoro que he desarrollado desde la última década del si glo pasado hasta el día de hoy. Mi interés por este fenómeno físico ligado a la vibra ción y a la expansión y retroalimentación de frecuencias, es que va más allá de las reglas e ideas tradicionales en la música y toca otros dominios que se relacionan de manera más íntimas con el sonido.

Resonancia, música electroacústica, arte sonoro, estética, transdisciplina.

Antes de la resonancia hubo vibración, y antes de la vibración movimiento. Algunos musicólogos europeos del siglo xx como Edgar Willems, pensaron que existía una evolución lineal en la música (Willems, Edgar 1977: p. 70). Primero hubo movi miento, y por lo tanto el ritmo se manifes tó en el cuerpo de los danzantes Africanos. Después hubo frecuencia, y por lo tanto la melodía, el campo emocional desarrollado al máximo en las inflexiones microtonales de la música asiática. Finalmente vino la armonía, el dominio vertical del pensa miento y de la inteligencia desarrollado en la música occidental Europea, comen zando con el contrapunto de los cantos gregorianos, luego el Ars Antiqua, el Ars Nova, el clavicordio bien temperado de Bach, hasta llegar a la armonía cromática del romanticismo tardío, y finalmente a la armonía extendida del siglo xx. Aunque esta visión occidental podría parecer co herente, es euro centrista, colonialista, y muy limitada en cuanto a nuestras capaci dades perceptivas.

el Callejón del Ruido

Para el compositor italiano Giacin to Scelsi: “La música no puede existir sin sonidos, pero el sonido existe sin la música […] El sonido tiene una ter cera dimensión: la profundidad y sus cualidades lo hacen esférico […] El que no penetre en el interior, en el cora zón del sonido, puede ser un artesano perfecto, un buen técnico, pero nunca un artista verdadero” (Scelsi G, 1985: p. 83).

La música electroacústica ha sido para muchos compositores un refugio de la teoría musical tradicional, una ma nera para experimentar directamente con el sonido y para ahondar en nues tra percepción de sus muchas y varia das cualidades. La resonancia es una de ellas, y en este breve ensayo intentaré desarrollar distintas ideas acerca de la cualidad inmersiva del sonido en rela ción a ella, a partir de mis experiencias creativas personales tanto en la música electroacústica como en el arte sonoro.

La resonancia no puede existir sin vi braciones. Scelsi estuvo influenciado por las filosofías orientales, y pensaba que “el sonido fue el primer movimien to de lo inmóvil, el comienzo de la crea ción” (Scelsi G, 1985: p.85). Entonces, tenemos sonido que es la misma cosa que la vibración y el movimiento. Estos dos elementos no pueden separarse, son lo mismo. Cotidianamente experimen tamos cómo los sonidos pueden mover cosas. En el siglo diecisiete, el físico Ro bert Hooke y más tarde en el siglo die ciocho Ernst Chladni, observaron cómo la harina y las partículas de arena se mo vían sobre una superficie sólida cuando la hacemos vibrar. Las diferentes reso nancias de estos materiales afectaban a

las partículas y las disponían creando distintas figuras geométricas.

El arte sonoro es un campo transdisci plinario que se ha vuelto muy popular en las últimas cuatro décadas, pero muchos artistas han experimentado con la vibra ción y el movimiento hace ya más de un siglo. Algunos artistas de las vanguardias de los comienzos del siglo xx exploraron la relación sinestésica del movimiento y el sonido, y muchos otros artistas la si guen explorando hoy en día. Mi primera experiencia en este territorio fue con mi escultura Ping-Roll en 1997, en don de alrededor de sesenta pelotas de ping pong son distribuidas de manera homo génea sobre una plancha de aluminio que tiene varios altavoces debajo de ella, y que emiten frecuencias de ondas sinusoi dales calculadas para hacer vibrar la plan cha. El efecto de estas vibraciones sobre las pelotas es que algunas de ellas rebotan en puntos fijos, mientras que otras se sa len de su órbita de rebotes para moverse rodando sobre la superficie. Hay un pro ceso largo en el que las distintas frecuen cias son transmitidas por los altavoces, y hacen que las pelotas se muevan cada vez que estas suenan, haciendo que se vayan formando configuraciones muy intere santes entre ellas; con el tiempo, poco a poco las pelotas se dirigen a distintas zonas entrópicas de la plancha en donde ya no podrán moverse más. El proceso se vuelve a repetir, no sin antes volver a distribuir las pelotas sobre la plancha de aluminio de manera homogénea (Rocha Iturbide, Manuel 2013: p. 136).

la resonanCia Como una vibraCión Continua. la retroalimentaCión y la amPlifiCaCión

La resonancia acústica es la capacidad de un cuerpo que vibra para responder a un

impulso o banda ancha de excitación de ruido. En la construcción de instrumen tos, los cuerpos acústicos están diseñados para expandir las resonancias de los soni dos por medio de amplificación y retroa limentación. Lo mismo sucede en la mú sica electroacústica, pero aquí usamos la retroalimentación algorítmica con filtros y otras técnicas como la de la convolu ción. Pero podemos imaginar otros tipos de resonancias que no afectan solamen te el cuerpo de un instrumento acústico o de un sonido convolucionado. En mi composición electroacústica La rama del tamarindo (2013) para dos pistas digita les, experimenté estirando los sonidos de distintos tambores afro colombianos (de alrededor de un segundo de duración), por medio de granulaciones temporales que los alargaban de 20 a 30 veces (20 a 30 segundos), y utilizando ventanas de lectura macro granulares de 370 milé simas de segundo. El resultado fue que las pequeñas resonancias de los tambores que surgen poco después del golpe sobre las membranas, se expanden en el tiempo de una manera muy peculiar, en donde la textura granular ruidosa del ataque se puede encontrar en un momento muy corto del comienzo, y luego se va con virtiendo poco a poco en una resonancia que cambia y se transmuta. Entonces, a partir de la extensión granular de un so nido, descubrí una idea nueva, la de una resonancia prolongada que transita en un continuum que va desde el ruido (ataque del tambor) hasta la resonancia pura (la última parte de la resonancia del sonido).

la resonanCia y las vibraCiones simPátiCas en el esPaCio

Este es un campo muy interesante en el que todavía hay mucho que decir y descubrir. Todos conocemos como las

estructuras de las cúpulas de grandes iglesias resuenan, y de hecho lo difí cil que es a veces tocar música en esos edificios debido al alto grado de rever beración. Es sorprendente lo poco que han pensado los músicos a través de los años en maneras particulares de com poner música para estos espacios. Por ejemplo, en una obra sonora de Pauli ne Oliveros en la que toca el acordeón, colaborando con Stuart Dempster en el trombón y Panaiotis cantando, los tres músicos improvisan en una cisterna gi gantesca tomando en cuenta la reverbe ración de 45 segundos que se da en el espacio, haciendo resonar los sonidos de sus instrumentos y creando un estatismo inmersivo.1

A través de los años, yo he experi mentado mucho con las distintas reso nancias y reverberaciones del sonido en distintos espacios, tocando música electroacústica en los patios coloniales mexicanos, iglesias, etc, no obstante, la experiencia de experimentar y descubrir las cualidades particulares de un espacio solo la he tenido al crear instalaciones sonoras, y lo que probablemente me ins piró para moverme en esa dirección fue la obra sonora conceptual de Alvin Lu cier I am sitting in a room (1970).

En el año 2003 colaboré con el ar tista mexicano Luciano Matus para rea lizar una intervención en la iglesia de San Agustín de la ciudad de México, dada en comodato a la UNAM y clausurada desde hacía años en el momento en que realizamos nuestra instalación. En Reco nocimiento del espacio, Luciano colocó distintas líneas de cable de nickel (que tienen el grueso y ancho de una cinta de casete) a través del espacio de la Igle sia, mientras que yo intervine cuatro de las cúpulas periféricas de la nave central para hacerlas resonar mediante frecuen

arte sonoro y electrónico

sección

el Callejón del Ruido

cias simpáticas a sus estructuras. La ma nera de hacer esto fue grabando distintos aplausos en cada una de las cúpulas, y lue go haciendo convoluciones de cada una de las resonancias obtenidas, con ruidos blancos largos y de manera recursiva, una y otra vez, hasta obtener las frecuencias resonantes más importantes (una especie de síntesis substractiva o de concentrado de caldo de pollo sónico) de los sonidos ocasionados por cada aplauso al interac tuar con cada una de las cúpulas. Final mente, hice sonar los sonidos resultantes de cada cúpula con cuatro altavoces dis puestos cada uno debajo de ellas (en el piso y apuntando hacia arriba), haciéndo las resonar de nuevo pero de una manera completamente nueva, al utilizar sus mis mas resonancias concentradas, obtenidas por medio de las convoluciones.

la resonanCia y otros tiPos de vibraCiones simPátiCas en la músiCa eleCtroaCústiCa

El concepto de simpatía puede ser ex tendido a otros campos. En la música electroacústica por ejemplo, podemos encontrar similitudes entre dos sonidos diferentes y crear un tercero que será un hibrido de los dos precedentes. Esta técnica se llama síntesis cruzada, y para mí, el sonido resultante de la mezcla de los espectros de dos sonidos es de algu na manera una “resonancia” de ellos. Es como un padre y una madre, primero se gustan porque resuenan sus personali dades, se conocen, son novios, y luego es posible que sean procreadores de un nuevo individuo que sería una mezcla de la resonancia de sus padres y de sus de más antepasados.

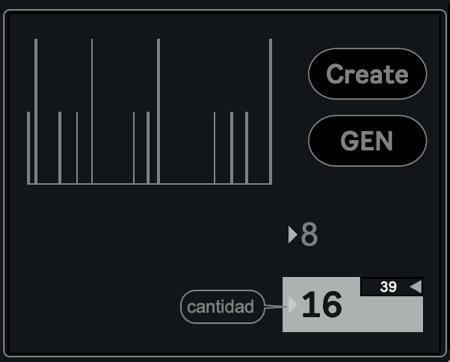

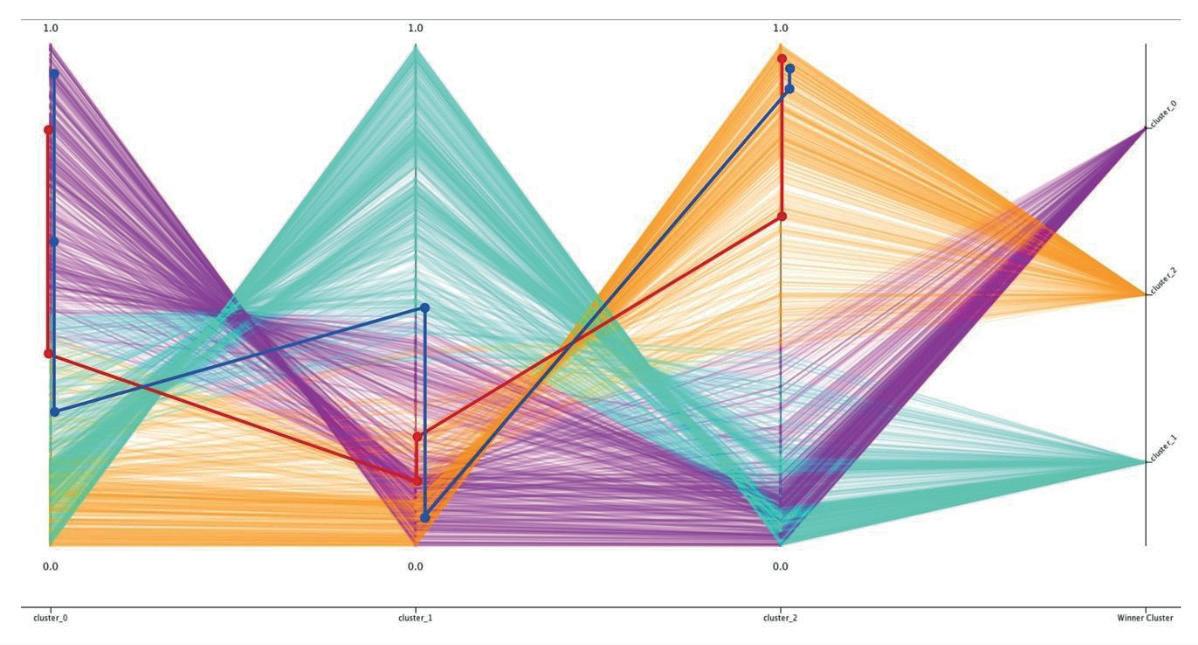

Gracias a las distintas cualidades de la síntesis cruzada podemos crear hibri daciones muy interesantes para producir