88 minute read

O Estado do conhecimento da Biodiversidade do Solo

from Amazônia 90

Solos globais sustentam a vida, mas o futuro parece “sombrio”. Leva milhares de anos para que os solos se formem: a proteção é necessária com urgência, dizem os cientistas

Fotos: FAO, ITPS, GSBI, SCBD e CE. 2020. E

Abiodiversidade do solo e o manejo sustentável do solo são pré-requisitos para o cumprimento de muitos dos Objetivos de Desenvolvimento Sustentável ”, disse a Subdiretora Geral da FAO Maria Helena Semedo. “Portanto, “ dados e informações sobre a biodiversidade do solo, do nível nacional ao global, são necessários para planejar com eficiência estratégias de manejo sobre um assunto ainda pouco conhecido”, acrescentou.

Biodiversidade abaixo

De acordo com o relatório, apesar do fato de a perda de biodiversidade estar na vanguarda das preocupações globais, a biodiversidade subterrânea não está recebendo o destaque que merece e precisa ser totalmente considerada ao planejar a melhor forma de impulsionar o desenvolvimento sustentável.

Mesmo que os organismos do solo desempenhem um papel crucial no aumento da produção de alimentos, melhorando dietas nutritivas, preservando a saúde humana e combatendo as mudanças climáticas, a real contribuição dessas minúsculas formas de vida permanece amplamente subestimada

“Esperamos que o conhecimento contido neste relatório facilite a avaliação do estado da biodiversidade do solo como parte integrante dos relatórios de biodiversidade em nível nacional e regional e de quaisquer levantamentos de solo”, avançou Semedo. Sendo um dos principais ‘reservatórios globais’ de biodiversidade, os solos hospedam mais de 25% da diversidade biológica mundial.

Além disso, mais de 40% dos organismos vivos nos ecossistemas terrestres estão associados aos solos durante seu ciclo de vida.

O relatório define a biodiversidade do solo como a variedade de vida subterrânea, desde genes e espécies animais, até as comunidades que eles formam, bem como os complexos ecológicos para os quais contribuem e aos quais pertencem; de micro-habitats de solo a paisagens. Isso inclui uma ampla gama de organismos, de formas unicelulares e microscópicas, a invertebrados, como nematódeos, minhocas, artrópodes e seus estágios larvais, bem como mamíferos, répteis e anfíbios que passam grande parte de sua vida abaixo do solo, e uma grande diversidade de algas e fungos.

O carbono orgânico do solo é crucial para a saúde do solo, fertilidade e serviços do ecossistema

Quase 90% dos organismos vivos vivem ou passam parte de suas vidas no solo

O uso excessivo e incorreto de agroquímicos continua sendo um dos principais fatores para a perda da biodiversidade do solo, reduzindo assim o potencial da biodiversidade do solo para uma agricultura sustentável e segurança alimentar.

Outras ameaças incluem desmatamento, urbanização, degradação da estrutura do solo, acidificação do solo, poluição, incêndios florestais, erosão e deslizamentos de terra, entre outros problemas, alerta a agência.

Solos e ação climática

Soluções baseadas na natureza envolvendo microrganismos do solo têm um potencial significativo para mitigar as mudanças climáticas. Eles desempenham um papel fundamental no sequestro de carbono e na redução das emissões de gases de efeito estufa. O relatório também descobriu que as atividades agrícolas são a maior fonte de gases de dióxido de carbono e óxido nitroso emitidos pelos solos, que derivam do uso excessivo ou incorreto de fertilizantes contendo nitrogênio.

Mantenha o solo vivo, proteja a biodiversidade

As plantas nutrem todo um mundo de criaturas no solo, observa a FAO, que, em troca, as alimentam e protegem. É essa comunidade diversa de organismos vivos que mantém o solo saudável e fértil, que constitui a biodiversidade do solo e determina os principais processos biogeoquímicos que tornam a vida possível na Terra.

Este ano, ao abordar os crescentes desafios da gestão do solo, a campanha da Organização para a Alimentação e Agricultura (FAO) “ Manter o solo vivo, proteger a biodiversidade do solo “ visa aumentar a consciência sobre a importância de sustentar ecossistemas saudáveis e o bem-estar humano. Ao incentivar as pessoas ao redor do mundo a se engajarem na melhoria proativa da saúde do solo, a campanha também visa a combater a perda da biodiversidade do solo.

Ameaças à biodiversidade do solo

Embora os solos sejam essenciais para o bem-estar humano e a sustentabilidade da vida no planeta, eles são ameaçados pela atividade humana, mudanças climáticas e desastres naturais.

Erosão do solo

Adoção de práticas sustentáveis de manejo do solo pelos agricultores, como premissa básica para a preservação da biodiversidade do solo, continua baixa devido à falta de suporte técnico

Mantenha o solo vivo, proteja a biodiversidade do solo

Etapas futuras

Geralmente, faltam dados detalhados, políticas e ações sobre a biodiversidade do solo em níveis local, nacional, regional e global.

O relatório destacou a necessidade de promover a mudança necessária para incluir indicadores biológicos de saúde do solo juntamente com indicadores físicos e químicos.

De acordo com o relatório, a adoção de práticas sustentáveis de manejo do solo pelos agricultores, como premissa básica para a preservação da biodiversidade do solo, continua baixa devido à falta de suporte técnico, oferta de incentivos e ambientes propícios, e precisa ser ampliada.

Um quarto de todas as espécies animais da Terra vive sob nossos pés e fornece os nutrientes para todos os alimentos. Os solos também armazenam tanto carbono quanto todas as plantas acima do solo e, portanto, são essenciais para lidar com a emergência climática. Mas também há grandes lacunas no conhecimento, de acordo com o relatório da Organização das Nações Unidas para Agricultura e Alimentação (FAO), que é o primeiro sobre o estado global da biodiversidade nos solos.

O relatório foi compilado por 300 cientistas, que descrevem o agravamento do estado dos solos tão importante quanto a crise climática e a destruição do mundo natural acima do solo. Crucialmente, leva milhares de anos para os solos se formarem, o que significa que é necessária uma proteção e restauração urgente dos solos restantes.

Os cientistas descrevem os solos como a pele do mundo vivo, vital, mas delgada e frágil, e facilmente danificada pela agricultura intensiva, destruição da floresta, poluição e aquecimento global.

Há cada vez mais atenção à importância da biodiversidade para a segurança alimentar e nutricional, especialmente a biodiversidade acima do solo, como plantas e animais. No entanto, menos atenção está sendo dada à biodiversidade sob nossos pés, a biodiversidade do solo, que impulsiona muitos processos que produzem alimentos ou purificam o solo e a água. Este relatório é o resultado de um processo inclusivo envolvendo mais de 300 cientistas de todo o mundo sob os auspícios da Parceria Global do Solo da FAO e seu Painel Técnico Intergovernamental sobre Solos, a Convenção sobre Diversidade Biológica, a Iniciativa Global de Biodiversidade do Solo e a Comissão. Apresenta de forma concisa o estado do conhecimento sobre a biodiversidade do solo, as ameaças a ela e as soluções que a biodiversidade do solo pode fornecer para problemas em diferentes campos.

Mapa genético do solo

Nova técnica de mapeamento mineral pode ajudar os agricultores a reduzir gastos com insumos e o impacto ambiental da produção

por *Domingos Zaparolli Fotos: Grupo de Pesquisa CSME/Unesp, Federação dos Cafeicultores do Cerrado

Amostras de solo para análise por difração de raios X em laboratório da Unesp de Jaboticabal

Um método inédito de mapeamento mineral de solo tem potencial de aperfeiçoar a agricultura em países de clima tropical. Elaborada por pesquisadores da Faculdade de Ciências Agrárias e Veterinárias da Universidade Estadual Paulista (FCAV-Unesp), campus de Jaboticabal (SP), a técnica utiliza o mapeamento magnético para determinar as características agronômicas e ambientais do solo. As informações obtidas são usadas para orientar os agricultores sobre as melhores áreas de plantio dos diferentes cultivares e a quantidade adequada de fertilizantes, corretivos e herbicidas a serem empregados em cada fração do terreno, o chamado talhão, reduzindo gastos com insumos e o impacto ambiental da produção. “Os solos não são iguais. Mesmo pequenas porções de terra que estão muito próximas podem apresentar composições físicas, químicas, biológicas e minerais diferentes”, explica o engenheiro- -agrônomo José Marques Júnior, líder do

Análise da composição do solo por fluorescência de raios X

grupo de pesquisa Caracterização do Solo para fins de Manejo Específico (CSME) da Unesp, responsável pelo desenvolvimento da nova técnica. Os solos de cultivo, informa o pesquisador, são formados por água, ar, matéria orgânica e minerais, sendo que os últimos respondem por aproximadamente 45% da composição total.

A mineralogia estuda o solo em suas frações nanométricas, as chamadas argilas, partículas minerais menores que 0,002 milímetro (mm). O objetivo é entender a capacidade do solo de reter e tornar disponível para as plantas nutrientes como fósforo, nitrogênio, potássio, cálcio e também água. Os pesquisadores comparam a caracterização mineral do solo com o sequenciamento do DNA de uma pessoa. “Assim como o DNA influencia as características humanas e de outras espécies, os diferentes tipos de minerais têm impacto sobre as características agronômicas e ambientais do solo”, define o engenheiro-agrônomo Diego Silva Siqueira, que fez mestrado e doutorado no grupo do CSME sob orientação de Marques Júnior. “A proposta é entregar ao agricultor uma espécie de mapa genético de sua área de plantio, que poderá ser usado para diferentes práticas agrícolas.” O mapeamento realizado pelo CSME faz a leitura dos minerais magnéticos que compõem o solo. Qualquer mudança na assinatura magnética da terra, explica Siqueira, expressa uma variação desses minerais e, consequentemente, de seu potencial agrícola e ambiental. “É uma técnica que se adéqua aos solos tropicais e subtropicais, que são abundantes em óxidos de ferro, alumínio e outros minerais com acentuada expressão magnética, funcionando como uma espécie de nanoímã, mas não se adapta tão bem ao

solo de países de clima temperado, que têm uma menor concentração desses minerais magnéticos e uma composição maior de argilas silicatadas”, detalha Marques Júnior. A leitura magnética já é empregada há décadas pela mineração e na indústria química, entre fabricantes de tintas e na engenharia de materiais sintéticos. O CSME ampliou a utilização da técnica para a agricultura em grandes áreas. A solução está sendo adotada por cafeicultores de Minas Gerais e produtores de cana-de-açúcar de São Paulo.

Em setembro de 2019, Siqueira e dois outros engenheiros-agrônomos, Gustavo Pollo, egresso do CSME, e Renan Gravena, uniram-se na formação da startup Quanticum, que oferece serviços de mapeamento magnético para áreas agrícolas. Eles obtiveram financiamento do programa Pesquisa Inovativa em Pequenas Empresas (Pipe) da FAPESP para um estudo sobre o mapeamento magnético na cafeicultura tropical. “O Brasil é responsável por um terço da produção mundial de café, mas não explora adequadamente o seu potencial no mercado de grãos especiais”, justifica Siqueira.

O mapeamento magnético despertou o interesse da Federação dos Cafeicultores do Cerrado Mineiro, entidade que reúne 4.500 produtores de Minas Gerais. “Ao longo do tempo aperfeiçoamos muito nosso conhecimento sobre os elementos que influenciam o terroir do café, como clima, altitude e regime hídrico. O mapeamento vai nos permitir aprofundar o entendimento do solo, que é um fator essencial para o cultivo”, conta Juliano Tarabal, superintendente da entidade. O terroir é a soma das características específicas de uma região agrícola, que permite a produção de uma bebida única.

“Um café produzido em um terroir nobre pode alcançar R$ 100 o quilo no supermercado, cerca de oito vezes mais do que um café convencional”, informa o executivo.

Segundo Tarabal, o mapeamento indicará as características de cada talhão e, ao realizar novos plantios, o cafeicultor poderá escolher a variedade da planta que se adapta melhor em cada faixa do solo. “Vamos garantir aos compradores as características exatas do grão entregue e certificar a origem da produção”, declara. Um primeiro produtor do município de Patrocínio, em Minas Gerais, já iniciou o uso da técnica. O café é uma cultura bianual e a avaliação é que se precise de pelo menos duas safras para uma análise adequada da experiência.

Na maior cooperativa de cafeicultores do mundo, a Cooxupé, que reúne 15,8 mil cooperados do sul de Minas e do interior de São Paulo, três associados mineiros realizam a experiência. Mário Ferraz de Araújo, gerente de desenvolvimento técnico da cooperativa, projeta que o mapeamento magnético permitirá ao produtor fazer a dosagem correta de fertilização e uma aplicação de herbicidas de acordo com a necessidade real de cada área plantada.

Segundo Araújo, atualmente o custo total de produção de cada hectare (ha) plantado de café da variedade arábica está entre R$ 8,5 mil e R$ 10 mil. Desse total, por volta de R$ 4 mil são gastos com fertilizantes e corretivos do solo. “Um uso mais racional de insumos tem potencial de melhorar significativamente o resultado financeiro da produção”, destaca. “Em um ano bom, 1 hectare gera por volta de 30 sacas de café e um faturamento na casa de R$ 15 mil. Em um ano ruim, R$ 10 mil. Fertilizantes e adubos levam 40% do faturamento do produtor”, analisa.

A caracterização mineral do solo reduz a quantidade das análises granulométrica, que indica os teores de areia, argila e silte (fragmento mineral com tamanho intermediário entre areia e argila), e química, que determina a acidez e a disponibilidade de nutrientes. “O mapeamento do solo permite definir quais áreas são heterogêneas e selecionar onde fazer a coleta para a análise química, reduzindo o número de coletas”, diz o engenheiro-agrônomo Alberto Vasconcellos Inda, coordenador do Programa de Pós-graduação em Ciência do Solo da Universidade Federal do Rio Grande do Sul (UFRGS).

Outro ganho é a qualificação da investigação química e física, permitindo a prescrição precisa dos nutrientes necessários na fertilização da área que receberá o plantio. “Quanto melhor a qualidade da informação, menor o risco do uso inadequado de insumos. A utilização excessiva de nutrientes na lavoura, como o nitrogênio, pode contaminar o lençol freático e os mananciais de superfície”, diz o agrônomo.Os estudos de caracterização do solo datam do fim do século XIX. A técnica mais conceituada, a difração de raios X (DRX), rendeu ao físico alemão Max von Laue (1879-1960) o Prêmio Nobel de Física de 1914.

Amostras com diferentes concentrações de ferro

Leitura de magnetismo do solo com uso de susceptibilímetros

Na Usina São Martinho

O grau de precisão do DRX é de 95%, o que os mineralogistas classificam como padrão ouro. Outros métodos empregados na caracterização são a espectroscopia de Mössbauer, que utiliza a radiação gama, e as análises termodiferencial (ATD) e termogravimétrica (ATG). Essas quatro técnicas apresentam resultados superiores a 85%. Todas elas, porém, têm três problemas em comum: são caras, demandam tempo e exigem profissionais altamente qualificados na operação dos equipamentos. Segundo Alberto Inda, esses problemas dificultaram a ampla utilização dessas tecnologias na agricultura tropical e subtropical.

Cada teste de difração de raios X analisa apenas um mineral por um custo médio de R$ 300, segundo levantamento mercadológico feito pela Quanticum. Uma amostra de solo típica do Brasil contém mais de 10 minerais que, mesmo em pequenas quantidades, impactam o potencial agronômico da terra. Considerando as metodologias tradicionais, de acordo com Siqueira, são necessários mais de R$ 2 mil para elaboração de um laudo que mostre os tipos e as quantidades de minerais em um único ponto amostral. O inventário de uma área agrícola de mil ha, coletando-se uma amostra de solo por hectare, não sai por menos de R$ 2 milhões.

A Quanticum realiza a leitura dos minerais por meio de sensores de medição de susceptibilidade magnética, os susceptibilímetros. Uma única leitura verifica os principais minerais presentes na amostra. O custo do laudo técnico varia de R$ 5 a R$ 30 por ha, dependendo do nível de detalhe e de outras informações, como a recomendação de fontes de adubo. “Em relação às técnicas consideradas padrão ouro, o resultado obtido tem precisão 15% a 20% menor, mas custo bem mais acessível ao agricultor”, afirma Diego Siqueira. O ideal é que o mapeamento magnético seja repetido nos anos seguintes, mas sempre com uma quantidade de amostra menor – por volta de 40% menos.

Depois desse acompanhamento inicial, a indicação é fazer uma análise pontual, com a coleta de uma amostra de terra direcionada a atender alguma situação específica, como uma área de plantio que vai receber um novo cultivar ou um talhão que sofreu forte compactação. A Usina São Martinho, uma das maiores produtoras e processadoras de cana-de-açúcar do mundo, foi a pioneira no uso da técnica no manejo da lavoura canavieira, já tendo mapeado todos os 80 mil ha de sua unidade em Pradópolis, no interior paulista. O trabalho foi desenvolvido por uma equipe de funcionários que foram graduandos ou pós-graduandos na FCAV-Unesp de Jaboticabal e integravam o grupo de pesquisa CSME.

Para o gerente agrícola da usina, Luís Gustavo Teixeira, o mapeamento magnético permite conhecer o solo em detalhes e fazer um manejo ainda mais eficiente e um uso ainda mais racional dos insumos, contribuindo para os ganhos de produtividade e a sustentabilidade ambiental da operação. A caracterização do solo obtido com o mapa magnético é usada não apenas para determinar as características do solo.

A técnica tem ajudado a São Martinho a identificar as áreas da lavoura de cana com diferentes potenciais de compactação e assim orientar o manejo desses talhões.Teixeira explica que os solos podem ser compactados tanto por fontes naturais, como o impacto das gotas de chuva, quanto pela ação do homem no ambiente, como o tráfego de máquinas agrícolas. A compactação dificulta o desenvolvimento das plantas, reduzindo o potencial produtivo da área. Por isso, é necessário realizar de tempos em tempos a operação de descompactação, com equipamentos subsoladores, que geralmente trabalham em uma profundidade fixa. A leitura magnética auxilia na identificação da profundidade da camada compactada. “A informação precisa gera ganhos em eficiência, com redução de custos operacionais, em combustíveis por exemplo, e uma melhor conservação do solo”, relata o gerente da São Martinho.

José Marques Júnior cita dados da agência da Organização das Nações Unidas para a Alimentação e Agricultura (FAO) para lembrar que o impacto econômico causado por manejo inadequado do solo apresenta um custo anual de US$ 70 por pessoa no mundo. Um valor que poderia, em sua análise, ser substancialmente reduzido com um conhecimento detalhado das áreas agrícolas. A FAO também estima que a produção de alimentos no mundo terá que aumentar em 70% para alimentar de forma adequada uma população estimada em quase 9,8 bilhões de pessoas em 2050. O Brasil deverá ser responsável por 40% do aumento da produção, segundo a FAO. Para Marques Júnior, o país pode atingir essa meta sem a abertura de novas fronteiras agrícolas na Amazônia, no Pantanal ou na Mata Atlântica. “Hoje temos mais de 100 milhões de hectares que já foram ocupados e depois abandonados por falta de conhecimento adequado do solo”, destaca.

[*] Revista Pesquisa Fapesp

Secagem de café em Minas Gerais: produtores do estado já estão usando o mapeamento mineral do solo em suas propriedades

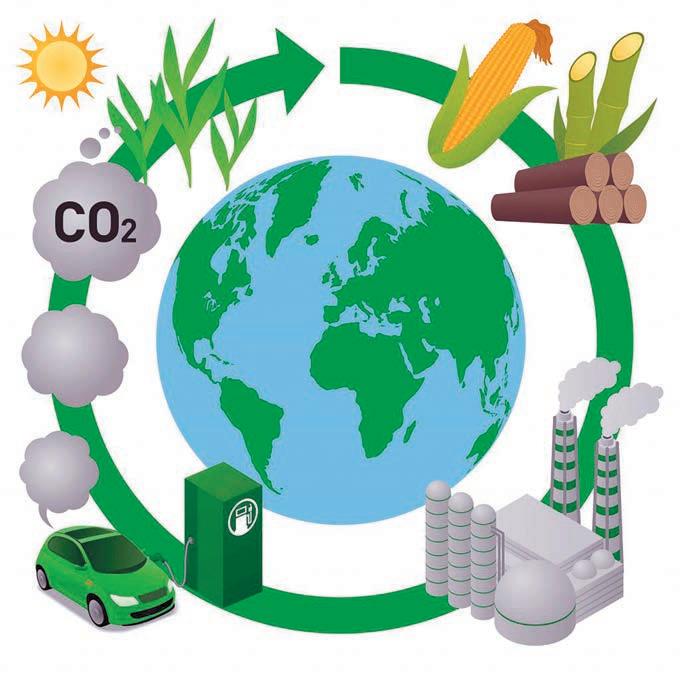

Cientistas criam combustíveis a partir de plantas

Biocombustíveis avançados mostram uma promessa real para substituir alguns combustíveis fósseis

Fotos: Ciência em HD via Unsplash

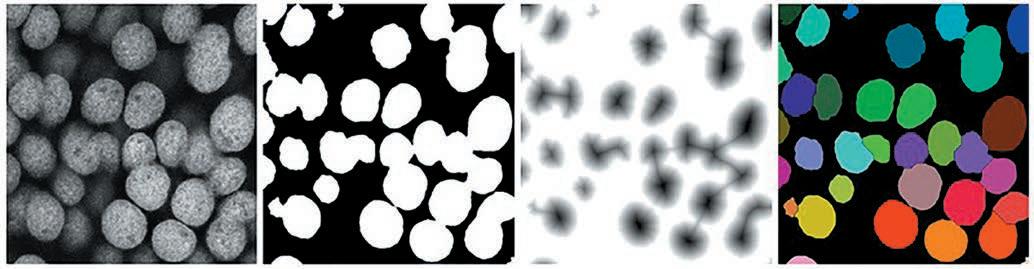

No cerne de sua descoberta: um método mais simples e menos caro para criar as ‘moléculas auxiliares’ que permitem que o carbono nas células seja transformado em energia. Essas moléculas auxiliares (que os químicos chamam de cofatores) são o dinucleotídeo adenina nicotinamida (NADH) e seu derivado (NADPH).

Esses cofatores em suas formas reduzidas são há muito conhecidos por serem uma parte fundamental na transformação do açúcar das plantas em butanol ou etanol para combustíveis. Ambos os cofatores também desempenham um papel importante na desaceleração do metabolismo das células cancerosas e têm sido alvo de tratamento para alguns tipos de câncer.

Mas o NADH e o NADPH são caros

Uma nova descoberta pode tornar a produção de biocombustíveis mais econômica

“Se você puder cortar o custo de produção pela metade, isso tornaria os biocombustíveis um aditivo muito atraente para fazer combustíveis flex com gasolina”, disse Vish Subramaniam, autor sênior do artigo e professor de engenharia recentemente aposentado da Ohio State. “O butanol muitas vezes não é usado como aditivo porque não é barato. Mas se você pudesse torná-lo mais barato, de repente o cálculo mudaria. Você poderia cortar o custo do butanol pela metade, porque o custo está atrelado ao uso desse cofator “.

Para criar esses cofatores reduzidos em laboratório, os pesquisadores construíram um eletrodo em camadas de níquel e cobre, dois elementos baratos.

Os cientistas descobriram uma maneira mais barata e eficiente de conduzir uma reação química no centro de muitos processos biológicos, o que pode levar a melhores maneiras de criar biocombustíveis a partir de plantas. Cientistas de todo o mundo vêm tentando há anos criar biocombustíveis e outros bioprodutos de maneira mais barata; este estudo, publicado recentemente na revista Scientific Reports , sugere que é possível fazê-lo.

“O processo de conversão de açúcar em álcool tem que ser muito eficiente se você quiser que o produto final seja competitivo com os combustíveis fósseis “, disse Venkat Gopalan, autor sênior do artigo e professor de química e bioquímica da Universidade Estadual de Ohio. “O processo de como fazer isso está bem estabelecido, mas o custo o torna não competitivo, mesmo com subsídios governamentais significativos. Esse novo desenvolvimento provavelmente ajudará a reduzir o custo”.

Esse eletrodo permitiu-lhes recriar o NADH e o NADPH a partir de suas formas oxidadas correspondentes. No laboratório, os pesquisadores foram capazes de usar o NADPH como cofator na produção de um álcool a partir de outra molécula, um teste que fizeram intencionalmente para mostrar que ¬o eletrodo que construíram poderia ajudar a converter biomassa - células vegetais - em biocombustíveis. Este trabalho foi realizado por Jonathan Kadowaki e Travis Jones, dois estudantes de graduação em engenharia mecânica e aeroespacial no laboratório Subramaniam, e Anindita Sengupta, uma pesquisadora de pós-doutorado no laboratório Gopalan.

Mas como o NADH e o NADPH estão no centro de muitos processos de conversão de energia dentro das células, essa descoberta pode ajudar em outras aplicações sintéticas.

O trabalho anterior de Subramaniam mostrou que os campos eletromagnéticos podem retardar a propagação de alguns cânceres de mama. Ele se aposentou do estado de Ohio em 31 de dezembro.

Essa descoberta está conectada, disse ele: pode ser possível para os cientistas controlar de forma mais fácil e acessível o fluxo de elétrons em algumas células cancerosas, potencialmente retardando seu crescimento e capacidade de metástase.

Venkat Gopalan, autor sênior do artigo e professor de química e bioquímica da Universidade Estadual de Ohio

Ele também passou grande parte de sua carreira científica posterior explorando se os cientistas poderiam criar uma planta sintética, algo que usaria a energia do sol para converter dióxido de carbono em oxigênio. Em uma escala grande o suficiente, ele pensou, tal criação poderia reduzir potencialmente a quantidade de dióxido de carbono na atmosfera e ajudar a lidar com a mudança climática.

“Sempre me interessei pela pergunta: ‘Podemos fazer uma planta sintética? Podemos fazer algo que possa resolver este problema do aquecimento global com o dióxido de carbono?’”, Disse Subramaniam. “Se é impraticável fazer isso com plantas porque continuamos destruindo-as por meio do desmatamento, existem outras formas inorgânicas de fazer isso?”

Esta descoberta pode ser um passo em direção a esse objetivo: as plantas usam o NADPH para transformar o dióxido de carbono em açúcares, que eventualmente se tornam oxigênio por meio da fotossíntese. Tornar o NADPH mais acessível e barato poderia possibilitar a produção de uma reação de fotossíntese artificial.

Mas sua aplicação mais provável e imediata é para biocombustíveis. O fato de os pesquisadores terem se reunido para esta investigação científica era raro: bioquímicos e engenheiros não costumam realizar pesquisas laboratoriais conjuntas. Gopalan e Subramaniam se encontraram em uma sessão de brainstorming hospedada pelo Centro de Ciências Aplicadas de Plantas do Estado de Ohio (CAPS), onde foram orientados a pensar em “grandes ideias para o céu” que poderiam ajudar a resolver alguns dos maiores problemas da sociedade. Subramaniam contou a Gopalan sobre seu trabalho com eletrodos e células, “e a próxima coisa que soubemos, estávamos discutindo este projeto”, disse Gopalan. “Certamente não teríamos nos falado se não fosse a oficina do CAPS”.

[*] Universidade Estadual de Ohio

Temperatura é crítica para a longevidade de árvores tropicais

Pela primeira vez, os cientistas forneceram evidências claras de que a vida útil das árvores tropicais diminui acima de um limite crítico de temperatura

por *University of Leeds

Os resultados, publicados em 14 de dezembro) na revista PNAS (Proceedings of the National Academy of Sciences) mostram que através dos trópicos, a expectativa de vida das árvores diminui para temperaturas acima de 25°C.

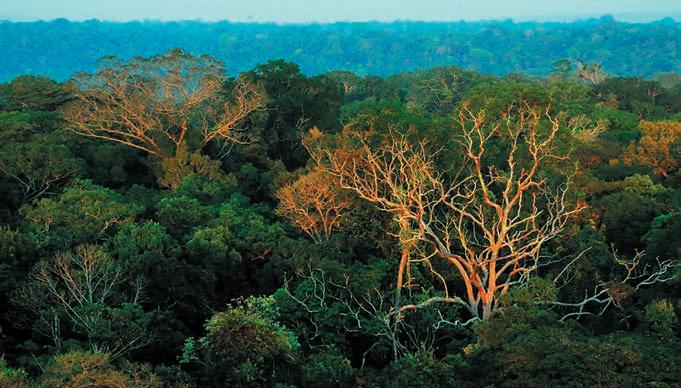

Como as temperaturas estão subindo rapidamente em grandes partes dos trópicos, a mortalidade de árvores provavelmente se acelerará em partes substanciais dos trópicos, incluindo a Amazônia, o Pantanal e as florestas atlânticas, com implicações nos habitats dos animais, qualidade do ar e estoques de carbono. Embora as florestas tropicais representem apenas 7% de toda a terra, elas abrigam cerca de 50% de todas as espécies animais e vegetais, e aproximadamente 50% dos estoques de carbono florestal na Terra. Assim, pequenas mudanças no funcionamento das florestas tropicais podem alterar significativamente os níveis atmosféricos de CO 2 - o gás de efeito estufa antropogênico mais importante.

Fotos: Roel Brienen

Tronco de árvore morta na floresta tropical do Peru

Floresta tropical no Peru

O Professor Manuel Gloor e o Dr. Roel Brienen, da Leeds ‘School of Geography, são co-autores do novo estudo.

O professor Gloor disse: “Muitas regiões nos trópicos estão aquecendo de maneira particularmente rápida e áreas substanciais ficarão mais quentes, em média, do que aproximadamente 25°C.

“Nossas descobertas - que são as primeiras a demonstrar que há um limite de temperatura - sugerem que, para as árvores nessas regiões, sua longevidade provavelmente será afetada negativamente.”

O Dr. Brienen acrescentou: “Isso indica que as florestas tropicais podem ser mais vulneráveis ao aumento do calor do que se pensava anteriormente. Como resultado do aquecimento global, esperamos, portanto, uma redução da vida útil das árvores nos trópicos. “Esses resultados são um sinal de alerta de que, junto com o desmatamento, o aquecimento global adiciona estresse extra às florestas tropicais da Terra”.

Segundo Buckeridge, além das altas temperaturas, a maior quantidade de CO2 na atmosfera contribui para acelerar a atividade metabólica das plantas

Examinando dados de anéis de árvores em todo o mundo

A equipe de pesquisa, liderada pelo Dr. Giuliano Locosselli, do Instituto de Biociências da Universidade de São Paulo, Brasil, passou quatro anos examinando dados de anéis de árvores de mais de 100.000 árvores em todo o mundo pertencentes a 400 espécies diferentes de 3.000 locais em todo o mundo.

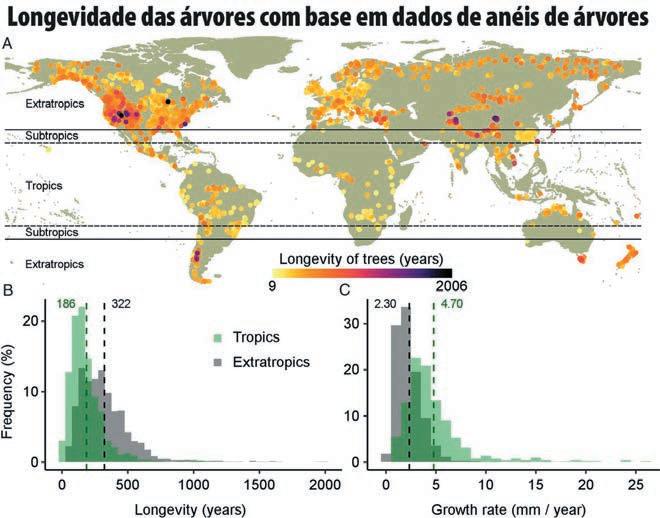

O Dr. Locosselli disse: “Nos trópicos, as árvores crescem, em média, duas vezes mais rápido do que nas regiões mais frias do mundo. Mas também têm uma vida útil média mais curta de 186 anos, em comparação com 322 anos de árvores em outros climas. a análise sugere que a expectativa de vida nos trópicos provavelmente diminuirá ainda mais.

( A ) Distribuição geográfica das idades máximas relatadas, aqui referidas como longevidade, para 3.343 populações no mundo. As linhas tracejadas indicam os limites da zona tropical (23,5 ° N a 23,5 ° S), e as linhas contínuas indicam os limites das áreas subtropicais (23,5 ° a 30 ° N e S). As populações mais velhas foram plotadas sobre as mais jovens no mapa para destacar a distribuição das árvores mais antigas. Os histogramas mostram a distribuição da longevidade das árvores ( B ) e da taxa de crescimento ( C ) das populações dos biomas tropicais (verde, entre 30 ° N e S de latitude) e extratrópicos (cinza).

“Se as árvores tropicais morrerem mais cedo, isso afetará a quantidade de carbono que essas florestas podem conter, levantando preocupações sobre o potencial futuro das florestas para compensar as emissões de CO 2 da queima de combustível fóssil. Também pode causar mudanças na biodiversidade e uma diminuição no número de espécies do planeta”.

Atualmente, as temperaturas médias nas florestas tropicais variam entre 21°C e 30°C. De acordo com as últimas previsões, as temperaturas tropicais na terra continuarão a aumentar, atingindo em média 2,5°C acima dos níveis pré-industriais nos próximos 10 a 20 anos. O estudo também mostra que os efeitos da temperatura na longevidade das árvores serão ainda mais exacerbados por condições de seca. A mudança climática também terá um impacto nas florestas tropicais fora da América do Sul, como a Floresta do Congo no oeste da África - a segunda maior floresta tropical do mundo depois da Amazônia.

O Dr. Locosselli acrescentou: “Embora as florestas tropicais na Amazônia já estejam perto desse limite de temperatura, as temperaturas no Congo são mais baixas. Mas, com esse grande aumento na temperatura, podemos começar a ver sinais de aumento da mortalidade de árvores. Deste ponto de vista , o cenário é bastante sombrio”.

O professor Marcos Buckeridge, diretor do Instituto de Biociências da Universidade de São Paulo, que também é coautor do estudo, acrescentou: “As temperaturas continuarão subindo no futuro próximo, mesmo que tomemos medidas drásticas de redução de emissões. “Portanto, é inevitável que o limite crítico para a longevidade das árvores seja cada vez mais ultrapassado nos trópicos e, portanto, é ainda mais importante proteger as florestas tropicais e reduzir as emissões de gases de efeito estufa”.

Árvores tropicais vivem menos

Estudo com 438 espécies indica que a longevidade média de exemplares de clima quente e de áreas frias é, respectivamente, de 186 e 322 anos

por *Eduardo Geraque Fotos: Joshua Mayer/Wikimedia Commons , Rod Waddington/Flickr/Wikimedia Commons

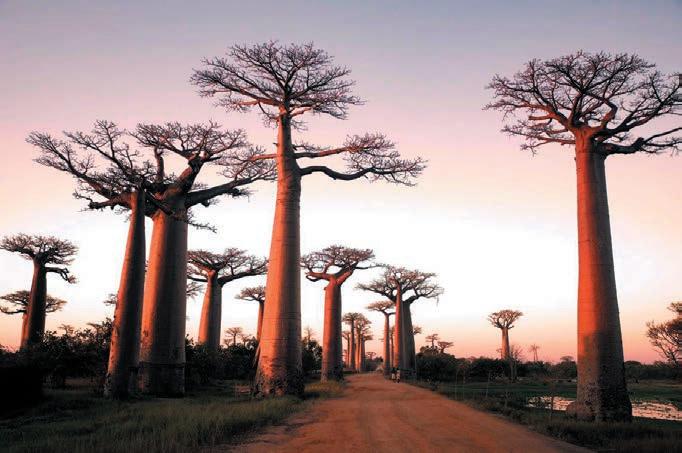

Em Madagascar, uma estrada pontuada por baobás, árvore tropical que chega a viver mil anos

Um grupo de biólogos brasileiros, em parceria com colegas europeus e do Chile, estudou a relação ainda pouco conhecida entre a longevidade e a taxa de crescimento das árvores e o comportamento do clima em florestas espalhadas pelo planeta. O trabalho analisou dados de 3.343 populações de árvores de 438 espécies, das quais 284 de áreas tropicais e 154 de zonas temperadas, que formam anéis de crescimento, um indicador a partir do qual se consegue estimar sua idade. Os resultados indicam que, em média, as árvores de regiões quentes crescem duas vezes mais rápido do que as de biomas temperados ou boreais. Mas a vida nos trópicos, pelo menos para as espécies avaliadas, costuma ser bem mais curta. Enquanto as árvores tropicais estudadas duram, em média, 186 anos, os exemplares de regiões de latitude maior vivem, também em média, 322 anos.

Em termos geográficos, os dados analisados, que foram compilados em mais de 200 estudos feitos previamente, englobam, no caso dos trópicos, espécies de áreas como a Amazônia e as florestas africanas e asiáticas. As regiões temperadas dos dois hemisférios incluem a América do Norte, a Europa, a Ásia, a Argentina e o Chile, além de áreas da Nova Zelândia e da Austrália, como a Tasmânia.

“O trabalho desmitifica um pouco a história de que haveria muitas árvores milenares nos trópicos”, comenta o botânico Marcos Buckeridge, do Instituto de Biociências da Universidade de são Paulo (IB-USP), coordenador do estudo, publicado em 14 de dezembro na revista científica PNAS.

Isso não significa que elas não existam, mas aparentemente estão presentes de forma menos frequente do que se imaginava.

Segundo o artigo, a espécie mais longeva das áreas tropicais é o baobá (Adansonia digitata), a única conhecida de clima quente que é capaz de passar dos mil anos. “Essas árvores das savanas africanas têm um tronco suculento que armazena muita água. Com essa estrutura, podem crescer rápido e, ao mesmo tempo, atingir idades muito elevadas”, comenta Giuliano Locosselli, que fez pós-doutorado na USP sob orientação de Buckeridge e agora está no Instituto de Botânica de São Paulo, especialista em análise de dados obtidos a partir dos anéis de crescimento de árvores e primeiro autor do trabalho. “A água armazenada permite que elas atinjam dimensões gigantescas sem sofrer estresse hídrico. O maior baobá conhecido tem pouco mais de 9 metros de diâmetro.”

Depois do baobá, as árvores mais longevas nos trópicos vivem no máximo cerca de meio milênio. Encontrada na América Central, a Hymenolobium mesoamericanum pode durar 560 anos, de acordo com o estudo. Originária da Ásia, mas plantada no Brasil, a teca (Tectona grandis) oferece madeira dura de qualidade e atinge uma longevidade de até 523 anos.

Típica dos biomas brasileiros, mas presente em boa parte da América Latina, o guanandi ou cabreúva (Calophyllum brasiliense) vive em média 490 anos.

Originária da Ásia, mas plantada no Brasil, a Teca (Tectona grandis) atinge uma longevidade de até 523 anos

Os dados compilados para as florestas mais frias e secas da Terra revelam espécies com idades bem mais avançadas. Nas regiões extratropicais, as árvores mais velhas, em média, ultrapassam com folga um milênio de idade. Entre as populações de árvores analisadas no estudo, o pódio das mais longevas foi formado por um trio de pinheiros da América do Norte: Pinus resinosa (2.006 anos), Pinus longaeva (1.965 anos) e Taxodium distichum (1.621 anos). A primeira espécie pode atingir até 50 metros de altura.

Sinal de alerta

O trabalho também analisou como a idade e a taxa de crescimento das espécies arbóreas de planícies tropicais são influenciadas por mudanças na temperatura e na disponibilidade de água. Sob essa perspectiva, a principal conclusão é preocupante, sobretudo no cenário atual de aumento do efeito estufa que torna o planeta progressivamente mais quente. “A longevidade das árvores tropicais diminui significativamente sob condições mais secas e quentes nos trópicos, provavelmente afetando a dinâmica da floresta e seu papel de retirar carbono da atmosfera e estocá-lo como biomassa. Esse tipo de alteração pode mexer com todas as cadeias alimentares desses ecossistemas e também das áreas temperadas”, diz Buckeridge. “Estamos em alerta vermelho, porque nosso trabalho indica que a mortalidade das árvores mais velhas aumenta quando a temperatura média anual em seu ambiente ultrapassa os 25,4 ° C.”

Para essa parte do trabalho, os pesquisadores usaram o modelo climático elaborado pelo instituto britânico Hadley Centre, um dos empregados nas análises feitas pelo Painel Intergovernamental de Mudanças Climáticas (IPCC) da Organização das Nações Unidas (ONU). De acordo com esse modelo, o limiar de 25,4° C em áreas tropicais deve ser atingido entre 2030 e 2050.

Entre as espécies de clima temperado, Pinus resinosa, encontrada na América do Norte, é a que apresenta maior longevidade média, cerca de 2 mil anos

Vários estudos já sinalizaram que a maior concentração de dióxido de carbono (CO2) na atmosfera, principal gás do efeito estufa, poderia atuar como uma espécie de fertilizante para muitas espécies vegetais. Nesse tipo de ambiente, as plantas cresceriam mais rapidamente e acumulariam mais biomassa, algo, em tese, bom para o clima. Dessa forma, os vegetais retirariam uma parte do excesso de carbono da atmosfera e ajudariam a combater o aquecimento global. O problema, segundo o novo estudo, é que as árvores cresceriam mais, mas morreriam mais cedo em razão das temperaturas elevadas.

Nas planícies tropicais quentes, por exemplo, onde as espécies arbóreas de folhas largas dominam a vegetação, os resultados do trabalho publicado na PNAS mostram diminuições consistentes na longevidade das árvores em locais secos e quando o limite de temperatura média anual ultrapassa 25,4 ° C. “Esse processo pode explicar os aumentos observados atualmente na mortalidade de árvores em florestas tropicais, como a Amazônia, e os registros das mudanças na composição das florestas na África Ocidental”, comenta Locosselli.

Em climas futuros mais secos e especialmente quentes, os resultados do artigo sugerem que as árvores com menor longevidade tendem a ganhar terreno nos trópicos. “Pode haver mudanças na composição das espécies das florestas tropicais, mas não uma morte generalizada”, opina o pesquisador do Instituto de Botânica. Apesar de classificar os resultados do novo estudo como muito interessantes, o ecólogo David Lapola, do Centro de Pesquisas Meteorológicas e Climáticas Aplicadas à Agricultura da Universidade Estadual de Campinas (Unicamp), pondera que mais observações de campo são necessárias para ter uma noção mais clara do que pode vir a ocorrer com as florestas em razão do aquecimento global. “Existem várias medidas feitas na Amazônia, por exemplo, que mostram que o tempo de vida das árvores vem, de fato, se reduzindo. Mas os anéis de crescimento não conseguem registrar uma tendência importante que tem sido verificada in loco e pode compensar a redução da longevidade: apesar de as árvores estarem morrendo mais cedo, elas estão nascendo em maior quantidade”, afirma Lapola. Para o pesquisador da Unicamp, ainda não é possível afirmar que, a longo prazo, daqui a 100 ou 200 anos, as florestas tropicais serão compostas por menos biomassa e passarão por um processo de savanização. “A questão da longevidade tem limitações e não é o único fator que controla a dinâmica florestal’, pondera Lapola. “Podem ocorrer outras mudanças funcionais dentro das florestas, como o crescimento de espécies mais adaptadas às secas”, avalia.

Elas estão livres de modificações humanas, incluindo agricultura, urbanização, extração de madeira e caça excessiva. Nova ferramenta de mapeamento online mostra florestas intactas - aquelas livres de danos humanos. Os cientistas esperam que informe as políticas para conservar e gerenciar as florestas

Fotos: Nature, Phys

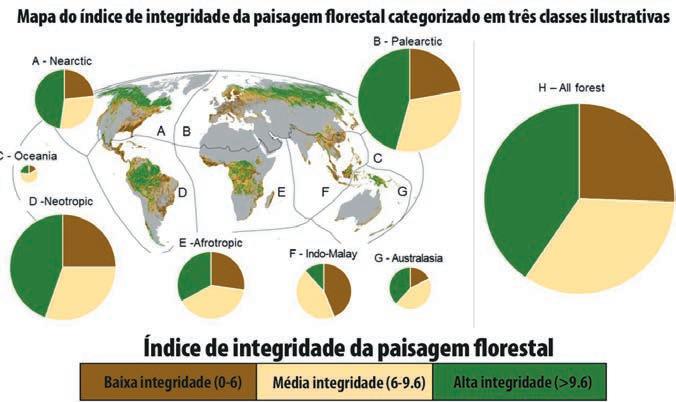

O Índice de Integridade da Paisagem Florestal para 2019 categorizado em três classes amplas e ilustrativas e mapeado em cada domínio biogeográfico ( a - g ). O tamanho dos gráficos de pizza indica o tamanho relativo das florestas dentro de cada domínio ( a - g ) eh mostra todas as florestas do mundo combinadas

O FLII torna visível a condição das florestas remanescentes do mundo para todos pela primeira vez e pode informar ‘ações direcionadas para conservar, gerenciar e restaurar’ essas florestas.

O FLII torna visível a condição das florestas remanescentes do mundo para todos pela primeira vez e pode informar ‘ações direcionadas para conservar, gerenciar e restaurar’ essas florestas.

Espera-se que o FLII seja usado pelos governos para um melhor manejo florestal e dê início a ‘políticas ambiciosas que priorizam a retenção da integridade da floresta’.

Espera-se que o FLII seja usado pelos governos para um melhor manejo florestal e dê início a ‘políticas ambiciosas que priorizam a retenção da integridade da floresta’.

O FLII torna visível a condição das florestas remanescentes do mundo para todos pela primeira vez e pode informar ‘ações direcionadas para conservar, gerenciar e restaurar’ essas florestas.

Menos da metade das florestas do mundo não são afetadas pela atividade humana, de acordo com um novo estudo.

Uma equipe internacional de 47 cientistas revela que apenas 40,5% das florestas do mundo têm ‘integridade do ecossistema’ - o que significa que estão livres de modificações humanas. A modificação humana inclui a exploração madeireira em escala industrial, fragmentação por infraestrutura, agricultura, urbanização, caça excessiva e extração de combustível de madeira. Embora as metas políticas para conter o desmatamento sejam geralmente precisas e ambiciosas, existem ‘apenas metas vagas’ em torno da redução dos níveis de modificação florestal.

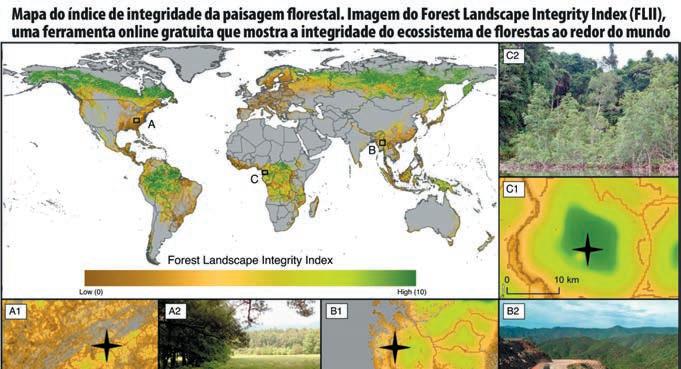

Portanto, os especialistas criaram o Índice de Integridade da Paisagem Florestal (FLII) - um mapa online que mostra a integridade do ecossistema de toda a vegetação lenhosa do mundo com mais de 5 metros de altura.

Três regiões são destacadas, incluindo (a) Smoky Mountains National Park no Tennessee, EUA, (b) uma região no estado de Shan em Mianmar e (c) Reserva Natural del Estuario del Muni em Guiné Equatorial. Os mapas A1 – C1 mostram o Índice de Integridade da Paisagem Florestal para esses locais. A2, B2 e C2 são fotografias de dentro destas regiões: (A2) a borda do Parque Nacional Smoky Mountains; (B2) mostra um caminhão madeireiro passando por alguma floresta parcialmente degradada ao longo de uma rodovia recém-construída em Shan Stat; e, (C3) mostra uma floresta de mangue intacta dentro da Reserva Natural del Estuario del Muni, perto da fronteira com o Gabão. As estrelas em (a), (b) e (c) indicam a localização aproximada de onde essas fotos foram tiradas. Todas as fotos foram tiradas por H.S.G.

Espera-se que o FLII seja usado pelos governos para um melhor manejo florestal e dê início a ‘políticas ambiciosas que priorizam a retenção da integridade da floresta’.

‘Muitas agendas ambientais globais, incluindo travar a perda de biodiversidade, reverter a degradação da terra e limitar as mudanças climáticas, dependem da retenção de florestas com alta integridade ecológica’, afirmam os autores em seu artigo.

‘No entanto, a escala e o grau de modificação da floresta permanecem mal quantificados e mapeados. ‘[FLII] é um mapa de medição contínua e aplicável globalmente da integridade da floresta no nível da paisagem, que oferece um indicador oportuno do status e das necessidades de manejo das florestas remanescentes da Terra.’

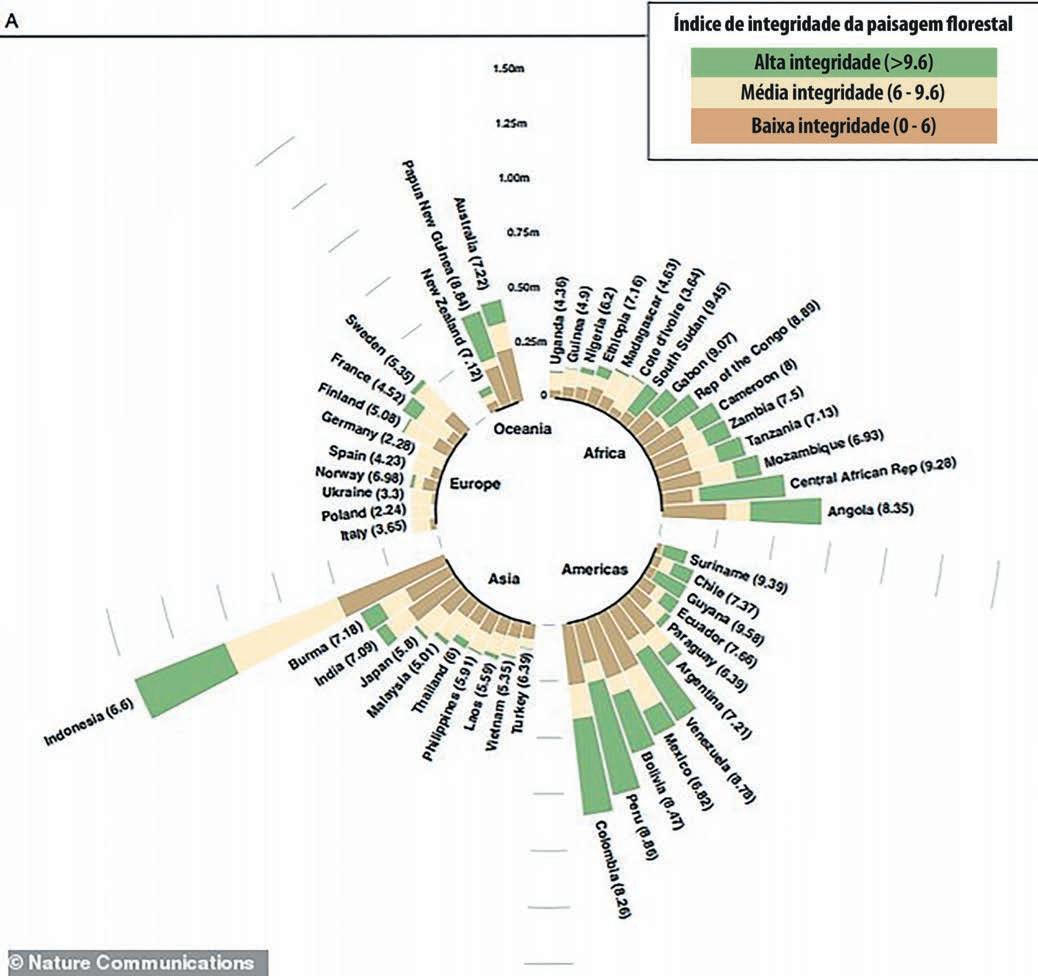

Países com extensão de floresta entre 1 milhão de km quadrados e 100.000 km quadrados de floresta. O tamanho da barra representa a área das florestas de um país

O desmatamento - a remoção permanente de árvores - é um grande problema ambiental, causando a destruição do habitat florestal e a perda da diversidade biológica.

Mas ‘muito menos atenção’ tem sido dada ao grau de modificação antropogênica (causada pelo homem) das florestas que ainda existem, dizem os pesquisadores.

A baixa integridade do ecossistema é separada e pode frequentemente ser um precursor do desmatamento total.

Os cientistas foram, portanto, inspirados a criar uma ilustração acessível da integridade do ecossistema.

‘As florestas são definidas na prática como tendo pelo menos um certo limite de densidade de cobertura de dossel e alturas de árvores, então a degradação, se for severa o suficiente, pode eventualmente empurrar as florestas abaixo desse limite’, disse o autor do estudo Tom Evans da Wildlife Conservation Society ao MailOnline.

“O desmatamento tira uma floresta de nossa escala de integridade porque ela é então classificada como não florestal.

Já existem grandes conjuntos de dados globais rastreando o desmatamento e recomendamos que sejam usados em conjunto com nossa métrica para obter uma imagem completa dos processos combinados de desmatamento e degradação.

A equipe usou sensoriamento remoto acessível, imagens de satélite e desenvolvimentos recentes em computação em nuvem e grandes novos conjuntos de dados para criar o FLII.

A ferramenta, que está disponível para todos online, mostra as florestas de ‘alta integridade’ em todo o mundo em uma cor verde escura e ‘baixa integridade’ (floresta altamente degradada) em um marrom alaranjado.

Esta codificação de cores é baseada em uma pontuação de integridade de um a 10, sendo 10 uma pontuação de integridade alta e 1 uma pontuação de integridade baixa.

A ferramenta revela que, globalmente, 6,7 milhões de milhas quadradas de floresta (40,5 por cento) tem alta integridade, principalmente encontrada no Canadá, Rússia, Amazônia, África Central e Nova Guiné - apenas 27 por cento dos quais estão em áreas protegidas designadas nacionalmente áreas.

Da floresta dentro de áreas protegidas, apenas 56 por cento tem integridade de alto nível de paisagem, mostra a ferramenta.

As florestas com alta integridade são o reino do Paleártico, particularmente no norte da Rússia, e o Neartic, no norte do Canadá, as Montanhas Rochosas e o Alasca.

Existem também grandes áreas de floresta com alta integridade nos Neotrópicos, concentradas na região amazônica, incluindo dentro das Guianas, Mata Atlântica no Brasil, sul do Chile e partes da Mesoamérica.

Florestas amplamente livres de modificações significativas - aquelas com alta integridade do ecossistema - normalmente fornecem níveis mais altos de muitos benefícios florestais do que florestas modificadas do mesmo tipo.

Florestas mais intactas são mais resilientes e armazenam mais carbono, o que significa que podem ajudar a combater as mudanças climáticas, por exemplo.

Agora é “essencial” que a comunidade científica continue desenvolvendo ferramentas e dados aprimorados para mostrar os níveis de integridade da floresta para a tomada de decisões, dizem os especialistas.

Isso ajudará as nações a alcançar os Objetivos de Desenvolvimento Sustentável (ODS) das Nações Unidas - 17 objetivos interligados projetados para ser um ‘modelo para alcançar um futuro melhor e mais sustentável para todos’. “Os governos devem adotar políticas e estratégias para reter e restaurar a integridade ecológica de suas

Existem também grandes áreas de floresta com alta integridade nos Neotrópicos, concentradas na região amazônica, incluindo dentro das Guianas, Mata Atlântica no Brasil, sul do Chile e partes da Mesoamérica. Retratou a floresta amazônica

florestas, ao mesmo tempo que garantem que as soluções também sejam economicamente viáveis, socialmente justas e politicamente aceitáveis em contextos locais complexos e altamente diversos”, diz o artigo.

‘Mapear e monitorar isso globalmente fornecerá informações essenciais para a formulação de políticas, planejamento e ação globais, nacionais e locais coordenados.

‘Este é um enorme desafio e nossos esforços para mapear o grau de modificação da floresta têm como objetivo aumentar a consciência sobre a importância do problema.’

Os dados do FLII, que podem ser baixados, estão sendo disponibilizados aos governos do mundo e serão implementados no programa de biodiversidade da ONU.

Florestas de Nothofagus pumilio (faias do sul) ao redor do Lago Argentino, nos Andes do sul da Patagônia, Argentina, mostrando grupos de árvores mortas

O DNA antigo continua a reescrever a história de formação da sociedade de 9.000 anos do milho

por *Smithsonian

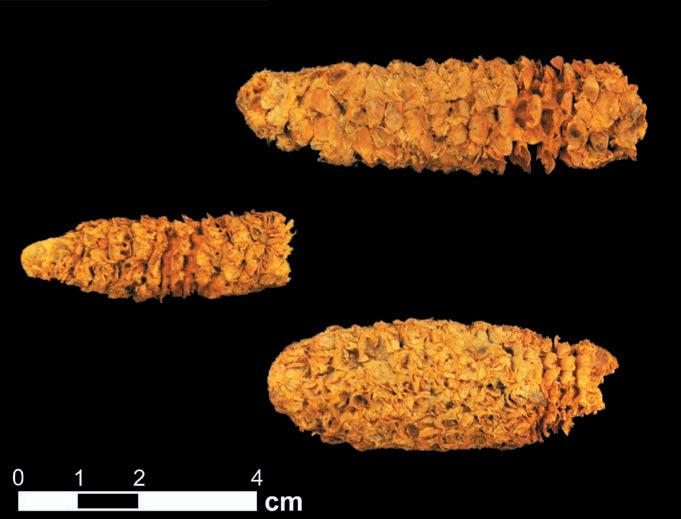

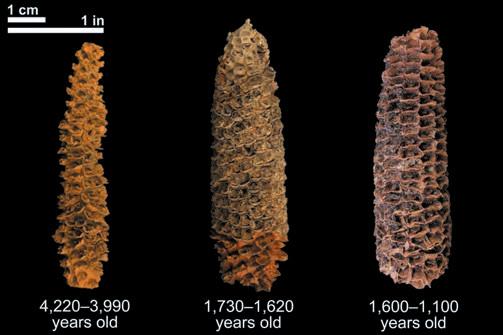

Três espigas de milho de aproximadamente 2.000 anos do local de abrigo de rocha El Gigante, em Honduras. Essas espigas de milho foram geneticamente analisadas por uma equipe internacional de cientistas

Fotos: Logan Kistler, Natália Carolina de Almeida Silva, Thomas Harper

Um novo estudo, que revela detalhes da história de 9.000 anos do milho, é um excelente exemplo das maneiras pelas quais a pesquisa básica sobre o DNA antigo pode fornecer insights sobre a história humana que de outra forma seriam inacessíveis, disse o co-autor Logan Kistler, curador de arqueogenômica e arqueobotânica no Museu Nacional de História Natural do Smithsonian.

“A domesticação - a evolução das plantas selvagens ao longo de milhares de anos nas plantações que nos alimentam hoje - é indiscutivelmente o processo mais significativo da história humana, e o milho é uma das plantações mais importantes atualmente cultivadas no planeta”, disse Kistler. “Compreender mais sobre o contexto evolutivo e cultural da domesticação pode nos dar informações valiosas sobre este alimento com o qual dependemos tão completamente e seu papel na formação da civilização como a conhecemos”.

Há cerca de 9.000 anos, o milho como é conhecido hoje não existia. Povos antigos no sudoeste do México encontraram uma grama selvagem chamada teosinto, que oferecia orelhas menores do que um dedo mindinho com apenas um punhado de grãos pedregosos. Mas por um golpe de gênio ou necessidade, esses cultivadores indígenas viram potencial no grão, adicionando-o a suas dietas e colocando-o no caminho para se tornar uma cultura domesticada que agora alimenta bilhões.

Apesar de quão vital o milho , ou milho, é para a vida moderna, ainda existem lacunas na compreensão de sua jornada através do espaço e do tempo. Agora, uma equipe co-liderada por pesquisadores do Smithsonian usou DNA antigo para preencher algumas dessas lacunas.

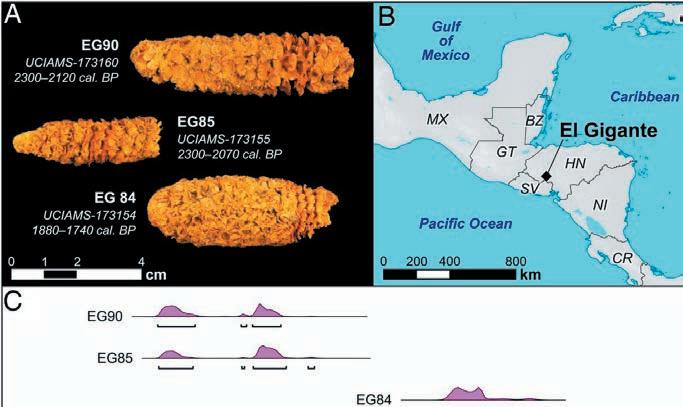

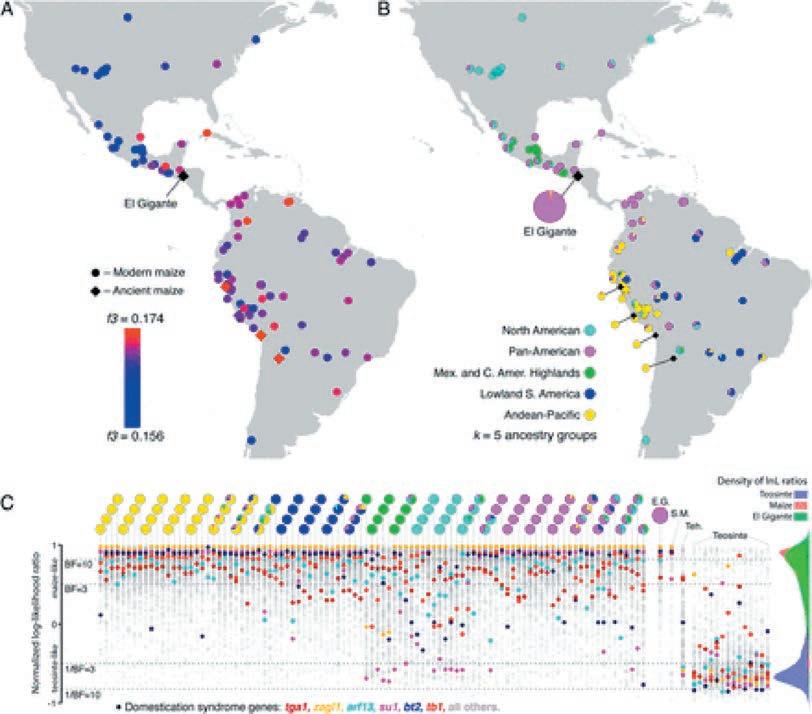

Espigas de milho do abrigo de rochas El Gigante (HN) com dados de todo o genoma. ( A ) Fotografias de espigas mostrando características morfológicas. ( B ) Mapa da América Central indicando a localização do abrigo de rochas El Gigante. ( C ) Distribuições de datas de radiocarbono para as três espigas de milho com dados de todo o genoma.

Na edição de 14 de dezembro da revista Proceedings of the National Academy of Sciences , Kistler e uma equipe internacional de colaboradores relatam os genomas totalmente sequenciados de três espigas de aproximadamente 2.000 anos do abrigo de rochas El Gigante, em Honduras. A análise dos três genomas revela que essas variedades milenares de milho da América Central tinham ascendência sul-americana e adiciona um novo capítulo em uma história complexa emergente da história da domesticação do milho.

“Mostramos que os humanos carregavam milho da América do Sul de volta para o centro de domesticação no México”, disse Kistler. “Isso teria proporcionado uma infusão de diversidade genética que pode ter adicionado resiliência ou aumentado a produtividade. Também ressalta que o processo de domesticação e melhoramento da cultura não segue apenas em linha reta.

Os humanos começaram a criar seletivamente o ancestral selvagem do milho, o teosinto, cerca de 9.000 anos atrás, no México, mas variedades parcialmente domesticadas da cultura não alcançaram o resto da América Central e do Sul por mais 1.500 e 2.000 anos, respectivamente.

Por muitos anos, o pensamento convencional entre os estudiosos foi que o milho foi primeiro totalmente domesticado no México e depois espalhado em outros lugares. No entanto, depois que as espigas de 5.000 anos encontradas no México acabaram sendo apenas parcialmente domesticadas , os estudiosos começaram a reconsiderar se esse pensamento capturava toda a história da domesticação do milho.

Então, em um estudo histórico de 2018 liderado por Kistler , os cientistas usaram DNA antigo para mostrar que, embora os primeiros

Uma variedade de espigas de milho de várias idades encontradas no abrigo de rochas El Gigante, em Honduras. Depois que os cientistas descobriram os restos de uma variedade totalmente domesticada e altamente produtiva de milho de 4.300 anos de idade no abrigo de rochas El Gigante, uma equipe pesquisou os estratos arqueológicos que cercam o local para outras espigas, grãos ou qualquer outra coisa que possa produzir material genético. Eles também começaram a trabalhar para sequenciar algumas das amostras de milho de 4.300 anos do local - os vestígios mais antigos da cultura em El Gigante

passos do teosinto em direção Embora os resultados cubram à domesticação ocorressem no apenas as amostras de milho México, o processo ainda não El Gigante datadas de cerca de havia sido concluído quando as 2.000 anos atrás, Kistler disse pessoas começaram a carregá-lo que a forma e a estrutura das para o sul, para a América Cen- espigas da camada de aproxitral e do Sul. Em cada uma des- madamente 4.000 anos sugere sas três regiões, o processo de que elas eram quase tão produdomesticação e melhoramento tivas quanto aquelas que ele e da cultura ocorreu em paralelo, seus co-autores eram capaz de mas em velocidades diferentes. sequenciar. Para Kistler, isso

Em um esforço anterior para significa que a melhoria da coaprimorar os detalhes desta lheita de sucesso provavelmenhistória de domesticação mais te ocorreu antes, e não durante rica e complexa, uma equipe os 2.000 anos intermediários ou de cientistas, incluindo Kistler, Ao longo de dois anos, a equipe tentou sequenciar 30 amostras, mas mais, separando essas camadas descobriu que restos de miapenas três eram de qualidade adequada para sequenciar um genoma completo. Todas as três amostras viáveis vieram da camada mais recente arqueológicas em El Gigante. lho de 4.300 anos do local de de ocupação do abrigo de rocha - carbono datado entre 2.300 e 1, 900 A equipe ainda hipotetiza que abrigo de rocha El Gigante na anos atrás - revelando sobreposição genética entre as três amostras do foi a introdução das variedades América Central vieram de um abrigo de rocha hondurenho e variedades de milho da América do Sul sul-americanas de milho e seus local totalmente domesticado e genes, provavelmente há pelo variedade altamente produtiva. Surpreso Gigante, os pesquisadores os analisaram menos 4.300 anos, que pode ter aumentaao encontrar milho totalmente domesti- em um painel de 121 genomas publicados do a produtividade do milho da região e a cado em El Gigante coexistindo em uma de várias variedades de milho, incluindo prevalência do milho na dieta das pessoas região não muito longe de onde o milho 12 derivados de antigas espigas e sementes que viviam na região mais ampla, conforparcialmente domesticado foi descoberto de milho. A comparação revelou fragmen- me descoberto em um estudo recente lideno México, Kistler e o co-líder do projeto tos de sobreposição genética entre as três rado por Kennett. Douglas Kennett, antropólogo da Univer- amostras do abrigo de rochas hondurenho e “Estamos começando a ver uma confluênsidade da Califórnia, em Santa Bárbara, se variedades de milho da América do Sul. “A cia de dados de vários estudos na América uniram geneticamente determinar a origem ligação genética com a América do Sul era Central, indicando que o milho estava se do milho El Gigante. sutil, mas consistente”, disse Kistler. tornando uma cultura básica mais produti “O abrigo de rocha El Gigante é notável “Repetimos a análise muitas vezes va de crescente importância dietética entre porque contém restos de plantas bem pre- usando diferentes métodos e composições 4.700 e 4.000 anos atrás”, disse Kennett. servados que abrangem os últimos 11.000 de amostra, mas continuamos obtendo o Juntas com o estudo recente de Kennett, anos”, disse Kennett. “Mais de 10.000 res- mesmo resultado”. essas últimas descobertas sugerem que algo tos de milho, de espigas inteiras a caules e Kistler, Kennett e seus co-autores em insti- importante pode ter ocorrido na domestifolhas fragmentadas, foram identificados. tuições colaboradoras, incluindo Texas A&M cação do milho há cerca de 4.000 anos na Muitos desses restos datam de tarde, mas University, Pennsylvania State University, América Central, e que uma injeção de dipor meio de um extenso estudo de radio- bem como o Francis Crick Institute e a Uni- versidade genética da América do Sul pode carbono, fomos capazes de identificar al- versity of Warwick no Reino Unido, levantam ter tido algo a ver com isso. Este momento guns restos que datam de 4.300 anos atrás”. a hipótese de que a reintrodução dessas va- proposto também se alinha com o surgi-

Eles procuraram nos estratos arque- riedades sul-americanas na América Central mento das primeiras comunidades agrícolas ológicos ao redor do abrigo de rocha El pode iniciaram o desenvolvimento de varie- estabelecidas na Mesoamérica, que finalGigante por espigas, grãos ou qualquer dades híbridas mais produtivas na região. mente deram origem a grandes civilizações outra coisa que pudesse render nas Américas, os olmecas, maias, material genético, e a equipe Teotihuacan e os astecas, embora começou a trabalhar para se- Kistler se apressasse em apontar quenciar algumas das amostras que essa ideia ainda é relegade milho de 4.300 anos do lo- da especulação. “Mal podemos cal - os vestígios mais antigos esperar para nos aprofundar da cultura El Gigante. Ao longo nos detalhes do que aconteceu de dois anos, a equipe tentou exatamente em torno da marca sequenciar 30 amostras, mas de 4.000 anos”, disse Kistler. apenas três eram de qualidade “Existem tantas amostras arqueadequada para sequenciar um ológicas de milho que não foram genoma completo. Todas as três analisadas geneticamente. Se amostras viáveis vieram da ca- começarmos a testar mais desmada mais recente de ocupação sas amostras, poderemos comedo abrigo de rocha - carbono çar a responder a essas questões datado entre 2.300 e 1.900 anos persistentes sobre a importância atrás. Com os três genomas dessa reintrodução de variedasequenciados de milho do El Variedades de milho encontradas perto de Cuscu e Machu Pichu em des sul-americanas”.

Salineras de Maras no Vale Sagrado Inca no Peru, junho de 2007

História do mundo em 5 alimentos

por *Douglas Broom

A história da alimentação é a história do desenvolvimento humano. A comida moldou a paisagem, a cultura e a política. Mas nossos sistemas alimentares atuais são insustentáveis e precisam ser mudados

Nós somos o que comemos. Mas o que comemos também pode nos dizer muito sobre nossa história como espécie neste planeta e a evolução da sociedade humana.

Os primeiros humanos eram tanto caçadores quanto forrageadores. A domesticação de animais e o plantio de safras criaram comunidades estabelecidas que, por sua vez, buscaram novos sabores e alimentos. O comércio de alimentos passou de um negócio local para um global que hoje vale US $ 1,5 trilhão , de acordo com a Organização das Nações Unidas para Agricultura e Alimentação.

Mas apesar do valor dos alimentos comercializados globalmente ter dobrado desde 1995, ainda vivemos em uma era de desigualdade alimentar e atitudes fortemente contrastantes. Enquanto 850 milhões de pessoas passam fome em todo o mundo, nos países desenvolvidos a comida se tornou um estilo de vida e uma questão política que delineia os grupos sociais.

O que é certo é que grande parte da produção de alimentos de hoje é insustentável e precisa de uma revisão radial se quisermos alimentar os dois bilhões extras de pessoas que aumentarão a população global nos próximos 30 anos.

Os alimentos que moldaram nossa história:

Fotos: Donnis Yash, FAO

1. Carne - um sabor de 2,5 milhões de anos

Acredita-se que as ovelhas foram os primeiros animais domésticos domesticados

Os arqueólogos acreditam que os primeiros humanos comiam uma dieta de frutas, sementes e cascas, suplementada ocasionalmente por carne. A primeira evidência de humanos usando ferramentas para cortar e preparar carne foi datada de mais de 2,6 milhões de anos atrás. Os primeiros animais a serem domesticados para uso alimentar são pensados para ter sido ovelhas no sudoeste da Ásia há 13.000 anos. Provavelmente, as cabras foram domesticadas cerca de 3.000 anos depois. Preservar carne foi uma habilidade aprendida logo depois, como atesta a descoberta de uma porção de carne bovina de 2.500 anos na China .

Acredita-se que as ovelhas foram os primeiros animais domésticos domesticados

Os primeiros humanos comiam sementes de gramíneas silvestres e acredita-se que o cultivo de cereais tenha começado de forma independente em diferentes partes do mundo há cerca de 12.000 anos . Acredita-se que o trigo tenha sido o primeiro cereal cultivado.

Estima-se que o cultivo do arroz tenha começado há cerca de 8.000 anos na China e na Índia , embora variedades silvestres já fossem consumidas muito antes disso. O cultivo inicial produzia apenas baixos rendimentos , mas há 10.000 anos a cidade de Jericó foi uma das primeiras cidades a prosperar no cultivo de cereais.

3. Especiarias - a globalização do sabor

Ninguém sabe ao certo quando o comércio de especiarias começou, mas ele já foi estabelecido há 4.000 anos, com a canela do Sri Lanka e a cássia da China sendo vendidas por mercadores no Oriente Médio.

O comércio durante o Império Romano foi descrito por um especialista como o nascimento da globalização , com o estabelecimento do que ficou conhecido como Rotas das Especiarias. Pessoas e ideias fluíram ao longo dessas rotas até a Idade Média, ajudando a moldar nosso mundo moderno.

4. Batatas - o primeiro alimento global?

Embora se acredite que tenha evoluído do tubérculo venenoso de um ancestral da família da erva-moura , a batata foi cultivada pela primeira vez nos Andes peruanos há 10.000 anos. Depois de ser trazido para a Europa em 1500, ele se espalhou rapidamente pelo mundo para se tornar um alimento global.

China, Índia e Ucrânia são os maiores produtores de hoje e as batatas agora fazem parte da dieta diária de pessoas em todo o mundo. Existe até uma rivalidade de longa data entre a França e a Bélgica sobre quem inventou as batatas fritas.

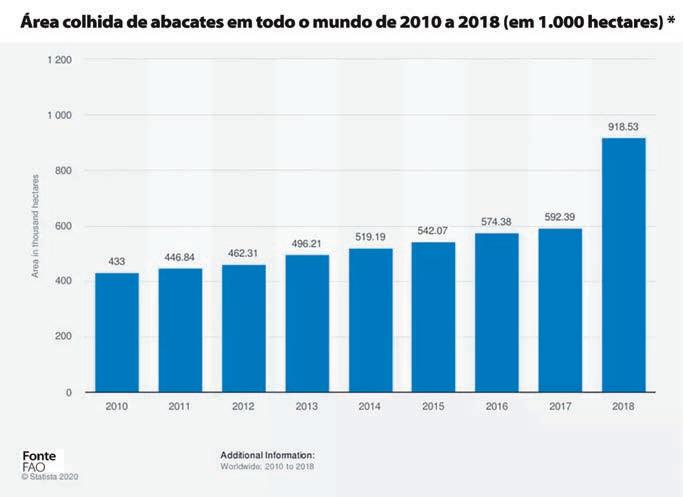

5. Abacate - o símbolo da alimentação moderna

Arqueólogos e botânicos continuam a debater as origens do arroz

Aclamado como um superalimento, graças às gorduras insaturadas saudáveis , o abacate se tornou tão valioso que guardas armados protegem o “ouro verde” no México e gangues de criminosos consideram a fruta tão lucrativa quanto o ópio .

Devido à popularidade da torrada com abacate, a fruta agora é sinônimo de cultura hipster. Mas os ambientalistas dizem que um pacote de dois abacates tem uma pegada de carbono de 850g de CO2 - o dobro de um quilo de banana.

[*] Em Bold Actions for Food as a Force for Good. Fórum Econômico Mundial

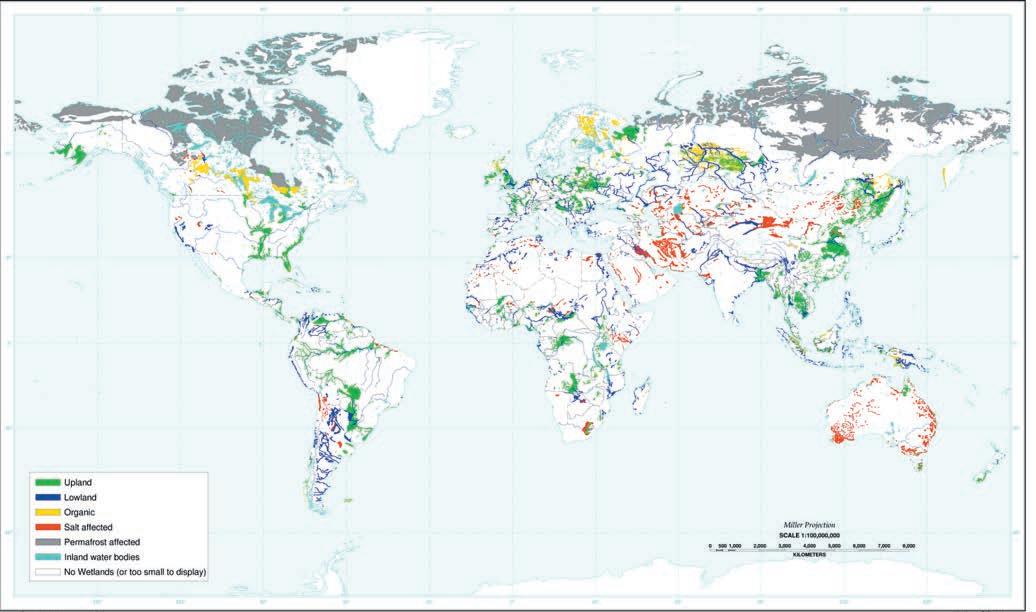

Dia Mundial das Zonas Úmidas 2021

Água, zonas úmidas e vida são inseparáveis

por *Luciana Constantino Fotos: Giuliano M. Locosselli e Milena Godoy-Veiga Quebec Ministry of Forests/Wildlife and Parks, Roel Brienen/University of Leeds

ASecretária-Geral da Convenção de Ramsar sobre Zonas Úmidas, Martha Rojas Urrego, aproveitou a data para lembrar que “menos de 1% da água do planeta é doce e grande parte armazenada em zonas úmidas”, espaços que “abrigam 40% da água. as espécies do planeta, mas desaparecem três vezes mais rápido que as florestas”.

Todos concordamos que a água doce é essencial para a vida, sem água não pode haver vida. No entanto, quantos se preocupam com a saúde dos ecossistemas que são a fonte de nossa água doce?

Estamos em uma crise de água com consequências profundas e as zonas úmidas estão no centro de sua resolução. Menos de 1% da água na Terra é água doce utilizável e é principalmente armazenada em áreas úmidas, como rios, riachos, lagos, pântanos, estuários e aquíferos. Consumimos pelo menos 10 bilhões de toneladas de água doce diariamente - mais do que a terra pode repor. Mesmo assim, precisaremos de 55% mais água até 2050 para uma população global de 10 bilhões de pessoas.

Nossa demanda insustentável por água doce está colocando uma enorme pressão sobre os pântanos.

Além disso, todas as nossas fontes de água são poluídas por produtos químicos, plástico ou águas residuais não tratadas - deixando 2,2 bilhões de pessoas bebendo água não segura e quase meio milhão morrendo a cada ano por causa disso. Exigimos por mais água potável, mas destruímos os meios pelos quais a obtemos. Quase 90% de nossas áreas úmidas, incluindo rios, lagos, pântanos e turfeiras desapareceram, e continuamos a perder áreas úmidas três vezes mais rápido do que as florestas.

Desconectamos nossa dependência da água do que fazemos com os pântanos.

Devemos entender e valorizar melhor o que as zonas úmidas fazem pela água.

Zonas Úmidas no Mundo

Ao captar, armazenar, filtrar e libertar água onde e quando necessário, as zonas húmidas garantem um abastecimento constante de água doce limpa, indispensável para o consumo, a irrigação e a produção de energia, bem como para o funcionamento dos ecossistemas. Interdependentes e inseparáveis, a água e as zonas húmidas são parceiros vitais para a vida, proporcionando um lar para 40% das espécies mundiais.

Poderíamos ter água suficiente para o nosso presente e futuro. Se mudarmos.

Devemos ser eficientes no consumo de água em todas as áreas. A indústria sozinha poderia reduzir seu uso de água em até 50%, enquanto a agricultura, de longe o maior consumidor de água, tem diversas maneiras de obter mais ‘safra por gota’.

Devemos parar de destruir e começar a restaurar os pântanos.

Todos nós, seja no setor agrícola ou industrial, para cada indivíduo em sua vida diária, é nossa responsabilidade coletiva economizar água e conservar as áreas úmidas.

São necessários investimentos significativos em zonas úmidas como soluções naturais para a gestão da água, bem como a adoção de políticas que integrem as zonas úmidas aos planos de gestão. Todas são ações decisivas em direção a uma economia verde e fundamentais para reconstruir melhor.

Para realçar a importância destes valiosos mas frágeis espaços naturais, a frase que Ramsar subscreve este ano é “Água, zonas húmidas e vida” , lembra o investigador Santos Cirujano, do Real Jardim Botânico (RJB-CSIC), para quem o acordo é “na realidade, uma lista de prestígio” que integra as zonas húmidas mais importantes

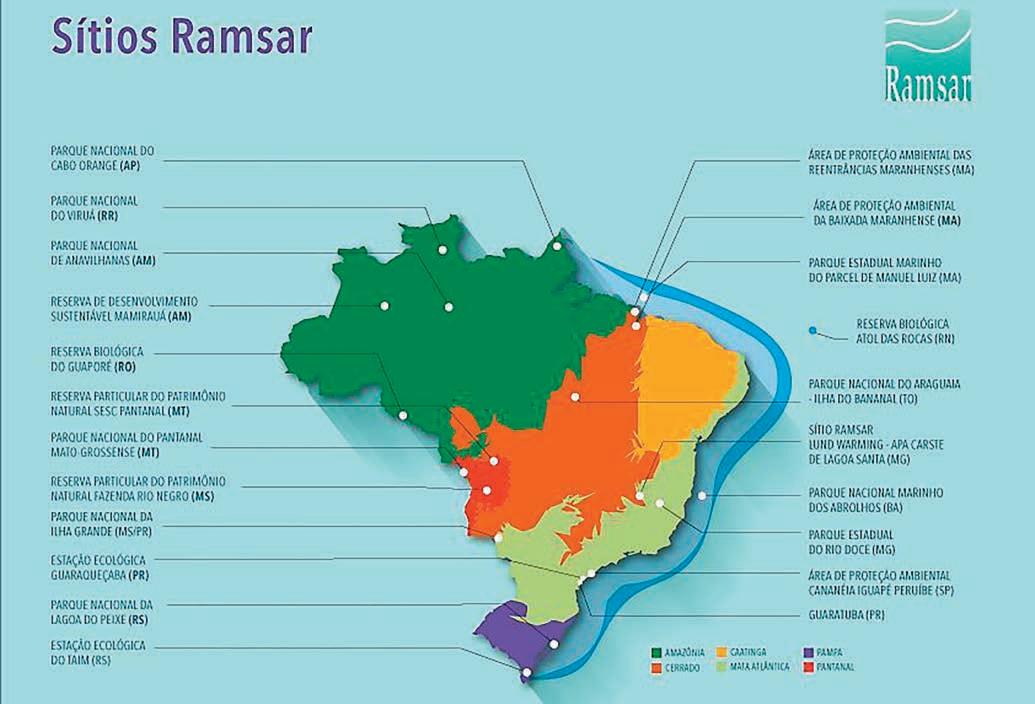

Alguns dos Sítios Ramsar no Brasil

do mundo, mas “só funciona se os estados membros se envolverem”, porque o tratado “não obriga à recuperação ou conservação de uma zona húmida específica”. Este botânico apelou a “um dos valores fundamentais da UE: a conservação da qualidade de vida”, associando esta aspiração ao ambiente, com cuja saúde está “diretamente relacionada”, razão pela qual “a qualidade de água e ar devem ser o foco principal das políticas ambientais” para os países europeus. Todos eles “são obrigados a conservar o seu ambiente natural” e a Espanha “deve liderar este esforço tendo em conta que é o país com maior biodiversidade do Velho Continente”.Também preocupado está Miguel Álvarez, investigador do Museu Nacional de Ciências Naturais (MNCN-CSIC) , que descreveu o acordo de Ramsar como “uma iniciativa multilateral bem intencionada”, embora no momento da verdade “as pessoas não se importem com o pantanais, viva de costas para eles”.

Isso porque tradicionalmente são considerados “lugares inabitáveis e centros de malária” o que, junto com sua progressiva deterioração, “leva ao seu desaparecimento”. De fato, o declínio desses ecossistemas úmidos “se acelerou no século passado”, de modo que sua recuperação só pode ser considerada como “um objetivo de longo prazo” para o qual a educação ambiental será essencial.

Junte-se a nós neste Dia Mundial das Zonas Úmidas, no 50º aniversário da Convenção de Ramsar sobre Zonas Úmidas para acelerar as ações que conservam e restauram as zonas úmidas do mundo.

Vamos fazer mudanças que valorizem as áreas úmidas, a fim de garantir nossa água doce. A Convenção sobre Zonas Úmidas é o tratado intergovernamental que fornece a estrutura para a conservação e uso racional de zonas úmidas e seus recursos. A Convenção foi adotada na cidade iraniana de Ramsar em 1971 e entrou em vigor em 1975. Desde então, quase 90% dos Estados membros da ONU, de todas as regiões geográficas do mundo, aderiram para se tornarem “Partes Contratantes”.

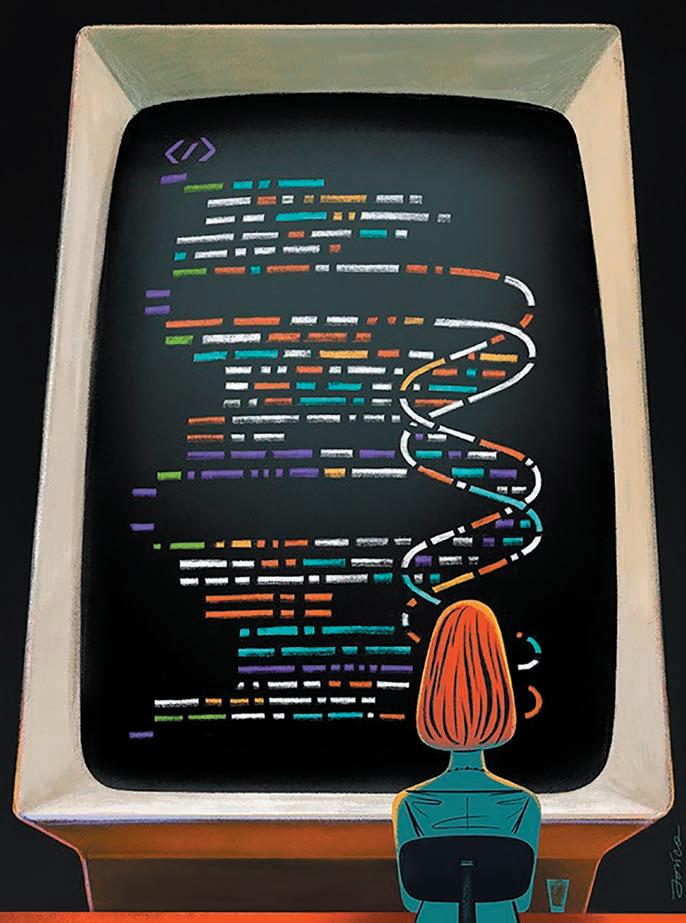

Códigos de computador que transformaram a Ciência

De Fortran a arXiv.org, esses avanços em programação e plataformas colocaram a biologia, a ciência do clima e a física em alta velocidade

por *Jeffrey M. Perkel

Fotos: David S. Goodsell (CC BY 4.0), Divulgação, Ignacio Arganda-Carreras, John Goldsmith / Celestial Visions, Nature, Paweł JońcaScience History, RCSB PDB (CC BY 4.0), University Corporation for Atmospheric Research / Science Photo Library, Wikipedia

Em 2019, a equipe do Event Horizon Telescope deu ao mundo o primeiro vislumbre de como um buraco negro realmente se parece. Mas a imagem de um objeto brilhante em forma de anel que o grupo revelou não era uma fotografia convencional. Foi computado - uma transformação matemática de dados capturados por radiotelescópios nos Estados Unidos, México, Chile, Espanha e no Pólo Sul 1 . A equipe lançou o código de programação usado para realizar essa façanha junto com os artigos que documentaram suas descobertas, para que a comunidade científica pudesse ver - e desenvolver - o que ela havia feito.

É um padrão cada vez mais comum. Da astronomia à zoologia, por trás de cada grande descoberta científica da era moderna, existe um computador. Michael Levitt, um biólogo computacional da Universidade de Stanford, na Califórnia, que ganhou uma parte do Prêmio Nobel de Química de 2013 por seu trabalho em estratégias computacionais para modelar estruturas químicas, observa que os laptops de hoje têm cerca de 10.000 vezes a memória e a velocidade do relógio que seu laboratório. construiu computador em 1967, quando começou seu trabalho premiado. “Nós realmente temos quantidades fenomenais de computação em nossas mãos hoje”, diz ele. “O problema é que ainda é preciso pensar.”

Digite o cientista-codificador. Um computador poderoso é inútil sem um software capaz de lidar com questões de pesquisa - e pesquisadores que saibam como escrevê-lo e usá-lo. “A pesquisa agora está fundamentalmente conectada ao software”, diz Neil Chue Hong, diretor do Software Sustainability Institute, com sede em Edimburgo, Reino Unido, uma organização dedicada a melhorar o desenvolvimento e o uso de software na ciência. “Isso permeia todos os aspectos da condução da pesquisa”.

As descobertas científicas obtêm, com razão, maior destaque na mídia.

A Nature mostra os bastidores, as peças-chave do código que transformaram a pesquisa nas últimas décadas. Embora nenhuma lista como essa possa ser definitiva, foram entrevistados dezenas de pesquisadores no ano passado para desenvolver uma linha diversificada de ferramentas de software que tiveram um grande impacto no mundo da Ciência. Você pode avaliar nossas escolhas no final da história.

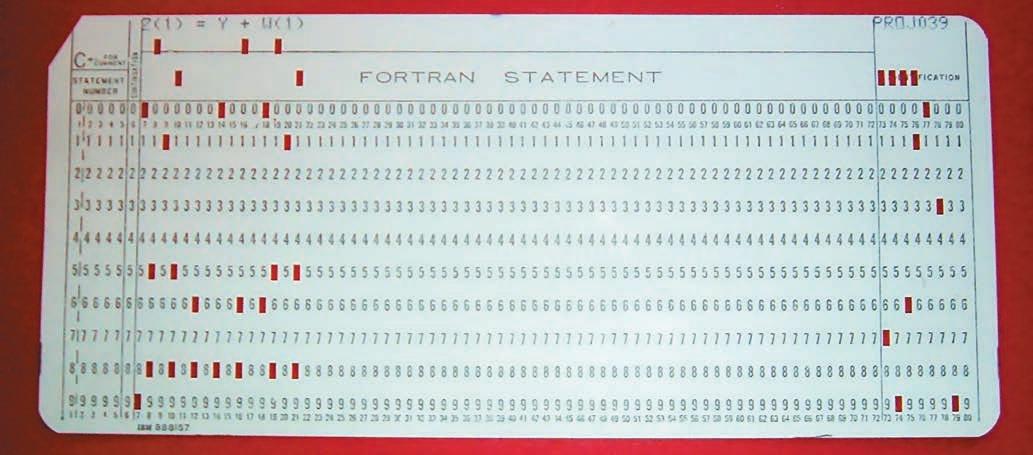

Pioneiro da linguagem: o compilador Fortran (1957)

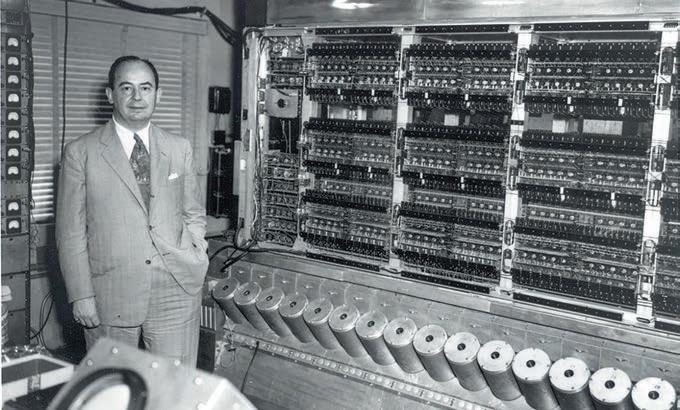

Este computador CDC 3600, entregue em 1963 ao National Center for Atmospheric Research em Boulder, Colorado, foi programado com a ajuda do compilador Fortran

Os primeiros computadores modernos não eram fáceis de usar. A programação era feita literalmente à mão, conectando bancos de circuitos com fios. As linguagens de máquina e assembly (linguagem de montagem) subsequentes permitiram aos usuários programar computadores em código, mas ambas ainda exigiam um conhecimento íntimo da arquitetura do computador, colocando as linguagens fora do alcance de muitos cientistas.

Isso mudou na década de 1950 com o desenvolvimento de linguagens simbólicas - em particular a linguagem de ‘tradução de fórmula’ Fortran, desenvolvida por John Backus e sua equipe na IBM em San Jose, Califórnia. Usando o Fortran, os usuários podiam programar computadores usando instruções legíveis por humanos, como x = 3 + 5. Um compilador então transformou essas instruções em um código de máquina rápido e eficiente.

Ainda não era fácil: nos primeiros dias, os programadores usavam cartões perfurados para inserir o código, e uma simulação complexa pode exigir dezenas de milhares deles. Ainda assim, diz Syukuro Manabe, climatologista da Universidade de Princeton em Nova Jersey, o Fortran tornou a programação acessível a pesquisadores que não eram cientistas da computação. “Pela primeira vez, fomos capazes de programar [o computador] por conta própria”, diz Manabe. Ele e seus colegas usaram a linguagem para desenvolver um dos primeiros modelos climáticos de sucesso.

Agora em sua oitava década, o Fortran ainda é amplamente usado em modelagem climática, dinâmica de fluidos, química computacional - qualquer disciplina que envolva álgebra linear complexa e requer computadores poderosos para processar números rapidamente. O código resultante é rápido e ainda existem muitos programadores que sabem como escrevê-lo. As bases de código do Fortran vintage ainda estão vivas e funcionando em laboratórios e supercomputadores em todo o mundo. “Os programadores mais antigos sabiam o que estavam fazendo”, diz Frank Giraldo, um matemático aplicado e modelador climático da Naval Postgraduate School em Monterey, Califórnia. “Eles se preocupavam muito com a memória, porque tinham muito pouca memória”.

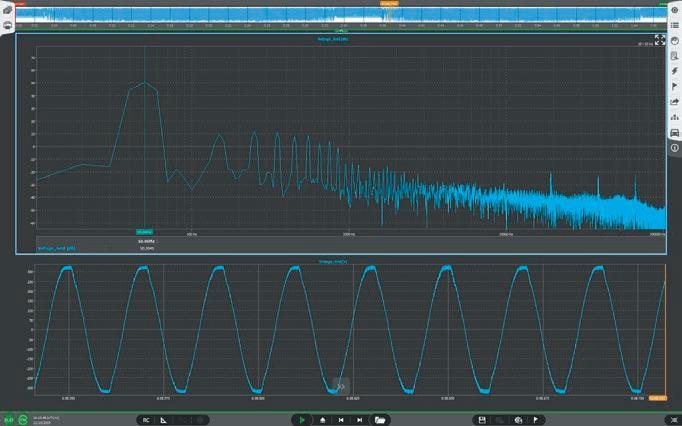

Processador de sinal: transformada rápida de Fourier (1965)

Quando os radioastrônomos examinam o céu, eles capturam uma cacofonia de sinais complexos que mudam com o tempo. Para entender a natureza dessas ondas de rádio, eles precisam ver como esses sinais se parecem em função da frequência.

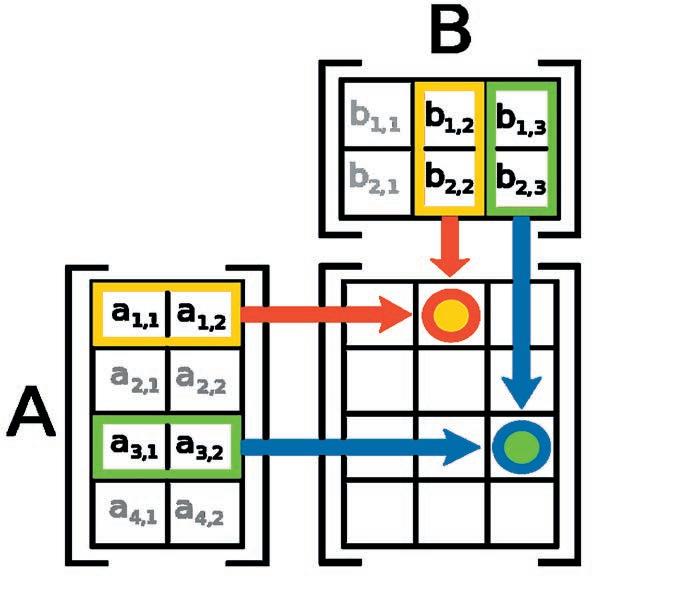

Um processo matemático chamado transformada de Fourier permite que os pesquisadores façam isso. O problema é que é ineficiente, exigindo N 2 cálculos para um conjunto de dados de tamanho N .

Em 1965, os matemáticos americanos James Cooley e John Tukey descobriram uma maneira de acelerar o processo. Usando recursão, uma abordagem de programação de ‘dividir para conquistar’ na qual um algoritmo se reaplica repetidamente, a transformada rápida de Fourier (FFT) simplifica o problema de calcular uma transformada de Fourier para apenas N log 2 ( N ) etapas. A velocidade melhora à medida que N cresce. Para 1.000 pontos, o aumento de velocidade é cerca de 100 vezes; para 1 milhão de pontos, é 50.000 vezes.

A ‘descoberta’ foi na verdade uma redescoberta - o matemático alemão Carl Friedrich Gauss a elaborou em 1805, mas nunca a publicou, diz Nick Trefethen, um matemático da Universidade de Oxford, no Reino Unido. Mas Cooley e Tukey sim, abrindo aplicativos em processamento digital de sinais, análise de imagens, biologia estrutural e muito mais. “É realmente um dos grandes eventos da matemática aplicada e da engenharia”, diz Trefethen. FFT foi implementado muitas vezes no código. Uma opção popular é chamada de FFTW, a ‘transformada de Fourier mais rápida no oeste’.

O evento reuniu no Hangar representantes da ONU Habitat, Programa das Nações Unidas para o Meio Ambiente, BNDES, Banco de Desenvolvimento da América Latina, empresários, gestores de prefeituras e governos estaduais da Amazônia, além de membros de organizações do terceiro setor

Paul Adams, que dirige a divisão de biofísica molecular e bioimagem integrada do Laboratório Nacional Lawrence Berkeley, na Califórnia, lembra que quando ele refinou a estrutura da proteína bacteriana GroEL em 1995 2 , o cálculo levou “muitas, muitas horas, senão dias”, mesmo com o FFT e um supercomputador.

“Tentando fazer isso sem o FFT, nem sei como teríamos feito isso de forma realista”, diz ele. “Teria demorado uma eternidade”.

Os bancos de dados são um componente tão integrado da pesquisa científica hoje que pode ser fácil ignorar o fato de que são orientados por software. Nas últimas décadas, esses recursos aumentaram de tamanho e deram forma a muitos campos, mas talvez em nenhum lugar essa transformação tenha sido mais dramática do que na biologia.

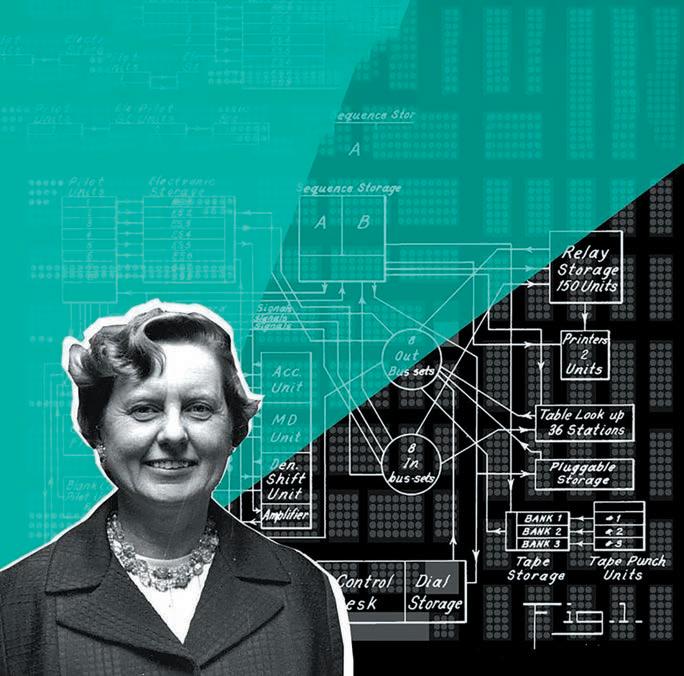

Os enormes bancos de dados de genoma e proteínas de hoje têm suas raízes no trabalho de Margaret Dayhoff, uma pioneira em bioinformática da National Biomedical Research Foundation em Silver Spring, Maryland.

No início dos anos 1960, enquanto os biólogos trabalhavam para separar as sequências de aminoácidos das proteínas, Dayhoff começou a reunir essas informações em busca de pistas sobre as relações evolutivas entre diferentes espécies. Seu Atlas of Protein Sequence and Structure , publicado pela primeira vez em 1965 com três co-autores, descreveu o que então se sabia das sequências, estruturas e semelhanças de 65 proteínas. A coleção foi a primeira que “não estava atrelada a uma questão específica de pesquisa”, escreveu o historiador Bruno Strasser em 2010 3. E codificou seus dados em cartões perfurados, o que possibilitou a ampliação do banco de dados e sua busca.

Seguiram-se outros bancos de dados biológicos computadorizados. O Protein Data Bank, que hoje detalha mais de 170.000 estruturas macromoleculares, entrou em operação em 1971. Russel Doolittle, um biólogo evolucionário da Universidade da Califórnia, San Diego, criou outro banco de dados de proteínas chamado Newat em 1981. E 1982 viu o lançamento do banco de dados que se tornaria GenBank, o arquivo de DNA mantido pelo US National Institutes of Health.

Esses recursos provaram seu valor em julho de 1983, quando equipes separadas lideradas por Michael Waterfield, um bioquímico de proteínas no Imperial Cancer Research Fund em Londres, e Doolittle relataram independentemente uma semelhança entre as sequências de um fator de crescimento humano específico e uma proteína em um vírus que causa câncer em macacos. A observação sugeriu um mecanismo de oncogênese por vírus - que ao mimetizar um fator de crescimento, o vírus induz o crescimento descontrolado de células 4 . “Isso acendeu a luz em algumas das mentes de biólogos que não gostavam de computadores e estatísticas”, disse James Ostell, ex-diretor do Centro Nacional de Informações sobre Biotecnologia dos Estados Unidos (NCBI): “Podemos entender algo sobre o câncer comparando sequências ”.

Além disso, diz Ostell, a descoberta marcou “um advento da biologia objetiva”. Além de projetar experimentos para testar hipóteses específicas, os pesquisadores poderiam minerar conjuntos de dados públicos em busca de conexões que poderiam nunca ter ocorrido àqueles que realmente coletaram os dados. Esse poder cresce drasticamente quando diferentes conjuntos de dados são interligados - algo que os programadores do NCBI conseguiram em 1991 com o Entrez, uma ferramenta que permite aos pesquisadores navegar livremente do DNA à proteína, à literatura e vice-versa.

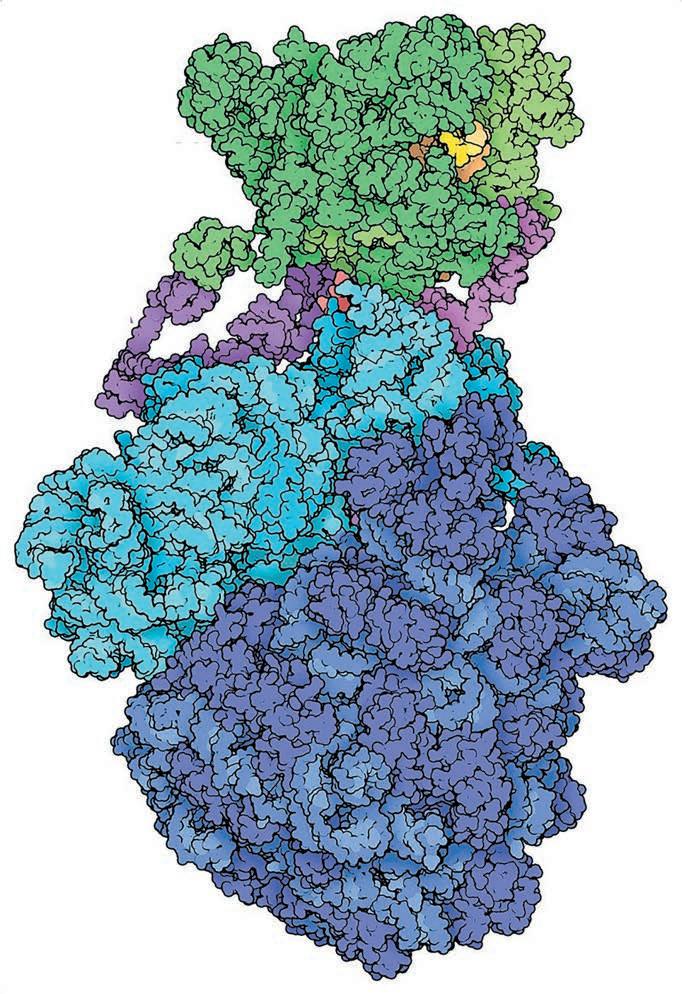

O Protein Data Bank possui um arquivo de mais de 170.000 estruturas moleculares, incluindo este ‘expressoma’ bacteriano, que combina os processos de síntese de RNA e proteína

Stephen Sherry, atual diretor interino do NCBI em Bethesda, Maryland, usou Entrez como estudante de graduação. “Lembro-me na época de pensar que era mágico”, diz ele.

Líder de previsão: o modelo de circulação geral (1969)