Master Thesis ǀ Tesis de Maestría

submitted within the UNIGIS MSc programme presentada para el Programa UNIGIS MSc

at/en

Interfaculty Department of Geoinformatics- Z_GIS

Departamento de Geomática – Z_GIS

University of Salzburg ǀ Universidad de Salzburg

Categorización de daños geo-referenciados de los ejes viales de la ciudad Quito, Ecuador usando algoritmos de Inteligencia Artificial y Python.

Classification of georeferenced damages of the road axes of the city Quito, Ecuador using Artificial Intelligence algorithms and Python.

by/por

Ing. Norman Ismael Orellana Ulloa

11938289

A thesis submitted in partial fulfilment of the requirements of the degree of Master of Science (Geographical Information Science y Systems) – MSc (GIS)

Advisor ǀ Supervisor: Leonardo Zurita Arthos PhD

Quito - Ecuador, 20/10/2022

COMPROMISO DE CIENCIA

Por medio del presente documento, incluyendo mi firma personal certifico y aseguro que mi tesis es completamente resultado de mi propio trabajo. He citado todas las fuentes que he usado en mi tesis y en todos los casos he indicado su origen.

Quito, 20 de octubre 2022 Firma

Quito, 20 de octubre 2022 Firma

AGRADECIMIENTOS

Quiero expresar mi gratitud a Dios, quien con su bendición llena siempre mi vida y a toda mi familia por estar siempre presentes.

Mi profundo agradecimiento a todas las autoridades y personal que forman parte de la UNIGIS, por confiar en mí, abrirme las puertas y permitirme realizar todo el proceso investigativo dentro de su establecimiento educativo.

Finalmente quiero expresar mi más grande y sincero agradecimiento a mis tutores, principales colaboradores y guías durante todo este proceso, quien con su dirección, conocimiento, enseñanza y colaboración permitieron el desarrollo de este trabajo de investigación.

DEDICATORIA

El presente trabajo investigativo lo dedicó principalmente a mi familia, por ser la inspiración que me brinda la fuerza para continuar en este proceso de obtener uno de los anhelos más deseados de mi carrera profesional.

A mis padres, por su amor, trabajo y sacrificio en todos estos años, gracias a ustedes he logrado llegar hasta aquí y convertirme en lo que soy. Ha sido un orgullo y el privilegio ser su hijo, son los mejores padres.

A mi esposa e hijos, por estar siempre presentes, acompañándome y por el apoyo moral, que me brindaron a lo largo de esta etapa de mi vida académica y profesional.

A toda mi familia, a mis amigos y profesores que me han apoyado y han hecho que el trabajo se realice con éxito, en especial a aquellos que me abrieron las puertas y compartieron sus conocimientos.

Norman

RESUMEN

El presente proyecto de investigación tuvo como objetivo principal la categorización de daños georreferenciados en las arterias viales de la ciudad de Quito, usando un algoritmo de inteligencia artificial desarrollado en Python. Se usó la captura de imágenes georeferenciadas mediante la aplicación Android AutoGuard©. Para el procesamiento de esta información se utilizó el programa ArcGIS Pro y su extensión LocateXT, que permitieron gestionar y administrar cartografía vectorial y ráster de los sistemas de información geográfica con los que se capturó la información. Una vez construidos las estructuras de datos con imágenes y videos georreferenciadas mediante etiquetas de identificación para el modelo de reconocimiento de imágenes por computadora se usó la aplicación Roboflow©. Mediante el uso de técnicas de I.A se entrenó el modelo de reconocimiento de daños viales.

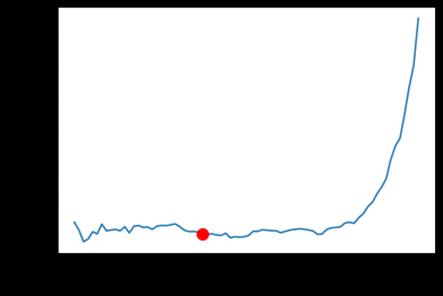

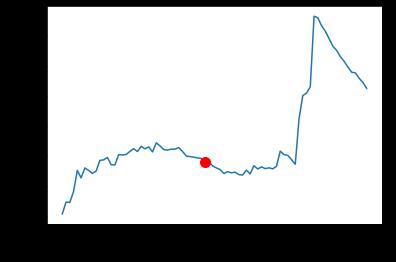

Como principales resultados se puede enunciar que, al utilizar herramientas de I.A, los procesos de detección de fallas que el personal de la EMOP Quito realiza se volverán proactivos mediante escaneos rápidos por las calles de la urbe, incrementando los puntos de prevención de accidentes o complicaciones del tráfico frente a una oportuna detección de falla. En lo referente a la tasa de aprendizaje del modelo se coordinó muy detenidamente la cantidad de categorías (clases) definidas para el reconocimiento (balancear clases) y el alto requerimiento de hardware requerido, ya que, si este último no es el mínimo necesario, el modelo será ineficiente. La ineficiencia del modelo podría categorizar generalidades que incremente su tasa de aprendizaje rápidamente, produciendo una sobrestimación de su predictibilidad o haciendo imposible el aprendizaje (resultados como generalidades de reconocimiento). Finalmente, el modelo propuesto en este trabajo de investigación se puede considerar adecuado para la categorización de las fallas en las arterias viales de la ciudad de Quito, Ecuador, debido a que el valor de la fiabilidad de sus clasificadores de imágenes (0.834116667) se encuentra cerca de 1

Palabras claves: algoritmos, daños georreferenciados, inteligencia artificial, reconocimiento, vías

5

ABSTRACT

The main objective of this research project was the categorization of geo-referenced damages in the road arteries of the city of Quito, using an artificial intelligence algorithm developed in Python. The capture of geo-referenced images using the Android AutoGuard© application was used. For the processing of this information, the ArcGIS Pro program and its LocateXT extension were used, which allowed the management and administration of vector and raster cartography of the geographic information systems with which the information was captured. Once the data structures were built with images and videos georeferenced by means of identification labels for the computer image recognition model, the Roboflow© application was used. Using A.I. techniques, the road damage recognition model was trained.

As main results it can be stated that, by using A.I. tools, the fault detection processes that the EMOP Quito staff performs will become proactive through quick scans through the streets of the city, increasing the points of prevention of accidents or traffic complications in the event of a timely fault detection. Regarding the learning rate of the model, the number of categories (classes) defined for recognition (balancing classes) and the high hardware requirement were carefully coordinated, since, if the latter is not the minimum necessary, the model will be inefficient. The inefficiency of the model could categorize generalities that increase their learning rate rapidly, producing an overestimation of their predictability or making learning impossible (results as recognition generalities). Finally, the model proposed in this research work can be considered adequate for the categorization of faults in the road arteries of the city of Quito, Ecuador, because the value of the reliability of its image classifiers (0.834116667) is close to 1.

Key world: Algorithms, georeferenced damage, artificial intelligence, recognition, pathways

6

7 INDICE DE CONTENIDOS COMPROMISO DE CIENCIA....................................................................................................2 AGRADECIMIENTOS...............................................................................................................3 DEDICATORIA 4 RESUMEN 5 ABSTRACT 6 INDICE DE CONTENIDOS 7 ÍNDICE DE FIGURAS..............................................................................................................10 ÍNDICE DE TABLAS................................................................................................................13 TABLA DE ACRÓNIMOS........................................................................................................14 1. INTRODUCCIÓN.....................................................................................................16 1.1. ANTECEDENTES.....................................................................................................17 1.2. OBJETIVO GENERAL 17 1.3. OBJETIVOS ESPECÍFICOS 17 1.4. PREGUNTAS DE INVESTIGACIÓN ..........................................................................18 1.5. HIPÓTESIS..............................................................................................................18 1.6. JUSTIFICACIÓN 18 1.7. ALCANCE ...............................................................................................................20 2. REVISIÓN DE LITERATURA.....................................................................................21 2.1. MARCO TEÓRICO 21 2.1.1. Clasificación y cuantificación de los deterioros del pavimento 21 2.1.2. Procesamiento de imágenes para el análisis de pavimentos...............................26

2.1.3. Arquitectura de la red ResNet-101.......................................................................34

2.1.4. SSD: comprensión de la detección de objetos de disparo único..........................36

2.2. MARCO HISTÓRICO 41

2.2.1. Trabajo final de grado, España: Detector de baches con Deep Learning 41

2.2.2. Artículo científico, Colombia: Técnicas de inteligencia artificial utilizadas en el procesamiento de imágenes y su aplicación en el análisis de pavimentos ........................42

2.2.3. Caso de estudio, United Kingdom: A Fast and Adaptive Road Defect Detection Approach Using Computer Vision with Real Time Implementation ...................................45

2.2.4. Proyecto de Investigación, Louisiana: Object Detection with Deep Learning: A Review. IEEE Conference on Computer Vision and Pattern Recognition (CVPR).................45

2.2.5. Caso de estudio, Cuba: Revisión de algoritmos de detección y seguimiento de objetos con redes profundas para video vigilancia inteligente. .........................................46

2.2.6. Proyecto de investigación, México: Clasificación de obstáculos a través del algoritmo SSD 47 3. METODOLOGÍA .....................................................................................................48 3.1. ÁREA DE ESTUDIO.................................................................................................48 3.2. FLUJOGRAMA DE METODOLOGÍA ........................................................................50

LA METODOLOGÍA.....................................................................53

3.4.1. Capturar la información........................................................................................53

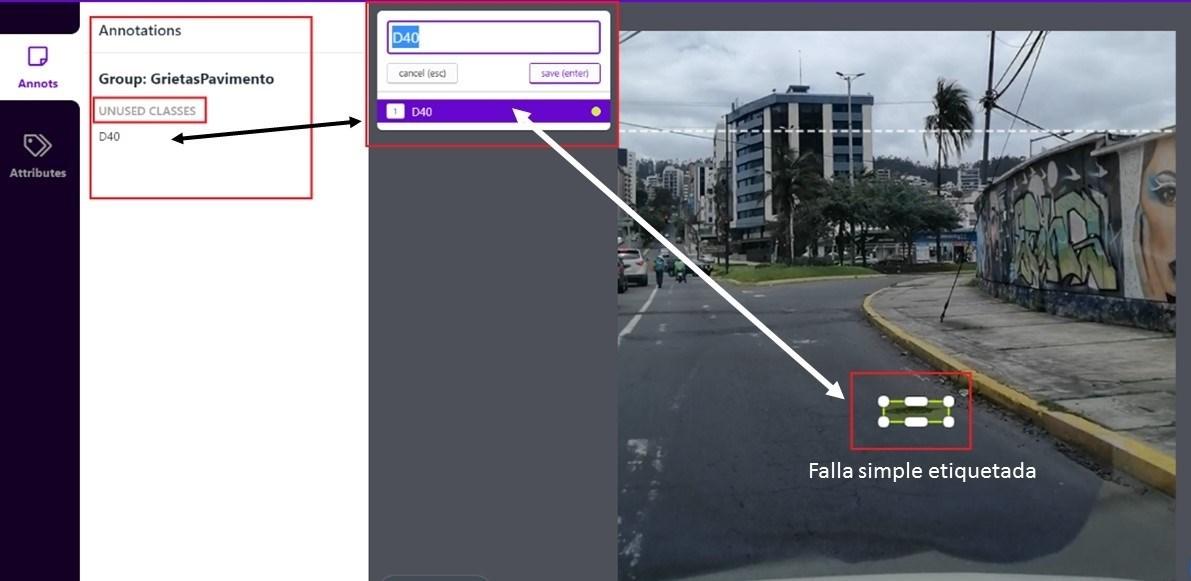

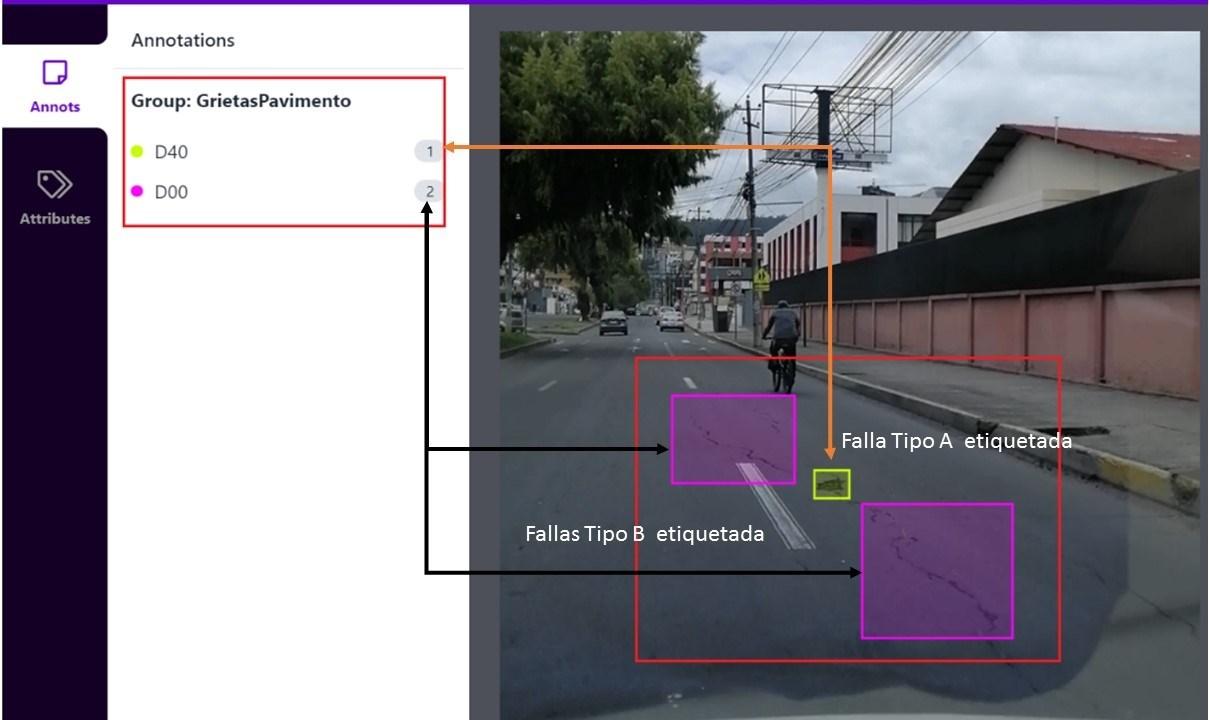

3.4.2. Preparación de datos para entrenamiento ..........................................................57

8

3.3. JUSTIFICACIÓN DE LA METODOLOGÍA 51 3.4. DESARROLLO DE

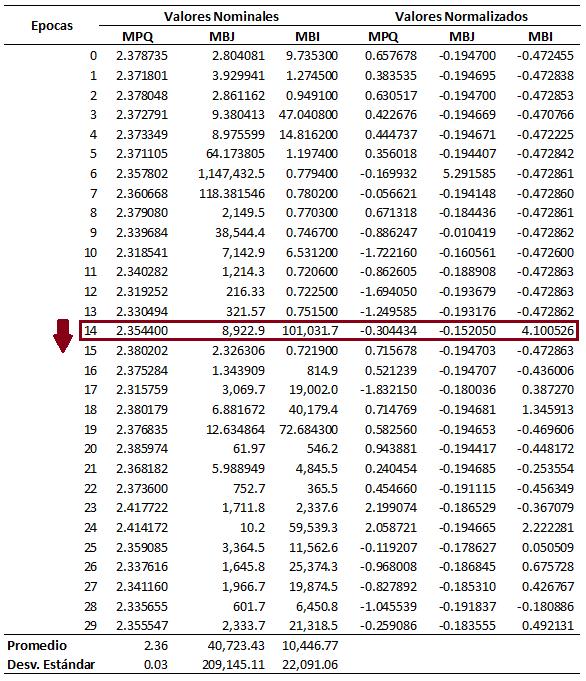

9 3.4.3. Entrenamiento del modelo de reconocimiento de fallas.....................................62 3.4.4. Preparación de lo Metadata para la validación del reconocimiento de fallas (imágenes) en una secuencia de video ...............................................................................72 3.4.5. Publicar los resultados en un Mapa Web.............................................................75 4. RESULTADOS Y DISCUSIÓN 76 4.1. RESULTADOS.........................................................................................................76 4.1.1. Aplicación de una muestra de imágenes para la validación del modelo .............76 4.1.2. Aplicación de una muestra de video para las pruebas de captura de imágenes del modelo 78 4.2. ANÁLISIS 82 4.2.1. Comparación del Aprendizaje Profundo entre modelos existentes y el modelo propio. Parámetro: Learning Rate 82 5. CONCLUSIONES Y RECOMENDACIONES ...............................................................95 5.1. CONCLUSIONES.....................................................................................................95 5.2. RECOMENDACIONES 97 6. REFERENCIAS.........................................................................................................99 ANEXOS 107 Anexo 1. NORMA NEVI-12 – MTOP: Pavimento rígido – Defectos – Terminología..........107

ÍNDICE DE FIGURAS

10

Figura 1 Terminología usada para la categorización de los pavimentos rígidos................23 Figura 2 Esquema objetivo con array de lentes .................................................................27 Figura 3 Esquema objetivo convencional 27 Figura 4 Algoritmo de clasificación 28 Figura 5 Esquema básico red neuronal...............................................................................29 Figura 6 Arquitectura de un CNN........................................................................................30 Figura 7 Aprendizaje tradicional Vs. Deep Learning 32 Figura 8 Error de entrenamiento (izquierda) y error de test (derecha) 35 Figura 9 Muestra de bloque de una red de aprendizaje por residuos ResNet....................36 Figura 10 Modelo de Detección de Imágenes CNN.............................................................37 Figura 11 Detector de caja múltiple de disparo único 38 Figura 12 Inferencia sobre Imágenes..................................................................................39 Figura 13 Marco SSD...........................................................................................................39 Figura 14 SSD Vs. R-CNN: Precisión y Velocidad.................................................................40 Figura 15 Mapa del área de estudio: Recorridos realizados 49 Figura 16 Flujograma de metodología ...............................................................................50 Figura 17 Estructura de los archivos Meta-data [*.str]......................................................54 Figura 18 Estructura del archivo de atributos personalizados: metadata .........................56

11

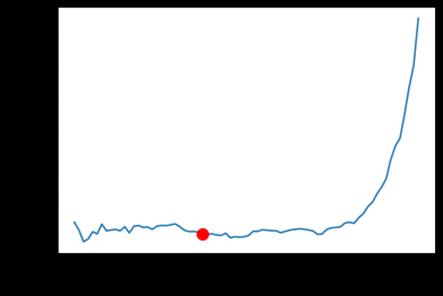

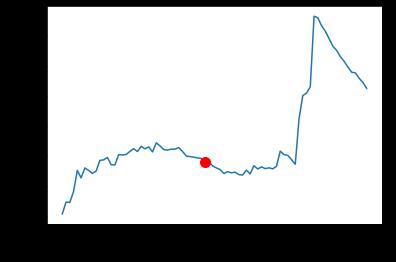

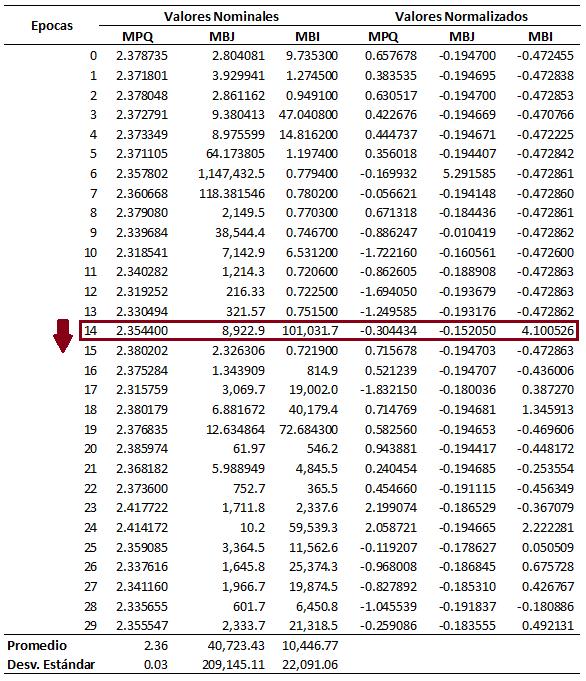

19 Entidad geográfica con información georreferenciada con segmentos.............56 Figura 20 Mapa georreferenciado de recorridos................................................................57 Figura 21 App Roboflow© ..................................................................................................58 Figura 22 Etiquetado de falla simple 59 Figura 23 Etiquetado de múltiples fallas (Clases)...............................................................60 Figura 24 Vista previa del DataSet de images con etiquetas de identificación de fallas (clases) .................................................................................................................................60 Figura 25 Estructura del archivo de entrenamiento en formato Pascal VOC.....................61 Figura 26 Proceso de entrenamiento del modelo 62 Figura 27 Visualización de los datos de entrenamiento .....................................................67 Figura 28 Definición de línea base - Predicciones...............................................................68 Figura 29 Salida ejecución comando lr_finfd() ...................................................................69 Figura 30 Salida ejecución comando plot_losses 71 Figura 31 Predictibilidad de imágenes del modelo- Ejemplo 1...........................................76 Figura 32 Predictibilidad de imágenes del modelo- Ejemplo 2...........................................77 Figura 33 Predictibilidad de imágenes del modelo- Ejemplo 3 77 Figura 34 Predictibilidad de imágenes del modelo- Ejemplo 4 78 Figura 35 Creación de una capa de información geográfica usando ArcGIS LocateXT......79 Figura 36 Archivo de video para la validación de la predicción del modelo.......................80 Figura 37 Gráfico de Pérdidas durante el entrenamiento: Train_Loss 86

Figura

Figura 38 Gráfico de Pérdidas con datos nuevos: Valid_Loss.............................................86

Figura 39 Delta Train Loss durante las épocas de aprendizaje del modelo........................91

Figura 40 Delta Valid Loss durante las épocas de aprendizaje del modelo........................91

12

ÍNDICE DE TABLAS

13

Tabla 1 Defectos Superficiales Pavimentos flexibles ..........................................................24 Tabla 2 Tensores y Arrays ...................................................................................................33 Tabla 3 Comparación de las técnicas de inteligencia artificial 43 Tabla 4 Reglas para los atributos personalizados 55 Tabla 5 Librerías para la ejecución del modelo de entrenamiento.....................................65 Tabla 6 Ajuste del modelo en base al Learning Rate ..........................................................70 Tabla 7 Secuencia de comandos para la validación del modelo en capturas de video 80 Tabla 8 Metadata con la predicción de detección en formato VMTI (Video Moving Target Indicator) 81 Tabla 9 Parámetro de Comparación: Learning Rate ..........................................................82 Tabla 10 Precisión promedio sobre pérdidas......................................................................83 Tabla 11 Valores de Pérdida durante el entrenamiento: Train Loss...................................84 Tabla 12 Valores de Pérdida con datos nuevos: Valid Loss 85 Tabla 13 Deep Learning Accuracy por Clase.......................................................................89 Tabla 14 Train Loss y Valid Loss durante las épocas de aprendizaje del modelo ...............90

TABLA DE ACRÓNIMOS

ANI Agencia Nacional de Infraestructura

API Application Programming Interface

APP Aplicación de software diseñada para ejecutarse en los smartphones

CNNs Redes neuronales convolucionales

CNTK Microsoft's Open-Source Deep-Learning Toolkit

CPU Central processing unit

CUDA Compute Unified Device Architecture

CVPR Conference on Computer Vision and Pattern Recognition

DSSTNE Deep Scalable Sparse Tensor Network Engine

EPMMOP Empresa Pública Metropolitana de Movilidad y Obras Públicas

FC Fully Connected

FPS Frames por segundo

GPU Unidades de procesamiento gráfico

HOG Histograma de gradientes orientados

IA Inteligencia Artificial

IL Inhibición lateral

INEC Instituto Nacional de Estadísticas y Censos

ITU International Telecommunication Union

JSON JavaScript Object Notation - Notación de objeto de JavaScript

MBI Modelo BigDataChallenge 2020 India

MBJ Modelo BigDataChallenge 2018 Japón

MOP-OOI-E Especificaciones Técnicas para la Construcción de Caminos y Puentes Ministerio de Obras Públicas.

MOP-OOI-F Especificaciones Generales para la Construcción de Caminos y Puentes Ministerio de Obras Públicas.

MPL Multi Layer Perceptron

MPQ Modelo Propio 2021 Quito

MTOP Ministerio de Transporte y Obra Publicas

PIP Package installer for Python

R-CNN Region-based Convolutional Neural Networks

RESNET Residual neural network

SIFT Scale-invariant feature transform

SIG Sistemas de Información Geográficos

SSD Single Shot Detector

14

VOC Visual Object Classes

XML Extensible Markup Language - Lenguaje de Marcado Extensible

15

1. INTRODUCCIÓN

De acuerdo con Zhao (2017), secretario general de la International Telecommunication Union (ITU, por sus siglas en inglés), la Cumbre Mundial AI for Good del 2017 fue el primer evento que inauguró el diálogo mundial sobre la posible contribución de la inteligencia artificial (IA) al bien común. Mientras que en ella se puso en marcha el primer diálogo mundial inclusivo sobre los beneficios de la IA, la cumbre de 2018 estuvo orientada a la acción y se centró en soluciones de IA eficaces y capaces de generar beneficios a largo plazo para diferentes áreas del conocimiento humano y para aplicaciones que ayudarán a mejorar los niveles de vida en las urbes del mundo(UTI, 2017).

Una de las áreas de aplicación, donde en los últimos años se ha impulsado el uso de herramientas de IA embebidas en aplicaciones GIS son aquellas enfocadas en la infraestructura vial. Los departamentos gubernamentales, nacionales y seccionales responsables del transporte se han visto en la necesidad de implementar herramientas efectivas para gestionar activos, recursos humanos, operaciones viales y administrativas mediante aplicaciones GIS combinadas con IA que les permita planificar, monitorear y gestionar infraestructura de calles, autopistas y rutas, de forma efectiva. Estas aplicaciones les han permitido determinar la capacidad y operaciones de mejoras e identificar las inversiones más estratégicas, como es el caso de éxito de la Agencia Nacional de Infraestructura (ANI) de Colombia, donde como parte de su estrategia de transparencia, la ANI identificó la necesidad de crear una solución que permitiera comunicar, tanto interna como externamente, los avances de los proyectos de infraestructura vial (ANI, 2021)

El éxito de estos desarrollos se ha fundamentado en los sistemas de reconocimiento de objetos. El reconocimiento y clasificación de objetos se realiza mediante técnicas de inteligencia artificial ejecutadas en un computador y, mediante algoritmos, el sistema de reconocimiento de objetos es entrenado mediante ejemplos previos, y se evalúa su comportamiento frente a nuevos objetos de la misma clase para los cuales ya ha sido entrenado (Condori, 2013).

16

1.1. ANTECEDENTES

En la ciudad de Quito, así como en otras ciudades, los daños en las vías son causados por diferentes factores como construcción deficiente, terreno irregular, precipitaciones, carga vehicular entre otros. La ubicación temprana de estos daños en los tramos de las vías permitirá a las organizaciones que realizan el mantenimiento vial, entender que tipos de daños ocurren en diferentes tramos, donde se encuentran ubicadas la mayor cantidad de estos problemas y planificar adecuadamente su mantenimiento preventivo. Tradicionalmente, este proceso se lleva a cabo mediante el registro en formularios de papel de la localización de dichos problemas, para luego sistematizarlos, evaluarlos y categorizar el problema para eventualmente planificar la intervención. Esto implica una gran cantidad de tiempo y recursos que pueden disminuirse utilizando herramientas tecnológicas que simplifiquen el proceso actualmente establecido. Este proceso de investigación tiene como objetivo implementar un modelo de inteligencia artificial, el cual, mediante el uso de imágenes obtenidas a partir de video capturado usando dispositivos móviles-smartphones, permitirá determinar el tipo de daño o grietas que existen en las vías y su ubicación en un mapa

1.2. OBJETIVO GENERAL

Formular una categorización de daños georreferenciados en las arterias viales de la ciudad de Quito (Ecuador) usando un algoritmo de inteligencia artificial desarrollado en Python

1.3. OBJETIVOS ESPECÍFICOS

• Definir una base de datos de imágenes de los daños en las vías de la ciudad de Quito, Ecuador capturadas desde videos georreferenciados.

• Describir el proceso de aprendizaje y categorización de los daños en las vías mediante el uso de un algoritmo de Inteligencia Artificial desarrollado en Python

17

• Evaluar la fiabilidad de la categorización del algoritmo de daños en las vías de la ciudad de Quito, Ecuador utilizando mapas de distribución espacial de las categorías de daños identificados.

1.4. PREGUNTAS DE INVESTIGACIÓN

• ¿Cómo utilizar imágenes desde videos georreferenciados para generar un inventario de daños en las vías de la ciudad de Quito?

• ¿Cómo utilizar herramientas de inteligencia artificial para implementar el proceso de aprendizaje y categorización de los daños en las vías de la ciudad de Quito?

• ¿Cómo evaluar la fiabilidad de la categorización de un algoritmo de detección de daños en las vías de la ciudad de Quito?

1.5. HIPÓTESIS

La aplicación de algoritmos de inteligencia artificial desarrollados en Python mejorará los tiempos de respuesta para la detección y evaluación de daños en las vías de la ciudad de Quito, Ecuador para el año 2021. Para validar esta hipótesis se comparará el tiempo actual que la empresa de movilidad y obras públicas del Municipio de Quito toma para la detección y evaluación de los tipos de daños en las vías y contrastarlo con el tiempo que tomará en procesar el algoritmo de inteligencia artificial para detección del mismo objeto detectado usando una herramienta tecnológica.

1.6. JUSTIFICACIÓN

La inteligencia artificial es una tecnología que desde hace algunas décadas ha estado presente Según Bellman (1978), mencionado por Jatoba et al. (2019, p.97), una de las definiciones de Inteligencia Artificial es “La automatización de actividades que se vinculan con procesos de pensamiento humano, actividades como la toma de decisiones, resolución de problemas, aprendizaje”.

18

En la actualidad, esta tecnología se ha vuelto más accesible, tanto para las necesidades personales como para las organizacionales. Esto se ha vuelto posible debido al avance de las tecnologías informáticas que permiten mayor capacidad de almacenamiento y procesamiento. El trabajo manual y repetitivo que una computadora puede realizar es realmente impresionante, tal como lo demostró Rohit Singh1 en la presentación que se realizó en la conferencia de desarrolladores de ESRI en Palmspring en el año 2019, en la que se mostró cómo se pueden implementar diferentes algoritmos-soluciones con inteligencia artificial. Uno de estos algoritmos que se presentaron fue el diseñado para la detección de fallas en las vías a partir de información recolectada con una cámara de video en un vehículo. Los conceptos usados en esta solución, que se aplicó en otros países como Japón, India y Grecia, podrían ayudar a la ciudad de Quito para resolver una de las preocupaciones constantes de quienes viven en esta ciudad, como es la del mantenimiento de la infraestructura vial. Los daños en las vías ocasionan afectaciones en los vehículos, así como también pueden ser detonantes de accidentes de tránsito. La detección temprana de estos daños o grietas en las vías asfaltadas es responsabilidad de la Empresa Pública Metropolitana de Movilidad y Obras Públicas (EPMMOP), actividad que se la vienen realizando, de acuerdo con los técnicos que manejan el Sistema de Información Geográfica de la EPMMOP, en forma manual y en base de decisiones políticas de acuerdo con las necesidades expresadas desde la ciudadanía. Todo esto debido a que la EPMMOP no cuenta con una herramienta tecnológica que permita realizar de forma automatizada este proceso, tal como se lo ha implementado en otras ciudades. La aplicación de los algoritmos de inteligencia artificial en comunión con los Sistemas de Información Geográfica se ha convertido en una oportunidad favorable para la automatización de tareas manuales con respecto a la ubicación de los problemas viales.

19

1 Director del Centro de Desarrollo e investigación de Inteligencia Artificial en New Delhi de ESRI Inc.

Actuar con un enfoque preventivo permitirá a la EPMMOP considerar realizar el mantenimiento vial a tiempo evitando daños mayores y minimizando los costos de reparación en la capa asfáltica, y con la posibilidad de contrarrestar los tiempos de espera en las inspecciones manuales y determinar el tipo de daño que existe en una ubicación geográfica específica todo esto de manera automatizada, y esto trae un beneficio intrínseco para la ciudadanía.

1.7. ALCANCE

El presente estudio explorará el uso de algoritmos Single Shot Detector (SSD) basados en redes neuronales convolucionales para la detección de imágenes y la eficiencia de la categorización de estas en un inventario de daños de las vías urbanas de la ciudad de Quito, Ecuador en el periodo marzo 2021. El proyecto no se limitará solamente a evaluar un algoritmo de detección de imágenes sino a diseñar e implementar una solución que se aplique en el Departamento de Obras Públicas del Distrito Metropolitano de la ciudad de Quito.

• No se tiene como objetivo el desarrollo de un algoritmo de detección de imágenes, sino la evaluación de un algoritmo en lenguaje Python, basado en una red neuronal ResNet101 y un modelo SSD.

• Los beneficiarios directos de este proyecto de investigación son los responsables del mantenimiento vial del Departamento de Obras Públicas del Distrito Metropolitano de la ciudad de Quito e indirectos las unidades financieras responsables de la elaboración de los presupuestos para mantenimiento vial del GAD del Distrito Metropolitano de la ciudad de Quito. Finalmente, los habitantes del Distrito Metropolitano de la ciudad de Quito se beneficiarán de este proyecto, ya que, al mejorar la calidad de las vías y su mantenimiento, la eficiencia de la movilidad se incrementaría dentro del distrito.

20

2. REVISIÓN DE LITERATURA

2.1. MARCO TEÓRICO

2.1.1. Clasificación y cuantificación de los deterioros del pavimento

De acuerdo con la historia de la evolución de la Norma Ecuatoriana Vial Norma Ecuatoriana Vial NEVI-12 - MTOP, la infraestructura vial en el Ecuador ha mantenido una historia de afectaciones constantes, como paralizaciones y colapso de puentes y caminos, generadas tanto por el riesgo sísmico cuanto por los factores climáticos a los que por décadas los Gobiernos han tenido que afrontar con soluciones inmediatistas y onerosas para el erario nacional, sin ningún soporte tecnológico que garantice una seguridad adecuada para el desarrollo. Las afectaciones de la red vial antes señaladas a su vez, de forma directa, han incidido negativamente al proceso de desarrollo económico y productivo del Ecuador, fomentando la pobreza y limitando el acceso a bienes, productos y servicios vitales garantizados por la Constitución. Las regulaciones técnicas del Ministerio de Transporte y Obras Públicas (MTOP: MOP-OOI-F y MOPOI-E), generadas en 1974, contribuyeron inicialmente para solucionar los aspectos antes mencionados. En 1993 fueron actualizadas, con mínimos cambios, a través de Acuerdos Ministeriales (Subsecretaria de Infraestructura del Transporte, 2013)

Formas de clasificación de los deterioros del pavimento

Dentro de la Norma NEVI-12 – MTOP para la generación de un inventario de daños visibles es necesario evaluar la condición global de un pavimento. Esta información es la que determina la localización y la extensión de las investigaciones posteriores, con el fin de establecer un juicio apropiado sobre la condición del pavimento que es objeto de la evaluación. Para evaluar los daños de un pavimento la norma considera tres factores (Subsecretaria de Infraestructura del Transporte, 2013):

21

a. Los deterioros se agrupan esencialmente en categorías, de acuerdo con los mecanismos que los originan. Como un primer paso, pueden clasificar de acuerdo con su causa primaria posible, sea ésta la acción del tránsito, sea la acción climática, sean los materiales o el proceso de construcción

b. Otra manera de clasificar los deterioros, es de acuerdo con la relación que ellos tengan con el comportamiento estructural del pavimento. Bajo esta perspectiva, se distinguen dos casos límites: deterioros estructurales y deterioros funcionales.

c. Otras características indeseables, como el excesivo nivel de ruido que afecta a los residentes vecinos a la vía 0 las propiedades ópticas inadecuadas que afectan a los usuarios, pueden ser el resultado de una inapropiada selección de materiales de construcción, pero también se pueden originar en el desgaste o en la polución de la superficie de rodamiento y de la señalización horizontal

Nomenclaturas de la Norma Ecuatoriana NEVI-12 – MTOP para la categorización de los deterioros de los pavimentos

Dentro de la Norma Ecuatoriana NEVI-12 – MTOP se especifica la nomenclatura y la definición de las categorías de daños que pueden presentarse en el sistema vial ecuatoriano. En el estudio “Development of a pavement condition rating procedure for roads, street, and parking lots”, desarrollado por Hein, Eng, y Burak (2007), se hace referencia al concepto de deterioro que fue utilizado como base para esta clasificación en la norma y que fue mencionado por Gabela (2013):

Los deterioros son aquellas modificaciones del pavimento respecto de su estado que se han desarrollado por el desgaste normal, deficiencias de los que lo conforman o lo soportan, factores como: aire, agua, luz ultravioleta, casos fortuitos como: fallas de sistemas de alcantarillado y abastecimiento de agua potable, erupciones volcánicas, entre otros, que disminuyen los niveles de seguridad, comodidad y confianza de los pavimentos, obligando de cierta manera a disminuir la velocidad de los vehículos que transitan, ya sea por seguridad, comodidad o ambos. En casos extremos de deterioro la circulación vehicular puede verse interrumpida (p. 7).

22

En función de esta definición se estableció la terminología usada en la norma ecuatoriana

NEVI-12 – MTOP para pavimentos rígidos, en la cual el MTOP (2012) conceptualiza los defectos como una “anomalía observada en el pavimento debida a problemas en la fundación, por mala ejecución o por mal uso del pavimento. Un defecto puede ser de varios tipos” (p. 122). En el Anexo 1 de este trabajo se encuentra el listado de la terminología usada para la categorización de los pavimentos rígidos. La Figura 1 muestra un resumen de esta terminología:

Figura 1

Terminología usada para la categorización de los pavimentos rígidos

Fuente: Adaptado MTOP-CAF-IBCH (2012)

23

Para definir en forma clara y precisa los tipos de deterioro, sus causas y acciones de corrección, en el manual de construcción de pavimentos del MTOP constan una serie de lineamientos que especifican cada uno de los deterioros por tipos de pavimentos (MTOPCAF-IBCH, 2012), los mismos que son resumidos en la Tabla 1

Tabla 1

Defectos Superficiales Pavimentos flexibles Tipo (Descripción)

• Perdida de agregado: Remoción de partículas (d > 6 mm) de la superficie

• Desgranamiento. Pérdida progresiva del material desde la superficie hacia abajo

• Afloramiento del asfalto (exudación). Exceso ligante en la superficie permitiendo una textura suave y resbaladiza, preferentemente en la zona de circulación

Deformaciones superficiales pavimentos flexibles

• Ondulación transversal. Ondulaciones transversales relativamente regulares

• Ondulación por desplazamiento Deformación plástica del pavimento principalmente en sentido longitudinal)

• Ahuellamiento. (Depresión transversal en la zona de circulación)

• Distorsión. Pérdida importante de la geometría transversal original

Agrietamientos Pavimentos Flexibles

• Agrietamiento longitudinal en la zona de circulación (Agrietamiento en el sentido longitudinal situado en la zona de circulación).

• Agrietamiento longitudinal en el centro de la vía. (Grietas longitudinales próximas al eje de la vía. Normalmente formado por sola grieta. Ocasionalmente con grietas secundarias)

• Agrietamiento longitudinal en el centro de la calzada. (Grietas longitudinales próximas al eje central de la calzada).

• Agrietamiento longitudinal en el borde (Grietas longitudinales entre el borde y 0,30 m hacia el centro)

• Agrietamiento sinuoso (Grietas sin dirección fija que se inicia y termina en los bordes)

• Agrietamiento transversal (Grietas perpendiculares al eje de la calzada. Normalmente si se desarrollan a todo lo ancho).

24

Agrietamientos Pavimentos Flexibles

• Agrietamiento tipo piel de cocodrilo. (Grietas que forman una red, en forma de bloques de tamaños irregulares cuyas dimensiones son indicativas del nivel en el cual ocurre la falla. Bloques cuyos lados son menores a 15 cm, indican fallas en las bases. Bloques de dimensiones mayores a 30 cm, indican fallas en la subrasante. Este agrietamiento normalmente va acompañado de deformaciones verticales y ocurre en capas asfáltica de poco espesor)

• Agrietamiento irregular (Grietas in orientación definida, usualmente llamados "grietas mapa", formando grandes bloques)

Defectos superficiales en pavimentos rígidos

• Descascaramiento (Perdida de material superficial en forma de "escamas". En general no tiene efectos estructurales dañinos).

• Desgaste superficial (Pulimiento de la superficie con aparición de agregado grueso, En general no tiene efectos estructurales dañinos)

• Fisuramiento. (Agrietamiento poco severo con aparición de líneas finas interconectadas o familia de fisuras aproximadamente paralelas. En general no tiene efectos estructurales dañinos)

• Excesiva rugosidad

Agrietamiento de pavimentos rígidos

• Agrietamiento transversal (Grieta en dirección perpendicular al eje de la calzada)

• Agrietamiento longitudinal (Grietas en dirección paralela al eje de la calvada ubicada en el interior de la losa).

• Agrietamiento de esquina (Grieta en las esquinas de los paños formando fisuras triangulares. Normalmente en la esquina exterior en pavimentos con juntas rectas y en la esquina del ángulo agudo interior en caso de juntas desviadas)

• Desintegración (Grieta en direcciones, desintegración del pavimento. Perdida de adhesión entre mortero y agregado grueso)

25

Fuente: MTOP-CAF-IBCH (2012)

2.1.2. Procesamiento de imágenes para el análisis de pavimentos

El estudio de imágenes en las mezclas asfálticas en la actualidad se usa para detectar grietas en la estructura utilizando la segmentación de bordes y la manipulación del contraste de la imagen, obteniendo información sobre el tipo falla y elementos útiles para los estudios sobre pavimentos (Li, Zhou, Liu, Li, y Cao, 2016). Para los autores, la recuperación de imágenes es un tema fundamental en el reconocimiento de patrones y adoptan el modelo de inhibición lateral (LI) como paso de preprocesamiento, que ensancha los gradientes de nivel de gris para facilitar el esquema de recuperación de imágenes. Al buscar una coincidencia perfecta entre una plantilla predefinida y una imagen de referencia, se adoptan algoritmos metaheurísticos para una buena capacidad de búsqueda. En la actualidad dos de los métodos más usados para la obtención de imágenes que van a ser procesadas para la detección de baches son:

a) Profundidad de campo. Las imágenes con profundidad de campo se basan en la incidencia de la luz en un objeto y su rebota en diferentes direcciones, que pueden ser captadas por dispositivos capaces de tomar diferentes convergencias de los rayos de luz (distintas direcciones) en una misma toma, y de ese modo se puede obtener imágenes con una cierta profundidad y considerarlas una imagen con profundidad 3D (Garamendi, 2017)

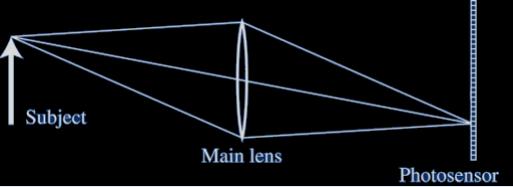

b) Imágenes convencionales 2D. Para este tipo de captura de imágenes se pueden utilizar cámaras de varios tipos:

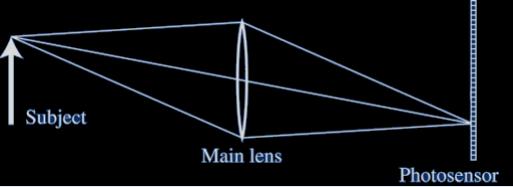

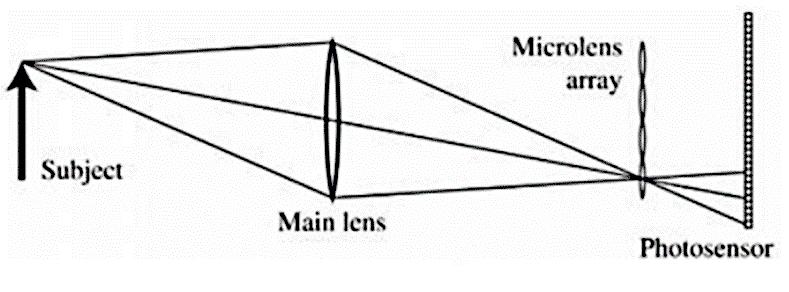

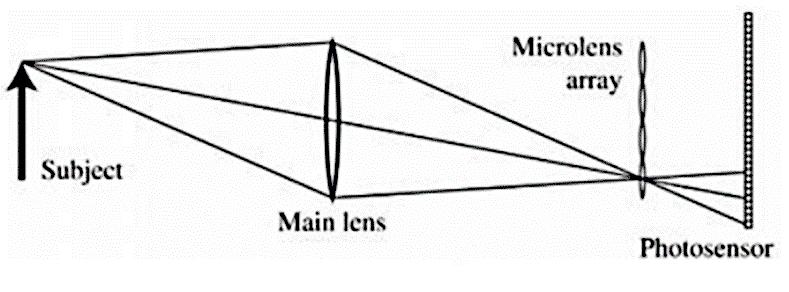

• Cámaras plenópticas. De acuerdo con Roca (2016), las cámaras plenópticas son los dispositivos disponibles en el mercado que utilizan tecnología de matriz de lentes. Con este tipo de cámaras, se puede llegar a extraer de un solo disparo distintos planos focales, permitiendo enfocar varios planos simultáneamente.

En este método, se utiliza un array de lentes, pero en este caso, se colocan detrás de la lente principal del objetivo. De ese modo, y con un sensor más amplio, se consigue desfragmentar los rayos de luz según su ángulo o dirección como se muestra en la Figura 2.

26

Fuente: Adaptado de Roca (2016)

• Cámaras fotográficas normales. La captura es en 2D, únicamente recoge los rayos de luz que inciden en la lente y que posteriormente converjan en el sensor. La Figura 3 muestra que estas imágenes no proporcionan factores de profundidad de campo, pueden ser realizadas con distinta distancia focal (zoom) o variando la apertura del diagrama, conseguir distintos enfoques o profundidad de campo, pero en ningún caso proporcionarán la visión para aplicar una segmentación por la profundidad en el terreno (Illescas, 2021).

Fuente: Adaptado de Illescas (2021)

De acuerdo con Yu, Yuan, Dong y Riha (2016), estos métodos tradicionales presentan problemas de sensibilidad, por la interferencia de la luz en la captura. Esto interfiere en la nitidez y contraste en la foto. Los autores afirman que en los años recientes se ha trabajado para tratar de mejorar estos sistemas con la implementación de técnicas de inteligencia artificial (IA). Ali, Wook, Pant, y Siarry (2015) definen que las técnicas de IA más utilizadas en las últimas décadas para el procesamiento de imágenes según son las redes neuronales,

27

Figura 2

Esquema objetivo con array de lentes

Figura 3

Esquema objetivo convencional

los sistemas difusos y los algoritmos evolutivos en donde se destacan los sistemas inmunes artificiales y la inteligencia de enjambre

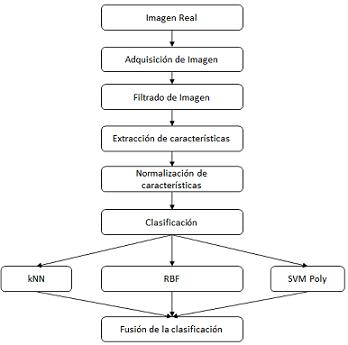

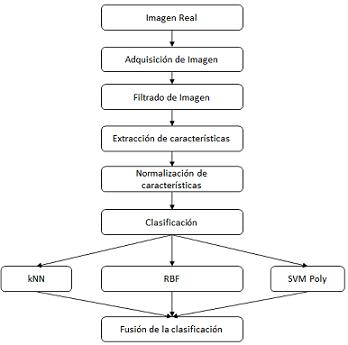

a) La lógica difusa permite valores intermedios para poder definir estados convencionales como sí/no, verdadero/falso, negro/blanco, etc. Este tipo de nociones como más caliente o poco frío pueden expresarse matemáticamente y ser procesados por computadoras. Miranda y Felipe (2015) argumentan que los conjuntos difusos se han usado en el trabajo con imágenes ya que no limitan numéricamente el desarrollo; esto es útil cuando se trabaja con imágenes debido a que sus características no se pueden delimitar de una forma exacta. De acuerdo con Mollajan, Ghiasi-Freez y Memarian (2016), la Figura 4 muestra el algoritmo para reconocimiento de imágenes en sistemas difusos e identifica que su desarrollo se da en 5 etapas:

Fuente. Adaptado de Mollajan et al. (2016)

b) Según Albuquerque, Alexandria, Cortez y Tavares (2009), el cerebro está constituido por neuronas que guardan y procesan una gran cantidad de información, por este motivo las redes neuronales artificiales buscan simular ese comportamiento del

28

Figura 4 Algoritmo de clasificación

cerebro. En la Figura 5, se muestra la estructura básica por capas neuronales propuesta por los autores, donde una primera capa está compuesta por las neuronas de entrada o input, la siguiente capa es la capa oculta, donde se puede tener varias capas de neuronas y finalmente la última capa es la capa de salida u output

Figura 5

Fuente. Adaptado de Basogain (2019)

En sus estudios, Mashaly y Alazba (2016) presentan dos tipos de redes para el procesamiento de imágenes: la multicapa que es la más utilizada y también las redes neuronales convolucionales, las cuales son especializadas para el trabajo con imágenes.

• La red neuronal multicapa o MPL (Multi Layer Perceptron) se basa en la unión de neuronas organizadas y distribuidas a lo largo de diferentes capas (Islam, Hannan, Basri, y Arebey, 2013). Este tipo de redes sirven para copiar el comportamiento de cualquier sistema usando entradas y salidas conocidas, de esta forma es capaz de clasificar elementos o imitar el funcionamiento de una estructura (Hekayati y Rahimpour, 2017)

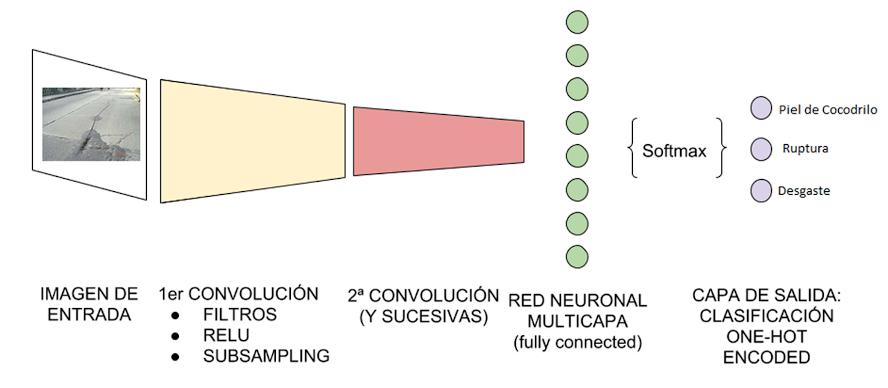

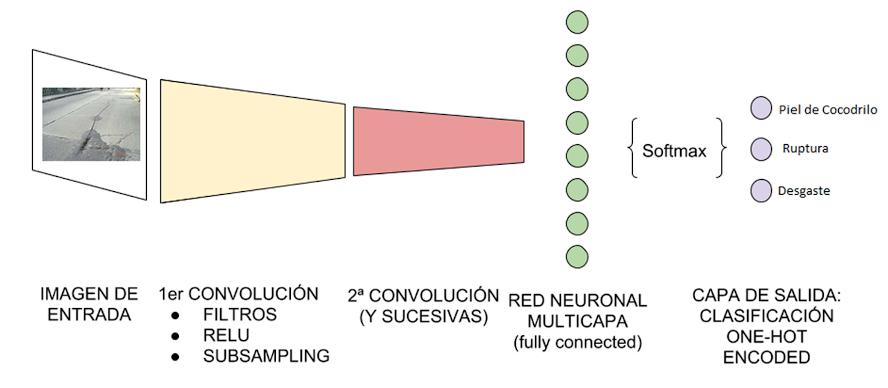

• Las redes neuronales convolucionales (CNNs)

Las redes neuronales convolucionales (CNNs)

Las redes neuronales convolucionales (CNNs) se han usado últimamente en tareas de análisis de imágenes, sobre todo destacando su uso en los procedimientos de clasificación

29

Esquema básico red neuronal

y reconocimiento (Zhang, Zeng, Zhang, Zhang, y Wu, 2017). Este modelo de red se ha desarrollado inspirado en el sistema de aprendizaje biológico. Según Zhang, Qu, Ma, Guan y Huang (2016), extraer las características propias de un elemento que lo diferencian de otros es un proceso que realizan los seres humanos con la vista y que las CNNs tratan de emular De acuerdo con Montoya (2018), la CNN es un tipo de Red Neuronal Artificial con aprendizaje supervisado que procesa sus capas imitando al córtex visual del ojo humano para identificar distintas características en las entradas que en definitiva hacen que pueda identificar objetos y “ver”. El mismo Montoya (2018) propone que las principales tareas que realiza una CNN son:

• Detección/categorización de objetos.

• Clasificación de escenas.

• Clasificación de imágenes en general.

Para la realización de estas tareas la CNN contiene varias capas ocultas especializadas (Figura 6) y con una jerarquía: esto quiere decir que las primeras capas pueden detectar líneas, curvas y se van especializando hasta llegar a capas más profundas que reconocen formas complejas (Pérez, Serrano, Acha, y Linares, 2011).

30

Figura 6 Arquitectura de un CNN

Fuente Adaptado de Pérez e al. (2011)

Donde:

• Las covoluciones consisten en tomar “grupos de pixeles cercanos” de la imagen de entrada e ir operando matemáticamente (producto escalar) contra una pequeña matriz que se llama kernel (Montoya, 2018) . Para Paris, Nakano-Miyatake y Robles-Camarillo (2016), las capas convolucionales se entienden como un conjunto de filtros comúnmente llamados: campos receptivos, éstos se ajustan para la extracción de características de una señal. A diferencia de una red neuronal tradicional, en la que cada neurona de una capa se conecta a todas las neuronas de la otra, conocido como Fully Connected (FC), en las CNN se comparten las neuronas a través de filtros que permiten extraer información de las imágenes de entrada.

• La función Softmax, también conocida como softargmax o función exponencial normalizada, es una generalización de la función logística a múltiples dimensiones. Se utiliza en la regresión logística multinomial y, a menudo, se utiliza como la última función de activación de una red neuronal para normalizar la salida de una red a una distribución de probabilidad sobre las clases de salida predichas (Bishop, 2016)

Deep Learning

De acuerdo con Matich (2001), las redes neuronales no son más que otra forma de simular ciertas características de aprendizaje propias del cerebro humano, la capacidad de memorizar y la asociación de hechos. En base a esta definición los autores concluyeron que aquellos problemas que no pueden expresarse a través de un algoritmo tienen una característica en común para su resolución: el aprendizaje a través de la experiencia. Deep Learning (Aprendizaje Profundo) es un algoritmo automático estructurado o jerárquico que emula el aprendizaje humano con el fin de obtener ciertos conocimientos. La Figura 7 hace un resumen comparativo de un algoritmo que aprende representaciones de datos con múltiples niveles de abstracción frente al aprendizaje tradicional (Cifuentes, Mendoza, Lizcano, Santrich, y Moreno, 2019).

31

Figura 7

Aprendizaje tradicional Vs. Deep Learning

Fuente. Adaptado de Silva (2020)

Autores como Valderrama (2017) proponen una reflexión comparativa para establecer las diferencias entre el aprendizaje tradicional y el Deep Learning:

El aprendizaje tradicional es un proceso completamente supervisado y el desarrollador debe ser muy específico al generar un algoritmo para indicarle al computador qué tipo de características debe buscar en una imagen para decidir si esta contiene una categoría especial de objeto, la tasa de éxito de la detección del objeto depende únicamente de la capacidad del programador para definir con precisión el conjunto de características para categorizar el objeto, mientras que en Deep Learning el algoritmo construye el conjunto de características por sí mismo sin supervisión, lo que vuelve al proceso de detección de imágenes más rápido y más preciso (p.40)

Vázquez (2018) define las características que ofrece la aplicación de Deep Learning y sus avances como ejemplos de su potencial:

• Clasificación de imágenes a nivel casi humano.

• Reconocimiento de voz a nivel casi humano.

• Transcripción de escritura a mano a nivel humano.

32

• Mejora de la traducción automática.

• Mejora de la conversión de texto a voz.

• Asistentes digitales como Google Now o Amazon Alexa.

• Conducción autónoma a nivel humano.

• Mejora de la orientación de anuncios, tal como la utilizan Google, Baidu y Bing.

• Mejora de los resultados de búsqueda en la web.

• Responder preguntas de lenguaje natural.

Ahora bien, dentro de Deep Learning, Kossaifi, Panagakis, Anandkumar y Pantic (2018) definen el concepto de tensor como fundamental para la representación de las estructuras de datos en Redes Neuronales y por lo tanto la base fundamental de Deep Learning. Un tensor es la estructura de datos principal utilizada por las redes neuronales. Las entradas, salidas y transformaciones dentro de las redes neuronales se representan utilizando tensores, y como resultado, la programación de redes neuronales utiliza tensores en gran medida. Matemáticamente hablando en el caso general, una matriz de números dispuestos en una cuadrícula normal con un número variable de ejes se conoce como tensor. Los tensores son una representación más generalizada de vectores que interactúan en dimensiones más altas. Tienen dos parámetros llamados dimensiones y rango.

Brownlee (2018) hace una definición más específica del concepto tensor para ciencias computaciones: En ciencias de la computación, se deja de usar palabras como, número, matriz, matriz 2d, y se empieza a usar la palabra matriz multidimensional o nd-array. En la Tabla 2, se indica el número de índices necesarios para tener acceso a un elemento específico dentro de la estructura de información, por lo que el autor concluye que, para fines prácticos en la programación de redes neuronales, tensores y nd-arrays son lo mismo.

Tabla 2

Tensores y Arrays

Índices Requeridos Ciencias computaciones Matemáticas N nd-Arrays nd-Tensor

Fuente: Browlee (2018)

33

Por lo tanto, los tensores son arreglos multidimensionales o nd-arrays. La razón por la que un tensor es una generalización es porque se usa el termino tensor para diferentes formas de arreglos (Browlee, 2018):

• Un escalar es un tensor de 0 dimensiones

• Un vector es un tensor dimensional 1

• Una matriz es un tensor dimensional 2

• Una nd-array es un tensor n dimensional

En Python, al igual que los vectores y matrices, los tensores se pueden representar mediante la matriz N-dimensional (nd array). Un tensor se puede definir en línea para el constructor de array () como una lista de listas. Para Blanco y Ramírez (2018) el uso de tensores es muy extendido en Deep Learning en Python, ya que existen múltiples librerías de código abierto enfocadas a su uso en este lenguaje. Las más importantes son: TensorFlow, Theano, Keras, Caffe, Lasagne, Deep Scalable Sparse Tensor Network Engine (DSSTNE), PrettyTensor, Torch, MXNet, DL4J, y Microsoft Cognitive Toolkit TensorFlow por su parte soporta Python y C++, además de Java y Go entre otros, además, permite distribuir los cálculos en Central processing unit (CPU), Unidades de procesamiento gráfico (GPU) de forma simultánea y escalado horizontal. Keras es una API de redes neuronales de alto nivel, escrita en Python y capaz de ejecutarse sobre TensorFlow, Microsoft's Open-Source DeepLearning Toolkit (CNTK) o Theano que fue desarrollado con un enfoque en permitir la investigación y experimentación rápida.

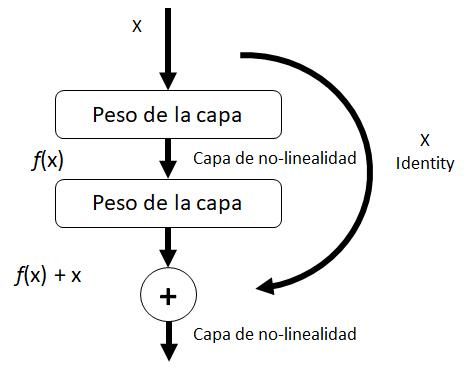

2.1.3. Arquitectura de la red ResNet-101

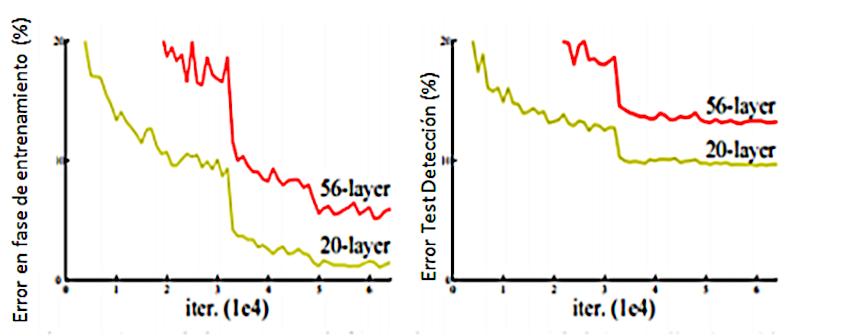

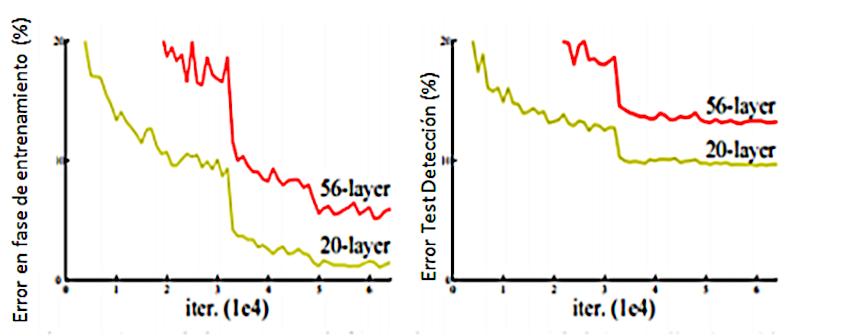

De acuerdo con Domènech (2019), la arquitectura ResNet nace del problema de la profundidad de la red. Se podría pensar que mientras más capas se utilizan para el entrenamiento en la detección de objetos, los resultados serán mejores, pero no es así. Cuando las redes se vuelven muy profundas, con un número de capas alto y las misma empiezan a converger, aparece un problema de degradación: cuanto más profunda es la

34

red, la precisión se satura y luego se degrada rápidamente. Se genera un aumento del error de predicción como se puede ver en la figura 8

Fuente. Adaptado de Ham (2015)

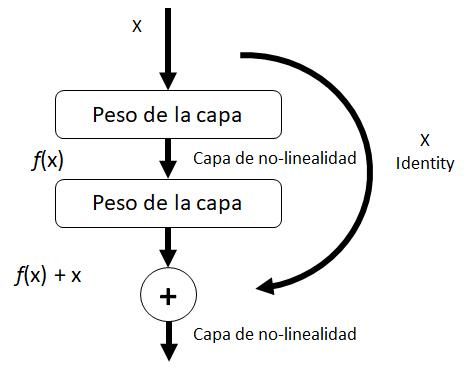

He, Zhang, Ren y Sun (2016) proponen una nueva aproximación de diseño para las redes de neuronas convolucionales: la optimización basada en residuos. Sus autores lanzaron tres arquitecturas inicialmente: ResNet-50, ResNet- 101 y ResNet-152. El número que acompaña al nombre indica el número de capas de la red, que, como se puede ver es mucho más elevado que en las arquitecturas anteriores. Sin embargo, a pesar de ello, esta red tiene una complejidad menor, es decir, el número de operaciones que realiza es menor. Esto es así porque implementa una nueva forma de aprendizaje basada en minimización de residuos, como se evidencia en la Figura 9 cada vez que se añade a la red una serie de capas que incluyan pesos, se añade un “atajo” que va desde la entrada de la primera de las capas a la salida de la última.

35

Figura 8

Error de entrenamiento (izquierda) y error de test (derecha)

Fuente.

Si x es la imagen a la entrada y f(x) la transformación que realizan las distintas capas, el objetivo de esta arquitectura es optimizar la función f(x)+x obtenida al pasar la imagen por dichas capas, de forma que, si una red clásica aprende una función, es decir, una función que, dado x, devuelva el valor y, ResNet lo que intenta aprender es cuánto le “falta” a x para convertirse en y.

Para poder solucionar el problema de la degradación por la profundidad de capas surgió la arquitectura ResNet. Esta arquitectura se basa en dividir una red profunda en fragmentos de tres capas y pasar la entrada a cada fragmento directamente a la siguiente capa, junto con la salida residual del fragmento anterior que pasa a ser la entrada del siguiente fragmento. Este método ayuda a eliminar el problema de degradación mencionado anteriormente (Domènech, 2019).

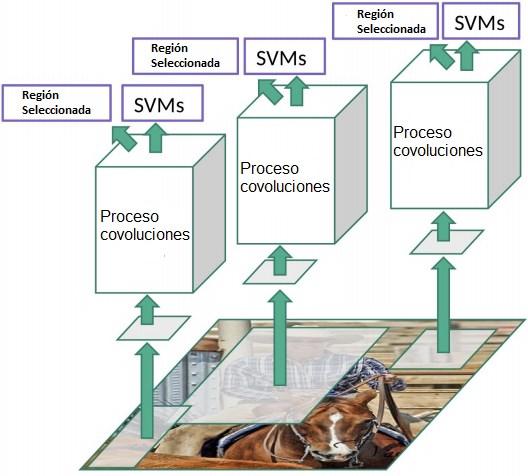

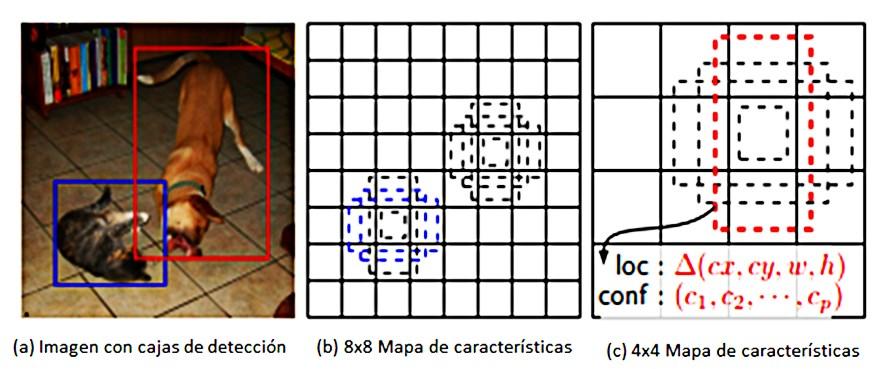

2.1.4. SSD: comprensión de la detección de objetos de disparo único

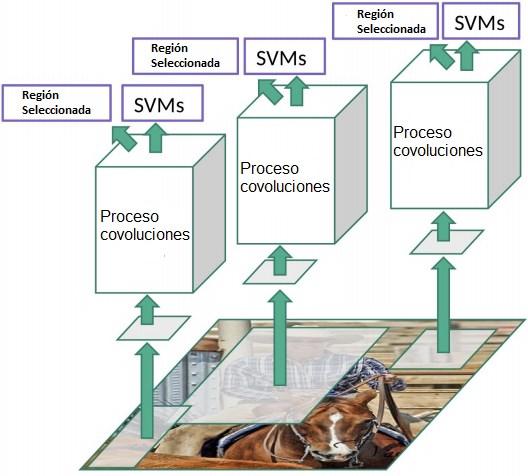

De acuerdo con Gutiérrez (2019), actualmente para la detección computacional de objetos se utilizan modelos basados en redes neuronales convolucionales como Region-based Convolutional Neural Networks (R-CNN), que utiliza una red neuronal de propuesta de región para crear cuadros de límite y utiliza esos cuadros para clasificar objetos (Gutiérrez,

36

Figura 9

Muestra de bloque de una red de aprendizaje por residuos ResNet

Adaptado de Hassan (2019)

2019). Si bien se considera que la técnica es precisa, todo el proceso se ejecuta a 7 cuadros por segundo, muy por debajo de lo que necesita un procesamiento en tiempo real. Los modelos basados en redes CNN, utiliza un método de búsqueda selectiva que extrae sólo un grupo de regiones de una imagen (Figura 10), y en lugar de intentar clasificar una imagen por un gran número de regiones, se pueden utilizar estas propuestas regionales seleccionadas extraídas para clasificar la imagen (Krizhevsky, Sutskever,

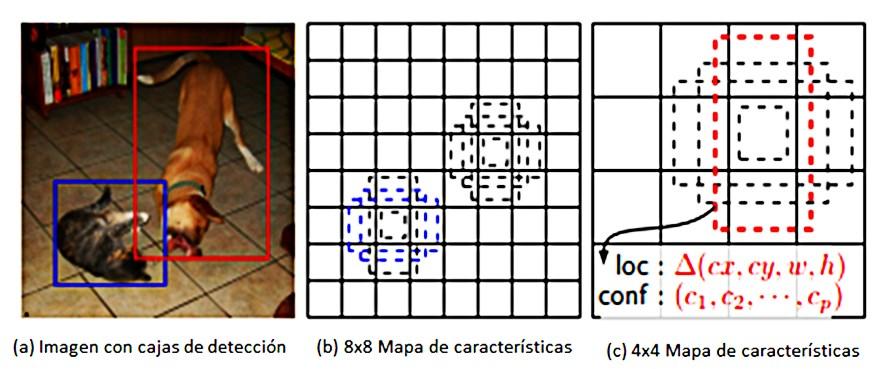

Para García (2018), SSD es un modelo que está diseñado para la detección de objetos en tiempo real. SSD acelera el proceso al eliminar la necesidad de la red de propuesta de la región. Para recuperar la caída en la precisión, SSD aplica algunas mejoras que incluyen funciones de escala múltiple y cajas predeterminadas. En la Figura 11, se puede apreciar cómo estas mejoras permiten que SSD iguale la precisión de Faster R-CNN utilizando imágenes de menor resolución, lo que aumenta aún más la velocidad (Long, Shelhamer, y Darrell, 2019). La detección de objetos SSD se compone de 2 partes:

• Extracción de mapas de características y

• Aplicación de filtros de convolución para detectar objetos.

37

y Hinton, 2019)

Figura 10

Modelo de Detección de Imágenes CNN

Fuente. Adaptado de Xu (2018)

Figura 11

Detector de caja múltiple de disparo único Fuente. Adaptado de Ham (2015)

En lugar de regiones, SSD utiliza regiones de predicción, la detección es analizada como un problema de regresión. Cada predicción se compone de un cuadro de límites y n puntuaciones para cada clase (una clase adicional para ningún objeto), y se elige la puntuación más alta como la clase para el objeto delimitado. La Figura 12 muestra los identificadores que genera SSD cuando una predicción contiene algún objeto, sin embargo, SSD reserva una clase "0" para indicar que no tiene objetos una predicción (Ichi.pro, 2021)

De acuerdo con Hui (2018b), SSD divide la imagen usando una cuadrícula y cada celda de la cuadrícula es responsable de detectar objetos en esa región de la imagen. Cada celda de la cuadrícula en el SSD se puede asignar con múltiples cuadros de anclaje previos. Estos cuadros de anclaje están predefinidos y cada uno es responsable del tamaño y la forma dentro de una celda de la cuadrícula. Como se puede observar en la Figura 13, SSD discretiza el espacio de salida de los cuadros delimitadores en un conjunto de cuadros predeterminados en diferentes proporciones y escalas por ubicación del mapa de características (Sanz, 2019)

38

En el momento de la predicción, la red genera puntuaciones para la presencia de cada categoría de objeto en cada cuadro predeterminado y produce ajustes en el cuadro para que coincida mejor con la forma del objeto. Además, la red combina predicciones de múltiples mapas de características con diferentes resoluciones para manejar de forma natural objetos de varios tamaños.

39

Figura 12

Inferencia sobre Imágenes

Fuente. Adaptado de Arunava (2019)

Figura 13

Marco SSD

Fuente. Adaptado de Ichi.Pro (2021)

SSD es una arquitectura flexible en cuanto al método de predecir las cajas delimitadoras y la confianza de que esta contenga un objeto) para múltiples categorías de objetos. En caso de que el detector solo utilice un prior por localización del mapa de características de más alto nivel semántico, tendrá un comportamiento similar a la arquitectura de tipo ventana deslizante llamada OverFeat1931 (Redmon, Kumar, Girshick, y Farhadi, 2016) En la Figura 14, Sachan (2019) muestra una comparativa entre los diferentes modelos de detección de imágenes revisados, en cuanto a precisión y velocidad.

Fuente. Adaptado de Silva (2020)

De acuerdo con García (2018), el modelo SSD contiene un entrenamiento simple de extremo a extremo (end-to-end), que incluso para imágenes de baja resolución obtiene buenos resultados de precisión, consiguiendo una mejoría en la velocidad que compensa aún más la precisión obtenida. En fase de entrenamiento, SSD necesita determinar que regiones por defecto concuerdan mejor con el ground truth2. Por tanto, se queda con las regiones por defecto que obtienen mejor porcentaje de IoU3. Los recuadros por defecto respecto del ground truth si superan cierto umbral (típicamente 0.5) son marcados como

2 Etiquetas de detección – predicción de cada imagen

3 También conocido como Jaccard Index, es la métrica utilizada para calcular el solape entre dos recuadros delimitadores o bounding boxes. Es el resultado de dividir la intersección de las regiones entre la unión de estas

40

Figura 14

SSD Vs. R-CNN: Precisión y Velocidad

positivos, mientras que los demás se marcan como negativos. Esto permite a la red aprender y obtener puntaciones altas en varios de los bounding boxes4 por defecto superpuestos en vez de solamente en el mejor. Este sistema implica que hay muchas más muestras negativas que positivas, por lo que se introduce un método para clasificar las regiones por defecto que tienen mayor pérdida de confianza y poder hacer una relación 3:1, como mucho, de negativos y positivos. A este método se le conoce como minería de negativos dura (Hard Negative Mining).

2.2. MARCO HISTÓRICO

2.2.1. Trabajo final de grado, España: Detector de baches con Deep Learning

Para Manzanares (2019), el mantenimiento de las carreteras en muchos países es muy deficiente, ya que en la mayoría de los casos la manera de reportar y detectar daños suele tener un alto costo y estas actividades son realizadas manualmente por grupos de trabajadores que informan de estos daños, a partir de denuncias de usuarios de las carreteras o reportes policiales. Para el autor con el avance de la tecnología hay una tendencia a la desaparición de estos trabajos manuales: llega la automatización de muchas de estas tareas. En su proyecto “Detector de baches con Deep Learning” Manzanares se centró en crear un detector de baches con tecnología Deep Learning, cuyo principal objetivo fue reducir el coste del mantenimiento de las carreteras, automatizando y agilizando el trabajo. Para cumplir con este objetivo el autor utilizó los fundamentos de Deep Learning, una las tecnologías más actuales y con mejores resultados en el campo de la detección de objetos. Luego Manzanares diseño un detector de baches a partir de esta tecnología, pasando por la selección de cuál es la plataforma más adecuada y conveniente

41

4 Conjunto de propuestas de objetos

para este proyecto, explicando cómo se ha entrenado la red neuronal base de su trabajo, comparándola con diferentes modelos de entrenamiento, para finalmente crear una APP (Aplicación de software diseñada para ejecutarse en los smartphones) como un prototipo funcional de detector de baches. Manzanares utilizó Retinanet como detector de objetos, por aportar un coste menor computacional y una alta precisión en la detección, ideal para un detector en tiempo real (Hui, 2018a). Para le generación de la App, el autor usó una máquina virtual con Ubuntu para poder trabajar con las librerías y paquetes que se necesitaba. El entorno virtual pudo construirse a partir de PIP (Package installer for Python) y trabajar desde el terminal de Ubuntu. Como entorno de trabajo para Python, el autor usó PyCharm porque proporcionaba una interfaz clara para programar y hacer ‘debug’ del código. El código de la App está basado en TensorFlow Mobile, una versión menos actual que TFlite, ya que según Manzanares se encontró más información y apoyo para poder trabajar con él. Hernández (2018) estableció que TensorFlow Mobile proporciona una forma más simple de crear este detector de baches, aunque es menos potente y completo que TFlite

2.2.2.

Artículo científico,

Colombia: Técnicas de inteligencia artificial utilizadas en el procesamiento de imágenes y su aplicación en el análisis de pavimentos Reyes, Mejía y Useche-Castelblanco (2019) establecieron que, debido al incremento en los costos de mantenimiento, rehabilitación y construcción de vías, estudiar las estructuras de pavimento para identificar la mecánica dinámica de sus fallas se ha vuelto un campo de gran importancia en las ciencias de ingeniería. Los autores hablan de nuevas herramientas de análisis que buscan hacer este estudio más eficiente, reduciendo su costo y tiempo de detección mediante el reconocimiento digital de imágenes. Para los autores la forma tradicional de analizar una imagen está limitado por la subjetividad del análisis, por eso proponen implementar diferentes técnicas de I.A, para optimizar los algoritmos de procesamiento de imágenes. En el estudio "Técnicas de inteligencia artificial utilizadas en el procesamiento de imágenes y su aplicación en el análisis de pavimentos" Reyes et al.

42

(2019) presentan una comparación entre las diferentes técnicas de I.A enfocadas en el procesamiento de imágenes, enfocándose en los trabajos realizados específicamente con imágenes de pavimentos, su análisis utilizando inteligencia artificial. Como la fortaleza de los modelos de reconocimiento de fallas se basan en arquitecturas de inteligencia artificial, los autores hicieron un análisis comparativo de estas arquitecturas en su proyecto "Técnicas de inteligencia artificial utilizadas en el procesamiento de imágenes y su aplicación en el análisis de pavimentos ", mismo que dividieron en 3 secciones: en la primera se muestran los trabajos realizados con cada técnica en el campo del procesamiento digital de imágenes. La segunda sección revisa las técnicas implementadas, específicamente en pavimentos, y proponen implementaciones para mejorar el procesamiento de imágenes en mezclas asfálticas. La Tabla 3 muestra un resumen de las conclusiones que los autores establecen al realizar un resumen comparativo entre las diferentes metodologías de I.A para el procesamiento de imágenes que fueron analizadas en su artículo:

Tabla 3

Comparación de las técnicas de inteligencia artificial Técnica IA Ventajas Desventajas

Sistemas difusos. (Abdullah y Abdolrazzagh-nezhad, 2014; Lim, Vats, y Seng, 2015)

• Su implementación permite que se pueda aplicar de una forma práctica y sencilla porque maneja un esquema de lenguaje natural.

• Dificultad por la definición subjetiva del problema de forma precisa por medio de etiquetas y su porcentaje de pertenencia

Sistemas difusos.

• Clasificación simple de sistemas complejos sin tener limitaciones a clases de etiquetado.

• No se aconseja para sistemas de alta precisión, debido a la subjetividad de su sistema lingüístico y no numérico

Red neuronal MLP. (Cristea, Leblebici, y Almási, 2016; Jani, Mishra, y Sahoo, 2017)

• Aprendizaje rápido con gran porcentaje de efectividad

• Necesidad periódica de reentrenamiento para no perder poder de capacidad de detección.

43

Técnica IA Ventajas Desventajas

• Capacidad de procesamiento en paralelo, muy útil en sistemas que necesitan "fast answer"

• Implementación simple de una red neuronal MLP

• Gran cantidad de datos para el entrenamiento mientras más clases de categorización existan

Red neuronal convolucional (Galdámez, Raveane, y Arrieta, 2017; Cao, Wang, Ming, y Gao, 2015)

• Red especializada en el trabajo con imágenes en 2D mediante el uso de diferentes matrices de filtros.

• Robustez de la identificación ante variaciones en las imágenes.

• Tiempos extensos para entrenamiento

• La calidad de la identificación depende del tamaño de la base de imágenes usada para el entrenamiento

• Alto costo computacional: trabajo con matrices y Convoluciones entre ellas.

Inteligencia de enjambreColonia de abejas. (Cui et al., 2017; Banitalebi, Abb Aziz, Bahar, y Zainal, 2015)

• Convergencia rápida a la solución del problema en con gran flexibilidad en el aprendizaje

• Necesidad de pocos parámetros de configuración

• Necesidad recurrente de un algoritmo externo de búsqueda global dentro de la región del problema para establecer la mejor solución.

• Situaciones convergencia prematura a una por una mala configuración de la estructura de búsqueda del mejor resultado

Sistema inmune artificial (Bayar, Darmoul, HajriGabouj, y Pierreval, 2015) (Costa, Matos, y Martínez, 2017)

Fuente: Reyes et al. (2019)

• Alta capacidad para la exploración de múltiples soluciones

• Autoaprendizaje estructurado, profundo y simple, tiene la capacidad de aprender de forma autónoma.

• Alto nivel de desarrollo en codificación inicial para estructurar sus capas y funcionamiento

• Baja robustez en su implementación.

44

2.2.3. Caso de estudio, United Kingdom: A Fast and Adaptive Road Defect Detection Approach Using Computer Vision with Real Time Implementation

Karakose et al. (2016) consideraron que el uso del reconocimiento de imágenes para detección de fallas en las vías urbanas no es una concepción nueva y convinieron que el defecto de la carretera es uno de los factores más importantes de accidentes de tráfico, por lo general se producen grietas, surcos y baches en la superficie de la carretera. De acuerdo con los autores de este trabajo, el reconocimiento de estos errores se basa en el hecho de que las personas los han visto. Pero estos errores no se corrigen en poco tiempo y se complican. Para ayudar en la detección de estos errores los autores sugieren técnicas en las que se usa la visión artificial por computador. En este estudio realizado se han adaptado diferentes carreteras por las operaciones realizadas en la detección de errores viales a partir de las imágenes recibidas. Se utilizan imágenes tomadas con la cámara de un vehículo para el estudio, además los autores enfocan en todo su proyecto a la personalización, es decir, en el uso de imágenes borrosas y sin procesas que son mejoradas en el computador usando formatos de imagen binarios y operaciones morfológicas matemáticas.

2.2.4. Proyecto de Investigación, Louisiana: Object

Detection with Deep Learning: A Review. IEEE Conference on Computer Vision and Pattern Recognition (CVPR)

Zhao et al. (2019) desarrollaron un trabajo de investigación donde, debido a la estrecha relación de la detección de objetos con el análisis de video y la comprensión de imágenes, expusieron métodos complejos para realizar estas labores, métodos que se basan en características (etiquetado) hechas en computadores y que se pueden entrenar poco a poco hasta convertirse en arquitecturas. Para los autores, el problema principal de la detección de objetos es determinar dónde se encuentran los objetos en una imagen determinada (localización de objetos) y a qué categoría pertenece cada objeto

45

(clasificación de objetos). Con estos fundamentos Zhao et al. canalizan los modelos tradicionales de detección de objetos en tres etapas: determinación de la región para selección, extracción de características y clasificación. El proyecto hace referencia al Deep Learning, basado en redes neuronales convolucionales, para la generación de modelos de reconocimiento de imágenes. Los autores manifiestan que esta arquitectura para reconocer diferentes objetos busca dentro de las imágenes características visuales que puedan proporcionar una representación semántica robusta del objeto. Zhao, Zheng, Xu y Wu mencionan que entre las características más representativas para la identificación de objetos están: SIFT5 , HOG 6 y Haar-like7. Para Lowe (2004) esto se debe al hecho de que estas características pueden producir representaciones asociadas con células complejas en el cerebro humano. Sin embargo, debido a la diversidad de apariencias, condiciones de iluminación y fondos, es difícil diseñar manualmente un descriptor de características robusto para describir perfectamente todo tipo de objetos.

2.2.5. Caso de estudio, Cuba: Revisión

de algoritmos de detección y seguimiento de objetos con redes profundas para video vigilancia inteligente.

En relación con el algoritmo SSD, Sánchez, González y Hernández (2020) exponen, en su trabajo de investigación, que hoy en día cada vez más se utilizan las redes neuronales

5 Scale-invariant feature transform o SIFT es un algoritmo usado en visión artificial para extraer características relevantes de las imágenes que posteriormente pueden usarse en reconocimiento de objetos, detección de movimiento, estereopsis, registro de la imagen y otras tareas (Estados Unidos Patente nº US6711293B1, 2004).

6 El histograma de gradientes orientados, HOG, es un descriptor de características utilizado en la visión por computadora y el procesamiento de imágenes con el fin de detectar objetos. La técnica cuenta las ocurrencias de orientación de gradiente en partes localizadas de una imagen (Mallick, 2016)

7 Las características similares a las de Haar son características de imágenes digitales que se utilizan en el reconocimiento de objetos. Una característica similar a Haar se representa tomando una parte rectangular de una imagen y dividiendo ese rectángulo en varias partes. A menudo se visualizan como rectángulos adyacentes en blanco y negro (Cepalia, 2021)

46

profundas para resolver problemas de visión por computadora, como el reconocimiento y seguimiento de personas a través de una red de cámaras. Los autores realizaron una revisión de los principales algoritmos de rastreo y detección de objetos, basados en redes profundas que permitirían conformar la arquitectura de un sistema de video - vigilancia inteligente y determinaron que los algoritmos one-stage son considerablemente más rápidos que los basados en propuestas de regiones, donde destaca SSD, y los algoritmos de rastreo offline tienen una mayor precisión comparado con los online, destacando a DeepSort como el más eficiente. En el artículo se menciona como uno de los principales usos del Deep Learning el entrenamiento de algoritmos para la detección de objetos en imágenes, entre los que se destaca SSD. Sánchez et al. (2020) fundamentaron esta afirmación debido a que los algoritmos one-stage son considerablemente más rápidos que los basados en propuestas de regiones, aunque tienen dificultades para detectar objetos pequeños, sobre todo si están agrupados. SSD supera a muchos de sus más complejos adversarios en velocidad y precisión en todos los escenarios, incluyendo objetos pequeños. Además, SSD se pudo utilizar en Mobilenet como extractor de características, en estos casos, sacrificando precisión, pudiéndose ejecutar en dispositivos libres de GPU, como celulares de gama media baja y Rasperry.

2.2.6. Proyecto de investigación, México: Clasificación de obstáculos a través del algoritmo SSD

De igual manera Moreno, Ramírez, Ávila y Carrillo (2017) mostraron los resultados de la implementación del algoritmo SSD en la clasificación de obstáculos, no sólo obteniendo resultados satisfactorios en la detección de objetos sino en sistemas autónomos de navegación. Los autores llevaron a cabo varios experimentos y lograron una clasificación del 89.99% de los objetos en tiempo real, con lo que se demostró que el algoritmo puede ser implementado en aplicaciones de navegación con una precisión confiable que permita una navegación segura en sistemas de navegación autónoma frente a la presencia de obstáculos.

47

3. METODOLOGÍA

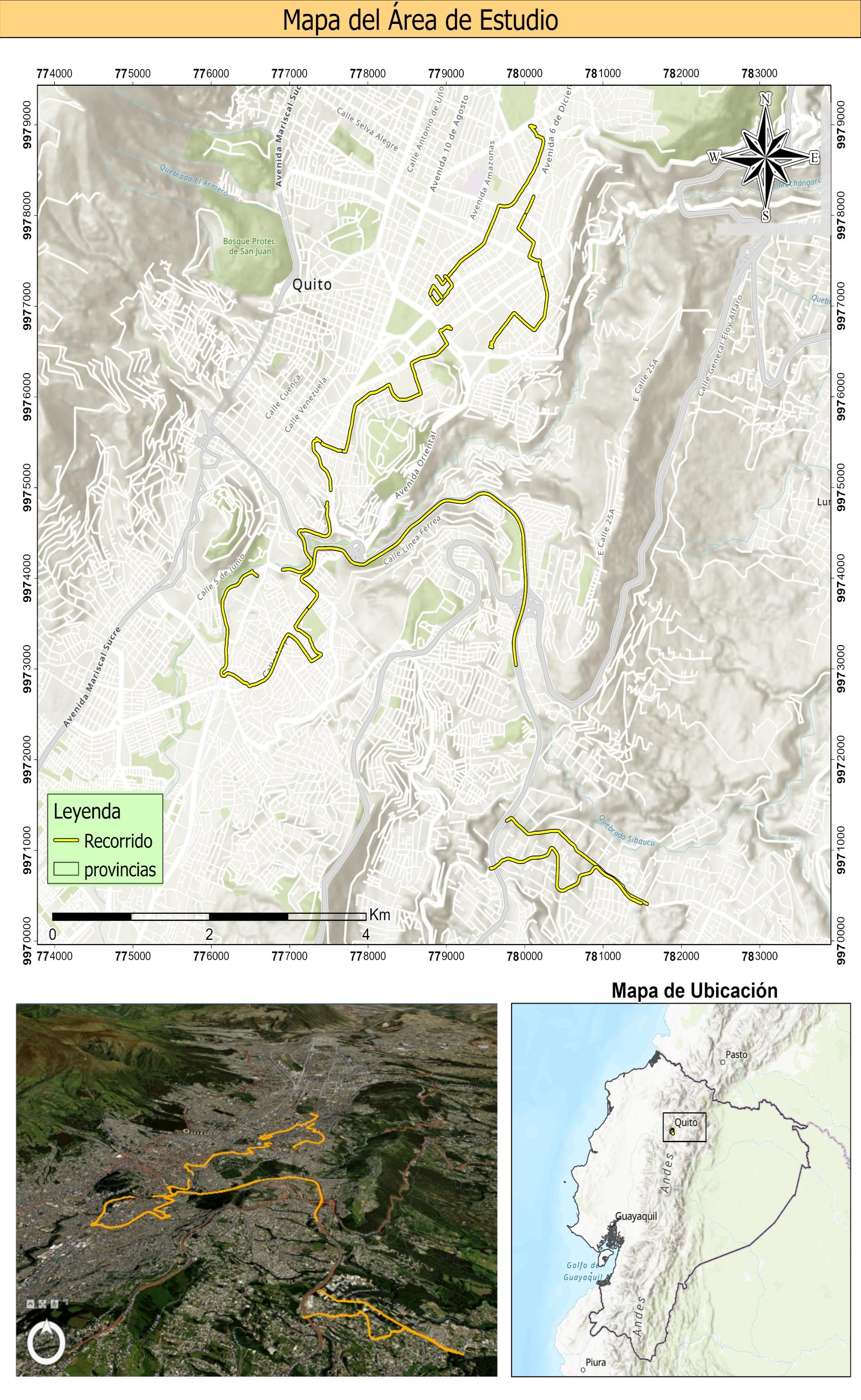

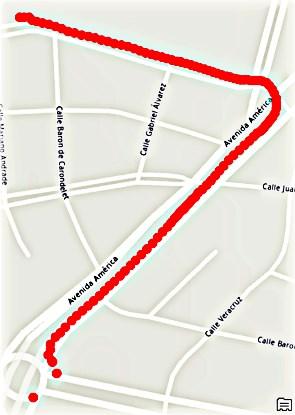

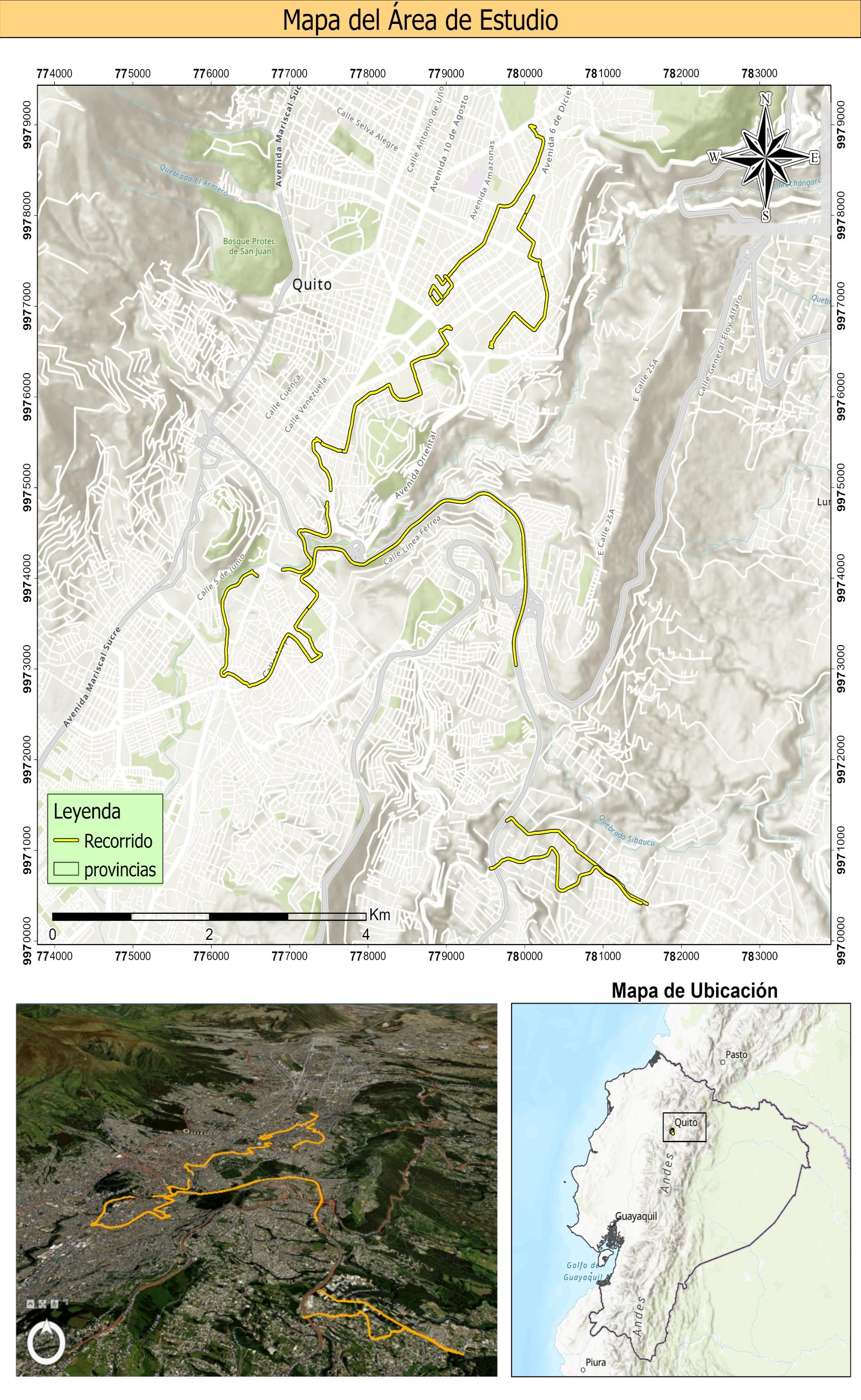

3.1. ÁREA DE ESTUDIO

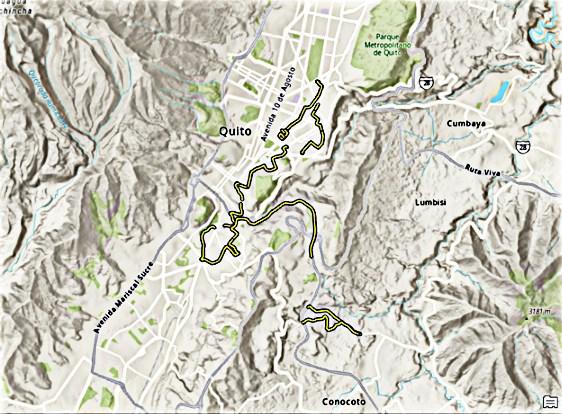

El Distrito Metropolitano de Quito es la capital de Ecuador y de la provincia de Pichincha, la gestión territorial abarca el área metropolitana conocida también como Distrito Metropolitano de Quito, ubicado en el centro norte de la provincia de Pichincha a una altitud de 2850 metros sobre el nivel del mar (Gestión de Comunicación M.A, 2017), cuenta con una población de 2,239,191 habitantes según el censo de población y vivienda del Instituto Nacional de Estadísticas y Censos (INEC) realizado en el 2010 (INEC, 2010) y tiene una proyección para el año 2025 de alrededor de 2,736,638 habitantes de los cuales 1,809,362 en la ciudad y 927,276 en el resto del territorio que se encuentra distribuido en 32 parroquias urbanas y 33 parroquias rurales. Según el plan maestro de movilidad para el Distrito Metropolitano de Quito 2009 - 2025 ( Municipio del Distrito Metropolitano de Quito, 2009), el grado de concentración de actividades económicas es significativamente más elevado en la ciudad que en el resto de zonas del Distrito, lo que se le conoce como la macro centralidad en donde se aloja al 72% de la población agrupando también una gran cantidad de equipamiento urbano, servicios públicos, comerciales y financieros lo que demanda de una gran atención a las soluciones para mejorar la movilidad en estos sectores.

En el plan maestro de movilidad para el Distrito Metropolitano de Quito 2009 – 2025 también se describe sobre la red vial, a través de un anillo periférico urbano en donde se incluyen las avenidas Simón Bolívar y Mariscal Sucre; un segundo anillo metropolitano constituido por la Perimetral Regional (E35) tramo Machachi – Sta. Rosa de Cusubamba; y las conexiones distritales conformadas por el acceso Panamericana Sur, Antigua vía QuitoConocoto, Autopista General Rumiñahui, Vía Interoceánica, Panamericana Norte y Vía Manuel Córdova Galarza, estas vías permiten el acceso a las principales zonas comerciales de la ciudad lo que ocasiona situaciones de congestión vehicular.

48

49

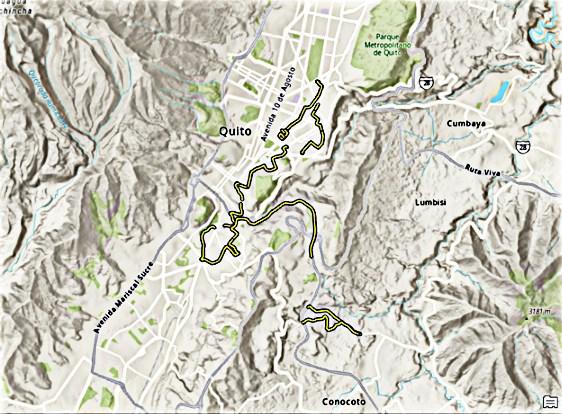

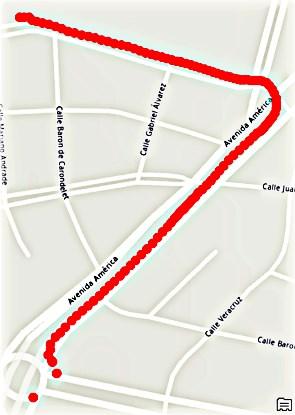

Figura 15

Mapa del área de estudio: Recorridos realizados

3.2. FLUJOGRAMA DE METODOLOGÍA

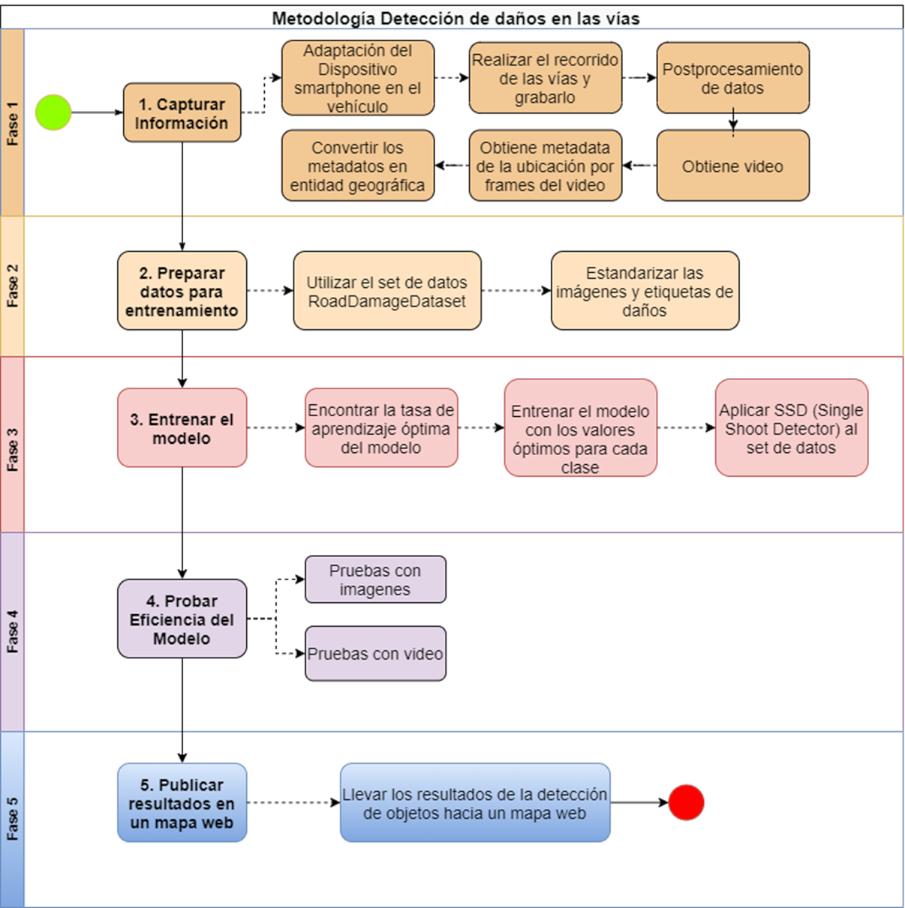

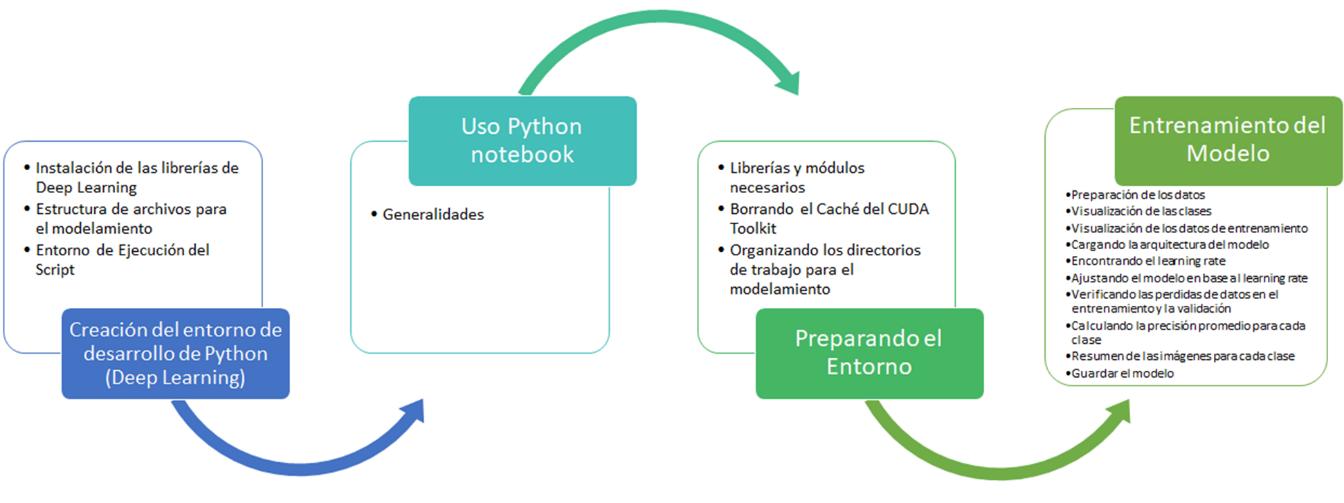

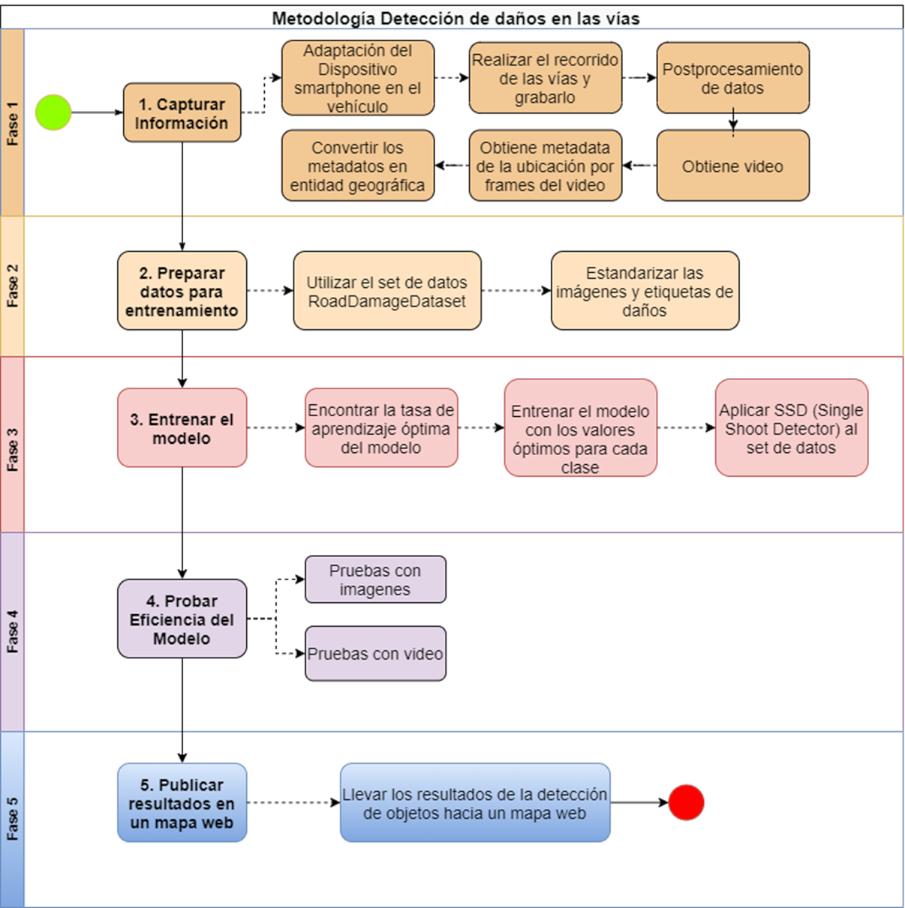

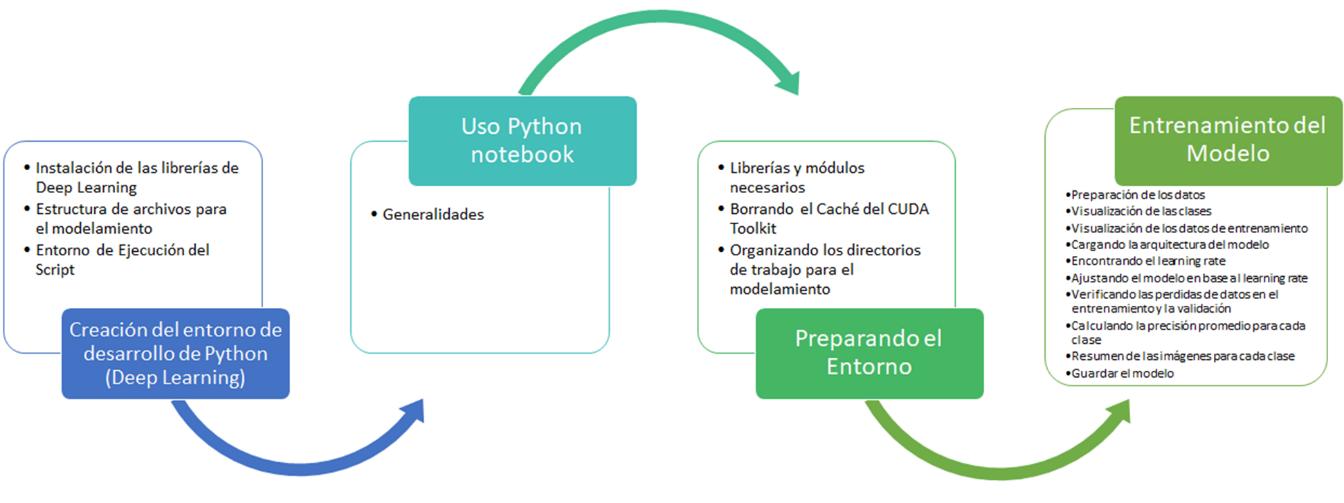

En el presente trabajo de investigación, se desarrolló un modelo de metodología para la implementación de una categorización de daños georreferenciados en las arterias viales de la ciudad de Quito (Ecuador), usando un algoritmo de inteligencia artificial desarrollado en Python. Este modelo metodológico se estructuró en cinco fases: Capturar la información, Preparar datos para entrenamiento del modelo, Entrenar al modelo, Probar la eficiencia del modelo y Publicar los resultados en un mapa Web. La Figura 16 muestra el detalle de las fases de esta propuesta:

50

Figura 16

Flujograma de metodología

Cada una de las fases contiene actividades con un sustento científico - técnico para que el aprendizaje del modelo pueda arrojar predicciones aceptables y la publicación de los resultados sea una herramienta útil para el departamento de obras públicas del distrito metropolitano de la ciudad de Quito

3.3. JUSTIFICACIÓN DE LA METODOLOGÍA

Para el proceso de la generación del modelo de metodología, se utilizaron varias herramientas tecnológicas aplicadas en diferentes procesos desde la captura de la información hasta los resultados obtenidos. Este modelo es la columna neurálgica de soporte para el cumplimiento de los objetivos de este trabajo de investigación

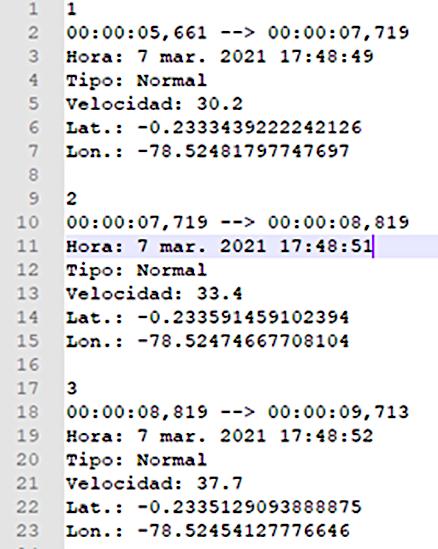

• Para la captura de las imágenes, desde una secuencia de video, con los que se generará una base de datos de daños georreferenciados en las vías de la ciudad de Quito, Ecuador se utilizó la App AutoGuard©. AutoGuard© es una aplicación móvil disponible para dispositivos Android que permite capturar los datos en campo a partir de un video y geolocalización. Se aprovechó las capacidades de un Smartphone (cámara, GPS, sistema operativo) por ser un dispositivo independiente y accesible. Si bien existen aplicaciones similares, AutoGuard© permite configurar la forma en la que se capturan los datos, su codificación y la calidad del video necesaria para la obtención de las imágenes de alta resolución que se utilizarán en el entrenamiento del modelo.

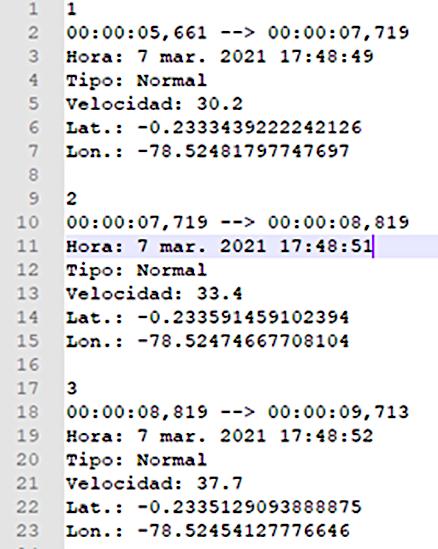

• El procesamiento de la información geográfica, que está en la metadata de los videos capturados, fue realizado mediante el uso de una de las extensiones de ArcGIS Pro©: LocateXT, la misma que incorpora opciones para la detección de coordenadas en archivos de texto y la extracción de atributos personalizados, adicionalmente, ArcGIS Pro © permite a los usuarios de sistemas de información geográfica gestionar y

51

administrar cartografía vectorial y ráster8 (E.S.R.I, 2021b), así como también ejecutar herramientas de analítica para resolver problemas espaciales. Esto ahorró tiempo en el traslado de la metadata hacia una estructura de datos organizada como es un “feature class”, para posterior convertirla en la metadata del video en formato CSV. Esta es la metadata que conformará la base de datos de imágenes georreferenciadas de los daños en las vías de la ciudad de Quito, Ecuador

El proceso de aprendizaje y categorización de los daños en las vías, mediante el uso de un algoritmo de IA desarrollado en Python, fue realizado en tres herramientas:

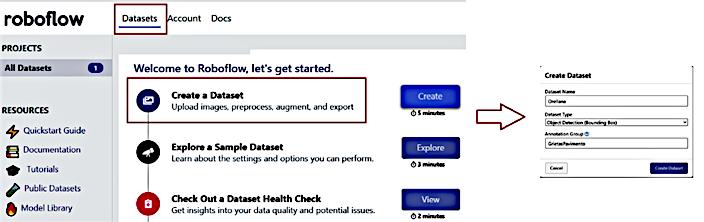

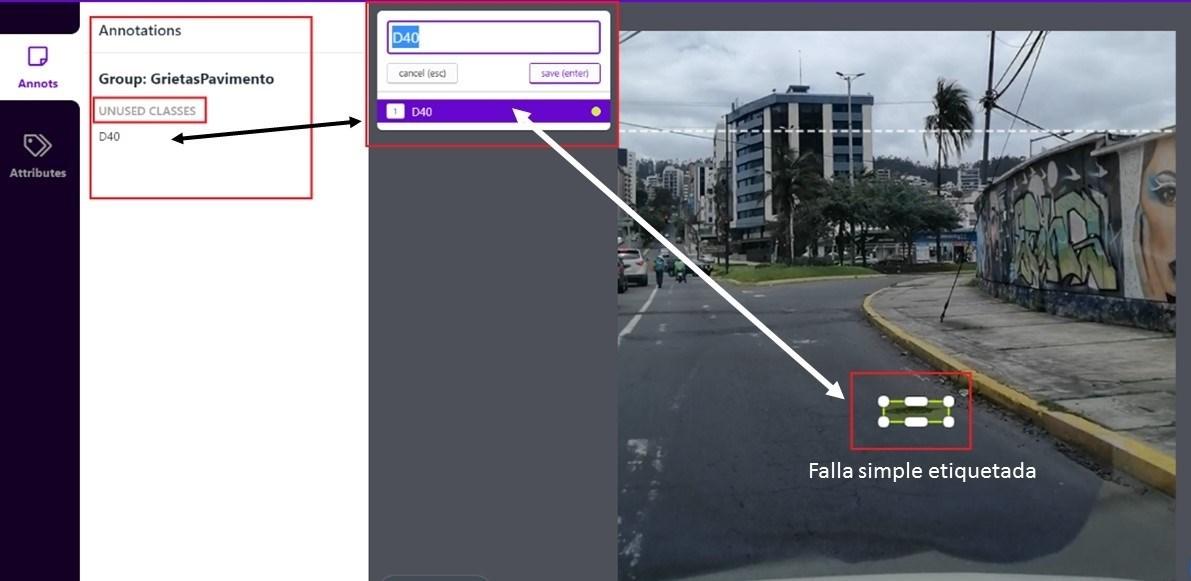

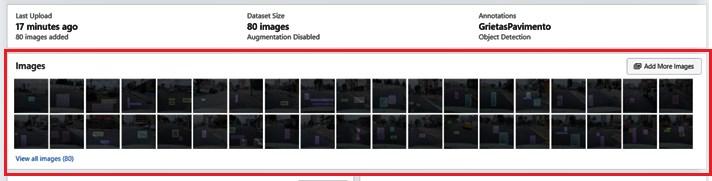

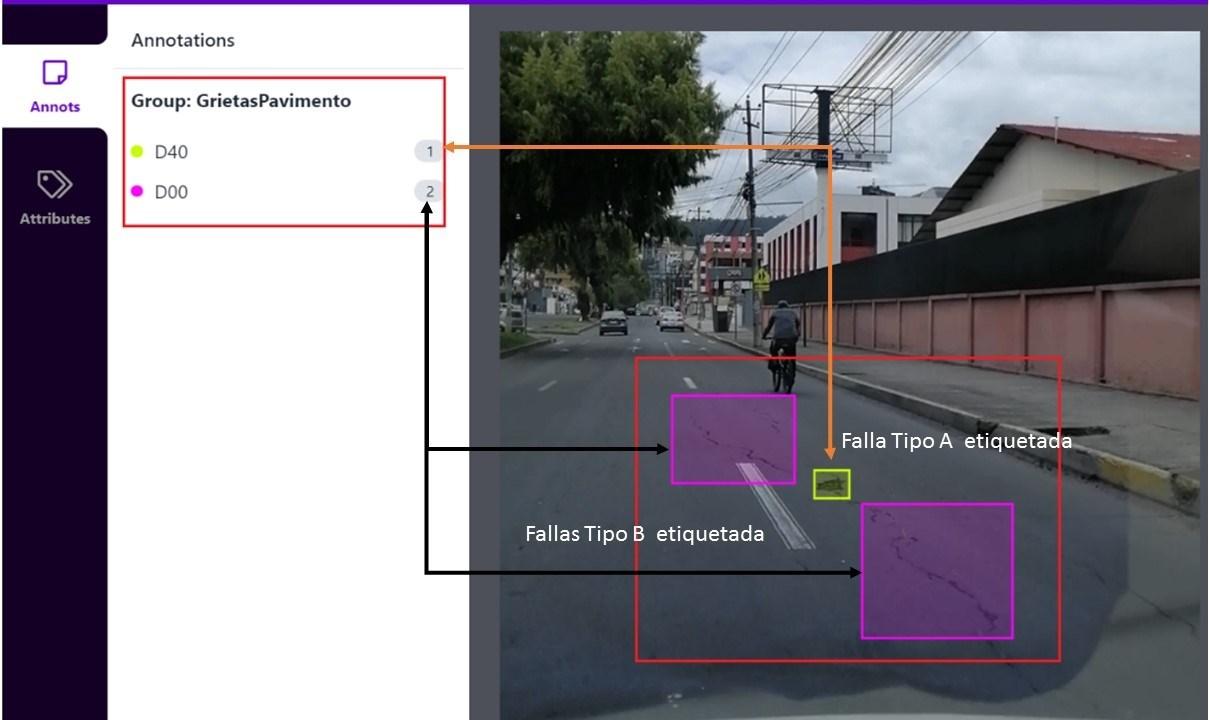

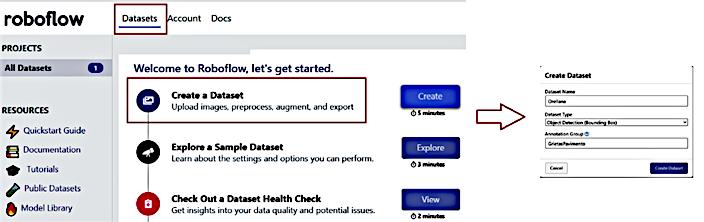

• Para el entrenamiento de las imágenes y la creación de la metadata de clases identificadas se utilizó la plataforma Roboflow, que cuenta con la opción de hacer carga de datos, y aplicando el formato de Pascal VOC (Visual Object Classes) permite la creación de las etiquetas de identificación de clases. Adicionalmente cuenta con las opciones de redimensionar el tamaño de las imágenes para una mejora en el entrenamiento y una optimización de los recursos de memoria de la tarjeta gráfica del sistema donde se implementa el modelo de reconocimiento de imágenes

• El entorno de programación Python© de ArcGIS Pro© Mediante el uso de esta API, se permite la integración de las librerías de inteligencia artificial y el entorno. De esta manera, se pudo implementar los scripts en el ambiente Jupyter Notebook.