10 minute read

INTELLIGENZA ARTIFICIALE

LE DOMANDE SCOMODE ANCORA SENZA RISPOSTA

Pregiudizio degli algoritmi, diseguaglianze di potere, utilizzi non trasparenti: per questi problemi non c’è ancora una risposta. Ma qualcuno la sta cercando.

Photo by Andrea De Santis on Unsplash A l problema del pregiudizio nell’intelligenza artificiale, il bias, così come ad altre questioni etiche connesse a questa tecnologia, ancora non c’è una risposta semplice. Ma diversi progetti di ricerca stanno tentando di comprendere e di gestire i pericoli nascosti nei sistemi di AI. Aziende come Google, Microsoft, Amazon, Apple e Facebook stanno costruendo il proprio impero economico sui dati e sull’intelligenza artificiale a essi applicata: due patrimoni che, messi insieme, permettono a questi colossi di offrire servizi sempre più evoluti, personalizzati e diversificati. Ma il rischio di manipolazioni o distorsioni nella rappresentazione della realtà, anche involontarie, è talmente alto che queste aziende non possono sottrarsi al problema etico. Nella teoria, Google fa un’ottima figura: stando alle sue linee guida, l’intelligenza artificiale dev’essere inclusiva, benefica per la società, rispettosa della privacy, accessibile democraticamente, sicura a partire dalla sua progettazione, affidabile e credibile. Deve, inoltre, “evitare di creare o rafforzare ingiusti pregiudizi”. Dalle dichiarazioni d’intenti alla pratica, però, non sempre tutto fila liscio. A fine 2020 ha fatto discutere la decisione di Big G di licenziare una delle sue ricercatrici, la trentasettenne Timnit Gebru. In un articolo scientifico scritto insieme ad altri cinque ricercatori, Gebru evidenziava due problemi connessi ai software di elaborazione del linguaggio, capaci di processare enormi moli di dati e di creare testi di senso compiuto: il pesante impatto ambientale di questi programmi e il rischio che possano veicolare pregiudizi, razzismo e discriminazioni.

Ecologista o inquinante? Addestrare un modello di AI di grandi dimensioni richiede un’enorme potenza di calcolo, dunque non stupisce che negli ultimi anni le emissioni di CO2 e i costi dei progetti di intelligenza artificiale sia-

no esplosi. Secondo uno studio del 2019 di Emma Strubell (altra ricercatrice di Google), il training di un algoritmo di comprensione del linguaggio può generare 284 tonnellate di anidride carbonica, l’equivalente di quanto prodotto in media da un’automobile nel suo intero ciclo di vita. Stando ai calcoli di Strubell, per allenare Bert (Bidirectional Encoder Representations from Transformers, modello introdotto nel 2019 nel motore di ricerca di Google) è stata prodotta una quantità di CO2 pari a quella di un volo aereo di andata e ritorno tra New York e San Francisco. D’altra parte gli algoritmi di machine learning e AI vengono anche usati per analizzare i funzionamenti dei data center e ricavare ottimizzazioni di efficienza energetica. A detta di Google, dopo solo un anno e mezzo di sperimentazione, già nel 2016 un algoritmo di apprendimento automatico aveva permesso di tagliare del 15% i consumi dei data center. Dunque non c’è una risposta semplice alla domanda se l’intelligenza artificiale sia più ecologista o più inquinante, ma certamente ci sono contraddizioni da sanare.

Diversity imperfetta? Un’altra domanda scomoda da porsi riguarda l’inclusività. Gli algoritmi dei programmi di comprensione del linguaggio vengano spesso allenati su grandi volumi di dati tratti dal Web, un calderone in cui proliferano discriminazioni, razzismo, sessismo, discorsi d’odio, volgarità. Nel rispondere alle polemiche sull’allontanamento di Timnit Gebru, Jeff Dean, vice presidente della divisione AI di Google, ha sottolineato l’impegno di Google a “continuare la ricerca su temi di particolare importanza per la diversity individuale e intellettuale, dall’ingiusto pregiudizio sociale e tecnico nei modelli di machine learning, alla insufficiente rappresentatività dei dati di training, fino all’inclusione del contesto sociale nei sistemi di AI”. Di nuovo, le dichiarazioni di principio si scontrano con la realtà. Ha qualcosa da dire in merito anche Kate Crawford, docente della University of Southern California e senior principal researcher di Microsoft Research: nel suo saggio Atlas of AI sono analizzati processi che avvengono nel dietro le quinte dell’intelligenza artificiale, come lo sfruttamento di personale sottopagato e gli impatti ambientali della supply chain. Come da lei raccontato in un’intervista al Guardian, “Questi sistemi si stanno diffondendo in una moltitudine di settori senza una forte regolamentazione, consenso o dibattito democratico”. Per mettere in piedi un sistema altamente automatizzato è spesso necessario un grosso lavoro manuale (malpagato) di raccolta e classificazione dei dati. “L’AI non è né artificiale né intelligente”, ha detto Crawford. “È fatta di risorse naturali e sono le persone che eseguono le attività a far sembrare autonomi i sistemi”. C’è poi il problema del bias, anche se il termine potrebbe essere riduttivo, perché “questi

Photo by Maxim Hopman on Unsplash sistemi producono continuamente errori: l’affidabilità creditizia delle donne viene giudicata inferiore, i volti di persone di colore vengono male etichettati, e finora la risposta è stata che ci servono più dati. Ma ho cercato di capire le logiche di classificazione più profonde e si intravedono forme di discriminazione non solo quando i sistemi vengono messi all’opera, ma nel modo in cui vengono costruiti e allenati a vedere il mondo”. Nei dataset usati per allenare gli algoritmi, le persone vengono catalogate secondo logiche non inclusive: per esempio esistono due sessi, maschio e femmina, e non c’è spazio per altre identità di genere, mentre i gruppi etnici sono soltanto cinque. Esistono sistemi di AI che correlano le espressioni facciali alle emozioni, considerando però vecchie classificazioni ormai superate. Come una degli anni Settanta dello psicologo Paul Ekman, che restringeva a rabbia, paura, tristezza, felicità, sorpresa e disgusto il ventaglio delle emozioni de-

ducibili dalle espressioni facciali. Successivamente lo stesso Ekman ampliò questa lista, e studi più recenti hanno sfatato il mito di poter correlare con precisione ciò che si legge sul volto di una persona allo stato d’animo sottostante. Tutte queste politiche di classificazione nel training degli algoritmi sono ormai sedimentate e anche per questo il bias è difficile da estirpare.

Un’etica possibile? Oltre alle questioni etiche, bisogna poi considerare il problema del potere. “L’etica è necessaria, ma non sufficiente”, ha sottolineato Crawford. “Più utile, per esempio, è chiedersi chi tragga vantaggi e chi venga danneggiato da questi sistemi di AI. E se mettano altro potere nelle mani di chi già è potente. Vediamo continuamente che questi sistemi, dal riconoscimento facciale al tracciamento sui posti di lavoro, stanno dando potere a istituzioni già potenti, grandi aziende, forze militari, forze dell’ordine”. Queste spinose questioni nulla tolgono al fatto che l’AI, se usata responsabilmente, possa essere uno straordinario motore di progresso tecnologico, economico e sociale. Secondo le stime della Commissione Europea, fra il 2019 e il 2025 grazie alla robotica e all’intelligenza artificiale potranno essere creati 60 milioni di posti di lavoro. E proprio la Commissione Europea ha pubblicato lo scorso aprile, dopo anni di dibattito sul tema, una proposta di regolamento che tenta di armonizzare l’uso dell’intelligenza artificiale in territorio comunitario, con l’obiettivo di “salvaguardare i valori e i diritti fondamentali dell’Ue e la sicurezza degli utenti”. La proposta vieta espressamente gli utilizzi non trasparenti dell’AI, come l’applicazione di tecniche subliminali per influenzare il comportamento delle persone. Inoltre non si potranno né commercializzare né mettere in azione sistemi che “sfruttino qualsiasi vulnerabilità di un gruppo specifico di persone, per la loro età o disabilità fisica o mentale, al fine di falsarne in misura rilevante il comportamento in un modo che provochi o possa provocare danni fisici o psicologici agli stessi o ad altri”. L’uso di sistemi di identificazione biometrica in tempo reale dovrà essere limitato a casi particolari in cui il fine giustifica i mezzi, come la ricerca di bambini scomparsi e la prevenzione di attacchi terroristici.

Valentina Bernocco

L’EUROPA PREVEDE QUATTRO LIVELLI DI RISCHIO

Un approccio “stratificato”, con diversi livelli di rischio, costi e benefici da ponderare: questa è la posizione ufficiale della Commissione Europea sul tema dell’intelligenza artificiale. Nell’aggiornamento 2021 al “Piano coordinato per l’AI” (la cui prima versione era stata varata nel 2018) si definiscono quattro categorie di rischio, con annessi obblighi e divieti. Dalla classificazione sono escluse le applicazioni sviluppate a scopi militari. Sono considerate di “rischio non accettabile”, e dunque vietate, le pratiche che prevedono manipolazione psicologica subliminale (per esempio, un’applicazione in cui ai camionisti venga fatto udire un suono subliminale che li spinge a guidare per più tempo senza interruzioni), quelle che stimolano comportamenti pericolosi (magari attraverso applicazioni apparentemente ludiche), sistemi di social scoring usati dalle autorità pubbliche (per esempio dai servizi sociali) e l’identificazione biometrica remota in tempo reale, usata dalle forze dell’ordine in spazi accessibili al pubblico (è concessa solo in alcuni contesti, come la ricerca di persone scomparse). Sono invece ammessi, anche se con numerose limitazioni, i sistemi a “rischio alto” usati per la ricerca delle persone scomparse, per attività di forze dell’ordine, per la gestione e il funzionamento delle infrastrutture critiche, per la gestione dei lavoratori, per l’accesso a servizi pubblici e privati essenziali, per il controllo delle frontiere, per l’amministrazione della giustizia e dei processi. I fornitori di tecnologie o servizi ad alto rischio sono hanno l’obbligo di attivare sistemi di controllo qualità, di redigere e mantenere aggiornata la documentazione tecnica, di fare valutazioni di conformità per apporre la marcatura CE sulle loro soluzioni. La maggior parte delle applicazioni di AI rientrano nel terzo livello, di “rischio moderato”, cioè pongono soprattutto potenziali problemi di privacy e di trasparenza. In questa categoria c’è l’obbligo di segnalare agli utenti che essi stanno interagendo con un sistema di AI (qualora ciò non sia evidente), di avvisarli se sono in funzione sistemi di riconoscimento biometrico o di analisi delle emozioni o se si trovano davanti a deep fake (immagini video create con l’intelligenza artificiale). Bollino verde per tutte le applicazioni con “rischi minimi o assenti”, per le quali non sono previsti obblighi vincolanti ma solo, eventualmente, codici di condotta suggeriti.

SPIONAGGIO E DISCRIMINAZIONI, BIOMETRIA SOTTO INDAGINE

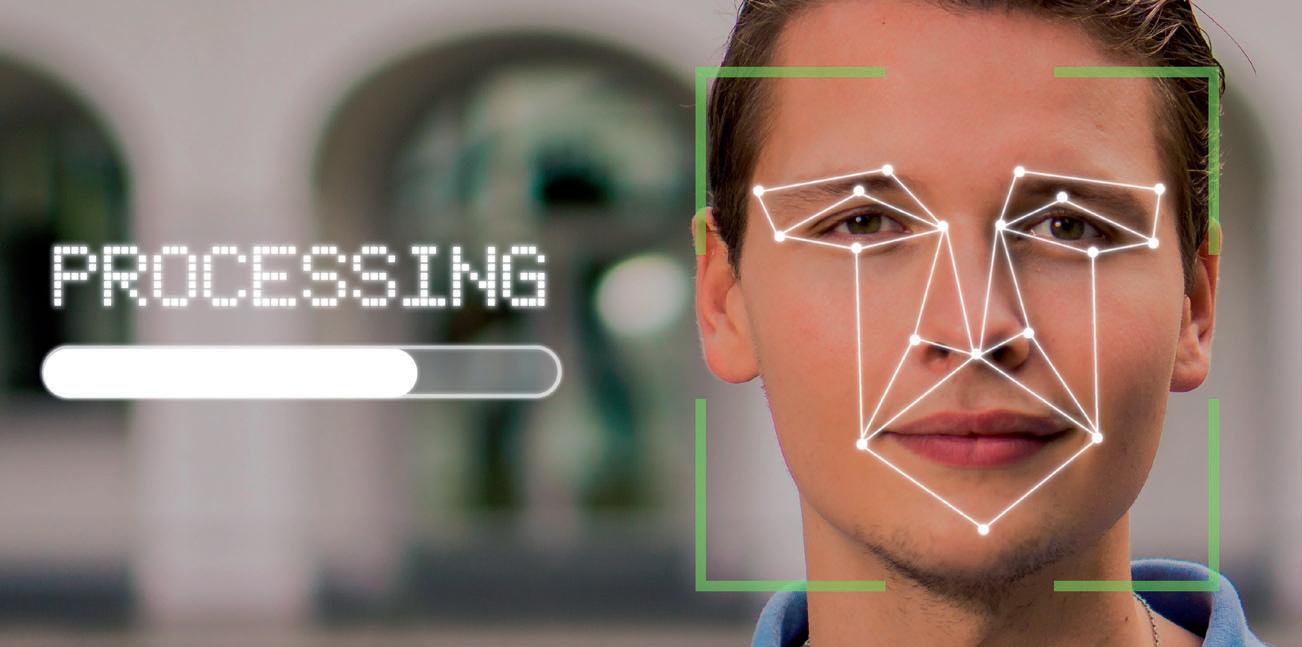

Le autorità garanti della privacy criticano l’uso non regolamentato e non trasparente del riconoscimento facciale. Ci stiamo trasformando in un gigantesco database?

I sistemi di riconoscimento facciale basati su intelligenza artificiale possono fare paura se usati in modo poco trasparente e troppo invasivo. Emblematico è il caso di Clearview AI, società statunitense specializzata in questo campo e che vanta tra i propri clienti circa tremila agenzie di pubblica sicurezza (tra cui l’esercito e l’aviazione statunitensi): all’inizio del 2020 un reportage del New York Times ha denunciato il furto, da parte dell’azienda, di tre miliardi di immagini ricavate dal Web e in particolare da piattaforme social come Facebook, YouTube e Venmo. Un immenso database di immagini di persone schedate a loro insaputa e senza aver mai prestato consensi per attività di questo tipo. Ma ClearView AI non è un caso di grave violazione della privacy isolato. In un documento del 2020, il Ga-

rante europeo della protezione dei

dati citava PimEyes, società polacca che consente a qualsiasi utente di caricare su un sito Web la foto di una persona per trovare eventuali altre immagini presenti in Rete. “Di fatto”, sottolineava il Garante, “è possibile far controllare dal database qualsiasi persona che incontrate per strada e a cui scattate di nascosto una foto”. L’ente europeo per la protezione dei dati caldeggia l’adozione di standard internazionali (come l’ISO/IEC 24745) e di meccanismi di autenticazione e crittografia come il biometric template protection. Si tratta di misure di tutela già disponibili, ma non adottate in modo sistematico e trasparente dagli sviluppatori di applicazioni biometriche. Laddove ci siano state verifiche concrete, molte tecnologie non hanno superato l’esame. Nel Regno Unito, per esempio, l’Information Commissioner's Office (Ico) ha avviato e in certi casi completato indagini su applicazioni di riconoscimento facciale “live”, rilevando criticità in tutti i casi. Di che cosa si tratta? A differenza dei classici sistemi di Cctv, le televisioni a circuito chiuso, i sistemi di live facial recognition impiegano algoritmi di intelligenza artificiale capaci di schedare o identificare le persone e di desumere dall’analisi facciale dati di vario tipo, anche sensibili: sesso, età, appartenenza etnica, segnali di disabilità o di malattia. “Sono profondamente preoccupata”, ha scritto la Information Commissioner, Elizabeth Denham, “in merito alla possibilità che la tecnologia di riconoscimento facciale in diretta sia usata in modo inappropriato, eccessivo o anche sconsiderato. Quando dei dati personali sensibili vengono raccolti su scala di massa senza che le persone ne abbiano coscienza, scelta o controllo, l’impatto può essere significativo”. Il garante britannico è preoccupato, in particolare, dei rischi per la sicurezza pubblica e della creazioni di profili biometrici per attività di marketing personalizzato. Nelle indagini già completate dall’Ico, nessuna delle aziende coinvolte ha saputo spiegare in modo completo quali procedimenti applicasse. Tra i sistemi già in funzione, inoltre, nessuno si è rivelato completamente conforme ai requisiti delle leggi sulla privacy in vigore nel Regno Unito. Se non altro, ha spiegato Dehnam, tutte le aziende oggetto d’indagine hanno scelto di interrompere le applicazioni in corso o di non procedere con quelle pianificate. Ma non per questo possiamo stare tranquilli. In futuro, ha scritto la Information Commissioner, “le videocamere Cctv potrebbero sovrapporsi ai sistemi di riconoscimento facciale live e addirittura combinarsi con i dati dei social media o con altri sistemi Big Data”. V.B.