200 minute read

TABLAS Y FIGURAS

TABLAS Y FIGURAS

Tabla 1.3.1. Ejemplo de búsqueda sobre acreditación de formación continuada

Formación Continuada AND Acreditación

OR

OR

education continuing accreditation*

education, medical, continuing

education, nursing, continuing

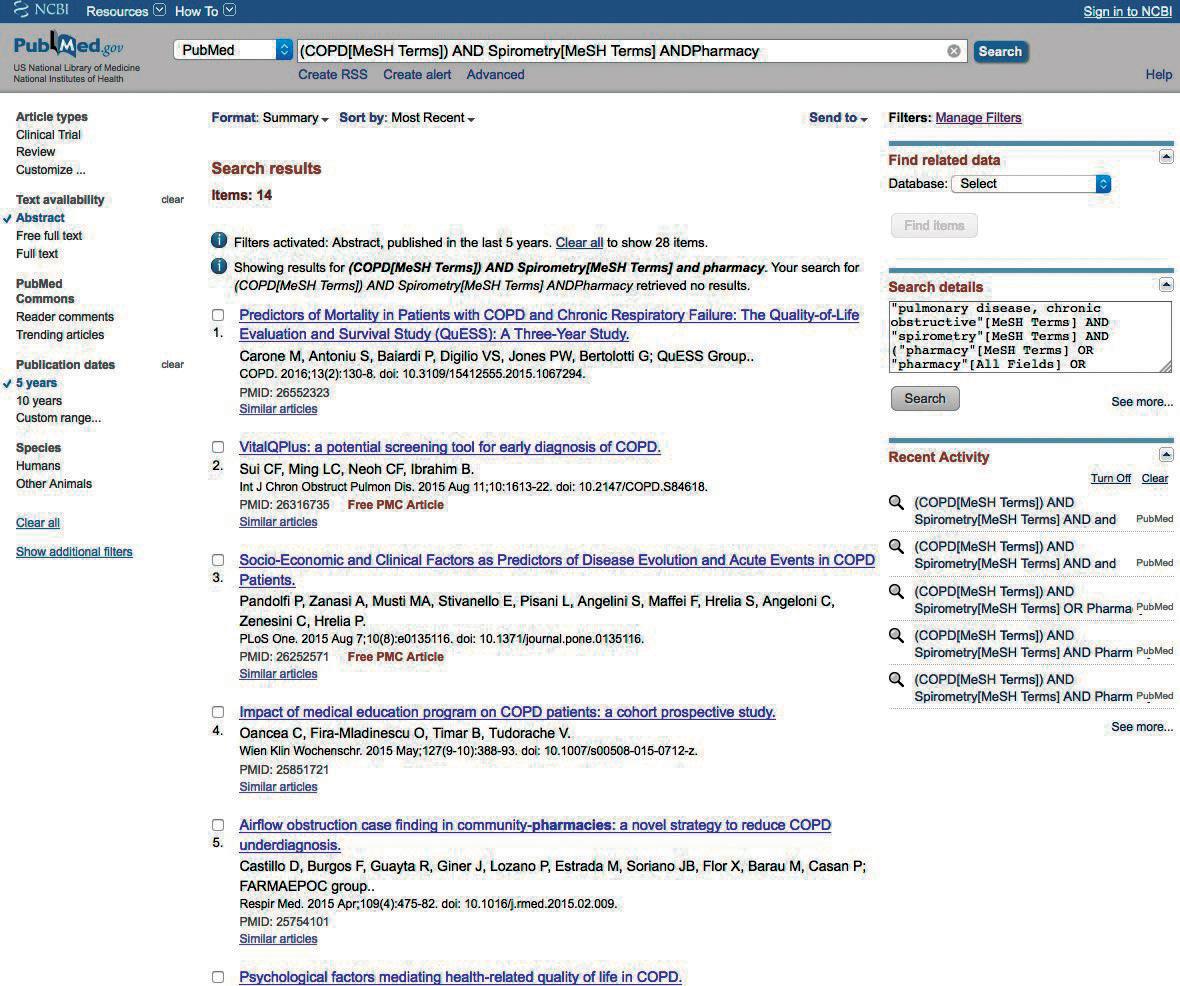

Figura 1.3.1. Figura 1.3.2.

Figura 1.3.3.

Figura 1.3.4. Figura 1.3.5.

Figura 1.3.6.

Figura 1.3.7.

Figura 1.3.8.

Figura 1.3.9.

Figura 1.3.10.

Figura 1.3.11.

Figura 1.3.12.

Figura 1.3.13.

Figura 1.3.14.

Figura 1.3.15.

Figura 1.3.16.

Figura 1.3.17.

Figura 1.3.18.

Figura 1.3.19.

Figura 1.3.20.

Modulo 2:

METODOLOGÍA CIENTÍFICA

Responsable: Dr. Joan Soriano2.

ÍNDICE

2.1. TIPOS DE DISEÑOS: GENERALIDADES ........................................................................................ 61 INTRODUCCIÓN .................................................................................................................................. 61 DISEÑO DE UN ESTUDIO ................................................................................................................. 61 Ejemplos PUNTOS CLAVE ................................................................................................................................... 63 BIBLIOGRAFÍA ..................................................................................................................................... 64 TABLAS Y FIGURAS ........................................................................................................................... 65

2.2. ESTUDIOS DESCRIPTIVOS ............................................................................................................. 69 INTRODUCCIÓN .................................................................................................................................. 69 CARACTERÍSTICAS GENERALES ................................................................................................... 69 ESTUDIOS ECOLÓGICOS ................................................................................................................. 71 Estudios descriptivos de mapas Estudios de series temporales ESTUDIOS DE BASE INDIVIDUAL ................................................................................................. 72 Series de casos Estudios transversales PUNTOS CLAVE ................................................................................................................................... 74 BIBLIOGRAFÍA ..................................................................................................................................... 75 TABLAS Y FIGURAS ........................................................................................................................... 76

2.3. ESTUDIOS ANALÍTICOS: COHORTES Y CASO-CONTROL ...................................................... 77 INTRODUCCIÓN .................................................................................................................................. 77 ESTUDIOS DE COHORTE .................................................................................................................. 77 Proceso de un estudio de cohorte Ventajas de un estudio de cohorte Inconvenientes de un estudio de cohorte Análisis ESTUDIOS DE CASOS Y CONTROLES .......................................................................................... 80 Tipos de estudio de casos y controles Proceso de un estudio de casos y controles Ventajas de los estudios de casos y controles Inconvenientes de los estudios de casos y controles Análisis INTERPRETACIÓN ............................................................................................................................... 82 PUNTOS CLAVE ................................................................................................................................... 83

BIBLIOGRAFÍA ..................................................................................................................................... 84 TABLAS Y FIGURAS ........................................................................................................................... 86

2.4. ESTUDIOS EXPERIMENTALES Y CUASI EXPERIMENTALES ................................................. 91 INTRODUCCIÓN .................................................................................................................................. 91 ESTUDIOS EXPERIMENTALES ........................................................................................................ 91 Características Ventajas y limitaciones ESTUDIOS CUASI EXPERIMENTALES .......................................................................................... 94 Características Ventajas y limitaciones PRINCIPALES SESGOS EN LOS ESTUDIOS EXPERIMENTALES Y CUASI EXPERIMENTALES ................................................................................................................ 95 ENSAYO CLÍNICO CON MEDICAMENTOS ................................................................................... 96 CONSIDERACIONES ÉTICAS DE LOS ESTUDIOS EXPERIMENTALES ................................ 96 PUNTOS CLAVE ................................................................................................................................... 97 BIBLIOGRAFÍA ..................................................................................................................................... 98 TABLAS Y FIGURAS ........................................................................................................................... 99

2.5. TIPOS DE ERROR. VALIDEZ, SESGOS Y CONFUSIÓN ............................................................. 101 EL ERROR EN INVESTIGACIÓN ....................................................................................................... 101 ERROR ALEATORIO. PRECISIÓN .................................................................................................... 101 Defi nición, causas y efectos del error aleatorio Evaluación del error aleatorio ERROR SISTEMÁTICO. VALIDEZ .................................................................................................... 102 Sesgo de selección. Defi nición, causas y efectos Sesgo de información. Defi nición, causas y efectos Confusión. Defi nición, causas y efectos Evaluación del error sistemático (sesgo de selección, sesgo de información y confusión). Análisis de sensibilidad VALIDEZ EXTERNA. GENERALIZACIÓN ........................................................................................ 105 REDUCIR LOS ERRORES ALEATORIOS Y SISTEMÁTICOS .................................................... 105 Evitar o reducir el error aleatorio Evitar o reducir el sesgo de selección Evitar o reducir el sesgo de información Evitar o reducir la confusión EQUÍVOCOS Y DUDAS FRECUENTES EN TORNO A LOS ERRORES EN INVESTIGACIÓN .................................................................................................................................. 108 CONSIDERACIONES FINALES ......................................................................................................... 109 PUNTOS CLAVE ................................................................................................................................... 109 BIBLIOGRAFÍA ..................................................................................................................................... 110 TABLAS Y FIGURAS ........................................................................................................................... 111

2.6. REVISIONES SISTEMÁTICAS Y METAANÁLISIS ...................................................................... 119 INTRODUCCIÓN .................................................................................................................................. 119 PROTOCOLO DE LA REVISIÓN SISTEMÁTICA ........................................................................... 119 DEFINICIÓN DE LA PREGUNTA DE REVISIÓN ............................................................................ 120 CRITERIOS DE INCLUSIÓN Y EXCLUSIÓN ................................................................................. 120 BÚSQUEDA BIBLIOGRÁFICA ......................................................................................................... 121 PROCESO DE REVISIÓN ................................................................................................................... 122 Equipo de revisión Estudios excluidos PROCESO DE EXTRACCIÓN DE DATOS ....................................................................................... 123 EVALUACIÓN DEL RIESGO DE SESGOS ...................................................................................... 123 ANÁLISIS DE RESULTADOS ............................................................................................................ 124 Metaánalisis Metasíntesis EVALUACIÓN DE LA CALIDAD DE LA EVIDENCIA ...................................................................... 125 REDACCIÓN DE RESULTADOS ....................................................................................................... 125 LIMITACIONES DE LOS RESULTADOS ......................................................................................... 125 REVISANDO UNA REVISIÓN .......................................................................................................... 125 PUNTOS CLAVE ................................................................................................................................... 126 BIBLIOGRAFÍA ..................................................................................................................................... 127 TABLAS Y FIGURAS ........................................................................................................................... 128

2.7. VALIDACIÓN DE PRUEBAS DIAGNÓSTICAS ............................................................................. 131 INTRODUCCIÓN .................................................................................................................................. 131 FASES DE UN ESTUDIO DE EVALUACIÓN DE PRUEBAS DIAGNÓSTICAS ....................... 131 ELEMENTOS CLAVE PARA AUMENTAR LA CALIDAD DE LOS ESTUDIOS DE VALIDACIÓN DIAGNÓSTICA .................................................................................................... 132 Estructura básica Pasos a seguir en los estudios VALIDEZ, FIABILIDAD Y PRECISIÓN DE LOS ESTUDIOS DE PRUEBAS DIAGNÓSTICAS .................................................................................................................................. 133 Validez Fiabilidad Precisión CONTROL DE CALIDAD DE LOS ESTUDIOS DE PRUEBAS DIAGNÓSTICAS .................... 136 PUNTOS CLAVE ................................................................................................................................... 136 BIBLIOGRAFÍA ..................................................................................................................................... 137 TABLAS Y FIGURAS ........................................................................................................................... 138

2.8. VALIDACIÓN DE CUESTIONARIOS ............................................................................................... 145 INTRODUCCIÓN .................................................................................................................................. 145 ELABORACIÓN DE UN CUESTIONARIO ....................................................................................... 146 VALIDACIÓN DEL CUESTIONARIO ................................................................................................ 147 Fiabilidad Validez RESPUESTA AL CAMBIO .................................................................................................................. 150 Cambio homogéneo Cambio heterogéneo CUESTIONES A CONSIDERAR ........................................................................................................ 151 PUNTOS CLAVE ................................................................................................................................... 152 BIBLIOGRAFÍA ..................................................................................................................................... 153 TABLAS Y FIGURAS ........................................................................................................................... 154

2.1. TIPOS DE DISEÑOS: GENERALIDADES

Dra. Elena Gimeno

INTRODUCCIÓN

En este capítulo se presentan los tipos de diseño en investigación y sus generalidades. En capítulos posteriores se describirán las características de cada uno de ellos de manera más detallada. El diseño de un proyecto de investigación se defi ne como el conjunto de procedimientos, métodos y técnicas para la selección de sujetos, evaluación de las variables del estudio, recogida de datos y análisis para la interpretación de resultados.

DISEÑO DE UN ESTUDIO

En investigación existen diferentes tipos de diseños de estudios. La elección del diseño más adecuado va a depender de la pregunta de investigación que se quiera responder (objetivo principal), de la frecuencia de la condición clínica o enfermedad a estudiar, de la consideración de los aspectos éticos, así como de los recursos económicos, de infraestructura y de tiempo del equipo investigador. Los factores a tener en cuenta para el diseño de un estudio se pueden clasifi car según diferentes criterios:

• Naturaleza de los datos: cuantitativo o cualitativo. • Propósito del estudio: descriptivo o analítico. • Asignación de la exposición: experimental u observacional. • Temporalidad del seguimiento: transversal o longitudinal. • Relación cronológica del inicio del estudio y aparición del fenómeno de estudio: prospectivo o retrospectivo. • Unidad de estudio: individuo o grupo de individuos.

En la tabla 2.1.1 se describen de manera general las características de cada uno de los criterios de clasifi cación para el diseño de un estudio.

La tigura 2.1.1 presenta un algoritmo de clasifi cación de los estudios teniendo en cuenta algunos de los criterios anteriormente descritos. Este algoritmo no presenta una clasifi cación universalmente aceptada (ya que puede variar en función de los criterios que se usen), pero puede ayudar a encuadrar la pregunta de investigación y decidir el diseño de estudio más adecuado.

Otra de las características a tener en cuenta y que está relacionada con un tipo de diseño u otro es la evidencia científi ca que los resultados de un estudio proporcionarán. La Figura 2.1.2 esquematiza de manera general la jerarquía de evidencia científi ca que cada tipo de estudio aporta.

Como se mencionó anteriormente, la estructura del diseño de nuestro estudio combinará las diferentes características o criterios que aparecen en la tabla y en el algoritmo. A continuación, se presentan algunos ejemplos de estudios, ya publicados, con el objetivo de analizar los criterios de clasifi cación vistos en este capítulo.

Ejemplos

Ejemplo 1. Garcia-Aymerich J, Gómez FP, Benet M, et al. PAC-COPD Study Group. Identifi cation and prospective validation of clinically relevant chronic obstructive pulmonary disease (COPD) subtypes. Th orax. 2011;66:430-437.

Este estudio recoge datos demográfi cos, clínicos, funcionales, etc. (estudio cuantitativo) de 342 pacientes con enfermedad pulmonar obstructiva crónica (EPOC) durante su primer ingreso por agudización en 9 hospitales terciarios de 3 comunidades autónomas españolas, sin hacer ningún tipo de intervención (estudio observacional), con el objetivo de: 1) identifi car los subtipos de los pacientes que ingresan por primera vez por agudización de la EPOC (analítico transversal) y 2) validar los subtipos identifi cados durante un seguimiento de 4 años (analítico longitudinal prospectivo) con variables clínicamente relevantes, como hospitalización y mortalidad (relación causa-efecto: estudio de cohorte).

Ejemplo 2. McKeever T, Harrison TW, Hubbard R, Shaw D. Inhaled corticosteroids and the risk of pneumonia in people with asthma: a case-control study. Chest. 2013;144:1788-1794.

En una cohorte de pacientes con diagnóstico de asma se identifi có a los pacientes que hubieran sido diagnosticados de neumonía (casos) y a pacientes de la misma edad y sexo que no hubieran tenido diagnóstico de neumonía (controles) (estudio cuantitativo) con el objetivo de estudiar la asociación (estudio analítico) de neumonía y el uso de corticoides inhalados en pacientes con asma (estudio observacional, longitudinal, relación efecto-causa: estudio de casos-controles).

Ejemplo 3. Miravitlles M, Soriano JB, García-Río F, et al. Prevalence of COPD in Spain: impact of undiagnosed COPD on quality of life and daily life activities. Th orax. 2009;64:863-868.

En este estudio se recogen datos demográfi cos y clínico-funcionales (cuantitativo) mediante envío de un cuestionario (transversal) a una muestra poblacional de más de 4.200 sujetos de edades comprendidas entre 40 y 80 años de 10 ciudades de España (descriptivo) para estimar la prevalencia de EPOC (transversal: prevalencia).

Ejemplo 4. Ehlken N, Lichtblau M, Klose H, et al. Exercise training improves peak oxygen consumption and haemodynamics in patients with severe pulmonary arterial hypertension and inoperable chronic thrombo-embolic pulmonary hypertension: a prospective, randomized, controlled trial. Eur Heart J. 2016;37:3544.

En este estudio se selecciona una muestra de 87 pacientes con hipertensión arterial pulmonar con el objetivo de estudiar los efectos de 15 semanas de entrenamiento físico en parámetros clínicos como el pico en el consumo de oxígeno y en la hemodinámica (estudio cuantitativo analítico). Los pacientes son asignados aleatoriamente a grupo intervención (entrenamiento físico) o grupo control (tratamiento habitual), y son

evaluados antes y después de la intervención (estudio prospectivo, experimental, aleatorizado y con grupo control: ensayo clínico controlado aleatorizado – ECA).

Ejemplo 5. Dobbels F, De Jong C, Drost E, et al. Th e PROactive innovative conceptual framework on physical activity. Eur Respir J. 2014;44:1223-1233.

Este estudio es un ejemplo de diseño cualitativo, ya que aunque los autores aportan información numérica sobre las características de los sujetos de estudio (edad, función pulmonar, prueba de la marcha, etc.), los resultados principales son básicamente narrativos: un marco conceptual y anotaciones extraídas de entrevistas y grupos focales con pacientes con EPOC para conocer su experiencia de actividad física.

PUNTOS CLAVE

• La pregunta de investigación y, por lo tanto, el objetivo principal del estudio constituye los factores que determinarán en mayor medida la selección del diseño más adecuado. • Los diferentes tipos de estudios se distribuyen de manera jerárquica en función de la evidencia científi ca que generan. En humanos, la mayor evidencia la proporcionarán los ensayos controlados aleatorizados (ECA), mientras que las series de casos son los que menor evidencia producen. • Los estudios cualitativos recogen información narrativa (no numérica) basada en percepciones, opiniones y explicaciones, mientras que los estudios cuantitativos recogen información que puede ser medida o registrada numéricamente. • Los estudios descriptivos se centran en el estudio de características generales, distribución de la población y descripción de la historia natural de una enfermedad. Los estudios analíticos permiten estudiar la relación causal entre la exposición (o intervención) y el efecto (o resultado). • En los estudios observacionales no existe manipulación por parte del investigador, quien se limita a observar lo que ocurre. Sin embargo, en los estudios experimentales se manipula el factor de estudio para evaluar el efecto. • Los estudios transversales recogen la información en un momento temporal determinado (ideales para estudiar prevalencia). Los estudios longitudinales recogen los datos después de un periodo de seguimiento (ideales para estudiar causalidad). • En los estudios prospectivos, el evento de interés se producirá después del inicio del estudio, mientras que en los estudios retrospectivos el evento de interés ya se produjo (los datos se pueden recoger mediante revisión de archivos históricos).

BIBLIOGRAFÍA

Argimón Pallás JM, Jiménez Villa J. Métodos de investigación clínica y epidemiológica. Madrid, Elsevier, 4ª ed., 2013. Garcia-Aymerich J, Soriano JB. “Aspectos epidemiológicos en neumología”. En: Casán P, García Río F, Gea J (editores). Fisiología y biología respiratorias. Madrid, ERGON, 2007, p. 689-701. Chatburn RL. Handbook for respiratory care research. Cleveland, Mandu Press, 1ª ed. 2002.

TABLAS Y FIGURAS

Tabla 2.1.1. Criterios de clasifi cación para el diseño de un estudio

Naturaleza de los datos Cualitativo Cuantitativo

Recoge información narrativa extraída de entrevista no estructurada, observación del participante, análisis documental, grupos focales, etc. Estudia las percepciones, opiniones y explicaciones en un grupo de sujetos de interés en situaciones o contextos dinámicos. Análisis inductivo (desarrollo de teorías). Recoge información que puede ser medida numéricamente. Estudia la asociación o relación entre variables cuantifi cables a través de una muestra representativa en contextos más controlados. Análisis deductivo (análisis de la teoría).

Propósito del estudio Descriptivo Analítico

Permite estudiar características generales y distribución poblacional, así como describir la historia natural de las enfermedades. Útil para generar hipótesis etiológicas que deberían contrastarse con estudios analíticos. Muchas veces clasifi cados como observacionales por su naturaleza implícita de no manipulación del factor de estudio. Permite evaluar una relación causal entre un factor, exposición o intervención y el efecto o resultado. Útil para confi rmar hipótesis etiológicas.

Asignación del factor de estudio Observacional Experimental

No existe manipulación del factor de estudio por parte del investigador, este simplemente se limita a observar, medir y analizar las variables de estudio en los sujetos de interés. Permite probar hipótesis y estudiar relaciones causales. Manipulación (asignación) del factor de estudio por parte del investigador, mediante aleatorización y según un protocolo previamente establecido. Si la asignación no es aleatorizada será un diseño

cuasi-experimental.

En general, se usa para evaluar el efecto de una intervención.

Temporalidad del seguimiento Transversal Longitudinal

Los datos se obtienen en un momento temporal determinado (cross-sectional). Se mide a la vez la frecuencia de la exposición y la enfermedad de interés, y por ello no permiten establecer relación causa-efecto. Ideal para estudiar (describir) la prevalencia de una enfermedad o una característica clínica, y para generar hipótesis causales que deberían contrastarse con estudios longitudinales. Los datos se obtienen después de un periodo de seguimiento (follow-up). Se establece una secuencia temporal entre las variables medidas lo que permite estudiar causalidad. Si la dirección temporal va de la causa hacia el desenlace (efecto) será un estudio experimental o uno de cohortes. Si la dirección temporal va desde el desenlace (efecto) hacia la causa será un estudio de casos y controles.

Relación cronológica del inicio del estudio y la aparición del fenómeno Prospectivo Retrospectivo

El desenlace o evento de interés se produce después del inicio del estudio. Los datos de las variables de interés se recogen a medida que van sucediendo. El desenlace o evento de interés se ha producido antes del inicio del estudio. Los datos se recogen mediante revisión de archivos o de historia clínica, o a través de entrevista sobre los eventos sucedidos.

Unidad de estudio

Individuo Grupo de individuos (ecológicos)

La información se recoge de manera individual. La información se recoge de manera agregada según criterios previamente establecidos, por ejemplo, geográfi cos o temporales.

Figura 2.1.1. Algoritmo de clasifi cación de los tipos de diseño de estudio

Figura 2.1.2. Jerarquía de evidencia científi ca según el tipo de estudio

2.2. ESTUDIOS DESCRIPTIVOS

Dr. José Luis López-Campos Bodineau

INTRODUCCIÓN

Las principales fuentes de orientación ética para la realización de investigaciones clínicas son tres: la DeclarA pesar de la extendida creencia de que los estudios descriptivos pueden tener un menor interés, esta opinión no se corresponde con la realidad. Los estudios descriptivos permiten tener una primera aproximación a un problema de salud, detectar de manera rápida un nuevo evento clínico, comparar situaciones entre áreas geográfi cas o momentos temporales y, además, son la principal fuente de generación de hipótesis para ulteriores estudios. Se trata, por tanto, de diseños sencillos, pero que pueden tener un gran poder de información. En concreto, la epidemiología descriptiva permite responder preguntas relevantes sobre la distribución de las enfermedades en el espacio y el tiempo y determinar los factores asociados a esta distribución. De esta manera, los estudios descriptivos aportan información sobre las poblaciones que desarrollan una determinada enfermedad o un efecto clínico, su frecuencia en comparación con otras poblaciones, cómo varía esta frecuencia en el tiempo o entre localizaciones geográfi cas y los factores de riesgo asociados. Por este motivo, es necesario conocer bien los estudios descriptivos y saber diseñarlos, ejecutarlos y analizarlos adecuadamente. Sus dos grandes ventajas son posibilitar la síntesis de información compleja y extensa y la generación de hipótesis. Se trata, por tanto, de diseños denominados observacionales o no experimentales, puesto que su objetivo es describir una situación clínica concreta en un contexto temporal y geográfi co sin intervenir de ninguna manera en la población observada.

CARACTERÍSTICAS GENERALES

Para llevar a cabo un estudio descriptivo, es necesario realizar una serie de pasos que nos ayudarán a defi nir el objetivo de nuestro trabajo y que deben tenerse en cuenta en la metodología. En su diseño deberemos defi nir: la enfermedad a estudiar, la población diana, las variables que vamos a registrar y la elección de la fuente de información.

Problema de salud a estudiar. En el diseño del estudio descriptivo es necesario identifi car y defi nir bien la enfermedad que va a ser objeto de estudio. Este paso es crucial para interpretar los resultados y compararlos con otros estudios previos. En este punto, además de identifi car la enfermedad en concreto, es necesario defi nir bien los criterios diagnósticos. Un ejemplo cercano está representado por los estudios epidemiológicos sobre enfermedad pulmonar obstructiva crónica (EPOC). Aunque el concepto de la enfermedad está claro,

los criterios diagnósticos para defi nir un caso en un estudio epidemiológico pueden variar, ya que pueden utilizarse el cociente fi jo FEV1/FVC de la espirometría o bien su límite inferior de la normalidad, y puede hacerse con la espirometría, la pre o la post-broncodilatación. Según se elija unos u otros, la prevalencia de la enfermedad cambiará.1

Población diana. Aunque siempre es interesante conocer cómo se comporta la población respecto a una determinada enfermedad o factor de riesgo, la población a estudio no tiene por qué ser la población general. En ocasiones interesará estudiar una población concreta. Por ejemplo, el cáncer de pulmón en mujeres, o en población no fumadora, o en un determinado rango de edad. Esta población debe quedar perfectamente identifi cada en el diseño del trabajo.

Variables a registrar. Es importante defi nir previamente qué información se va a registrar de cada caso. Para ello, no sólo es importante seleccionar las variables, sino que también hay que concretar dos aspectos relevantes:

• Cómo se van a defi nir estas variables. Por ejemplo, si queremos estudiar la distribución de pacientes con frecuentes agudizaciones, no sólo tendremos que elegir el número de agudizaciones como variable, también tendremos que defi nir qué vamos a considerar una agudización y qué vamos a considerar como agudizador frecuente. Otro ejemplo podría ser el nivel socioeconómico, cuya defi nición y estratifi cación deberemos defi nir en la metodología. Situaciones parecidas se pueden dar en la categorización de la gravedad de una enfermedad, la intensidad de la exposición a un factor de riesgo o los valores de una determinación analítica. • Cómo se van a registrar. En este sentido, deberemos defi nir si se va a registrar como una variable continua o categórica. Para las variables cualitativas está claro que se deben registrar como categóricas, pero deberemos defi nir las categorías que vamos a emplear. En ocasiones será sencillo (por ejemplo, hombre o mujer), pero en otras será más complicado (por ejemplo, nivel de estudios o situación socioeconómica). En cuanto a las variables cuantitativas, podremos registrarlas como números o categorizarlas; en este último caso también deberemos defi nir las categorías. Esta decisión es de especial relevancia, ya que dependiendo de si usamos la variable cuantitativa cruda o categorizada realizaremos después el análisis estadístico de los datos en la misma línea.

Elección de la fuente de información. En nuestro caso, la fuente de información será por lo general la historia clínica del paciente o bien datos almacenados en bases de datos sanitarias. Aquí es importante tener presente dos aspectos:

• La fuente de la información. En función de la variable que queramos medir, deberemos recurrir al historial médico, al de enfermería o a otros registros. Por ejemplo, si vamos a registrar la temperatura corporal de los pacientes durante una hospitalización, no tendría mucha validez si extrajéramos este dato de la historia médica, puesto que allí se recoge de manera inconstante. Sin embargo, el historial de enfermería la recoge sistemáticamente. • Si la información que vamos a usar se puede extraer directamente como dato primario del origen o si, por el contrario, la información tiene que ser procesada antes de su análisis. Por ejemplo, podemos analizar los niveles de potasio en suero, que es un dato primario de la historia clínica; sin embargo si queremos estudiar el uso de un índice compuesto, tendremos que calcularlo a partir de los datos de la historia. En este último caso, será necesario defi nir muy bien en la metodología cómo tratan los datos y de qué fuente provienen.

Clasifi cación. Los estudios descriptivos se han clasifi cado de distintas formas. En este capítulo hablaremos de dos grandes tipos de estudio en función de la unidad de análisis. Si la unidad de análisis son personas,

hablaremos de estudio de base individual. Si, por el contrario, se analizan datos de grupos de poblaciones, también llamados datos agregados, entonces hablaremos de estudios ecológicos.

ESTUDIOS ECOLÓGICOS

Los estudios ecológicos usan datos agregados de grupos poblacionales. Su función es describir la distribución de las enfermedades en una población, durante un período de tiempo concreto y en un ámbito geográfi co defi nido. De esta manera, pueden dar información sobre la frecuencia de la enfermedad o del fenómeno a estudiar y cuáles son los factores asociados. Este tipo de estudio permite, además, identifi car aumentos en el tiempo o el espacio de una agregación de casos o eventos que son de una ayuda considerable al planifi car políticas de salud.

Hasta hace unas décadas, estos estudios eran difíciles de llevar a cabo, puesto que no existían muchas fuentes de información de donde extraer los datos. Con la informatización de los datos y la disponibilidad a través de internet, se ha conseguido que estos datos estén disponibles para los investigadores interesados en responder preguntas de investigación. Por lo general, las bases de datos de salud suelen estar abiertas siempre que se cumplan los requisitos éticos, incluyendo la confi dencialidad de los datos, y que se utilicen para el fi n de investigación defi nido.

Entre sus ventajas destaca que son relativamente rápidos de realizar, siempre que se tenga la información adecuada. Además, son bastante económicos, ya que, al tener acceso a la información, realmente el principal recurso necesario para llevarlos a cabo es tiempo para hacer un análisis correcto. Su principal limitación es que sirven para plantear hipótesis, pero generalmente no para verifi carlas. Otra limitación metodológica se deriva de la comparación entre estudios. Debido a que son estudios de datos agregados, puede ser erróneo comparar datos de áreas geográfi cas o momentos temporales distintos, puesto que la estructura de la población que se estudia puede infl uir en los resultados. Por ejemplo, podríamos detectar una mayor mortalidad por EPOC en un país en comparación con otro, pero si el primer país tuviera una población más envejecida, entonces las diferencias podrían deberse a esta diferencia y no a un porcentaje de mortalidad por EPOC distinto. Para corregir esto, los estudios ecológicos ajustan sus valores a la población de estudio. De esta manera, las denominadas tasas crudas se transforman en tasas ajustadas a la población de esa zona y en ese momento. Es lo que se llama estandarización o ajuste de tasas. Las formas de estandarización de tasas quedan fuera de los objetivos de este capítulo, pero básicamente existen dos métodos, denominados método directo e indirecto. Una consideración metodológica que limita estos estudios es que asumen que toda la población está expuesta en la misma medida a los factores de riesgo en estudio, por lo que sus resultados no deben aplicarse a un caso concreto, puesto que incurriríamos en la denominada falacia ecológica.

Para entender la falacia ecológica, es importante recordar que los estudios ecológicos nos dan información agregada de la población en estudio, pero no de los individuos concretos. La falacia ecológica se produce cuando queremos extrapolar los resultados de un grupo a un individuo concreto o bien cuando queremos extrapolar los resultados de un individuo o grupo de individuos al grupo completo. Los estudios ecológicos se pueden clasifi car en dos grandes grupos: estudios descriptivos de mapas y estudios de series temporales.

Estudios descriptivos de mapas

Los estudios de mapas estudian un determinado parámetro epidemiológico, como puede ser la incidencia, la prevalencia o la mortalidad, buscando patrones según su distribución entre diversas áreas geográfi cas. Estas áreas pueden ser de cualquier tamaño: localidades, provincias, países o continentes. Generalmente se hace un mapa de calor en el que se colorea cada ámbito geográfi co en mayor o menor intensidad de color

según el mayor o menor valor del parámetro estudiado. La generación de estos mapas siempre ha necesitado una gran cantidad de tiempo, puesto que tradicionalmente se han hecho de manera manual con soft ware no específi co. En los últimos años han comenzado a aparecer aplicaciones específi camente diseñadas para el tratamiento de los datos y su distribución geográfi ca. Estas aplicaciones generan los mapas necesarios una vez se han introducido los datos. Entre ellas fi guran aplicaciones independientes, aplicaciones que se integran en los paquetes de ofi mática más comunes del mercado y aplicaciones online a través de páginas web específi cas. La fi gura 2.2.1 es un ejemplo de este tipo de mapas realizado por una aplicación online de acceso gratuito.

Estudios de series temporales

Los estudios de series o tendencias temporales describen la evolución de un problema de salud en el tiempo. En este tipo de estudio, es el tiempo y no el espacio lo que se analiza para apreciar los cambios del problema de salud. La principal limitación es que si la información es considerable y la variabilidad de los datos también, entonces puede ser difícil ver un patrón. Para esto existen métodos estadísticos que simplifi can la información y muestran una tendencia única. El método más conocido es la denominada regresión de joinpoint.2 Este análisis de regresión identifi ca puntos de infl exión (denominados joinpoints) en la curva de evolución temporal, con el objeto de identifi car los años en que se produjeron cambios signifi cativos en la pendiente lineal de la tendencia temporal. Este enfoque tiene dos ventajas principales: identifi ca el momento en que hay cambios en la tendencia y estima la magnitud del aumento o de la disminución observada en cada intervalo mediante el cálculo del denominado porcentaje de cambio anual entre dos joinpoints. Actualmente existe soft ware gratuito que hace este tipo de análisis. En la fi gura 2.2.2 se presenta un ejemplo de estudio de serie temporal con análisis de regresión de joinpoint.

ESTUDIOS DE BASE INDIVIDUAL

Series de casos

Los estudios de series de casos, o incluso de un caso concreto, son los estudios más simples. La descripción de uno o varios casos clínicos con características clínicas relevantes constituye la base de la investigación biomédica, sus orígenes, y tiene una gran relevancia clínica. A pesar de que su valor epidemiológico es escaso por no tener una muestra representativa ni contar con un grupo control, al compartir con colegas una presentación clínica peculiar, junto con la actitud diagnóstica o terapéutica llevada a cabo su valor clínico y docente es indudable. Además, este tipo de estudios también cumple la función de establecer hipótesis clínicamente relevantes que más adelante deberán confi rmarse con otro tipo de estudio. Por ejemplo, en 1935 dos médicos de Baltimore, Louis Hamman y Arnold Rich, publicaron una serie de 4 casos clínicos, la mayoría de pacientes de raza negra, entre los 20 y los 30 años de edad, que desarrollaban un cuadro clínico de un fracaso respiratorio agudo acompañado de infi ltrados pulmonares y con un pronóstico ominoso.3 Esta descripción inicial dio lugar al estudio de la patología intersticial pulmonar con un cuadro que en su día se denominó como pulmón de Hamman-Rich y que actualmente se ha asociado con la neumonía intersticial aguda. Entre sus ventajas fi guran que son fáciles, económicos y rápidos de realizar, tienen sentido clínico, permiten llamar la atención sobre un hecho clínico poco habitual y sirven para generar hipótesis.

Estudios transversales

Los estudios transversales, también llamados estudios de prevalencia, tienen por objetivo evaluar la presencia de una enfermedad y de los factores de riesgo asociados en un mismo momento temporal y en una población bien defi nida. Como resultado obtenemos la prevalencia de una determinada enfermedad o factor de riesgo en esa población defi nida.

Ventajas

Entre sus ventajas fi guran que proporciona información fi able y estática, una fotografía, para la planifi cación sanitaria, ya que permite identifi car grupos más vulnerables a un determinado problema de salud y además describe las enfermedades y las relaciona con la distribución de sus factores de riesgo en la población. Además, proporciona información basal para estudios de seguimiento y puede dar información sobre el impacto de una determinada intervención terapéutica en la población al repetir el estudio tras esta intervención. Finalmente, otra ventaja es su coste relativamente bajo en comparación con los estudios de seguimiento.

Limitaciones

El diseño de los estudios transversales, por otro lado, tiene algunos retos metodológicos. En primer lugar, por lo general resulta difícil estudiar toda la población diana, por lo que suelen tener una primera fase de selección de una muestra sobre la que se hace el estudio. El reto está en asegurar que esta muestra seleccionada es representativa de la población completa. Para conseguirlo, es necesario hacer algún tipo de muestreo bien defi nido y defi nir bien los criterios de inclusión y exclusión en el estudio. Los tipos de muestreos, sus ventajas e inconvenientes quedan fuera de los objetivos de este capítulo, pero este aspecto es importante para darle validez a los resultados. Es vital que las personas estudiadas sigan este proceso de muestreo para evitar sesgos en la selección de la muestra que la haga no representativa de la población a estudio. En este sentido, se han descrito diversos tipos de sesgos de selección que deben ser tenidos en cuenta, como el del voluntario sano, el de los no respondedores o el de supervivencia. En segundo lugar, es importante recordar que la información es estática en el tiempo, es una fotografía de la situación. Por tanto, al medir simultáneamente la presencia o no de enfermedad y sus factores de riesgo no tenemos noción de la dirección temporal de la asociación. En otras palabras, no sabemos si fue antes la enfermedad o el factor de riesgo. En tercer lugar, generalmente se asume que la enfermedad a estudio está representada por una variable dicotómica (tiene o no tiene la enfermedad), pero esto no siempre es así.

Análisis

El análisis de los estudios transversales nos aporta un resultado más inmediato, la prevalencia, entendida como número de sujetos que tienen la enfermedad entre el número de sujetos estudiados. Para estudiar su relación con un factor de riesgo determinado, podemos calcular la prevalencia entre los expuestos a ese factor de riesgo y entre los no expuestos. Esto nos permite estimar cómo de frecuente es la enfermedad entre expuesto y no expuesto mediante el cálculo de la razón de prevalencia, que es el cociente de ambas. Como alternativa a esta aproximación, un estudio de prevalencia se puede analizar como un estudio de casos-control y calcular la odds ratio de prevalencia, como se verá en el capítulo de los estudios de casos-control.

PUNTOS CLAVE

• Los estudios descriptivos permiten tener una primera aproximación a un problema de salud, comparar situaciones entre áreas geográfi cas o momentos temporales y disponer de una fuente de generación de hipótesis. • Los estudios ecológicos usan datos agregados de grupos poblacionales con objeto de describir la distribución de las enfermedades en una población, durante un período de tiempo concreto y en un ámbito geográfi co defi nido. • A pesar de que su valor epidemiológico es escaso por no tener una muestra representativa ni contar con un grupo control, los estudios de series de casos constituyen la base de la investigación biomédica y sus orígenes y tienen una gran relevancia clínica. • Los estudios transversales, también llamados estudios de prevalencia, tienen por objetivo evaluar la presencia de una enfermedad y de los factores de riesgo asociados en un mismo momento temporal.

BIBLIOGRAFÍA

1. Tilert T, Dillon C, Paulose-Ram R, Hnizdo E, Doney B. Estimating the U.S. prevalence of chronic obstructive pulmonary disease using pre- and post-bronchodilator spirometry: the National Health and

Nutrition Examination Survey (NHANES) 2007-2010. Respir Res. 2013;14:103. 2. Kim HJ, Fay MP, Feuer EJ, Midthune DN. Permutation tests for joinpoint regression with applications to cancer rates. Stat Med. 2000;19(3):335-351. 3. Hamman L, Rich AR. Fulminating Diff use Interstitial Fibrosis of the Lungs. Trans Am Clin Climatol

Assoc. 1935;51:154-163. 4. López-Campos JL, Tan W, Soriano JB. Global burden of COPD. Respirology. 2015. 5. López-Campos JL, Ruiz-Ramos M, Soriano JB. COPD mortality rates in Andalusia, Spain, 1975-2010: a joinpoint regression analysis. Int J Tuberc Lung Dis. 2013;17(1):131-136.

TABLAS Y FIGURAS

Figura 2.2.1. Ejemplo de estudio ecológico de mapas. La fi gura muestra la distribución de la mortalidad por EPOC en el mundo

Reproducido de López-Campos JL, et al. Respirology. 2015(4).

Figura 2.2.2. Ejemplo de estudio de serie temporal. La gráfi ca representa un análisis de regresión de joinpoint sobre la mortalidad por EPOC en Andalucía en hombres (A) y mujeres (B)

SMR: tasa de mortalidad estandarizada. TMR: tasa de mortalidad estandarizada y truncada para las edades entre 40 y 70 años. Reproducido de López-Campos JL, et al. Int J Tuberc Lung Dis. 2012(5).

2.3. ESTUDIOS ANALÍTICOS: COHORTES Y CASO-CONTROL

Dr. Joan B. Soriano Ortiz Dra. Patricia Pérez

INTRODUCCIÓN

Gran parte de la investigación biomédica es de tipo observacional. Al contrario de los ensayos clínicos, en que la calidad se da por supuesta, en la investigación observacional la calidad es a menudo insufi ciente, lo que difi culta la evaluación de sus puntos fuertes y débiles para la generalización de un estudio y su aplicación traslacional a los pacientes y a la salud general. Dentro de la sistemática de los diseños de estudio en investigación, los estudios observacionales no descriptivos y analíticos, que permiten probar hipótesis y estudiar causalidades, se clasifi can en:

• Estudios de cohorte: Siguen a lo largo del tiempo a un grupo de sujetos (cohorte) inicialmente libres de enfermedad midiendo en el momento de su exposición al factor de interés y estudiando la aparición posterior de la enfermedad. • Estudios de casos y controles, también llamados de caso-control: Comparan determinadas características (exposiciones) entre personas con la enfermedad (casos) y personas libres de la enfermedad (controles).

A continuación se repasan sucintamente las características y usos de cada uno.

ESTUDIOS DE COHORTE

También denominados estudios de seguimiento, de proyección o de incidencia. La palabra cohorte deriva del latín cohors, que era una unidad táctica del ejército romano formada por 480 hombres o legionarios, que marchaban juntos a la batalla. Diez cohortes, numeradas del I al X, constituían una legión romana. Durante el gobierno del emperador Augusto, el ejército romano totalizó 28 legiones. Es de interés repasar las distintas unidades: contubernio, 8 hombres; centuria, 10 contubernios (80 hombres); manípulo, 2 centurias (160 hombres); cohorte, 6 centurias (480 hombres); legión, 10 cohortes más 120 jinetes (5.240 hombres). Una vez entraban en una cohorte, liderada por seis centuriones, los soldados romanos podían cambiar de posición según su jerarquía y experiencia dentro de su cohorte, hasta que se licenciaban o morían.

Este mismo concepto se aplica a la cohorte en investigación clínica: un individuo sano o sin enfermedad/ evento de interés es reclutado en una cohorte y aporta información hasta que, voluntariamente, involuntariamente o por fallecimiento, abandona la cohorte.

En investigación epidemiológica y clínica, un estudio de cohortes es un estudio epidemiológico, observacional, analítico y longitudinal, prospectivo en el que compara la frecuencia de una enfermedad (o de un determinado desenlace) entre muestras de una población o entre dos o más poblaciones, una de las cuales está sometida a un determinado factor de exposición o factor de riesgo al que no está expuesta la otra. Los individuos que componen los grupos de estudio se seleccionan en función de la presencia de una determinada característica o exposición.

Estos individuos no tienen la enfermedad de interés y son seguidos durante un cierto periodo de tiempo para observar la frecuencia con que la enfermedad aparece en cada uno de los grupos. Los estudios de cohorte tienen por objetivo medir causalidad entre los factores de riesgo y la enfermedad a estudiar.

Proceso de un estudio de cohorte

El proceso para realizar un estudio de cohorte incluye las siguientes etapas:

• Seleccionar una muestra de estudio de individuos sanos de una población. El concepto sano se entiende en su acepción más amplia, y signifi ca que antes de iniciar el periodo de seguimiento los participantes no han experimentado la enfermedad o evento de interés. • Medir variables de exposición en la muestra, si el factor de riesgo está ausente o presente. • Seguir la cohorte. • Medir las variables de resultado, es decir, la presencia o ausencia de enfermedad. • Analizar mediante la estadística adecuada.

Ventajas de un estudio de cohorte

Un diseño de estudio de cohorte permite:

1. Estudiar factores de exposición extraños. 2. Visualizar los múltiples efectos (riesgos y benefi cios) que una exposición pueda tener. 3. Observar simultáneamente los efectos de varias exposiciones (siempre y cuando esta posibilidad sea planteada desde el principio del estudio). 4. Posibilitar la muestra de la secuencia temporal entre exposición y desenlace. 5. Permitir la estimación de incidencia y riesgo relativo. 6. Establecer claramente la secuencia de sucesos de interés, como es la de exposición-enfermedad. 7. Evitar el sesgo de supervivencia. 8. Tener mejor control sobre la selección de sujetos. 9. Tener mayor control de las medidas. 10. Tener movimiento.

Inconvenientes de un estudio de cohorte

Sin embargo, también deben considerarse sus potenciales limitaciones:

1. A menudo requiere grandes tamaños muestrales. 2. No es efi ciente en eventos raros o con largos períodos de latencia (tiempo transcurrido desde la exposición al evento).

3. Su ejecución puede requerir mucho tiempo y dinero. 4. No es útil para enfermedades raras (pues no hay sufi cientes sujetos). 5. Son estudios caros por la cantidad de personas y el tiempo de seguimiento necesarios, así como por los esfuerzos que han de llevarse a cabo para que la calidad del seguimiento minimice las pérdidas entre las poblaciones que se siguen, manteniéndolas en un nivel aceptable. 6. No se dispone de resultados hasta después de transcurrido mucho tiempo. 7. Sólo evalúan la relación entre el evento del estudio y la exposición a ciertos factores defi nidos y/o cuantifi cados al inicio del estudio.

Los estudios de seguimiento son los estudios prospectivos clásicos, caracterizados por el hecho de que el planteamiento del estudio y la medición de la exposición (o no exposición) se producen con anterioridad al desarrollo de la enfermedad. A pesar de que se trata de estudios muy costosos, pues requieren grandes recursos económicos y de tiempo, y de gran solidez, ya que la probabilidad de que estén sesgados es menor, hay que cuidar extremadamente los aspectos del diseño y evitar sesgos, especialmente de clasifi cación y el de los trabajadores sanos, entre otros.

Como alternativa, existe otro tipo de estudios de cohortes, el estudio de las cohortes retrospectivas, en que la investigación se plantea después de haberse producido la enfermedad, para lo cual tanto la presencia de exposición como el desenlace deben proceder de registros históricos o clínicos de alta fi abilidad en los que se hayan registrado con precisión en el momento de producirse.

En función de la existencia de medidas repetidas, se distinguen dos tipos de estudios de cohorte: estudios longitudinales y estudios sin medidas repetidas.

El estudio de cohorte perfecto no existe, y quizás sea literalmente imposible de conseguir.1 En una enfermedad crónica, asociada al envejecimiento y al tabaco, como la EPOC,2 o con aspectos ambientales, como el asma, sería quizás una versión ampliada al ámbito respiratorio del Estudio de Framingham3 lo que nos permitiera hacer lo que los cardiólogos ya han hecho. Además, se debe tener en cuenta el conocimiento (o la falta de conocimiento) de la genética y el origen precoz de las enfermedades de aparición tardía. Desde este punto de vista, un tanto ingenuo, el estudio de cohortes para explorar la historia natural de una enfermedad debe tener las siguientes características: ser grande; comenzar antes del nacimiento; incluir el seguimiento de por vida; incluir unos pocos cientos de páginas de formularios de encuestas, pruebas de función pulmonar estandarizadas y muchas otras, mediciones de biomarcadores (incluyendo imágenes) y medidas de exposición directa y, por supuesto, la genética y todas las “ómicas” (por ejemplo, la genómica, la proteómica, la metabolómica). Obviamente, no es una tarea fácil. Una alternativa podría ser la puesta en común de los resultados de estudios de historia natural individuales. Utilizando un enfoque metaanalítico, podría ser una solución parcial, positiva, como se ha propuesto en cohortes de nacimiento que estudian asma y atopia, y se está explorando actualmente para la función pulmonar y la EPOC. Como consecuencia, el estudio de cohortes ideal para investigar la historia natural de las enfermedades respiratorias crónicas podría consistir en múltiples estudios, cada uno de los cuales se dirigiría a responder una pregunta científi ca específi ca.

Existen cohortes de muy diversos orígenes y modelos a seguir. Una cohorte puede representar desde una muestra de la población general en un lugar determinado geográfi camente (p. ej., la cohorte de Framingham mencionada anteriormente) hasta un grupo de trabajadores pertenecientes a una industria o un grupo de pacientes con una exposición (p. ej., hipertensos tratados). Algunas cohortes seleccionan a individuos de los que se espera un alto grado de colaboración para minimizar las pérdidas y aumentar la calidad de los datos recogidos. Es el caso de la cohorte de enfermeras de la Universidad de Harvard o la cohorte de voluntarios de la Sociedad Americana del Cáncer. Existen cohortes que fueron establecidas hace años y cuyos miembros son objeto de un seguimiento regular. Aunque en su día fueron diseñadas para un estudio concreto, normal-

mente con el paso del tiempo sus usos se van ampliando y llegan a ser una valiosa fuente de datos para múltiples enfermedades. Otras cohortes que se han utilizado son las llamadas históricas (p. ej., supervivientes a la bomba atómica de Hiroshima). En SEPAR, las cohortes ya establecidas y de gran utilidad incluyen, entre otros, los trabajadores de tareas de rescate del Prestige4 y la cohorte de pacientes CHAIN.5

Análisis

La medida de asociación usada normalmente en los estudios de cohorte es el riesgo relativo (RR). Tal como se aprecia en la tabla 2.3.1, el análisis para un estudio de cohorte permite calcular la incidencia en cada grupo y el riesgo relativo en los expuestos en comparación con los no expuestos, de modo que riesgo relativo = (a/a+b)/(c/c+d).6

Si los tiempos de seguimiento son desiguales, sea por abandono, fallecimiento por una causa diferente al evento de estudio, fi nalización del periodo de estudio establecido en el protocolo u otros, una forma de compensarlo es realizar análisis basados en tiempo-persona o en el promedio de tiempo durante el que se ha seguido a los sujetos de la cohorte. Esto posibilita calcular la tasa de incidencia por una unidad de tiempo determinado, de modo que riesgo relativo = (a/tpe) / (c/tpne), donde tpe es el tiempo-persona de seguimiento de los sujetos expuestos y tpne es el tiempo-persona de seguimiento de los sujetos no expuestos.7 (Tabla 2.3.2)

ESTUDIO DE CASOS Y CONTROLES

Un estudio de casos y controles es un estudio epidemiológico, observacional, analítico, con seguimiento retrospectivo, en el cual los sujetos se seleccionan en función de que tengan (casos) o no tengan (controles) una determinada enfermedad o, en general, un determinado evento. Una vez seleccionados los individuos de cada grupo, se investiga si estuvieron expuestos o no a una característica de interés y se compara la proporción de expuestos en el grupo de casos con la del grupo de control.

Tipos de estudio de casos y controles

Estudio de casos y controles retrospectivos: Todos los casos han sido diagnosticados antes del inicio del estudio.

Estudio de casos y controles prospectivos: Los casos son diagnosticados con posterioridad al inicio del estudio, y así pueden incluirse los nuevos casos detectados durante un cierto tiempo establecido previamente.

Estudio de casos y controles de base poblacional: Combina elementos del estudio de cohorte y de casos y controles. Se sigue a un grupo de individuos hasta que aparezca la enfermedad de interés, de igual forma que en el estudio de cohortes. Estos casos se comparan con un grupo control, cuyos componentes pertenecen a la misma población. Una vez obtenidos todos los casos y controles, se analiza el tipo de exposición previa o actual, como en un estudio de casos y controles. Este tipo de estudio es recomendable para enfermedades raras, puesto que un sujeto inicialmente identifi cado como control podría desarrollar el evento de interés durante el tiempo de seguimiento y ser seleccionado como caso, lo que pone en peligro el valor estadístico del estudio.

Estudio de casos y controles anidados: Es un estudio caso-control en el cual tanto los casos como los controles son tomados de la población que participa en un estudio de cohortes. Como los datos de esta población se obtienen a lo largo del tiempo, se reduce la posibilidad de sesgos de selección e información, que son comunes en los diseños caso-control. Es decir, no se genera sesgo porque el sujeto puede pasar de control a caso si desarrolla el evento de estudio.

Proceso de un estudio de casos y controles

El proceso empieza seleccionando una muestra de población con la enfermedad o problema de estudio. A estos individuos se les llama casos. A continuación se selecciona una muestra de la población de riesgo que no presenta enfermedad, que será el grupo control. Finalmente, se miden las variables predictoras, que son los factores de riesgo.

Ventajas de los estudios de casos y controles

Los diseños de estudio de casos y controles:

1. Estudian eventos raros o enfermedades y también enfermedades con un largo periodo de latencia; además, pueden ser un estudio preliminar para conocer la asociación entre un factor de riesgo y una determinada enfermedad. 2. Permiten estudiar muestras relativamente pequeñas. 3. Requieren tiempos cortos de ejecución en comparación con los estudios de cohortes prospectivos. 4. Son relativamente baratos comparados con los estudios de cohortes (aunque los de diseño de base poblacional suelen ser más caros). 5. Determinan la odds ratio. 6. Evalúan muchos factores de riesgo para una enfermedad o suceso.

Inconvenientes de los estudios de casos y controles

De nuevo, también deben considerarse sus potenciales limitaciones:

1. 1Son inefi cientes para el estudio de efectos de exposición raros, para los que es preferible considerar un estudio de cohorte. 2. No establecen la secuencia de eventos de interés, lo que difi culta la recogida de información fi able sobre el estado de la exposición del sujeto al evento de estudio en el tiempo. 3. Pueden incurrir en posibles errores de selección de casos y controles por la difi cultad para conseguir un grupo de comparación adecuado que cumpla los criterios de Hill.8-9 Este sesgo es menor en el diseño de base poblacional. 4. Pueden dar posibles sesgos de supervivencia. 5. Sólo pueden estudiar una variable de resultado (enfermedad). 6. No proporcionan estimadores de prevalencia, incidencia o riesgo atribuible. (En el diseño de base poblacional sí se puede estimar la incidencia.) 7. Son inapropiados cuando el resultado de interés no se conoce al comienzo del estudio o cuando el resultado es una variable continua.

Algunos ejemplos de estudios de casos y controles son: el estudio de las causas de las epidemias por aceite de colza y síndrome del aceite tóxico,10 el asma de soja en Barcelona,11 las neumonías y el síndrome Ardistyl.12

Análisis

La medida de asociación usada normalmente en los estudios de caso-control es la razón de probabilidades, habitualmente denominada odds ratio (OR) (Tabla 2.3.1). Un estudio de caso-control no permite calcular ni la incidencia ni el RR, pero sí permite calcular la odds ratio como medida de asociación, de la siguiente manera: 1º odds entre los expuestos = a/b; 2º odds ratio entre los no expuestos = c/d; y 3º odds ratio = (a/b)/ (c/d)= ad/bc. Esta medida, en el caso concreto de los estudios “anidados”, es siempre un estimador válido del riesgo relativo que se habría obtenido en un estudio de cohortes. Mas allá de la deducción matemática de esta propiedad de las OR, varios estudios han demostrado esto empíricamente. De lo cual se deduce que

los resultados en un estudio de casos y controles “anidados” son virtualmente los mismos que los obtenidos en el correspondiente estudio de cohortes.

Finalmente, debe mencionarse la iniciativa STROBE13 (siglas de Strengthening the Reporting of Observational Studies in Epidemiology, en español Fortalecimiento de la Presentación de estudios observacionales en epidemiología), que tanto para los estudios de cohorte o de casos y controles, como para el resto de estudios observacionales pretende incrementar la calidad de su realización, informe e interpretación. STROBE ha desarrollado recomendaciones sobre lo que debería incluirse en un informe preciso y completo de un estudio observacional en las tres grandes modalidades de estudio: de cohortes, de casos y controles y transversales. Se desarrolló un listado de 22 elementos (la declaración STROBE) que se relacionan con el título, resumen, introducción, métodos, resultados y discusión de los artículos. Por ejemplo, la obtención de muestra de estudio fi nal debe poder reconstruirse con un diagrama de fl ujo de participantes (Figura 2.3.1), semejante al estándar CONSORT de un ensayo clínico. En particular, 18 puntos son comunes a los tres diseños de estudio y cuatro son específi cos para la cohorte, casos y controles, o estudios transversales.14 Se estima que la declaración STROBE contribuye a mejorar la calidad de los informes de los estudios observacionales. STROBE también está disponible en castellano.15

INTERPRETACIÓN

Los investigadores clínicos que tengan capacidad para integrar información de diferentes disciplinas y puedan realizar o interpretar los resultados de estudios epidemiológicos con diseño de cohortes o caso-control, entre otros, y que también puedan interactuar con otros investigadores básicos y clínicos, junto con matemáticos y bioinformáticos, tendrán ventajas añadidas al aplicar su investigación a todos los niveles. Sólo se necesita una receta de éxito para superar con creces estos nuevos desafíos: monitorizar las tendencias de las enfermedades y sus determinantes mediante la epidemiología llamada de “suela de zapato”,16-17 es decir, la epidemiología clásica, quizás complementada por Big Data y otras nuevas tecnologías,18 como la inteligencia artifi cial. La implementación de herramientas como las descritas recientemente será de gran ayuda.19-21

Esta nueva frontera en la investigación médica será probablemente más efi ciente y potencialmente más precisa. El uso de información de las historias clínicas, en papel o en versión digital, combinadas con el texto de los informes de radiología, bioquímica, función pulmonar u otras variables fi siológicas, no es ni sencillo ni directo.20-21 Superar estos desafíos conjugando algoritmos de inteligencia artifi cial y aprendizaje de máquinas (machine learning), con el reconocimiento del texto libre con la tecnología de procesamiento de lenguaje natural (NLP por sus siglas en inglés) dará una verdadera “nueva vida” a los datos recogidos en las historias clínicas, que el sistema de atención médica recopila por defecto, y las oportunidades que surgen de su reutilización pueden ser más que atractivas.22-24

Para concluir, la tabla 2.3.3 resume las ventajas e inconvenientes de los estudios de casos y controles frente a los estudios de cohortes.

PUNTOS CLAVE

• Los estudios de cohorte y los de casos y controles constituyen dos tipos de estudios observacionales, no descriptivos y analíticos. • Ambos diseños de estudio son similares a pesar de usar métodos y estrategias analíticas diferentes. • La diferencia fundamental entre estos dos tipos de estudios radica en el método de selección de los sujetos de estudio, que en los primeros se basa en el grado de exposición, y en los segundos, en el evento de interés. • Estos estudios representan una alternativa válida a los estudios experimentales. No obstante, debido a su mayor complejidad y a su mayor vulnerabilidad a los diferentes sesgos, se requiere un conocimiento avanzado en el campo de la metodología y el análisis epidemiológico para poder utilizarlos sin que lleven a resultados erróneos o de difícil interpretación. • Los estudios observacionales, de cohorte y de casos y controles son fundamentales para generar hipótesis de causalidad, que idealmente deben confi rmarse en ensayos clínicos controlados.

BIBLIOGRAFÍA

1. Kohansal R, Soriano JB, Agusti A. Investigating the natural history of lung function: facts, pitfalls, and opportunities. Chest. 2009;135:1330-1341. 2. Mannino DM, Watt G, Hole D, et al. Th e natural history of chronic obstructive pulmonary disease. Eur

Respir J. 2006;27:627-643. 3. Kannel WB, Feinleib M, McNamara PM, et al. An investigation of coronary heart disease in families: the

Framingham off spring study. Am J Epidemiol. 1979;110:281-290. 4. Zock JP, Rodríguez-Trigo G, Pozo-Rodríguez F, Barberà JA. Health eff ects of oil spills: lessons from the

Prestige. Am J Respir Crit Care Med. 2011;184:1094-1096. 5. López-Campos JL, Peces-Barba G, Soler-Cataluña JJ, Soriano JB, De Lucas Ramos P, De-Torres JP, Marín JM, Casanova C (en nombre del grupo de estudio CHAIN). Chronic obstructive pulmonary disease history assessment in Spain: a multidimensional chronic obstructive pulmonary disease evaluation.

Study methods and organization. Arch Bronconeumol. 2012;48:453-459. 6. De Stavola BL, Nitsch D, Silva ID, et al. Statistical issues in life course epidemiology. Am J Epidemiol. 2006;163:84-96. 7. LAZCANO-PONCE E, FERNANDEZ E, SALAZAR-MARTINEZ E, HERNANDEZ-AVILA M. Estudios de cohorte. Metodología, sesgos y aplicación. Salud pública Méx [online]. 2000, vol. 42, n.3, pp. 230-241. ISSN 0036-3634. http://dx.doi.org/10.1590/S0036-36342000000300010. 8. Hill AB. “Th e Environment and Disease: Association or Causation?”, en Proceedings of the Royal Society of Medicine, 1965;58:295-300. 9. Delgado M, Llorca J, Doménech JM. Investigación científi ca: Fundamentos metodológicos y estadísticos. Barcelona, Signo; 5ª ed., 2012. 10. Posada de la Paz M, Philen RM, Borda AI. Toxic oil syndrome: the perspective aft er 20 years. Epidemiol

Rev. 2001;23:231-247. 11. Sunyer J, Antó JM, Rodrigo MJ, Morell F. Case-control study of serum immunoglobulin-E antibodies reactive with soybean in epidemic asthma. Lancet. 1989;1:179-182. 12. Solé A, Cordero PJ, Morales P, Martínez ME, Vera F, Moya C. Epidemic outbreak of interstitial lung disease in aerographics textile workers -the “Ardystil syndrome”: a fi rst year follow up. Th orax. 1996;51:9495. 13. Vandenbroucke JP, Von Elm E, Altman DG, Gøtzsche PC, Mulrow CD, Pocock SJ, Poole C, Schlesselman JJ, Egger M; STROBE initiative Strengthening the Reporting of Observational Studies in Epidemiology (STROBE): explanation and elaboration. Ann Intern Med. 2007;147:163-194. 14. http://www.strobe-statement.org/index.php?id=available-checklists [acceso el 21 de dic. de 15]. 15. Von Elm E, Altman DG, Egger M, Pocock SJ, Gøtzsche PC, Vandenbroucke JP; Iniciativa STROBE.

Declaración de la Iniciativa STROBE (Strengthening the Reporting of Observational studies in Epidemiology): directrices para la comunicación de estudios observacionales. Gac Sanit. 2008;22:144-150. 16. Koo D, Th acker SB. In Snow’s Footsteps: Commentary on Shoe-Leather and Applied Epidemiology. Am

J Epidemiol. 2010;172:737-739. 17. Tong SY. Genomic polish for shoe-leather epidemiology. Nat Rev Microbiol. 2013;11(1):8. 18. Gené Badia J, Gallo de Puelles P, De Lecuona I. Big data y seguridad de la información. Aten Primaria. 2018;50(1):3-5. 19. Johnston IG, Hoff mann T, Greenbury SF, Cominetti O, Jallow M, Kwiatkowski D, Barahona M, Jones

NS, Casals-Pascual C. Precision identifi cation of high-risk phenotypes and progression pathways in severe malaria without requiring longitudinal data. NPJ Digit Med. 2019;10:2:63. 20. Divita G, Carter M, Redd A, Zeng Q, Gupta K, Trautner B, Samore M, Gundlapalli A. Scaling-up NLP

Pipelines to Process Large Corpora of Clinical Notes. Methods Inf Med. 2015;54(6):548-552.

21. MacRae J, Darlow B, McBain L, Jones O, Stubbe M, Turner N, Dowell A. Accessing primary care Big

Data: the development of a soft ware algorithm to explore the rich content of consultation records. BMJ

Open. 2015;5(8):e008160. 22. Hernández-Medrano I, Carrasco G. El profesional de la salud ante el mundo del Big Data. Rev Calid

Asist. 2016;31(5):250-253.

TABLAS Y FIGURAS

Tabla 2.3.1. Tabla de 2x2 y su análisis

Expuestos

No expuestos Enfermos No enfermos

a b a+b

c d Prueb

a+b b+d N

Análisis para un estudio de cohorte:

Permite calcular la incidencia en cada grupo y el riesgo relativo en los expuestos respecto a los no expuestos Riesgo relativo = (a/a+b)/(c/c+d) Incidencia en el grupo de expuestos: a/(a+b) Incidencia en el grupo de no expuestos: c/(c+d) Diferencia de incidencia acumulada: a/(a+b) – c/(c+d) (Si la exposición es protectora, se calcula al revés: c/(c+d) - a/(a+b) )

Análisis para un estudio caso-control:

No permite calcular la incidencia ni el RR, pero sí permite calcular la odds ratio como medida de asociación. Odds entre los expuestos = a/b Odds entre los no expuestos = c/d Odds ratio = (a/b)/(c/d) = ad/bc

Tabla 2.3.2. Principales diseños de estudios en Epidemiología

Usos

Unidad de análisis

Temporalidad

Ventajas

Inconvenientes

Ejemplo Ensayos clínicos Estudios transversales Estudios de casos y controles Estudios de cohorte

Comparar tratamientos (preventivos o terapéuticos) Investigar la prevalencia de enfermedades Estudiar la relación de las enfermedades con exposiciones “fi jas” de los individuos (sexo, raza…) Generar hipótesis Estudiar los factores de riesgo de una enfermedad Evaluar las intervenciones terapéuticas Identifi car las causas de epidemias Estudiar factores de riesgo de las enfermedades Establecer tasas de incidencia Estudiar la historia natural de las enfermedades Establecer pronóstico

Individuo Individuo/grupo Individuo Individuo

Prospectivos Retrospectivos Retrospectivos Prospectivos o retrospectivos

“Libres” de sesgos mayormente Económicos, rápidos y sencillos Permiten estudiar diferentes exposiciones y enfermedades al mismo tiempo Habitualmente representan a la población general Económicos, rápidos y sencillos Permiten estudiar diversas exposiciones de una enfermedad Útiles para enfermedades raras Conceptualmente sencillos Permiten estudiar todos los efectos asociados a una exposición

No permiten probar hipótesis etiológicas No permiten hacer inferencias causales (¿un factor es causa o efecto?) Sólo identifi can casos prevalentes (no incidentes) de enfermedad Sólo permiten estudiar un efecto asociado a una o más exposiciones Susceptibles de error de medida (evaluación retrospectiva de los factores de exposición) y de sesgo de selección Costosos y lentos (requieren largos períodos) Poco útiles para enfermedades raras o con largos períodos de latencia

Medical Research Council Working Party. Long term domiciliary oxygen therapy in chronic hypoxic cor pulmonale complicating chronic bronchitis and emphysema. Lancet 1981;1):681-6.

Objetivo: Estudiar la efectividad de la oxigenoterapia crónica do miciliaria en pacientes respiratorios crónicos. Diseño y sujetos: Ensayo clínico. Pacientes (n=87) con bronquitis crónica o enfi sema con obstrucción irreversible del fl ujo aéreo, insufi ciencia respiratoria e insufi ciencia cardíaca congestiva, aleatorizados a grupo tratamiento (oxígeno domicilario mínimo 15h/d) o control (no oxígeno). Resultados: Tras 5 años de seguimiento, murieron el 45% de los sujetos en el grupo tratamiento y el 67% en el grupo control. No se observaron diferencias en los días de estancia hospitalaria o de ausencia laboral.

Sobradillo V, Miravitlles M, Jimenez CA, Gabriel R, Viejo JL, Masa JF, Fernandez-Fau L, Villasante C. [Epidemiological study of chronic obstructive pulmonary disease in Spain (IBERPOC): prevalence of chronic respiratory symptoms and airfl ow limitation] Arch Bronconeumol 1999;35:159-66.

Objetivo: Estudiar la prevalencia de síntomas respiratorios crónicos y limitación crónica al fl ujo aéreo en España. Diseño y sujetos: Estudio transversal en 7 áreas españolas. Selección de una muestra aleatoria poblacional de más de 4000 sujetos entre 40 y 69 años a partir del censo. Resultados: Se encontraron las siguientes prevalencias: síntomas respiratorios crónicos 48% (IC 95%:46.4-49.5), bronquitis crónica 4.8% (4.15.4), asma 4.9% (4.2-5.5), limitación crónica al fl ujo aéreo 10.6 (9.6-11.5). Excepto el asma, todos los trastornos fueron más frecuentes en hombres que en mujeres y en fumadores o exfumadores que en no-fumadores. Se encontraron diferencias geográfi cas importantes entre áreas.

Teran-Santos J, Jimenez-Gomez A, Cordero-Guevara J. Th e association between sleep apnea and the risk of traffi c accidents. Cooperative Group Burgos-Santander. N Engl J Med 1999;340:847-51.

Objetivo: Estudiar la relación entre apnea del sueño y accidentes de tráfi co. Diseño y sujetos: Casos y controles. Casos: 102 conductores visitados en urgencias tras accidentes de tráfi co. Controles: 152 sujetos seleccionados al azar a partir de atención primaria de la misma zona geográfi ca, apareados por sexo y edad. Resultados: Los sujetos con índice de apnea-hipopnea igual o mayor a 10 mostraron una razón de odds de 6.3 (IC 95%: 2.4-16.2) de tener un accidente de tráfi co, independiente de confusores como ingesta de alcohol, consumo de fármacos u otros.

Doll R, Peto R. Mortality in relation to smoking: 20 years’ observations on male British doctors. Br Med J 1976;2:1525-36.

Objetivo: Estudiar la relación entre el hábito tabáquico y la mortalidad. Diseño y sujetos: Cohorte de más de 34000 hombres que respondieron en 1951 un cuestionario sobre tabaco y fueron seguidos durante 20 años. Resultados: La razón de riesgo de morir en los fumadores respecto a los no fumadores de la misma edad fue de 2. Las causas de muerte asociadas al tabaco fuer on enfermedad cardíaca, cáncer de pulmón, enfermedad pulmonar obstructiva crónica y enfermedades vasculares.

Tabla 2.3.3. Pros y contras de los estudios de casos y controles frente a los de cohortes

Características Casos y controles Cohortes

Conocer historia natural enfermedad Mal Bien Planifi cación Mejor en prospectivos Bien Incidencia No (sí en híbridos) Sí Cálculo de riesgos Parcial Todos Valoración de exposición Tras efecto Mejor, sobre todo si hay cambios en el tiempo Multiefectividad No Sí Sesgos Muchos Pocos Infl uencia de la mortalidad Difícil de estudiar Más fácil Control de calidad de la información Más difícil Más fácil

Exposiciones raras No Sí Enfermedades raras Sí No Coste Variable (menor que las cohortes prospectivas) Variable (en general más caros)

Tiempo Menor que las cohortes prospectivas

Mayor en las cohortes prospectivas Reproducibilidad Alta Escasa (prospectivos) Intervención No Sí, aunque discreta Cantidad de personal Depende Depende Pérdidas No Sí Riesgo de obsoleto Bajo Mayor Como exploratorios Sí No Asociaciones débiles entre exposición y respuesta No Sí Comprensibilidad Baja Alta

Figura 2.3.1. Ejemplo de diagrama de fl ujo STROBE (adaptado de referencia 12)

Dra. Carmen Fuentelsaz Gallego

INTRODUCCIÓN

Los estudios experimentales, también llamados estudios de intervención, son estudios de tipo analítico que permiten conocer la relación entre la variable independiente (la intervención que se realiza) y la o las dependientes (las principales variables de resultado, que son las que se verán afectadas por la intervención). La principal diferencia entre ambos tipos es que en los estudios experimentales se realiza una intervención, mientras que en los estudios observacionales sólo se observan determinadas características de los sujetos de estudio (Figura 2.4.1).

En los estudios experimentales hay, al menos, una intervención (o manipulación), puede haber un grupo control y uno experimental, y una asignación aleatoria a ambos grupos.

Son realmente experimentales cuando hay una intervención, grupo control y experimental y asignación aleatoria a ambos grupos. Se consideran cuasi experimentales cuando no hay grupo control y experimental o, en caso de que los haya, cuando la asignación a ambos grupos no se realiza de forma aleatoria.

ESTUDIOS EXPERIMENTALES

Características

Los estudios experimentales (también llamados ensayos clínicos) son de tipo prospectivo, es decir, se hace un seguimiento de los sujetos de estudio para ver el efecto de la intervención.1-3 Por tanto, el objetivo de estos estudios es conocer si una intervención es más efi caz o efectiva que otra. Esto es, cuando se plantea una hipótesis de superioridad, pero también se pueden plantear hipótesis de no inferioridad o de equivalencia.4

El esquema de un estudio experimental se presenta en la fi gura 2.4.2. Como cualquier otro tipo de estudio, se inicia defi niendo las características de la población de referencia mediante los criterios de selección, es decir, los criterios de inclusión y los de exclusión, que deben estar claramente determinados. En estos estudios, los criterios de selección suelen ser muy estrictos, sobre todo en los ensayos clínicos con medicamentos, lo que puede perjudicar su validez externa.

Si la población de referencia es demasiado grande, por lo que no es pertinente estudiarla toda, se seleccionará una muestra de sujetos, que serán los que realmente se estudiarán. Para ello, se debe estimar el tamaño de muestra necesario para poder valorar el efecto de la intervención en la variable principal de resultado y se debe determinar la técnica de muestreo a utilizar.

Cabe señalar la diferencia entre la técnica de muestreo aleatoria y la asignación aleatoria a los grupos control y experimental, ya que a veces son términos que se confunden.

La técnica de muestreo es la que se utiliza para seleccionar la muestra de la población de referencia. En los estudios experimentales no se suele utilizar una técnica de muestreo aleatoria (aunque sería lo ideal), y generalmente se utiliza un muestreo consecutivo, incluyendo a los sujetos a medida que van ingresando en el hospital o acuden a la consulta.

La asignación es la forma en que se decide si los sujetos de estudio se incluyen en el grupo control o en el grupo experimental. Esta asignación debe ser aleatoria, es decir, al azar, de forma que cualquier sujeto tenga la misma probabilidad de formar parte del grupo control que del grupo experimental. Lo más habitual es utilizar programas estadísticos para hacer la asignación, mediante la generación de números aleatorios.