CHIMIE Quels procédés pour la transition énergétique ?

Archéologie LA ZÉROIÈME DYNASTIE ÉGYPTIENNE Art et science LE SECRET DE « LA DAME À L’HERMINE »

Biologie évolutive L’ESPÈCE HUMAINE, ACCÉLÉRATEUR DE LA SÉLECTION NATURELLE ?

CHIMIE Quels procédés pour la transition énergétique ?

Archéologie LA ZÉROIÈME DYNASTIE ÉGYPTIENNE Art et science LE SECRET DE « LA DAME À L’HERMINE »

Biologie évolutive L’ESPÈCE HUMAINE, ACCÉLÉRATEUR DE LA SÉLECTION NATURELLE ?

Avec les réseaux de tenseurs, les ordinateurs classiques reviennent dans la course

MENSUEL POUR LA SCIENCE

Rédacteur en chef : François Lassagne

Rédacteurs en chef adjoints : Loïc Mangin, Marie-Neige Cordonnier

Rédacteurs : François Savatier, Sean Bailly

Stagiaire : Caroline Barathon

HORS-SÉRIE POUR LA SCIENCE

Rédacteur en chef adjoint : Loïc Mangin

Développement numérique : Philippe Ribeau-Gésippe

Directeur marketing et développement : Frédéric-Alexandre Talec

Chef de produit marketing : Ferdinand Moncaut

Directrice artistique : Céline Lapert

Maquette : Pauline Bilbault, Raphaël Queruel, Ingrid Leroy, Ingrid Lhande

Réviseuses : Anne-Rozenn Jouble, Maud Bruguière et Isabelle Bouchery

Assistante administrative : Finoana Andriamialisoa

Directrice des ressources humaines : Olivia Le Prévost

Fabrication : Marianne Sigogne et Stéphanie Ho

Directeur de la publication et gérant : Nicolas Bréon

Ont également participé à ce numéro :

Marie Diquelou, Clémentine Laurens, Guy Libourel, Martin Renoult, Malvyne Rolli-Derkinderen, Pierre Tallet, Camille Testard

PUBLICITÉ France

stephanie.jullien@pourlascience.fr

ABONNEMENTS https://www.pourlascience.fr/abonnements/ Courriel : serviceclients@groupepourlascience.fr

Tél. : 01 86 70 01 76

Du lundi au vendredi de 8 h 30 à 12 h 30 et de 13 h 30 à 16 h 30

Adresse postale : Service abonnement groupe Pour la Science 20 rue Rouget-de-Lisle 92130 Issy-les-Moulineaux.

Tarif d’abonnement Formule Intégrale 1 an (12 numéros du magazine + 4 numéros Hors-Série + accès au site) : 99 euros

Europe / Reste du monde : consulter https://www pourlascience fr/abonnements/ DIFFUSION

Contact réservé aux dépositaires et diffuseurs de presse – TBS SERVICES

Tél : 01 40 94 22 23

DISTRIBUTION

MLP

ISSN 0 153-4092

Commission paritaire n° 0927K82079 Dépôt légal : 5636 – Septembre 2024 N° d’édition : M0770563-01 www.pourlascience.fr 170 bis boulevard du Montparnasse – 75 014 Paris Tél. 01 55 42 84 00

SCIENTIFIC AMERICAN

Editor in chief : Laura Helmuth

President : Kimberly Lau

2024. Scientific American, une division de Springer Nature America, Inc. Soumis aux lois et traités nationaux et internationaux sur la propriété intellectuelle. Tous droits réservés. Utilisé sous licence. Aucune partie de ce numéro ne peut être reproduite par un procédé mécanique, photographique ou électronique, ou sous la forme d’un enregistrement audio, ni stockée dans un système d’extraction, transmise ou copiée d’une autre manière pour un usage public ou privé sans l’autorisation écrite de l’éditeur. La marque et le nom commercial «Scientific American» sont la propriété de Scientific American, Inc. Licence accordée à «Pour la Science SARL». © Pour la Science SARL, 170 bis bd du Montparnasse, 75014 Paris. En application de la loi du 11 mars 1957, il est interdit de reproduire intégralement ou partiellement la présente revue sans autorisation de l’éditeur ou du Centre français de l’exploitation du droit de copie (20 rue des Grands-Augustins, 75006 Paris).

Origine du papier : Autriche Taux de fibres recyclées : 30 %

« Eutrophisation » ou « Impact sur l’eau » : Ptot 0,007 kg/tonne

Imprimé en France

Maury Imprimeur SA Malesherbes

N° d’imprimeur : 279 490

François Lassagne Rédacteur en chef

a physique » voudrait trouver la théorie ultime, faire se rejoindre la mécanique quantique et la théorie de la relativité, mais n’y parvient pas. À défaut d’une théorie englobante, pour des problèmes concrets, un autre chemin est envisageable : partir des équations de la mécanique quantique pour calculer le comportement de n’importe quel système physique. Sauf que c’est impossible : les calculs nécessaires sont bien trop longs, même pour des systèmes physiques très simples. C’est ce que les physiciens appellent le « problème à N corps quantique ».

En 2019, l’équipe de John Martinis, chez Google, accomplissait avec un prototype d’ordinateur quantique (Sycamore) une tâche bien plus modeste, mais suffisante pour que les chercheurs y voient la marque de la suprématie quantique (définie en 2012 par le physicien de Caltech John Preskill), c’est-à-dire l’exécution par une machine quantique d’un calcul qu’un ordinateur classique est incapable de conduire en un temps raisonnable. Pourtant, par la suite, d’autres équipes sont parvenues au même résultat que Sycamore, avec des ordinateurs classiques… et le recours à des algorithmes de compression démultipliant leurs capacités de calcul : les réseaux de tenseurs.

Un débat s’est installé entre physiciens : où placer le seuil de la suprématie quantique ? Un autre débat l’a suivi, sur la place publique, autour du mot « suprématie ». Fallait-il remplacer ce mot, trop connoté, accaparé par les « suprémacistes blancs », comme y insistèrent certains, en particulier aux États-Unis, et privilégier « avantage » ou « primauté » ? Fallait-il au contraire éviter le piège des interprétations politiques, conserver le terme en usage dans la communauté des physiciens ?

Nous avons choisi de donner la primauté à la physique – les phénomènes, les expériences et la logique nous intéressent ici davantage que la sémantique –, et de conserver le terme qu’emploient régulièrement les chercheurs travaillant sur le problème à N corps quantique. Un problème dont le physicien Antoine Tilloy estime, dans ce numéro, qu’il est « l’obstacle majeur qui empêche le réductionnisme de passer d’un triomphe théorique à un triomphe pratique ».

Les réseaux de tenseurs s’affirment aujourd’hui comme un outil puissant pour lever cet obstacle, dotant les ordinateurs classiques de capacités de calcul inespérées. Au passage, ils améliorent, aussi, les performances des ordinateurs quantiques. La suprématie quantique n’a pas fini de faire parler d’elle. n

P. 6

ÉCHOS DES LABOS

• Le meilleur chemin pour visiter un quasi-cristal

• H5N1 : faut-il s’inquiéter du saut d’espèce ?

• La formation des yardangs et du Sphinx simulée

• Il y a 21 000 ans, le Gulf Stream était plus puissant

• Désactiver les gènes des maladies à prions

P. 16

LES LIVRES DU MOIS

P. 18

DISPUTES

ENVIRONNEMENTALES

Objection à l’obstruction

Catherine Aubertin

P. 20

LES SCIENCES À LA LOUPE

En couverture :

© Yurchanka Siarhei/Shutterstock

Les portraits des contributeurs sont de Seb Jarnot

Ce numéro comporte un courrier de réabonnement posé sur le magazine sur une sélection d’abonnés.

Les limites des évaluations à l’aveugle

Yves Gingras

P. 84

ART & SCIENCE

Le secret de « La Dame à l’hermine » Loïc Mangin

P. 88

IDÉES DE PHYSIQUE

Que d’eau, que d’o… ptique

Jean-Michel Courty et Édouard Kierlik

P. 32

ÉCOLOGIE

L’ESPÈCE HUMAINE, ACCÉLÉRATEUR DE LA SÉLECTION

NATURELLE ?

Lee Alan Dugatkin

Les activités humaines ne modifient pas seulement l’environnement dans lequel vivent les espèces Elles modifient les espèces elles-mêmes, et influencent la sélection naturelle.

P. 46

ARCHÉOLOGIE

LETTRE D’INFORMATION

NE MANQUEZ PAS

LA PARUTION DE VOTRE MAGAZINE

GRÂCE À LA NEWSLETTER

• Notre sélection d’articles

• Des offres préférentielles

• Nos autres magazines en kiosque

Inscrivez-vous www.pourlascience.fr

P. 92

CHRONIQUES DE L’ÉVOLUTION

Le coup d’avance du coucou

Hervé Le Guyader

P. 96

SCIENCE & GASTRONOMIE

Le fin mot du risotto

Hervé This

P. 98 À PICORER

LA ZÉROIÈME DYNASTIE ÉGYPTIENNE

Joachim Willeitner

Qui a fondé le royaume égyptien ? Seule certitude : plus de 3 000 ans avant notre ère, le Sud a subjugué le Nord en quelques siècles, pendant lesquels des régentes ont contribué à mettre en place les traditions pharaoniques, ensuite immuables

P. 40

ASTROPHYSIQUE

LES RÉSULTATS

PROMETTEURS D’OSIRIS-REX

Robin George Andrews

La mission spatiale a rapporté sur Terre des échantillons de la surface de l’astéroïde Bennu. Les analyses préliminaires livrent déjà certains de leurs secrets

P. 54

ÉGYPTOLOGIE

« L’UNIFICATION A D’ABORD ÉTÉ

UN PROCESSUS DE PROPAGATION

CULTURELLE »

Entretien avec Béatrix Midant-Reynes

Les élites de Haute-Égypte de l’âge du Cuivre ont inventé un État responsable de la bonne marche de la société et du cosmos, moteur culturel qui a unifié le pays

PHYSIQUE THÉORIQUE

Antoine Tilloy

Pour certains problèmes, les ordinateurs quantiques étaient supposés s’imposer face à leurs concurrents classiques au point d’atteindre une forme de suprématie. Mais grâce à une méthode efficace de compression des données, ces derniers n’ont pas dit leur dernier mot !

MÉDECINE

CANCER DE LA PROSTATE : DES TRAITEMENTS

POUR TOUS LES STADES

Marc B. Garnick

Grâce à l’imagerie de pointe et à des protocoles affinés, le diagnostic de la maladie et la prise en charge des patients se sont considérablement améliorés ces dernières années, même pour les formes les plus avancées de la maladie.

SCIENCE ET FICTION

SIMULATION TOTALE : LA THÈSE DE L’ILLUSION SE PRÉCISE

Jean-Paul Delahaye

De récents travaux reprennent et affinent les raisonnements du philosophe suédois Nick Bostrom, qui, il y a vingt ans, estimait probable que notre réalité soit en fait une simulation informatique menée par une civilisation avancée.

P. 62

CHIMIE

« LE DÉFI EST D’ALIMENTER SANS PÉTROLE NI GAZ

LA PART NON ÉLECTRIFIABLE DE NOS USAGES »

Entretien avec Marc Fontecave

Carburants issus du CO2, production d’hydrogène… Les chercheurs développent de nombreux procédés évitant l’emploi du gaz et du pétrole La plupart dépendent d’une production accrue d’électricité affranchie des énergies fossiles.

HISTOIRE DES SCIENCES

« JE REVIENS AU VRAI MESMER, CELUI DU XVIIIe SIÈCLE »

Entretien avec Bruno Belhoste

Qui était Franz Anton Mesmer, ce médecin allemand qui fit sensation avec ses cures magnétiques, fondées sur la circulation d’un fluide universel ? Une nouvelle biographie présente son vrai visage. Rencontre avec son auteur

Pour certains problèmes, les ordinateurs quantiques étaient supposés s’imposer face à leurs concurrents classiques au point d’atteindre une forme de suprématie. Mais grâce à une méthode efficace de compression des données, ces derniers n’ont pas dit leur dernier mot !

ANTOINE TILLOY

L’ESSENTIEL

> Les réseaux de tenseurs sont un concurrent sérieux des ordinateurs quantiques sur certains types de calculs en lien avec le problème quantique à N corps.

> Ces algorithmes compriment la représentation de la fonction d’onde qui décrit le système étudié. Ils réduisent ainsi

Lle nombre de paramètres utilisés pour pouvoir stocker l’information dans la mémoire d’un ordinateur standard.

> Ces algorithmes ont résolu les problèmes intéressants en une dimension et continuent de progresser pour les cas en 2D et en 3D.

e 23 octobre 2019, Google marque les esprits dans la course à l’ordinateur quantique en annonçant avoir atteint la « suprématie quantique » (aussi nommé « avantage quantique »). D’un point de vue expérimental, l’équipe de John Martinis a réalisé un tour de force incontestable : elle a réussi à opérer de façon cohérente 53 qubits supraconducteurs du processeur quantique Sycamore . Ce dernier, refroidi à moins de 20 millikelvins ( une température 100 fois plus faible que celle du vide intersidéral), a été contrôlé grâce à des exploits d’ingénierie microonde. L’équipe a alors utilisé ce protoordinateur quantique pour faire de « l’échantillonnage de circuit quantique aléatoire », une tâche mathématique sans aucun intérêt pratique, mais très difficile pour un ordinateur classique La firme américaine estime alors que Frontier, le plus puissant supercalculateur du monde, installé au laboratoire américain

La firme américaine Google a-t-elle vraiment a eint la suprématie quantique ? £

d’Oak Ridge, aurait mis 100 000 ans pour venir à bout du calcul que Sycamore a effectué en seulement 200 secondes. C’est la suprématie quantique : il existe une tâche (fût-elle inutile) qu’une machine exploitant la mécanique quantique peut résoudre plus rapidement que les meilleurs ordinateurs classiques. Cet avantage préfigure, on l’espère, une accélération quantique pour des applications réelles

L’AUTEUR

ANTOINE TILLOY chargé de recherche au centre automatique et systèmes des Mines Paris, au sein de l’université Paris Sciences et Lettres

Rapidement, l’annonce de Google est critiquée La firme américaine a-t-elle vraiment atteint la suprématie quantique ? Dès l’année suivante , plusieurs groupes de chercheurs répliquent avec de nouvelles méthodes classiques optimisées pour l’échantillonnage de circuit quantique. Ils montrent qu’il est possible de simuler en quelques minutes l’expérience de Google de façon parfaite avec un supercalculateur, là où Sycamore y parvenait avec un taux d’erreurs important. Plus spectaculaire, Yiqing Zhou et Miles Stoudenmire, de l’institut Flatiron, à New York, et Xavier Waintal, du CEA à Grenoble, mènent la simulation d’un problème similaire en s’autorisant le même taux d’erreurs que Sycamore Résultat : le calcul est drastiquement simplifié et tourne sur un ordinateur de bureau Point commun de toutes ces approches classiques : elles utilisent le même type d’algorithme, les réseaux de tenseurs, une puissante méthode de compression

Les réseaux de tenseurs sont des concurrents sérieux pour l’ordinateur quantique sur les tests symboliques de suprématie, comme l’échantillonnage de circuit quantique aléatoire. Mais la vraie bataille ne se livre pas là. Pour comprendre ce qui se joue, il faut remonter au vrai problème utile et fondamental qu’ordinateur quantique et réseaux de tenseurs cherchent ultimement à résoudre : le problème à N corps quantique

Ce problème émerge quand on essaie d’exploiter les lois de la physique pour déterminer les propriétés d’un système constitué d’un grand nombre de particules quantiques

Certes, les physiciens théoriciens, dont je fais partie, aiment rappeler, non sans pédanterie, qu’on ne connaît pas exactement les lois fondamentales de la nature, puisqu’on ne sait pas décrire conjointement la force gravitationnelle et la matière quantique Si la question est difficile, c’est qu’on ne sait tout simplement pas ce que la théorie ultime devrait prédire : il n’y a jusqu’à maintenant aucune expérience réalisable sur Terre qui permette de tester cette intersection problématique entre gravité et

quantique Une autre manière plus positive (mais paradoxalement moins vendeuse) de présenter la situation est que l’on connaît suffisamment bien les lois de la physique pour pouvoir en principe prédire le résultat de n’importe quelle expérience raisonnable ! Dès lors, il devrait être possible de simuler et de calculer, in silico, les propriétés physiques de n’importe quelle molécule, de n’importe quel matériau, en partant d’équations quantiques que l’on sait facilement écrire

Ce graal de la physique théorique est malheureusement inatteignable aujourd’hui La résolution des équations est trop difficile , pour les humains comme pour les ordinateurs, dans la quasi-totalité des situations d’intérêt Pourquoi ? Parce que le nombre de paramètres nécessaires pour représenter l’état d’un système de N particules quantiques – la fonction d’onde – croît exponentiellement avec N Et, en dehors de systèmes ultrasimples et isolés,

comme celui d’un unique atome d’hydrogène dans le vide, tout phénomène physique intéressant met en jeu de nombreuses particules quantiques en interaction (par exemple les électrons d’une molécule complexe qui déterminent ses propriétés chimiques).

Stocker les coefficients de la fonction d’onde d’un système d’une centaine de particules est impossible même en utilisant l’intégralité des ordinateurs et superordinateurs sur Terre (voir l’encadré ci-dessous) A fortiori, faire évoluer cette fonction d’onde dans le temps à l’aide des équations connues est totalement impensable Ainsi , toute la physique d’un système quantique constitué de nombreuses particules interagissant pour produire un phénomène collectif intéressant nous est a priori numériquement inaccessible Cette obstruction pratique, qui empêche de passer de lois

Le problème quantique à N corps, comme son nom l’indique, ne vient pas du nombre d d’états accessible à chaque particule (sinon il s’appellerait le problème à d états !), mais principalement de la croissance avec N Considérons le cas d = 2, c’est-à-dire 2 états accessibles par particule (ce qui correspond à un qubit), qui est a priori le plus simple. Prenons un système tridimensionnel contenant 3 × 3 × 3 = 27, et la fonction d’onde qui le décrit. Si un coe cient de celle-ci est codé sur 64 bits, alors la fonction d’onde occupe (64 bits) × 227 soit 1 gigaoctet en mémoire. C’est faisable sans di culté sur un ordinateur personnel. Pour un système à peine plus gros de 4 × 4 × 4 = 64 particules quantiques, le stockage demande (64 bits) × 264 = 128 milliards de gigaoctets ou 128 exaoctets soit plus de 100 fois la capacité de stockage de

Une particule quantique isolée est, à elle seule, un système déjà riche, mais on peut simplifier sa description en supposant qu’elle n’a que d niveaux (par exemple d’énergie) accessibles.

Elle est alors entièrement caractérisée par sa fonction d’onde quantique, qui contient d nombres complexes c1,… cd

Frontier, le plus puissant supercalculateur du monde. Stocker la fonction d’onde d’un système de 5 × 5 × 5 est inimaginable avec les ressources disponibles sur Terre. Or les systèmes d’intérêt comme les modèles de matériaux supraconducteurs à haute température impliquent souvent des comportements collectifs d’un grand nombre d’électrons, ce qui rend impossible leur simulation par des techniques classiques usuelles.

Pour N particules ayant chacune d niveaux accessibles, on a dN états au total.

La fonction d’onde de l’ensemble est donc une collection de dN nombres complexes. d niveaux accessibles Énergie d N niveaux accessibles | Ψ > = c 1 | > + c 2 | > + c 3 | > +

Si le nombre complexe ci n’est pas simplement interprétable, le module carré |ci|2 fournit la probabilité d’être dans le niveau i si on mesure l’énergie.

fondamentales connues à des prédictions macroscopiques robustes, constitue le problème à N corps quantique

En pratique, on est contraint soit d’utiliser des modèles phénoménologiques approchés et pas toujours assez précis, soit de mesurer directement par l’expérience les propriétés qui nous intéressent. Au fond, le problème à N corps constitue l’obstacle majeur qui empêche le réductionnisme de passer d’un triomphe théorique à un triomphe pratique Ainsi, et d’un point de vue pragmatique, le problème à N corps quantique est un défi infiniment plus important pour l’humanité que l’unification de la gravité et de la mécanique quantique, puisqu’il nous empêche de répondre à des questions qui se posent naturellement, et ouvriraient la voie à des innovations et à des applications utiles, plutôt qu’à des questions qu’on a peine à trouver. Les physiciens théoriciens ont pris conscience du problème à N corps quantique dès 1929 et l’article fondateur de Paul Dirac sur la chimie quantique. Avec la mécanique quantique non relativiste connue à l’époque, il était a priori possible de décrire précisément les réactions chimiques Mais Dirac note que le nombre de variables mises en jeu étant colossal il est indispensable de trouver des méthodes approchées pour extraire des résultats concrets des équations

Depuis , en suivant cette idée , les théoriciens ont développé une multitude de méthodes plus ou moins efficaces pour approcher les solutions du problème à N corps En chimie, par exemple, la méthode de la fonctionnelle de densité (DFT) a permis de prédire les propriétés d’un grand nombre de molécules simples En matière condensée, la théorie du champ moyen dynamique (DMFT), proposée par Antoine Georges et Gabriel Kotliar, a permis de comprendre les propriétés électriques d’un grand nombre de matériaux . Malgré tous ces progrès, un grand pan du problème à N corps reste difficile à approximer avec ces méthodes C’est en particulier le cas de tous les systèmes dits « fortement corrélés », où les particules quantiques sont intriquées de manière non triviale. L’intrication est une particularité quantique, synonyme de non-séparabilité, qui empêche de caractériser un système de particules en les décrivant chacune individuellement. Elle peut être vue schématiquement comme un lien entre les particules, forçant à distance une corrélation dans leur dynamique. Une grande partie de la physique nucléaire, de la physique des supraconducteurs à haute température et de la physique des catalyseurs tombent dans cette catégorie des systèmes fortement corrélés, pour lesquels l’intrication joue un rôle crucial

L’ordinateur quantique et les réseaux de tenseurs sont deux approches plus récentes et, de façon paradoxale, conceptuellement plus simples, qui s’insèrent dans cette longue tradition des efforts de résolution du problème à N corps. Dans les deux cas, l’objectif est d’attaquer le problème frontalement, en représentant directement la fonction d’onde quantique et son nombre astronomique de variables

L’idée des réseaux de tenseurs est de compresser la représentation de la fonction d’onde pour qu’elle puisse être enregistrée dans la mémoire d’un ordinateur

L’idée de l’ordinateur quantique est d’utiliser la mécanique quantique elle-même pour simuler un système de particules quantiques. Comme l’a observé Richard Feynman, la nature, elle-même, sait très bien simuler la mécanique quantique Cette observation d’apparence triviale mène à l’idée de simulateur quantique, qui consiste à émuler un système inconnu grâce à un analogue facilement configurable Par exemple, on peut utiliser des atomes piégés sur une grille bidimensionnelle par des pinces optiques pour simuler un problème de matière condensée. C’est ce type de machines que développent notamment l’entreprise française Pasqal et son concurrent américain Quera Computing

L’ordinateur quantique est un raffinement de cette idée : on remplace le système analogue par une version numérique utilisant des qubits, ce qui a l’avantage de permettre une précision arbitraire grâce aux codes correcteurs d’erreur L’ordinateur quantique est ainsi au même niveau de robustesse (en tout cas théoriquement) qu’un ordinateur classique, et ne souffre pas des objections que l’on peut faire aux calculateurs analogiques, dont la précision est par principe limitée.

L’engouement pour l’ordinateur quantique a réellement décollé en 1994, quand le mathématicien américain Peter Shor a découvert un algorithme quantique permettant de factoriser rapidement de grands nombres, contenant potentiellement des milliers de chiffres Pour de si grands nombres, aucun algorithme classique connu n’est efficace L’algorithme de Shor représente ainsi une réelle menace pour de nombreux systèmes de cryptographie utilisés actuellement, dont la sécurité repose sur la difficulté de la factorisation Cette puissance inespérée pour une tâche « classique » sans lien avec la mécanique quantique a fait espérer d’autres applications hors de la physique. Néanmoins, elles sont pour le moment peu nombreuses et le problème à N corps quantique reste ainsi l’application principale de l’ordinateur quantique (et peut-être sa seule application utile). Là où l’ordinateur quantique apporte une solution « matérielle » au nombre gigantesque de variables de la fonction d’onde, les réseaux de tenseurs sont une solution « logicielle ». L’idée est de compresser la représentation de la fonction d’onde du système de particules,

c’est-à-dire de réduire son nombre de paramètres, pour qu’elle puisse être enregistrée dans la mémoire d’un ordinateur standard Les algorithmes de réseaux de tenseurs sont ainsi à la mécanique quantique ce que le format informatique courant jpeg est aux images : un moyen de compresser drastiquement la représentation, au prix d’une perte minimale (et contrôlable) de précision

Les techniques de compression permettent de réduire le nombre de paramètres nécessaires pour décrire un objet, une image, une piste audio, une vidéo ou une fonction d’onde. Elles ne sont e caces que si l’objet est su samment structuré. Si l’objet est totalement générique, la compression ne sera pas e cace. Par exemple, pour une image où chaque pixel a une couleur aléatoire, la seule solution est d’enregistrer la couleur de chaque pixel. Dans une photo de chat, de nombreux sous-ensembles de pixels ont des couleurs similaires, et un encodage intelligent est possible (par exemple avec jpeg).

Dans un système quantique contenant N particules, un élément crucial pour la compressibilité est la structure de l’intrication quantique. De manière simplifiée, l’intrication peut être vue comme un lien entre deux particules quantiques. Pour un état quantique de N particules tiré aléatoirement, les liens se forment entre des parties arbitrairement éloignées. Si on considère un sous-ensemble de particules, la plupart de ces dernières sont alors connectées avec une particule à l’extérieur du sous-ensemble. L’entropie d’intrication, qui quantifie la densité d’intrication du système et qui correspond au nombre de liens qu’il faut couper pour séparer le sous-ensemble du reste du système, est élevée et suit une loi de volume (elle est proportionnelle au nombre de particules contenues dans le sous-ensemble).

Pour un système de particules quantiques à basse température, ces liens restent courts. Dans ce cas, les seules particules du sous-ensemble connectées avec le reste du système sont sur le bord du sous-ensemble. L’entropie d’intrication suit la loi des aires, elle est proportionnelle au nombre de particules sur le périmètre (pour un système bidimensionnel) et sur la surface (si le système est tridimensionnel). Ces configurations sont non génériques et laissent espérer qu’une compression est possible.

Avant de raconter l’histoire des réseaux de tenseurs, il faut rappeler qu’il n’y a jamais de compression magique Toute méthode de compression doit exploiter une structure sousjacente aux données à compresser Une image contenant uniquement des pixels aléatoires est impossible à compresser car totalement générique : la seule solution est de stocker la couleur de chaque pixel En revanche, une image de chat ou de paysage est extrêmement non générique (les pixels proches tendent à être de la même couleur par exemple ). Cette structure ( ou régularité) est exploitée par les algorithmes comme jpeg, qui peuvent ainsi drastiquement réduire la taille de l’image au prix d’une perte de qualité minimale De la même manière , si la fonction d’onde est totalement générique, comme une image faite de pixels aléatoires, alors il n’y a pas d’espoir de pouvoir la représenter de manière parcimonieuse, et seul l’ordinateur quantique sera capable de la représenter exactement C’est d’ailleurs ce qui permet de comprendre en creux les domaines où l’avantage quantique est atteignable : là où la compression est impossible. La question cruciale est donc de savoir si les fonctions d’onde qui apparaissent naturellement dans les instances intéressantes du problème à N corps quantique ont une structure, un caractère non générique, qui les rend compressibles, au moins en principe. La réponse est positive et leur structure est précisément celle que les réseaux de tenseurs représentent.

Intrication « générique »

Intrication locale (loi des aires)

En 1992, Steve White, de l’université de Californie à Irvine, fournit la première illustration qu’une compression efficace est possible À cette époque, les physiciens théoriciens s’intéressent au cas particulier du problème à N corps en une dimension d’espace (où les particules quantiques sont confinées sur une ligne). Il s’agit alors d’une première étape, on l’espère, vers la résolution du cas tridimensionnel. La réduction à une dimension permet de simplifier un peu les équations, et d’avoir quelques modèles dits « intégrables », c’est-àdire exactement solubles, qui servent de banc d’essai pour les méthodes de résolution générales De plus, les méthodes approchées existantes, qui donnent des résultats raisonnables en 3D, comme les méthodes de champ moyen, sont catastrophiques en une dimension. La 1D est ainsi le terrain de jeu idéal pour tester de nouvelles idées. Avec l’algorithme DMRG ( density matrix renormalization group , ou groupe de renormalisation de la matrice de densité) de Steve White, un large pan du problème à N corps 1D est résolu du jour au lendemain Pour une grande classe d’équations, incluant la plupart

Pour construire un réseau de tenseurs, l’idée est de tapisser l’espace avec de l’intrication locale virtuelle, puis de ramener cette intrication dans l’espace physique, ici des particules (en bleu clair) sur un réseau carré (A). Plus précisément, on pose des paires de particules virtuelles (en rouge)

intriquées sur chaque lien entre les nœuds du réseau (B)

Sur chaque nœud, on applique une transformation linéaire (en noir) qui fusionne les particules virtuelles et physiques présentes, soit pour construire des liens plus longs, soit pour se lier à la particule physique sur le

nœud (C). En ajustant la transformation sur chaque site (D), on peut reproduire n’importe quel schéma d’intrication su samment local (E)

La représentation compressée de l’état quantique est contenue dans ces choix de transformation, qui sont la seule chose que l’on doit stocker en mémoire.

des situations d’intérêt , cet algorithme est capable de calculer l’état du système à très basse température avec une précision que l’on peut fixer au niveau souhaité, sans même utiliser de supercalculateur C’est une révolution, car ce problème semblait alors difficilement soluble avec des méthodes classiques, sans ordinateur quantique . L’algorithme DMRG de Steve White est extrêmement efficace, et réduit le problème à N corps 1D à de l’algèbre linéaire élémentaire Mais de façon peut-être surprenante, on ne comprend pas bien à cette époque la raison de son efficacité

De l’autre côté de l’Atlantique, la même année et de façon indépendante de Steve White, trois mathématiciens – Mark Fannes, Bruno Nachtergaele et Reinhard Werner –introduisent une classe d’états quantiques qu’ils jugent intéressants à étudier : les états « produits de matrices » (dits MPS, pour matrix product states). Ceux-ci peuvent être décrits avec très peu de paramètres, et ils sont faciles à manipuler et à caractériser. Mathématiquement , la fonction d’onde d’un état quantique de N particules est représentable par un tenseur à N indices (un tableau de nombres en N dimensions), une généralisation des matrices (un tableau de nombres en deux dimensions). Si chaque particule a d états accessibles, alors ce tenseur contient dN nombres (qui prend une valeur astronomique dès que N est grand). L’idée de Fannes, Nachtergaele et Werner est de considérer des fonctions d’onde particulières où ce tenseur à N indices peut s’écrire comme un produit de

matrices, chacune de petite taille Ces MPS sont un cas particulier de réseaux de tenseurs en 1D Il faut attendre trois ans pour comprendre le lien entre l’algorithme DMRG et les MPS. En 1995, les physiciens Stellan Östlund et Stefan Rommer, de l’université de technologie Chalmers , en Suède , montrent que l’algorithme DMRG de Steve White est en fait équivalent à une compression des états quantiques vers une représentation en MPS (voir les encadrés ci-dessus et page 30) Les deux chercheurs lèvent ainsi une partie du voile, mais il reste à comprendre pourquoi cette structure fonctionne aussi bien. Pourquoi ces réseaux de tenseurs assez simples, les états produits de matrices, qui ont si peu de paramètres, représentent-ils aussi bien les états quantiques des systèmes qui intéressent les physiciens ?

Au début des années 2000, les spécialistes suspectent , sans l’avoir prouvé dans le cas général, que les fonctions d’onde du problème à N corps partagent une propriété qui les rend

Plus les paires que l’on cherche à former sont éloignées, plus il faut de particules virtuelles sur les liens, plus les transformations peuvent être compliquées, et plus le coût de la méthode est élevé.

Dans le cas général, l’intrication peut être plus compliquée qu’un simple lien

E

entre deux particules (et connecter plusieurs particules en même temps de manière plus di use et complexe). Néanmoins, la même stratégie s’applique, et on peut toujours ajuster les transformations linéaires pour représenter une intrication générale, tant qu’elle est su samment locale.

ne tire pas les fonctions d’onde de façon aléatoire ! Au contraire, une fonction d’onde qui décrit un système physique, en l’occurrence un problème à N corps, obéit nécessairement à l’équation de Schrödinger et possède donc une certaine structure. Dès lors, elle possède quasi exclusivement des liens courts Ainsi , tout sous-ensemble de particules assez gros n’est connecté au reste du système que via ses bords Son entropie d’intrication est proportionnelle à la surface du bord (en 3D) ou au périmètre (en 2D) : c’est la loi des aires. Les fonctions d’onde intéressantes sont ainsi aux fonctions d’onde « génériques » ce que les images de chats sont aux pixels aléatoires

non génériques (pas complètement aléatoires) et donc a priori compressibles. Dans ces fonctions d’onde qui intéressent les physiciens, l’intrication quantique respecte la « loi des aires » Le terme est apparu initialement dans le contexte des trous noirs, avec les travaux de Jacob Bekenstein et Stephen Hawking, pour souligner le fait que la quantité d’entropie d’un trou noir est théoriquement proportionnelle à l’aire de sa surface et non à son volume, comme on s’y attend pour un objet ordinaire Le problème à N corps est a priori sans lien avec la gravité, mais on y observe un phénomène similaire pour l’intrication (voir l’encadré page 27) Pour un système donné contenant un grand nombre de particules, ces dernières peuvent être plus ou moins intriquées les unes avec les autres Comment estimer cette propriété ? Une méthode assez naturelle consiste à diviser en deux le système et de se demander combien de liens d’intrication il faudrait couper pour séparer les deux parties : ce nombre est nommé l’entropie d’intrication.

Pour une configuration de particules aléatoire, les liens sont arbitrairement longs. Dès lors, si on ne regarde qu’un petit sousensemble de particules, la plupart des liens les connectent à des particules à l’extérieur Ainsi, dans une telle situation, l’entropie d’intrication est proportionnelle au nombre de particules du sous - ensemble considéré et donc à son volume : on dit que le système vérifie une loi de volume. C’est une propriété générique, à laquelle obéit presque sûrement une fonction d’onde tirée de façon aléatoire Mais la nature

En 2004, les physiciens Ignacio Cirac et Frank Verstraete, alors à l’institut Max-Planck d’optique quantique de Munich, comprennent que les réseaux de tenseurs 1D, utilisés dans l’algorithme de Steve White, possèdent par défaut cette propriété non générique de loi des aires. Mieux, ils parviennent à démontrer que si l’intrication d’un système de particules unidimensionnel est assez faible, vérifiant rigoureusement la loi des aires, alors les réseaux de tenseurs 1D en fournissent une compression dont l’erreur peut être rendue aussi faible que désiré pour un coût mémoire modéré. Matthew Hastings, alors au laboratoire national de Los Alamos, complète la preuve formelle de l’efficacité des réseaux de tenseurs en 2007 en démontrant que les systèmes quantiques 1D d’intérêt vérifient effectivement la loi des aires

Le problème à N corps à une dimension d’espace est un succès incontestable Le problème semblait hors d’atteinte pour les ordinateurs classiques Et quelques années plus tard, l’humanité dispose d’un algorithme qui permet de le résoudre, et une preuve rigoureuse de son efficacité Le tout sans avoir besoin d’ordinateur quantique. Néanmoins, même en 1D, la compression n’est pas sans limite. Lorsqu’on injecte beaucoup d’énergie dans un système de particules quantiques (par exemple en l’éloignant fortement de son point d’équilibre), fût-il unidimensionnel, la dynamique devient chaotique. L’intrication quantique explose et se délocalise, et la capacité à compresser la description du système disparaît Un tel système finit par se thermaliser, et redevient alors facile à décrire grâce à la physique statistique Mais pendant une phase transitoire, une complexité incompressible émerge C’est précisément dans ce régime que l’on trouve les pistes pour l’avantage quantique, qu’elles soient utiles ou non Les circuits quantiques aléatoires simulés par la machine de Google correspondent justement à des dynamiques engendrant le maximum d’intrication

Sans intérêt pratique, leur réelle raison d’être est de mettre en défaut le plus efficacement possible les méthodes de compression classiques Sur cette tâche où les ordinateurs quantiques montrent leurs muscles, les réseaux de tenseurs sont ainsi voués à perdre un jour (même s’ils résistent admirablement). Mais pour les problèmes utiles, les jeux ne sont pas faits.

Hors de situations exceptionnelles en laboratoire (comme dans les nanofils), les systèmes quantiques sont rarement confinés à une unique dimension d’espace. Ainsi, le succès des réseaux de tenseurs en 1D, aussi impressionnant qu’il soit, n’est a priori qu’un prélude aux dimensions supérieures, sans quoi la méthode restera confinée à l’étude de modèles jouets

La résolution du problème à N corps unidimensionnel était partie du domaine de

l’algorithmique, avant d’être plus tard justifiée par la théorie. L’attaque des dimensions supérieures emprunte le chemin inverse En 2004, alors qu’ils viennent de comprendre ce qui permet la compression unidimensionnelle et ainsi de cimenter la première révolution des réseaux de tenseurs, Ignacio Cirac et Frank Verstraete mettent en ligne une prépublication visionnaire , jamais formellement acceptée dans un journal. Ils y proposent une généralisation des états produits de matrice de Fannes, Nachtergaele et Werner aux dimensions supérieures Ces nouveaux états, qui correspondent aux réseaux de tenseurs modernes, sont en principe utilisables pour tous les problèmes physiques d’intérêt, en deux et trois dimensions d’espace Les deux chercheurs espèrent alors passer rapidement de la théorie à un algorithme utilisable pour résoudre une grande partie des instances utiles du problème à N corps

GÉNÉRALITÉS SUR LES TENSEURS

Le terme « tenseur » a de nombreuses significations subtilement di érentes en physique. On n’a besoin ici que d’une définition minimale, équivalente à celle d’un tableau multidimensionnel utilisée dans la plupart des langages de programmation. Là où un vecteur est un tableau à une dimension, une matrice un tableau à 2 dimensions, un tenseur est simplement la généralisation à 3 dimensions ou plus. De même que les vecteurs et les matrices peuvent être multipliés, les tenseurs ont une opération élémentaire, la contraction, qui consiste à multiplier les coe cients de deux tenseurs et sommer sur une paire d’indices fixés à l’identique. Par exemple, on peut contracter deux tenseurs tridimensionnels A et B pour en obtenir un troisième C :

On doit au physicien Roger Penrose une notation compacte pour les tenseurs et la contraction. On représente un tenseur à N dimensions par une boule d’où sortent N pattes. Pour représenter la contraction, on relie simplement les deux pattes correspondant à l’indice sommé. Sur l’exemple précédent cela donne :

Lorsque l’on contracte de nombreux tenseurs entre eux, selon un graphe quelconque, on obtient un réseau de tenseurs.

DÉCOMPOSITION D’UNE FONCTION D’ONDE EN RÉSEAU DE TENSEURS

L’état quantique |Ψ> d’un système de N particules ayant chacune d niveaux accessibles est la combinaison linéaire des dN niveaux accessibles à l’ensemble

où chaque indice ik se réfère au niveau occupé par la particule k. Les dN coe cients complexes Ci1,i2,…,iN sont des tenseurs à N indices qui déterminent l’état. En suivant la notation de Penrose, on peut représenter un tel tenseur ainsi : On peut compresser ce tenseur en le forçant à s’écrire sous la forme d’un réseau de tenseurs. En général il y a beaucoup moins de paramètres dans les tenseurs élémentaires. Le choix d’un réseau unidimensionnel donne les états produits de matrices (MPS), e caces pour le problème à N corps en 1D : Un réseau bidimensionnel ou tridimensionnel correspond aux états introduits par Cirac et Verstraete, e caces en 2 dimensions d’espace ou plus :

Mais les cas des dimensions 2 et 3 relèvent davantage de l’épopée que de la révolution. Dès le début, les spécialistes remarquent que les réseaux de tenseurs d’Ignacio Cirac et de Frank Verstraete sont plus difficiles à utiliser que les états produits de matrice unidimensionnels qu’ils généralisent Leur puissance de compression n’est pas mise en doute : on pense qu’ils représentent avec peu de paramètres les fonctions d’onde quantiques apparaissant dans le problème à N corps, c’est-à-dire précisément celles qui nous intéressent. Mais le problème est qu’il est beaucoup plus difficile d’extraire de l’information de la représentation compressée qu’en une dimension d’espace En 2007, les deux physiciens démontrent avec Norbert Schuch et Michael Wolf, alors eux aussi à l’institut Max - Planck d’optique quantique , que pour certains réseaux de tenseurs 2D ou 3D, décompresser la représentation pour extraire des prédictions peut être plus difficile que le problème à N corps lui-même ! Un tel résultat rend a priori impossible le passage de l’idée théorique à un algorithme efficace

Est-ce la fin des espoirs ? Non, car il n’est pas sûr que les réseaux de tenseurs qui apparaissent lorsqu’on compresse des fonctions d’onde physiques fassent partie de la classe difficile identifiée par les quatre chercheurs ! Peut- être que les réseaux de tenseurs qui émergent naturellement sont plus simples, et au moins approximativement décompressibles Sans preuve formelle d’impossibilité, il n’est pas interdit d’essayer

Après des efforts héroïques par de nombreux physiciens théoriciens, parmi lesquels on peut citer le suisse Philippe Corboz, on parvient à construire différents algorithmes de compression et décompression de réseaux de tenseurs en 2 et 3 dimensions , adaptés aux fonctions d’onde physiques Ces travaux culminent avec l’application de la méthode au modèle de Fermi-Hubbard bidimensionnel, un modèle simplifié de matériau supraconducteur à haute température L’algorithme n’est pas encore assez précis pour trancher certaines questions cruciales sur ces systèmes, mais on s’en rapproche progressivement.

Le problème à N corps est-il en passe d’être résolu ? Pas tout à fait, car malgré les progrès remarquables des théoriciens ces dernières années , les algorithmes de réseaux de tenseurs en 2D et 3D demandent trop de puissance de calcul pour atteindre une précision satisfaisante sur des problèmes physiques non idéalisés. On doit se contenter de réseaux de tenseurs avec peu de paramètres, et donc d’une compression un peu bruitée en 2D et pour le moment bien trop grossière en 3D Dans certains cas, les réseaux de tenseurs restent la

meilleure méthode, mais dans d’autres, ces limitations rendent des approches plus traditionnelles comme la DMFT ou la méthode de Monte-Carlo préférables. Le consensus est que la compression apportée par les réseaux de tenseurs reste en principe efficace, comme avec DMRG en 1D, mais qu’il faudrait accéder à des nombres de paramètres beaucoup plus grands pour commencer à le voir. Dans cette optique, il faudrait améliorer encore les algorithmes de compression et développer des codes massivement parallèles pour voir émerger une compression efficace Selon cette hypothèse , les réseaux de tenseurs seraient comme les réseaux de neurones juste avant la révolution des processeurs graphiques (GPU) : le bon outil théorique avant l’heure Une autre option est que la difficulté de la 2D et de la 3D soit plus fondamentale, et qu’il manque un ingrédient théorique à la proposition d’Ignacio Cirac et Frank Verstraete. Certains ont déjà proposé des extensions , comme les réseaux de tenseurs isométriques, qui sacrifient un peu de généralité pour intégrer certaines astuces responsables de l’efficacité numérique de DMRG en 1D

Alors que la 2D et la 3D résistent encore, les réseaux de tenseurs ont trouvé des applications dans d’autres domaines. Ils ont notamment été utilisés dans le domaine de l’intelligence artificielle, en apprentissage statistique théorique, soit pour remplacer des réseaux de neurones (ce qui a l’avantage de présenter une meilleure interprétabilité, on peut mieux comprendre comment on obtient un résultat à partir d’un jeu de données initiales ) soit comme une méthode de compression de réseaux de neurones existants Les réseaux de tenseurs aident aussi leur adversaire immédiat : ils sont désormais utilisés dans les codes correcteurs qui permettront aux ordinateurs quantiques d’être robustes aux erreurs. Ces dernières années, les investissements massifs dans l’ordinateur quantique ont remis sur le devant de la scène le problème à N corps, qui occupait les théoriciens depuis des décennies En 2023, IBM s’est essayé à l’avantage quantique sur un cas « utile » en résolvant une instance simple du problème à N corps en 2D (une version 2D du modèle d’Ising) sur Eagle, son meilleur processeur quantique à 127 qubits. À peine douze jours plus tard, l’équipe de Miles Stoudenmire a répondu en simulant le même modèle en quelques minutes grâce aux réseaux de tenseurs Les méthodes classiques gardent ainsi la tête dans la bataille pour faire tomber les instances utiles du problème à N corps quantique. Même si les ordinateurs quantiques progressent, les méthodes classiques continuent de se raffiner grâce à cet aiguillon, et rien ne dit qui sortira en tête de cette course n

BIBLIOGRAPHIE

Yiqing Zhou et al., What limits the simulation of quantum computers ?, Physical Review X, 2020.

F. Arute et al., Quantum supremacy using a programmable superconducting processor, Nature, 2019.

P. Corboz, Improved energy extrapolation with infinite projected entangled-pair states applied to the two-dimensional Hubbard model, Physical Review B, 2016.

F. Verstraete et J. I. Cirac, Matrix product states represent ground states faithfully, Physical Review B, 2006.

S. R. White, Density matrix formulation for quantum renormalization groups, Physical Review Letters, 1992.

L’ESSENTIEL

> Depuis quelques années, grâce à des diagnostics plus précis du stade de la maladie, on privilégie la surveillance active de la tumeur à l’intervention chirurgicale quand cela est possible.

> Lorsque les métastases sont en nombre limité et localisées près de la prostate, leur

traitement par radiothérapie ciblée conduit souvent à une rémission à long terme.

> Lorsque des métastases se sont développées dans d’autres parties du corps, des thérapies plus e caces, fondées sur une meilleure compréhension de la biologie de la maladie, sont désormais disponibles.

L’AUTEUR

MARC B. GARNICK professeur de médecine à la faculté de médecine de Harvard (HMS) et au centre médical des diaconesses Beth-Israel, à Boston

Grâce à l’imagerie de pointe et à des protocoles affinés, le diagnostic de la maladie et la prise en charge des patients se sont considérablement améliorés ces dernières années, même pour les formes les plus avancées de la maladie.

Le diagnostic et le traitement du cancer de la prostate ont longtemps fait l’objet de controverses et d’incertitudes. Le test de l’antigène prostatique spécifique (PSA , pour prostatic specific antigen) en est un exemple Ce test, qui consiste à mesurer la concentration d’une protéine – le PSA – dans le sang, est capable de mettre en évidence un cancer même en l’absence de symptômes Après son introduction au début des années 1990, le dosage du PSA a été largement adopté : des millions de tests sont effectués chaque année aux États-Unis [son usage s’est développé de façon similaire en Europe à la même époque, ndlr]. En 2012, cependant, un groupe de travail gouvernemental américain a indiqué qu’il était susceptible d’entraîner, contre des cancers potentiellement peu dangereux, un surtraitement qu’il aurait mieux valu épargner au patient.

Depuis , les arguments pour ou contre le dosage du PSA continuent de s’affronter, mais on comprend mieux pourquoi certains cancers de la prostate progressent plus vite que d’autres, ce qui a permis d’améliorer le pronostic des patients à tous les stades de la maladie, même dans les cas les plus avancés. Un spécialiste du cancer de la prostate a aujourd’hui accès à un ensemble d’outils thérapeutiques élaborés et est capable d’estimer quand il est possible de différer un traitement en toute sécurité On ne saurait trop insister

sur l’importance de ces progrès Le cancer de la prostate reste l’une des tumeurs malignes les plus répandues Aux États-Unis, à l’exception de certains cancers de la peau, ceux de la prostate sont les plus fréquents chez les hommes : près de 270 000 d’entre eux en recevront le diagnostic cette année Il s’agit aussi du quatrième cancer le plus répandu dans le monde. Heureusement, la grande majorité des patients vivront des années après l’annonce de la maladie et mourront probablement de causes non liées à leur tumeur

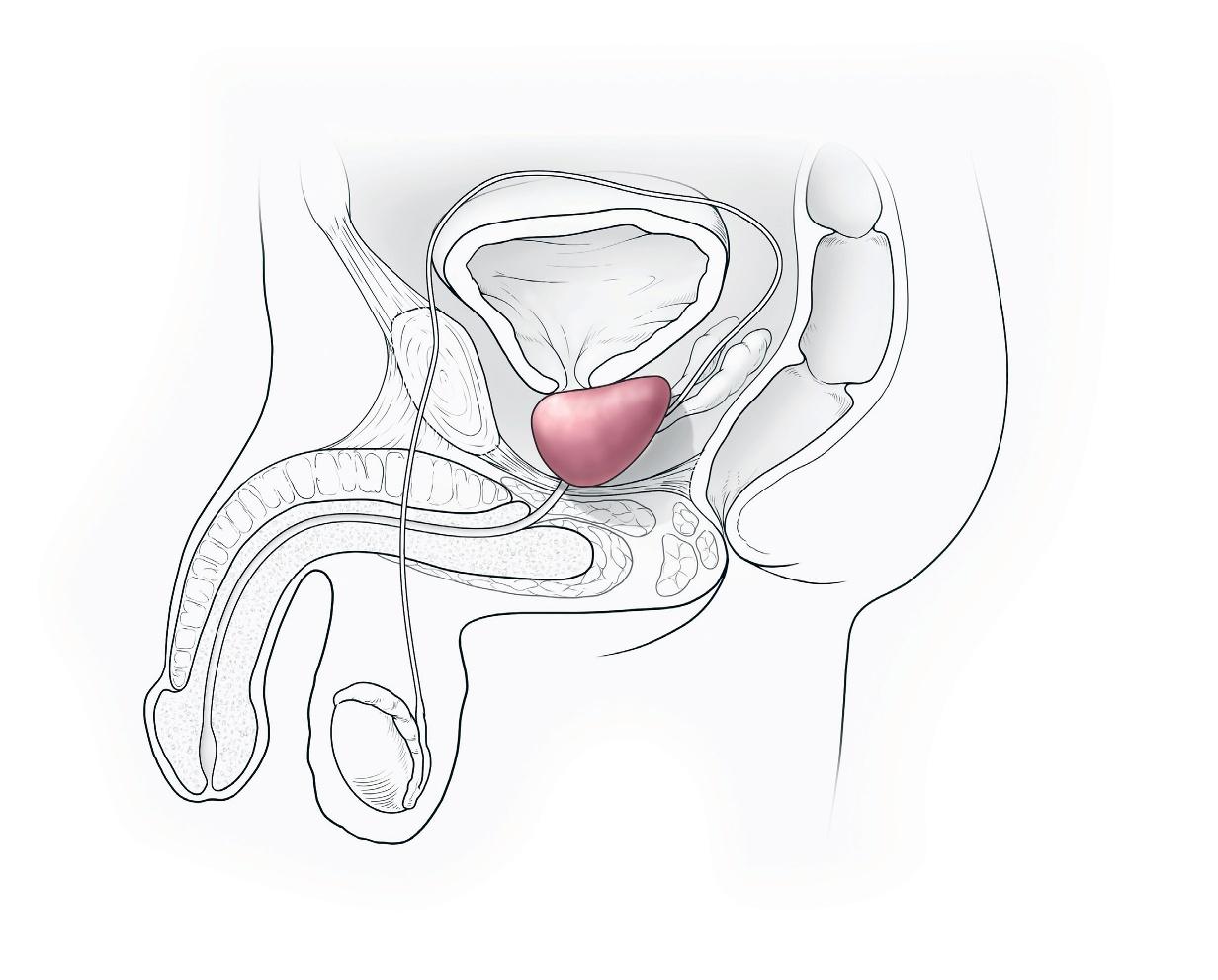

Fondamentalement, ce cancer survient dans la prostate Située devant le rectum, sous la vessie et au-dessus du pénis, cette glande produit un liquide qui se mélange aux spermatozoïdes, issus des testicules, pour former le sperme. On distingue quatre stades principaux de cancer

Au début, les tumeurs, localisées, ne présentent aucun signe d’extension au-delà de la prostate. Une deuxième forme de la maladie, dite « localement avancée », reste proche de la glande. Une troisième est le cancer métastatique de la prostate , qui se propage vers d’autres parties du corps. Le traitement des tumeurs de cette catégorie a bénéficié de l’amélioration des tests d’imagerie diagnostique. En fait, grâce à eux, les cancérologues ont caractérisé une catégorie supplémentaire, le cancer oligométastatique de la prostate, un stade situé sur un continuum entre le cancer localisé et la maladie métastatique plus dispersée Les découvertes majeures des dix dernières années

ont transformé la façon dont nous abordons chaque type de cancer de la prostate, et ces progrès devraient se poursuivre durant les prochaines décennies.

Les premières étapes du traitement des personnes atteintes d’un cancer localisé sont fondées sur une stratification du risque Ce processus permet au médecin d’évaluer la probabilité que la tumeur soit éliminée et le patient guéri par un traitement local (généralement par chirurgie ou radiothérapie) et, si celle-ci diminue, la probabilité que le cancer reprenne. Le médecin détermine le risque en fonction des résultats du dosage du PSA , de l’examen physique de la prostate et de l’inspection des cellules issues d’une biopsie de la tumeur

La conduite à tenir face à un patient dont le taux de PSA est élevé fait continûment l’objet de révisions. Il y a encore cinq à sept ans, le médecin palpait la prostate à la recherche d’anomalies potentiellement cancéreuses. Invariablement, l’étape suivante consistait en une biopsie faite à l’aiguille – une procédure inconfortable au cours de laquelle le médecin prélève des fragments de tissu prostatique par le rectum.

Mais, à présent, on dispose d’un moyen d’effectuer la biopsie à travers le périnée , la zone située entre l’arrière du scrotum (le sac de peau qui contient les testicules) et la région anorectale Grâce à des améliorations techniques, il est possible de la réaliser en ambulatoire, sans anesthésie générale ni sédation. Cette technique réduit le risque d’infection et le besoin d’antibiotiques, car elle ne perturbe pas la flore bactérienne du rectum. Ce que des chercheurs ont confirmé dans une étude récente : ils ont comparé les résultats de patients ayant subi une biopsie transrectale et reçu des antibiotiques à ceux de personnes ayant subi une biopsie transpérinéale avec peu ou pas d’antibiotiques, et ont constaté qu’il n’y avait pas davantage de complications dues aux infections chez ces dernières

Plus encourageante encore est la perspective de ne plus avoir besoin de biopsie Lorsqu’un patient présente un taux anormal de PSA mais aucun signe clair de dépôts cancéreux à l’examen rectal , les médecins ont désormais la possibilité d’utiliser l’imagerie par résonance magnétique (IRM) pour examiner la prostate et les tissus environnants L’IRM est le meilleur moyen d’identifier les cancers « cliniquement significatifs », c’est-à-dire ceux qui, s’ils ne sont pas traités ou diagnostiqués, risquent de se propager Elle met aussi en évidence la propagation d’un cancer ou encore des tumeurs situées dans des endroits inhabituels, par exemple à l’avant de la prostate. Un autre avantage de l’IRM est qu’elle identifie moins de cancers cliniquement non

significatifs – qui ne risquent pas de causer des problèmes et qu’il est préférable de ne pas traiter –, ce qui est une bonne chose, car cela évite des traitements inutiles. Dans certains centres médicaux aux États-Unis et dans nombre d’autres en Europe, un médecin ne pratique une biopsie que si l’IRM révèle des signes cliniquement significatifs. Des études qui ont comparé les deux approches diagnostiques – biopsie de routine pour tous les patients présentant un taux élevé de PSA et biopsie fondée sur des résultats anormaux de l’IRM – ont montré qu’elles sont aussi efficaces l’une que l’autre pour détecter les cancers cliniquement significatifs

Une fois le cancer de la prostate diagnostiqué, que se passe-t-il ? Pendant des décennies, la question du traitement a été tout aussi controversée que celle du diagnostic. Heureusement, de nouvelles recherches menées au RoyaumeUni et publiées en 2023 ont permis d’y voir plus clair L’urologue Freddie Hamdy et ses collègues ont étudié plusieurs centaines de personnes présentant un taux élevé de PSA et dont la biopsie de la prostate avait révélé la présence d’un cancer De façon aléatoire, ces patients ont soit subi une ablation chirurgicale de la glande, soit reçu un traitement par radiothérapie, soit fait l’objet d’un suivi complet sans traitement. Quinze ans plus tard, environ 3 % des patients de chaque groupe étaient morts d’un cancer de la prostate et environ 20 % de chaque groupe, de causes sans rapport avec le cancer. Sur la base des résultats de cette étude et d’autres, davantage de personnes se voient désormais proposer une « surveillance active » après un diagnostic de cancer de la prostate, dans le cadre de laquelle le traitement est soit retardé, soit totalement évité Le suivi soutenu de patients n’ayant pas subi d’intervention chirurgicale ou de radiothérapie est de plus en plus courant ; il est même étendu à présent aux patients porteurs de tumeurs plus inquiétantes. La surveillance comprend une série de mesures : le dosage du PSA tous les trois à six mois, l’examen physique de la prostate et l’évaluation des symptômes urinaires du patient Ces tests sont suivis de biopsies de plus en plus espacées dans le temps tant qu’aucun changement pathologique significatif n’apparaît. Si un cancer est identifié comme présentant un risque intermédiaire ou élevé , les médecins doivent suivre sa progression, généralement à l’aide de scintigraphies osseuses et de tomodensitométries abdominopelviennes, des examens qui visent à rechercher toute propagation du cancer dans les zones où il a tendance à métastaser. Malheureusement, ces techniques ne sont pas assez sensibles pour détecter de manière fiable sa propagation dans des structures de moins de 1 centimètre de diamètre, comme les ganglions lymphatiques

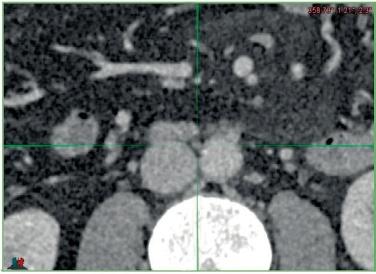

La prostate, siège de l’un des cancers les plus fréquents, est une glande de la taille d’une noix située dans la cavité pelvienne. Elle produit un liquide qui se mélange aux spermatozoïdes issus des testicules et au liquide que produisent les vésicules séminales pour former le sperme, qui sort du corps par l’urètre lors de l’éjaculation.

L’IRM est le meilleur moyen d’identifier les cancers cliniquement significatifs

Canal déférent

Urètre

Par conséquent, il arrive que de petites zones métastatiques passent inaperçues. On dit de ces cas qu’ils sont « sous-estimés »

En général, les patients dont la maladie est sous-estimée ne sont pas traités jusqu’à ce que le cancer devienne détectable par des symptômes comme des problèmes de miction ou des douleurs La maladie nécessite alors parfois des thérapies intensives et les chances de rémission à long terme sont moindres Aujourd’hui, cependant, des diagnostics plus précis devraient aider à résoudre ce problème C’est ce que permet, en particulier, une technique d’imagerie de pointe – nommée PET-CT – qui combine tomographie par émission de positons et tomodensitométrie. Cette technique détecte des molécules présentes dans les cellules cancéreuses, comme l’antigène membranaire spécifique de la prostate (PSMA). Si le PSMA est repéré en dehors de la prostate, par exemple dans les ganglions lymphatiques pelviens, les zones touchées sont identifiables et il est alors possible de planifier une radiothérapie ciblée ou une ablation chirurgicale.

Voyons de plus près comment on utilise le PET-CT en pratique. L’un de mes patients, un homme de 68 ans, s’était vu diagnostiquer un cancer de la prostate localisé, mais avec

Vésicule séminale

Rectum (zone d’accès pour une biopsie)

Périnée (zone d’accès pour une biopsie)

Testicule

des caractéristiques à haut risque La scintigraphie osseuse et la tomodensitométrie traditionnelles n’avaient révélé aucun signe de propagation du cancer hors de la glande. Pourtant, la recherche du PSMA par PET-CT a mis en évidence plusieurs petits dépôts de cellules cancéreuses dans des zones bien définies du bassin, ce qui indiquait que le cancer s’était propagé aux ganglions lymphatiques Cette découverte a déclenché un traitement comprenant une radiothérapie de la prostate et des ganglions lymphatiques cancéreux ainsi qu’une hormonothérapie antiandrogénique, un traitement qui réduit la quantité de testostérone dans le corps – l’hormone qui stimule le développement du cancer de la prostate L’identification de dépôts tumoraux dans un nombre limité de ganglions lymphatiques pelviens (on parle de « cancer oligométastatique de la prostate ») a permis une nouvelle utilisation d’une ancienne technique en oncologie appelée « radiothérapie stéréotaxique des métastases », qui cible de façon précise [grâce à de nombreux faisceaux convergents, ndlr] les ganglions lymphatiques ou les zones osseuses touchés Parfois, on associe à cette technique l’ablation chirurgicale des ganglions lymphatiques anormaux Des études récentes sur l’utilisation de la radiothérapie stéréotaxique en

Ce texte est une adaptation de l’article Treating prostate cancer at any stage publié par Scientific American en mai 2024.

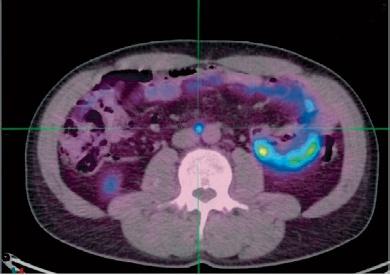

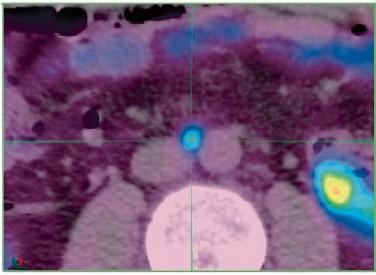

La technique d’imagerie PET-CT, qui combine la tomographie à émission de positons (PET) et la tomodensitométrie (CT), permet de détecter des métastases invisibles à l’aide de la seule tomodensitométrie. À gauche, une image de PET montre l’absorption normale du traceur radioactif dans les tissus sains (en noir) et sa concentration, liée au cancer, dans des ganglions lymphatiques métastatiques et la prostate (en rouge). À droite, la même région a été observée par CT seule (en haut) ou par PET-CT (en bas) ciblant l’antigène membranaire spécifique de la prostate (PSMA). Avec le PET-CT, on distingue l’absorption du traceur par des métastases de ganglions de faible volume (flèche orange) qu’il serait impossible de repérer sur les images de CT seules (flèche jaune)

conjonction avec les traitements conventionnels montrent, dans certains cas, une rémission à long terme se prolongeant sur des années de suivi. Jusqu’à récemment, un tel scénario était impensable Mon patient a suivi une thérapie de ce type accompagnée d’une hormonothérapie relativement courte Il est actuellement en rémission.

L’identification précise des petits dépôts métastatiques présente d’autres avantages. Depuis des décennies, l’hormonothérapie est le traitement de base de nombreuses formes de cancer de la prostate Les patients doivent poursuivre cette thérapie pendant des années, parfois toute leur vie Ses effets secondaires sont similaires à ceux de la ménopause En fait, l’« andropause » est le terme qui les décrit le mieux : la baisse du taux de testostérone s’accompagne d’une multitude de symptômes comme la perte de libido, des troubles de l’érection, la prise de poids, des bouffées de chaleur, de l’ostéoporose, des troubles cognitifs, des changements d’humeur, une baisse d’énergie et l’aggravation de problèmes cardiaques et vasculaires préexistants. Or des études sur l’utilisation de la radiothérapie stéréotaxique dans le cas d’un cancer oligométastatique de la prostate suggèrent des pistes pour retarder l’hormonothérapie , l’administrer pour une durée plus courte ou même l’omettre chez des patients qui, auparavant, auraient été diagnostiqués comme en ayant besoin

En déployant de façon stratégique les formes classiques de traitement localisé – la chirurgie d’ablation de la prostate ou la radiothérapie – et la radiothérapie stéréotaxique, les

médecins raccourcissent la durée de l’hormonothérapie, voire l’éliminent chez des patients atteints d’un cancer oligométastatique Une telle approche aurait été difficile à imaginer il y a cinq ans Des études de suivi à plus long terme aideront les scientifiques à déterminer si certaines personnes traitées de cette manière connaissent une rémission prolongée.

L’hormonothérapie antiandrogénique a longtemps été le principal traitement contre les formes avancées de cancer de la prostate, avec métastases dans d’autres parties du corps

Historiquement, les médecins recommandaient l’ablation chirurgicale des testicules – la principale source de testostérone – ou l’administration d’autres hormones qui bloquent sa production et son action Au milieu des années 1980, j’ai ainsi participé à des recherches sur des médicaments appelés « analogues de l’hormone lutéinisante ». Cette hormone réduit la production de testostérone en interrompant le signal cérébral qui ordonne aux testicules de fabriquer cette molécule Mais aujourd’hui, de nouveaux agents sont disponibles, qui réduisent encore l’action de la testostérone, voire la bloquent L’objectif du traitement des formes avancées du cancer de la prostate est d’éliminer les sources multiples de cette hormone. Celle-ci provient principalement des testicules, mais les glandes surrénales en produisent aussi une petite quantité De plus, il arrive que les cellules cancéreuses elles-mêmes évoluent et se mettent à produire leurs propres androgènes

Or la testostérone et sa forme active, la dihydrotestostérone, traversent la membrane des cellules cancéreuses et interagissent avec les récepteurs des androgènes présents dans leur cytoplasme ( le milieu intracellulaire ). Les récepteurs transportent ensuite la dihydrotestostérone jusqu’au noyau, où elle ordonne à la cellule cancéreuse de croître, de se répliquer et de se propager

L’hormonothérapie classique affecte peu la production de testostérone par les glandes surrénales et par les cellules cancéreuses, et elle ne bloque pas l’activité des récepteurs d’androgènes. Mais de nouvelles variantes de cette thérapie pourraient remédier à ces lacunes Les combinaisons de médicaments qui agissent sur ces processus ont considérablement amélioré la survie des personnes atteintes d’un cancer métastatique de la prostate et, plus important encore, les patients tolèrent ces traitements plus intensifs. Les nouvelles normes prescrivent donc des combinaisons de deux, voire trois molécules. Des médicaments comme le docétaxel, utilisé en chimiothérapie, et d’autres nouveaux, bloquent la production de testostérone par les glandes surrénales ou les cellules cancéreuses, ou interfèrent avec l’activité des récepteurs androgéniques Combinés à l’hormonothérapie classique, ils ont considérablement amélioré la survie des patients

Une autre thérapie consiste à identifier les cellules cancéreuses exprimant le PSMA et à les détruire à l’aide d’une molécule pharmaceutique radioactive injectable qui cible spécifiquement le PSMA présent à leur surface et laisse intactes la plupart des cellules saines L’Agence américaine des produits alimentaires (FDA) et médicamenteux a approuvé cette molécule, le lutécium 177 (commercialisée sous le nom de Pluvicto), pour le traitement du cancer de la prostate devenu résistant à d’autres formes d’hormonothérapie et de chimiothérapie [en France, la molécule a obtenu l’autorisation de mise sur le marché en 2022, ndlr]. Il est probable qu’elle deviendra une thérapie importante même pour les stades plus précoces de la maladie.

L’analyse du génome des patients et des tumeurs a également contribué à la réduction des symptômes et à l’allongement de la durée de vie. En effet, certaines mutations génétiques connues pour augmenter le risque de cancer du sein et de l’ovaire sont aussi associées à un risque accru de cancer de la prostate Le dépistage de ces mutations est de plus en plus courant, et on ajoute au traitement des patients qui en sont porteurs des thérapies spécifiques qui bloquent leurs effets délétères, ce qui améliore les résultats obtenus. Il est par ailleurs essentiel de comprendre le type de mutation impliqué , tant pour

les patients que pour les membres de leur famille . Les mutations dites « germinales » sont celles que le patient a héritées de ses parents biologiques. Elles touchent toutes les cellules de l’organisme et sont transmissibles à ses enfants. Une mutation « somatique », en revanche, n’est pas héritée et se développe dans le cancer lui-même. Les thérapies ciblées conçues spécifiquement pour corriger les effets des unes ou des autres ont amélioré la longévité des patients de façon notable

Les mutations des gènes BRCA, associées à l’apparition précoce de cancers du sein et de l’ovaire, sont parmi les plus connues de celles qui favorisent la genèse de tumeurs. Lorsque des chercheurs ont étudié la survenue de cancers dans des familles présentant de telles mutations, ils ont découvert de nombreux cas de cancer de la prostate. Ce constat a conduit à la découverte qu’elles apparaissaient à la fois chez les hommes et chez les femmes de ces familles Ces mutations modifient la façon dont l’ADN est réparé, ce qui introduit des défauts susceptibles d’entraîner la formation d’un cancer

BIBLIOGRAPHIE

F. C. Hamdy et al., Fifteen-year outcomes after monitoring, surgery, or radiotherapy for prostate cancer, N. Engl. J. Med., 2023.

K. Fizazi et al., Rucaparib or physician’s choice in metastatic prostate cancer, N. Engl. J. Med., 2023.

K. Zhang et al., Prostate cancer screening in Europe and Asia, Asian Journal of Urology, 2017.

Depuis, des médicaments ont été mis au point pour traiter les cancers liés aux mutations de gènes BRCA. Plusieurs de ces médicaments, appartenant à une classe de molécules appelée « inhibiteurs de l’enzyme Parp », ont récemment reçu l’approbation de la FDA pour être utilisés comme traitement chez les personnes porteuses d’une telle mutation [ en France, la Haute autorité de santé a émis un avis favorable en 2021, ndlr]. Cette recherche a permis de généraliser les tests génétiques chez les patients atteints de cancer de la prostate et, lorsque des mutations germinales sont détectées, d’offrir un conseil génétique aux familles

Toutes ces avancées ont eu lieu au cours de la dernière décennie, une période incroyablement courte en oncologie. Et les nouvelles stratégies mises en œuvre ont déjà commencé à transformer le cancer de la prostate, autrefois rapidement mortel, en une maladie chronique avec laquelle les patients vivent pendant des années, voire aussi longtemps que le prévoit leur espérance de vie n

L’ESSENTIEL

> Des chercheurs se penchent sur l’hypothèse que notre monde ne serait qu’une simulation informatique, créée par des êtres situés dans une réalité supérieure.

> Certains arguments tirés de la physique tendent à confirmer

cette hypothèse… alors que d’autres mènent à la conclusion opposée.

> Physiciens, informaticiens et philosophes explorent des pistes pour tenter de formaliser ce questionnement de manière rigoureuse.

L’AUTEUR

JEAN-PAUL DELAHAYE professeur émérite à l’université de Lille et chercheur au laboratoire Cristal

De récents travaux reprennent et affinent les raisonnements du philosophe suédois Nick Bostrom qui, il y a vingt ans, estimait probable que notre réalité soit en fait une simulation informatique menée par une civilisation avancée.

Sommes - nous des marionnettes dont les fils sont tenus par des êtres supérieurs, qui nous auraient programmés dans leurs superordinateurs ? La question est bien plus sérieuse qu’on ne l’imagine, et au-delà des nouvelles, livres ou films de science - fiction , des dizaines d’articles ont traité le sujet, écrits par des philosophes ou des scientifiques, y compris les plus prestigieux Des travaux présentés récemment par de très sérieux chercheurs canadiens et prenant en compte la nature quantique de notre monde reformulent les raisonnements développés il y a vingt ans par le philosophe suédois Nick Bostrom Les premiers raisonnements aboutissaient à une évaluation proche de 100 % pour la probabilité que nous soyons dans une simulation conduite au sein d’ordinateurs

appartenant à une civilisation avancée. La nouvelle étude du problème produit des formules plus précises, mais malheureusement, selon la valeur des paramètres qui y apparaissent, elles confirment les conclusions de Nick Bostrom ou s’y opposent franchement Le problème est devenu plus scientifique et riche, et s’il reste pour l’instant difficile d’en tirer une conclusion définitive, le travail entrepris est fascinant et donne à réfléchir Bien entendu, la nature proprement scientifique des discussions autour de cette question est parfois discutable Il faut accepter, pour se plonger dans cette littérature, de concevoir l’exercice comme un jeu intellectuel entremêlant la physique, la philosophie et les romans de science-fiction

La question posée est : quelle est la probabilité que nous vivions dans une simulation qui serait menée sur les machines d’une civilisation

Certains indices concrets pourraient nous aider à déterminer si nous vivons dans une simulation informatique engendrée par des êtres supérieurs. Par exemple, des « défauts » au sein de notre réalité (comme des dysfonctionnements difficilement explicables sur des écrans d’ordinateurs) pourraient faire partie de ces indices.

supérieure ayant atteint la capacité technique de produire et de faire fonctionner des modèles informatiques de l’univers entier avec ses éventuels habitants ? L’utilité de ces simulations dont nous serions les jouets et qui feraient du monde que nous percevons une illusion serait, pour cette civilisation, de mieux comprendre et résoudre certains problèmes de physique, de théorie de l’évolution, de psychologie ou de sociologie. Ou peut-être ces expériences seraient-elles liées à des questions que nous ne pouvons même pas imaginer. Les êtres à l’origine de notre existence seraient analogues aux chercheurs qui, ici, sur Terre, étudient la circulation routière en créant des logiciels qui la simulent, dans le but de comprendre comment surviennent les embouteillages ou l’effet d’une réduction des vitesses maximales autorisées sur les risques d’accidents.

L’idée que notre monde serait une illusion n’est pas nouvelle. On en trouve une première forme chez Platon avec le mythe de la caverne et plus récemment chez René Descartes qui, dans

Dans le roman Simulacron 3 de Daniel Galouye (1964), Douglas Hall travaille sur un projet de simulation si réaliste que les êtres virtuels qui y évoluent pensent vivre dans un monde réel. Mais en raison d’événements troublants advenant autour de ce projet, le héros commence à soupçonner que son propre monde n’est qu’une simulation, créée dans un niveau supérieur de réalité.

la première de ses Méditations métaphysiques, parue en 1641, émet l’hypothèse que tout ce qui est autour de nous pourrait être une tromperie créée par un « diable ». Ce « doute radical » s’impose et plaît à Descartes car il en déduit qu’« il n’est en [son] pouvoir de parvenir à la connaissance d’aucune vérité » Il explique qu’il imagine « un mauvais génie, non moins rusé et trompeur que puissant, qui a employé toute son industrie à [le] duper » et qui fait que « le ciel, l’air, la terre, les couleurs, les figures, les sons et toutes les choses extérieures [qu’il voit] ne sont que des illusions dont il se sert pour surprendre [sa] crédulité ». La science-fiction, bien évidemment, s’est aussi emparée de ce thème, et dès 1964 l’auteur américain Daniel Galouye en fait le sujet central de son excellent roman Simulacron 3, où le héros comprend progressivement qu’il n’est pas dans un vrai monde, mais dans un univers fictif créé par un ordinateur Bien d’autres récits et films , dont la fameuse trilogie Matrix, explorent cette idée d’une réalité totalement illusoire. Plus étonnant peut-être, cette hypothèse et éventuellement sa réfutation sont l’objet d’une discussion

acharnée dans le monde de la philosophie, et ce depuis un étonnant article de Nick Bostrom de 2003. Le philosophe, actuellement chercheur à la Macrostrategy Research Initiative, s’intéresse, outre l’hypothèse de la simulation, à un certain nombre de thèmes en lien avec les sciences fondamentales, comme l’intelligence artificielle ou encore le principe anthropique. Son article de 2003 a été cité plus de 1 500 fois, et la discussion qu’il a lancée se poursuit aujourd’hui sans relâche, avec de nombreux articles publiés chaque année sur ce thème. En particulier, il est remarquable que Gilles Brassard, l’un des co-inventeurs de la cryptographique quantique, dont le nom circule depuis plusieurs années pour le prix Nobel de physique, se soit penché de près sur ces questions En 2021, il a cosigné, avec son collègue de l’université de Montréal Alexandre BibeauDelisle, un article publié dans les Proceedings de la Royal Society de Londres, dans lequel les deux chercheurs réexplorent le raisonnement probabiliste de Nick Bostrom en 2003. Ils prennent en compte la possibilité des ordinateurs quantiques, et formulent leur raisonnement dans un cadre de physique théorique plus précis. Ils ajoutent aussi l’idée d’éventuelles « simulations récursives », c’est-à-dire créées par des êtres qui seraient eux-mêmes déjà dans une simulation Nous allons rappeler le raisonnement de Nick Bostrom, puis nous présenterons brièvement les idées d’Alexandre Bibeau-Delisle et Gilles Brassard.

Conçu par Nick Bostrom en 2001 et publié en 2003, le raisonnement suivant, que nous présentons succinctement , est le point de départ des nouveaux travaux probabilistes et physiques sur le problème de la simulation

Si toute civilisation dans le cosmos ne finit pas par s’autodétruire avant d’avoir acquis une technologie suffisante pour mener des simulations globales incluant des êtres intelligents et conscients de la même nature que nous, alors il est possible que des civilisations disposant de tels moyens procèdent à un très grand nombre de simulations de ce type, donnant « naissance » à des êtres fictifs, intelligents et conscients, en très grand nombre Dans ce cas, ces êtres fictifs des réalités simulées seront bien plus nombreux que les êtres réels de la réalité de base Si l’on accepte ces hypothèses, il en résulte donc que la probabilité que nous soyons dans une simulation est très élevée, et sans doute proche de 100 % Ainsi, nous sommes presque certainement dans une simulation. Suivant cet argumentaire, il n’y aurait alors qu’une alternative, dont les deux issues sont aussi troublantes l’une que l’autre : soit notre civilisation se détruira elle-même parce que

Dans une nouvelle étude du problème de la simulation, les deux physiciens canadiens Alexandre Bibeau-Delisle et Gilles Brassard adoptent l’idée que les phénomènes quantiques ne peuvent être simulés e cacement qu’en exploitant des ressources informatiques quantiques. Ils y ajoutent les hypothèses suivantes :

(a) À une certaine échelle, l’espacetemps devient discret.

(b) La densité d’information dans le monde est finie.

(c) La gravité ne remettra pas gravement en cause la mécanique quantique.

Dans un premier calcul, ils envisagent qu’il existera des systèmes de calculs d’une puissance de 1050 OPS/kg (opérations par seconde et par kilogramme) – une valeur classique due au physicien spécialiste des systèmes complexes Seth Lloyd, qui résulte de considérations de physique fondamentale. Ils estiment que la masse utilisée pour simuler les cerveaux d’un monde virtuel sera un milliard de fois plus faible que celle des cerveaux réels ; une valeur plus grande renforcerait la conclusion. Sachant qu’un cerveau réel a une puissance d’environ 1016 OPS et une masse d’environ 1,4 kg, il en résulte que pour chaque cerveau réel, on pourrait simuler jusqu’à 1050 × 1,4 / (109 × 1016) = 1,4 × 1025 cerveaux fictifs, en ordre de grandeur. La proportion de cerveaux simulés parmi tous les cerveaux serait alors d’environ 1,4 × 1025 / (1,4 × 1025 + 1), soit un nombre très proche de 1 Ce résultat conforte l’idée de Nick Bostrom selon laquelle nous sommes plus probablement dans une

Réalités simulées

Réalités simulées de niveau 2

Etc.

simulation que dans un monde réel. Plus précisément, la formule générale donnant cette probabilité est : RCal = (MBraMUseDMat/PBra ) / ((MBraMUseDMat / PBra ) + 1) où :