ÉMISSIONS DE CO2

La traque des sources

MÉTÉO EXTRÊME

La vraie part du réchauffement

DOMESTICATION 50 ans d’aquaculture, et maintenant ? DOM : 8,50 € –BEL./LUX. : 8,50 € –CH : 12,70 FS –CAN. 12,99 $CA –PORT. CONT. 8,50 € – MAR. : 78 DH –TOM : 1 100 XPF Édition française de Scientific American –Juin 2023n° 548 POUR LA SCIENCE 06/23 La perspective de Fabrice Teletchea biologiste L 13256548F: 7,00 €RD LA

DE LA CLIMATOLOGIE Neurosciences AUX ORIGINES DU SENS INNÉ DES NOMBRES Mathématiques LE PIÈGE DES ALGORITHMES GALACTIQUES Histoire des sciences CHIEN-SHIUNG WU, LA VARIABLE CACHÉE DE L’INTRICATION

NOUVELLE ÈRE

Directrice des rédactions : Cécile Lestienne

MENSUEL POUR LA SCIENCE

Rédacteur en chef : François Lassagne

Rédacteurs en chef adjoints : Loïc Mangin, Marie-Neige Cordonnier

Rédacteurs : François Savatier, Sean Bailly

HORS-SÉRIE POUR LA SCIENCE

Rédacteur en chef adjoint : Loïc Mangin

Développement numérique : Philippe Ribeau-Gésippe

Community manager et partenariats : Aëla Keryhuel aela.keryhuel@pourlascience.fr

Directrice artistique : Céline Lapert

Maquette : Pauline Bilbault, Raphaël Queruel, Ingrid Leroy, Ingrid Lhande

Réviseuses : Anne-Rozenn Jouble, Maud Bruguière et Isabelle Bouchery

Assistant administratif : Bilal El Bohtori

Responsable marketing : Frédéric-Alexandre Talec

Direction du personnel : Olivia Le Prévost

Fabrication : Marianne Sigogne et Stéphanie Ho

Directeur de la publication et gérant : Nicolas Bréon

Ont également participé à ce numéro : Laure Bonnaud-Ponticelli, Christophe Corona, Hippolyte Dourdent, Séverine Duparcq, Shalom Eliahou, Didier Swingedouw, Grace Thomas

PUBLICITÉ France

stephanie.jullien@pourlascience.fr

ABONNEMENTS

www.boutique.groupepourlascience.fr

Courriel : serviceclients@groupepourlascience.fr

Tél. : 01 86 70 01 76

Du lundi au vendredi de 8 h 30 à 12 h 30 et de 13 h 30 à 16 h 30

Adresse postale :

Service abonnement

Groupe Pour la Science

235 avenue Le-Jour-se-Lève

92 100 Boulogne-Billancourt

Tarifs d’abonnement 1 an (12 numéros)

France métropolitaine : 59 euros – Europe : 71 euros

Reste du monde : 85,25 euros

DIFFUSION

Contact kiosques : À Juste Titres ; Alicia Abadie

Tél. 04 88 15 12 47

Information/modification de service/réassort : www.direct-editeurs.fr

DISTRIBUTION

MLP

ISSN 0 153-4092

Commission paritaire n° 0927K82 079

Dépôt légal : 5636 – Juin 2023

N° d’édition : M077 0548-01

www.pourlascience.fr

170 bis boulevard du Montparnasse – 75 014 Paris

Tél. 01 55 42 84 00

SCIENTIFIC AMERICAN

Editor in chief : Laura Helmut

President : Kimberly Lau 2023. Scientific American, une division de Springer Nature America, Inc.

Soumis aux lois et traités nationaux et internationaux sur la propriété intellectuelle. Tous droits réservés. Utilisé sous licence. Aucune partie de ce numéro ne peut être reproduite par un procédé mécanique, photographique ou électronique, ou sous la forme d’un enregistrement audio, ni stockée dans un système d’extraction, transmise ou copiée d’une autre manière pour un usage public ou privé sans l’autorisation écrite de l’éditeur. La marque et le nom commercial «Scientific American» sont la propriété de Scientific American, Inc. Licence accordée à «Pour la Science SARL».

© Pour la Science SARL, 170 bis bd du Montparnasse, 75014 Paris.

En application de la loi du 11 mars 1957, il est interdit de reproduire intégralement ou partiellement la présente revue sans autorisation de l’éditeur ou du Centre français de l’exploitation du droit de copie (20 rue des Grands-Augustins, 75006 Paris).

Origine du papier : Autriche

Taux de fibres recyclées : 30 %

« Eutrophisation » ou « Impact sur l’eau » : Ptot 0,007 kg/tonne

DITO É

Imprimé en France

Maury Imprimeur SA Malesherbes

N° d’imprimeur : 270 257

TOUS COMPTES FAITS

Dans son dernier rapport d’évaluation, le Groupe d’experts intergouvernemental sur l’évolution du climat (Giec) mentionne que des « avancées majeures en science de l’attribution » rendent mature et solide cette discipline, dont l’objectif est de quantifier la part du réchauffement climatique dans les événements météorologiques extrêmes. En 2013, le Giec déclarait que cette science n’était pas encore « adaptée à l’objectif visé ». Dix ans plus tard, les rapports se multiplient, à l’initiative de communautés de climatologues. Ils montrent qu’ici le réchauffement a rendu 50 % plus intenses les pluies accompagnant un ouragan, là 9 fois plus probables de redoutables incendies saisonniers… La climatologie ne se contente plus de comprendre la machinerie climatique : elle fait les comptes. Et la comptabilité qu’elle établit s’intéresse autant aux conséquences du réchauffement qu’aux émissions de gaz à effet de serre (GES) qui en sont à l’origine. En combinant inventaires déclaratifs et mesures atmosphériques, il est désormais possible de traquer les émissions de GES à l’échelle des territoires.

Dire qui émet quoi, et ce que telle catastrophe doit au réchauffement, facilite l’action juridique. En 2021, déjà, en Nouvelle-Galles du Sud (Australie), un rapport des scientifiques réunis au sein de la World Weather Attribution, liant changement climatique et fréquence des incendies, a servi de socle à une injonction faite au gouvernement de réduire les émissions de gaz à effet de serre.

Ce changement d’ère de la climatologie fait écho aux climatologues et spécialistes de la biodiversité rassemblés dans le mouvement Scientist Rebellion. Ceux-ci appellent, comme le relève l’économiste de l’environnement Catherine Aubertin, « à une décroissance d’urgence, rompant ainsi avec la posture non prescriptive qui est la leur au sein du Giec ».

Les passerelles entre la science visant la seule connaissance et celle nourrissant l’ambition de transformer les modes de vie ne sont pas nouvelles ; les naturalistes explorateurs du XVIIIe siècle se sont mués peu à peu en promoteurs de techniques d’élevage plus performantes, qui, plus tard poussées à l’extrême, ont réduit la biodiversité des espèces domestiquées en même temps qu’augmentaient les rendements des systèmes agricoles. Notre dossier spécial sur la domestication, réalisé en partenariat avec le Muséum national d’histoire naturelle, l’illustre avec clarté. n

POUR LA SCIENCE N° 548 / JUIN 2023 / 3

François Lassagne Rédacteur en chef

OMMAIRE s

ACTUALITÉS GRANDS FORMATS

P. 6

ÉCHOS DES LABOS

• La théorie des graphes, l’invitée surprise des soirées

• La paléogénétique fait aussi parler les objets

• Les plantes ne souffrent pas en silence

• De l’air pollué au cancer

• L’IRM bat des records

• L’impact global de la fonte de la glace antarctique

• L’angle magique du graphène continue de surprendre

P. 18

LES LIVRES DU MOIS

P. 20 DISPUTES

ENVIRONNEMENTALES Y aura-t-il un septième rapport du Giec ?

Catherine Aubertin

P. 22

LES SCIENCES À LA LOUPE

Des pairs fatigués d’évaluer

Yves Gingras

P. 58

ARCHÉOLOGIE

AUX RACINES DE LA DOMESTICATION

Jean-Denis Vigne

Et la domestication fut ?

La nouvelle histoire des relations entre humains et non-humains que dessine l’archéologie depuis une trentaine d’années suggère un tout autre scénario…

P. 64

HISTOIRE DES SCIENCES

LE GRAND BOND UTILITARISTE

Cécile Callou et Clémence Pagnoux

Si la naissance de l’élevage et de l’agriculture remonte à 15 000 ans, la domestication ne s’est réellement intensifiée qu’il y a 300 ans.

P. 48

COGNITION

COMPTER AVANT DE PARLER

P. 72

HISTOIRE DES SCIENCES

LETTRE D’INFORMATION

NE MANQUEZ PAS

LA PARUTION DE VOTRE MAGAZINE

GRÂCE À LA NEWSLETTER

• Notre sélection d’articles

• Des offres préférentielles

• Nos autres magazines en kiosque Inscrivez-vous

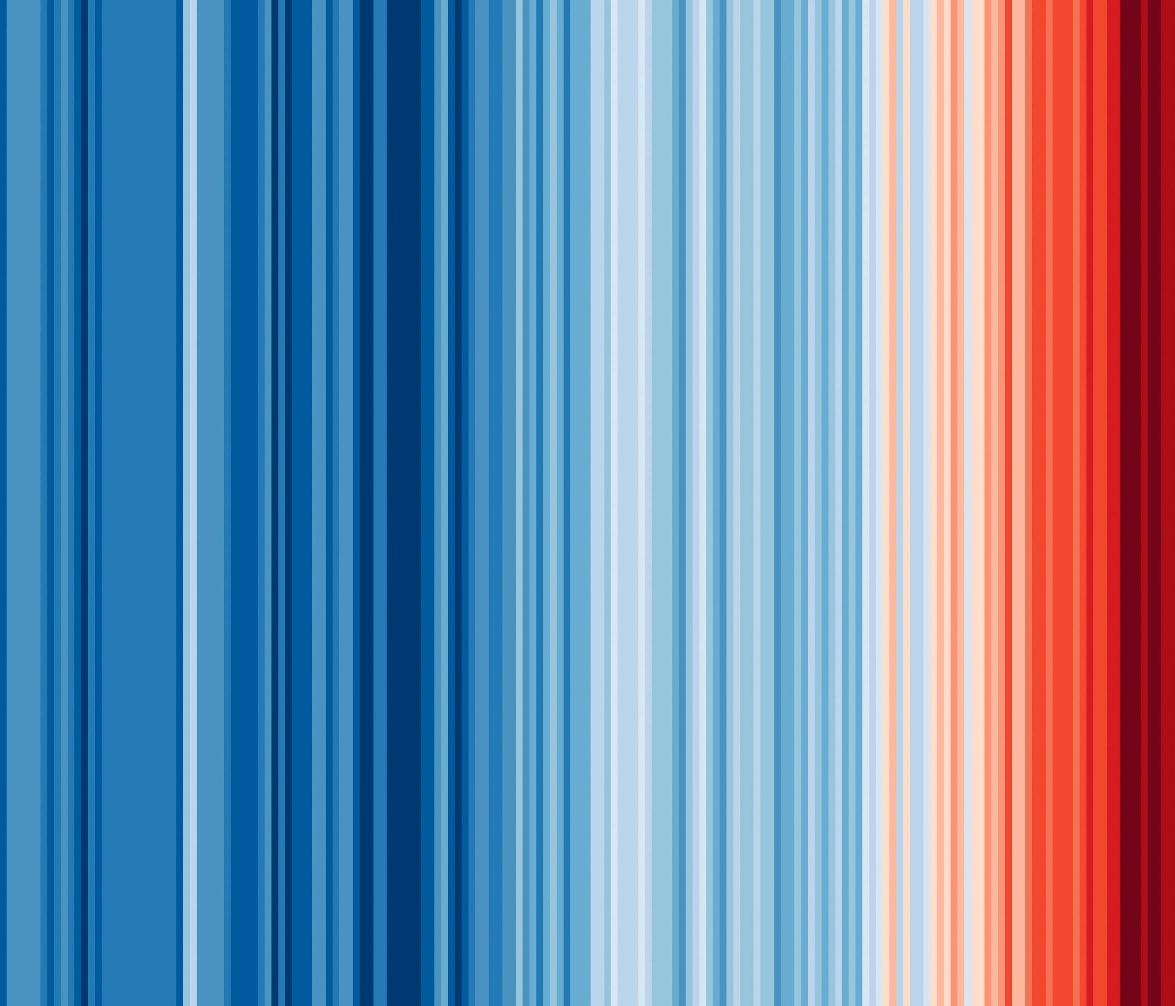

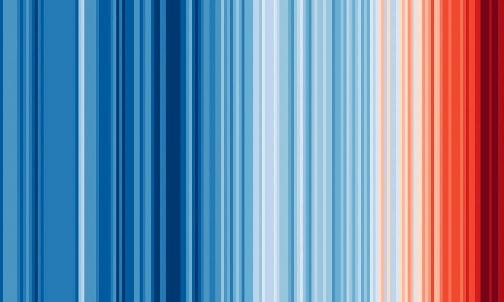

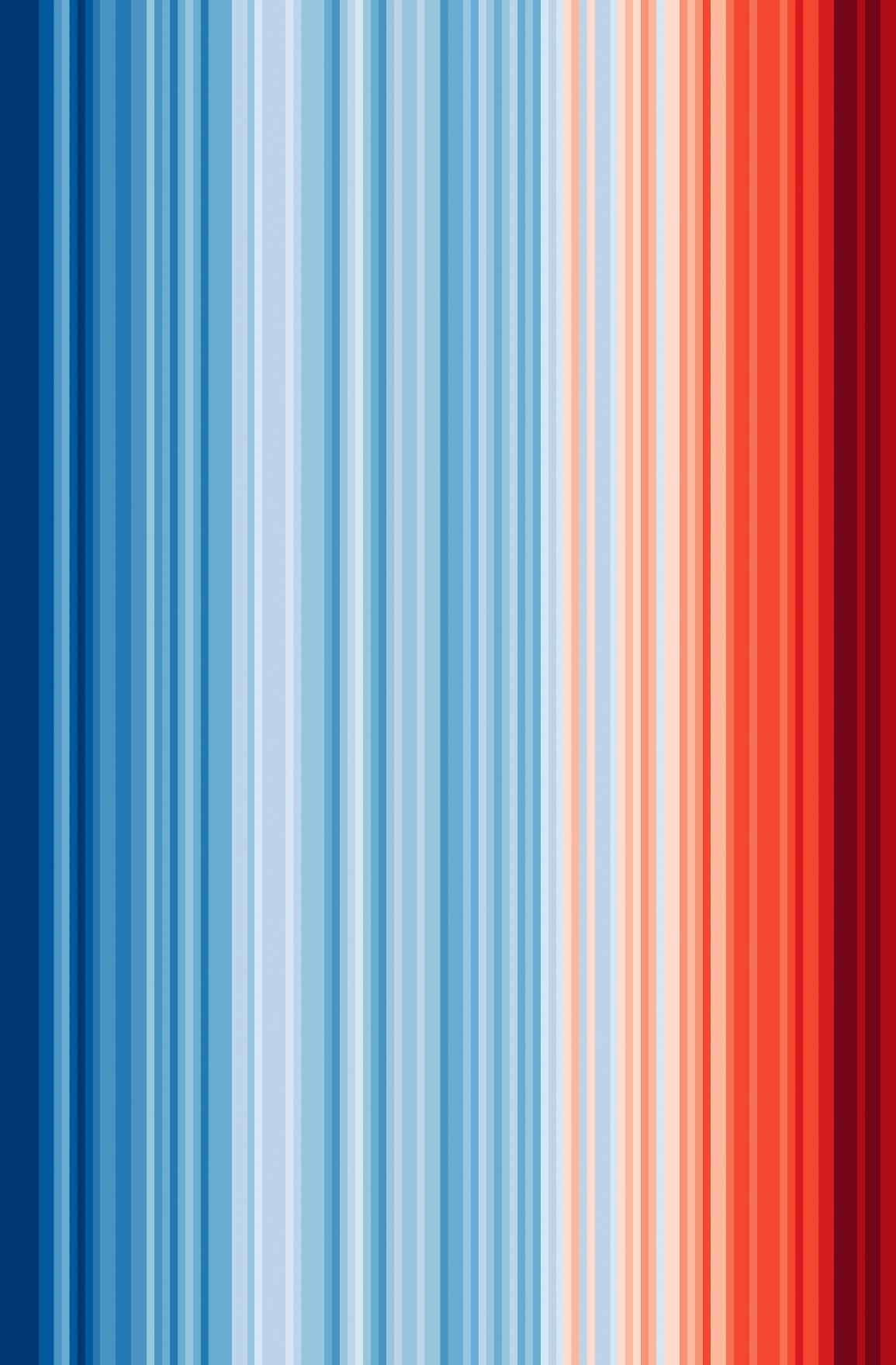

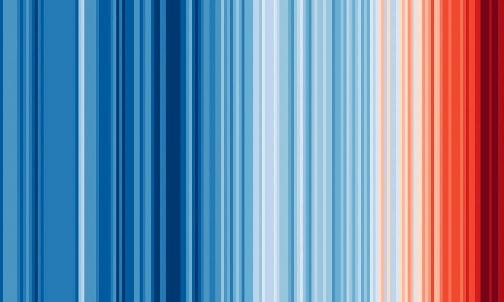

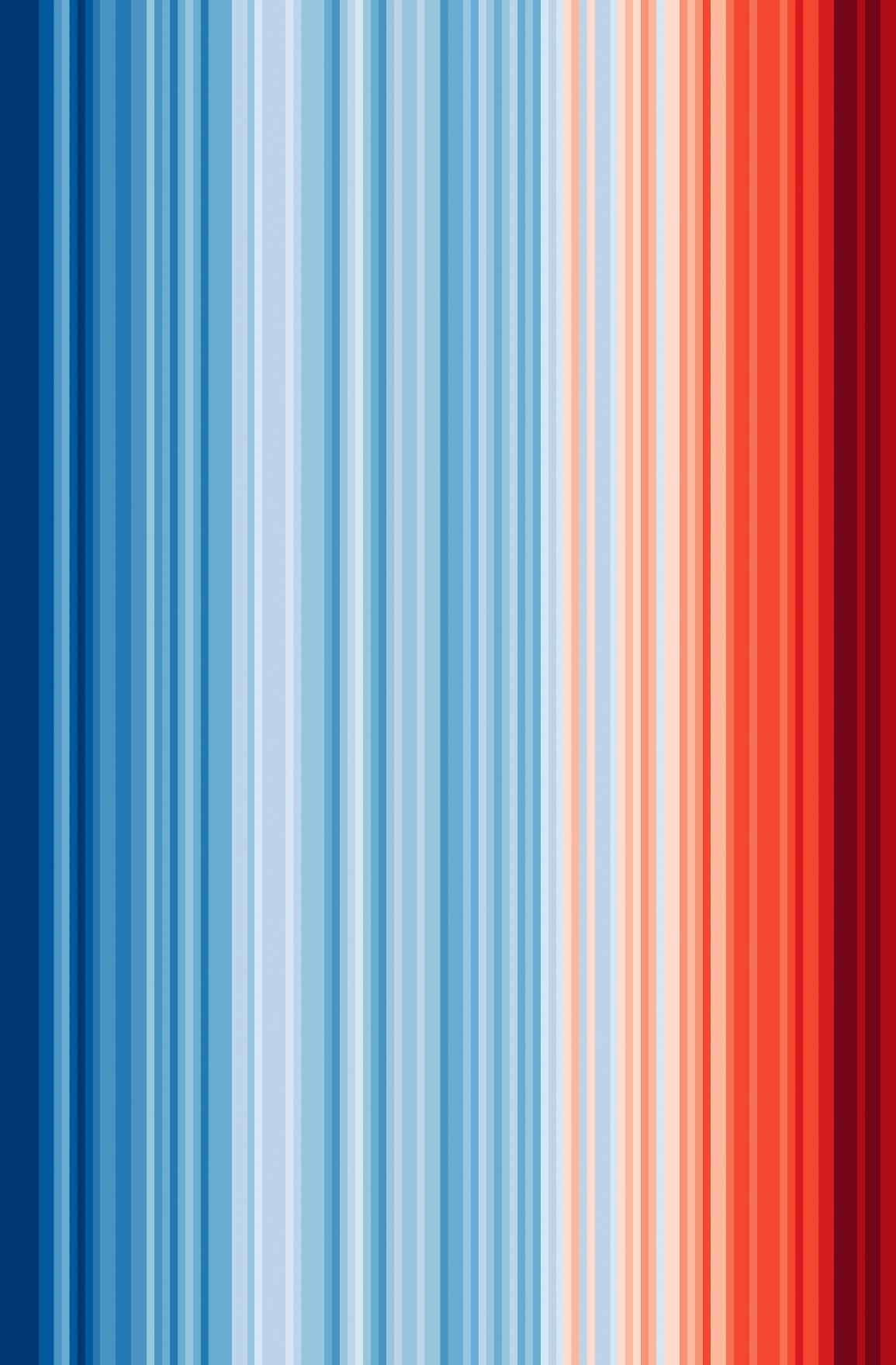

En couverture : © Ed Hawkins, université de Reading, https://showyourstripes.info/ © Hervé Cohonner (auteur)

Les portraits des contributeurs sont de Seb Jarnot

Ce numéro comporte un courrier de réabonnement posé sur le magazine sur une sélection d’abonnés.

Jacob Beck et Sam Clarke

Tout petits, les bébés comparent déjà les nombres, les mémorisent, s’y intéressent… Une capacité aujourd’hui considérée comme innée, et sur laquelle les apprentissages vont s’appuyer tout au long du développement de l’enfant.

LA VARIABLE CACHÉE DE L’INTRICATION QUANTIQUE

Michelle Frank

En menant une expérience sur des paires de photons, la physicienne Chien-Shiung Wu a inspiré plusieurs générations successives de chercheurs dans la quête pour comprendre l’intrication quantique. Une influence presque oubliée…

4 / POUR LA SCIENCE N° 548 / JUIN 2023

fr N° 548 /

www.pourlascience.fr

Juin 2023

DOSSIER SPÉCIAL : QUELLES DOMESTICATIONS POUR LE XXIe

P. 68

BIOLOGIE ANIMALE

CINQUANTE ANS D’AQUACULTURE, ET MAINTENANT ?

Fabrice Teletchea

En un demi-siècle, l’élevage des poissons a produit l’équivalent de plusieurs millénaires de domestication des animaux terrestres Ce qui interroge nos pratiques actuelles et futures…

P. 24 LA NOUVELLE ÈRE DE LA CLIMATOLOGIE

RENDEZ-VOUS

P. 80

LOGIQUE & CALCUL L’EFFICACITÉ TROMPEUSE DES ALGORITHMES GALACTIQUES

Jean-Paul Delahaye

Une méthode de calcul peut être la meilleure en théorie, mais totalement inutile pour toute application dans le monde réel

P. 86

ART & SCIENCE

Le castor, artiste en résilience

Loïc Mangin

P. 26

CLIMATOLOGIE

MÉTÉO EXTRÊME : LA JUSTE PART DU RÉCHAUFFEMENT CLIMATIQUE

Lois Parshley

Après des années de tâtonnements, les climatologues déterminent désormais très vite la part due au changement climatique dans les catastrophes naturelles

P. 37

ENVIRONNEMENT

ÉMISSIONS MONDIALES : UN BUDGET CARBONE DÉSÉQUILIBRÉ

Andrea Thompson

Les pays occidentaux ont émis beaucoup plus de carbone depuis le début de l’ère industrielle, rapporté à leur population, que le seuil à ne pas dépasser pour limiter la hausse des températures à 1,5 °C.

P. 40

PHYSIQUE DE L’ATMOSPHÈRE

P. 88

IDÉES DE PHYSIQUE

De la glace comme du verre

Jean-Michel Courty et Édouard Kierlik

P. 92

CHRONIQUES DE L’ÉVOLUTION

De curieuses chimères chez les fourmis folles

Hervé Le Guyader

P. 96

SCIENCE & GASTRONOMIE

Mangerons-nous du bois ?

Hervé This

P. 98 À PICORER

« ON SAIT ESTIMER

LES ÉMISSIONS D’UNE VILLE AU MOIS PRÈS »

Entretien avec Thomas Lauvaux

L’efficacité des plans de lutte contre le réchauffement climatique passe par la mesure des réductions des émissions de gaz à effet de serre effectivement réalisées. Or cette évaluation reste entachée d’importantes incertitudes

De nouvelles méthodes pourraient cependant changer la donne.

POUR LA SCIENCE N° 548 / JUIN 2023 / 5

SIÈCLE ?

MATHÉMATIQUES

LA THÉORIE DES GRAPHES, L’INVITÉE SURPRISE DES SOIRÉES

P

P

Lors d’une soirée, il est toujours amusant d’établir les relations entre les uns et les autres. Le genre de questions qui intéressent les mathématiciens spécialistes des graphes.

Un problème di cile en théorie des graphes, qui s’applique aux relations dans un groupe, vient de connaître une avancée inattendue.

Ramsey, qui s’est intéressé au problème dès les années 1920.

«

Vous vous connaissez ? », question classique lors d’une soirée avec de nombreux invités venant d’horizons variés. Pour les mathématiciens, les fêtes sont aussi l’occasion de jouer avec la théorie des graphes. Si l’on représente les n invités comme n nœuds d’un graphe et que chaque nœud est connecté à tous les autres, on obtient un graphe complet. L’idée est alors de colorier les liens entre les nœuds, en rouge si les deux individus se connaissent, en bleu s’ils se rencontrent pour la première fois. Dans un groupe de n invités, trouvera-t-on un sous-groupe de k invités qui soit se connaissent tous, soit ne se connaissent pas du tout ? Si n est très grand par rapport à k , il est presque évident qu’on trouvera toujours k personnes qui se

connaissent ou k personnes qui ne se connaissent pas. La question intéressante est alors : pour un k donné, quel est le plus petit n tel que ces conditions de

£

connaissances/non-connaissances sont satisfaites ? Cette valeur minimale de n par rapport à k, notée R(k), est nommée « nombre de Ramsey », d’après Frank

De façon étonnante, la réponse est connue pour k = 2, 3 et 4, mais pas pour k = 5 et plus. Le calcul devient vite trop difficile, même pour un supercalculateur Or Julian Sahasrabudhe, de l’université de Cambridge, et ses collègues viennent de proposer une avancée qui donne une borne supérieure au nombre de Ramsey

Pour k = 2, la réponse est évidente : avec deux invités, soit ils se connaissent, soit ils ne se sont jamais croisés . Autrement dit, R(2) = 2. Pour k = 3, il faut six invités. On peut le vérifier en testant tous les graphes possibles , soit 215 = 32 768 graphes (15 étant le nombre d’arêtes du graphe complet à six nœuds). En revanche, avec seulement cinq invités, on peut colorier le graphe de sorte qu’il n’est pas possible d’avoir trois personnes qui se connaissent ou trois personnes qui ne se connaissent pas. Ce contre-exemple est assez facile à trouver : dans ce graphe, chaque invité connaît exactement deux

6 / POUR LA SCIENCE N° 548 / JUIN 2023

P. 6 Échos des labos

. 18 Livres du mois

. 20 Disputes environnementales

ÉCHOS DES LABOS

P. 22 Les sciences à la loupe

En reliant chacun des n invités à tous les autres, on obtient un graphe complet comptant n nœuds £

© Monkey Business Images/Shutterstock

autres invités, qui eux ne se connaissent pas. Le nombre de Ramsey R(3) est donc égal à 6. Pour k = 4, c’est déjà plus compliqué , mais la réponse est connue depuis 1955 grâce à Robert Greenwood et Andy Gleason qui ont établi que R(4) = 18.

Les choses se corsent à partir de k = 5. On ne connaît pas la valeur exacte de R (5), mais juste un encadrement. Dès 1935, Paul Erdős et George Szekeres ont exhibé une formule pour majorer le nombre de Ramsey, R(k) < 4k , une majoration dite « exponentielle » , car la variable k est en exposant En 1947, Paul Erd ő s a aussi proposé une formule de minoration . Au cours des soixantequinze années qui ont suivi, ces formules ont connu diverses améliorations. Ainsi, depuis 2017 et les travaux de Brendan McKay, on sait que R (5) est compris entre 43 et 48. Ensuite, R(6) est compris entre 102 et 165, R(7) entre 205 et 540, etc Les intervalles grandissent très vite Mais on comprend la difficulté . Pour R(5), il faudrait vérifier tous les graphes complets à 43 nœuds dont les arêtes sont coloriées avec deux couleurs Cela correspondrait à près de 2 903 graphes à considérer, ce qui est hors de portée des ordinateurs les plus puissants.

Si on ne peut pas calculer les nombres de Ramsey, peut-être peut-on améliorer leur encadrement Les mathématiciens cherchaient ainsi à majorer R(k) par une formule exponentielle Ck, où C est plus petit que 4. Or, c’est ce que viennent de réussir Julian Sahasrabudhe et ses collègues : R(k) < (4 – ε)k pour ε très petit L’amélioration semble infime , mais à mesure que k augmente, cette correction prend de l’importance . De nombreux scientifiques avaient exploré cette voie sans parvenir à la démontrer.

La prudence reste de mise, l’article a pour l’instant été rendu public sur le site arXiv, il doit encore passer l’épreuve de l’évaluation par les pairs. David Conlon, de Caltech , spécialiste du sujet , est confiant dans la robustesse de l’approche utilisée Mais pour les chercheurs, le plus important avec ce résultat est que la barrière psychologique posée par le « 4 » est maintenant levée et ouvre la porte à d’encore meilleures améliorations ! n

Sean Bailly

Sean Bailly

La paléogénétique fait aussi parler les objets

Mise au point à l’institut Max-Planck d’anthropologie évolutionnaire de Leipzig, une méthode révèle les gènes du principal utilisateur humain d’un objet ancien. Marie Soressi, qui a codirigé le projet, évoque son principe et ses enjeux.

Marie Soressi, professeuse de préhistoire à l’université de Leyde, au Pays-Bas.

Pourquoi s’intéresser aux gènes de qui a porté un pendentif dans la grotte de Denisova, en Sibérie, au Paléolithique supérieur ?

Prouver, comme nous l’avons fait, qu’une femme sapiens a porté ce pendentif façonné dans une dent d’élan a une implication sociale. Et, sans l’ADN, comment faire ? Toutefois, nous avons surtout apporté la preuve que de l’ADN ancien piégé dans les pores de l’os peut être étudié. Or les sites préhistoriques ont déjà livré des milliers d’artefacts réalisés à partir d’os et de dents, de sorte que nous pouvons désormais espérer pouvoir les lier à qui les a façonnés ou à un utilisateur principal, et, par là, apporter des éléments de réponse à nombre de questions anthropologiques.

Comment fonctionne la procédure que vous avez mise au point ?

Nous avons en quelque sorte appliqué le principe des cycles de température de la machine à laver. Après un lavage préliminaire, l’objet est placé dans des bains de phosphate de sodium pour trois triples temps d’extraction, d’abord à 21 °C, ensuite à 60 °C et finalement à 90 °C. Le phosphate de sodium est un puissant « attracteur » de molécules d’ADN. Comme la température fragilise les liaisons entre l’hydroxyapatite de l’os et les molécules d’ADN, ces dernières se retrouvent libres.

Le phosphate de sodium pénètre dans les pores de l’os et attire les molécules libres, qui se retrouvent en solution.

La progression en température permet de concentrer dans le bain à 21 °C surtout l’ADN du cervidé, puis dans les bains à 60 °C et à 90 °C aussi l’ADN humain. Une fois cette extraction faite, des amorces chimiques permettent de sélectionner les brins d’ADN ancien humain, puis de les séquencer et de reconstituer le génome par bio-informatique.

Cette dernière partie de la procédure est-elle la même que celle,

bien maîtrisée, qu’on utilise déjà pour séquencer de l’ADN contenu dans des échantillons d’os réduit en poudre ?

Exactement. Et mes collègues paléogénéticiens disent que la qualité de lecture de l’ADN issu des pores d’un objet en os se compare à celle qu’on atteint déjà à partir d’échantillons paléolithiques d’os réduits en poudre.

Dès lors, nous allons pouvoir étudier l’ADN piégé dans les centaines de milliers d’objets issus des fouilles anciennes ?

Hélas non, ou alors, nous aurions une chance inouïe, car les objets issus des fouilles anciennes ont été touchés des milliers de fois, et sont vraisemblablement ultracontaminés avec des ADN divers, à commencer par ceux des fouilleurs…

La méthode s’applique donc surtout aux artefacts issus des fouilles actuelles ?

Oui, et son existence doit en changer les pratiques ! Sans obliger les fouilleurs à travailler à l’avenir en tenue de cosmonaute, le port de gants et la mise en sécurité immédiate sous sac étanche devraient, dans la plupart des cas, su re à sauver l’information génétique. En plus, vous aurez remarqué que la méthode n’est pas destructive : elle donne des informations supplémentaires, mais les objets restent étudiables autrement. C’est pourquoi nous pouvons espérer bientôt beaucoup d’informations inédites sur qui faisait quoi avec tel ou tel objet… Et puis, moins on recule dans le temps, plus il reste d’objets poreux en matières organiques… C’est une énorme mine d’informations sur une période allant du Paléolithique au Néolithique à… peut-être même la période historique.

Aurons-nous aussi des informations sur les personnes assassinées ou leurs assassins ?

Dans le cadre de la police scientifique ? Je ne sais pas. Nous avons déjà été approchés par des gens très intéressés par cette possibilité, mais nous n’avons pas développé notre méthode pour ça. n

POUR LA SCIENCE N° 548 / JUIN 2023 / 7

M. Campos et al., en ligne arXiv:2303.09521, 2023.

PALÉOANTHROPOLOGIE

Propos recueillis par François Savatier

E. Essel et al., Nature, en ligne le 3 mai 2023.

© Université de Leyde

BIOLOGIE VÉGÉTALE

LES PLANTES NE SOUFFRENT PAS EN SILENCE

Quand elles manquent d’eau ou sont blessées, les plantes « crépitent » : les ultrasons qu’elles produisent sont audibles à plusieurs mètres.

Contrairement aux idées reçues depuis l’Antiquité, de nombreuses observations montrent que les plantes sont loin d’être passives par rapport à leur environnement. Une nouvelle découverte renforce ce constat. Itzhak Khait, de l’université de Tel-Aviv, en Israël, et ses collègues viennent d’observer qu’elles émettent des sons détectables à distance – des sortes de clics très courts à des intervalles apparemment aléatoires. En condition de stress (déshydratation ou tige coupée), les plantes produisent entre 30 et 50 clics par heure, alors qu’elles sont presque silencieuses en conditions favorables. En outre, les chercheurs sont capables de distinguer les sons émis par di ff érentes espèces et selon les caractéristiques du stress.

Itzhak Khait et ses collègues ont surtout étudié des plants de tabac (Nicotiana tabacum) et de tomate (Solanum lycopersicum). Ils ont d’abord capté pendant une heure les sons entre 20 et 150 kilohertz ( kHz ) en plaçant des microphones à 10 centimètres de la plante dans des petits caissons acoustiques, sans bruit de fond Certaines plantes n’avaient pas été arrosées depuis cinq jours, d’autres avaient eu la tige coupée, d’autres étaient maintenues en bonne santé Les biologistes ont détecté des sons dans le domaine des ultrasons, entre 20 et 100 kHz, inaudibles pour une oreille humaine – nous entendons jusqu’à environ 16 kHz. Le volume est comparable à celui d’une conversation humaine.

Grâce à un algorithme d’intelligence artificielle, ils identifient les sons émis selon les espèces, le type et le niveau de stress qu’elles subissent avec une précision de 84 %.

Sans conclure sur l’origine biophysique des sons émis, les chercheurs évoquent une forte corrélation entre leur nombre et la transpiration de la plante par ses stomates, de petits orifices présents dans les feuilles chargés de réguler les échanges gazeux entre la plante et l’atmosphère De même, ils supposent qu’une partie de ces sons est due au phénomène de cavitation (liée à des bulles d’air dans le système vasculaire où circule la sève), mais de futurs travaux devront le confirmer Et si leur étude ne permet pas d’en déduire que toutes

3 à 5 mètres

LES CRÉPITEMENTS DES PLANTES SERAIENT PERCEPTIBLES SUR QUELQUES MÈTRES AVEC UN DISPOSITIF ADAPTÉ À LA FRÉQUENCE D’ÉMISSION.

les plantes font du bruit, ils constatent que c’est le cas pour le blé (Triticum aestivum), le maïs (Zea mays), le raisin (Vitis vinifera), un cactus (Mammillaria spinosissima) et un lamier (Lamium amplexicaule)

« Ce travail expérimental rigoureux a le mérite de soulever de nouvelles questions , constate Adelin Barbacci, chercheur à l’Inrae : quelles sont les causes biologiques, les mécanismes à l’origine de ces sons ? Quelle est la signature spectrale de chaque plante ? Est-ce que les plantes voisines perçoivent ces sons ? Sont-elles capables de les analyser aussi finement que les algorithmes d’apprentissage profond utilisés ici ? Des animaux comme des rongeurs, des chauves-souris, des insectes les entendent-ils et à quoi leur servent ces informations ? » En attendant, les auteurs proposent que ces informations soient exploitées par les agriculteurs ou les horticulteurs pour évaluer le besoin en eau des plantes n

Isabelle Bellin

8 / POUR LA SCIENCE N° 548 / JUIN 2023 ÉCHOS DES LABOS © Université de Tel-Aviv

Des micros sont installés autour d’un cactus pour enregistrer les sons émis par la plante.

I. Khait et al., Cell, 2023.

Les Vikings, les pieds dans l’eau

En 985, le Viking Erik le Rouge fonda une colonie au Groenland. Mais au XVe siècle, celle-ci disparut soudainement. Les historiens avancent diverses explications : changement climatique, crise économique, guerre… Marisa Borreggine, de l’université Harvard, et son équipe proposent un nouveau facteur ayant aggravé une situation déjà fragile. Une hausse locale du niveau de la mer de 3 mètres aurait inondé les terres agricoles indispensables à la survie de ces populations.

PNAS, 17 avril 2023.

Recyclage de l’époxy

Le secteur éolien fait face à une question importante : comment recycler les pales arrivées en fin de vie dont les déchets totaliseront des millions de tonnes d’ici à 2050 ? Ces pales sont constituées de résine époxy, un matériau réputé di cile à recycler. Or, en utilisant un catalyseur à base de ruthénium, l’équipe autour d’Alexander Ahrens, de l’université d’Aarhus, au Danemark, a réussi à casser certaines liaisons carbone-oxygène de la résine. Reste à développer à grande échelle ce processus.

Nature, 26 avril 2023.

Les nombreux arbres hors des forêts

La déforestation est une mauvaise nouvelle pour la lutte contre le réchau ement climatique. Pour aider à mieux protéger les forêts, Florian Reiner, de l’université de Copenhague, et ses collègues ont recensé tous les arbres du continent africain grâce à la constellation de nanosatellites PlanetScope. Petite surprise : 29 % des arbres sont situés en dehors des zones forestières, dans des prairies ou sur des terres cultivées.

Nature Communications, 2 mai 2023.

MÉDECINE

DE L’AIR POLLUÉ AU CANCER

La responsabilité de la pollution de l’air dans la multiplication des cas de cancer du poumon chez des non-fumeurs est bien établie. Cependant, le mécanisme biologique qui la sous-tend n’était pas encore mis au jour. La vision traditionnelle du cancer est que l’exposition à certaines molécules provoque des mutations qui s’accumulent et conduisent à la formation d’une tumeur. Mais le mécanisme mis en évidence ici par William Hill et ses collègues, de l’institut Francis Crick, à Londres, diffère de ce schéma.

Ici aussi, une première étape implique des mutations dans les cellules épithéliales des poumons . Mais ces mutations , seules , ne conduisent pas à une prolifération incontrôlée des cellules, même quand elles touchent le gène EGFR, impliqué dans la croissance des cellules. Dans une deuxième étape, la pollution par des particules fines, d’un diamètre inférieur à 2,5 micromètres, ou PM2,5, crée une inflammation du tissu pulmonaire Celle-ci favorise alors la prolifération des cellules porteuses de mutations Plus précisément, c’est l’action des macrophages du système immunitaire en réponse à la présence des particules fines qui

COMMENT LES PIEUVRES GOÛTENT

PAR LE TOUCHER

Le poulpe chasse grâce à ses huit bras qui s’infiltrent dans la moindre crevasse. Mais, comportement étonnant, après avoir touché certaines proies, le céphalopode décide de les rejeter. Nicholas Bellono, de l’université Harvard, aux États-Unis, et ses collègues ont découvert que les ventouses de la pieuvre sont tapissées de récepteurs sensibles au goût.

Ces récepteurs s’apparentent à des récepteurs nicotiniques du système nerveux impliqués dans le contrôle de la contraction des muscles Or, chez le poulpe, ces récepteurs ont subi des changements structurels au cours de l’évolution, leur conférant une fonction inédite de récepteur sensoriel chimiotactile . Plus précisément, le domaine de liaison du ligand, la région du récepteur à laquelle se lie la

est en cause Ces macrophages émettent un composé , une interleukine notée IL 1 β , qui déclenche la multiplication de cellules porteuses d’une mutation sur EGFR.

Chez la souris, l’utilisation d’anticorps antiIL1β suffit à réduire la formation tumorale. En s’inspirant de ce résultat, « on peut imaginer, en ciblant les personnes les plus à risque, des interventions nutritionnelles, puisqu’il a été montré que la consommation de certains antioxydants diminuerait l’expression de l’IL1β », suggère Isabella Annesi-Maesano, de l’Inserm. n

Noëlle Guillon

Les ventouses des bras des poulpes ont des récepteurs chimiotactiles qui leur permettent de goûter et sélectionner leurs proies.

molécule de signal qui lui correspond, a pris une forme qui lui permet de se lier à davantage de molécules non solubles dans l’eau, comme les résidus graisseux laissés sur les fonds marins par des proies potentielles n

William Rowe-Pirra

POUR LA SCIENCE N° 548 / JUIN 2023 / 9

ÉVOLUTION

D’après Airparif, les particules fines PM2,5 proviennent pour moitié du secteur résidentiel et pour un quart du transport routier.

W. Hill et al., Nature, 2023.

C. Allard et al., Nature, 2023 ; G. Kang et al., ibid.

© NadyGinzburg/Shutterstock

EN BREF

(en haut) ; © Anik Grearson (en bas)

P. 26 CLIMATOLOGIE

MÉTÉO EXTRÊME : LA JUSTE PART DU RÉCHAUFFEMENT CLIMATIQUE

P. 37 ENVIRONNEMENT

ÉMISSIONS MONDIALES : UN BUDGET CARBONE DÉSÉQUILIBRÉ

P. 40 PHYSIQUE DE L’ATMOSPHÈRE « ON SAIT ESTIMER LES ÉMISSIONS D’UNE VILLE AU MOIS PRÈS »

avec Thomas Lauvaux

LA NOUVELLE ÈRE DE LA CLIMATOLOGIE

Les climatologues maîtrisent aujourd’hui des méthodes qui les rendent capables à la fois de quantifier la part du réchauffement climatique dans la survenue d’événements météorologiques extrêmes et de traquer les sources de gaz à effet de serre à l’échelle des territoires, en temps quasi réel.

24 / POUR LA SCIENCE N° 548 / JUIN 2023

Entretien

© sumberarto/Shutterstock

;

https://showyourstripes.info/ POUR LA SCIENCE N° 548 / JUIN 2023 / 25

© Ed Hawkins, université de Reading,

MÉTÉO EXTRÊME

La juste part du réchauffement climatique

Après des années de tâtonnements, les climatologues déterminent désormais très vite la part due au changement climatique dans les catastrophes naturelles.

LOIS PARSHLEY

LOIS PARSHLEY

26 / POUR LA SCIENCE N° 548 / JUIN 2023 CLIMATOLOGIE

POUR LA SCIENCE N° 548 / JUIN 2023 / 27

© Miriam Martincic

L’ESSENTIEL L’AUTRICE

> Juste après la sécheresse doublée d’une canicule de la fin 2022 en Argentine, un groupe de chercheurs a déterminé la part de ce phénomène météorologique extrême attribuable au réchau ement climatique.

> La World Weather Attribution, qui a conduit cette analyse, est une alliance de chercheurs

créée pour mettre en œuvre les progrès d’une nouvelle science : l’attribution climatique.

> Cette science est considérée aujourd’hui par le Giec comme capable de calculer de façon fiable les e ets météorologiques du réchau ement climatique. Ses méthodes commencent à se di user largement.

LOIS PARSHLEY journaliste scientifique indépendante

Pour beaucoup de Sud-Américains, l’été commence au début du mois de décembre : le soleil s’attardant, il devient temps d’organiser des asados dans le jardin – c’est-à-dire des grillades. Le 7 décembre dernier, toutefois , ce n’était guère praticable , puisque la température régnant à la frontière entre la Bolivie et le Paraguay a dépassé les 45 °C, et, en Argentine, s’est approchée des 40 °C Comme, de plus, une sécheresse sévissait depuis trois ans, la chaleur a achevé de brûler les immenses champs de blé de cette partie du monde… Pendant que, pour affronter la canicule, le gouvernement argentin limitait les exportations de blé et invitait sa population à

Des avancées majeures rendent la science de l’a ribution mature £

climatologie, visant à déterminer la part attribuable au changement climatique de ce type d’événements

La WWA illustre la capacité croissante des chercheurs à quantifier très vite le rôle du changement climatique dans les phénomènes météorologiques extrêmes Les progrès de la science de l’attribution climatique sont susceptibles d’avoir des implications dans nombre de domaines, du secteur de l’assurance aux négociations internationales sur le financement de l’adaptation au changement climatique.

Friederike Otto espère que les analyses de l’alliance qu’elle a cofondée montreront aux gouvernements pourquoi il est si vital de réduire les émissions de gaz à effet de serre Pour signaler que le réchauffement climatique aggrave un événement particulier, et dans quelle mesure, l’alliance s’est donné pour principe de publier un rapport présentant une réponse claire avant que l’événement en question ne soit oublié Par là, elle souhaite informer les médias, les urbanistes, la protection civile, les décideurs et tous ceux que concerne la préparation du retour inéluctable d’une catastrophe similaire ; et – ambition considérable ! – le faire pratiquement alors que le phénomène est toujours en cours

Ce texte est une adaptation de l’article Blame Game, publié par Scientific American en juin 2023.

rester à la maison, plusieurs membres de la World Weather Attribution (WWA) se sont réunis par visioconférence Cette organisation est une alliance de chercheurs rassemblée par le physicien Geert Jan van Oldenborgh (19612021) et par la climatologue Friederike Otto, pour analyser les événements météorologiques extrêmes ( c’est- à - dire d’intensité et/ou de durée inhabituelles) du monde entier Cette activité que l’on nomme en anglais attribution science – « science de l’attribution climatique » en français – est une nouvelle branche de la

En 2021, moins d’une semaine après l’installation d’un dôme de chaleur au-dessus du nord-ouest des États-Unis, la WWA a minutieusement analysé le phénomène à partir des enregistrements météorologiques, et publié un rapport très complet L’alliance avançait qu’il semblait impossible que les températures observées eussent existé en l’absence de réchauffement climatique anthropique, ajoutant qu’elles se situaient « très en dehors du spectre observé historiquement » Puis, lorsque au printemps dernier des pans entiers de l’Inde et du Pakistan souffrirent d’une chaleur assez

28 / POUR LA SCIENCE N° 548 / JUIN 2023 CLIMATOLOGIE MÉTÉO EXTRÊME : LA JUSTE PART DU RÉCHAUFFEMENT CLIMATIQUE

forte pour menacer la vie humaine, la WWA calcula que le changement climatique avait rendu les vagues de chaleur plus chaudes et plus probables dans cette partie du monde. Quand cette canicule fut suivie à la fin de l’été dernier par des inondations si considérables qu’elles recouvrirent d’eau près de 10 % de la surface du Pakistan, l’alliance estima que les effets du changement climatique avaient pu augmenter les précipitations de 50 %.

De telles estimations sont une nouveauté Dans les années 2010, de nombreux climatologues hésitaient encore à affirmer que le réchauffement climatique contribuait à tel ou tel événement Ainsi, tant la solidité avec laquelle on sait faire aujourd’hui la part du réchauffement climatique dans les phénomènes météorologiques extrêmes que la vitesse avec laquelle on la détermine sont des progrès considérables. « Le niveau de compétence a radicalement changé », se réjouit Friederike Otto depuis son bureau de l’université d’Oxford, où la climatologue enseigne sa discipline.

De fait, en 2014 encore, attribuer tout ou partie d’un phénomène météorologique au changement climatique impliquait un lent et difficile chemin : il fallait parfois plus d’un an pour qu’un article sur l’attribution climatique passe le cap de l’examen par les pairs. C’est bien pourquoi , très tôt , Friederike Otto a amené la WWA à renoncer à la publication scientifique pour se concentrer sur la réalisation efficace d’analyses approfondies, rapidement suivies par la communication au public d’une synthèse des résultats. Une idée raisonnable, puisque dans son dernier rapport publié en 2021, le Groupe d’experts intergouvernemental sur l’évolution du climat (Giec) mentionne que des « avancées majeures en science de l’attribution » la rendent mature et solide Or en 2013 encore, le même groupe d’experts déclarait au contraire que cette science n’était pas encore « adaptée à l’objectif visé »

L’ANNÉE OÙ TOUT A COMMENCÉ

2004 est importante pour la science de l’attribution climatique , puisque c’est cette année-là – quelque dix-huit mois après l’événement – que fut publiée l’analyse d’un des premiers cas flagrants de phénomène météorologique où le changement climatique joua un rôle : la vague de chaleur européenne d’août 2003. La canicule entraîna des récoltes médiocres, une fonte de 10 % de la masse des glaciers alpins et plus de 30 000 morts prématurées à travers l’Europe , dont environ 15 000 en France Peter Stott, l’auteur principal de l’article, dirige le Centre Hadley pour la recherche et la prévision climatique , en Grande - Bretagne . Il suggérait que la part anthropique de la vague de chaleur avait au moins doublé son ampleur À l’époque ,

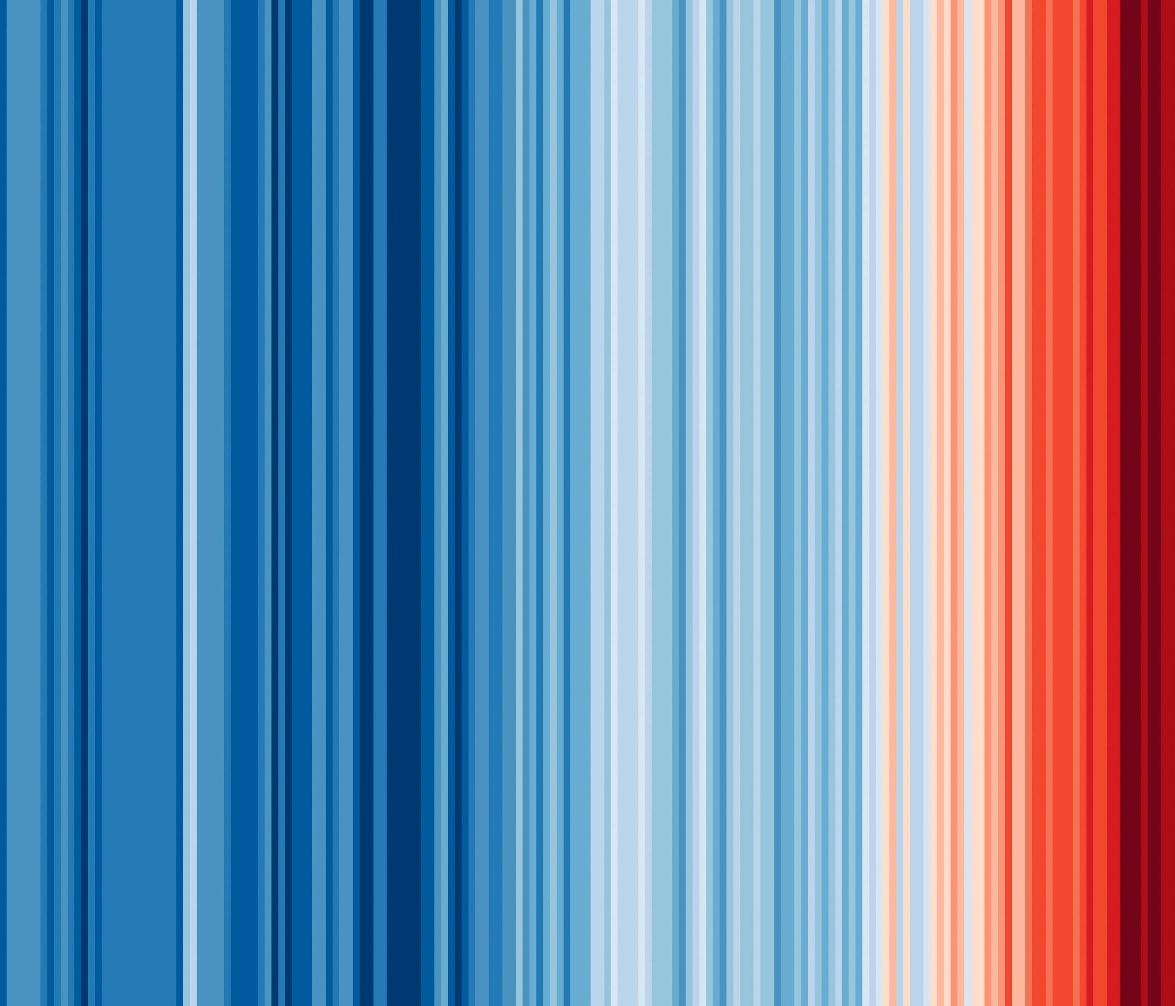

LES ACTIVITÉS HUMAINES AGGRAVENT LA MÉTÉO

Depuis 2004, les chercheurs ont réalisé des centaines d’études d’attribution climatique. Dans l’ensemble, 71 % de ces travaux montrent que le changement climatique a aggravé les phénomènes météorologiques d’intensité et/ou de durées inhabituelles (points rouges) ; il n’a rendu que 9 % des phénomènes météorologiques moins graves ou moins fréquents (points bleus) Le réchau ement climatique a aussi aggravé les canicules dans 93 % des cas, la sécheresse dans 69 % des cas et la pluie ou les inondations dans 56 % des cas.

Ci-dessous, les événements météorologiques sont regroupés par type et chaque point représente une étude. Celles qui furent réalisées très vite – les « évaluations rapides » – sont hachurées. Les dates donnent les années de publication. Ces données relatives à 431 études allant jusqu’en mai 2022 proviennent de Carbon Brief, un site web basé au Royaume-Uni consacré à l’activité climatique.

RÉSULTATS

Plus grave ou plus probable Pas d’e et climatique perceptible Données insu isantes ou non concluantes Moins grave ou probable

2004 (Date de publication des résultats)

Chaleur

Pluies et inondations

Sécheresse

Froid, neige et glace

Tempêtes Incendies

Les événements apparaissant moins de 10 fois dans la base de données de Carbon Brief, tels que le blanchiment de coraux ou des inondations, sont omis.

POUR LA SCIENCE N° 548 / JUIN 2023 / 29 © Voilà: ; source : R. Pidcock et R. McSweeney, Mapped: How climate change affects extreme weather around the world, Carbon Brief, 2022

2022 2018 2014

E ets océaniques

explique Stephanie Herring, climatologue à la NOAA , l’Agence américaine d’observation océanique et atmosphérique, cet aspect de la question semblait un « détail », et ne préoccupait guère les physiciens de l’atmosphère et autres spécialistes des probabilités d’événements météorologiques Lorsque Stephanie Herring s’est mise à préparer pour la Société américaine de météorologie un rapport sur les événements extrêmes, « personne ne s’attendait à tant d’intérêt dans le public »

En octobre 2012, la sensibilité publique s’accrut encore lorsque l’ouragan Sandy frappa New York et le New Jersey. Comment une telle tempête avait- elle pu frapper aussi loin au nord ? Publiées plusieurs mois après Sandy, les analyses montrèrent qu’en début d’année, une quantité excessive de banquise avait fondu créant en Arctique de vastes étendues de mer libre, capables d’absorber la chaleur du soleil L’énergie absorbée avait sans doute contribué à la fureur de Sandy, mais cette possibilité ne fut pas présentée comme une théorie plausible. Les chercheurs tendent à être prudents, le plus prudents possible, ce qui les pousse à sous-estimer les phénomènes climatiques, commente Kevin Trenberth , un chercheur émérite au Centre national américain de recherche atmosphérique. En 2012, ils répugnaient encore à envisager sérieusement un impact du changement climatique sur telle ou telle tempête.

Dans les années qui suivirent, la mise en évidence de l’impact du réchauffement climatique profita de progrès techniques Ainsi, alors qu’au début des années 2000, peu d’organismes de recherche disposaient des gros calculateurs nécessaires au fonctionnement des simulations climatiques extrêmement gourmandes en données, l’informatique dans les nuages, c’est-àdire l’emploi de serveurs distants pour stocker des masses de données pendant le calcul, changea la donne Elle rendit les chercheurs capables de faire exécuter des calculs à partir de leurs ordinateurs portables Il devint ainsi possible de combiner des simulations et de les faire tourner plusieurs fois, ce qui accroissait la confiance dans les résultats La précision et la résolution spatiale des modèles s’étaient aussi beaucoup améliorées, ce qui rendait possible l’étude de lieux spécifiques. Dans le cours de leurs travaux, les chercheurs ont développé deux méthodes d’attribution de phénomènes météorologiques au changement climatique. La première, l’« attribution probabiliste d’événements », vise à estimer dans quelle mesure les activités humaines contribuent à la probabilité qu’un certain type d’événement se produise, par exemple une vague de chaleur Les chercheurs y comparent les prédictions des modèles de dynamiques météorologiques extrêmes avec ou sans climat plus chaud, ce qui met en évidence l’influence

DAVANTAGE DE CHALEUR, DE PLUIE, MOINS DE SOLEIL

Neuf études de cas détaillées démontrent que le changement climatique d’origine anthropique a des e ets météorologiques extrêmes, qu’il s’agisse par exemple des récentes

précipitations intenses en Californie, de la sécheresse persistante en Iran ou de la diminution de l’ensoleillement sur le plateau tibétain, qui y réduit la croissance végétative. Les résultats

1,5 fois plus probable à cause de l’influence humaine

Pluies excessives (GB)

Précipitations records (Chine du Nord)

Réduction de l’ensoleillement (Plateau tibétain)

Incendies (Afrique du Sud)

Sécheresse persistante (Iran)

Vague de chaleur record (Corée du Sud)

Températures élevées et faibles précipitations (Californie et Nevada)

Record de chaleur (Asie du Sud-Est)

Vague de chaleur marine (Pacifique du Nord-Ouest)

Moins probable Plus probable

L’Argentine a été touchée par d’importants feux de forêts en 2022 (à gauche, dans la province de Corrientes), liés à des températures inhabituelles (approchant 40 °C en décembre), survenant après trois ans de sécheresse. Le risque d’incendies saisonniers en Australie (à droite, Sydney dans la fumée en 2019) serait 9 fois plus grand à cause du réchauffement climatique, selon la WWA.

publiés en 2021 et 2022 dans le Bulletin de la société américaine de météorologie quantifient l’influence de l’activité humaine sur les probabilités des phénomènes météorologiques extrêmes.

La canicule a engendré des températures océaniques records, entraînant des e lorescences d’algues toxiques autour du Japon, lesquelles ont endommagé gravement les écosystèmes marins du pays. L’influence humaine a rendu cette canicule 43 fois plus probable.

43 Intervalle de confiance de 90 à 95 %

30 / POUR LA SCIENCE N° 548 / JUIN 2023 CLIMATOLOGIE MÉTÉO EXTRÊME : LA JUSTE PART DU RÉCHAUFFEMENT CLIMATIQUE

PHÉNOMÈNES MÉTÉOROLOGIQUES EXTRÊMES

1,6 1,7 1,9 2,2 4 4,1 11

© Voilà: ; source : Explaining extreme events of 2021 and 2022 from a climate perspective, Bull. Am. Meteor. Soc. Spec. Coll., 2022

de certains facteurs, comme l’augmentation des émissions de gaz à effet de serre, sur la probabilité d’un phénomène ( lire l’encadré page 34 ). Dans le premier rapport qu’elle publia, la WWA comparait par exemple les températures dans cinq villes de France lors de la vague de chaleur en 2015 avec les étés du début des années 1900, mettant en évidence que le réchauffement climatique avait quadruplé les chances d’occurrence d’une vague de chaleur La deuxième méthode, « l’approche narrative », consiste à poser puis à répondre à des questions concrètes à propos de tel ou tel événement météorologique Par exemple : le changement climatique a - t- il augmenté les précipitations de telle tempête ?

À la WWA , on compare l’approche narrative à une sorte d’« autopsie de l’événement », qui met en évidence les évolutions de l’atmosphère, par exemple les changements de taux de vapeur d’eau en un lieu et un moment donnés . Les scientifiques pratiquant l’une ou l’autre de ces méthodes ont peu à peu pris conscience de leur complémentarité. « Chacune d’elles apporte des informations importantes sur les risques associés au réchauffement climatique », souligne Elisabeth Lloyd, membre de l’Académie américaine des arts et des sciences Tandis que l’approche narrative indique aux décideurs politiques si les routes et les ponts résisteront ou pas à des précipitations intenses, l’approche probabiliste aide la protection civile à estimer à quelle fréquence les tempêtes les obligeront à interdire l’accès à ces routes et à ces ponts

En 2017, la science de l’attribution climatique progressa encore, après que l’ouragan Harvey eut séjourné des jours durant dans la région de Houston , déversant plus de 1 500 millimètres d’eau en certains lieux, ce qui constituait un record jamais atteint ! Dans un article de 2018, Kevin Trenberth souligna

que l’évaporation supérieure à la normale des eaux très chaudes du golfe du Mexique avait conduit à ces précipitations inouïes Friederike Otto calcula de son côté que le réchauffement climatique avait ajouté quelque 15 % à ces précipitations Kevin Trenberth tira de ces résultats la conclusion que dans les zones subissant des ouragans, les autorités devraient s’adapter à des inondations de plus en plus importantes en améliorant les voies d’évacuation , les normes de construction et la conception des réseaux électriques

LE DÉFI ARGENTIN

Cette position suscita des réactions critiques : les climatologues devraient se cantonner à faire de la recherche et s’abstenir de parler des implications de leurs résultats Un point de vue que Friederike Otto, à qui on a déjà reproché d’être trop politique, rejette : « Les chercheurs neutres n’existent pas : les questions que nous nous posons découlent de nos valeurs, sont déterminées par ceux qui nous financent et par là où nous vivons C’est en rendant les choses transparentes que l’on fait de la bonne science , et pas en faisant comme si rien ne se passait. »

Lors de la création de la WWA en 2014, l’alliance n’écrivait que quelques rapports

POUR LA SCIENCE N° 548 / JUIN 2023 / 31 ©

baismartin/Shutterstock (à gauche) ; © M. W. Hunt/Shutterstock (à droite)

L’approche narrative est une sorte d’autopsie de l’événement météo £

THOMAS LAUVAUX

est titulaire de la chaire de professeur junior CASAL (Carbon Across Scales And Landscapes), de l’université de Reims-ChampagneArdenne. Il a développé des modèles atmosphériques dits d’« inversion », qui, à partir des équations de la physique des fluides et des mesures de composés atmosphériques, relient les sources d’émission de gaz à e et de serre aux quantités de ces gaz dans l’atmosphère.

On sait estimer les émissions d’une ville au mois près

La plupart des plans de lutte contre le réchauffement climatique établissent des objectifs de réduction des émissions de gaz à effet de serre. Connaître l’efficacité de ces plans passe par la mesure des réductions effectivement réalisées. Or l’évaluation des émissions réelles reste encore entachée d’importantes incertitudes. De nouvelles méthodes pourraient cependant changer la donne.

40 / POUR LA SCIENCE N° 548 / JUIN 2023 PHYSIQUE DE L’ATMOSPHÈRE

© Julien Debant, L’Hebdo du Vendredi

D’où viennent les informations sur les émissions de gaz à effet de serre ?

Les informations les plus fiables aujourd’hui viennent des statistiques publiques nationales. La France, par exemple, tient le compte précis de ses importations et exportations. Dans ces relevés figurent les millions de tonnes de pétrole, de gaz, de charbon que l’on importe. Nous disposons de statistiques renseignant tous les types d’activités, du point de vue de l’énergie Le bilan carbone des achats nationaux de gaz ou de pétrole, a priori très précis (on sait suivre les stocks de pétrole depuis l’espace) doit être corrigé en faisant des approximations sur les fuites du système logistique Les énergies renouvelables importées compliquent un peu les choses Si la France achète de l’électricité aux Pays-Bas, par exemple, cette dernière peut être issue de centrales solaires ou à gaz… La part de biocarburant, la nature de ces biocarburants, pas toujours connues précisément, induisent d’autres incertitudes, car il est difficile d’estimer la quantité de CO2 émise pour un litre consommé L’évaluation des émissions liées aux systèmes de chauffage est, elle aussi, dépendante de la fiabilité des données sur le rendement des chaudières ou des convertisseurs d’énergie S’agissant des biens, s’il est possible de calculer le bilan carbone de ce que nous produisons et exportons, c’est beaucoup plus aléatoire pour celui des marchandises importées Finalement, les marges d’erreur sont donc élevées. Néanmoins, dans les pays développés, le bilan carbone national peut être estimé avec quelques pourcents d’erreur – entre 3 et 5 % pour la France Mais dans certains pays, la barre d’erreur atteint 20, voire 30 %.

Si les bilans carbone nationaux sont estimés avec quelques pourcents d’erreur, n’est-ce pas un problème pour le suivi des politiques de réduction des émissions ?

En effet La mise en application des stratégies nationales de réduction des émissions de gaz à effet de serre se traduit actuellement par des diminutions de quelques pourcents par an. Si vous avez une barre d’erreur de 30 %, vous êtes incapable de savoir si vous êtes sur une dynamique de décroissance ou en croissance Pour l’évaluation des politiques publiques , c’est terrible Même une erreur de 3 %, pour la France, signifie qu’il faut attendre au moins deux ou trois ans avant de confirmer une décroissance ou une croissance des émissions Cette année, notre pays a annoncé – 2,5 % d’émissions de CO2 en 2022 par rapport à 2021. C’est crédible : dans le contexte de la guerre en Ukraine, d’importants efforts de réduction des consommations d’énergie fossile ont été faits –et les énergies renouvelables ont pu aussi contribuer à cette baisse. Mais en réalité, ce pourcentage est équivalent à la marge d’erreur du bilan carbone national. Cette difficulté à estimer de manière fiable les effets de politiques climatiques est manifeste au niveau national, et s’accentue encore à plus petite échelle, car il est très compliqué d’attribuer les émissions à un territoire donné

Quelles sont les difficultés à cette petite échelle ?

Prenons l’exemple des émissions du trafic automobile On peut s’appuyer sur les chiffres d’une station-service. On sait que les voitures sont venues, elles ont consommé tant de litres d’essence dans la région, mais on ne sait pas où

Entre 2019 et 2020, l’instrument Tropomi, à bord du satellite Sentinel-5P, a rendu possible la mesure des fuites de méthane les plus importantes du globe. Celles-ci se situent surtout à proximité des sites d’extraction et de transport de gaz (ci-dessous, à droite : fuite en Iraq, en haut, et en Russie, en bas).

POUR LA SCIENCE N° 548 / JUIN 2023 / 41

©

Kayrros, Inc. ; Esri, HERE, Garmin, FAO, NOAA, USGS, les contributeurs d’OpenStreetMap et la communauté des utilisateurs de GIS

Principaux gazoducs Débit de fuite : 10 tonnes/h 500 tonnes/h

Sept capteurs de précision, disposés dans l’axe des vents dominants, mesurent la quantité de CO2 présent dans l’atmosphère de la métropole parisienne. D’après une campagne de mesures effectuée entre 2016 et 2021, le taux de CO2 varie entre 390 et 450 ppm.

elles sont allées ensuite Certaines stationsservice sont des stations de passage, d’autres vont alimenter des véhicules qui brûleront le carburant localement. Autre exemple : à qui attribuer les émissions de la centrale de SaintAvold (en Moselle), centrale à charbon sollicitée pour compenser la perte de production du parc nucléaire ? Au territoire environnant ? À l’Allemagne, ou au Luxembourg, connectés au même réseau ? Ce sont des agences comme Airparif, Atmo Occitanie, Atmo Grand Est, le Citepa, qui se chargent de récolter des données Mais l’exercice est toujours compliqué Si je reprends l’exemple de la route, dans un territoire donné, il est possible d’utiliser des dispositifs capables de compter le nombre de voitures et camions sur une chaussée Mais cela ne dira pas quel carburant est utilisé, ni le poids du véhicule . Dans de nombreuses zones rurales, on ne peut pas se reposer sur ces dispositifs. On utilise alors des estimations de fréquentation, parfois basées sur des études très anciennes. Les barres d’erreur deviennent vraiment problématiques

Pourquoi est-il nécessaire d’évaluer régulièrement les émissions de gaz à effet de serre à l’échelle territoriale ?

Comme l’a dit un collègue, « on ne commence pas un régime sans monter sur la balance ». On ne peut pas mettre en place une politique climatique efficace, optimisée économiquement, si on ne dispose pas d’une estimation récente et fiable des émissions de carbone dans chaque secteur des activités humaines sur un territoire donné N’oublions pas que les régions sont en charge de concevoir des plans climat, air, énergie, territoriaux (PCAET). Mis en place au niveau régional, ceux-ci doivent être cohérents pour, in fine, correspondre à l’objectif de l’État français en matière de réduction des

émissions de gaz à effet de serre, pour 2030 et 2050. Ces plans doivent être faits pour chaque secteur d’activité, avec des échéances, des niveaux d’émission à atteindre… En pratique, dans un territoire très industrialisé, les efforts vont a priori s’intéresser aux sites industriels. Ailleurs, les cibles seront le résidentiel, les transports… Mais outre que les incertitudes sur les bilans sont très grandes, les derniers inventaires disponibles, actuellement, à l’échelle des villes et des régions, datent de 2019. Ils ont toujours trois ou quatre ans de retard sur l’année en cours – c’est le temps nécessaire pour collecter les données et les traiter statistiquement. Imaginezvous concevoir, par exemple, le plan climat de Paris, sur la base d’une situation pré-Covid, alors que la mobilité, les usages des entreprises ont évolué en profondeur C’est paradoxal : on demande aux décideurs de préparer un futur qui atténuera le réchauffement climatique et ses effets, alors qu’en réalité on maîtrise mal l’évaluation, au présent, des émissions de gaz à l’origine du réchauffement.

La mesure directe du CO2 ou du méthane dans l’atmosphère est-elle la solution pour connaître les contributions des divers types d’activité, dans chaque territoire ?

Non. Les mesures atmosphériques, seules, ne peuvent suffire à apporter une solution au problème, car elles sont compliquées à interpréter Quand on installe des capteurs au sol et au - dessus d’une ville ( avec des ballonssondes), comme j’ai pu le faire à Paris, à Reims, aux États - Unis et ailleurs , les instruments relèvent des concentrations de CO₂. Ces relevés produisent une information fiable. Le problème, c’est que les concentrations obtenues sont le résultat de phénomènes très divers : les arbres qui respirent et qui absorbent le carbone, les voitures qui passent à côté, la cheminée au-dessus du toit Et on ne sait pas vraiment ce qu’on mesure On va donc mener une analyse atmosphérique fine, utiliser des modèles et faire une attribution des sources les plus probables. Chaque donnée locale est donc affectée de marges d’erreur importantes Le « bon » système d’évaluation des bilans carbone territoriaux s’appuiera sur des inventaires de départ – de la meilleure qualité possible – qui seront recoupés par de l’information atmosphérique. On peut imaginer un modèle type smart city (« ville intelligente »), collectant au quotidien des données de trafic et de consommation énergétique, notamment À partir de telles informations, on est capable de calculer le bilan carbone théorique de la ville, et le bilan ajusté en comparant le résultat avec la quantité de CO2 effectivement mesurée dans l’atmosphère. D’une certaine manière, l’atmosphère fait ainsi figure de référence pour contraindre les méthodes d’inventaires.

42 / POUR LA SCIENCE N° 548 / JUIN 2023 ©

G. Albora, Aerolab, université de Reims

PHYSIQUE DE L’ATMOSPHÈRE « ON SAIT ESTIMER LES ÉMISSIONS D’UNE VILLE AU MOIS PRÈS »

Comment passe-t-on d’une mesure de CO2 dans l’atmosphère à l’estimation de la production de CO2 propre à un territoire donné ?

Prenons l’exemple de Paris. Techniquement, il faut commencer par isoler la capitale dans les données atmosphériques recueillies. Pour cela, on dispose en périphérie de la ville de capteurs, au sol , donnant les concentrations de CO ₂ générales de la région, et de capteurs dans la ville et en sortie de celle-ci. Il est ainsi possible de suivre, à mesure que la masse d’air va voler au-dessus de Paris, l’accumulation du CO₂ spécifique à la ville En choisissant judicieusement nos points de référence, nous établissons un gradient, lié au mouvement de la masse d’air

Le taux de CO2 ainsi calculé n’est pas exempt d’incertitudes La représentation du vent, dans les modèles atmosphériques, est loin d’être parfaite La diffusion, la turbulence, la convection, les nuages, tout ça est très compliqué Les modèles sont susceptibles d’échouer à simuler les conditions réelles Nous utilisons donc, aussi, des réseaux de capteurs atmosphériques, avec des lâchers de ballons, mais également des mesures par Lidar (light detection and ranging) de la vitesse du vent ou de la hauteur de mélange de la couche atmosphérique. En ajoutant des mesures météorologiques, nous pouvons forcer nos modèles de transport atmosphérique à suivre les données – ce n’est plus de la modélisation pure, on oblige les équations de Navier-Stokes, décrivant les écoulements des fluides, à restituer les données recueillies au-dessus de la ville Une fois le modèle ainsi optimisé , nous attribuons les sources de CO2 en faisant littéralement tourner le modèle en marche avant et en marche arrière : c’est ce qu’on appelle « l’inversion », qui consiste à remonter le vent pour identifier la source d’une concentration de CO2 donnée On donne ainsi une probabilité qu’une mesure soit liée à l’incinérateur d’ordures… avec un certain degré de confiance La grande qualité de l’inversion, c’est de très bien contraindre le total de CO2 émis Elle n’est pas précise, par contre, pour l’attribution spatiale des sources – au contraire des inventaires C’est donc la combinaison des deux méthodes qui fait la force du système. Et ainsi, à l’échelle d’un mois, ou d’une semaine, il est possible de calculer le total des émissions du territoire à 5 % près

Les mesures atmosphériques sont-elles déjà utilisées pour établir les bilans carbone officiels ? Je pense sincèrement que la technologie est prête à être utilisée par les décideurs publics. Des discussions sont en cours, notamment avec la Ville de Paris, avec la Ville de Reims. Je travaille avec Origins earth, une start-up qui exploite les algorithmes que nous avons développés dans nos travaux de recherche Cela reste une technologie chère. Un capteur de qualité

coûte au minimum 100 000 euros À Paris, on en a déployé dix, plus vingt autres un peu moins performants Pour une ville, c’est un investissement à plusieurs millions pour avoir un système de suivi des émissions Or un bilan carbone, sur inventaire, coûte entre 30 000 et 50 000 euros : la comparaison est sans appel À l’heure actuelle, la méthode standard acceptée par l’Ademe

BIBLIOGRAPHIE

T. Lauvaux et al., Global assessment of oil and gas methane ultra-emitters, Science, 2022.

J. Lian, et al, Can we use atmospheric CO2 measurements to verify emission trends reported by cities ? Lessons from a six-year atmospheric inversion over Paris, EGUsphere [preprint], 2023.

comme par le Giec reste l’inventaire Mais il me semble indispensable de passer au stade d’après. Nous savons qu’avec les inventaires seuls, les décideurs publics n’ont pas d’information à jour, et elle se révèle fausse ou imprécise Comment une mairie peut-elle décider d’un plan sans être capable d’évaluer si les effets seront au rendezvous ? Les plans climat relèvent de l’intention, mais le travail de chiffrage reste à faire

Vous avez utilisé des mesures spatiales pour suivre les émissions de méthane à l’échelle globale. Quel bilan en tirez-vous ?

Les détections que nous avons menées par satellite ont notamment montré que le secteur pétrolier et gazier émettait de très grandes quantités de méthane en raison des fuites sur les sites d’extraction et le long des réseaux de distribution On sait que certains pays producteurs accepteront difficilement les régulations – que l’Europe semble vouloir renforcer Jusqu’ici, l’extraction du gaz était peu chère En perdre 3, 4 ou 5 % était toujours moins coûteux que de réparer les fuites Ce n’est plus forcément vrai à présent que son prix est élevé sur le marché mondial Par ailleurs, les investisseurs tendent à privilégier davantage les producteurs d’énergie les plus « verts » Les marchés financiers tiennent compte désormais d’indices qui donnent du poids à la quantité de fuites – que l’on sait à présent objectiver. Les premiers utilisateurs des modèles de détection des fuites de méthane depuis l’espace ont été des acteurs financiers. Je pense que la transition énergétique – qu’il s’agisse de surveiller les niveaux d’émission ou la réalité des projets de compensation carbone sur le terrain – a besoin désormais de pouvoir compter non seulement sur des instruments de mesure performants – ils sont là –, mais aussi sur des standards instaurant des protocoles clairs, à même de diffuser largement et de manière robuste les modèles issus de la recherche n Propos recueillis par François Lassagne

POUR LA SCIENCE N° 548 / JUIN 2023 / 43

L’information fournie par les inventaires de CO2 n’est pas à jour £

L’ESSENTIEL

> À partir du XVIIIe siècle en France, plusieurs naturalistes ont théorisé et rationalisé la domestication.

> Enthousiasmés par les espèces d’animaux et de plantes découvertes lors des grandes explorations, ils voyaient dans leur acclimatation en France

la piste d’une nouvelle ressource alimentaire.

> Leur approche utilitariste a abouti à une augmentation drastique de la diversité des espèces domestiquées et à l’apparition des races et des variétés.

LES AUTRICES

CÉCILE CALLOU archéozoologue, maîtresse de conférences au Muséum national d’histoire naturelle, à Paris

CLÉMENCE PAGNOUX

archéobotaniste, maîtresse de conférences au Muséum national d’histoire naturelle, à Paris

Le grand bond utilitariste

Si la naissance de l’élevage et de l’agriculture remonte à 15 000 ans, la domestication ne s’est réellement intensifiée qu’il y a 300 ans.

Charolaise , limousine , blonde d’Aquitaine… Actuellement, le patrimoine français compte onze races bovines à viande selon la fédération Races de France, qui rassemble les associations d’éleveurs Certes, grâce à des programmes de conservation mis en place à partir de 1976, une quinzaine d’autres variétés locales persistent, comme la bretonne pie noir, mais leurs effectifs restent très faibles Pourtant, au XIXe siècle, la situation était tout autre. Jusqu’à la première moitié du XXe siècle , les races bovines étaient aussi nombreuses, et de formes et de couleurs aussi variées, que les régions dont elles prenaient le nom. En 1859, dans son traité Races bovines de France, de Suisse, d’Angleterre et de Hollande, le marquis Élie de Dampierre recensait ainsi dix-sept races bovines principales, la plupart utilisées indifféremment pour

le lait, la viande ou le travail, ainsi que d’autres « races et sous-races peu connues ».

De fait, dès le XVIIIe siècle, on observe, tant dans l’élevage que dans l’agriculture, une augmentation massive de la diversité des espèces aussi bien que des races et variétés domestiquées Ce n’est pas un hasard Si l’élevage et l’agriculture ont débuté il y a 15 000 ans, ce n’est que bien plus récemment, il y a seulement 300 ans, qu’un tournant majeur s’est opéré, qui a abouti à une modification complète des méthodes de sélection, et à l’apparition des races et des variétés

LE TEMPS DES GRANDS CHANGEMENTS

Le XVIIIe siècle est fascinant dans les changements profonds qu’il a apportés dans notre environnement, notre perception de la nature et jusque dans nos assiettes. D’abord, le siècle

TRIBUNES DU MUSÉUM

CÉCILE CALLOU

interviendra le samedi 10 juin de 15 heures à 17 heures lors de la tribune Domestication(s) du Muséum national d’histoire naturelle, à Paris.

Événement gratuit, informations sur : mnhn.fr/tribunes

64 / POUR LA SCIENCE N° 548 / JUIN 2023

HISTOIRE DES SCIENCES

DOSSIER SPÉCIAL

Domestication(s) Samedi 10 juin 2023

des premiers grands voyages d’exploration scientifique (expéditions de Bougainville, de Cook, de Lapérouse, de Baudin…) à l’initiative de l’Occident, qui ont fait suite aux grandes découvertes maritimes des XV-XVIIe siècles, est aussi celui des naturalistes. Favorisées par les innovations techniques navales, les expéditions permettent en effet à nombre d’entre eux d’explorer des territoires inconnus, d’observer et de collecter de nouvelles espèces, et de réfléchir à leur acclimatation dans d’autres régions

Certains s’intéressent à l’agriculture dans son ensemble, comme Louis Liger ou l’abbé Rozier. D’autres se consacrent à des domaines particuliers, comme Réaumur et sa Pratique de l’art de faire éclore et d’élever en toute saison des oiseaux domestiques de toutes espèces, à l’origine des incubateurs artificiels. La création des premières écoles vétérinaires (à Lyon en 1762 et à Maisons-Alfort en 1766) s’inscrit dans ce

mouvement Pour les zootechniciens , l’histoire de l’élevage débute d’ailleurs officiellement à cette période D’autres encore étudient l’histoire naturelle dans son organisation générale , en particulier Georges - Louis Leclerc , comte de Buffon. Le XVIIIe siècle est aussi celui où des plantes alimentaires, rapportées d’Amérique en Europe dès le XVIe siècle, commencent à être cultivées pour l’alimentation et sont largement consommées : c’est le cas de la tomate et de la pomme de terre, plante miracle en période de disette. C’est également l’époque des premiers essais d’hybridations expérimentales, notamment sur les fraisiers, dont le Français Antoine Nicolas Duchesne obtient plusieurs variétés hybrides par croisement à partir d’espèces européennes, et les Britanniques Thomas Andrew Knight et Michael Keens, à partir d’espèces américaines Ces derniers observent que le croisement

Sur les quelque 4 millions de vaches allaitantes (c’est-à-dire qui allaitent leurs veaux et sont destinées à être vendues pour leur viande) élevées en France, environ 80 % proviennent des seules races charolaise, limousine (ci-dessus) et blonde d’Aquitaine.

POUR LA SCIENCE N° 548 / JUIN 2023 / 65

© Jeremy-Stenuit/Shutterstock

spontané entre deux espèces différentes produit une plante dont le fruit possède plusieurs caractéristiques des deux espèces parentes Si les lois de l’hérédité des caractères ne seront établies qu’au siècle suivant, ces expériences comptent parmi les premières tentatives de création variétale

Enfin, une nouvelle institution voit le jour : le Muséum national d’histoire naturelle, créé par décret en 1793 à la suite du Jardin des plantes C’est dans son sillage que s’amorce le tournant de la domestication.

En 1792, Jacques-Henri Bernardin de SaintPierre, alors intendant du Jardin des plantes, rédige son Mémoire sur la nécessité de joindre une ménagerie au Jardin national des plantes de Paris, où il défend l’idée de rassembler au sein de l’institution des animaux rapportés lors des voyages. Ses réflexions sont nourries par une visite de ce qui subsistait de la ménagerie de

Versailles, où on lui a proposé d’accueillir les animaux qui y survivaient « pour en faire des squelettes » Ulcéré à l’idée de tuer des animaux venus d’Asie, d’Afrique ou d’Amérique, il voit dans la création de la ménagerie du Jardin des plantes un intérêt pour l’étude scientifique et la représentation artistique d’animaux parfaitement inconnus et étrangers Le lieu viserait à attirer les curieux, mais avec pour objectif l’instruction publique Surtout, l’agriculture bénéficierait de la possibilité d’acclimater des animaux et de les croiser avec des races domestiques.

Bernardin de Saint-Pierre n’est pas le seul à penser ainsi . Louis Daubenton , premier directeur du Muséum, suggère de son côté une longue liste d’espèces utiles susceptibles de rejoindre le rang des « domestiques », issues de tous les continents et de tous les milieux , même les étangs et les viviers Mais c’est à Isidore Geoffroy Saint-Hilaire, alors titulaire de la chaire de zoologie, qu’il revient de mettre en pratique les expériences d’acclimatation. En 1854, il publie un ouvrage sur la « domestication et naturalisation des animaux utiles » et

fonde la Société zoologique d’acclimatation, dont l’objectif est de participer à l’introduction, à l’acclimatation, à la domestication et au perfectionnement des espèces utiles ou d’ornement, qu’il s’agisse de mammifères, d’oiseaux, de poissons, de crustacés, de mollusques ou même d’insectes :

Nous voulons fonder, Messieurs, une association, jusqu’à ce jour sans exemple, d’agriculteurs, de naturalistes, de propriétaires, d’hommes éclairés, non seulement en France, mais dans tous les pays civilisés, [afin] de peupler nos champs, nos forêts, nos rivières, d’hôtes nouveaux ; d’augmenter le nombre de nos animaux domestiques , cette richesse première du cultivateur ; d’accroître et de varier les ressources alimentaires, si insuffisantes, dont nous disposons aujourd’hui ; de créer d’autres produits économiques ou industriels ; et, par là même, de doter notre agriculture, si longtemps languissante, notre industrie, notre commerce et la société tout entière de biens jusqu’à présent inconnus ou négligés, non moins précieux un jour que ceux dont les générations antérieures nous ont légué le bienfait

UN JARDIN POUR ACCLIMATER LES ANIMAUX

On trouve ainsi à Paris dès 1861 d’un côté la ménagerie du Jardin des plantes, alors considérée comme un lieu d’observation zoologique et, de l’autre, le jardin d’acclimatation, situé dans le bois de Boulogne, présenté comme un terrain d’expérimentation. Le premier aquarium public français y est d’ailleurs ouvert Des notions comme « acclimatation », « naturalisation » , « apprivoisement » sont précisées : « acclimater », c’est imprimer des modifications qui rendent l’espèce propre à vivre et à se perpétuer dans des conditions nouvelles d’existence ; « naturaliser », c’est amener à vivre dans d’autres lieux à l’état sauvage ; « apprivoiser », c’est rendre familier avec l’homme en distinguant asservissement complet (apprivoisé) et privation de liberté (captif).

Retrouvez Cécile Callou dans le magazine De cause à e ets, sur France Culture, mardi 6 juin de 21 heures à 22 heures, pour une émission intitulée « Les espèces domestiquées peuventelles retourner à l’état sauvage ? ».

Le podcast sera disponible ensuite sur le site de l’émission : https://bit.ly/3VS09Hi

Du côté des plantes, les principes de l’hérédité des caractères sont mis en évidence au cours du XIXe siècle et débouchent sur la naissance de l’amélioration variétale par sélection de caractères On doit au botaniste Louis de Vilmorin les premiers travaux sur l’amélioration de la betterave sucrière, dont il décrit « une nouvelle race » en 1856. Ses descendants mettent en œuvre à grande échelle la sélection généalogique : son fils Henry de Vilmorin participe à la création de nouvelles variétés de blés hybrides et ses petits-enfants contribuent à l’acclimatation d’arbres pour l’ornement et à la sélection de variétés potagères.

La liste des espèces concernées par l’approche de Geoffroy Saint-Hilaire est impressionnante : elle contient tous les animaux – de l’insecte au mammifère – qui ont connu une

66 / POUR LA SCIENCE N° 548 / JUIN 2023 HISTOIRE DES SCIENCES LE GRAND BOND UTILITARISTE

À

ÉCOUTER

La sélection raisonnée des individus a mené à l’explosion de la diversité des races £

forme d’exploitation quelque part dans le monde. De nombreux oiseaux sont ainsi introduits à cette époque , de même que le lama et l’alpaca, très prisés pour la qualité de leur laine, dont le prix ne cesse d’augmenter en raison de la forte demande des manufactures textiles et de la concurrence, notamment avec l’Angleterre

Avec le recul, l’impact de cette politique sur l’environnement n’a pas été énorme, car peu d’espèces exotiques se sont implantées à l’état sauvage En revanche, le nombre d’espèces domestiquées a drastiquement augmenté à cette époque : Geoffroy Saint- Hilaire liste 21 mammifères ( dont le renne , le lama et le chinchilla ), 17 oiseaux ( faisans , colombes , canards , oies… ), 2 poissons (carpe vulgaire et poisson rouge), 7 insectes (abeilles, cochenilles et vers à soie ) – dont on retrouve encore la plupart dans la liste des animaux domestiques définie par l’arrêté du 11 août 2006. Et si la création de nouvelles formes animales par hybridation empirique a échoué dans la ménagerie d’acclimatation, la connaissance de nouvelles espèces a élargi le champ des possibles.

En particulier, à partir de cette époque , grâce aux avancées zootechniques et à la mise en place des pratiques vétérinaires, la productivité s’est considérablement améliorée et , avec elle , la sélection des individus , qui a mené à la définition actuelle des races et à l’explosion de leur diversité De même , les vagues d’acclimatation et les expériences de croisement , d’hybridation et de sélection diverses ont transformé le secteur des plantes, qu’elles soient utiles ou ornementales Ainsi, les nombreuses variétés actuelles de rosier dérivent de l’acclimatation d’espèces du Proche-Orient (dès le XIVe siècle) et de Chine (au XVIIIe siècle), et de leur croisement avec des formes européennes

QUEL HÉRITAGE AUJOURD’HUI ?

Aujourd’hui, de la très grande diversité de races et variétés locales, reflet d’un terroir, il ne reste qu’assez peu de choses. Les races bovines à viande en sont un bon exemple En France, la diminution de leur nombre est le fruit d’un choix délibéré fait au lendemain de la Seconde Guerre mondiale pour augmenter la productivité et nourrir les populations affamées. De même, du côté des plantes, depuis les premiers essais d’amélioration variétale réalisés avec succès sur le blé, puis sur le maïs et la tomate , la sélection toujours plus ciblée a donné lieu à une modification profonde de la diversité cultivée Les variétés locales de blé, par exemple, ont été peu à peu remplacées par

Le zoologiste français Isidore Geoffroy Saint-Hilaire (1805-1861) fonda en 1854 la Société zoologique d’acclimatation, qui avait pour objectif de « concourir :

1° À l’introduction, à l’acclimatation et à la domestication des espèces d’animaux utiles ou d’ornement ;

2° Au perfectionnement et à la multiplication des races nouvellement introduites ou domestiques ».

BIBLIOGRAPHIE

J.-D. Vigne et B. David (dir.), La Terre, le vivant, les humains, MNHN/ La Découverte, 2022.

I. Geo roy Saint-Hilaire, Acclimatation et domestication des animaux utiles, 1861.

L. L. de Vilmorin, Note sur la création d’une nouvelle race de betterave et considération sur l’hérédité des végétaux, Comptes rendus des séances hebdomadaires de l’Académie des sciences, 1859.

J.-H. Bernardin de Saint-Pierre, Mémoire sur la nécessité de joindre une ménagerie au Jardin national des plantes de Paris, 1792.

d’autres obtenues par croisement à partir de variétés issues de régions plus lointaines (Crimée, Angleterre) et plus limitées, par sélection de caractères liés à la résistance aux aléas climatiques et aux maladies, ou aux qualités boulangères Si bien qu’actuellement , une dizaine de variétés de blé tendre se partagent 50 % des surfaces cultivées en blé en France , alors qu’il en existe plus de 350 dans le catalogue des semences

Depuis le milieu du XXe siècle , la recherche sur l’amélioration variétale s’est accélérée, associée à des progrès techniques fulgurants Une sélection très ciblée, contrôlée en séquençant le génome des individus obtenus , est désormais possible , et de nouvelles techniques d’amélioration des plantes ouvrent la voie à la modification ciblée du génome ou à la modulation de l’expression des gènes, soulevant de nouveaux questionnements dans un contexte de désengagement de la recherche publique et de montée en puissance des intérêts privés : comment éviter les transferts de gènes modifiés d’un organisme à un autre ? À qui appartiennent les différentes « créations » (variétés, races, séquences, voire gènes) ? L’écart entre les objectifs des semenciers et ceux des cultivateurs semble aussi s’accroître, la sélection raisonnée en laboratoire, en vue de produire un panel stable de races et de variétés, se faisant au détriment de la recherche de formes adaptées à l’environnement Sans oublier le décalage que cette recherche de stabilité introduit vis-à-vis du concept de biodiversité, qui décrit l’évolution des espèces – sauvages comme cultivées – au contact de leur environnement

Les mouvements pour la sauvegarde des races locales et des semences paysannes, apparus dès la fin des années 1970, s’amplifient depuis une vingtaine d’années . Des voix s’élèvent pour dénoncer les risques de fuite en avant technologique et appeler à chercher d’autres solutions aux aléas du climat , aux effets des nuisibles et aux défis futurs de l’agriculture et de l’élevage Cependant, la tendance est toujours à la diminution du nombre d’espèces cultivées et de races animales élevées Récemment , l’Académie d’agriculture a publié un texte qui invite la société à s’interroger sur ses rapports aux vivants non humains. Ses auteurs voient dans la conservation de la biodiversité domestique un enjeu majeur pour la transition agroécologique et notre sécurité alimentaire, tout en militant pour une reconnaissance juridique du concept de « biens vivants » Il est clair que la façon dont on définira les droits accordés aux animaux influera sur la domestication de demain n

POUR LA SCIENCE N° 548 / JUIN 2023 / 67 ©

Photographie de Franck, Wellcome Collection, Public Domain Mark

P. 80 Logique & calcul

P. 86 Art & science

P. 88 Idées de physique

P. 92 Chroniques de l’évolution

P. 96 Science & gastronomie

P. 98 À picorer L’AUTEUR

L’EFFICACITÉ TROMPEUSE DES ALGORITHMES GALACTIQUES

Une méthode de calcul peut être la meilleure en théorie, mais totalement inutile pour toute application dans le monde réel.